Google và Intel hôm thứ Ba đã ra mắt chip AI của riêng họ để thách thức Nvidia khi cuộc đua sản xuất chất bán dẫn tiên tiến để cung cấp năng lượng cho các mô hình AI có khả năng tạo ra như ChatGPT hoặc Gemini ngày càng gay gắt.

Google đã phát hành Cloud TPU v5p và Intel đã công bố bộ xử lý Gaudi 3 AI. Các con chip này được thiết kế để tăng hiệu suất trong quá trình đào tạo hệ thống AI cũng như 'chạy phần mềm đã hoàn thiện'.

Ngoài ra đọc: Trận động đất ở Đài Loan làm gián đoạn trung tâm chip AI lớn, đe dọa nguồn cung toàn cầu

Đào tạo LLM với tốc độ nhanh hơn

Google lần đầu tiên công bố bộ xử lý TPU hay còn gọi là bộ xử lý tensor mới vào tháng 5, cùng với Gemini. Họ cho biết TPU vXNUMXp, hiện có sẵn cho các nhà phát triển, là bộ xử lý AI “mạnh mẽ và có khả năng mở rộng” nhất từ trước đến nay.

Công ty tuyên bố rằng chip cập nhật của họ có thể đào tạo các mô hình ngôn ngữ lớn (LLM), công nghệ đằng sau các chatbot AI như Gemini và ChatGPT, nhanh hơn ba lần so với người tiền nhiệm của nó, Google TPU v4. Nó cho biết chip AI mang lại thông lượng gấp 12 lần so với phiên bản cũ.

“Bây giờ ở thế hệ thứ năm, những tiến bộ này [đối với TPU của Google] đã giúp khách hàng đào tạo và phục vụ các mô hình ngôn ngữ tiên tiến,” Giám đốc điều hành Google Sundar Pichai cho biết tại một sự kiện của công ty ở Las Vegas, theo cho các phương tiện truyền thông công nghiệp.

[Nhúng nội dung]

Trong khi mục đích là thách thức Nvidia, công ty Mỹ cung cấp tới 90% chip AI được gọi là bộ xử lý đồ họa hoặc GPU, Google cho thấy rằng họ vẫn phụ thuộc vào Nvidia.

Trong cùng blog đăng bài công bố TPU mới nhất của mình, Google cho biết họ đang nâng cấp siêu máy tính A3, được cung cấp bởi Nvidia H100 các đơn vị xử lý đồ họa. Công ty cũng tiết lộ rằng họ đang sử dụng GPU mới nhất của Nvidia, Blackwell, trong Siêu máy tính AI của nó.

Google cũng phát hành Axion, một bộ xử lý trung tâm (CPU) tùy chỉnh mới dành cho các trung tâm dữ liệu được xây dựng bằng công nghệ của hãng Arm của Anh. Nó cho biết Axion, đối thủ của CPU của Microsoft, Amazon và Meta, có thể xử lý nhiều tác vụ khác nhau, bao gồm tìm kiếm của Google và hoạt động AI.

Theo Google, Axion cung cấp “hiệu suất tốt hơn 30% so với các phiên bản dựa trên Arm có mục đích chung nhanh nhất hiện có trên đám mây hiện nay” và “hiệu suất tốt hơn tới 50% và hiệu suất năng lượng tốt hơn tới 60%” so với các Arm có mục đích chung khác. khoai tây chiên.

Intel: AI ở mọi nơi

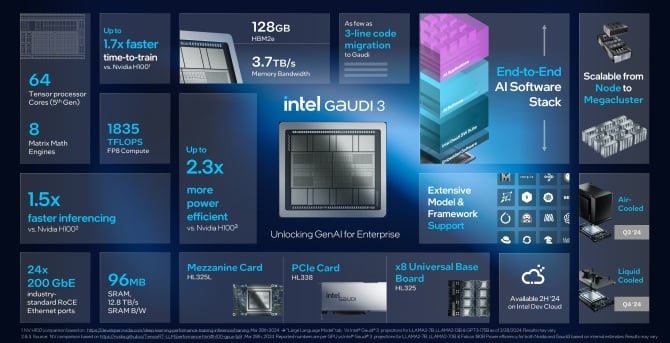

Hôm thứ Ba, Intel cũng đã công bố ra mắt phiên bản mới của bộ xử lý trí tuệ nhân tạo, Gaudi 3. Công ty cho biết chip Gaudi 3 có hiệu suất năng lượng cao hơn gấp đôi so với GPU H100 của Nvidia và có thể chạy các mô hình AI một lần một- nhanh hơn một nửa.

Giám đốc điều hành Intel Pat Gelsinger cho biết: “Sự đổi mới đang tiến triển với tốc độ chưa từng thấy, tất cả đều được kích hoạt bằng silicon - và mọi công ty đều nhanh chóng trở thành công ty AI”. tuyên bố. “Intel đang đưa AI đến mọi nơi trong toàn doanh nghiệp, từ PC đến trung tâm dữ liệu cho đến thiết bị biên.

🔎

_🔥🔥🔥_

****🤖****- Mundia Brian (@Mundia_Brian_) 9 Tháng Tư, 2024

Gelsinger không cho biết Gaudi 3 sẽ có giá bao nhiêu, Bloomberg báo cáoTuy nhiên, ông cho biết cái gọi là chip tăng tốc của công ty ông sẽ “thấp hơn rất nhiều” so với giá chip hiện tại và tương lai của Nvidia. Ông nói thêm rằng họ sẽ đưa ra tổng chi phí sở hữu “cực kỳ tốt”.

Intel tuyên bố rằng con chip mới nhất của họ sẽ mang lại “bước nhảy vọt đáng kể” trong việc đào tạo và suy luận AI cho các thực thể làm việc về AI tổng hợp. Các công ty đào tạo hệ thống AI cần chúng để có thể đưa ra dự đoán khi trả lời các câu hỏi thực tế – được gọi là suy luận.

Theo Intel, Gaudi 3 sẽ nhanh hơn và tiết kiệm điện hơn H100 và tất cả các mô hình ngôn ngữ lớn được đào tạo bằng GPU như Llama của Meta hay Falcon đa ngôn ngữ của Abu Dhabì. Nó cho biết con chip này có thể giúp đào tạo các mô hình như Stable Diffusion hoặc Whisper từ OpenAI để nhận dạng giọng nói.

Công ty cho biết trong các loại hình đào tạo này, Gaudi 3 nhanh hơn 1.7 lần và chạy phần mềm tốt hơn 1.5 lần. Intel cho biết hiệu năng của chip AI này có thể so sánh với B200 mới của Nvidia, vượt trội ở một số lĩnh vực và tụt hậu ở những lĩnh vực khác.

Intel cho biết chip Gaudi 3 mới sẽ có sẵn cho khách hàng vào quý XNUMX và các công ty bao gồm Supermicro, Dell và HP sẽ xây dựng các hệ thống với bộ tăng tốc AI.

Nvidia đầy thách thức

Các công ty đang xây dựng hệ thống AI tiên tiến đang tìm cách giảm chi phí bằng cách ngừng phụ thuộc vào GPU đắt tiền của Nvidia.

Theo kỹ sư phần mềm James Hamilton, vào năm 2023, Amazon đã chi khoảng 65 triệu USD cho một đợt đào tạo. Ông hy vọng con số đó sẽ sớm đạt hơn 1 tỷ USD.

Một tuần trước, OpenAI và Microsoft tiết lộ có kế hoạch xây dựng một trung tâm dữ liệu trị giá 100 tỷ USD để đào tạo AI có tên là 'Stargate'. Và vào tháng 9, Giám đốc điều hành Meta Mark Zuckerberg cho biết công ty của ông có kế hoạch chi XNUMX tỷ USD chỉ riêng cho GPU Nvidia.

Tất cả các công ty công nghệ lớn đều mua chip từ Nvidia, nhưng họ cũng bắt đầu tự sản xuất hoặc mua từ AMD, hãng đã giới thiệu GPU trung tâm dữ liệu mới có tên MI300X vào năm ngoái. AMD có kế hoạch mở rộng và bán thêm chip trí tuệ nhân tạo cho máy chủ trong năm nay.

Các đối thủ của Google là Microsoft, Meta [cả khách hàng của AMD] và Amazon, cũng đã phát triển chip AI của riêng họ. Tuy nhiên, nó sẽ không dễ dàng. Đầu năm nay, Nvidia đã phát hành GPU B100 và B200, sản phẩm kế thừa của H100, hứa hẹn tăng hiệu suất. Các con chip này dự kiến sẽ bắt đầu được xuất xưởng vào cuối năm 2024.

Sự bùng nổ AI và H100 giúp tăng gấp đôi doanh thu của Nvidia và nâng mức định giá thị trường của nó lên hơn 2 nghìn tỷ USD, khiến nó trở thành một trong những công ty thành công nhất ở Phố Wall.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://metanews.com/google-and-intel-launch-own-ai-chips-as-nvidia-rivalry-heats-up/

- :là

- :không phải

- 1 tỷ USD

- $ 65 triệu

- $ 9 tỷ

- $ LÊN

- 1

- 12

- 2023

- 2024

- 7

- 800

- 9

- a

- Có khả năng

- gia tốc

- Theo

- ngang qua

- thêm

- tiên tiến

- tiến bộ

- thăng tiến

- cách đây

- AI

- Mô hình AI

- Hệ thống AI

- Đào tạo AI

- nhằm mục đích

- Tất cả

- cô đơn

- bên cạnh

- Ngoài ra

- đàn bà gan dạ

- AMD

- an

- và

- công bố

- Thông báo

- LÀ

- khu vực

- ARM

- xung quanh

- nhân tạo

- trí tuệ nhân tạo

- AS

- At

- có sẵn

- BE

- trở thành

- sau

- đằng sau hậu trường

- Hơn

- Tỷ

- Bloomberg

- bùng nổ

- tăng

- cả hai

- Brian

- mang lại

- Đưa

- xây dựng

- Xây dựng

- xây dựng

- nhưng

- mua

- by

- gọi là

- CAN

- Trung tâm

- Trung tâm

- trung tâm

- giám đốc điều hành

- thách thức

- chatbot

- ChatGPT

- Chip

- Snacks

- tuyên bố

- đám mây

- Các công ty

- công ty

- Của công ty

- so sánh

- đối thủ cạnh tranh

- nội dung

- Phí Tổn

- Chi phí

- Current

- khách hàng

- khách hàng

- cắt

- dữ liệu

- Trung tâm dữ liệu

- các trung tâm dữ liệu

- Trung tâm dữ liệu

- Tháng mười hai

- cung cấp

- cung cấp

- thung lũng nhỏ

- phụ thuộc

- thiết kế

- phát triển

- phát triển

- ĐÃ LÀM

- Lôi thôi

- sự gián đoạn

- tăng gấp đôi

- xuống

- được mệnh danh là

- Sớm hơn

- dễ dàng

- Cạnh

- nhúng

- kích hoạt

- ky sư

- Doanh nghiệp

- thực thể

- Sự kiện

- Mỗi

- ở khắp mọi nơi

- Mở rộng

- dự kiến

- kỳ vọng

- đắt tiền

- nhanh hơn

- nhanh nhất

- Hình

- Công ty

- hãng

- Tên

- Trong

- từ

- tương lai

- thu nhập

- Gemini

- Tổng Quát

- mục đích chung

- thế hệ

- thế hệ

- Trí tuệ nhân tạo

- Toàn cầu

- đi

- Google Cloud

- GPU

- GPU

- đồ họa

- Hamilton

- xử lý

- Có

- he

- giúp đỡ

- đã giúp

- Cao

- của mình

- Độ đáng tin của

- Tuy nhiên

- HTTPS

- Hub

- in

- Bao gồm

- ngành công nghiệp

- Intel

- Sự thông minh

- Tăng cường

- giới thiệu

- IT

- ITS

- james

- Tháng một

- jpg

- chỉ

- nổi tiếng

- Ngôn ngữ

- lớn

- LAS

- Las Vegas

- Họ

- Năm ngoái

- một lát sau

- mới nhất

- phóng

- phát động

- Lượt thích

- Loài đà mã ở nam mỹ

- tìm kiếm

- Rất nhiều

- chính

- làm cho

- Làm

- dấu

- đánh dấu zuckerberg

- thị trường

- max-width

- Phương tiện truyền thông

- Siêu dữ liệu

- microsoft

- triệu

- mô hình

- chi tiết

- hầu hết

- nhiều

- Cần

- Mới

- tại

- Nvidia

- of

- cung cấp

- Xưa

- on

- ONE

- OpenAI

- Hoạt động

- or

- Nền tảng khác

- Khác

- kết thúc

- riêng

- quyền sở hữu

- Hòa bình

- PC

- hiệu suất

- kế hoạch

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- quyền lực

- -

- người tiền nhiệm

- Dự đoán

- xử lý

- Bộ xử lý

- hứa hẹn

- cung cấp

- mục đích

- trận động đất

- Quý

- Câu hỏi

- Mau

- Cuộc đua

- đạt

- Đọc

- thực

- công nhận

- phát hành

- dựa vào

- phản ứng

- Tiết lộ

- ganh đua

- đối thủ

- chạy

- chạy

- Nói

- tương tự

- nói

- cảnh

- tìm kiếm

- bán

- Chất bán dẫn

- phục vụ

- Các máy chủ

- Giao Hàng

- cho thấy

- có ý nghĩa

- Silicon

- duy nhất

- Phần mềm

- Kỹ sư phần mềm

- một số

- sớm

- phát biểu

- Speech Recognition

- tiêu

- tiêu

- ổn định

- Bắt đầu

- bắt đầu

- Tiểu bang

- Vẫn còn

- đường phố

- thành công

- như vậy

- Sundar Pichai

- siêu máy tính

- vật tư

- hệ thống

- nhiệm vụ

- công nghệ cao

- Công nghệ

- hơn

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- tự

- Kia là

- họ

- Thứ ba

- điều này

- năm nay

- số ba

- thông lượng

- thời gian

- đến

- Tổng số:

- Train

- đào tạo

- Hội thảo

- đào tạo

- Nghìn tỷ

- đúng

- Thứ Ba

- Hai lần

- kiểu

- Uk

- đơn vị

- các đơn vị

- chưa từng có

- Tiết lộ

- cập nhật

- us

- sử dụng

- Định giá

- khác nhau

- Vegas

- phiên bản

- Tường

- Wall Street

- tuần

- TỐT

- cái nào

- Thì thầm

- sẽ

- với

- đang làm việc

- sẽ

- năm

- nhưng

- youtube

- zephyrnet

- Zuckerberg