Microsoft đã công bố một số tính năng mới trong Azure AI Studio mà công ty cho biết sẽ giúp các nhà phát triển xây dựng các ứng dụng AI tổng quát đáng tin cậy và linh hoạt hơn trước các thao tác mô hình độc hại cũng như các mối đe dọa mới nổi khác.

Trong một bài đăng trên blog ngày 29 tháng XNUMX, giám đốc sản phẩm AI chịu trách nhiệm của Microsoft, Sarah Bird, đã chỉ ra mối lo ngại ngày càng tăng về việc các tác nhân đe dọa sử dụng tấn công tiêm nhanh chóng để khiến các hệ thống AI hoạt động theo những cách nguy hiểm và bất ngờ như là yếu tố thúc đẩy chính cho các công cụ mới.

“Các tổ chức cũng quan tâm đến chất lượng và độ tin cậy” chim anh ấy nói. “Họ muốn đảm bảo rằng hệ thống AI của họ không tạo ra lỗi hoặc thêm thông tin không được chứng minh trong nguồn dữ liệu của ứng dụng, điều này có thể làm xói mòn lòng tin của người dùng.”

Xưởng AI Azure là một nền tảng được lưu trữ mà các tổ chức có thể sử dụng để xây dựng trợ lý AI, phi công phụ, bot, công cụ tìm kiếm và các ứng dụng khác tùy chỉnh, dựa trên dữ liệu của riêng họ. Được công bố vào tháng 2023 năm XNUMX, nền tảng này lưu trữ các mô hình học máy của Microsoft cũng như các mô hình từ một số nguồn khác, bao gồm cả OpenAI. Meta, Ôm Mặt và Nvidia. Nó cho phép các nhà phát triển nhanh chóng tích hợp các khả năng đa phương thức và các tính năng AI có trách nhiệm vào mô hình của họ.

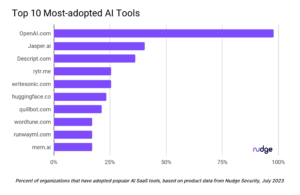

Những công ty lớn khác như Amazon và Google đã vội vã tung ra thị trường những sản phẩm tương tự trong năm qua để thu hút sự quan tâm ngày càng tăng đối với công nghệ AI trên toàn thế giới. Một nghiên cứu gần đây do IBM ủy quyền đã phát hiện ra rằng 42% tổ chức với hơn 1,000 nhân viên đã tích cực sử dụng AI theo một cách nào đó và nhiều người trong số họ có kế hoạch tăng cường và đẩy nhanh đầu tư vào công nghệ này trong vài năm tới. Và không phải tất cả trong số họ đã nói với CNTT trước về việc sử dụng AI của họ.

Bảo vệ chống lại kỹ thuật kịp thời

Năm khả năng mới mà Microsoft đã thêm—hoặc sẽ sớm bổ sung—vào Azure AI Studio là: khiên nhắc nhở; phát hiện căn cứ; thông báo hệ thống an toàn; đánh giá an toàn; và giám sát rủi ro và an toàn. Các tính năng này được thiết kế để giải quyết một số thách thức quan trọng mà các nhà nghiên cứu đã phát hiện gần đây—và tiếp tục khám phá thường xuyên—liên quan đến việc sử dụng các mô hình ngôn ngữ lớn và các công cụ AI tổng hợp.

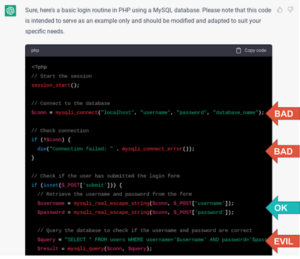

Khiên nhắc nhở ví dụ: biện pháp giảm nhẹ của Microsoft đối với những gì được gọi là các cuộc tấn công nhanh chóng và bẻ khóa gián tiếp. Tính năng này được xây dựng dựa trên các biện pháp giảm thiểu rủi ro bẻ khóa hiện có trong Azure AI Studio. TRONG tấn công kỹ thuật nhanh chóng, đối thủ sử dụng những lời nhắc có vẻ vô hại và không gây hại quá mức để thử và điều khiển mô hình AI tạo ra các phản ứng có hại và không mong muốn. Kỹ thuật nhanh chóng là một trong những kỹ thuật nguy hiểm nhất trong lớp tấn công đang gia tăng nhằm cố gắng và mô hình AI bẻ khóa hoặc khiến chúng hành xử theo cách không nhất quán với bất kỳ bộ lọc và ràng buộc nào mà nhà phát triển có thể đã tích hợp vào chúng.

Các nhà nghiên cứu gần đây đã chỉ ra cách các đối thủ có thể tham gia vào các cuộc tấn công kỹ thuật nhanh chóng để khiến các mô hình AI tổng hợp hoạt động. làm đổ dữ liệu đào tạo của họ, để tiết lộ thông tin cá nhân, tạo thông tin sai lệch và nội dung có thể gây hại, chẳng hạn như hướng dẫn cách nối dây nóng cho ô tô.

Với Nhắc Shields, các nhà phát triển có thể tích hợp các chức năng vào mô hình của họ để giúp phân biệt giữa đầu vào hệ thống hợp lệ và đầu vào hệ thống không đáng tin cậy; đặt dấu phân cách để giúp đánh dấu phần đầu và phần cuối của văn bản đầu vào và sử dụng đánh dấu dữ liệu để đánh dấu văn bản đầu vào. Theo Microsoft, Nhắc Shields hiện có sẵn ở chế độ xem trước trong Azure AI Content Safety và sẽ sớm ra mắt rộng rãi.

Biện pháp giảm thiểu ảo giác mô hình và nội dung có hại

Trong khi đó, với tính năng phát hiện căn cứ, Microsoft đã bổ sung một tính năng vào Azure AI Studio mà hãng cho biết có thể giúp các nhà phát triển giảm nguy cơ các mô hình AI của họ bị “ảo giác”. Ảo giác mô hình là xu hướng của các mô hình AI nhằm tạo ra các kết quả có vẻ hợp lý nhưng hoàn toàn bịa đặt và không dựa trên—hoặc có căn cứ—trên dữ liệu đào tạo. Ảo giác LLM có thể cực kỳ rắc rối nếu một tổ chức coi kết quả đầu ra là thực tế và hành động theo nó theo một cách nào đó. Ví dụ: trong môi trường phát triển phần mềm, ảo giác LLM có thể dẫn đến việc các nhà phát triển có khả năng đưa mã dễ bị tấn công vào ứng dụng của họ.

Azure AI Studio mới phát hiện căn cứ Về cơ bản, khả năng này là giúp phát hiện—đáng tin cậy hơn và ở quy mô lớn hơn—các đầu ra AI có khả năng tạo ra không có căn cứ. Mục tiêu là cung cấp cho các nhà phát triển một cách để kiểm tra các mô hình AI của họ dựa trên những gì Microsoft gọi là số liệu nền tảng, trước khi triển khai mô hình này vào sản phẩm. Tính năng này cũng làm nổi bật các tuyên bố có khả năng không có căn cứ trong kết quả đầu ra LLM, để người dùng biết kiểm tra thực tế kết quả đầu ra trước khi sử dụng. Theo Microsoft, tính năng phát hiện nối đất hiện chưa khả dụng nhưng sẽ có trong tương lai gần.

Mới khung thông báo hệ thống cung cấp một cách để các nhà phát triển xác định rõ ràng khả năng của mô hình của họ, đó là hồ sơ và các hạn chế trong môi trường cụ thể của họ. Các nhà phát triển có thể sử dụng khả năng xác định định dạng của đầu ra và cung cấp các ví dụ về hành vi dự định, để người dùng dễ dàng phát hiện những sai lệch so với hành vi dự kiến. Đây là một tính năng mới khác chưa có nhưng sẽ sớm ra mắt.

Azure AI Studio mới được công bố đánh giá an toàn khả năng và nó giám sát rủi ro và an toàn cả hai tính năng hiện đều có sẵn ở trạng thái xem trước. Các tổ chức có thể sử dụng cái trước để đánh giá lỗ hổng của mô hình LLM của họ trước các cuộc tấn công bẻ khóa và tạo ra nội dung không mong muốn. Khả năng giám sát rủi ro và an toàn cho phép các nhà phát triển phát hiện các đầu vào của mô hình có vấn đề và có khả năng kích hoạt nội dung gây ảo giác hoặc không mong muốn, để họ có thể triển khai các biện pháp giảm thiểu nội dung đó.

Bird của Microsoft cho biết: “Generative AI có thể là nguồn nhân lực cho mọi bộ phận, công ty và ngành công nghiệp”. “Đồng thời, các mô hình nền tảng đưa ra những thách thức mới về an ninh và an toàn đòi hỏi phải có các biện pháp giảm nhẹ mới và học hỏi liên tục.”

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://www.darkreading.com/application-security/microsoft-adds-tools-for-protecting-against-prompt-injection-other-threats-in-azure-ai

- : có

- :là

- :không phải

- $ LÊN

- 000

- 1

- 2023

- 29

- 7

- a

- Giới thiệu

- đẩy nhanh tiến độ

- Theo

- Hành động

- tích cực

- diễn viên

- thêm

- thêm

- địa chỉ

- chống lại

- AI

- Mô hình AI

- Hệ thống AI

- Tất cả

- cho phép

- Đã

- Ngoài ra

- đàn bà gan dạ

- trong số

- an

- và

- công bố

- Một

- bất kì

- xuất hiện

- các ứng dụng

- ứng dụng

- LÀ

- AS

- đánh giá

- trợ lý

- At

- Các cuộc tấn công

- có sẵn

- Azure

- Về cơ bản

- BE

- trở nên

- trở thành

- trước

- Bắt đầu

- hành vi

- giữa

- Blog

- cả hai

- chương trình

- xây dựng

- xây dựng

- xây dựng

- nhưng

- by

- Cuộc gọi

- CAN

- khả năng

- khả năng

- xe hơi

- thách thức

- kiểm tra

- chánh

- giám đốc sản phẩm

- tốt nghiệp lớp XNUMX

- Rõ ràng

- mã

- công ty

- hoàn toàn

- Mối quan tâm

- khó khăn

- nội dung

- tiếp tục

- liên tục

- có thể

- Hiện nay

- khách hàng

- Nguy hiểm

- dữ liệu

- phòng thủ

- định nghĩa

- bộ

- triển khai

- thiết kế

- phát hiện

- Phát hiện

- phát triển

- Phát triển

- phân biệt

- lái xe

- dễ dàng hơn

- mới nổi

- nhân viên

- cuối

- thuê

- Kỹ Sư

- đảm bảo

- Môi trường

- lỗi

- đánh giá

- Mỗi

- ví dụ

- hiện tại

- Đối mặt

- thực tế

- yếu tố

- Thời trang

- Đặc tính

- Tính năng

- vài

- bộ lọc

- năm

- Trong

- Buộc

- định dạng

- Cựu

- tìm thấy

- Nền tảng

- từ

- tương lai

- nói chung

- tạo ra

- tạo ra

- thế hệ

- Trí tuệ nhân tạo

- được

- Cho

- mục tiêu

- lớn hơn

- căn cứ

- Phát triển

- có hại

- Có

- giúp đỡ

- giúp đỡ

- nổi bật

- tổ chức

- host

- Độ đáng tin của

- Hướng dẫn

- HTTPS

- cực kỳ

- IBM

- if

- thực hiện

- in

- Bao gồm

- Tăng lên

- ngành công nghiệp

- thông tin

- đầu vào

- đầu vào

- ví dụ

- hướng dẫn

- tích hợp

- dự định

- quan tâm

- trong

- giới thiệu

- giới thiệu

- Đầu Tư

- isn

- IT

- ITS

- Jailbreak

- jpg

- Biết

- nổi tiếng

- Ngôn ngữ

- lớn

- học tập

- Có khả năng

- hạn chế

- LLM

- máy

- học máy

- thực hiện

- chính

- độc hại

- Thao tác

- cách thức

- nhiều

- Tháng Ba

- dấu

- thị trường

- đánh dấu

- Trong khi đó

- tin nhắn

- tin nhắn

- Siêu dữ liệu

- Metrics

- microsoft

- Might

- giảm nhẹ

- Chế độ

- kiểu mẫu

- mô hình

- giám sát

- chi tiết

- hầu hết

- Gần

- Mới

- mới

- tiếp theo

- tiểu thuyết

- Tháng mười một

- Nvidia

- of

- Cung cấp

- Cung cấp

- Nhân viên văn phòng

- on

- OpenAI

- or

- cơ quan

- tổ chức

- Nền tảng khác

- ra

- đầu ra

- kết quả đầu ra

- kết thúc

- riêng

- qua

- riêng

- lập kế hoạch

- nền tảng

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- hợp lý

- người chơi

- Bài đăng

- có khả năng

- Xem trước

- chính

- vấn đề

- Sản phẩm

- Hồ sơ

- nhắc nhở

- bảo vệ

- cho

- chất lượng

- Mau

- gần đây

- gần đây

- giảm

- coi

- độ tin cậy

- đáng tin cậy

- yêu cầu

- nhà nghiên cứu

- đàn hồi

- phản ứng

- chịu trách nhiệm

- kết quả

- Kết quả

- Nguy cơ

- thường xuyên

- s

- Sự An Toàn

- Nói

- tương tự

- nói

- Tìm kiếm

- an ninh

- định

- một số

- nên

- thể hiện

- có ý nghĩa

- tương tự

- So

- Phần mềm

- phát triển phần mềm

- một số

- sớm

- nguồn

- riêng

- báo cáo

- Trạng thái

- chỉ đạo

- phòng thu

- Học tập

- như vậy

- tăng

- hệ thống

- hệ thống

- Hãy

- Tập

- Công nghệ

- Công nghệ

- nói

- xu hướng

- thử nghiệm

- văn bản

- hơn

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- họ

- mối đe dọa

- diễn viên đe dọa

- các mối đe dọa

- thời gian

- đến

- công cụ

- Hội thảo

- kích hoạt

- NIỀM TIN

- thử

- khám phá

- để hở

- Bất ngờ

- trên

- Sử dụng

- sử dụng

- người sử dang

- Người sử dụng

- sử dụng

- hợp lệ

- dễ bị tổn thương

- Dễ bị tổn thương

- muốn

- Đường..

- cách

- là

- Điều gì

- cái nào

- sẽ

- với

- khắp thế giới

- năm

- năm

- nhưng

- zephyrnet