Trong nghiên cứu đầu tiên thuộc loại này, công ty trí tuệ nhân tạo (AI) Anthropic đã phát triển một mô hình ngôn ngữ lớn (LLM) được tinh chỉnh để cộng đồng người dùng có thể đánh giá giá trị.

Việc phát triển AI dân chủ hơn có ý nghĩa gì? Để tìm hiểu, chúng tôi đã hợp tác với @collect_intel sử dụng @usepolis để quản lý hiến pháp AI dựa trên ý kiến của ~ 1000 người Mỹ. Sau đó, chúng tôi đã đào tạo một mô hình chống lại nó bằng AI Hiến pháp. pic.twitter.com/ZKaXw5K9sU

– Nhân loại (@AnthropicAI) 17 Tháng Mười

Nhiều LLM công khai đã được phát triển với các rào chắn - các hướng dẫn được mã hóa chỉ ra hành vi cụ thể - nhằm cố gắng hạn chế các kết quả đầu ra không mong muốn. Ví dụ: Claude của Anthropic và ChatGPT của OpenAI thường cung cấp cho người dùng phản hồi an toàn soạn sẵn đối với các yêu cầu đầu ra liên quan đến chủ đề bạo lực hoặc gây tranh cãi.

Tuy nhiên, như vô số chuyên gia đã chỉ ra, các rào chắn và các kỹ thuật can thiệp khác có thể dùng để cướp quyền của người dùng. Những gì được coi là có thể chấp nhận được không phải lúc nào cũng hữu ích và những gì được coi là hữu ích không phải lúc nào cũng được chấp nhận. Và các định nghĩa về đạo đức hoặc đánh giá dựa trên giá trị có thể khác nhau giữa các nền văn hóa, dân số và thời kỳ.

Một giải pháp khả thi cho vấn đề này là cho phép người dùng ra lệnh căn chỉnh giá trị cho các mô hình AI. Thử nghiệm “AI hiến pháp tập thể” của Anthropic là một cú đâm vào “thử thách lộn xộn” này.

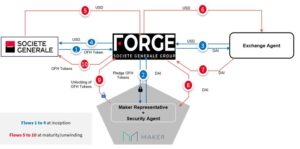

Anthropic, phối hợp với Polis và Dự án Trí tuệ Tập thể, đã khai thác 1,000 người dùng thuộc nhiều nhóm nhân khẩu học khác nhau và yêu cầu họ trả lời một loạt câu hỏi thông qua bỏ phiếu.

Thách thức xoay quanh việc cho phép người dùng mà cơ quan xác định điều gì là phù hợp mà không khiến họ gặp phải những kết quả đầu ra không phù hợp. Điều này liên quan đến việc thu hút các giá trị của người dùng và sau đó triển khai những ý tưởng đó vào một mô hình đã được đào tạo.

Anthropic sử dụng một phương pháp gọi là “AI hiến pháp” để trực tiếp nỗ lực của nó trong việc điều chỉnh LLM để đảm bảo an toàn và hữu ích. Về cơ bản, điều này liên quan đến việc cung cấp cho mô hình một danh sách các quy tắc mà nó phải tuân theo và sau đó đào tạo nó để thực hiện các quy tắc đó trong suốt quá trình của nó, giống như hiến pháp đóng vai trò là tài liệu cốt lõi cho quản trị ở nhiều quốc gia.

Trong thử nghiệm AI về Hiến pháp tập thể, Anthropic đã cố gắng tích hợp phản hồi dựa trên nhóm vào hiến pháp của mô hình. Kết quả, theo đối với một bài đăng trên blog của Anthropic, dường như đã là một thành công về mặt khoa học ở chỗ nó làm sáng tỏ những thách thức tiếp theo nhằm đạt được mục tiêu cho phép người dùng sản phẩm LLM xác định các giá trị chung của họ.

Một trong những khó khăn mà nhóm phải vượt qua là tìm ra một phương pháp mới cho quy trình đo điểm chuẩn. Vì thử nghiệm này dường như là thử nghiệm đầu tiên thuộc loại này và nó dựa trên phương pháp AI Hiến pháp của Anthropic, nên không có thử nghiệm nào được thiết lập để so sánh các mô hình cơ sở với các mô hình được điều chỉnh bằng các giá trị có nguồn gốc từ cộng đồng.

Cuối cùng, có vẻ như mô hình triển khai dữ liệu thu được từ phản hồi thăm dò ý kiến của người dùng đã vượt trội hơn mô hình cơ sở “một chút” trong lĩnh vực đầu ra sai lệch.

Theo bài đăng trên blog:

“Hơn cả mô hình thu được, chúng tôi rất hào hứng với quá trình này. Chúng tôi tin rằng đây có thể là một trong những trường hợp đầu tiên trong đó các thành viên của công chúng, với tư cách là một nhóm, cố tình chỉ đạo hành vi của một mô hình ngôn ngữ lớn. Chúng tôi hy vọng rằng các cộng đồng trên khắp thế giới sẽ dựa trên những kỹ thuật như thế này để đào tạo các mô hình phù hợp với bối cảnh và văn hóa cụ thể phục vụ nhu cầu của họ.”

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://cointelegraph.com/news/antropic-democratic-ai-chatbot-by-letting-users-vote-for-its-values

- : có

- :là

- $ LÊN

- 000

- 1

- 17

- a

- Giới thiệu

- chấp nhận được

- đạt được

- ngang qua

- chống lại

- cơ quan

- AI

- Chatbot AI

- Mô hình AI

- liên kết

- cho phép

- Cho phép

- Đã

- luôn luôn

- Mỹ

- an

- và

- trả lời

- nhân loại

- xuất hiện

- xuất hiện

- thích hợp

- KHU VỰC

- xung quanh

- nhân tạo

- trí tuệ nhân tạo

- Trí tuệ nhân tạo (AI)

- AS

- At

- nỗ lực

- đã cố gắng

- cơ sở

- dựa

- BE

- được

- hành vi

- Tin

- điểm chuẩn

- giữa

- có thành kiến

- Blog

- xây dựng

- xây dựng

- by

- gọi là

- CAN

- Trung tâm

- thách thức

- thách thức

- chatbot

- ChatGPT

- Cointelegraph

- hợp tác

- Tập thể

- đến

- Cộng đồng

- cộng đồng

- so sánh

- xem xét

- Hiến pháp

- gây tranh cãi

- Trung tâm

- dữ liệu

- các định nghĩa

- dân chủ

- Nhân khẩu học

- Xác định

- phát triển

- Phát triển

- ra lệnh

- khó khăn

- đạo diễn

- khác nhau

- tài liệu

- làm

- những nỗ lực

- chủ yếu

- thành lập

- ví dụ

- kích thích

- thử nghiệm

- thông tin phản hồi

- Tìm kiếm

- Công ty

- Tên

- Trong

- từ

- xa hơn

- Cho

- Cho

- mục tiêu

- quản trị

- Nhóm

- có

- Có

- mong

- HTTPS

- ý tưởng

- thực hiện

- thực hiện

- thực hiện

- in

- hướng dẫn

- tích hợp

- Sự thông minh

- cố ý

- trong

- tham gia

- IT

- ITS

- jpg

- bản án

- Loại

- Ngôn ngữ

- lớn

- để

- Lượt thích

- LIMIT

- Danh sách

- LLM

- nhiều

- Có thể..

- nghĩa là

- Các thành viên

- phương pháp

- Phương pháp luận

- kiểu mẫu

- mô hình

- đạo đức

- chi tiết

- nhiều

- phải

- Quốc

- nhu cầu

- tiểu thuyết

- Tháng mười một

- of

- on

- ONE

- Ý kiến

- or

- Nền tảng khác

- ra

- vượt trội

- đầu ra

- kết quả đầu ra

- Vượt qua

- hợp tác

- kinh nguyệt

- Nơi

- kế hoạch

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- có thể

- Bài đăng

- tiềm năng

- quá trình

- Sản phẩm

- dự án

- công khai

- Câu hỏi

- liên quan

- yêu cầu

- phản ứng

- kết quả

- Kết quả

- cướp

- quy tắc

- Sự An Toàn

- khoa học

- Loạt Sách

- phục vụ

- phục vụ

- riêng

- Học tập

- thành công

- Khai thác

- Mục tiêu

- nhóm

- kỹ thuật

- thử nghiệm

- hơn

- việc này

- Sản phẩm

- Khu vực

- thế giới

- cung cấp their dịch

- Them

- sau đó

- Đó

- điều này

- những

- Tuy nhiên?

- các mối đe dọa

- khắp

- thời gian

- đến

- Chủ đề

- đối với

- Train

- đào tạo

- Hội thảo

- thường

- không mong muốn

- sử dụng

- người sử dang

- Người sử dụng

- sử dụng

- sử dụng

- giá trị

- dựa trên giá trị

- Các giá trị

- thông qua

- Bỏ phiếu

- là

- we

- Điều gì

- cái nào

- sẽ

- với

- không có

- thế giới

- zephyrnet