Sự phát triển và tiến bộ của AI đã tăng theo cấp số nhân trong vài năm qua. Báo cáo của Statista rằng đến năm 2024, thị trường AI toàn cầu sẽ tạo ra doanh thu đáng kinh ngạc khoảng 3000 tỷ đô la, so với 126 tỷ đô la vào năm 2015. Tuy nhiên, các nhà lãnh đạo công nghệ hiện đang cảnh báo chúng ta về những rủi ro khác nhau của AI.

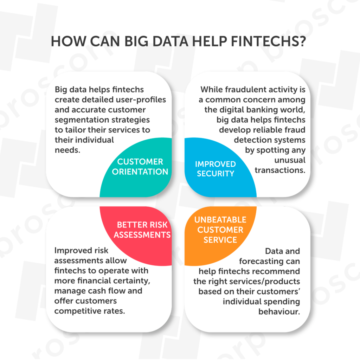

Đặc biệt, làn sóng gần đây của trí tuệ nhân tạo các mô hình như ChatGPT đã giới thiệu các khả năng mới trong các lĩnh vực nhạy cảm với dữ liệu khác nhau, chẳng hạn như chăm sóc sức khỏe, giáo dục, tài chính, v.v. Những phát triển được hỗ trợ bởi AI này dễ bị tổn thương do nhiều thiếu sót của AI mà các tác nhân độc hại có thể phơi bày.

Hãy thảo luận xem các chuyên gia AI đang nói gì về những phát triển gần đây và nêu bật những rủi ro tiềm ẩn của AI. Chúng tôi cũng sẽ đề cập ngắn gọn về cách quản lý những rủi ro này.

Các nhà lãnh đạo công nghệ và mối quan tâm của họ liên quan đến rủi ro của AI

Geoffrey Hinton

Geoffrey Hinton – một nhà lãnh đạo công nghệ AI nổi tiếng (và là cha đỡ đầu của lĩnh vực này), người gần đây đã rời Google, đã nói lên mối quan tâm của anh ấy về sự phát triển nhanh chóng của AI và những nguy cơ tiềm ẩn của nó. Hinton tin rằng các chatbot AI có thể trở nên “khá đáng sợ” nếu chúng vượt qua trí thông minh của con người.

Hinton nói:

“Ngay bây giờ, những gì chúng ta đang thấy là những thứ như GPT-4 làm lu mờ một người về lượng kiến thức chung mà nó có, và nó làm lu mờ họ trong một thời gian dài. Về mặt suy luận thì không tốt bằng nhưng nó đã làm được suy luận đơn giản rồi. Và với tốc độ tiến triển, chúng tôi hy vọng mọi thứ sẽ trở nên tốt hơn khá nhanh. Vì vậy, chúng ta cần phải lo lắng về điều đó.”

Hơn nữa, anh ấy tin rằng “những kẻ xấu” có thể sử dụng AI cho “những điều xấu”, chẳng hạn như cho phép rô bốt thực hiện các mục tiêu phụ của chúng. Bất chấp những lo ngại của mình, Hinton tin rằng AI có thể mang lại những lợi ích ngắn hạn, nhưng chúng ta cũng nên đầu tư nhiều vào sự an toàn và kiểm soát của AI.

Elon Musk

Sự tham gia của Elon Musk vào AI bắt đầu với khoản đầu tư ban đầu của ông vào Deepmind vào năm 2010, để đồng sáng lập OpenAI và kết hợp AI vào các phương tiện tự trị của Tesla.

Mặc dù rất nhiệt tình với AI, nhưng anh ấy thường xuyên bày tỏ lo ngại về những rủi ro của AI. Musk nói rằng các hệ thống AI mạnh mẽ có thể nguy hiểm cho nền văn minh hơn là vũ khí hạt nhân. Trong một cuộc phỏng vấn tại Fox News vào tháng 2023 năm XNUMX, anh ấy nói:

“AI nguy hiểm hơn, ví dụ, quản lý sai thiết kế máy bay hoặc bảo trì sản xuất hoặc sản xuất ô tô tồi. Theo nghĩa là nó có tiềm năng — tuy nhiên, một người nhỏ có thể coi xác suất đó — nhưng nó không tầm thường và có khả năng hủy diệt nền văn minh.”

Hơn nữa, Musk ủng hộ các quy định của chính phủ về AI để đảm bảo an toàn trước những rủi ro tiềm ẩn, mặc dù “điều đó chẳng thú vị chút nào”.

Tạm dừng các thử nghiệm AI khổng lồ: Một bức thư ngỏ được hỗ trợ bởi hàng nghìn chuyên gia AI

Viện Tương lai của Cuộc sống đã công bố một bức thư ngỏ vào ngày 22 tháng 2023 năm XNUMX. Bức thư kêu gọi tạm dừng sáu tháng trên Phát triển hệ thống AI tiên tiến hơn hơn GPT-4. Các tác giả bày tỏ lo ngại về tốc độ phát triển của các hệ thống AI đang đặt ra những thách thức kinh tế xã hội nghiêm trọng.

Hơn nữa, bức thư nói rằng các nhà phát triển AI nên làm việc với các nhà hoạch định chính sách để ghi lại các hệ thống quản trị AI. Tính đến tháng 2023 năm 31,000, bức thư đã được ký bởi hơn XNUMX nhà phát triển AI, chuyên gia và lãnh đạo công nghệ. Những người ký tên đáng chú ý bao gồm Elon Musk, Steve Wozniak (Đồng sáng lập Apple), Emad Mostaque (CEO, Stability AI), Yoshua Bengio (người đoạt giải Turing), và nhiều người khác.

Lập luận ngược lại về việc ngừng phát triển AI

Hai nhà lãnh đạo AI nổi bật, Andrew Ng và Yann LeCun, đã phản đối lệnh cấm phát triển các hệ thống AI tiên tiến trong sáu tháng và coi việc tạm dừng là một ý tưởng tồi.

Ng nói rằng mặc dù AI có một số rủi ro, chẳng hạn như sự thiên vị, sự tập trung quyền lực, v.v. Nhưng giá trị do AI tạo ra trong các lĩnh vực như giáo dục, chăm sóc sức khỏe và huấn luyện đáp ứng là rất lớn.

Yann LeCun nói rằng không nên ngừng nghiên cứu và phát triển, mặc dù các sản phẩm AI đến tay người dùng cuối có thể được điều chỉnh.

Những mối nguy hiểm tiềm tàng và rủi ro trước mắt của AI là gì?

1. Thay đổi công việc

Các chuyên gia AI tin rằng các hệ thống AI thông minh có thể thay thế các nhiệm vụ nhận thức và sáng tạo. Ngân hàng đầu tư Goldman Sachs ước tính rằng khoảng Hàng triệu việc làm sẽ được tự động hóa bởi AI tổng quát.

Do đó, cần có những quy định về phát triển AI để nó không gây ra suy thoái kinh tế nghiêm trọng. Nên có các chương trình giáo dục để nâng cao kỹ năng và đào tạo lại nhân viên để đối phó với thách thức này.

2. Hệ thống AI thiên vị

Xu hướng phổ biến giữa con người về giới tính, chủng tộc hoặc màu da có thể vô tình thấm vào dữ liệu được sử dụng để đào tạo hệ thống AI, sau đó khiến hệ thống AI trở nên sai lệch.

Chẳng hạn, trong bối cảnh tuyển dụng việc làm, một hệ thống AI thiên vị có thể loại bỏ hồ sơ của các cá nhân có nguồn gốc dân tộc cụ thể, tạo ra sự phân biệt đối xử trong thị trường việc làm. TRONG thực thi pháp luật, chính sách dự đoán thiên vị có thể nhắm mục tiêu không tương xứng vào các vùng lân cận hoặc nhóm nhân khẩu học cụ thể.

Do đó, điều cần thiết là phải có một chiến lược dữ liệu toàn diện để giải quyết các rủi ro AI, đặc biệt là sai lệch. Các hệ thống AI phải được đánh giá và kiểm toán thường xuyên để đảm bảo tính công bằng.

3. Các ứng dụng AI quan trọng về an toàn

Xe tự lái, chẩn đoán và điều trị y tế, hệ thống hàng không, điều khiển nhà máy điện hạt nhân, v.v., đều là những ví dụ về các ứng dụng AI quan trọng về mặt an toàn. Các hệ thống AI này nên được phát triển một cách thận trọng vì ngay cả những lỗi nhỏ cũng có thể gây ra hậu quả nghiêm trọng đối với cuộc sống con người hoặc môi trường.

Chẳng hạn, sự cố của phần mềm AI có tên Hệ thống tăng cường đặc tính cơ động (MCAS) một phần là do vụ tai nạn của hai chiếc Boeing 737 MAX, lần đầu tiên vào tháng 2018 năm 2019 và sau đó là vào tháng 346 năm XNUMX. Đáng buồn thay, hai vụ tai nạn đã giết chết XNUMX người.

Làm thế nào chúng ta có thể vượt qua những rủi ro của hệ thống AI? – Phát triển AI có trách nhiệm & Tuân thủ quy định

AI có trách nhiệm (RAI) có nghĩa là phát triển và triển khai các hệ thống AI công bằng, có trách nhiệm giải trình, minh bạch và an toàn, đảm bảo quyền riêng tư và tuân thủ các quy định pháp luật cũng như chuẩn mực xã hội. Việc triển khai RAI có thể phức tạp do sự phát triển rộng rãi và nhanh chóng của hệ thống AI.

Tuy nhiên, các công ty công nghệ lớn đã phát triển các khung RAI, chẳng hạn như:

Các phòng thí nghiệm AI trên toàn cầu có thể lấy cảm hứng từ những nguyên tắc này hoặc phát triển các khuôn khổ AI có trách nhiệm của riêng họ để tạo ra các hệ thống AI đáng tin cậy.

Tuân thủ quy định AI

Vì dữ liệu là một thành phần không thể thiếu của hệ thống AI, nên các tổ chức và phòng thí nghiệm dựa trên AI phải tuân thủ các quy định sau để đảm bảo bảo mật, quyền riêng tư và an toàn cho dữ liệu.

-

GDPR (Quy định chung về bảo vệ dữ liệu) – khung bảo vệ dữ liệu của EU.

-

CCPA (Đạo luật về quyền riêng tư của người tiêu dùng California) – một đạo luật của tiểu bang California về quyền riêng tư và bảo vệ người tiêu dùng.

-

HIPAA (Đạo luật về trách nhiệm giải trình và cung cấp bảo hiểm y tế) – một đạo luật của Hoa Kỳ bảo vệ dữ liệu y tế của bệnh nhân.

-

Đạo luật AI của EUvà Hướng dẫn đạo đức cho AI đáng tin cậy – một quy định AI của Ủy ban Châu Âu.

Có nhiều luật khu vực và địa phương được ban hành bởi các quốc gia khác nhau để bảo vệ công dân của họ. Các tổ chức không đảm bảo tuân thủ quy định về dữ liệu có thể bị phạt nặng. Chẳng hạn, GDPR đã đặt ra mức phạt là €20 triệu hoặc 4% lợi nhuận hàng năm đối với các hành vi vi phạm nghiêm trọng như xử lý dữ liệu bất hợp pháp, sự đồng ý về dữ liệu chưa được chứng minh, vi phạm quyền của chủ thể dữ liệu hoặc chuyển dữ liệu không được bảo vệ cho một thực thể quốc tế.

Quy định & Phát triển AI – Hiện tại & Tương lai

Cứ mỗi tháng trôi qua, những tiến bộ của AI đang đạt đến những đỉnh cao chưa từng thấy. Tuy nhiên, các quy định và khuôn khổ quản trị AI đi kèm đang bị chậm trễ. Họ cần phải mạnh mẽ và cụ thể hơn.

Các nhà lãnh đạo công nghệ và nhà phát triển AI đã gióng lên hồi chuông cảnh báo về những rủi ro của AI nếu không được quản lý đầy đủ. Nghiên cứu và phát triển AI có thể mang lại nhiều giá trị hơn nữa trong nhiều lĩnh vực, nhưng rõ ràng là việc điều chỉnh cẩn thận hiện nay là bắt buộc.

Liên kết: https://www.unite.ai/tech-leaders-highlighting-the-risks-of-ai-the-urgency-of-robust-ai-regulation/?utm_source=pocket_saves

Nguồn: https://www.unite.ai

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- EVM tài chính. Giao diện hợp nhất cho tài chính phi tập trung. Truy cập Tại đây.

- Tập đoàn truyền thông lượng tử. Khuếch đại IR/PR. Truy cập Tại đây.

- PlatoAiStream. Thông minh dữ liệu Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- nguồn: https://www.fintechnews.org/tech-leaders-highlighting-the-risks-of-ai-the-urgency-of-robust-ai-regulation/

- : có

- :là

- :không phải

- 000

- 2015

- 2018

- 2019

- 2023

- 2024

- 31

- 7

- a

- Giới thiệu

- trách nhiệm

- trách nhiệm

- ngang qua

- Hành động

- địa chỉ

- đầy đủ

- tiên tiến

- tiến bộ

- đại lý

- AI

- Quản trị AI

- máy bay

- Tất cả

- Cho phép

- Đã

- Ngoài ra

- Mặc dù

- trong số

- số lượng

- an

- và

- hàng năm

- Apple

- các ứng dụng

- Tháng Tư

- LÀ

- đối số

- xung quanh

- AS

- kiểm toán

- tác giả

- Tự động

- tự trị

- xe tự trị

- hàng không

- được hậu thuẫn

- nền

- Bad

- Ban

- Ngân hàng

- bbc

- BE

- bởi vì

- trở nên

- được

- bắt đầu

- được

- Tin

- tin

- Lợi ích

- Hơn

- thiên vị

- có thành kiến

- lớn

- công nghệ lớn

- Tỷ

- Boeing

- một thời gian ngắn

- mang lại

- rộng

- nhưng

- by

- CA

- california

- Cuộc gọi

- CAN

- khả năng

- xe hơi

- cẩn thận

- Nguyên nhân

- thận trọng

- CDC

- giám đốc điều hành

- thách thức

- thách thức

- đặc điểm

- chatbot

- ChatGPT

- Công dân

- Nền văn minh

- trong sáng

- Đồng sáng lập

- huấn luyện

- nhận thức

- màu sắc

- hoa hồng

- Các công ty

- so

- phức tạp

- tuân thủ

- tuân theo

- thành phần

- toàn diện

- tập trung

- Mối quan tâm

- đồng ý

- Hậu quả

- xem xét

- người tiêu dùng

- quyền riêng tư của người tiêu dùng

- Sự bảo vệ người tiêu dùng

- bối cảnh

- điều khiển

- có thể

- nước

- Crash

- tạo ra

- Tạo

- Sáng tạo

- Nguy hiểm

- nguy hiểm

- dữ liệu

- xử lý dữ liệu

- bảo vệ dữ liệu

- bảo mật dữ liệu

- chiến lược dữ liệu

- nhiều

- Deepmind

- nhân khẩu học

- triển khai

- Thiết kế

- Mặc dù

- phát triển

- phát triển

- phát triển

- phát triển

- Phát triển

- phát triển

- khác nhau

- thảo luận

- do

- tài liệu

- tài liệu ai

- làm

- Không

- XUỐNG

- hai

- Đầu

- EC

- Kinh tế

- suy thoái kinh tế

- Đào tạo

- Tư vấn Giáo dục

- Elon

- Elon Musk

- nhân viên

- đảm bảo

- nhiệt tình

- thực thể

- Môi trường

- lỗi

- thiết yếu

- dự toán

- vv

- đạo đức

- EU

- Châu Âu

- Châu Âu

- Ủy ban châu Âu

- đánh giá

- Ngay cả

- Mỗi

- ví dụ

- mong đợi

- thí nghiệm

- các chuyên gia

- các chuyên gia tin rằng

- số mũ

- thể hiện

- FAIL

- công bằng

- nổi tiếng

- NHANH

- vài

- lĩnh vực

- Lĩnh vực

- cuối

- Tên

- theo

- tiếp theo

- Trong

- Forbes

- Khung

- khung

- thường xuyên

- từ

- vui vẻ

- xa hơn

- GDPR

- Giới Tính

- Tổng Quát

- dữ liệu chung

- Quy định về bảo vệ dữ liệu chung

- tạo ra

- thế hệ

- Trí tuệ nhân tạo

- được

- khổng lồ

- được

- Toàn cầu

- toàn cầu

- goldman

- Goldman Sachs

- tốt

- quản trị

- Chính phủ

- Các nhóm

- Tăng trưởng

- hướng dẫn

- tạm dừng

- Có

- he

- cho sức khoẻ

- bảo hiểm y tế

- chăm sóc sức khỏe

- nặng nề

- chiều cao

- Đánh dấu

- làm nổi bật

- của mình

- Độ đáng tin của

- Tuy nhiên

- HTTPS

- Nhân loại

- trí tuệ con người

- IBM

- ý tưởng

- if

- lập tức

- bắt buộc

- thực hiện

- in

- bao gồm

- kết hợp

- các cá nhân

- Cảm hứng

- ví dụ

- Viện

- bảo hiểm

- thiếu

- Sự thông minh

- Thông minh

- Quốc Tế

- Phỏng vấn

- trong

- giới thiệu

- Đầu tư

- đầu tư

- sự tham gia

- IT

- ITS

- Việc làm

- jpg

- tháng sáu

- Giữ

- kiến thức

- Phòng thí nghiệm

- tụt hậu

- Luật

- lãnh đạo

- các nhà lãnh đạo

- trái

- Hợp pháp

- Pháp luật

- bức thư

- Cuộc sống

- Lượt thích

- địa phương

- dài

- bảo trì

- làm cho

- Làm

- quản lý

- nhiều

- Tháng Ba

- thị trường

- tối đa

- max-width

- Có thể..

- có nghĩa

- y khoa

- dữ liệu y tế

- microsoft

- triệu

- nhỏ

- mô hình

- tháng

- tháng

- chi tiết

- Xạ hương

- phải

- Cần

- Mới

- Nổi bật

- tại

- hạt nhân

- Điện hạt nhân

- Tháng Mười

- of

- on

- ONE

- mở

- phản đối

- or

- tổ chức

- kết thúc

- Vượt qua

- riêng

- Hòa bình

- một phần

- đặc biệt

- Đi qua

- qua

- tạm dừng

- người

- người

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- bảo vệ

- các nhà hoạch định chính sách

- đặt ra

- tiềm năng

- quyền lực

- mạnh mẽ

- trình bày

- thịnh hành

- nguyên tắc

- riêng tư

- giải thưởng

- xử lý

- Sản lượng

- Sản phẩm

- Khóa Học

- Tiến độ

- nổi bật

- bảo vệ

- bảo vệ

- công bố

- Cuộc đua

- tăng giá

- nhanh

- Tỷ lệ

- đạt

- đạt

- gần đây

- gần đây

- tuyển dụng

- coi

- khu vực

- quy định

- Quy định

- quy định

- nhà quản lý

- Tuân thủ quy định

- liên quan

- tương đối

- thay thế

- nghiên cứu

- nghiên cứu và phát triển

- chịu trách nhiệm

- đáp ứng

- kết quả

- doanh thu

- ngay

- quyền

- rủi ro

- robot

- mạnh mẽ

- s

- Sachs

- biện pháp bảo vệ

- Sự An Toàn

- Nói

- nói

- nói

- nói

- Ngành

- an toàn

- an ninh

- nhìn thấy

- ý nghĩa

- nghiêm trọng

- định

- nghiêm trọng

- thời gian ngắn

- thiếu sót

- nên

- Người ký

- Ký kết

- Đơn giản

- Six

- Sáu tháng

- nhỏ

- So

- xã hội

- kinh tế xã hội

- Phần mềm

- một số

- riêng

- Tính ổn định

- Tiểu bang

- Bang

- Steve

- Steve Wozniak

- dừng lại

- Chiến lược

- Sau đó

- như vậy

- Hỗ trợ

- vượt qua

- hệ thống

- hệ thống

- Hãy

- Mục tiêu

- nhiệm vụ

- công nghệ cao

- công ty công nghệ cao

- tạm thời

- về

- hơn

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- sau đó

- Đó

- Kia là

- họ

- điều

- điều này

- đến

- chạm

- Hội thảo

- chuyển

- minh bạch

- điều trị

- kinh hai

- đáng tin cậy

- đáng tin cậy

- Turing

- hai

- chúng tôi

- chưa từng có

- khẩn cấp

- us

- sử dụng

- đã sử dụng

- giá trị

- khác nhau

- Xe cộ

- SỰ VI PHẠM

- Dễ bị tổn thương

- cảnh báo

- Sóng

- Đường..

- we

- Vũ khí

- Điều gì

- cái nào

- CHÚNG TÔI LÀ

- sẽ

- người chiến thắng

- với

- Công việc

- lo

- năm

- youtube

- zephyrnet