Giới thiệu

Tuyển dụng là một ngành công nghiệp trị giá 200 tỷ đô la trên toàn cầu với hàng triệu người tải lên hồ sơ và xin việc hàng ngày trên hàng nghìn nền tảng việc làm. Các doanh nghiệp có các cơ hội mở của họ được liệt kê trên các nền tảng này và những người tìm việc đến nộp hồ sơ. Mỗi doanh nghiệp đều có một bộ phận tuyển dụng chuyên trách xem xét hồ sơ ứng viên theo cách thủ công và trích xuất dữ liệu liên quan để xem họ có phù hợp hay không.

💡

Khi mọi người sáng tạo với sơ yếu lý lịch của mình về phong cách và cách trình bày, việc tự động trích xuất dữ liệu từ những sơ yếu lý lịch này rất khó và nó chủ yếu vẫn là công việc thủ công. Một số nghiên cứu chỉ cho thấy 1% hồ sơ ứng viên trên các cổng thông tin việc làm này được chuyển sang giai đoạn tiếp theo. Vì vậy, chúng ta đang nói về việc lãng phí hàng giờ đồng hồ để xem xét các bản lý lịch thậm chí không có bộ kỹ năng cơ bản cần thiết.

Tình huống từ lăng kính của người tìm việc cũng không lý tưởng. Bạn có 50 cổng thông tin việc làm khác nhau như Monster hoặc Indeed, nơi bạn phải tạo hồ sơ mới mỗi lần. Sau đó, bạn phải đi xuống hố thỏ để tìm vai trò (vần mà!) phù hợp và danh sách dường như không bao giờ kết thúc. Bạn luôn cảm thấy không hài lòng vì có thể có nhiều việc làm hơn ở đây và bạn nên tìm hiểu sâu hơn. Bạn cũng đăng ký nhận bản tin email để gửi cho bạn những công việc không phù hợp nhất hiện có.

Vì vậy, câu hỏi đặt ra ở đây là, chúng tôi thực hiện quy trình trích xuất thông tin sơ yếu lý lịch này như thế nào, thông minh hơn và tốt hơn? Điều gì sẽ xảy ra nếu hệ thống có thể tự động từ chối những ứng viên có bộ kỹ năng trong hồ sơ của họ không đáp ứng tiêu chí? Điều gì sẽ xảy ra nếu bạn với tư cách là người tìm việc chỉ cần tải lên sơ yếu lý lịch của mình và được hiển thị chính xác tất cả các công việc liên quan?

Trong bài viết này, chúng tôi mong muốn giải quyết vấn đề chính xác này. Chúng ta sẽ xem xét đi sâu vào cách chúng ta có thể tận dụng deep learning và OCR để Tiếp tục phân tích cú pháp.

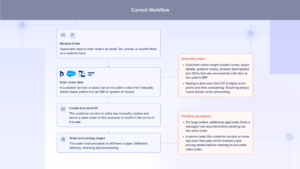

Tự động hóa quy trình phân tích sơ yếu lý lịch của bạn. Xây dựng trình phân tích cú pháp sơ yếu lý lịch tùy chỉnh với Nanonets.

Một hệ thống lý tưởng để lọc hồ sơ

Hãy cố gắng thiết kế một hệ thống lý tưởng cho một hệ thống trích xuất dữ liệu thông minh để lọc sơ yếu lý lịch.

Sơ yếu lý lịch của người nộp đơn có các định dạng khác nhau về cách trình bày, thiết kế, phông chữ và bố cục. Một hệ thống lý tưởng nên trích xuất thông tin sâu sắc hoặc nội dung bên trong những bản lý lịch này càng nhanh càng tốt và giúp ích cho nhà tuyển dụng dù họ trông như thế nào vì chúng chứa đựng những phẩm chất cần thiết như kinh nghiệm, kỹ năng, thành tích học tập xuất sắc của ứng viên. Ngoài ra, trong trường hợp ngược lại, ứng viên có thể tải sơ yếu lý lịch lên nền tảng danh sách việc làm như Monster hoặc Indeed và nhận các công việc phù hợp được hiển thị cho họ ngay lập tức và thậm chí xa hơn nữa khi thông báo qua email về công việc mới.

Phân tích cú pháp tiếp tục là gì

It chuyển đổi một dạng dữ liệu sơ yếu lý lịch không có cấu trúc thành định dạng có cấu trúc. Đó là một chương trình phân tích và trích xuất dữ liệu sơ yếu lý lịch/CV và trả về kết quả đầu ra mà máy có thể đọc được như XML hoặc JSON. Điều này giúp lưu trữ và phân tích dữ liệu một cách tự động.

Ưu điểm của phân tích cú pháp dựa trên OCR

Nhà tuyển dụng có thể đặt ra các tiêu chí cho công việc và các ứng viên không phù hợp với những tiêu chí đó có thể được lọc ra một cách nhanh chóng và tự động.

- Nhà tuyển dụng tiết kiệm được hàng tấn giờ làm việc để phục vụ các ứng viên tiềm năng tốt hơn.

- Các ứng viên có thể được đánh giá và lựa chọn các vai trò phù hợp khác.

- Một công ty có thể theo dõi chất lượng của các ứng viên theo thời gian. Các phân tích có ý nghĩa về ứng viên có thể được tạo ra.

- Nếu các bước tiếp theo là thực hiện bài kiểm tra trực tuyến, thì quá trình chọn lọc và bài kiểm tra có thể được tích hợp một cách hợp lý.

- Quá trình đăng ký cho một cổng thông tin việc làm trở nên đơn giản. Hiện tại, một ứng viên phải nhập thông tin của cô ấy / anh ấy vào một biểu mẫu trong khi đăng ký trang web.

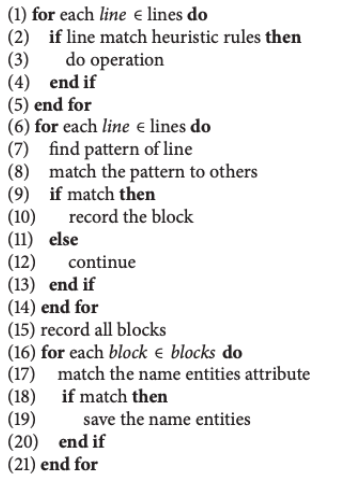

Bây giờ, chúng ta sẽ xem xét một nghiên cứu về Khai thác thông tin sơ yếu lý lịch, được xuất bản vào năm 2018, bởi một nhóm tại Học viện Công nghệ Bắc Kinh. Mục tiêu cuối cùng là trích xuất thông tin từ hồ sơ xin việc và cung cấp tính năng khớp công việc tự động. Chúng tôi trích dẫn công việc này là một Kỹ thuật truyền thống vì thuật toán được đề xuất sử dụng các phép phỏng đoán quy tắc đơn giản và các mẫu đối sánh văn bản. Các tác giả của nghiên cứu này đề xuất hai bước đơn giản để trích xuất thông tin. Trong bước đầu tiên, văn bản thô của sơ yếu lý lịch được xác định là các khối sơ yếu lý lịch khác nhau. Để đạt được mục tiêu, họ đã thiết kế một tính năng được gọi là Phong cách viết, để mô hình hóa thông tin cú pháp câu trên các khối văn bản.

Để xác định các khối văn bản, thuật toán chỉ cần tuân theo một vài chú thích như “Thử nghiệm dự án” và “Sở thích và Sở thích”. Bất cứ khi nào các chú thích này được xác định, chúng sẽ tạo điều kiện thuận lợi cho công việc tiếp theo bằng cách xem qua từng dòng và cho đến khi các chú thích tiếp theo được xác định. Sau khi các khối này được phân đoạn, chúng sử dụng tính năng của chúng Phong cách viết và thực hiện một vài phép phỏng đoán dựa trên quy tắc cho mỗi dòng. Trong kịch bản của họ, họ đã xem xét sơ yếu lý lịch Trung Quốc nơi các khoảng trắng được sử dụng để phân tách các thẻ khác nhau, điều này rất rõ ràng Phong cách viết tính năng. Đây là một ví dụ về cách họ đề cập đến kinh nghiệm làm việc của họ.

“2005–2010 [vị trí công việc],” “[vị trí công việc] [thời gian làm việc],” và “[đại học] [chuyên ngành] [bằng cấp] [phạm vi thời gian].”

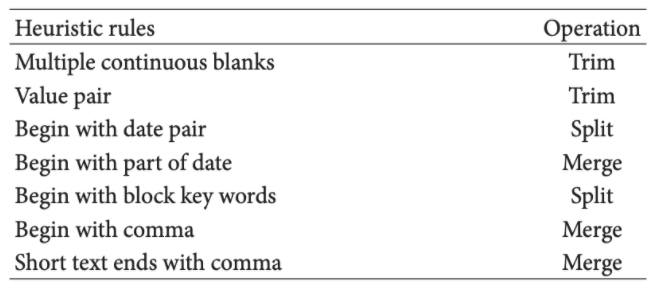

Dưới đây là hình ảnh xác định các Quy tắc Heuristic và các hoạt động tương ứng của chúng.

Trong bước thứ hai, một số bộ phân loại được sử dụng để xác định các đặc điểm khác nhau của thông tin dữ kiện trong sơ yếu lý lịch. Các thực thể tên khác nhau được thu thập, chẳng hạn như tên trường đại học, tên công ty, vị trí công việc và phòng ban, dễ dàng trích xuất từ sơ yếu lý lịch. Dưới đây là thuật toán văn bản,

Nhìn vào thuật toán này, nó là một hệ thống đối sánh mẫu dựa trên biểu thức chính quy. Tương tự như điều này, có một số công cụ và nghiên cứu được đề xuất.

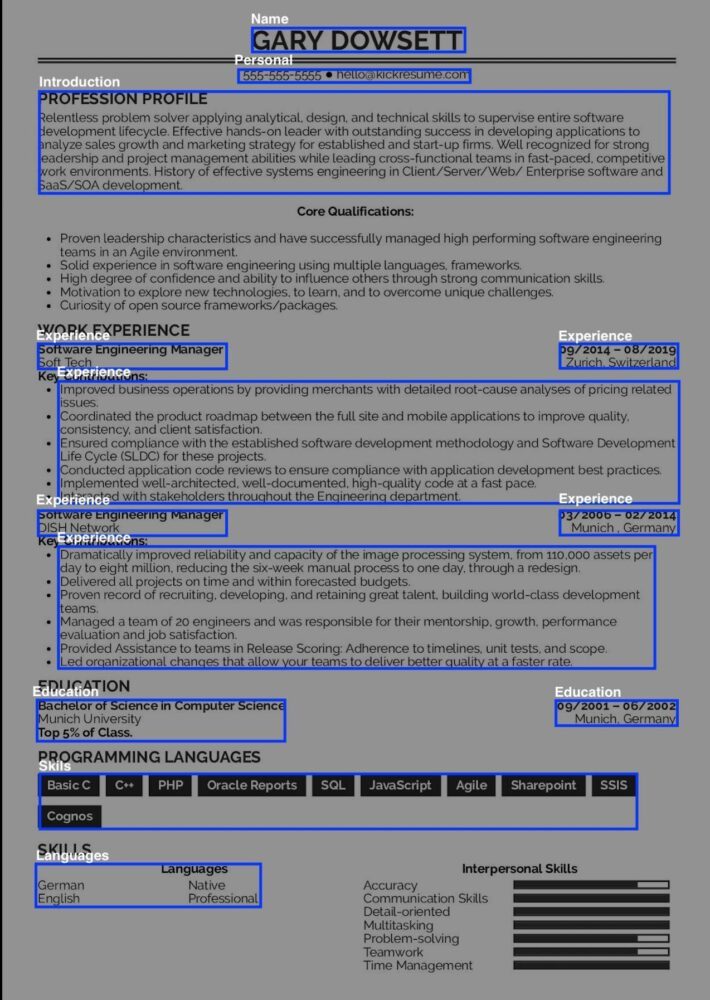

Sử dụng nhận dạng đối tượng được đặt tên

Một cách tiếp cận truyền thống nữa là sử dụng Nhận dạng đối tượng được đặt tên. Nó được sử dụng khi bạn muốn một tập hợp các chuỗi cụ thể từ các vùng được trích xuất. Ví dụ: hãy xem xét thành phần của một sơ yếu lý lịch dưới đây,

Giả sử bạn chỉ muốn ngôn ngữ lập trình mà anh ấy giỏi. Những loại vấn đề này có thể được giải quyết bằng cách sử dụng NER, trước khi đi sâu vào, chúng ta hãy xem nó là gì,

Nhận dạng đối tượng được đặt tên là một thuật toán trong đó nó lấy một chuỗi văn bản làm đầu vào (một đoạn hoặc câu) và xác định các danh từ có liên quan (người, địa điểm và tổ chức) và các từ cụ thể khác. Ví dụ, trong một sơ yếu lý lịch nhất định nếu bạn muốn trích xuất, chỉ Tên và Số điện thoại sử dụng NER sẽ giúp công việc của chúng ta dễ dàng hơn nhiều. Nó có thể đạt được bằng cách học sâu. Điều này là do một kỹ thuật được gọi là nhúng từ, có khả năng hiểu mối quan hệ ngữ nghĩa và cú pháp giữa các từ. Có một số quá trình xử lý trước liên quan đến hầu hết các chương trình liên quan đến dữ liệu, ngay cả Phân tích cú pháp sơ yếu lý lịch này cũng bao gồm một phần. Trong hầu hết các trường hợp, sơ yếu lý lịch được lưu dưới dạng PDF hoặc DOCX, do đó, để dễ dàng hơn, trong các bước đầu tiên, chúng tôi sẽ chuyển tài liệu word thành một bản lưu trong một biến. Làm theo mã bên dưới,

import docx2txt

def extract_text_from_doc(doc_path):

temp = docx2txt.process(doc_path)

text = [line.replace('t', ' ') for line in temp.split('n') if line]

return ' '.join(text)

path = "vihark.docx"

text = extract_text_from_doc(path)

Như chúng ta có thể thấy ở đây, chúng tôi đã sử dụng một thư viện có tên là doct2txt để sao chép tất cả thông tin có trong tài liệu word sang văn bản tên biến. Tiếp theo, chúng tôi sẽ nhập thư viện spacy và tải một mô hình được đào tạo trước cho NER. Bạn cũng cần tải xuống trước khi chúng tôi đưa vào sử dụng.

import spacy

from spacy.matcher import Matcher

# load pre-trained model

nlp = spacy.load('en_core_web_sm')

# initialize matcher with a vocab

matcher = Matcher(nlp.vocab)

def extract_name(resume_text):

nlp_text = nlp(resume_text)

# First name and Last name are always Proper Nouns

pattern = [{'POS': 'PROPN'}, {'POS': 'PROPN'}]

matcher.add('NAME', None, pattern)

matches = matcher(nlp_text)

for match_id, start, end in matches:

span = nlp_text[start:end]

return span.text

name = extract_name(text)

print(name)

Tôi đã sử dụng Sơ yếu lý lịch của mình và mô hình có thể lấy ra tên từ Sơ yếu lý lịch. Tương tự, chúng ta có thể trích xuất các thành phần khác từ Sơ yếu lý lịch bằng NER.

Đầu ra: Vihar Kurama

Thách thức các thuật toán truyền thống thất bại

- Lặp lại các mẫu sơ yếu lý lịch khác nhau và các quy tắc viết là không thể do 1000 định dạng khác nhau không có thứ tự thẳng

- Tạo cấu trúc phân cấp giữa phụ đề và nội dung lồng nhau bên trong rất khó

- Việc tạo ra các quy tắc để trích xuất các giá trị như kinh nghiệm, năm tốt nghiệp, v.v. không phải lúc nào cũng đơn giản.

- Các quy tắc sẽ cần thay đổi khi ngôn ngữ thay đổi khi lĩnh vực công việc (tiếp thị so với kỹ thuật) thay đổi.

Xây dựng Công cụ phân tích cú pháp hồ sơ chính xác bằng cách sử dụng Học sâu

Trong phần trước, chúng ta đã thảo luận về các phương pháp truyền thống. Ở đây chúng ta sẽ thảo luận về cách chúng ta có thể xây dựng một mô hình tự động chính xác để phân tích cú pháp hồ sơ. Bắt đầu nào!

Chung ta se lam như thê nao? Làm thế nào chúng ta có thể xây dựng một mô hình chung cho tất cả các mẫu sơ yếu lý lịch hiện có? Đây là đâu Học sâu (DL) và Thị giác máy tính (CV) đi vào hình ảnh. Nếu bạn không quen với DL, hãy nghĩ về nó như một bộ não nhân tạo học từ dữ liệu bằng các hàm toán học. Không giống như các thuật toán truyền thống, chúng được coi là thông minh, có nghĩa là chúng có thể hoạt động trong các tình huống khác nhau với độ chính xác cao. Thêm một lợi thế nữa là không giống như các thuật toán truyền thống, các thuật toán này có thể dễ dàng tích hợp hoặc triển khai vào bất kỳ hệ thống hiện có nào. Mặt khác, các thuật toán Computer Vision giống như mắt của máy móc, chúng phát hiện và xử lý trước hình ảnh một cách thông minh và chuyển đổi chúng thành dữ liệu có thể chỉnh sửa trong thời gian nhanh chóng.

Xem xét vấn đề phân tích cú pháp hồ sơ của chúng tôi, ở cấp độ cao, Deep Learning tìm các vùng hữu ích một cách thông minh từ hồ sơ và chuyển đến Computer Vision, nơi nó chuyển đổi các phần đã xác định thành văn bản có thể chỉnh sửa. Bây giờ chúng ta sẽ hiểu toàn bộ quá trình xây dựng mô hình bằng cách thực hiện các kỹ thuật khác nhau.

Phát hiện đối tượng và OCR

Sơ yếu lý lịch về cơ bản là các mẫu trực tiếp bao gồm các phần khác nhau. Có nghĩa là hầu hết các phần trong Sơ yếu lý lịch đều tương tự nhau nhưng chúng được sắp xếp theo các định dạng khác nhau. Các thành phần khác nhau của Sơ yếu lý lịch là [Mục tiêu nghề nghiệp, Nền tảng giáo dục, Kinh nghiệm làm việc, Lãnh đạo, Ấn phẩm, v.v.]. Để trích xuất các thành phần này, chúng tôi coi đây là các đối tượng và phát hiện chúng thông qua một thuật toán phát hiện đối tượng. Có một số thách thức cần được giải quyết như trích xuất bảng (đôi khi các thành phần như nền giáo dục được thêm vào trong bảng), biến thể phông chữ, biến thể mẫu, v.v.

Bây giờ chúng ta sẽ đi sâu vào cách phát hiện đối tượng được sử dụng để trích xuất các thành phần từ sơ yếu lý lịch. Để đạt được điều này, Mạng Nơ-ron Convolution (CNN) thường được sử dụng. Có một số ứng dụng dựa trên CNN đã đạt được hiệu suất hiện đại cho các vấn đề Phân loại và Phân đoạn Hình ảnh. Dưới đây là hình ảnh của một CNN đơn giản,

Để tiếp tục phân tích cú pháp bằng cách sử dụng Phát hiện đối tượng, phân đoạn trang thường là bước đầu tiên. Mục tiêu chính của phân đoạn trang là phân đoạn sơ yếu lý lịch thành các khu vực văn bản và không phải văn bản. Sau đó, chúng tôi trích xuất các đối tượng thành phần khác nhau, chẳng hạn như bảng, các phần từ các phần không phải văn bản. Không giống như các phương pháp dựa trên quy tắc truyền thống trong đó có nhiều tham số, mục tiêu chính của phương pháp dựa trên học (trong trường hợp này là CNN) lúc đầu là chia các trang tài liệu thành các dòng, sau đó phân loại từng dòng và kết hợp các kết quả phân loại theo các quy tắc.

Bây giờ chúng ta sẽ thảo luận về một số phương pháp phát hiện đối tượng

[Lưu ý: Các thuật toán này không phải lúc nào cũng giống nhau, với các kỹ thuật mới và các kiến trúc mạng nơ-ron khác nhau, hiệu suất luôn thay đổi]

Phương pháp 1: Phát hiện đối tượng trang dựa trên CNN trong ảnh tài liệu

Công việc này được đề xuất bởi Xiaohan Yi và nhóm của ông vào năm 2017 tại ICDAR (Hội nghị Quốc tế về Phân tích và Nhận biết Tài liệu). Mục tiêu của nghiên cứu này là phát hiện các khu vực cụ thể từ các trang được quét bằng CNN. Thuật toán được đề xuất có thể đạt được kết quả tốt sau ba giai đoạn, hãy cùng thảo luận về chúng.

Giai đoạn 1: Trong giai đoạn này, một tập dữ liệu được các tác giả thu thập bao gồm 12,000 hình ảnh trang tài liệu tiếng Anh được chọn từ 1,100 bài báo khoa học của CiteSeer. Mỗi tài liệu này đều có sự khác nhau về bố cục cũng như văn bản (phông chữ, màu sắc). Trong giai đoạn này, một tập dữ liệu được các tác giả thu thập bao gồm 12,000 hình ảnh trang tài liệu tiếng Anh được chọn từ 1,100 bài báo khoa học của CiteSeer. Mỗi tài liệu này đều có sự khác nhau về bố cục cũng như văn bản (phông chữ, màu sắc). Họ đã chú thích các đối tượng trong mỗi trang một cách thủ công, tổng cộng có 380,000 đối tượng trang tài liệu, bao gồm 350,000 dòng văn bản, 22,000 công thức, 5,783 hình và 2,295 bảng.

Để phát hiện đối tượng, hai phương pháp được sử dụng. Thứ nhất, Đề xuất thô, trong đó Tìm kiếm theo chiều rộng-Đầu tiên (BFS) được sử dụng để tìm tất cả các vùng 8 thành phần được kết nối trong hình ảnh nhị phân được lọc, khi một thành phần được tạo, nó sẽ được thay thế bằng hình chữ nhật bao quanh để giảm thông tin không liên quan trong hình ảnh. Thứ hai, chiến lược lược bớt được sử dụng để phát hiện các cột trong các trang và lọc các vùng tồn tại trong nhiều cột.

Giai đoạn 2: Giai đoạn thứ hai Liên quan đến việc thiết kế và đào tạo một mạng nơ-ron tích tụ. Các tác giả đã đề xuất CNN dựa trên Spatial Pyramid Pooling (SPP) được xây dựng trên đầu Mạng VGG-16. Một điểm khác biệt chính khi sử dụng SPP so với CNN là, Cấu trúc (SPP) gộp các bản đồ đối tượng địa lý thành kích thước cố định bằng cách lấy mẫu giảm tỷ lệ cố định. Stochastic Gradient Descent được sử dụng để đào tạo mạng.

VGG-16 đã là một mạng được đào tạo hiện có đã đạt được hiệu suất hiện đại cho các nhiệm vụ phân loại trên tập dữ liệu ImageNet.

Giai đoạn 3: Trong giai đoạn cuối, kết quả đã được rút ra. Mạng được đề xuất đã đạt được độ chính xác nhớ lại của việc phân đoạn dòng văn bản, diễn đàn, bảng và hình với lần lượt là 94.1%, 90.9%, 88.5%, 83.2%. Dưới đây là hình ảnh của toàn bộ quá trình,

Tham khảo: Phát hiện đối tượng trang dựa trên CNN trong hình ảnh tài liệu – Ấn phẩm hội nghị IEEE

Trong phần này, tôi sẽ thảo luận về công trình “Học cách tách cấu trúc ngữ nghĩa từ tài liệu sử dụng mạng thần kinh đa phương thức hoàn toàn hợp lệ” được đề xuất bởi các nhà nghiên cứu từ Adobe và Đại học bang Pennsylvania. Các tác giả đề xuất một mạng phức hợp đầu cuối, đa phương thức, đầy đủ để trích xuất cấu trúc ngữ nghĩa từ hình ảnh tài liệu. Mạng lưới này lấy một tài liệu làm đầu vào và chia nó thành các vùng quan tâm và để công nhận vai trò của từng vùng. Hãy xem làm thế nào điều này đạt được trong các giai đoạn khác nhau được đề xuất.

Giai đoạn 1: Giai đoạn đầu tiên tương tự như giai đoạn được thảo luận trong cách tiếp cận trước - phân đoạn trang. Ở đây thay vì chú thích trực tiếp hình ảnh, bản đồ nhúng văn bản (bạn có thể coi đây là những phần nhúng đã học được từ văn bản trong đó các từ có cùng nghĩa có cách diễn đạt tương tự) đã được sử dụng. Ưu điểm ở đây khi sử dụng tính năng nhúng văn bản là nó thậm chí có thể cho biết sự khác biệt giữa một danh sách và một số đoạn văn vì chúng sẽ được thể hiện ở các kích thước thấp hơn.

Giai đoạn 2: Giai đoạn này được gọi là phân tích cấu trúc logic. Nó dựa trên ngữ nghĩa hình ảnh mà nó phân loại từng khu vực thành các lớp có liên quan đến ngữ nghĩa như đoạn văn và chú thích. Về cơ bản, đây là đầu ra từ mạng nơ-ron tích tụ đầy đủ đa phương thức mà họ đã đề xuất. Bây giờ chúng ta hãy thảo luận về kiến trúc của mô hình được đề xuất, dưới đây là ảnh chụp màn hình.

Một tính năng cốt lõi của mô hình này là nó sử dụng kết nối bỏ qua thay thế được minh họa bằng các mũi tên màu xanh lam trong hình ảnh và các khối chập giãn được lấy cảm hứng từ kiến trúc Inception. Mỗi khối chập giãn bao gồm 5 khối chập giãn với kích thước hạt nhân 3 × 3 và độ giãn d = 1, 2, 4, 8, 16. Sự cần thiết của việc sử dụng chúng trong các CNN thông thường là để giảm tổn thất thông tin trong khi lấy mẫu xuống. Kiến trúc này được đào tạo trên một tập dữ liệu được thu thập bao gồm tổng số 271 tài liệu được dán nhãn với bố cục đa dạng, phức tạp. Tất cả các lớp tích chập đều có kích thước nhân ba × ba và bước tiến là 1. Việc gộp chung (trong bộ mã hóa) và không gộp (trong bộ giải mã) có kích thước nhân là 2 × 2. Các lớp chuẩn hóa hàng loạt được áp dụng ngay sau mỗi lần tích chập và trước tất cả các hàm phi tuyến tính. Mạng đã đạt được Độ chính xác IOU khi trích xuất bkg, hình, bảng, phần, chú thích, danh sách, đoạn văn với độ chính xác lần lượt là 84.6%, 83.3%, 79.4%, 58.3%, 61.0%, 66.7%, 77.1%. Dưới đây là hình ảnh về cách mô hình trả về các vùng quan tâm được phân đoạn.

Tự động hóa quy trình phân tích sơ yếu lý lịch của bạn. Xây dựng trình phân tích cú pháp sơ yếu lý lịch tùy chỉnh với Nanonets.

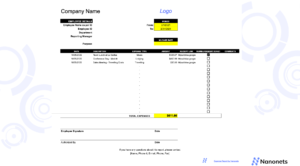

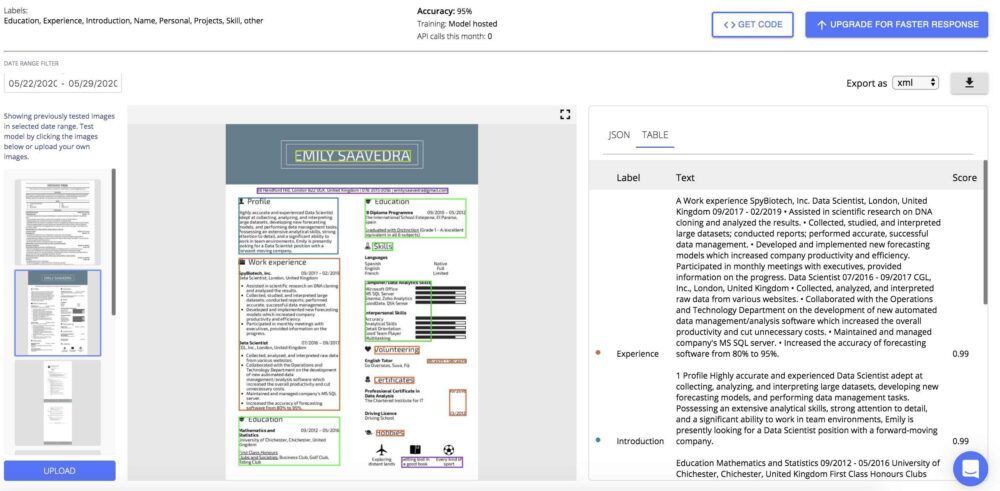

Sử dụng Nanonet

Sử dụng API Nanonets Bạn có thể tự động trích xuất tất cả các thông tin cần thiết từ các Sơ yếu lý lịch cần thiết để tìm kiếm và đối sánh công việc. Chỉ cần tải lên Sơ yếu lý lịch và nhận tất cả các trường được trích xuất trả về ở định dạng bạn chọn.

Tự động hóa quy trình phân tích sơ yếu lý lịch của bạn. Xây dựng trình phân tích cú pháp sơ yếu lý lịch tùy chỉnh với Nanonets.

Chúng tôi giải quyết hầu hết các vấn đề được liệt kê ở trên để bạn không phải mất thời gian sáng tạo lại bánh xe.

- Xác định các cặp khóa-giá trị: Chúng không được định vị đồng nhất trên các định dạng: Sử dụng triển khai GCN của chúng tôi, chúng tôi có thể phân tích cú pháp khóa trên các Hồ sơ. Việc triển khai GCN của chúng tôi bao gồm các tối ưu hóa để tìm kiếm tìm kiếm vùng lân cận phù hợp nhằm cân bằng tốt nhất giữa sự bùng nổ tính năng và việc thiếu ngữ cảnh để mô hình diễn giải chính xác khóa nào thuộc về mỗi bên.

2. Tính đến nhiều ngôn ngữ.

Các mô hình của chúng tôi đã được đào tạo với các phần nhúng văn bản không liên quan đến ngôn ngữ. Điều này đạt được bằng cách tạo ra một không gian đặc trưng sao cho các từ nhúng cho 'Giáo dục' và 'giáo dục' (người Tây Ban Nha) và 'giáo dục' (người Bồ Đào Nha) tất cả ánh xạ đến cùng một không gian đối tượng địa lý. Vì vậy, các tính năng văn bản trở nên độc lập với ngôn ngữ và mô hình không cần được đào tạo cho mỗi ngôn ngữ.

3. Không đủ dữ liệu để đào tạo cho một khóa cụ thể (mất cân bằng lớp): Chúng tôi có một lượng lớn Hồ sơ xin việc mà các mô hình của chúng tôi được đào tạo để giảm thiểu vấn đề này.

Các vấn đề khác

- Xoay vòng và cắt xén: Chúng tôi đã triển khai mô hình xoay và cắt xén như một phần của bước xử lý trước nhằm xác định các cạnh của tài liệu và sau đó định hướng tài liệu một cách chính xác. Điều này sử dụng một mô hình tương tự như mô hình phát hiện đối tượng với chức năng mục tiêu được sửa đổi để xác định 4 góc trái ngược với 2 điểm tiêu chuẩn trong bài toán phát hiện đối tượng. Điều này giải quyết cho cả xoay và cắt xén

- Chất lượng tài liệu mờ và kém: Chúng tôi có một mô hình chất lượng được đặt làm một phần trong quy trình tiền xử lý của chúng tôi, mô hình này chỉ chấp nhận các tài liệu trên một ngưỡng chất lượng nhất định. Đây là bộ phân loại nhị phân là một mô hình phân loại hình ảnh đơn giản được đào tạo trên một số tài liệu có chất lượng tốt và xấu. Trong quá trình thu thập tài liệu, các tài liệu có thể bị từ chối sớm nếu chúng không đáp ứng các tiêu chuẩn chất lượng cần thiết và có thể được gửi đi để thu thập lại hoặc xử lý thủ công.

- Dữ liệu trôi dạt: Trôi dữ liệu là một vấn đề khi mô hình chỉ được hiển thị với dữ liệu từ một nhà cung cấp hoặc một khu vực duy nhất. Nếu mô hình đã được đào tạo trong quá khứ về nhiều nhà cung cấp khác nhau, các ngành công nghiệp địa lý, v.v. thì khả năng sai lệch dữ liệu sẽ giảm đi đáng kể vì nó đã được tiếp xúc với những phương sai này.

Đọc thêm

- AI

- AI & Máy học

- nghệ thuật ai

- máy phát điện nghệ thuật ai

- ai rô bốt

- trí tuệ nhân tạo

- chứng nhận trí tuệ nhân tạo

- trí tuệ nhân tạo trong ngân hàng

- robot trí tuệ nhân tạo

- robot trí tuệ nhân tạo

- phần mềm trí tuệ nhân tạo

- blockchain

- hội nghị blockchain ai

- thiên tài

- trí tuệ nhân tạo đàm thoại

- hội nghị tiền điện tử ai

- dall's

- học kĩ càng

- google ai

- học máy

- plato

- Plato ai

- Thông tin dữ liệu Plato

- Trò chơi Plato

- PlatoDữ liệu

- Platogaming

- tiếp tục phân tích cú pháp

- quy mô ai

- cú pháp

- zephyrnet