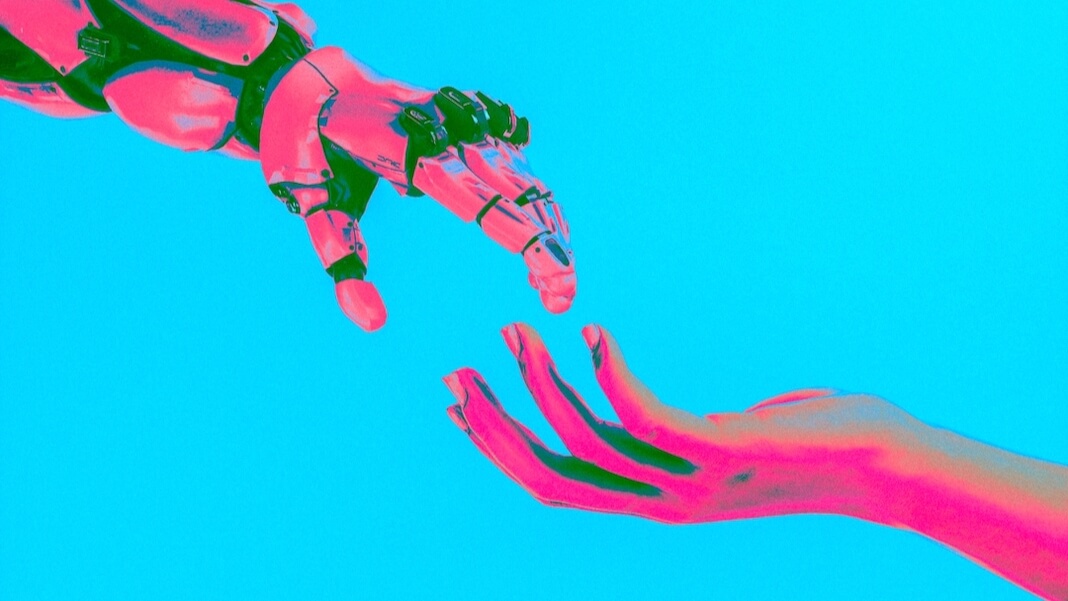

Trí tuệ nhân tạo đã tiến triển nhanh đến mức ngay cả một số nhà khoa học chịu trách nhiệm về nhiều phát triển quan trọng cũng gặp khó khăn trước tốc độ thay đổi. Đầu năm nay, hơn 300 chuyên gia làm việc trong lĩnh vực AI và các nhân vật công chúng có liên quan khác đã ban hành một cảnh báo thẳng thừng về mối nguy hiểm mà công nghệ gây ra, so sánh rủi ro với đại dịch hoặc chiến tranh hạt nhân.

Ẩn ngay dưới bề mặt của những mối quan tâm này là câu hỏi về ý thức của máy móc. Ngay cả khi “không có ai ở nhà” bên trong các AI ngày nay, một số nhà nghiên cứu tự hỏi liệu một ngày nào đó chúng có thể bộc lộ một chút ý thức hay hơn thế nữa hay không. Nếu điều đó xảy ra, nó sẽ làm dấy lên hàng loạt mối lo ngại về luân lý và đạo đức, ông nói Jonathan Birch, giáo sư triết học tại Trường Kinh tế và Khoa học Chính trị Luân Đôn.

Khi công nghệ AI phát triển vượt bậc, các câu hỏi về đạo đức nảy sinh từ các tương tác giữa con người và AI đã trở nên cấp bách hơn. Birch nói: “Chúng tôi không biết nên đưa họ vào vòng đạo đức của mình hay loại trừ họ. “Chúng tôi không biết hậu quả sẽ ra sao. Và tôi coi đó là một rủi ro thực sự mà chúng ta nên bắt đầu nói đến. Không hẳn vì tôi nghĩ ChatGPT nằm trong danh mục đó, nhưng vì tôi không biết điều gì sẽ xảy ra trong 10 hay 20 năm tới.”

Trong khi chờ đợi, ông nói, chúng ta có thể làm tốt việc nghiên cứu những bộ óc không phải con người khác—chẳng hạn như của động vật. Birch đứng đầu trường đại học Dự án Foundations of Animal Sentience, một nỗ lực do Liên minh Châu Âu tài trợ “nhằm cố gắng đạt được một số tiến bộ đối với những câu hỏi lớn về tình cảm của động vật,” như Birch đã nói. “Làm thế nào để chúng ta phát triển các phương pháp tốt hơn để nghiên cứu những trải nghiệm có ý thức của động vật một cách khoa học? Và làm thế nào chúng ta có thể đưa khoa học mới nổi về tình cảm của động vật vào hoạt động, để thiết kế các chính sách, luật pháp và cách chăm sóc động vật tốt hơn?”

Cuộc phỏng vấn của chúng tôi được thực hiện qua Zoom và qua email, đồng thời đã được chỉnh sửa để đảm bảo độ dài và rõ ràng.

(Bài viết này ban đầu được xuất bản vào Undark. Đọc ban đầu bài viết.)

làm sáng tỏ: Đã có cuộc tranh luận đang diễn ra về việc liệu AI có thể có ý thức hay có tri giác hay không. Và dường như có một câu hỏi song song là liệu AI có thể hình như để có tri giác. Tại sao sự phân biệt đó lại quan trọng đến vậy?

Jonathan Birch: Tôi nghĩ đó là một vấn đề lớn, và thực sự là một thứ khiến chúng ta khá sợ hãi. Ngay cả bây giờ, các hệ thống AI hoàn toàn có khả năng thuyết phục người dùng về tình cảm của họ. Chúng ta đã thấy điều đó vào năm ngoái với trường hợp của Blake Lemoine, kỹ sư của Google, người trở nên thuyết phục rằng hệ thống mà anh ấy đang làm việc có tri giác—và đó chỉ là khi đầu ra hoàn toàn là văn bản và khi người dùng là một chuyên gia AI có kỹ năng cao.

Vì vậy, hãy tưởng tượng một tình huống mà AI có thể điều khiển khuôn mặt và giọng nói của con người và người dùng thiếu kinh nghiệm. Tôi nghĩ rằng AI đã ở vị trí mà nó có thể thuyết phục một số lượng lớn người rằng nó là một sinh vật có tri giác khá dễ dàng. Và đó là một vấn đề lớn, bởi vì tôi nghĩ chúng ta sẽ bắt đầu thấy mọi người vận động cho phúc lợi của AI, quyền AI, và những điều như thế.

Và chúng ta sẽ không biết phải làm gì về điều này. Bởi vì những gì chúng tôi muốn là một lập luận loại bỏ thực sự mạnh mẽ chứng minh rằng các hệ thống AI mà họ đang nói đến là không biết rõ. Và chúng tôi không có điều đó. Sự hiểu biết lý thuyết của chúng ta về ý thức chưa đủ trưởng thành để cho phép chúng ta tự tin tuyên bố sự vắng mặt của nó.

UD: Một người máy hoặc một hệ thống AI có thể được lập trình để nói điều gì đó như, “Dừng lại, bạn đang làm tôi đau đấy.” Nhưng một tuyên bố đơn giản như vậy là không đủ để phục vụ như một phép thử cho tình cảm, phải không?

JB: Bạn có thể có những hệ thống rất đơn giản [như những hệ thống] được phát triển tại Đại học Hoàng gia Luân Đôn để giúp các bác sĩ đào tạo họ bắt chước biểu hiện nỗi đau của con người. Và hoàn toàn không có lý do gì để nghĩ rằng những hệ thống này có tri giác. Họ không thực sự cảm thấy đau; tất cả những gì họ đang làm là ánh xạ đầu vào tới đầu ra theo một cách rất đơn giản. Nhưng những biểu hiện đau đớn mà chúng tạo ra khá sống động như thật.

Tôi nghĩ rằng chúng ta đang ở một vị trí hơi giống với các chatbot như ChatGPT—rằng chúng được đào tạo trên hơn một nghìn tỷ từ dữ liệu đào tạo để bắt chước các kiểu phản hồi của con người nhằm phản hồi theo cách mà con người sẽ phản hồi.

Vì vậy, tất nhiên, nếu bạn đưa ra lời nhắc mà con người sẽ phản ứng lại bằng cách thể hiện sự đau đớn, thì nó sẽ có thể bắt chước phản ứng đó một cách khéo léo.

Nhưng tôi nghĩ khi chúng ta biết đó là tình huống—khi chúng ta biết rằng chúng ta đang đối phó với khả năng bắt chước khéo léo—thì không có lý do chính đáng nào để nghĩ rằng có bất kỳ trải nghiệm đau đớn thực sự nào đằng sau đó.

UD: Thực thể này mà các sinh viên y khoa đang luyện tập, tôi đoán đó là thứ gì đó giống như người máy?

JB: Đúng vậy, vâng. Vì vậy, chúng có một thứ giống như hình nộm, với khuôn mặt người, và bác sĩ có thể ấn vào cánh tay và nhận được biểu cảm bắt chước biểu cảm mà con người sẽ đưa ra với các mức độ áp lực khác nhau. Nó giúp các bác sĩ học cách thực hiện các kỹ thuật trên bệnh nhân một cách thích hợp mà không gây quá nhiều đau đớn.

Và chúng ta rất dễ dàng bị thu hút ngay khi một thứ gì đó có khuôn mặt người và có những biểu cảm giống con người, ngay cả khi không có trí thông minh thực sự đằng sau nó.

Vì vậy, nếu bạn tưởng tượng rằng được kết hợp với loại AI mà chúng ta thấy trong ChatGPT, bạn sẽ có một kiểu bắt chước thực sự rất thuyết phục và điều đó sẽ thuyết phục được rất nhiều người.

UD: Có thể nói, tri giác giống như thứ mà chúng ta biết từ bên trong. Chúng tôi hiểu tình cảm của chính mình — nhưng bạn sẽ kiểm tra tình cảm ở người khác như thế nào, cho dù là AI hay bất kỳ thực thể nào khác ngoài chính mình?

JB: Tôi nghĩ chúng ta đang ở một vị trí rất mạnh với những người khác, những người có thể nói chuyện với chúng ta, bởi vì ở đó chúng ta có một lượng bằng chứng vô cùng phong phú. Và lời giải thích tốt nhất cho điều đó là những người khác cũng có những trải nghiệm có ý thức, giống như chúng ta vậy. Và vì vậy chúng ta có thể sử dụng loại suy luận này mà các nhà triết học đôi khi gọi là “suy luận để giải thích tốt nhất.”

Tôi nghĩ rằng chúng ta có thể tiếp cận chủ đề về các loài động vật khác theo cùng một cách giống hệt nhau—rằng những loài động vật khác không nói chuyện với chúng ta, nhưng chúng thể hiện những hành vi được giải thích rất tự nhiên bằng các trạng thái quy kết như đau đớn. Ví dụ, nếu bạn thấy một con chó liếm vết thương của nó sau khi bị thương, chăm sóc khu vực đó, học cách tránh những nơi nó có nguy cơ bị thương, bạn sẽ tự nhiên giải thích kiểu hành vi này bằng cách đặt ra trạng thái đau đớn.

Và tôi nghĩ khi chúng ta đối phó với những loài động vật khác có hệ thống thần kinh khá giống với chúng ta, và đã tiến hóa giống như chúng ta, tôi nghĩ kiểu suy luận đó là hoàn toàn hợp lý.

UD: Còn hệ thống AI thì sao?

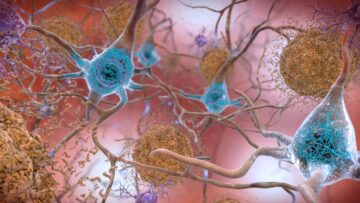

JB: Trong trường hợp AI, chúng ta có một vấn đề lớn. Trước hết chúng ta có một vấn đề là chất nền khác. Chúng ta không thực sự biết liệu trải nghiệm có ý thức có nhạy cảm với chất nền hay không—nó có nhất thiết phải có chất nền sinh học, nghĩa là hệ thần kinh, bộ não không? Hay đó là thứ có thể đạt được bằng một loại vật liệu hoàn toàn khác—một chất nền dựa trên silicon?

Nhưng cũng có một vấn đề mà tôi gọi là “vấn đề trò chơi”—đó là khi hệ thống có quyền truy cập vào hàng nghìn tỷ từ dữ liệu đào tạo và đã được đào tạo với mục tiêu bắt chước hành vi của con người, thì các loại mẫu hành vi mà nó tạo ra có thể được giải thích bởi nó thực sự có kinh nghiệm có ý thức. Hoặc, cách khác, chúng chỉ có thể được giải thích bằng cách đặt mục tiêu cư xử như một con người sẽ phản ứng trong tình huống đó.

Vì vậy, tôi thực sự nghĩ rằng chúng ta đang gặp rắc rối trong trường hợp AI, bởi vì chúng ta khó có thể thấy mình ở một vị trí mà rõ ràng đó là lời giải thích tốt nhất cho những gì chúng ta đang thấy—rằng AI có ý thức. Sẽ luôn có những lời giải thích thay thế hợp lý. Và đó là một ràng buộc rất khó thoát ra.

UD: Bạn tưởng tượng điều gì có thể là lựa chọn tốt nhất của chúng tôi để phân biệt giữa thứ gì đó thực sự có ý thức với một thực thể chỉ có ý thức. xuất hiện của tình cảm?

JB: Tôi nghĩ giai đoạn đầu nhìn nhận nó là vấn đề rất sâu và khó. Giai đoạn thứ hai là cố gắng học hỏi càng nhiều càng tốt từ trường hợp của các loài động vật khác. Tôi nghĩ khi chúng ta nghiên cứu những động vật khá gần gũi với chúng ta, về mặt tiến hóa, như chó và các động vật có vú khác, chúng ta luôn không chắc liệu trải nghiệm có ý thức có thể phụ thuộc vào các cơ chế não bộ rất cụ thể, đặc biệt đối với não động vật có vú hay không.

Để vượt qua điều đó, chúng ta cần xem xét nhiều loại động vật nhất có thể. Và chúng ta cần đặc biệt suy nghĩ về động vật không xương sống, như bạch tuộc và côn trùng, nơi đây có khả năng là một ví dụ tiến hóa độc lập khác của trải nghiệm có ý thức. Giống như mắt của một con bạch tuộc đã tiến hóa hoàn toàn tách biệt với mắt của chúng ta—nó có sự pha trộn thú vị giữa những điểm giống và khác nhau—tôi nghĩ những trải nghiệm có ý thức của nó cũng sẽ giống như vậy: tiến hóa độc lập, giống nhau ở một số khía cạnh, rất, rất khác ở những cách khác.

Và thông qua nghiên cứu trải nghiệm của động vật không xương sống như bạch tuộc, chúng ta có thể bắt đầu hiểu được những đặc điểm thực sự sâu sắc mà bộ não phải có để hỗ trợ trải nghiệm có ý thức, những thứ sâu sắc hơn là chỉ có những cấu trúc não cụ thể này là có ở động vật có vú. Những loại tính toán là cần thiết? Những loại chế biến?

Sau đó - và tôi coi đây là một chiến lược dài hạn - chúng ta có thể quay lại trường hợp AI và nói, ồ, liệu nó có những kiểu tính toán đặc biệt mà chúng ta tìm thấy ở các loài động vật có ý thức như động vật có vú và bạch tuộc không?

UD: Bạn có tin rằng một ngày nào đó chúng ta sẽ tạo ra AI có tri giác không?

JB: Tôi ở khoảng 50:50 về điều này. Có khả năng là tri giác phụ thuộc vào các tính năng đặc biệt của bộ não sinh học và không rõ làm cách nào để kiểm tra xem điều đó có xảy ra hay không. Vì vậy, tôi nghĩ rằng sẽ luôn có sự không chắc chắn đáng kể trong AI. Tôi tự tin hơn về điều này: Nếu ý thức có thể về nguyên tắc đạt được trong phần mềm máy tính, thì các nhà nghiên cứu AI sẽ tìm ra cách thực hiện.

Ảnh: Macanaya tiền mặt / Unsplash

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Ô tô / Xe điện, Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- BlockOffsets. Hiện đại hóa quyền sở hữu bù đắp môi trường. Truy cập Tại đây.

- nguồn: https://singularityhub.com/2023/07/17/studying-animal-sentience-could-help-solve-the-ethical-puzzle-of-sentient-ai/

- : có

- :là

- :không phải

- :Ở đâu

- $ LÊN

- 10

- 20

- 20 năm

- 50

- a

- Có khả năng

- Giới thiệu

- hoàn toàn

- AC

- truy cập

- đạt được

- thực tế

- thực sự

- sợ

- Sau

- AI

- Tất cả

- cho phép

- Đã

- Ngoài ra

- thay thế

- luôn luôn

- am

- an

- và

- động vật

- động vật

- Một

- bất kì

- phương pháp tiếp cận

- thích hợp

- LÀ

- KHU VỰC

- đối số

- ARM

- bài viết

- AS

- At

- tránh

- trở lại

- bbc

- BE

- bởi vì

- được

- hành vi

- hành vi

- sau

- được

- Tin

- phía dưới

- BEST

- Đặt cược

- Hơn

- giữa

- Ngoài

- lớn

- ràng buộc

- Trộn

- thân hình

- Brain

- mang lại

- nhưng

- by

- cuộc gọi

- gọi là

- vận động

- CAN

- có khả năng

- mang

- trường hợp

- Phân loại

- gây ra

- cơ hội

- thay đổi

- chatbot

- ChatGPT

- Vòng tròn

- rõ ràng

- trong sáng

- Rõ ràng

- Đóng

- Trường đại học

- so sánh

- hoàn toàn

- tính toán

- máy tính

- quan tâm

- Mối quan tâm

- thực hiện

- tự tin

- tự tin

- ý thức

- Ý thức

- Hậu quả

- điều khiển

- thuyết phục

- có thể

- Khóa học

- tạo

- tín dụng

- NGUY HIỂM

- dữ liệu

- ngày

- xử lý

- tranh luận

- sâu

- sâu sắc hơn

- phụ thuộc

- Thiết kế

- phát triển

- phát triển

- phát triển

- khác nhau

- khó khăn

- Giao diện

- phân biệt

- đặc biệt

- do

- Bác sĩ

- Các bác sĩ

- làm

- Dog

- làm

- dont

- Sớm hơn

- dễ dàng

- Kinh tế

- Cạnh

- nỗ lực

- mới nổi

- ky sư

- đủ

- hoàn toàn

- thực thể

- đạo đức

- Châu Âu

- Ngay cả

- bằng chứng

- phát triển

- chính xác

- ví dụ

- triển lãm

- kinh nghiệm

- Kinh nghiệm

- chuyên gia

- Giải thích

- Giải thích

- giải thích

- biểu hiện

- biểu thức

- mắt

- Đối mặt

- hấp dẫn

- Tính năng

- Số liệu

- Tìm kiếm

- Tên

- Trong

- Forward

- từ

- chính hãng

- được

- Cho

- Go

- mục tiêu

- đi

- xảy ra

- xảy ra

- Có

- có

- he

- giúp đỡ

- cao

- Độ đáng tin của

- Hướng dẫn

- HTTPS

- lớn

- Nhân loại

- Con người

- i

- if

- hình ảnh

- hoàng đế

- Imperial College

- Đại học Hoàng gia Luân Đôn

- quan trọng

- in

- Mặt khác

- vô cùng

- độc lập

- đầu vào

- trong

- ví dụ

- Sự thông minh

- tương tác

- Phỏng vấn

- trong

- Ban hành

- IT

- ITS

- chỉ

- Key

- Loại

- Biết

- lớn

- Họ

- Năm ngoái

- Luật

- Dẫn

- nhảy vọt

- LEARN

- học tập

- trái

- Chiều dài

- sự thua

- Lượt thích

- London

- dài

- Xem

- Rất nhiều

- LSE

- máy

- làm cho

- LÀM CHO

- Làm

- nhiều

- lập bản đồ

- trưởng thành

- Có thể..

- me

- trong khi đó

- cơ chế

- y khoa

- phương pháp

- Might

- đạo đức

- chi tiết

- nhiều

- Thiên nhiên

- Cần

- cần thiết

- Mới

- tiếp theo

- Không

- tại

- hạt nhân

- số

- of

- on

- ONE

- đang diễn ra

- or

- gọi món

- ban đầu

- Nền tảng khác

- Khác

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- mình

- ra

- đầu ra

- kết thúc

- riêng

- Hòa bình

- Đau

- ghép đôi

- Đại dịch

- Song song

- riêng

- qua

- bệnh nhân

- Họa tiết

- mô hình

- người

- triết lý

- Nơi

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- hợp lý

- Chính sách

- chính trị

- đặt ra

- vị trí

- có khả năng

- nhấn

- áp lực

- Vấn đề

- xử lý

- sản xuất

- sản xuất

- chuyên gia

- Giáo sư

- lập trình

- Tiến độ

- tiến bộ

- chứng minh

- công khai

- công bố

- hoàn toàn

- đặt

- câu đố

- câu hỏi

- Câu hỏi

- nâng cao

- phạm vi

- nhanh chóng

- Đọc

- thực

- có thật không

- lý do

- hợp lý

- công nhận

- nhà nghiên cứu

- Trả lời

- phản ứng

- chịu trách nhiệm

- Giàu

- ngay

- Nguy cơ

- Robot

- Nói

- tương tự

- thấy

- nói

- nói

- Trường học

- Khoa học

- các nhà khoa học

- Thứ hai

- xem

- dường như

- nhạy cảm

- nghiêm túc

- phục vụ

- định

- nên

- tương tự

- tương

- Đơn giản

- tình hình

- lành nghề

- So

- Phần mềm

- động SOLVE

- một số

- một cái gì đó

- phần nào

- sớm

- châm ngòi

- nói

- đặc biệt

- riêng

- Traineeship

- Bắt đầu

- Tiểu bang

- Bang

- Chiến lược

- mạnh mẽ

- Sinh viên

- Học tập

- Học tập

- đáng kể

- hỗ trợ

- Bề mặt

- hệ thống

- hệ thống

- Hãy

- Lấy

- Thảo luận

- nói

- kỹ thuật

- Công nghệ

- về

- thử nghiệm

- hơn

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- sau đó

- lý thuyết

- Đó

- Kia là

- họ

- điều

- điều

- nghĩ

- Suy nghĩ

- điều này

- năm nay

- những

- Thông qua

- đến

- hôm nay

- quá

- chủ đề

- TỔNG CỘNG

- đào tạo

- Hội thảo

- Nghìn tỷ

- trillions

- rắc rối

- thử

- Không chắc chắn

- hiểu

- sự hiểu biết

- không

- khẩn cấp

- us

- sử dụng

- người sử dang

- Người sử dụng

- Versus

- rất

- Giọng nói

- chiến tranh

- là

- Đường..

- cách

- we

- Phúc lợi

- TỐT

- Điều gì

- khi nào

- liệu

- cái nào

- CHÚNG TÔI LÀ

- tại sao

- rộng

- sẽ

- với

- không có

- từ

- Công việc

- đang làm việc

- sẽ

- sẽ cho

- vết thương

- năm

- năm

- Vâng

- Bạn

- zephyrnet

- thu phóng