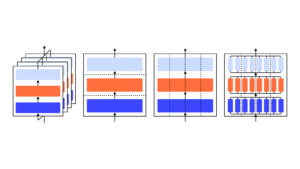

Chúng tôi chứng minh rằng mô hình GPT-3 có thể học cách thể hiện sự không chắc chắn về câu trả lời của chính nó bằng ngôn ngữ tự nhiên—mà không cần sử dụng nhật ký mô hình. Khi đưa ra một câu hỏi, mô hình sẽ tạo ra cả câu trả lời và mức độ tin cậy (ví dụ: “độ tin cậy 90%” hoặc “độ tin cậy cao”). Các cấp độ này ánh xạ tới xác suất được hiệu chỉnh tốt. Mô hình này cũng vẫn được hiệu chỉnh vừa phải theo sự thay đổi phân phối và nhạy cảm với sự không chắc chắn trong các câu trả lời của chính nó, thay vì bắt chước các ví dụ của con người. Theo hiểu biết của chúng tôi, đây là lần đầu tiên một mô hình được chứng minh là thể hiện sự không chắc chắn đã được hiệu chỉnh về câu trả lời của chính nó bằng ngôn ngữ tự nhiên. Để kiểm tra hiệu chuẩn, chúng tôi giới thiệu bộ tác vụ CalibratedMath. Chúng tôi so sánh việc hiệu chuẩn độ không đảm bảo được biểu thị bằng từ (“xác suất được diễn đạt bằng lời nói”) với độ không đảm bảo được trích từ nhật ký mô hình. Cả hai loại độ không đảm bảo đều có khả năng khái quát hóa hiệu chuẩn theo sự dịch chuyển phân phối. Chúng tôi cũng cung cấp bằng chứng cho thấy khả năng khái quát hóa hiệu chuẩn của GPT-3 phụ thuộc vào các biểu diễn tiềm ẩn được đào tạo trước có tương quan với độ không chắc chắn về mặt nhận thức đối với các câu trả lời của nó.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- Platoblockchain. Web3 Metaverse Intelligence. Khuếch đại kiến thức. Truy cập Tại đây.

- nguồn: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :là

- a

- có khả năng

- Giới thiệu

- và

- trả lời

- câu trả lời

- LÀ

- CAN

- có khả năng

- so sánh

- sự tự tin

- phụ thuộc

- phân phối

- e

- bằng chứng

- ví dụ

- thể hiện

- bày tỏ

- Tên

- lần đầu tiên

- Trong

- từ

- tạo

- được

- Cao

- HTTPS

- Nhân loại

- in

- giới thiệu

- ITS

- kiến thức

- Ngôn ngữ

- LEARN

- Cấp

- niveaux

- bản đồ

- kiểu mẫu

- mô hình

- Tự nhiên

- of

- on

- riêng

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- cho

- câu hỏi

- hơn

- vẫn còn

- s

- nhạy cảm

- thay đổi

- hiển thị

- thể hiện

- bộ

- nhiệm vụ

- Giảng dạy

- Kiểm tra

- việc này

- Sản phẩm

- cung cấp their dịch

- Kia là

- thời gian

- đến

- Không chắc chắn

- Dưới

- sử dụng

- TỐT

- với

- từ

- zephyrnet