Phát hiện sai lệch trong kết quả dữ liệu và mô hình là yêu cầu cơ bản để xây dựng các mô hình trí tuệ nhân tạo (AI) và máy học (ML) có trách nhiệm. Thật không may, việc phát hiện sự thiên vị không phải là một nhiệm vụ dễ dàng đối với đại đa số những người thực hành do có rất nhiều cách để đo lường nó và các yếu tố khác nhau có thể góp phần dẫn đến kết quả sai lệch. Ví dụ: việc lấy mẫu dữ liệu huấn luyện không cân bằng có thể dẫn đến một mô hình kém chính xác hơn đối với một số tập hợp con dữ liệu nhất định. Xu hướng cũng có thể được tạo ra bởi chính thuật toán ML—ngay cả với tập dữ liệu huấn luyện được cân bằng tốt, kết quả có thể thiên về một số tập hợp con dữ liệu nhất định so với các tập hợp con khác.

Để phát hiện thành kiến, bạn phải hiểu biết thấu đáo về các loại thành kiến khác nhau và các nguyên nhân tương ứng. số liệu thiên vị. Ví dụ, tại thời điểm viết bài này, Làm rõ Amazon SageMaker cung cấp 21 số liệu khác nhau để lựa chọn.

Trong bài đăng này, chúng tôi sử dụng trường hợp sử dụng dự đoán thu nhập (dự đoán thu nhập của người dùng từ các tính năng đầu vào như giáo dục và số giờ làm việc mỗi tuần) để chứng minh các loại sai lệch khác nhau và số liệu tương ứng trong SageMaker Clarify. Chúng tôi cũng phát triển một khuôn khổ để giúp bạn quyết định số liệu nào quan trọng đối với ứng dụng của bạn.

Giới thiệu về SageMaker Làm rõ

Các mô hình ML đang ngày càng được sử dụng để giúp đưa ra quyết định trên nhiều lĩnh vực khác nhau, chẳng hạn như dịch vụ tài chính, chăm sóc sức khỏe, giáo dục và nguồn nhân lực. Trong nhiều trường hợp, điều quan trọng là phải hiểu lý do tại sao mô hình ML đưa ra dự đoán cụ thể và liệu dự đoán đó có bị ảnh hưởng bởi sai lệch hay không.

SageMaker Clarify cung cấp các công cụ cho cả hai nhu cầu này, nhưng trong bài đăng này, chúng tôi chỉ tập trung vào chức năng phát hiện sai lệch. Để tìm hiểu thêm về khả năng giải thích, hãy xem Giải thích sự kiện trận đấu Bundesliga x Bàn thắng sử dụng Amazon SageMaker Làm rõ.

SageMaker Claritify là một phần của Amazon SageMaker, là dịch vụ được quản lý hoàn toàn để xây dựng, đào tạo và triển khai các mô hình ML.

Ví dụ về câu hỏi về sự thiên vị

Để làm cơ sở cho cuộc thảo luận, sau đây là một số câu hỏi mẫu mà các nhà xây dựng ML và các bên liên quan của họ có thể đặt ra liên quan đến sự thiên vị. Danh sách này bao gồm một số câu hỏi chung có thể liên quan đến một số ứng dụng ML, cũng như các câu hỏi về các ứng dụng cụ thể như truy xuất tài liệu.

Bạn có thể hỏi, dựa trên các nhóm quan tâm đến dữ liệu đào tạo (ví dụ: nam so với nữ), tôi nên sử dụng số liệu nào để trả lời các câu hỏi sau:

- Việc biểu diễn nhóm trong dữ liệu huấn luyện có phản ánh thế giới thực không?

- Các nhãn mục tiêu trong dữ liệu huấn luyện có ưu tiên nhóm này hơn nhóm kia bằng cách gán cho nhóm đó các nhãn tích cực hơn không?

- Mô hình có độ chính xác khác nhau cho các nhóm khác nhau không?

- Trong một mô hình có mục đích là xác định các ứng viên đủ tiêu chuẩn để tuyển dụng, liệu mô hình đó có độ chính xác như nhau đối với các nhóm khác nhau không?

- Trong một mô hình có mục đích truy xuất các tài liệu liên quan đến truy vấn đầu vào, mô hình đó có truy xuất các tài liệu liên quan từ các nhóm khác nhau theo cùng một tỷ lệ không?

Trong phần còn lại của bài đăng này, chúng tôi phát triển một khuôn khổ về cách xem xét trả lời những câu hỏi này và những câu hỏi khác thông qua các số liệu có sẵn trong SageMaker Clarify.

Trường hợp sử dụng và bối cảnh

Bài đăng này sử dụng một ví dụ hiện có về công việc SageMaker Claritify từ Tính công bằng và khả năng giải thích với sổ ghi chép SageMaker Clarify và giải thích các giá trị số liệu sai lệch được tạo ra. Máy tính xách tay đào tạo mô hình XGBoost trên Bộ dữ liệu UCI dành cho người lớn (Dua, D. và Graff, C. (2019). Kho lưu trữ máy học UCI. Irvine, CA: Đại học California, Trường Khoa học Thông tin và Máy tính).

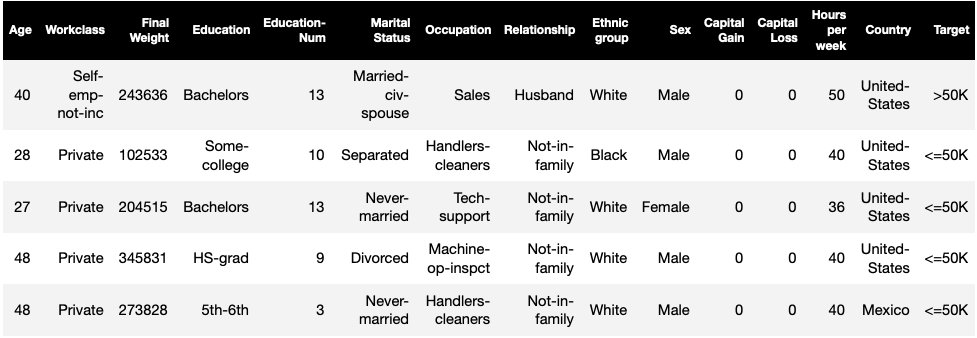

Nhiệm vụ ML trong tập dữ liệu này là dự đoán liệu một người có thu nhập hàng năm trên hay dưới 50,000 USD. Bảng sau đây hiển thị một số trường hợp cùng với các tính năng của chúng. Việc đo lường độ lệch trong dự đoán thu nhập rất quan trọng vì chúng ta có thể sử dụng những dự đoán này để đưa ra các quyết định như ưu đãi giảm giá và tiếp thị có mục tiêu.

Thuật ngữ thiên vị

Trước khi đi sâu hơn, hãy xem lại một số thuật ngữ cần thiết. Để có danh sách đầy đủ các thuật ngữ, hãy xem Amazon SageMaker làm rõ các điều khoản về thành kiến và công bằng.

- nhãn – Đặc điểm mục tiêu mà mô hình ML được huấn luyện để dự đoán. MỘT nhãn quan sát đề cập đến giá trị nhãn được quan sát trong dữ liệu được sử dụng để huấn luyện hoặc kiểm tra mô hình. MỘT nhãn dự đoán là giá trị được dự đoán bởi mô hình ML. Nhãn có thể ở dạng nhị phân và thường được mã hóa thành 0 và 1. Chúng tôi giả sử 1 đại diện cho nhãn thuận lợi hoặc tích cực (ví dụ: thu nhập lớn hơn hoặc bằng 50,000 USD) và 0 đại diện cho nhãn bất lợi hoặc tiêu cực. Nhãn cũng có thể bao gồm nhiều hơn hai giá trị. Ngay cả trong những trường hợp này, một hoặc nhiều giá trị tạo thành nhãn thuận lợi. Để đơn giản, bài viết này chỉ xem xét các nhãn nhị phân. Để biết chi tiết về cách xử lý nhãn có nhiều hơn hai giá trị và nhãn có giá trị liên tục (ví dụ: trong hồi quy), hãy xem Sách trắng về tính công bằng và khả năng giải thích của Amazon AI.

- Khía cạnh – Một cột hoặc đối tượng liên quan đến độ lệch được đo. Trong ví dụ của chúng tôi, khía cạnh là

sexvà nhận hai giá trị:womanvàman, được mã hóa dưới dạngfemalevàmaletrong dữ liệu (dữ liệu này được trích từ Điều tra dân số năm 1994 và thực thi tùy chọn nhị phân). Mặc dù bài đăng xem xét một khía cạnh duy nhất chỉ có hai giá trị, nhưng đối với các trường hợp phức tạp hơn liên quan đến nhiều khía cạnh hoặc các khía cạnh có nhiều hơn hai giá trị, hãy xem Sách trắng về tính công bằng và khả năng giải thích của Amazon AI. - Bias – Sự mất cân bằng đáng kể trong dữ liệu đầu vào hoặc dự đoán mô hình giữa các giá trị khía cạnh khác nhau. Điều gì tạo nên “đáng kể” phụ thuộc vào đơn đăng ký của bạn. Đối với hầu hết các số liệu, giá trị 0 hàm ý không có sự mất cân bằng. Các chỉ số sai lệch trong SageMaker Clarify được chia thành hai loại:

- Tập huấn trước – Khi xuất hiện, sai lệch huấn luyện trước chỉ biểu thị sự mất cân bằng trong dữ liệu.

- Bài huấn luyện – Xu hướng sau đào tạo cũng xem xét thêm các dự đoán của các mô hình.

Hãy xem xét từng loại riêng biệt.

Sự thiên vị trước khi đào tạo

Các chỉ số sai lệch đào tạo trước trong SageMaker Làm rõ câu trả lời cho câu hỏi sau: Tất cả các giá trị khía cạnh có được biểu thị bằng (hoặc tương tự) trong dữ liệu không? Điều quan trọng là phải kiểm tra dữ liệu để tìm độ lệch trước khi huấn luyện vì nó có thể chuyển thành sai lệch sau huấn luyện trong dự đoán mô hình. Ví dụ: một mô hình được huấn luyện trên dữ liệu không cân bằng trong đó một giá trị khía cạnh rất hiếm khi xuất hiện có thể cho thấy độ chính xác kém hơn đáng kể đối với giá trị khía cạnh đó. Đại diện bằng nhau có thể được tính toán như sau:

- Toàn bộ dữ liệu huấn luyện không phân biệt nhãn

- Tập hợp con của dữ liệu huấn luyện chỉ có nhãn tích cực

- Mỗi nhãn riêng biệt

Hình dưới đây cung cấp bản tóm tắt về cách mỗi số liệu phù hợp với từng loại trong số ba loại.

Một số danh mục bao gồm nhiều hơn một số liệu. Các số liệu cơ bản (hộp màu xám) trả lời câu hỏi về độ lệch trong danh mục đó ở dạng đơn giản nhất. Các số liệu trong hộp trắng cũng bao gồm các trường hợp đặc biệt (ví dụ: nghịch lý Simpson) và sở thích của người dùng (ví dụ: tập trung vào một số bộ phận dân số khi tính toán hiệu suất dự đoán).

Biểu diễn giá trị khía cạnh không phân biệt nhãn

Số liệu duy nhất trong danh mục này là Mất cân bằng lớp (CI). Mục tiêu của số liệu này là đo lường xem tất cả các giá trị khía cạnh có được biểu thị bằng nhau trong dữ liệu hay không.

CI là sự khác biệt trong phần dữ liệu được tạo thành bởi hai giá trị thuộc tính. Trong tập dữ liệu mẫu của chúng tôi, đối với khía cạnh sex, phân tích (hiển thị trong biểu đồ hình tròn) cho thấy phụ nữ chiếm 32.4% dữ liệu đào tạo, trong khi nam giới chiếm 67.6%. Kết quả là:

CI = 0.676 - 0.324 = 0.352

Sự mất cân bằng cấp cao nghiêm trọng có thể dẫn đến hiệu suất dự đoán kém hơn đối với giá trị thuộc tính có biểu diễn nhỏ hơn.

Chỉ biểu thị giá trị khía cạnh ở cấp độ nhãn tích cực

Một cách khác để đo mức độ đại diện bằng nhau là kiểm tra xem tất cả các giá trị khía cạnh có chứa một phần mẫu tương tự có nhãn được quan sát dương hay không. Các nhãn tích cực bao gồm các kết quả thuận lợi (ví dụ: được cấp khoản vay, được chọn cho công việc), do đó, việc phân tích các nhãn tích cực một cách riêng biệt sẽ giúp đánh giá xem các quyết định thuận lợi có được phân bổ đồng đều hay không.

Trong tập dữ liệu mẫu của chúng tôi, các nhãn được quan sát được chia thành các giá trị dương và âm, như minh họa trong hình sau.

11.4% tổng số phụ nữ và 31.4% tổng số nam giới có nhãn tích cực (vùng bóng tối ở thanh bên trái và bên phải). Sự khác biệt về Tỷ lệ Tích cực trong Nhãn (DPL) đo lường sự khác biệt này.

DPL = 0.314 - 0.114 = 0.20

Chỉ số nâng cao trong danh mục này, Chênh lệch nhân khẩu học có điều kiện trong nhãn (CDDL), đo lường sự khác biệt trong các nhãn tích cực nhưng phân tầng chúng theo một biến khác. Chỉ số này giúp kiểm soát Nghịch lý của Simpson, trường hợp tính toán trên toàn bộ dữ liệu cho thấy sai lệch, nhưng sai lệch sẽ biến mất khi nhóm dữ liệu theo một số thông tin phụ.

Sản phẩm Nghiên cứu tuyển sinh 1973 UC Berkeley cung cấp một ví dụ Theo dữ liệu, nam giới được nhận vào trường với tỷ lệ cao hơn nữ giới. Tuy nhiên, khi kiểm tra ở cấp độ từng khoa của trường đại học, phụ nữ được nhận vào với tỷ lệ tương đương hoặc cao hơn ở mỗi khoa. Quan sát này có thể được giải thích bằng nghịch lý Simpson, nảy sinh ở đây vì phụ nữ nộp đơn vào các trường có tính cạnh tranh cao hơn. Kết quả là, nhìn chung, phụ nữ được nhận vào học ít hơn so với nam giới, mặc dù theo từng trường họ được nhận với tỷ lệ tương tự hoặc cao hơn.

Để biết thêm chi tiết về cách tính CDDL, xem Sách trắng về tính công bằng và khả năng giải thích của Amazon AI.

Biểu diễn giá trị khía cạnh ở cấp độ của từng nhãn riêng biệt

Sự bình đẳng trong đại diện cũng có thể được đo lường cho từng nhãn riêng lẻ chứ không chỉ nhãn tích cực.

Số liệu trong danh mục này tính toán sự khác biệt trong phân bổ nhãn của các giá trị thuộc tính khác nhau. Phân phối nhãn cho một giá trị thuộc tính chứa tất cả các giá trị nhãn được quan sát, cùng với phần mẫu có giá trị của nhãn đó. Ví dụ, trong hình thể hiện sự phân bổ nhãn, 88.6% phụ nữ có nhãn quan sát tiêu cực và 11.4% có nhãn quan sát tích cực. Vì vậy, phân bổ nhãn cho phụ nữ là [0.886, 0.114] và đối với nam giới là [0.686, 0.314].

Số liệu cơ bản trong danh mục này, phân kỳ Kullback-Leibler (KL), đo lường sự khác biệt này như sau:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

Các số liệu nâng cao trong danh mục này, phân kỳ Jensen-Shannon (JS), Lp-norm (LP), Tổng khoảng cách biến thiên (TVD) và Kolmogorov-Smirnov (KS), cũng đo lường sự khác biệt giữa các phân bố nhưng có các đặc tính toán học khác nhau. Ngoại trừ những trường hợp đặc biệt, họ sẽ cung cấp những hiểu biết sâu sắc tương tự như KL. Ví dụ: mặc dù giá trị KL có thể là vô cùng khi giá trị khía cạnh không chứa mẫu có nhãn nhất định (ví dụ: không có nam giới nào có nhãn âm), JS tránh các giá trị vô hạn này. Để biết thêm chi tiết về những khác biệt này, xem Sách trắng về tính công bằng và khả năng giải thích của Amazon AI.

Mối quan hệ giữa DPL (Loại 2) và các số liệu dựa trên phân phối của KL/JS/LP/TVD/KS (Loại 3)

Các số liệu dựa trên phân phối có thể áp dụng tự nhiên hơn cho các nhãn không nhị phân. Đối với nhãn nhị phân, do thực tế là sự mất cân bằng trong nhãn tích cực có thể được sử dụng để tính toán sự mất cân bằng trong nhãn tiêu cực, nên số liệu phân phối cung cấp thông tin chi tiết tương tự như DPL. Vì vậy, bạn chỉ có thể sử dụng DPL trong những trường hợp như vậy.

Xu hướng sau đào tạo

Các chỉ số sai lệch sau đào tạo trong SageMaker Clarify giúp chúng tôi trả lời hai câu hỏi chính:

- Có phải tất cả các giá trị khía cạnh được thể hiện ở một tỷ lệ tương tự trong các dự đoán mô hình tích cực (thuận lợi) không?

- Mô hình có hiệu suất dự đoán tương tự cho tất cả các giá trị khía cạnh không?

Hình dưới đây cho thấy cách các chỉ số ánh xạ tới từng câu hỏi này. Câu hỏi thứ hai có thể được chia nhỏ hơn tùy thuộc vào nhãn nào mà hiệu suất được đo lường.

Đại diện bình đẳng trong dự đoán mô hình tích cực

Các chỉ số trong danh mục này kiểm tra xem tất cả các giá trị thuộc tính có chứa một phần mẫu tương tự có nhãn được dự đoán dương tính theo mô hình hay không. Lớp số liệu này rất giống với số liệu huấn luyện trước của DPL và CDDL—điểm khác biệt duy nhất là danh mục này xem xét các nhãn được dự đoán thay vì các nhãn được quan sát.

Trong tập dữ liệu mẫu của chúng tôi, 4.5% tổng số phụ nữ được mô hình gán nhãn tích cực và 13.7% tổng số nam giới được gán nhãn tích cực.

Số liệu cơ bản trong danh mục này, Sự khác biệt về Tỷ lệ Tích cực trong Nhãn Dự đoán (DPPL), đo lường sự khác biệt trong các bài tập lớp tích cực.

DPPL = 0.137 - 0.045 = 0.092

Hãy lưu ý rằng trong dữ liệu đào tạo, phần lớn nam giới có nhãn được quan sát tích cực cao hơn. Theo cách tương tự, tỷ lệ nam giới cao hơn được gán nhãn dự đoán tích cực.

Chuyển sang các số liệu nâng cao trong danh mục này, Tác động Khác biệt (DI) đo lường sự chênh lệch tương tự trong các bài tập tích cực của lớp, nhưng thay vì sự khác biệt, nó tính tỷ lệ:

DI = 0.045 / 0.137 = 0.328

Cả DI và DPPL đều truyền tải những hiểu biết sâu sắc giống nhau về mặt chất lượng nhưng khác nhau ở một số trường hợp góc. Ví dụ, các tỷ số có xu hướng bùng nổ thành những con số rất lớn nếu mẫu số nhỏ. Lấy ví dụ về các số 0.1 và 0.0001. Tỷ lệ là 0.1/0.0001 = 10,000 trong khi chênh lệch là 0.1 – 0.0001 ≈ 0.1. Không giống như các số liệu khác trong đó giá trị 0 hàm ý không có độ lệch, đối với DI, không có độ lệch tương ứng với giá trị 1.

Sự chênh lệch nhân khẩu học có điều kiện trong các nhãn dự đoán (CDDPL) đo lường sự chênh lệch về biểu thị giá trị khía cạnh trong nhãn tích cực, nhưng giống như chỉ số đào tạo trước của CDDL, nó cũng kiểm soát nghịch lý Simpson.

Kiểm tra lật ngược thực tế (FT) đo lường xem các mẫu tương tự từ hai giá trị khía cạnh có nhận được quyết định tương tự từ mô hình hay không. Một mô hình gán các quyết định khác nhau cho hai mẫu tương tự nhau nhưng khác nhau về giá trị khía cạnh có thể bị coi là sai lệch so với giá trị khía cạnh được gán nhãn bất lợi (âm). Với giá trị khía cạnh đầu tiên (phụ nữ), nó sẽ đánh giá xem liệu các thành viên tương tự có giá trị khía cạnh khác (nam) có dự đoán mô hình khác hay không. Các thành viên tương tự được chọn dựa trên thuật toán lân cận gần nhất k.

Hiệu suất ngang nhau

Các dự đoán mô hình có thể có cách biểu thị tương tự trong các nhãn tích cực từ các giá trị khía cạnh khác nhau, tuy nhiên hiệu suất mô hình trên các nhóm này có thể khác nhau đáng kể. Trong nhiều ứng dụng, có thể mong muốn có được hiệu suất dự đoán tương tự trên các giá trị khía cạnh khác nhau. Các số liệu trong danh mục này đo lường sự khác biệt về hiệu suất dự đoán giữa các giá trị thuộc tính.

Vì dữ liệu có thể được phân chia theo nhiều cách khác nhau dựa trên nhãn được quan sát hoặc dự đoán nên có nhiều cách khác nhau để đo lường hiệu suất dự đoán.

Hiệu suất dự đoán như nhau bất kể nhãn

Bạn có thể xem xét hiệu suất của mô hình trên toàn bộ dữ liệu, bất kể nhãn được quan sát hay dự đoán - tức là độ chính xác tổng thể.

Các hình dưới đây cho thấy cách mô hình phân loại đầu vào từ hai giá trị thuộc tính trong tập dữ liệu mẫu của chúng tôi. Âm tính thực (TN) là trường hợp cả nhãn được quan sát và nhãn dự đoán đều bằng 0. Dương tính giả (FP) là phân loại sai trong đó nhãn được quan sát là 0 nhưng nhãn được dự đoán là 1. Dương tính thật (TP) và âm tính giả (FN) được xác định tương tự.

|

|

Đối với mỗi giá trị khía cạnh, hiệu suất mô hình tổng thể, nghĩa là độ chính xác cho giá trị khía cạnh đó là:

tính chính xác = (TN + TP🇧🇷TN + FP + FN + TP)

Với công thức này, độ chính xác đối với nữ là 0.930 và đối với nam là 0.815. Điều này dẫn đến số liệu duy nhất trong danh mục này, Sự khác biệt về độ chính xác (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 có nghĩa là độ chính xác của cả hai nhóm là như nhau. Giá trị lớn hơn (dương hoặc âm) cho thấy sự khác biệt lớn hơn về độ chính xác.

Hiệu suất tương đương chỉ trên nhãn tích cực

Bạn có thể hạn chế phân tích hiệu suất mô hình chỉ ở các nhãn tích cực. Ví dụ: nếu ứng dụng nhằm phát hiện các khuyết tật trên dây chuyền lắp ráp, thì có thể nên kiểm tra xem các bộ phận không bị lỗi (nhãn tích cực) thuộc các loại khác nhau (giá trị khía cạnh) có được phân loại là không bị lỗi ở cùng một tỷ lệ hay không. Số lượng này được gọi là thu hồi hoặc tỷ lệ dương thực sự:

Nhớ lại = TP / (TP + FN)

Trong tập dữ liệu mẫu của chúng tôi, mức thu hồi đối với phụ nữ là 0.389 và mức thu hồi đối với nam giới là 0.425. Điều này dẫn đến số liệu cơ bản trong danh mục này, Sự khác biệt về khả năng thu hồi (RD):

RD = 0.425 - 0.389 = 0.036

Bây giờ, hãy xem xét ba chỉ số nâng cao trong danh mục này, xem chúng mã hóa tùy chọn người dùng nào và chúng khác với chỉ số cơ bản của RD như thế nào.

Đầu tiên, thay vì đo lường hiệu suất trên các nhãn được quan sát tích cực, bạn có thể đo lường hiệu suất trên các nhãn được dự đoán tích cực. Cho một giá trị thuộc tính, chẳng hạn như phụ nữ và tất cả các mẫu có giá trị thuộc tính đó được mô hình dự đoán là dương tính, có bao nhiêu mẫu thực sự được phân loại chính xác là dương tính? Đại lượng này được gọi là tỷ lệ chấp nhận (AR) hoặc độ chính xác:

AR = TP / (TP + FP)

Trong ví dụ của chúng tôi, AR cho nữ là 0.977 và AR cho nam là 0.970. Điều này dẫn đến sự khác biệt về tỷ lệ chấp nhận (DAR):

DAR = 0.970 - 0.977 = -0.007

Một cách khác để đo lường độ lệch là kết hợp hai chỉ số trước đó và đo xem mô hình gán cho một giá trị khía cạnh nhiều hơn bao nhiêu dự đoán tích cực so với các nhãn tích cực được quan sát. SageMaker Clarify đo lường lợi thế này bằng mô hình dưới dạng tỷ lệ giữa số lượng nhãn tích cực được quan sát cho giá trị khía cạnh đó và số lượng nhãn tích cực được dự đoán và gọi nó là sự chấp nhận có điều kiện (CA):

CA = (TP + FN🇧🇷TP + FP)

Trong ví dụ của chúng tôi, CA đối với phụ nữ là 2.510 và đối với nam giới là 2.283. Sự khác biệt về CA dẫn đến số liệu cuối cùng trong danh mục này, Sự khác biệt trong Chấp nhận có điều kiện (DCA):

DCA = 2.283 - 2.510 = -0.227

Hiệu suất tương đương chỉ trên nhãn phủ định

Theo cách tương tự như nhãn tích cực, độ lệch cũng có thể được tính bằng chênh lệch hiệu suất trên nhãn phủ định. Việc xem xét các nhãn âm một cách riêng biệt có thể quan trọng trong một số ứng dụng nhất định. Ví dụ: trong ví dụ về phát hiện lỗi của chúng tôi, chúng tôi có thể muốn phát hiện các bộ phận bị lỗi (nhãn âm) thuộc các loại khác nhau (giá trị thuộc tính) ở cùng một tỷ lệ.

Số liệu cơ bản trong danh mục này, độ đặc hiệu, tương tự như số liệu thu hồi (tỷ lệ dương tính thực). Độ đặc hiệu tính toán độ chính xác của mô hình trên các mẫu có giá trị khía cạnh này có nhãn âm được quan sát:

Tính đặc hiệu = TN / (TN + FP)

Trong ví dụ của chúng tôi (xem bảng nhầm lẫn), độ đặc hiệu cho phụ nữ và nam giới lần lượt là 0.999 và 0.994. Do đó, Sự khác biệt về tính đặc hiệu (SD) là:

SD = 0.994 - 0.999 = -0.005

Tiếp tục, giống như thước đo tỷ lệ chấp nhận, đại lượng tương tự cho nhãn phủ định—tỷ lệ từ chối (RR)—là:

RR = TN / (TN + FN)

RR đối với phụ nữ là 0.927 và đối với nam giới là 0.791, dẫn đến chỉ số Sự khác biệt về Tỷ lệ Từ chối (DRR):

DRR = 0.927 - 0.791 = -0.136

Cuối cùng, nhãn phủ định tương tự của chấp nhận có điều kiện, từ chối có điều kiện (CR), là tỷ lệ giữa số lượng nhãn phủ định được quan sát cho giá trị khía cạnh đó và số lượng nhãn phủ định được dự đoán:

CR = (TN + FP🇧🇷TN + FN)

CR đối với nữ là 0.928 và đối với nam là 0.796. Số liệu cuối cùng trong danh mục này là Sự khác biệt trong Từ chối có điều kiện (DCR):

DCR = 0.796 - 0.928 = 0.132

Hiệu suất như nhau trên nhãn tích cực và tiêu cực

SageMaker Clarify kết hợp hai danh mục trước đó bằng cách xem xét tỷ lệ hiệu suất mô hình trên nhãn dương và nhãn âm. Cụ thể, đối với mỗi giá trị khía cạnh, SageMaker Clarify tính toán tỷ lệ giữa kết quả âm tính giả (FN) và kết quả dương tính giả (FP). Trong ví dụ của chúng tôi, tỷ lệ FN/FP ở nữ là 679/10 = 67.9 và ở nam là 3678/84 = 43.786. Điều này dẫn đến chỉ số Bình đẳng trong điều trị (TE), đo lường sự khác biệt giữa tỷ lệ FP/FN:

TE = 67.9 - 43.786 = 24.114

Ảnh chụp màn hình sau đây cho thấy cách bạn có thể sử dụng SageMaker Clarify với Xưởng sản xuất Amazon SageMaker để hiển thị các giá trị cũng như phạm vi và mô tả ngắn gọn về các số liệu sai lệch khác nhau.

Câu hỏi về độ lệch: Bắt đầu với số liệu nào?

Hãy nhớ lại các câu hỏi mẫu về sự thiên vị ở đầu bài viết này. Sau khi xem xét các số liệu từ các danh mục khác nhau, hãy xem xét lại các câu hỏi. Để trả lời câu hỏi đầu tiên liên quan đến cách trình bày của các nhóm khác nhau trong dữ liệu huấn luyện, bạn có thể bắt đầu với chỉ số Mất cân bằng lớp (CI). Tương tự, đối với các câu hỏi còn lại, bạn có thể bắt đầu bằng cách xem xét Sự khác biệt về Tỷ lệ Dương trong Nhãn (DPL), Sự khác biệt về Độ chính xác (AD), Sự khác biệt về Tỷ lệ Chấp nhận (DAR) và Sự khác biệt về Thu hồi (RD), tương ứng.

Xu hướng không có giá trị khía cạnh

Để dễ trình bày, mô tả về các chỉ số sau đào tạo này đã loại trừ chỉ số Chỉ số Entropy tổng quát (GE). Số liệu này đo lường độ lệch mà không xem xét giá trị khía cạnh và có thể hữu ích trong việc đánh giá cách phân bổ lỗi của mô hình. Để biết chi tiết, hãy tham khảo Entropy tổng quát (GE).

Kết luận

Trong bài đăng này, bạn đã biết cách 21 số liệu khác nhau trong SageMaker Clarify đo lường độ lệch ở các giai đoạn khác nhau của quy trình ML. Bạn đã tìm hiểu về các số liệu khác nhau thông qua trường hợp sử dụng dự đoán thu nhập, cách chọn số liệu cho trường hợp sử dụng của mình và những số liệu nào bạn có thể bắt đầu.

Bắt đầu hành trình AI có trách nhiệm của bạn bằng cách đánh giá độ lệch trong các mô hình ML của bạn bằng sổ ghi chép demo Công bằng và khả năng giải thích với SageMaker Clarify. Bạn có thể tìm tài liệu chi tiết về SageMaker Clarify, bao gồm định nghĩa chính thức về số liệu, tại Tính công bằng và khả năng giải thích mô hình đối với các dự đoán của học máy là gì. Để triển khai các số liệu sai lệch bằng nguồn mở, hãy tham khảo tài liệu aws-sagemaker-làm rõ kho lưu trữ GitHub. Để thảo luận chi tiết bao gồm các hạn chế, hãy tham khảo Sách trắng về tính công bằng và khả năng giải thích của Amazon AI.

Giới thiệu về tác giả

song phương Zafar là Nhà khoa học ứng dụng tại AWS, làm việc về Tính công bằng, Khả năng giải thích và Bảo mật trong Học máy.

song phương Zafar là Nhà khoa học ứng dụng tại AWS, làm việc về Tính công bằng, Khả năng giải thích và Bảo mật trong Học máy.

Denis V. Batalov là Kiến trúc sư giải pháp của AWS, chuyên về Machine Learning. Anh ấy đã làm việc cho Amazon từ năm 2005. Denis có bằng Tiến sĩ trong lĩnh vực AI. Theo dõi anh ấy trên Twitter: @dbatalov.

Michele Donini là một Nhà Khoa học Ứng dụng Sr tại AWS. Anh ấy dẫn đầu một nhóm các nhà khoa học làm việc về AI có trách nhiệm và sở thích nghiên cứu của anh ấy là Công bằng thuật toán và Học máy có thể giải thích.

Michele Donini là một Nhà Khoa học Ứng dụng Sr tại AWS. Anh ấy dẫn đầu một nhóm các nhà khoa học làm việc về AI có trách nhiệm và sở thích nghiên cứu của anh ấy là Công bằng thuật toán và Học máy có thể giải thích.

- AI

- nghệ thuật ai

- máy phát điện nghệ thuật ai

- ai rô bốt

- Amazon SageMaker

- trí tuệ nhân tạo

- chứng nhận trí tuệ nhân tạo

- trí tuệ nhân tạo trong ngân hàng

- robot trí tuệ nhân tạo

- robot trí tuệ nhân tạo

- phần mềm trí tuệ nhân tạo

- Học máy AWS

- blockchain

- hội nghị blockchain ai

- thiên tài

- trí tuệ nhân tạo đàm thoại

- hội nghị tiền điện tử ai

- dall's

- học kĩ càng

- google ai

- học máy

- plato

- Plato ai

- Thông tin dữ liệu Plato

- Trò chơi Plato

- PlatoDữ liệu

- Platogaming

- quy mô ai

- cú pháp

- zephyrnet