Trí tuệ nhân tạo (AI) gần đây đã tạo ra một làn sóng phẫn nộ với khả năng cách mạng hóa cách mọi người tiếp cận và giải quyết các nhiệm vụ và vấn đề phức tạp khác nhau. Từ chăm sóc sức khỏe đến tài chính, AI và các mô hình học máy liên quan đã chứng tỏ tiềm năng của chúng trong việc hợp lý hóa các quy trình phức tạp, nâng cao mô hình ra quyết định và khám phá những hiểu biết có giá trị.

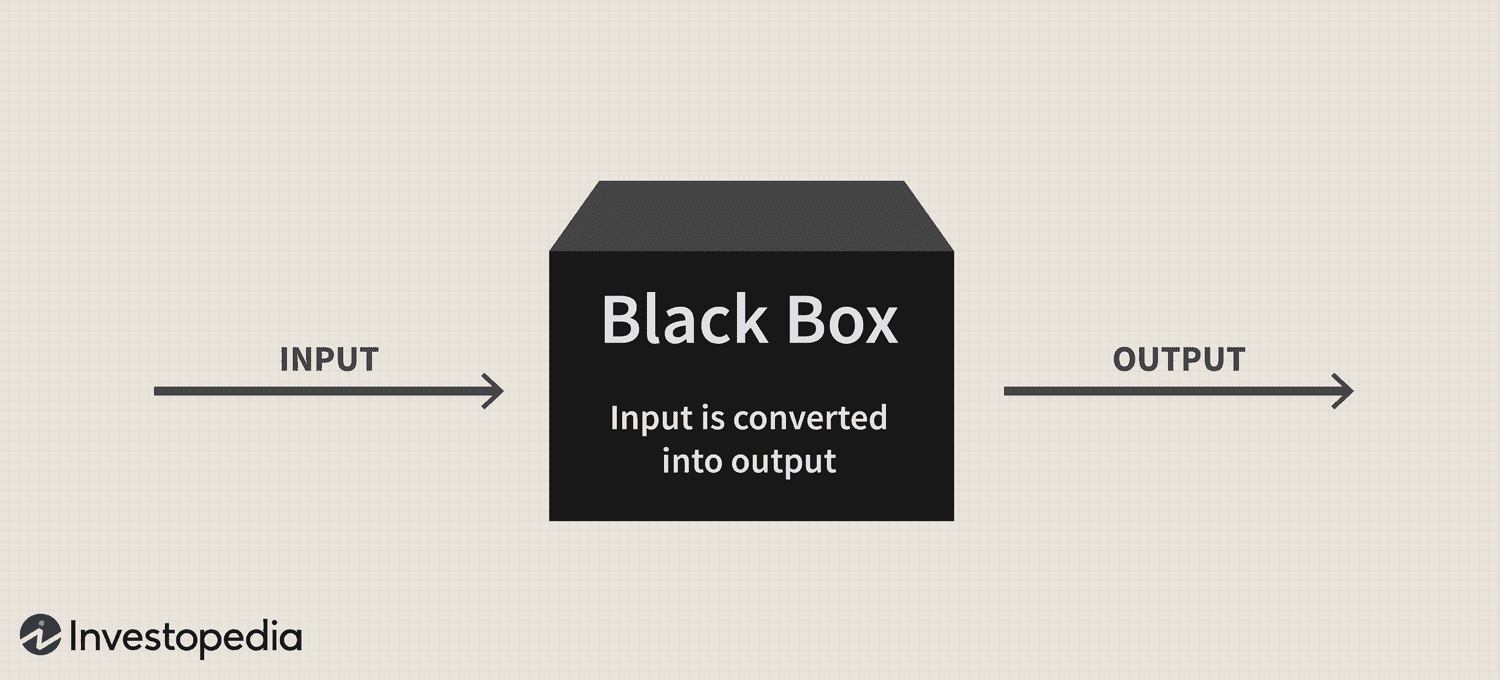

Tuy nhiên, bất chấp tiềm năng to lớn của công nghệ, vấn đề “hộp đen” kéo dài vẫn tiếp tục là một thách thức đáng kể đối với việc áp dụng nó, đặt ra câu hỏi về tính minh bạch và khả năng diễn giải của các hệ thống tinh vi này.

Tóm lại, vấn đề về hộp đen bắt nguồn từ việc khó hiểu cách các hệ thống AI và mô hình máy học xử lý dữ liệu và đưa ra các dự đoán hoặc quyết định. Các mô hình này thường dựa trên các thuật toán phức tạp không dễ hiểu đối với con người, dẫn đến việc thiếu trách nhiệm và sự tin cậy.

Do đó, khi AI ngày càng được tích hợp vào nhiều khía cạnh khác nhau trong cuộc sống của chúng ta, thì việc giải quyết vấn đề này là rất quan trọng để đảm bảo việc sử dụng công nghệ mạnh mẽ này có trách nhiệm và có đạo đức.

Hộp đen: Tổng quan

Phép ẩn dụ “hộp đen” bắt nguồn từ quan điểm cho rằng các hệ thống AI và mô hình học máy hoạt động theo cách mà con người không thể hiểu được, giống như nội dung của một chiếc hộp mờ đục được niêm phong. Các hệ thống này được xây dựng dựa trên các mô hình toán học phức tạp và tập hợp dữ liệu nhiều chiều, tạo ra các mối quan hệ và mẫu phức tạp hướng dẫn quá trình ra quyết định của chúng. Tuy nhiên, những hoạt động bên trong này không dễ dàng tiếp cận hoặc hiểu được đối với con người.

Về mặt thực tế, vấn đề về hộp đen AI là khó khăn trong việc giải mã lý do đằng sau các dự đoán hoặc quyết định của hệ thống AI. Vấn đề này đặc biệt phổ biến trong các mô hình học sâu như mạng thần kinh, trong đó nhiều lớp nút được kết nối với nhau xử lý và chuyển đổi dữ liệu theo cách phân cấp. Sự phức tạp của các mô hình này và các phép biến đổi phi tuyến tính mà chúng thực hiện khiến việc theo dõi cơ sở lý luận đằng sau các kết quả đầu ra của chúng trở nên vô cùng khó khăn.

Nikita Brudnov, Giám đốc điều hành của BR Group - một bảng điều khiển phân tích tiếp thị dựa trên AI - nói với Cointelegraph rằng sự thiếu minh bạch trong cách các mô hình AI đưa ra các quyết định và dự đoán nhất định có thể là vấn đề trong nhiều bối cảnh, chẳng hạn như chẩn đoán y tế, ra quyết định tài chính và tố tụng pháp lý, ảnh hưởng đáng kể đến việc tiếp tục áp dụng AI.

Tạp chí: Joe Lubin: Sự thật về sự chia rẽ của những người sáng lập ETH và 'Crypto Google'

Ông nói: “Trong những năm gần đây, người ta đã chú ý nhiều đến việc phát triển các kỹ thuật diễn giải và giải thích các quyết định do các mô hình AI đưa ra, chẳng hạn như tạo điểm số về mức độ quan trọng của tính năng, trực quan hóa ranh giới quyết định và xác định các giải thích giả thuyết phản thực tế”.

“Tuy nhiên, những kỹ thuật này vẫn còn sơ khai và không có gì đảm bảo rằng chúng sẽ hiệu quả trong mọi trường hợp.”

Brudnov còn tin rằng với việc phân cấp hơn nữa, các cơ quan quản lý có thể yêu cầu các quyết định do hệ thống AI đưa ra phải minh bạch và có trách nhiệm hơn để đảm bảo giá trị đạo đức và sự công bằng tổng thể của chúng. Ông cũng gợi ý rằng người tiêu dùng có thể ngần ngại sử dụng các sản phẩm và dịch vụ do AI cung cấp nếu họ không hiểu cách chúng hoạt động và quy trình ra quyết định của chúng.

James Wo, người sáng lập DFG - một công ty đầu tư tích cực đầu tư vào các công nghệ liên quan đến AI - tin rằng vấn đề hộp đen sẽ không ảnh hưởng đến việc áp dụng trong tương lai gần. Per Wo, hầu hết người dùng không nhất thiết phải quan tâm đến cách thức hoạt động của các mô hình AI hiện tại và rất vui khi chỉ đơn giản là nhận được tiện ích từ chúng, ít nhất là vào thời điểm hiện tại.

“Trong trung hạn, một khi tính mới của các nền tảng này mất đi, chắc chắn sẽ có nhiều hoài nghi hơn về phương pháp hộp đen. Các câu hỏi cũng sẽ tăng lên khi việc sử dụng AI vào tiền điện tử và Web3, nơi có các rủi ro tài chính và hậu quả cần xem xét,” ông thừa nhận.

Tác động đến niềm tin và tính minh bạch

Một lĩnh vực mà sự thiếu minh bạch có thể ảnh hưởng đáng kể đến niềm tin là chẩn đoán y tế dựa trên AI. Ví dụ: các mô hình AI có thể phân tích dữ liệu y tế phức tạp trong chăm sóc sức khỏe để đưa ra các chẩn đoán hoặc khuyến nghị điều trị. Tuy nhiên, khi các bác sĩ lâm sàng và bệnh nhân không thể hiểu được lý do đằng sau những gợi ý này, họ có thể đặt câu hỏi về độ tin cậy và giá trị của những hiểu biết này. Sự hoài nghi này có thể dẫn đến sự do dự trong việc áp dụng các giải pháp AI, có khả năng cản trở những tiến bộ trong chăm sóc bệnh nhân và y học cá nhân hóa.

Trong lĩnh vực tài chính, các hệ thống AI có thể được sử dụng để chấm điểm tín dụng, phát hiện gian lận và đánh giá rủi ro. Tuy nhiên, vấn đề về hộp đen có thể tạo ra sự không chắc chắn về tính công bằng và chính xác của các điểm tín dụng này hoặc lý do đằng sau các cảnh báo gian lận, hạn chế khả năng số hóa ngành của công nghệ.

Ngành công nghiệp tiền điện tử cũng phải đối mặt với những hậu quả của vấn đề hộp đen. Ví dụ: tài sản kỹ thuật số và công nghệ chuỗi khối bắt nguồn từ tính phi tập trung, tính mở và khả năng kiểm chứng. Các hệ thống AI thiếu tính minh bạch và khả năng diễn giải sẽ tạo ra sự mất kết nối giữa kỳ vọng của người dùng và thực tế của các giải pháp do AI điều khiển trong lĩnh vực này.

Mối quan tâm về quy định

Từ quan điểm pháp lý, vấn đề hộp đen AI đưa ra những thách thức độc đáo. Đối với những người mới bắt đầu, tính không rõ ràng của các quy trình AI có thể khiến các cơ quan quản lý ngày càng khó đánh giá sự tuân thủ của các hệ thống này với các quy tắc và hướng dẫn hiện có. Hơn nữa, sự thiếu minh bạch có thể làm phức tạp khả năng của các cơ quan quản lý trong việc phát triển các khuôn khổ mới có thể giải quyết các rủi ro và thách thức do các ứng dụng AI gây ra.

Các nhà lập pháp có thể gặp khó khăn trong việc đánh giá tính công bằng, thiên vị và các hoạt động bảo mật dữ liệu của hệ thống AI cũng như tác động tiềm ẩn của chúng đối với quyền của người tiêu dùng và sự ổn định của thị trường. Ngoài ra, nếu không hiểu rõ về quy trình ra quyết định của các hệ thống do AI điều khiển, các cơ quan quản lý có thể gặp khó khăn trong việc xác định các lỗ hổng tiềm ẩn và đảm bảo áp dụng các biện pháp bảo vệ thích hợp để giảm thiểu rủi ro.

Một sự phát triển quy định đáng chú ý liên quan đến công nghệ này là Đạo luật Trí tuệ Nhân tạo của Liên minh Châu Âu, đang tiến lại gần hơn trở thành một phần trong quy chế của khối sau khi đạt được thỏa thuận chính trị tạm thời vào ngày 27 tháng XNUMX.

Về cốt lõi, Đạo luật AI nhằm mục đích tạo ra một môi trường đáng tin cậy và có trách nhiệm để phát triển AI trong EU. Các nhà lập pháp đã áp dụng một hệ thống phân loại phân loại các loại AI khác nhau theo rủi ro: không thể chấp nhận, cao, hạn chế và tối thiểu. Khung này được thiết kế để giải quyết các mối lo ngại khác nhau liên quan đến vấn đề hộp đen AI, bao gồm các vấn đề về tính minh bạch và trách nhiệm giải trình.

Việc không thể giám sát và điều chỉnh hiệu quả các hệ thống AI đã làm căng thẳng mối quan hệ giữa các ngành và cơ quan quản lý khác nhau.

Đầu tháng trước, chatbot AI nổi tiếng ChatGPT đã được ra mắt. bị cấm ở Ý trong 29 ngày, chủ yếu là do những lo ngại về quyền riêng tư do cơ quan bảo vệ dữ liệu của quốc gia đưa ra vì nghi ngờ vi phạm Quy định bảo vệ dữ liệu chung (GDPR) của EU. Tuy nhiên, nền tảng này đã được phép tiếp tục các dịch vụ của mình vào ngày 29 tháng XNUMX sau khi Giám đốc điều hành Sam Altman thông báo rằng ông và nhóm của mình đã thực hiện các bước cụ thể để tuân thủ các yêu cầu của cơ quan quản lý, bao gồm cả việc tiết lộ các phương pháp xử lý dữ liệu và triển khai thực hiện quy định về độ tuổi. các biện pháp kiểm soát.

Quy định không đầy đủ về hệ thống AI có thể làm xói mòn niềm tin của công chúng vào các ứng dụng AI khi người dùng ngày càng lo ngại về những thành kiến cố hữu, sự không chính xác và ý nghĩa đạo đức.

Xử lý sự cố hộp đen

Để giải quyết vấn đề hộp đen AI một cách hiệu quả, việc sử dụng kết hợp các phương pháp thúc đẩy tính minh bạch, khả năng diễn giải và trách nhiệm giải trình là điều cần thiết. Hai chiến lược bổ sung như vậy là AI có thể giải thích được (XAI) và các mô hình mã nguồn mở.

XAI là một lĩnh vực nghiên cứu chuyên thu hẹp khoảng cách giữa sự phức tạp của các hệ thống AI và nhu cầu về khả năng diễn giải của con người. XAI tập trung vào việc phát triển các kỹ thuật và thuật toán có thể đưa ra lời giải thích mà con người có thể hiểu được đối với các quyết định do AI điều khiển, cung cấp thông tin chuyên sâu về lý do đằng sau những lựa chọn này.

Các phương pháp thường được sử dụng trong XAI bao gồm các mô hình thay thế, phân tích tầm quan trọng của tính năng, phân tích độ nhạy và giải thích mô hình bất khả tri có thể diễn giải cục bộ. Việc triển khai XAI trong các ngành có thể giúp các bên liên quan hiểu rõ hơn về các quy trình do AI điều khiển, nâng cao niềm tin vào công nghệ và tạo điều kiện tuân thủ các yêu cầu quy định.

Song song với XAI, việc thúc đẩy áp dụng các mô hình AI nguồn mở có thể là một chiến lược hiệu quả để giải quyết vấn đề hộp đen. Các mô hình nguồn mở cấp toàn quyền truy cập vào các thuật toán và dữ liệu điều khiển các hệ thống AI, cho phép người dùng và nhà phát triển xem xét kỹ lưỡng và hiểu các quy trình cơ bản.

Tính minh bạch ngày càng tăng này có thể giúp xây dựng lòng tin và thúc đẩy sự hợp tác giữa các nhà phát triển, nhà nghiên cứu và người dùng. Hơn nữa, cách tiếp cận nguồn mở có thể tạo ra các hệ thống AI mạnh mẽ, có trách nhiệm và hiệu quả hơn.

Vấn đề hộp đen trong không gian tiền điện tử

Vấn đề hộp đen có sự phân nhánh đáng kể đối với các khía cạnh khác nhau của không gian tiền điện tử, bao gồm chiến lược giao dịch, dự đoán thị trường, biện pháp bảo mật, token hóa và hợp đồng thông minh.

Trong lĩnh vực chiến lược giao dịch và dự đoán thị trường, các mô hình do AI điều khiển đang trở nên phổ biến khi các nhà đầu tư tìm cách tận dụng giao dịch thuật toán. Tuy nhiên, vấn đề hộp đen cản trở sự hiểu biết của người dùng về cách thức hoạt động của các mô hình này, khiến việc đánh giá hiệu quả và rủi ro tiềm ẩn của chúng trở nên khó khăn. Do đó, sự không rõ ràng này cũng có thể dẫn đến sự tin tưởng không chính đáng vào các quyết định đầu tư do AI điều khiển hoặc khiến các nhà đầu tư phụ thuộc quá nhiều vào các hệ thống tự động.

AI đóng một vai trò quan trọng trong việc tăng cường các biện pháp bảo mật trong hệ sinh thái chuỗi khối bằng cách phát hiện các giao dịch gian lận và các hoạt động đáng ngờ. Tuy nhiên, sự cố hộp đen làm phức tạp quá trình xác minh đối với các giải pháp bảo mật dựa trên AI này. Việc thiếu minh bạch trong quá trình ra quyết định có thể làm xói mòn niềm tin vào các hệ thống bảo mật, gây lo ngại về khả năng bảo vệ tài sản và thông tin của người dùng.

Tokenization và hợp đồng thông minh — hai thành phần quan trọng của hệ sinh thái blockchain — cũng đang chứng kiến sự tích hợp ngày càng tăng của AI. Tuy nhiên, vấn đề hộp đen có thể che khuất logic đằng sau mã thông báo do AI tạo hoặc thực thi hợp đồng thông minh.

Khi AI cách mạng hóa các ngành công nghiệp khác nhau, việc giải quyết vấn đề hộp đen đang trở nên cấp bách hơn. Bằng cách thúc đẩy sự hợp tác giữa các nhà nghiên cứu, nhà phát triển, nhà hoạch định chính sách và các bên liên quan trong ngành, các giải pháp có thể được phát triển để thúc đẩy tính minh bạch, trách nhiệm giải trình và sự tin cậy trong các hệ thống AI. Do đó, sẽ rất thú vị để xem mô hình công nghệ mới lạ này tiếp tục phát triển như thế nào.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoAiStream. Thông minh dữ liệu Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Đúc kết tương lai với Adryenn Ashley. Truy cập Tại đây.

- Mua và bán cổ phần trong các công ty PRE-IPO với PREIPO®. Truy cập Tại đây.

- nguồn: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- : có

- :là

- :không phải

- :Ở đâu

- 2023

- 27

- a

- có khả năng

- Giới thiệu

- truy cập

- có thể truy cập

- trách nhiệm

- trách nhiệm

- chính xác

- ngang qua

- Hành động

- tích cực

- hoạt động

- thêm

- Ngoài ra

- địa chỉ

- giải quyết

- con nuôi

- Nhận nuôi

- Nhận con nuôi

- tiến bộ

- ảnh hưởng đến

- Sau

- cơ quan

- Hiệp định

- AI

- Đạo luật AI

- Chatbot AI

- Hỗ trợ AI

- Mục tiêu

- Cảnh báo

- thuật toán

- thuật toán kinh doanh

- thuật toán

- Tất cả

- Đã

- Ngoài ra

- trong số

- an

- phân tích

- phân tích

- phân tích

- và

- công bố

- các ứng dụng

- phương pháp tiếp cận

- cách tiếp cận

- thích hợp

- Tháng Tư

- LÀ

- KHU VỰC

- xung quanh

- nhân tạo

- trí tuệ nhân tạo

- AS

- các khía cạnh

- thẩm định, lượng định, đánh giá

- Tài sản

- liên kết

- At

- sự chú ý

- Tự động

- BE

- trở nên

- trở thành

- trở thành

- được

- sau

- tin

- Hơn

- giữa

- thiên vị

- thành kiến

- Đen

- blockchain

- hệ sinh thái blockchain

- Công nghệ blockchain

- cơ quan

- cuốn sách

- ranh giới

- Hộp

- cầu nối

- xây dựng

- xây dựng lòng tin

- xây dựng

- các doanh nghiệp

- by

- CAN

- không thể

- tận

- mà

- trường hợp

- giám đốc điều hành

- nhất định

- thách thức

- thách thức

- thách thức

- chatbot

- ChatGPT

- lựa chọn

- phân loại

- Hệ thống phân loại

- trong sáng

- bác sĩ lâm sàng

- Cointelegraph

- hợp tác

- kết hợp

- bổ túc

- phức tạp

- phức tạp

- tuân thủ

- các thành phần

- hiểu

- quan tâm

- Mối quan tâm

- Hậu quả

- hậu quả là

- Hãy xem xét

- người tiêu dùng

- Các quyền của người tiêu dùng

- Người tiêu dùng

- nội dung

- bối cảnh

- tiếp tục

- liên tiếp

- hợp đồng

- hợp đồng

- Trung tâm

- có thể

- đất nước của

- tạo

- tạo ra

- tín dụng

- quan trọng

- Crypto

- Công nghiệp tiền điện tử

- không gian mật mã

- bảng điều khiển

- dữ liệu

- dữ liệu riêng tư

- xử lý dữ liệu

- bảo vệ dữ liệu

- bộ dữ liệu

- Phân cấp

- quyết định

- Ra quyết định

- quyết định

- dành riêng

- sâu

- học kĩ càng

- chắc chắn

- nhu cầu

- chứng minh

- thiết kế

- Mặc dù

- Phát hiện

- phát triển

- phát triển

- phát triển

- phát triển

- Phát triển

- khác nhau

- khó khăn

- khó khăn

- Khó khăn

- kỹ thuật số

- Tài sản kỹ thuật số

- số hóa

- do

- miền

- dont

- lái xe

- hai

- dễ dàng

- hệ sinh thái

- Hiệu quả

- hiệu quả

- hiệu quả

- việc làm

- cho phép

- nâng cao

- tăng cường

- đảm bảo

- đảm bảo

- Nhập cảnh

- Môi trường

- thiết yếu

- ETH

- đạo đức

- EU

- Châu Âu

- đánh giá

- phát triển

- ví dụ

- thực hiện

- hiện tại

- mong đợi

- giải thích

- Đối mặt

- khuôn mặt

- tạo điều kiện

- công bằng

- Đặc tính

- tài chính

- tài chính

- Công ty

- tập trung

- Trong

- có thể thấy trước

- hình thức

- Foster

- bồi dưỡng

- người sáng lập

- người sáng lập

- Khung

- khung

- gian lận

- phát hiện gian lận

- lừa đảo

- từ

- Full

- chức năng

- xa hơn

- Hơn nữa

- tương lai

- đạt được

- khoảng cách

- GDPR

- Tổng Quát

- dữ liệu chung

- tạo ra

- tạo ra

- cấp

- Nhóm

- Bảo hành

- hướng dẫn

- hướng dẫn

- có

- vui mừng

- Có

- he

- chăm sóc sức khỏe

- giúp đỡ

- Cao

- cản trở

- của mình

- Độ đáng tin của

- Tuy nhiên

- HTTPS

- Nhân loại

- Con người

- xác định

- if

- bao la

- Va chạm

- tác động

- thực hiện

- thực hiện

- hàm ý

- tầm quan trọng

- in

- không có khả năng

- bao gồm

- Bao gồm

- Tăng lên

- tăng

- lên

- các ngành công nghiệp

- ngành công nghiệp

- thông tin

- vốn có

- những hiểu biết

- tích hợp

- hội nhập

- Sự thông minh

- kết nối với nhau

- quan tâm

- thú vị

- trong

- đầu tư

- Các nhà đầu tư

- Đầu tư

- vấn đề

- các vấn đề

- IT

- Italy

- ITS

- Thiếu sót

- Họ

- nhà lập pháp

- lớp

- dẫn

- hàng đầu

- học tập

- ít nhất

- Hợp pháp

- tố tụng

- Lượt thích

- Hạn chế

- cuộc sống

- địa phương

- logic

- máy

- học máy

- thực hiện

- làm cho

- Làm

- cách thức

- nhiều

- thị trường

- dự đoán thị trường

- Marketing

- toán học

- Có thể..

- các biện pháp

- y khoa

- dữ liệu y tế

- y học

- Phương pháp luận

- Might

- tối thiểu

- Giảm nhẹ

- mô hình

- Màn Hình

- tháng

- chi tiết

- Hơn thế nữa

- hầu hết

- di chuyển

- nhiều

- nhiều

- nhất thiết

- Cần

- mạng

- mạng thần kinh

- Tuy nhiên

- Mới

- Không

- các nút

- Nổi bật

- Khái niệm

- tiểu thuyết

- mới lạ

- tại

- of

- off

- cung cấp

- thường

- on

- hàng loạt

- đục

- mã nguồn mở

- Sự cởi mở

- hoạt động

- or

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- tổng thể

- thanh toán

- mô hình

- một phần

- đặc biệt

- bệnh nhân

- bệnh nhân

- mô hình

- người

- Thực hiện

- Cá nhân

- Nơi

- nền tảng

- Nền tảng

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- Play

- các nhà hoạch định chính sách

- chính trị

- Phổ biến

- phổ biến

- khả năng

- tiềm năng

- có khả năng

- mạnh mẽ

- Thực tế

- thực hành

- Dự đoán

- trình bày

- quà

- thịnh hành

- chủ yếu

- riêng tư

- Vấn đề

- vấn đề

- Kỷ yếu

- quá trình

- Quy trình

- xử lý

- Sản phẩm

- thúc đẩy

- Thúc đẩy

- bảo vệ

- cho

- tạm

- công khai

- lòng tin của công

- câu hỏi

- Câu hỏi

- nâng lên

- nâng cao

- lý do

- đạt

- Thực tế

- vương quốc

- gần đây

- gần đây

- khuyến nghị

- về

- Quy định

- Quy định

- quy định

- Điều phối

- nhà quản lý

- liên quan

- Mối quan hệ

- độ tin cậy

- dựa

- hậu quả

- yêu cầu

- Yêu cầu

- nghiên cứu

- nhà nghiên cứu

- chịu trách nhiệm

- kết quả

- tiếp tục

- cách mạng hóa

- cuộc cách mạng

- quyền

- Nguy cơ

- đánh giá rủi ro

- rủi ro

- mạnh mẽ

- Vai trò

- quy tắc

- biện pháp bảo vệ

- Nói

- Sam

- Sam Altman

- ghi bàn

- an ninh

- Các biện pháp an ninh

- xem

- Tìm kiếm

- Độ nhạy

- DỊCH VỤ

- bộ

- hiển thị

- có ý nghĩa

- đáng kể

- đơn giản

- Chủ nghĩa hoài nghi

- thông minh

- hợp đồng thông minh

- Hợp đồng thông minh

- Giải pháp

- động SOLVE

- tinh vi

- nguồn

- Không gian

- riêng

- chia

- Tính ổn định

- các bên liên quan

- đứng

- đứng

- thân cây

- Các bước

- Vẫn còn

- chiến lược

- Chiến lược

- hợp lý hóa

- Đấu tranh

- như vậy

- đáng ngờ

- hệ thống

- hệ thống

- Tandem

- nhiệm vụ

- nhóm

- công nghệ cao

- kỹ thuật

- Công nghệ

- Công nghệ

- về

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- Đó

- Kia là

- họ

- điều này

- đến

- Mã thông báo

- Tokens

- Dấu vết

- Giao dịch

- Chiến lược giao dịch

- Giao dịch

- Chuyển đổi

- biến đổi

- Minh bạch

- minh bạch

- điều trị

- NIỀM TIN

- đáng tin cậy

- Sự thật

- hai

- loại

- Không chắc chắn

- khám phá

- cơ bản

- hiểu

- dễ hiểu

- sự hiểu biết

- độc đáo

- trên

- us

- sử dụng

- người sử dang

- Người sử dụng

- tiện ích

- Quý báu

- khác nhau

- Xác minh

- Vi phạm

- quan trọng

- Lỗ hổng

- là

- Web3

- khi nào

- cái nào

- sẽ

- với

- ở trong

- không có

- chứng kiến

- wo

- Công việc

- hoạt động

- năm

- zephyrnet