Chúng tôi rất vui mừng thông báo rằng Khởi động Amazon SageMaker giờ đây có thể truyền phát các phản hồi suy luận mô hình ngôn ngữ lớn (LLM). Truyền phát mã thông báo cho phép bạn xem đầu ra phản hồi của mô hình khi nó đang được tạo thay vì đợi LLM hoàn thành việc tạo phản hồi trước khi nó được cung cấp cho bạn sử dụng hoặc hiển thị. Khả năng phát trực tuyến trong SageMaker JumpStart có thể giúp bạn xây dựng các ứng dụng có trải nghiệm người dùng tốt hơn bằng cách tạo ra nhận thức về độ trễ thấp cho người dùng cuối.

Trong bài đăng này, chúng tôi sẽ hướng dẫn cách triển khai và truyền phát phản hồi từ một Mô hình hướng dẫn Falcon 7B điểm cuối.

Tại thời điểm viết bài này, các LLM sau có sẵn trong SageMaker JumpStart hỗ trợ phát trực tuyến:

- Mistral AI 7B, Mistral AI 7B Hướng dẫn

- Falcon 180B, Falcon 180B Trò chuyện

- Falcon 40B, Falcon 40B Hướng dẫn

- Falcon 7B, Falcon 7B Hướng dẫn

- Hướng dẫn PPO GPT NeoX 4B của Rinna Nhật Bản

- Hướng dẫn PPO GPT NeoX 3.6B của Rinna Nhật Bản

Để kiểm tra cập nhật về danh sách các mô hình hỗ trợ phát trực tuyến trong SageMaker JumpStart, hãy tìm kiếm “huggingface-llm” tại Các thuật toán tích hợp với Bảng mô hình được đào tạo trước.

Lưu ý rằng bạn có thể sử dụng tính năng phát trực tuyến of Amazon SageMaker lưu trữ ngay lập tức cho bất kỳ mô hình nào được triển khai bằng SageMaker TGI Deep Learning Container (DLC) như được mô tả trong Thông báo ra mắt bộ chứa Suy luận LLM ôm mặt mới trên Amazon SageMaker.

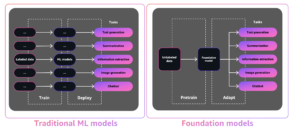

Các mô hình nền tảng trong SageMaker

SageMaker JumpStart cung cấp quyền truy cập vào nhiều mô hình từ các trung tâm mô hình phổ biến, bao gồm Hugging Face, PyTorch Hub và TensorFlow Hub mà bạn có thể sử dụng trong quy trình phát triển ML của mình trong SageMaker. Những tiến bộ gần đây trong ML đã tạo ra một loại mô hình mới được gọi là mô hình nền tảng, thường được đào tạo về hàng tỷ tham số và có thể được điều chỉnh cho phù hợp với nhiều loại trường hợp sử dụng, chẳng hạn như tóm tắt văn bản, tạo tác phẩm nghệ thuật kỹ thuật số và dịch ngôn ngữ. Bởi vì việc đào tạo những mô hình này tốn kém nên khách hàng muốn sử dụng các mô hình nền tảng được đào tạo trước hiện có và tinh chỉnh chúng khi cần, thay vì tự đào tạo những mô hình này. SageMaker cung cấp danh sách mô hình được tuyển chọn mà bạn có thể chọn trên bảng điều khiển SageMaker.

Giờ đây, bạn có thể tìm thấy các mô hình nền tảng từ các nhà cung cấp mô hình khác nhau trong SageMaker JumpStart, cho phép bạn bắt đầu nhanh chóng với các mô hình nền tảng. SageMaker JumpStart cung cấp các mô hình nền tảng dựa trên các tác vụ hoặc nhà cung cấp mô hình khác nhau và bạn có thể dễ dàng xem lại các đặc điểm của mô hình cũng như điều khoản sử dụng. Bạn cũng có thể thử các mô hình này bằng tiện ích giao diện người dùng thử nghiệm. Khi muốn sử dụng mô hình nền tảng trên quy mô lớn, bạn có thể làm như vậy mà không cần rời khỏi SageMaker bằng cách sử dụng sổ ghi chép dựng sẵn từ các nhà cung cấp mô hình. Vì các mô hình được lưu trữ và triển khai trên AWS nên bạn tin tưởng rằng dữ liệu của mình, dù dùng để đánh giá hay sử dụng mô hình trên quy mô lớn, sẽ không bị chia sẻ với bên thứ ba.

truyền mã thông báo

Truyền mã thông báo cho phép phản hồi suy luận được trả về khi nó được mô hình tạo ra. Bằng cách này, bạn có thể thấy phản hồi được tạo tăng dần thay vì đợi mô hình kết thúc trước khi cung cấp phản hồi hoàn chỉnh. Truyền trực tuyến có thể giúp mang lại trải nghiệm người dùng tốt hơn vì nó làm giảm nhận thức về độ trễ cho người dùng cuối. Bạn có thể bắt đầu thấy kết quả khi nó được tạo và do đó có thể ngừng tạo sớm nếu kết quả đầu ra có vẻ không hữu ích cho mục đích của bạn. Truyền trực tuyến có thể tạo ra sự khác biệt lớn, đặc biệt đối với các truy vấn dài hạn, vì bạn có thể bắt đầu thấy kết quả đầu ra khi nó được tạo, điều này có thể tạo ra cảm nhận về độ trễ thấp hơn mặc dù độ trễ từ đầu đến cuối vẫn giữ nguyên.

Tại thời điểm viết bài này, bạn có thể sử dụng tính năng phát trực tuyến trong SageMaker JumpStart cho các mô hình sử dụng Ôm mặt LLM Suy luận tạo văn bản DLC.

| Phản hồi không hấp | Phản hồi bằng tính năng phát trực tuyến |

Tổng quan về giải pháp

Đối với bài đăng này, chúng tôi sử dụng mô hình Falcon 7B Instruct để giới thiệu khả năng phát trực tuyến SageMaker JumpStart.

Bạn có thể sử dụng mã sau để tìm các mẫu khác trong SageMaker JumpStart hỗ trợ phát trực tuyến:

Chúng tôi nhận được các ID mẫu sau hỗ trợ phát trực tuyến:

Điều kiện tiên quyết

Trước khi chạy sổ ghi chép, cần thực hiện một số bước ban đầu để thiết lập. Chạy các lệnh sau:

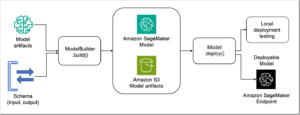

Triển khai mô hình

Bước đầu tiên, hãy sử dụng SageMaker JumpStart để triển khai mô hình Falcon 7B Instruct. Để biết hướng dẫn đầy đủ, hãy tham khảo Mô hình nền tảng Falcon 180B của TII hiện có sẵn thông qua Amazon SageMaker JumpStart. Sử dụng mã sau đây:

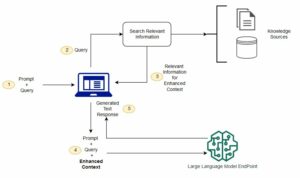

Truy vấn điểm cuối và phản hồi luồng

Tiếp theo, tạo tải trọng để gọi điểm cuối đã triển khai của bạn. Điều quan trọng là tải trọng phải chứa cặp khóa/giá trị "stream": True. Điều này báo hiệu cho máy chủ suy luận tạo văn bản tạo ra phản hồi phát trực tuyến.

Trước khi truy vấn điểm cuối, bạn cần tạo một trình vòng lặp có thể phân tích phản hồi luồng byte từ điểm cuối. Dữ liệu cho mỗi mã thông báo được cung cấp dưới dạng một dòng riêng biệt trong phản hồi, do đó, trình vòng lặp này trả về mã thông báo mỗi khi một dòng mới được xác định trong bộ đệm phát trực tuyến. Trình vòng lặp này được thiết kế tối thiểu và bạn có thể muốn điều chỉnh hành vi của nó cho phù hợp với trường hợp sử dụng của mình; ví dụ: trong khi trình lặp này trả về chuỗi mã thông báo, dữ liệu dòng chứa thông tin khác, chẳng hạn như xác suất nhật ký mã thông báo, có thể được quan tâm.

Bây giờ bạn có thể sử dụng Boto3 invoke_endpoint_with_response_stream API trên điểm cuối mà bạn đã tạo và bật tính năng phát trực tuyến bằng cách lặp qua TokenIterator ví dụ:

Chỉ định trống end tham số cho print sẽ kích hoạt luồng hình ảnh mà không cần chèn ký tự dòng mới. Điều này tạo ra đầu ra sau:

Bạn có thể sử dụng mã này trong sổ tay hoặc các ứng dụng khác như Streamlit hoặc Gradio để xem hoạt động phát trực tuyến cũng như trải nghiệm mà nó mang lại cho khách hàng của bạn.

Làm sạch

Cuối cùng, hãy nhớ dọn dẹp mô hình và điểm cuối đã triển khai của bạn để tránh phát sinh thêm chi phí:

Kết luận

Trong bài đăng này, chúng tôi đã hướng dẫn bạn cách sử dụng tính năng phát trực tuyến mới ra mắt trong SageMaker JumpStart. Chúng tôi hy vọng bạn sẽ sử dụng khả năng truyền phát mã thông báo để xây dựng các ứng dụng tương tác yêu cầu độ trễ thấp để có trải nghiệm người dùng tốt hơn.

Giới thiệu về tác giả

rachna chadha là Kiến trúc sư giải pháp chính AI/ML trong lĩnh vực Tài khoản chiến lược tại AWS. Rachna là một người lạc quan, tin rằng việc sử dụng AI có đạo đức và có trách nhiệm có thể cải thiện xã hội trong tương lai và mang lại sự thịnh vượng về kinh tế và xã hội. Khi rảnh rỗi, Rachna thích dành thời gian cho gia đình, đi bộ đường dài và nghe nhạc.

rachna chadha là Kiến trúc sư giải pháp chính AI/ML trong lĩnh vực Tài khoản chiến lược tại AWS. Rachna là một người lạc quan, tin rằng việc sử dụng AI có đạo đức và có trách nhiệm có thể cải thiện xã hội trong tương lai và mang lại sự thịnh vượng về kinh tế và xã hội. Khi rảnh rỗi, Rachna thích dành thời gian cho gia đình, đi bộ đường dài và nghe nhạc.

Tiến sĩ Kyle Ulrich là một nhà khoa học ứng dụng với Các thuật toán tích hợp sẵn của Amazon SageMaker đội. Lĩnh vực nghiên cứu của ông bao gồm các thuật toán học máy có thể mở rộng, thị giác máy tính, chuỗi thời gian, phi tham số Bayesian và quy trình Gaussian. Tiến sĩ của anh ấy đến từ Đại học Duke và anh ấy đã xuất bản các bài báo trên NeurIPS, Cell và Neuron.

Tiến sĩ Kyle Ulrich là một nhà khoa học ứng dụng với Các thuật toán tích hợp sẵn của Amazon SageMaker đội. Lĩnh vực nghiên cứu của ông bao gồm các thuật toán học máy có thể mở rộng, thị giác máy tính, chuỗi thời gian, phi tham số Bayesian và quy trình Gaussian. Tiến sĩ của anh ấy đến từ Đại học Duke và anh ấy đã xuất bản các bài báo trên NeurIPS, Cell và Neuron.

Tiến sĩ Ashish Khetan là Nhà khoa học ứng dụng cấp cao với các thuật toán tích hợp Amazon SageMaker và giúp phát triển các thuật toán máy học. Ông lấy bằng Tiến sĩ tại Đại học Illinois Urbana-Champaign. Ông là một nhà nghiên cứu tích cực về học máy và suy luận thống kê, đồng thời đã xuất bản nhiều bài báo tại các hội nghị NeurIPS, ICML, ICLR, JMLR, ACL và EMNLP.

Tiến sĩ Ashish Khetan là Nhà khoa học ứng dụng cấp cao với các thuật toán tích hợp Amazon SageMaker và giúp phát triển các thuật toán máy học. Ông lấy bằng Tiến sĩ tại Đại học Illinois Urbana-Champaign. Ông là một nhà nghiên cứu tích cực về học máy và suy luận thống kê, đồng thời đã xuất bản nhiều bài báo tại các hội nghị NeurIPS, ICML, ICLR, JMLR, ACL và EMNLP.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://aws.amazon.com/blogs/machine-learning/stream-large-language-model-responses-in-amazon-sagemaker-jumpstart/

- : có

- :là

- $ LÊN

- 1

- 10

- 100

- 12

- 13

- 14

- 19

- 7

- 8

- a

- Giới thiệu

- truy cập

- Trợ Lý Giám Đốc

- Hoạt động

- hoạt động

- thêm vào

- thêm vào

- tiến bộ

- tư vấn

- AI

- AI / ML

- thuật toán

- cho phép

- Ngoài ra

- đàn bà gan dạ

- Amazon SageMaker

- Khởi động Amazon SageMaker

- Amazon Web Services

- an

- và

- Thông báo

- bất kì

- api

- các ứng dụng

- áp dụng

- LÀ

- Nghệ thuật

- AS

- At

- có sẵn

- tránh

- AWS

- dựa

- Bayesian

- BE

- bởi vì

- trước

- hành vi

- được

- tin

- Hơn

- lớn

- tỷ

- thân hình

- Hộp

- mang lại

- đệm

- xây dựng

- được xây dựng trong

- nhưng

- by

- CAN

- khả năng

- trường hợp

- trường hợp

- Phân loại

- đặc điểm

- nhân vật

- kiểm tra

- Chọn

- tốt nghiệp lớp XNUMX

- giống cá lăng

- khách hàng

- mã

- hoàn thành

- phức tạp

- máy tính

- Tầm nhìn máy tính

- hội nghị

- An ủi

- xây dựng

- chứa

- Container

- Container

- chứa

- nội dung

- Chi phí

- có thể

- tạo

- tạo ra

- Tạo

- CSS

- lưu trữ

- khách hàng

- dữ liệu

- giảm

- sâu

- học kĩ càng

- triển khai

- triển khai

- mô tả

- Thiết kế

- thiết kế

- nhà thiết kế

- Xác định

- phát triển

- Nhà phát triển

- Phát triển

- sự khác biệt

- khác nhau

- kỹ thuật số

- Nghệ thuật kỹ thuật số

- Giao diện

- do

- miền

- Tên miền

- Duke

- đại học công tước

- mỗi

- Đầu

- dễ dàng

- Kinh tế

- cho phép

- cho phép

- Cuối cùng đến cuối

- Điểm cuối

- Động cơ

- đảm bảo

- đặc biệt

- đạo đức

- đánh giá

- Ngay cả

- ví dụ

- kích thích

- hiện tại

- đắt tiền

- kinh nghiệm

- Đối mặt

- gia đình

- Đặc tính

- bộ lọc

- Tìm kiếm

- hoàn thành

- Tên

- tiếp theo

- Trong

- Nền tảng

- Khung

- từ

- Full

- chức năng

- tương lai

- nói chung

- tạo ra

- tạo ra

- tạo ra

- thế hệ

- được

- được

- Các mục tiêu

- có

- hướng dẫn

- Có

- he

- giúp đỡ

- hữu ích

- giúp

- cô

- của mình

- mong

- tổ chức

- lưu trữ

- Độ đáng tin của

- Hướng dẫn

- HTML

- HTTPS

- Hub

- trung tâm

- ÔmKhuôn Mặt

- i

- xác định

- id

- if

- Illinois

- nhập khẩu

- quan trọng

- nâng cao

- in

- bao gồm

- Bao gồm

- chỉ

- thông tin

- ban đầu

- đầu vào

- cài đặt, dựng lên

- ví dụ

- thay vì

- hướng dẫn

- tương tác

- quan tâm

- lợi ích

- IT

- ITS

- Tiếng Nhật

- JavaScript

- json

- Giữ

- nổi tiếng

- kyle

- Ngôn ngữ

- lớn

- Độ trễ

- phóng

- phát động

- học tập

- để lại

- Lượt thích

- Lượt thích

- Dòng

- Danh sách

- Listening

- LLM

- đăng nhập

- tìm kiếm

- Thấp

- thấp hơn

- máy

- học máy

- thực hiện

- duy trì

- làm cho

- nhiều

- Có thể..

- Might

- ML

- kiểu mẫu

- mô hình

- Âm nhạc

- tên

- Cần

- cần thiết

- Mới

- mới

- Không

- máy tính xách tay

- tại

- of

- Cung cấp

- on

- Trực tuyến

- Tối ưu hóa

- or

- Nền tảng khác

- ra

- đầu ra

- kết quả đầu ra

- kết thúc

- đôi

- giấy tờ

- tham số

- thông số

- các bên tham gia

- nhận thức

- Bằng tiến sĩ

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- Phổ biến

- Bài đăng

- Predictor

- Hiệu trưởng

- quá trình

- Quy trình

- sản xuất

- đúng

- sự thịnh vượng

- cung cấp

- nhà cung cấp dịch vụ

- nhà cung cấp

- cung cấp

- cung cấp

- công bố

- mục đích

- mục đích

- ngọn đuốc

- truy vấn

- Mau

- phạm vi

- hơn

- gần đây

- xem

- thường xuyên

- nhớ

- cần phải

- nghiên cứu

- nhà nghiên cứu

- Thông tin

- phản ứng

- phản ứng

- chịu trách nhiệm

- trở lại

- Trả về

- xem xét

- Tăng lên

- chạy

- chạy

- nhà làm hiền triết

- tương tự

- khả năng mở rộng

- Quy mô

- Nhà khoa học

- Tìm kiếm

- Công cụ tìm kiếm

- xem

- nhìn thấy

- Tìm kiếm

- TỰ

- cao cấp

- riêng biệt

- Loạt Sách

- máy chủ

- DỊCH VỤ

- thiết lập

- chia sẻ

- nên

- giới thiệu

- cho thấy

- thông suốt

- So

- Mạng xã hội

- Xã hội

- giải pháp

- một số

- Chi

- Bắt đầu

- bắt đầu

- thống kê

- Bước

- Các bước

- Dừng

- Chiến lược

- dòng

- trực tuyến

- như vậy

- hỗ trợ

- Hỗ trợ

- Nhiệm vụ

- nhiệm vụ

- nhóm

- mẫu

- tensorflow

- về

- thử nghiệm

- văn bản

- hơn

- việc này

- Sản phẩm

- Dòng

- Them

- tự

- Đó

- vì thế

- Kia là

- Thứ ba

- các bên thứ ba

- điều này

- Tuy nhiên?

- Thông qua

- thời gian

- Chuỗi thời gian

- đến

- mã thông báo

- Train

- đào tạo

- Dịch

- đúng

- NIỀM TIN

- thử

- hướng dẫn

- thường

- ui

- trường đại học

- Cập nhật

- Cập nhật

- Sử dụng

- sử dụng

- ca sử dụng

- đã sử dụng

- người sử dang

- Kinh nghiệm người dùng

- sử dụng

- sử dụng

- thông qua

- tầm nhìn

- chờ đợi

- Đợi

- đi bộ

- muốn

- Đường..

- we

- web

- các dịch vụ web

- Website

- khi nào

- liệu

- cái nào

- trong khi

- CHÚNG TÔI LÀ

- rộng

- sẽ

- với

- ở trong

- không có

- quy trình làm việc

- đang làm việc

- viết

- Bạn

- trên màn hình

- zephyrnet