Năm ngoái, chúng tôi đã thông báo về tính khả dụng chung của RStudio trên Amazon SageMaker, môi trường phát triển tích hợp RStudio Workbench được quản lý hoàn toàn đầu tiên trong ngành (IDE) trên đám mây. Bạn có thể nhanh chóng khởi chạy RStudio IDE quen thuộc và quay số lên xuống các tài nguyên máy tính bên dưới mà không làm gián đoạn công việc của bạn, giúp dễ dàng xây dựng các giải pháp học máy (ML) và phân tích trong R ở quy mô lớn.

Với khối lượng dữ liệu ngày càng tăng được tạo ra, các bộ dữ liệu được sử dụng cho ML và phân tích thống kê đang phát triển song song. Điều này mang đến những thách thức về thời gian phát triển tăng lên và tính toán quản lý cơ sở hạ tầng. Để giải quyết những thách thức này, các nhà khoa học dữ liệu đã tìm cách triển khai các kỹ thuật xử lý dữ liệu song song. Xử lý dữ liệu song song, hoặc song song hóa dữ liệu, lấy các tập dữ liệu lớn hiện có và phân phối chúng trên nhiều bộ xử lý hoặc các nút để hoạt động trên dữ liệu đồng thời. Điều này có thể cho phép thời gian xử lý các bộ dữ liệu lớn hơn nhanh hơn, cùng với việc sử dụng được tối ưu hóa trên máy tính. Điều này có thể giúp những người thực hành ML tạo ra các mẫu có thể sử dụng lại để tạo tập dữ liệu, đồng thời cũng giúp giảm tải và chi phí cho cơ sở hạ tầng máy tính.

Tổng quan về giải pháp

Trong thời hạn Amazon SageMaker, nhiều khách hàng sử dụng Xử lý SageMaker để giúp thực hiện xử lý dữ liệu song song. Với SageMaker Processing, bạn có thể sử dụng trải nghiệm được quản lý, đơn giản hóa trên SageMaker để chạy khối lượng công việc xử lý dữ liệu của mình, chẳng hạn như kỹ thuật tính năng, xác thực dữ liệu, đánh giá mô hình và diễn giải mô hình. Điều này mang lại nhiều lợi ích vì không có cơ sở hạ tầng lâu dài để quản lý — các phiên bản xử lý giảm xuống khi công việc hoàn tất, môi trường có thể được chuẩn hóa thông qua vùng chứa, dữ liệu bên trong Dịch vụ lưu trữ đơn giản của Amazon (Amazon S3) được phân phối nguyên bản trên các phiên bản và cài đặt cơ sở hạ tầng linh hoạt về bộ nhớ, máy tính và lưu trữ.

Xử lý SageMaker cung cấp các tùy chọn về cách phân phối dữ liệu. Để xử lý dữ liệu song song, bạn phải sử dụng Tùy chọn ShardedByS3Key cho S3DataDistributionType. Khi tham số này được chọn, Xử lý SageMaker sẽ lấy n các thể hiện và phân phối các đối tượng 1 /n các đối tượng từ nguồn dữ liệu đầu vào trên các phiên bản. Ví dụ: nếu hai cá thể được cung cấp bốn đối tượng dữ liệu, thì mỗi cá thể nhận được hai đối tượng.

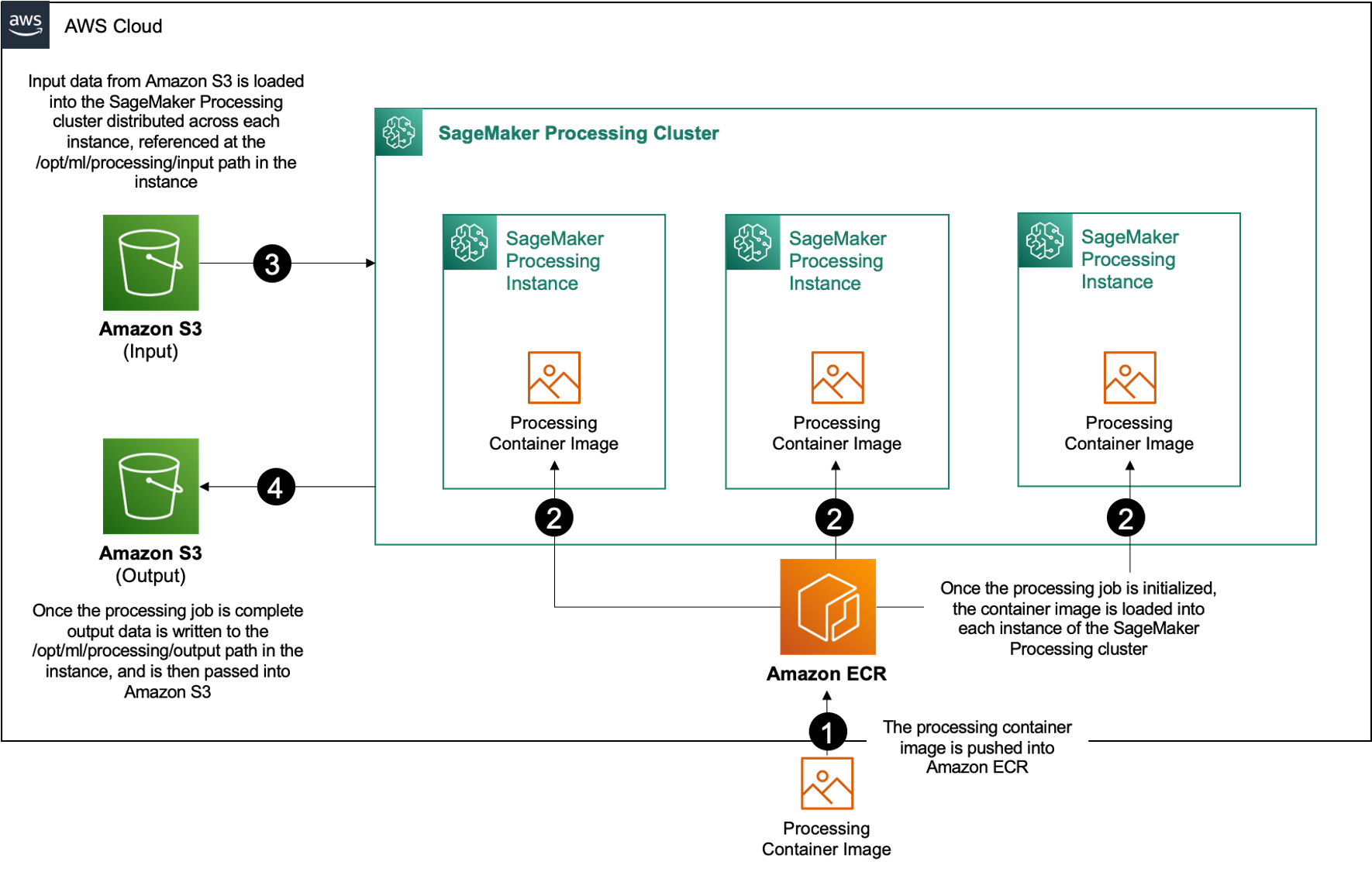

Xử lý SageMaker yêu cầu ba thành phần để chạy các công việc xử lý:

- Hình ảnh vùng chứa có mã và các phần phụ thuộc của bạn để chạy khối lượng công việc xử lý dữ liệu của bạn

- Đường dẫn đến nguồn dữ liệu đầu vào trong Amazon S3

- Đường dẫn đến nguồn dữ liệu đầu ra trong Amazon S3

Quá trình này được mô tả trong sơ đồ sau.

Trong bài đăng này, chúng tôi hướng dẫn bạn cách sử dụng RStudio trên SageMaker để giao tiếp với một loạt các công việc Xử lý SageMaker để tạo một đường ống xử lý dữ liệu song song bằng cách sử dụng Ngôn ngữ lập trình R.

Giải pháp bao gồm các bước sau:

- Thiết lập dự án RStudio.

- Xây dựng và đăng ký hình ảnh vùng chứa xử lý.

- Chạy quy trình xử lý hai bước:

- Bước đầu tiên lấy nhiều tệp dữ liệu và xử lý chúng qua một loạt các công việc xử lý.

- Bước thứ hai nối các tệp đầu ra và chia chúng thành các tập dữ liệu huấn luyện, kiểm tra và xác nhận.

Điều kiện tiên quyết

Hoàn thành các điều kiện tiên quyết sau:

- Thiết lập RStudio trên SageMaker Workbench. Để biết thêm thông tin, hãy tham khảo Thông báo RStudio được quản lý hoàn toàn trên Amazon SageMaker cho các nhà khoa học dữ liệu.

- Tạo người dùng bằng RStudio trên SageMaker với các quyền truy cập thích hợp.

Thiết lập dự án RStudio

Để thiết lập dự án RStudio, hãy hoàn thành các bước sau:

- Điều hướng đến Xưởng sản xuất Amazon SageMaker bảng điều khiển trên bảng điều khiển SageMaker.

- Khởi chạy ứng dụng của bạn trong môi trường RStudio.

- Bắt đầu một phiên RStudio mới.

- Trong Tên phiên, nhập tên.

- Trong Loại sơ thẩm và Hình ảnh, sử dụng cài đặt mặc định.

- Chọn Bắt đầu phiên.

- Điều hướng vào phiên.

- Chọn Dự án mới, Kiểm soát phiên bản, và sau đó Chọn Git.

- Trong URL kho lưu trữ, đi vào

https://github.com/aws-samples/aws-parallel-data-processing-r.git - Để các tùy chọn còn lại làm mặc định và chọn Tạo dự án.

Bạn có thể điều hướng đến aws-parallel-data-processing-R thư mục trên Các tập tin tab để xem kho lưu trữ. Kho chứa các tệp sau:

Container_Build.rmd/datasetbank-additional-full-data1.csvbank-additional-full-data2.csvbank-additional-full-data3.csvbank-additional-full-data4.csv

/dockerDockerfile-ProcessingParallel_Data_Processing.rmd/preprocessingfilter.Rprocess.R

Xây dựng thùng chứa

Trong bước này, chúng tôi xây dựng hình ảnh vùng chứa xử lý của mình và đẩy nó lên Đăng ký container đàn hồi Amazon (Amazon ECR). Hoàn thành các bước sau:

- Điều hướng đến

Container_Build.rmdtập tin. - cài đặt Xây dựng hình ảnh SageMaker Studio CLI bằng cách chạy ô sau. Đảm bảo bạn có các quyền cần thiết trước khi hoàn thành bước này, đây là CLI được thiết kế để đẩy và đăng ký các hình ảnh vùng chứa trong Studio.

- Chạy ô tiếp theo để xây dựng và đăng ký vùng chứa xử lý của chúng tôi:

Sau khi công việc chạy thành công, bạn nhận được kết quả đầu ra giống như sau:

Chạy quy trình xử lý

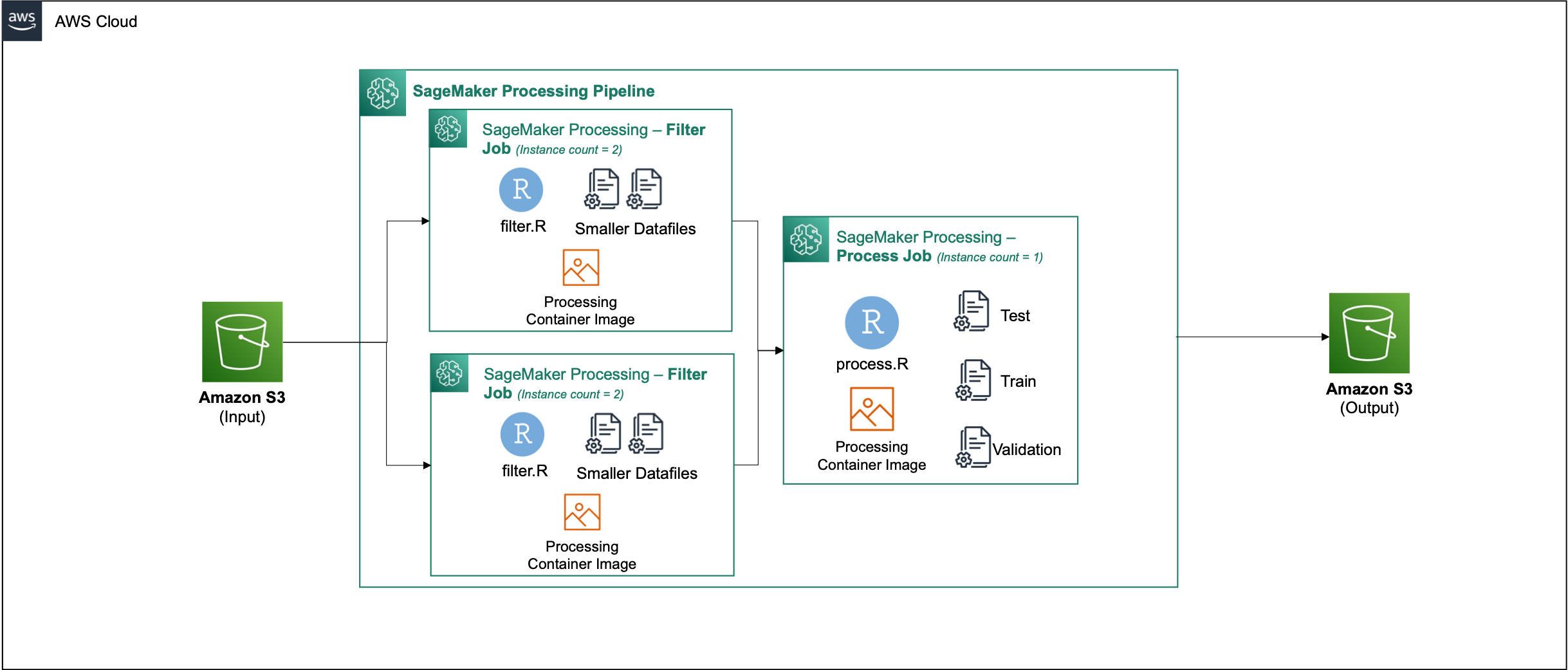

Sau khi bạn xây dựng vùng chứa, hãy điều hướng đến Parallel_Data_Processing.rmd tập tin. Tệp này chứa một loạt các bước giúp chúng tôi tạo đường dẫn xử lý dữ liệu song song bằng cách sử dụng SageMaker Processing. Sơ đồ sau đây mô tả các bước của đường ống mà chúng tôi hoàn thành.

Bắt đầu bằng cách chạy bước nhập gói. Nhập các gói RStudio được yêu cầu cùng với SageMaker SDK:

Bây giờ, hãy thiết lập các chi tiết về môi trường và vai trò thực thi SageMaker của bạn:

Khởi tạo vùng chứa mà chúng ta đã tạo và đăng ký ở bước trước đó:

Từ đây, chúng tôi đi sâu vào từng bước xử lý chi tiết hơn.

Tải lên tập dữ liệu

Đối với ví dụ của chúng tôi, chúng tôi sử dụng Bộ dữ liệu Tiếp thị Ngân hàng từ UCI. Chúng tôi đã chia tập dữ liệu thành nhiều tệp nhỏ hơn. Chạy mã sau để tải tệp lên Amazon S3:

Sau khi các tệp được tải lên, hãy chuyển sang bước tiếp theo.

Thực hiện xử lý dữ liệu song song

Trong bước này, chúng tôi lấy các tệp dữ liệu và thực hiện kỹ thuật tính năng để lọc ra các cột nhất định. Công việc này được phân phối trên một loạt các trường hợp xử lý (ví dụ của chúng tôi, chúng tôi sử dụng hai).

Chúng tôi sử dụng filter.R để xử lý dữ liệu và định cấu hình công việc như sau:

Như đã đề cập trước đó, khi chạy công việc xử lý dữ liệu song song, bạn phải điều chỉnh tham số đầu vào với cách dữ liệu sẽ được phân mảnh và kiểu dữ liệu. Do đó, chúng tôi cung cấp phương pháp sharding bằng cách S3Prefix:

Sau khi bạn chèn các thông số này, SageMaker Processing sẽ phân phối dữ liệu một cách đồng đều trên số lượng phiên bản đã chọn.

Điều chỉnh các tham số nếu cần, sau đó chạy ô để bắt đầu công việc.

Tạo tập dữ liệu đào tạo, kiểm tra và xác thực

Trong bước này, chúng tôi lấy các tệp dữ liệu đã xử lý, kết hợp chúng và chia chúng thành các bộ dữ liệu kiểm tra, huấn luyện và xác thực. Điều này cho phép chúng tôi sử dụng dữ liệu để xây dựng mô hình của mình.

Chúng tôi sử dụng process.R để xử lý dữ liệu và định cấu hình công việc như sau:

Điều chỉnh các tham số là cần thiết, sau đó chạy ô để bắt đầu công việc.

Chạy đường ống

Sau khi tất cả các bước được khởi tạo, hãy bắt đầu quy trình xử lý để chạy từng bước bằng cách chạy ô sau:

Thời gian của mỗi công việc này sẽ khác nhau dựa trên kích thước phiên bản và số lượng đã chọn.

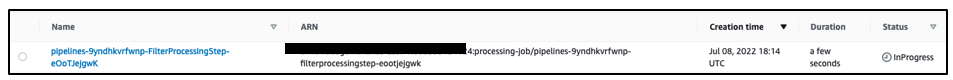

Điều hướng đến bảng điều khiển SageMaker để xem tất cả các công việc xử lý của bạn.

Chúng tôi bắt đầu với công việc lọc, như được hiển thị trong ảnh chụp màn hình sau.

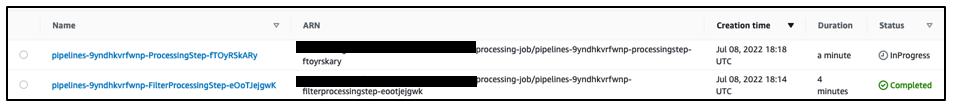

Khi hoàn tất, đường ống chuyển sang công việc xử lý dữ liệu.

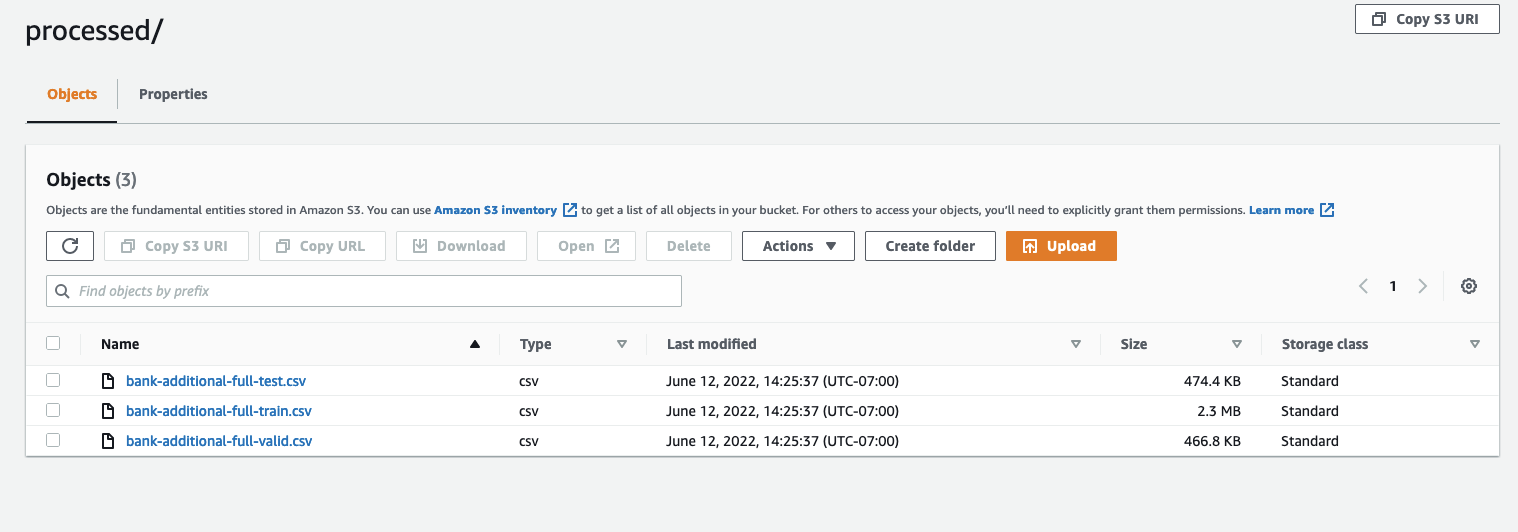

Khi cả hai công việc hoàn tất, hãy điều hướng đến nhóm S3 của bạn. Nhìn trong sagemaker-rstudio-example thư mục, dưới processed. Bạn có thể xem các tệp cho tập dữ liệu đào tạo, kiểm tra và xác nhận.

Kết luận

Với lượng dữ liệu ngày càng tăng sẽ được yêu cầu để xây dựng các mô hình ngày càng phức tạp hơn, chúng tôi cần thay đổi cách tiếp cận đối với cách chúng tôi xử lý dữ liệu. Xử lý dữ liệu song song là một phương pháp hiệu quả trong việc đẩy nhanh quá trình tạo tập dữ liệu và nếu được kết hợp với các công cụ và môi trường đám mây hiện đại như RStudio trên SageMaker và SageMaker Processing, có thể loại bỏ phần lớn công việc quản lý cơ sở hạ tầng, tạo mã soạn sẵn và quản lý môi trường. Trong bài đăng này, chúng tôi đã giới thiệu cho các bạn cách thực hiện xử lý dữ liệu song song trong RStudio trên SageMaker. Chúng tôi khuyến khích bạn dùng thử bằng cách sao chép kho lưu trữ GitHub và nếu bạn có đề xuất về cách làm cho trải nghiệm tốt hơn, vui lòng gửi sự cố hoặc yêu cầu kéo.

Để tìm hiểu thêm về các tính năng và dịch vụ được sử dụng trong giải pháp này, hãy tham khảo RStudio trên Amazon SageMaker và Chế biến Amazon SageMaker.

Giới thiệu về tác giả

Raj Pathak là một Kiến trúc sư Giải pháp và Cố vấn Kỹ thuật cho các khách hàng thuộc nhóm 50 và trung bình của FSI (Ngân hàng, Bảo hiểm, Thị trường Vốn) trên khắp Canada và Hoa Kỳ. Raj chuyên về Học máy với các ứng dụng trong Trích xuất tài liệu, Chuyển đổi Trung tâm Liên hệ và Thị giác Máy tính.

Raj Pathak là một Kiến trúc sư Giải pháp và Cố vấn Kỹ thuật cho các khách hàng thuộc nhóm 50 và trung bình của FSI (Ngân hàng, Bảo hiểm, Thị trường Vốn) trên khắp Canada và Hoa Kỳ. Raj chuyên về Học máy với các ứng dụng trong Trích xuất tài liệu, Chuyển đổi Trung tâm Liên hệ và Thị giác Máy tính.

Jake Wen là Kiến trúc sư Giải pháp tại AWS với niềm đam mê đào tạo ML và Xử lý ngôn ngữ tự nhiên. Jake giúp khách hàng Doanh nghiệp vừa và nhỏ có khả năng lãnh đạo về thiết kế và tư duy để xây dựng và triển khai các ứng dụng trên quy mô lớn. Ngoài công việc, anh ấy thích đi bộ đường dài.

Jake Wen là Kiến trúc sư Giải pháp tại AWS với niềm đam mê đào tạo ML và Xử lý ngôn ngữ tự nhiên. Jake giúp khách hàng Doanh nghiệp vừa và nhỏ có khả năng lãnh đạo về thiết kế và tư duy để xây dựng và triển khai các ứng dụng trên quy mô lớn. Ngoài công việc, anh ấy thích đi bộ đường dài.

Aditi Rajnish là sinh viên kỹ thuật phần mềm năm thứ nhất tại Đại học Waterloo. Sở thích của cô bao gồm thị giác máy tính, xử lý ngôn ngữ tự nhiên và tính toán biên. Cô ấy cũng rất đam mê với hoạt động tiếp cận và vận động STEM dựa vào cộng đồng. Khi rảnh rỗi, cô ấy có thể leo núi, chơi piano hoặc học cách nướng bánh nướng hoàn hảo.

Aditi Rajnish là sinh viên kỹ thuật phần mềm năm thứ nhất tại Đại học Waterloo. Sở thích của cô bao gồm thị giác máy tính, xử lý ngôn ngữ tự nhiên và tính toán biên. Cô ấy cũng rất đam mê với hoạt động tiếp cận và vận động STEM dựa vào cộng đồng. Khi rảnh rỗi, cô ấy có thể leo núi, chơi piano hoặc học cách nướng bánh nướng hoàn hảo.

Sean Morgan là Kiến trúc sư Giải pháp AI / ML tại AWS. Anh ấy có kinh nghiệm trong lĩnh vực nghiên cứu học thuật và bán dẫn, đồng thời sử dụng kinh nghiệm của mình để giúp khách hàng đạt được mục tiêu của họ trên AWS. Trong thời gian rảnh rỗi, Sean là một người đóng góp và bảo trì mã nguồn mở tích cực, đồng thời là trưởng nhóm sở thích đặc biệt cho Tiện ích bổ sung TensorFlow.

Sean Morgan là Kiến trúc sư Giải pháp AI / ML tại AWS. Anh ấy có kinh nghiệm trong lĩnh vực nghiên cứu học thuật và bán dẫn, đồng thời sử dụng kinh nghiệm của mình để giúp khách hàng đạt được mục tiêu của họ trên AWS. Trong thời gian rảnh rỗi, Sean là một người đóng góp và bảo trì mã nguồn mở tích cực, đồng thời là trưởng nhóm sở thích đặc biệt cho Tiện ích bổ sung TensorFlow.

Paul Wu là Kiến trúc sư Giải pháp làm việc trong Kinh doanh Greenfield của AWS ở Texas. Các lĩnh vực chuyên môn của anh ấy bao gồm container và di chuyển.

Paul Wu là Kiến trúc sư Giải pháp làm việc trong Kinh doanh Greenfield của AWS ở Texas. Các lĩnh vực chuyên môn của anh ấy bao gồm container và di chuyển.

- AI

- nghệ thuật ai

- máy phát điện nghệ thuật ai

- ai rô bốt

- Amazon SageMaker

- trí tuệ nhân tạo

- chứng nhận trí tuệ nhân tạo

- trí tuệ nhân tạo trong ngân hàng

- robot trí tuệ nhân tạo

- robot trí tuệ nhân tạo

- phần mềm trí tuệ nhân tạo

- Học máy AWS

- blockchain

- hội nghị blockchain ai

- thiên tài

- trí tuệ nhân tạo đàm thoại

- hội nghị tiền điện tử ai

- dall's

- học kĩ càng

- google ai

- học máy

- plato

- Plato ai

- Thông tin dữ liệu Plato

- Trò chơi Plato

- PlatoDữ liệu

- Platogaming

- quy mô ai

- cú pháp

- zephyrnet