放射学报告是描述和解释放射成像检查结果的全面、冗长的文件。 在典型的工作流程中,放射科医生监督、读取和解释图像,然后简明地总结主要发现。 总结(或 印象)是报告中最重要的部分,因为它可以帮助临床医生和患者关注报告中包含临床决策信息的关键内容。 创造清晰而有影响力的印象比简单地重申调查结果需要付出更多的努力。 因此,整个过程既费力、耗时,又容易出错。 往往需要数年的时间 训练 让医生积累足够的专业知识来撰写简洁且信息丰富的放射学报告摘要,进一步凸显自动化过程的重要性。 此外,自动生成报告结果摘要 对于放射学报告至关重要。 它能够将报告翻译成人类可读的语言,从而减轻患者阅读冗长而晦涩的报告的负担。

为了解决这个问题,我们建议使用生成式人工智能,这是一种可以创造新内容和想法的人工智能,包括对话、故事、图像、视频和音乐。 生成式人工智能由机器学习 (ML) 模型提供支持,这是一种基于大量数据进行预训练的非常大的模型,通常称为基础模型 (FM)。 机器学习的最新进展(特别是基于变压器的神经网络架构的发明)导致了包含数十亿参数或变量的模型的兴起。 本文中提出的解决方案使用预训练的大型语言模型 (LLM) 进行微调,以帮助根据放射学报告中的发现生成摘要。

本文演示了一种使用 AWS 服务对公开可用的 LLM 进行放射学报告汇总任务进行微调的策略。 法学硕士在自然语言理解和生成方面表现出了卓越的能力,可以作为适应各种领域和任务的基础模型。 使用预训练模型有显着的好处。 它降低了计算成本,减少了碳足迹,并允许您使用最先进的模型,而无需从头开始训练。

我们的解决方案使用 法兰-T5 XL 调频,使用 亚马逊SageMaker JumpStart,这是一个提供算法、模型和 ML 解决方案的 ML 中心。 我们演示了如何使用笔记本来实现这一点 亚马逊SageMaker Studio。 微调预训练模型涉及对特定数据进行进一步训练,以提高不同但相关任务的性能。 该解决方案涉及对 FLAN-T5 XL 模型进行微调,该模型是 FLAN-TXNUMX XL 模型的增强版本 T5 (文本到文本传输转换器)通用法学硕士。 T5 将自然语言处理 (NLP) 任务重新构建为统一的文本到文本格式,这与 BERT-style 模型只能输出类标签或输入范围。 它针对从 91,544 份自由文本放射学报告中获得的摘要任务进行了微调 MIMIC-CXR 数据集.

解决方案概述

在本节中,我们将讨论解决方案的关键组成部分:选择任务策略、微调 LLM 以及评估结果。 我们还说明了解决方案架构以及实施该解决方案的步骤。

确定任务的策略

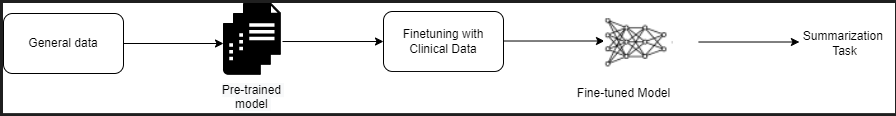

有多种策略可以完成自动化临床报告总结的任务。 例如,我们可以使用从头开始针对临床报告进行预训练的专门语言模型。 或者,我们可以直接微调公开可用的通用语言模型来执行临床任务。 在训练 a 的环境中,可能需要使用经过微调的领域不可知模型 从头开始的语言模型 成本太高了。 在此解决方案中,我们演示了使用 FLAN -T5 XL 模型的后一种方法,我们针对放射学报告总结的临床任务进行了微调。 下图说明了模型工作流程。

典型的放射学报告组织良好且简洁。 此类报告通常包含三个关键部分:

- 背景 – 提供有关患者人口统计的一般信息,以及有关患者、临床病史和相关病史的基本信息以及检查程序的详细信息

- 发现 – 提供详细的检查诊断和结果

- 印花 – 简要总结最显着的发现或对结果的解释,并根据观察到的异常情况评估重要性和潜在诊断

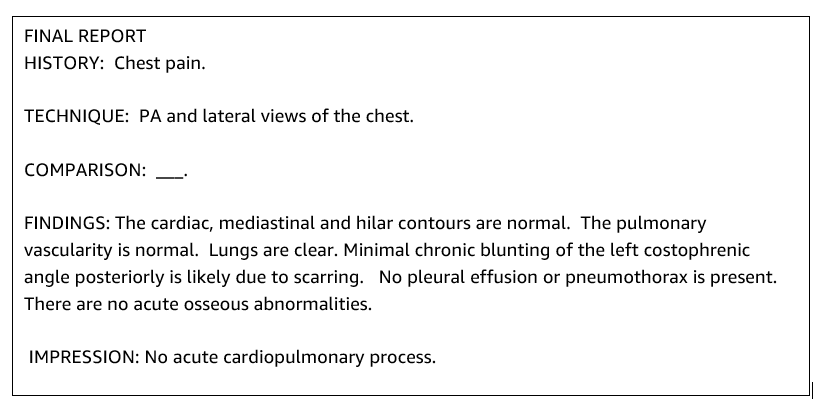

该解决方案利用放射学报告中的结果部分生成印象部分,该部分与医生的总结相对应。 下图是放射学报告的示例。

针对临床任务微调通用法学硕士

在此解决方案中,我们对 FLAN-T5 XL 模型进行微调(调整模型的所有参数并针对任务进行优化)。 我们使用临床领域数据集微调模型 模拟CXR,这是一个公开的胸部 X 光照片数据集。 要通过 SageMaker Jumpstart 微调此模型,必须以 {提示,完成} 对的形式提供带标签的示例。 在本例中,我们使用 MIMIC-CXR 数据集中原始报告中的成对的 {Findings, Impression}。 为了进行推理,我们使用提示,如下例所示:

![]()

该模型在加速计算上进行了微调 毫升.p3.16xlarge 具有 64 个虚拟 CPU 和 488 GiB 内存的实例。 为了进行验证,随机选择了 5% 的数据集。 经过微调的 SageMaker 训练作业所用时间为 38,468 秒(约 11 小时)。

评估结果

培训完成后,评估结果至关重要。 为了对生成的印象进行定量分析,我们使用 RED (面向回忆的基础评估),评估摘要最常用的指标。 该指标将自动生成的摘要与参考或一组参考(人工生成的)摘要或翻译进行比较。 ROUGE1 指的是重叠 一元词组 (每个单词)候选(模型的输出)和参考摘要之间。 ROUGE2 指的是重叠 二元组 (两个词)候选摘要和参考摘要之间。 ROUGEL 是一个句子级度量,指的是两段文本之间的最长公共子序列 (LCS)。 它忽略文本中的换行符。 ROUGELsum 是一个汇总级指标。 对于此指标,文本中的换行符不会被忽略,而是被解释为句子边界。 然后计算每对参考句子和候选句子之间的 LCS,然后计算并集 LCS。 为了在给定的一组参考句子和候选句子上聚合这些分数,计算平均值。

演练和架构

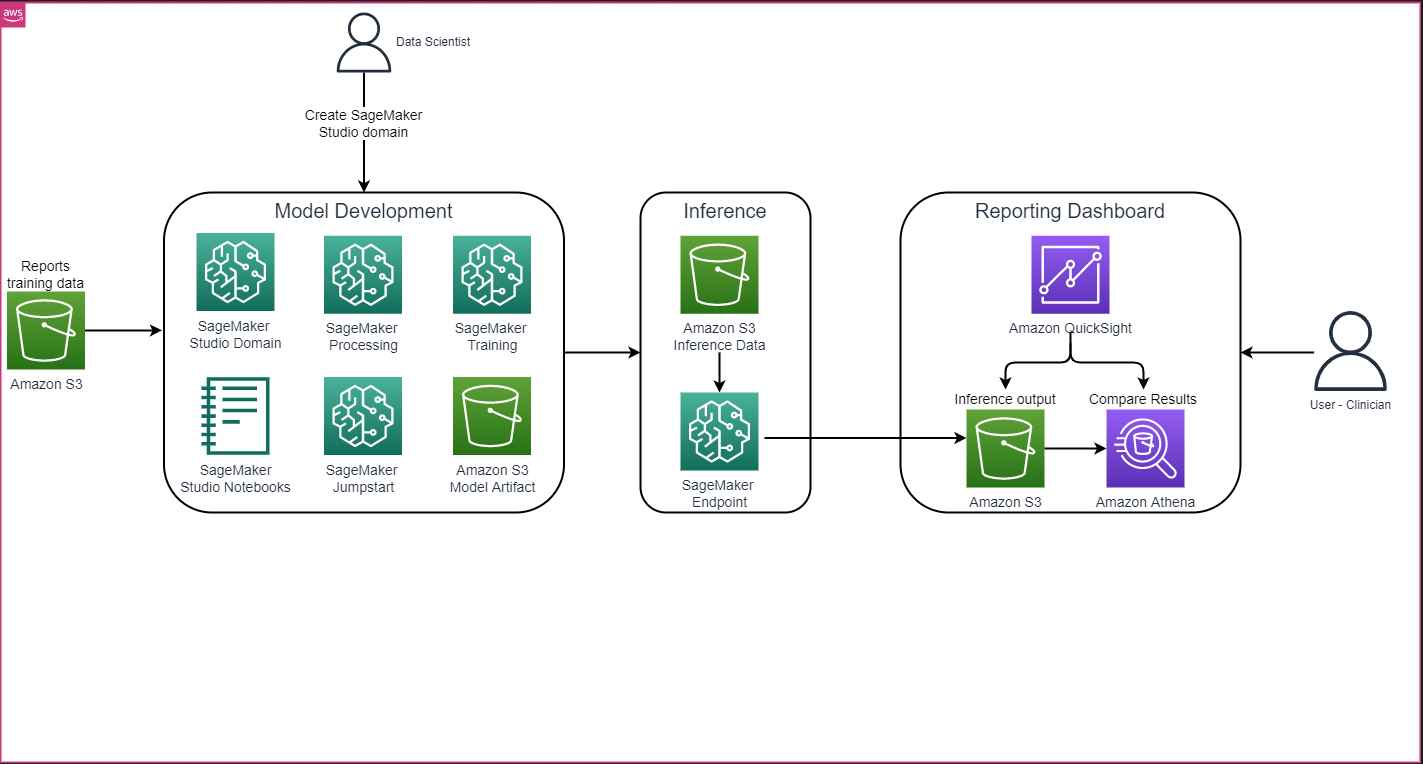

如下图所示的整体解决方案架构主要由使用 SageMaker Studio 的模型开发环境、使用 SageMaker 端点的模型部署以及使用 SageMaker Studio 的报告仪表板组成 亚马逊QuickSight.

在以下部分中,我们将演示如何微调 SageMaker JumpStart 上提供的 LLM,以通过 SageMaker Python SDK 总结特定于域的任务。 我们特别讨论以下主题:

- 搭建开发环境的步骤

- 模型微调和评估的放射学报告数据集概述

- 演示如何使用 SageMaker JumpStart 和 SageMaker Python SDK 以编程方式微调 FLAN-T5 XL 模型

- 预训练和微调模型的推理和评估

- 预训练模型和微调模型的结果比较

该解决方案可在 在 AWS 上使用具有大型语言模型的生成式 AI 生成放射学报告印象 GitHub回购.

先决条件

首先,您需要一个 AWS账户 您可以在其中使用 SageMaker Studio。 如果您还没有 SageMaker Studio 用户配置文件,则需要创建一份用户配置文件。

本文中使用的训练实例类型是 ml.p3.16xlarge。 请注意,p3 实例类型 需要增加服务配额限制。

MIMIC CXR 数据集 可以通过数据使用协议进行访问,该协议需要用户注册并完成认证过程。

设置开发环境

要设置开发环境,您需要创建 S3 存储桶、配置笔记本、创建端点并部署模型,以及创建 QuickSight 仪表板。

创建一个S3存储桶

创建一个S3存储桶 被称为 llm-radiology-bucket 托管训练和评估数据集。 这也将用于在模型开发期间存储模型工件。

配置笔记本

完成以下步骤:

- 从 SageMaker 控制台或 AWS命令行界面 (AWS CLI)。

有关加入域的更多信息,请参阅 加入 Amazon SageMaker 域.

- 创建一个新的 SageMaker Studio 笔记本 用于清理报告数据和微调模型。 我们使用带有 Python 3 内核的 ml.t2.medium 4vCPU+3GiB 笔记本实例。

- 在笔记本中,安装相关软件包,例如

nest-asyncio,IPyWidgets(适用于 Jupyter Notebook 的交互式小部件)和 SageMaker Python SDK:

为了推断预训练和微调的模型, 创建端点并部署每个模型 在笔记本中如下:

- 从 Model 类创建一个可以部署到 HTTPS 端点的模型对象。

- 使用模型对象的预构建创建 HTTPS 端点

deploy()方法:

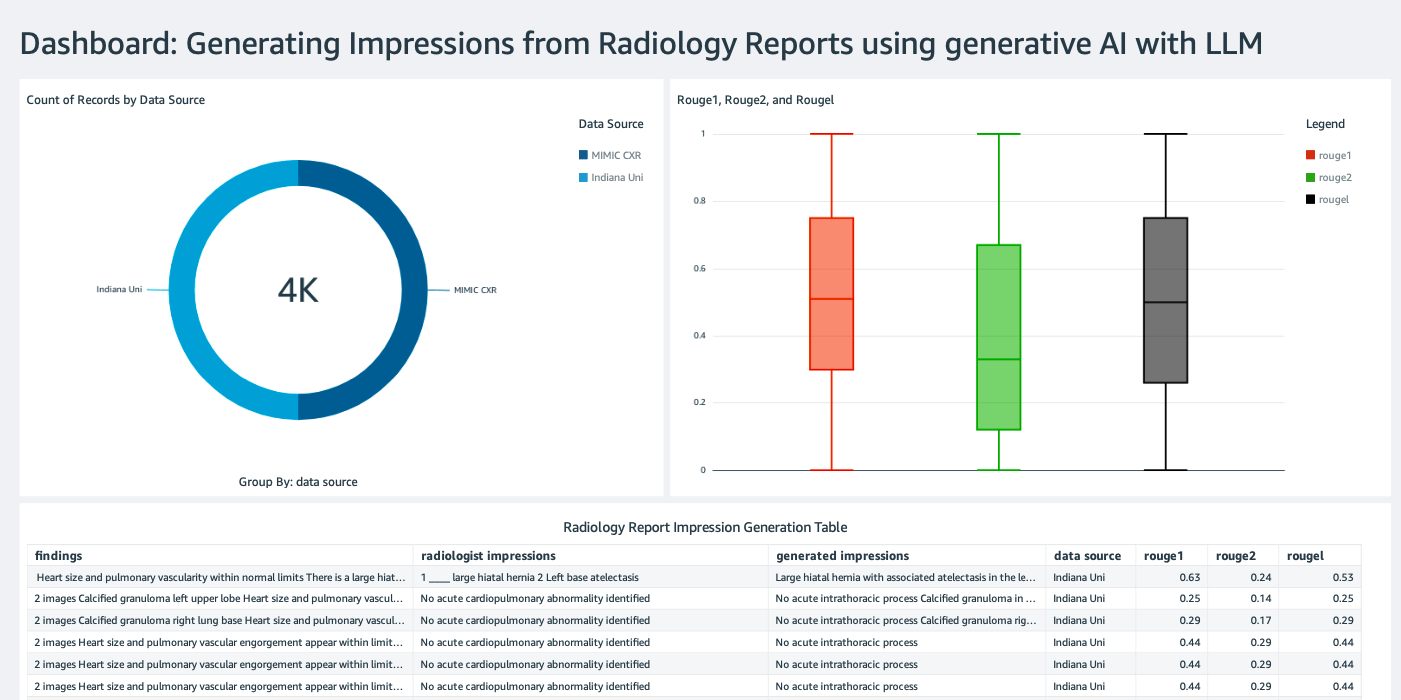

创建 QuickSight 仪表板

创建一个 具有 Athena 数据源的 QuickSight 仪表板 推论结果为 亚马逊简单存储服务 (Amazon S3)将推理结果与真实情况进行比较。 以下屏幕截图显示了我们的示例仪表板。

放射学报告数据集

该模型现已进行微调,所有模型参数均根据从下载的 91,544 份报告进行调整 MIMIC-CXR v2.0 数据集。 由于我们仅使用放射学报告文本数据,因此我们仅下载了一份压缩报告文件(mimic-cxr-reports.zip)来自 MIMIC-CXR 网站。 现在我们在 2,000 份报告(称为 dev1 数据集)来自单独的 保留了该数据集的子集。 我们使用另外 2,000 份放射学报告(称为 dev2)用于评估来自胸部 X 射线收集的微调模型 印第安纳大学医院网络。 所有数据集都以 JSON 文件形式读取并上传到新创建的 S3 存储桶 llm-radiology-bucket。 请注意,默认情况下所有数据集都不包含任何受保护的健康信息 (PHI); 所有敏感信息均替换为三个连续下划线(___)由提供商提供。

使用 SageMaker Python SDK 进行微调

为了进行微调, model_id 被指定为 huggingface-text2text-flan-t5-xl 来自 SageMaker JumpStart 模型列表。 这 training_instance_type 设置为 ml.p3.16xlarge 并且 inference_instance_type 如ml.g5.2xlarge。 JSON格式的训练数据是从S3存储桶中读取的。 下一步是使用选定的 model_id 提取 SageMaker JumpStart 资源 URI,包括 image_uri ( Amazon Elastic Container注册 (Amazon ECR)Docker 映像的 URI), model_uri (预训练模型工件 Amazon S3 URI),以及 script_uri (训练脚本):

此外,输出位置设置为 S3 存储桶内的文件夹。

只有3个超参数epochs改为XNUMX,其余均为默认:

训练指标如 eval_loss (用于验证损失), loss (对于训练损失),以及 epoch 定义并列出要跟踪的内容:

我们使用 SageMaker JumpStart 资源 URI (image_uri, model_uri, script_uri)之前确定了创建估计器并通过指定数据集的 S3 路径在训练数据集上对其进行微调。 Estimator 类需要一个 entry_point 范围。 在这种情况下,JumpStart 使用 transfer_learning.py。 如果未设置该值,训练作业将无法运行。

这项培训工作可能需要几个小时才能完成; 因此,建议将等待参数设置为 False 并在 SageMaker 控制台上监控训练作业状态。 使用 TrainingJobAnalytics 函数来跟踪不同时间戳的训练指标:

部署推理端点

为了进行比较,我们为预训练模型和微调模型部署了推理端点。

首先,使用以下命令检索推理 Docker 映像 URI model_id,并使用此 URI 创建预训练模型的 SageMaker 模型实例。 通过使用模型对象的预构建创建 HTTPS 端点来部署预训练模型 deploy() 方法。 为了通过 SageMaker API 运行推理,请确保传递 Predictor 类。

重复上述步骤以创建微调模型的 SageMaker 模型实例并创建端点以部署模型。

评估模型

首先,设置摘要文本的长度、模型输出的数量(如果需要生成多个摘要,则应大于1)以及光束的数量 束搜索。

将推理请求构建为 JSON 负载,并使用它来查询预训练和微调模型的端点。

计算聚合的 胭脂分数 (ROUGE1、ROUGE2、ROUGEL、ROUGELsum)如前所述。

比较结果

下表描述了评估结果 dev1 和 dev2 数据集。 评估结果于 dev1 (MIMIC CXR 放射学报告中的 2,000 个结果)显示总体平均值提高了约 38 个百分点 胭脂1和胭脂2 与预训练模型相比的分数。 对于 dev2,ROUGE31 和 ROUGE25 分数分别提高了 1 个百分点和 2 个百分点。 总体而言,微调使 ROUGELsum 分数提高了 38.2 个百分点和 31.3 个百分点 dev1 和 dev2 数据集,分别。

|

评价 数据集 |

预训练模型 | 微调模型 | ||||||

| 胭脂1 | 胭脂2 | 鲁格尔 | 鲁格尔苏姆 | 胭脂1 | 胭脂2 | 鲁格尔 | 鲁格尔苏姆 | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

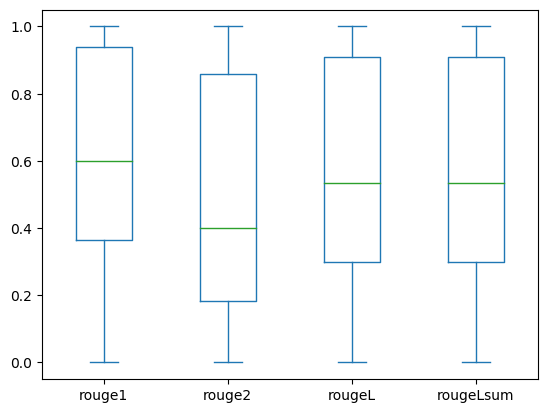

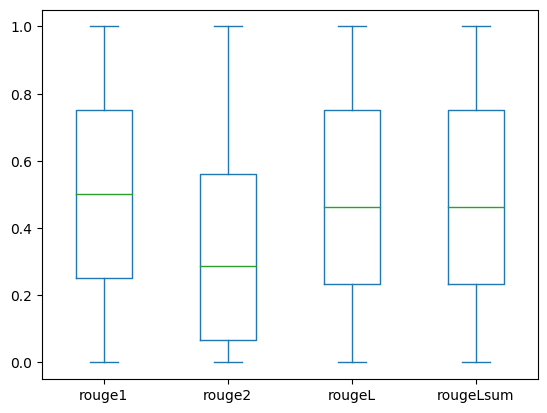

以下箱线图描述了 ROUGE 分数的分布 dev1 和 dev2 使用微调模型评估的数据集。

|

|

(一个): dev1 |

(b): dev2 |

下表显示评估数据集的 ROUGE 分数具有大致相同的中位数和平均值,因此呈对称分布。

| 数据集 | 樂譜 | 计数 | 平均值 | 标准差 | 最低限度 | 25% 百分位 | 50% 百分位 | 75% 百分位 | 最大 |

dev1 |

胭脂1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| 胭脂 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| 胭脂L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| 鲁格尔苏姆 | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

胭脂 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| 胭脂 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| 胭脂L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| 胭脂Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

清理

为避免将来产生费用,请删除您使用以下代码创建的资源:

结论

在这篇文章中,我们演示了如何使用 SageMaker Studio 微调 FLAN-T5 XL 模型以执行临床领域特定的总结任务。 为了增加置信度,我们将预测与真实情况进行比较,并使用 ROUGE 指标评估结果。 我们证明,针对特定任务进行微调的模型比针对通用 NLP 任务预训练的模型返回更好的结果。 我们想指出的是,对通用法学硕士进行微调可以完全消除预培训的成本。

尽管这里介绍的工作重点是胸部 X 射线报告,但它有可能扩展到具有不同解剖结构和模式的更大数据集,例如 MRI 和 CT,其中放射学报告可能更复杂,有多种发现。 在这种情况下,放射科医生可以按照重要性顺序生成印象,并包括后续建议。 此外,为此应用程序设置反馈循环将使放射科医生能够随着时间的推移提高模型的性能。

正如我们在这篇文章中所示,微调模型会生成具有高 ROUGE 分数的放射学报告的印象。 您可以尝试根据不同部门的其他特定领域的医疗报告对法学硕士进行微调。

关于作者

阿德瓦勒·阿金法德林博士 是 AWS 医疗保健和生命科学领域的高级数据科学家。 他的专业知识是可重复的端到端 AI/ML 方法、实际实施,以及帮助全球医疗保健客户针对跨学科问题制定和开发可扩展的解决方案。 他拥有两个物理学研究生学位和一个工程博士学位。

阿德瓦勒·阿金法德林博士 是 AWS 医疗保健和生命科学领域的高级数据科学家。 他的专业知识是可重复的端到端 AI/ML 方法、实际实施,以及帮助全球医疗保健客户针对跨学科问题制定和开发可扩展的解决方案。 他拥有两个物理学研究生学位和一个工程博士学位。

普里亚·帕达特 是 AWS 的高级合作伙伴解决方案架构师,在医疗保健和生命科学领域拥有丰富的专业知识。 Priya 与合作伙伴共同推动上市战略,并推动解决方案开发,以加速基于 AI/ML 的开发。 她热衷于利用技术来改变医疗保健行业,以推动更好的患者护理结果。

普里亚·帕达特 是 AWS 的高级合作伙伴解决方案架构师,在医疗保健和生命科学领域拥有丰富的专业知识。 Priya 与合作伙伴共同推动上市战略,并推动解决方案开发,以加速基于 AI/ML 的开发。 她热衷于利用技术来改变医疗保健行业,以推动更好的患者护理结果。

埃克塔·瓦利亚·布拉尔博士,是 AWS 医疗保健和生命科学 (HCLS) 专业服务业务部门的高级 AI/ML 顾问。 她在人工智能/机器学习在医疗保健领域的应用方面拥有丰富的经验,特别是在放射学领域。 工作之余,当不讨论放射学中的人工智能时,她喜欢跑步和徒步旅行。

埃克塔·瓦利亚·布拉尔博士,是 AWS 医疗保健和生命科学 (HCLS) 专业服务业务部门的高级 AI/ML 顾问。 她在人工智能/机器学习在医疗保健领域的应用方面拥有丰富的经验,特别是在放射学领域。 工作之余,当不讨论放射学中的人工智能时,她喜欢跑步和徒步旅行。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- PlatoData.Network 垂直生成人工智能。 赋予自己力量。 访问这里。

- 柏拉图爱流。 Web3 智能。 知识放大。 访问这里。

- 柏拉图ESG。 汽车/电动汽车, 碳, 清洁科技, 能源, 环境, 太阳能, 废物管理。 访问这里。

- 柏拉图健康。 生物技术和临床试验情报。 访问这里。

- 图表Prime。 使用 ChartPrime 提升您的交易游戏。 访问这里。

- 块偏移量。 现代化环境抵消所有权。 访问这里。

- Sumber: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :具有

- :是

- :不是

- :在哪里

- $UP

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- Able

- 关于

- 加快

- 加速

- 访问

- 完成

- 积累

- 另外

- 进步

- 驳

- 聚合

- 协议

- AI

- AI / ML

- 算法

- 所有类型

- 允许

- 已经

- 还

- 共

- Amazon

- 亚马逊SageMaker

- 亚马逊网络服务

- 量

- an

- 分析

- 和

- 另一个

- 任何

- API

- 应用领域

- 的途径

- 约

- 架构

- 保健

- 论点

- AS

- 评定

- At

- 自动表

- 自动

- 自动化

- 可使用

- 避免

- AWS

- 基地

- 基于

- BE

- 因为

- before

- 作为

- 好处

- 更好

- 之间

- 大

- 十亿美元

- 都

- 边界

- 盒子

- 负担

- 商业

- 但是

- by

- 被称为

- CAN

- 候选人

- 能力

- 碳

- 关心

- 案件

- 例

- 变

- 收费

- 选择

- 程

- 清洁

- 清除

- 临床资料

- 临床医生

- 码

- 采集

- 相当常见

- 常用

- 比较

- 相比

- 完成

- 完成

- 复杂

- 组件

- 全面

- 计算

- 计算

- 简洁

- 信心

- 连续

- 由

- 安慰

- 顾问

- 包含

- 容器

- 内容

- Contents

- 对比

- 对话

- 对应

- 价格

- 昂贵

- 成本

- 可以

- 情侣

- 创建信息图

- 创建

- 创造

- 危急

- 危急程度

- 习俗

- 合作伙伴

- XNUMX月XNUMX日

- data

- 数据科学家

- 数据集

- 决策

- 默认

- 定义

- 学位

- 人口统计

- 演示

- 证明

- 演示

- 部门

- 部署

- 部署

- 部署

- 描述

- 描述

- 详细

- 详情

- 开发

- 研发支持

- 不同

- 直接

- 讨论

- 讨论

- 分布

- 分配

- 码头工人

- 医生

- 文件

- 域

- 域名

- 别

- 画

- 驾驶

- 驱动器

- ,我们将参加

- 每

- 此前

- 努力

- 或

- 消除

- 其他

- enable

- 使

- 端至端

- 端点

- 工程师

- 增强

- 更多

- 整个

- 环境

- 时代

- 时代

- 错误

- 特别

- 必要

- 评估

- 评估

- 评估

- 评估

- 考试

- 例子

- 例子

- 执行

- 扩大

- 体验

- 专门知识

- 广泛

- 丰富的经验

- 提取

- 失败

- false

- 反馈

- 数字

- 文件

- 档

- 发现

- 专注焦点

- 重点

- 以下

- 如下

- 针对

- 申请

- 格式

- 基金会

- 止

- 功能

- 进一步

- 此外

- 未来

- 其他咨询

- 一般用途

- 生成

- 产生

- 产生

- 代

- 生成的

- 生成式人工智能

- 得到

- 特定

- 全球

- 去市场

- 毕业

- 更大的

- 陆运

- 有

- 有

- he

- 健康管理

- 健康资讯

- 医疗保健

- 医疗保健行业

- 帮助

- 帮助

- 帮助

- 相关信息

- 高

- 突出

- 远足

- 他的

- 历史

- 主持人

- HOURS

- 创新中心

- How To

- HTML

- HTTP

- HTTPS

- 中心

- 拥抱脸

- 人

- ID

- 思路

- 确定

- if

- 说明

- 图片

- 图片

- 同步成像

- 有影响力的

- 实施

- 实现

- 进口

- 重要

- 改善

- 改进

- in

- 包括

- 包含

- 增加

- 行业中的应用:

- 信息

- 信息

- 输入

- 安装

- 例

- 互动

- 解释

- 成

- 发明

- IT

- 工作

- 工作机会

- JSON

- 只是

- 只有一个

- 保持

- 键

- 标签

- 语言

- 大

- 发射

- 学习

- 导致

- 长度

- 生活

- 生命科学

- 喜欢

- 喜欢

- 极限

- Line

- 清单

- 已发布

- LLM

- 位于

- 圖書分館的位置

- 离

- 机

- 机器学习

- 使

- 可能..

- 意味着

- 医生

- 中等

- 内存

- 方法

- 方法

- 公

- 指标

- 可能

- 分钟

- ML

- 模型

- 模型

- 显示器

- 更多

- 最先进的

- MRI

- 许多

- 多

- 音乐

- 必须

- 姓名

- 自然

- 自然语言处理

- 必要

- 需求

- 网络

- 神经网络

- 全新

- 新

- 下页

- NLP

- 笔记本

- 现在

- 数

- 对象

- 获得

- of

- 提供

- 经常

- on

- 前期洽谈

- 一

- 仅由

- 追求项目的积极优化

- or

- 秩序

- 原版的

- 其他名称

- 我们的

- 输出

- 结果

- 产量

- 学校以外

- 超过

- 最划算

- 覆盖

- 简介

- 包

- 对

- 对

- 参数

- 参数

- 部分

- 特别

- 合伙人

- 伙伴

- 通过

- 多情

- 径

- 病人

- 患者

- 百分比

- 演出

- 性能

- 博士学位

- 物理

- 件

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 点

- 点

- 帖子

- 潜力

- 供电

- 实用

- 预测

- 预报器

- 呈现

- 礼物

- 主要

- 市场问题

- 问题

- 过程

- 处理

- 生成

- 所以专业

- 本人简介

- 提供

- 建议

- 保护

- 提供

- 供应商

- 提供

- 公然

- 蟒蛇

- 量

- 阅读

- 阅读

- 最近

- 建议

- 建议

- 减少

- 引用

- 简称

- 指

- 正则表达式

- 注册

- 有关

- 相应

- 卓越

- 更换

- 报告

- 报告

- 业务报告

- 请求

- 必须

- 需要

- 资源

- 资源

- 分别

- REST的

- 导致

- 成果

- 回报

- 上升

- 运行

- 运行

- sagemaker

- 同

- 可扩展性

- 科学

- 科学家

- 划伤

- SDK

- 搜索

- 秒

- 部分

- 部分

- 看到

- 选

- 前辈

- 敏感

- 句子

- 分开

- 服务

- 特色服务

- 服务

- 集

- 设置

- 设置

- 她

- 应该

- 显示

- 如图

- 作品

- 意义

- 显著

- 简易

- 只是

- 小

- So

- 方案,

- 解决方案

- 解决

- 一些

- 跨度

- 专门

- 具体的

- 特别是

- 指定

- 开始

- 开始

- 国家的最先进的

- Status

- 步

- 步骤

- 仍

- 存储

- 商店

- 故事

- 策略

- 策略

- 工作室

- 这样

- 概要

- 肯定

- 表

- 采取

- 需要

- 任务

- 任务

- 专业技术

- 比

- 这

- 他们

- 然后

- 那里。

- 从而

- 因此

- 博曼

- Free Introduction

- 那些

- 三

- 通过

- 次

- 至

- 也有

- Topics

- 跟踪时

- 培训

- 产品培训

- 转让

- 改造

- 变压器

- 翻译

- 真相

- 尝试

- 二

- 类型

- 普遍

- 下划线

- 理解

- 统一

- 单元

- 大学

- 上传

- 使用

- 用过的

- 用户

- 使用

- 运用

- 验证

- 折扣值

- 价值观

- 各个

- 广阔

- 版本

- 通过

- 视频

- 在线会议

- 等待

- 是

- we

- 卷筒纸

- Web服务

- 您的网站

- ,尤其是

- 这

- 而

- 宽度

- 将

- 中

- 也完全不需要

- Word

- 话

- 工作

- 工作流程

- 将

- 写作

- X-射线

- 年

- 完全

- 您一站式解决方案

- 和风网