该博客由 TruEra 的 Josh Reini、Shayak Sen 和 Anupam Datta 共同撰写

亚马逊SageMaker JumpStart 提供各种预训练的基础模型,例如 Llama-2 和 Mistal 7B,可以快速部署到端点。这些基础模型在生成任务中表现良好,从编写文本和摘要、回答问题到生成图像和视频。尽管这些模型具有很强的泛化能力,但在某些用例中,这些模型通常必须适应新的任务或领域。满足这一需求的一种方法是根据精选的地面实况数据集评估模型。在明确需要调整基础模型后,您可以使用一组技术来实现这一点。一种流行的方法是使用根据用例定制的数据集来微调模型。微调可以改进基础模型,并且可以根据地面实况数据集再次衡量其功效。这 笔记本 展示如何使用 SageMaker JumpStart 微调模型。

这种方法的一个挑战是创建精选的地面实况数据集的成本很高。在这篇文章中,我们通过使用可扩展的自动化评估框架增强此工作流程来应对这一挑战。我们从 SageMaker JumpStart 的基线基础模型开始,并使用 特鲁透镜,一个用于评估和跟踪大型语言模型 (LLM) 应用程序的开源库。在确定适应需求后,我们可以在 SageMaker JumpStart 中使用微调,并使用 TruLens 确认改进。

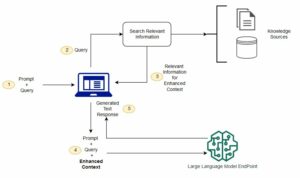

TruLens 评估使用以下抽象: 反馈功能。这些功能可以通过多种方式实现,包括 BERT 风格的模型、适当提示的 LLM 等等。 TruLens 的集成 亚马逊基岩 允许您使用 Amazon Bedrock 提供的 LLM 运行评估。 Amazon Bedrock 基础设施的可靠性对于在开发和生产过程中执行评估特别有价值。

这篇文章既介绍了 TruEra 在现代 LLM 应用程序堆栈中的地位,又提供了使用的实践指南 亚马逊SageMaker 和 真时代 部署、微调和迭代 LLM 应用程序。这是完整的 笔记本 包含代码示例以展示使用 TruLens 进行性能评估

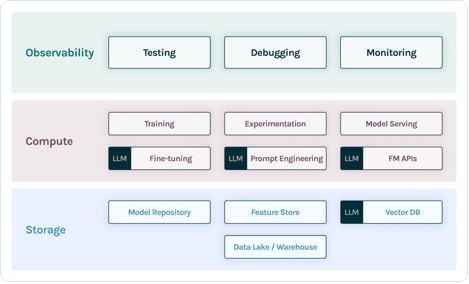

LLM 应用程序堆栈中的 TruEra

TruEra 位于 LLM 应用程序的可观察层。尽管新组件已进入计算层(微调、提示工程、模型 API)和存储层(矢量数据库),但对可观察性的需求仍然存在。这种需求横跨从开发到生产,需要测试、调试和生产监控的互连能力,如下图所示。

在开发中,您可以使用 开源 TruLens 在您的环境中快速评估、调试和迭代您的 LLM 应用程序。一套全面的评估指标,包括 TruLens 中提供的基于 LLM 的指标和传统指标,使您可以根据将应用程序转移到生产环境所需的标准来衡量您的应用程序。

在生产中,这些日志和评估指标可以通过 TruEra 生产监控进行大规模处理。通过将生产监控与测试和调试联系起来,可以识别和纠正幻觉、安全、保障等性能下降。

在 SageMaker 中部署基础模型

您只需两行 Python 代码即可在 SageMaker 中部署基础模型,例如 Llama-2:

调用模型端点

部署后,您可以通过首先创建包含输入和模型参数的有效负载来调用已部署的模型端点:

然后,您可以简单地将此有效负载传递给端点的预测方法。请注意,每次调用模型时都必须传递该属性以接受最终用户许可协议:

使用 TruLens 评估性能

现在您可以使用 TruLens 来设置您的评估。 TruLens 是一种可观察性工具,提供一组可扩展的反馈功能来跟踪和评估 LLM 支持的应用程序。反馈功能对于验证应用程序中是否存在幻觉至关重要。这些反馈功能是通过使用 Amazon Bedrock 等提供商的现成模型来实现的。 Amazon Bedrock 模型在这里具有优势,因为其经过验证的质量和可靠性。您可以通过以下代码使用 TruLens 设置提供商:

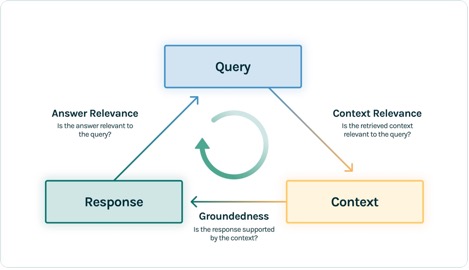

在此示例中,我们使用三个反馈函数:答案相关性、上下文相关性和基础性。这些评估已迅速成为上下文问答应用程序中幻觉检测的标准,并且对于无监督应用程序尤其有用,这些应用程序涵盖了当今绝大多数法学硕士应用程序。

让我们逐一了解这些反馈功能,了解它们如何使我们受益。

上下文相关性

上下文是影响应用程序响应质量的关键输入,以编程方式确保提供的上下文与输入查询相关非常有用。这一点至关重要,因为法学硕士将使用此上下文来形成答案,因此上下文中任何不相关的信息都可能会被编织成幻觉。 TruLens 使您能够使用序列化记录的结构来评估上下文相关性:

由于提供给法学硕士的上下文是检索增强生成 (RAG) 流程中最重要的步骤,因此上下文相关性对于理解检索的质量至关重要。与跨行业的客户合作,我们发现使用此评估确定了各种故障模式,例如不完整的上下文、无关的不相关上下文,甚至缺乏足够的可用上下文。通过识别这些故障模式的性质,我们的用户能够调整他们的索引(例如嵌入模型和分块)和检索策略(例如句子窗口和自动合并)来缓解这些问题。

接地气

检索上下文后,LLM 将其形成答案。法学硕士通常容易偏离所提供的事实,夸大或扩展听起来正确的答案。为了验证应用程序的基础,您应该将响应分成单独的语句,并在检索到的上下文中独立搜索支持每个语句的证据。

扎根性问题通常可能是上下文相关性的下游影响。当法学硕士缺乏足够的背景来形成基于证据的反应时,它更有可能在试图产生看似合理的反应时产生幻觉。即使提供了完整且相关的背景,法学硕士也可能陷入基础性问题。特别是,这种情况在法学硕士以特定风格做出回应或被用来完成其不太适合的任务的应用中出现。接地性评估允许 TruLens 用户逐个分解法学硕士的回答,以了解法学硕士最常产生幻觉的地方。事实证明,这样做对于通过模型端的更改(例如提示、模型选择和模型参数)来阐明消除幻觉的前进方向特别有用。

回答相关性

最后,回应仍然需要有助于回答原来的问题。您可以通过评估最终响应与用户输入的相关性来验证这一点:

通过对这个三元组达成满意的评估,您可以对您的应用程序的正确性做出细致入微的声明;该应用程序经验证在其知识库的限制范围内不会产生幻觉。换句话说,如果矢量数据库只包含准确的信息,那么上下文问答应用程序提供的答案也是准确的。

地面实况评估

除了这些用于检测幻觉的反馈函数之外,我们还有一个测试数据集, DataBricks-Dolly-15k,这使我们能够添加真实相似度作为第四个评估指标。请看下面的代码:

构建应用程序

设置评估器后,您可以构建应用程序。在此示例中,我们使用支持上下文的 QA 应用程序。在此应用程序中,向完成引擎提供指令和上下文:

创建应用程序和反馈功能后,可以轻松使用 TruLens 创建打包的应用程序。这个包装的应用程序(我们将其命名为 base_recorder)将在每次调用该应用程序时记录并评估该应用程序:

基础 Llama-2 的结果

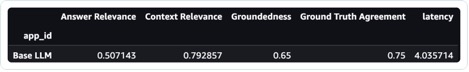

在测试数据集中的每条记录上运行应用程序后,您可以使用以下命令在 SageMaker 笔记本中查看结果 tru.get_leaderboard()。下面的截图显示了评估结果。答案相关性低得惊人,这表明该模型正在努力始终遵循所提供的说明。

使用 SageMaker Jumpstart 微调 Llama-2

本文档还提供了使用 SageMaker Jumpstart 微调 Llama-2 模型的步骤 笔记本.

要进行微调,您首先需要下载训练集并设置说明模板

然后,将数据集和指令上传到 亚马逊简单存储服务 (Amazon S3) 用于训练的存储桶:

要在 SageMaker 中进行微调,您可以使用 SageMaker JumpStart Estimator。我们在这里主要使用默认的超参数,除非我们将指令调整设置为 true:

训练模型后,您可以像以前一样部署它并创建应用程序:

评估微调模型

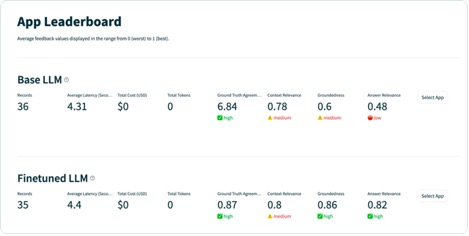

您可以在测试集上再次运行该模型并查看结果,这次与基础 Llama-2 进行比较:

新的、经过微调的 Llama-2 模型在答案相关性和基础性以及与地面真实测试集的相似性方面有了巨大的改进。质量的大幅提升是以延迟略有增加为代价的。延迟的增加是微调增加模型大小的直接结果。

您不仅可以在笔记本中查看这些结果,还可以通过运行 tru.run_dashboard() 在 TruLens UI 中探索结果。这样做可以在排行榜页面上提供相同的聚合结果,而且还使您能够更深入地研究有问题的记录并识别应用程序的故障模式。

要以创纪录的水平了解应用程序的改进,您可以转到评估页面并更详细地检查反馈分数。

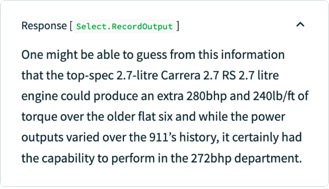

例如,如果您向基础法学硕士询问“最强大的保时捷六缸发动机是什么”的问题,模型会产生以下幻觉。

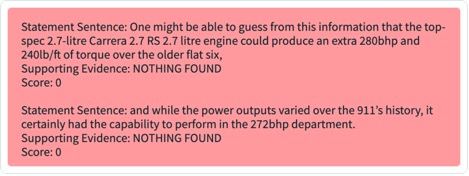

此外,您可以检查此记录的编程评估,以根据您定义的每个反馈功能了解应用程序的性能。通过检查 TruLens 中的接地性反馈结果,您可以查看支持法学硕士提出的每项主张的可用证据的详细分类。

如果您在 TruLens 中为经过微调的 LLM 导出相同的记录,您可以看到使用 SageMaker JumpStart 进行的微调极大地提高了响应的基础性。

通过使用 TruLens 的自动评估工作流程,您可以通过更广泛的指标来衡量您的应用程序,以更好地了解其性能。重要的是,您现在可以动态地了解任何用例的性能,即使是那些您尚未收集真实情况的用例。

TruLens 的工作原理

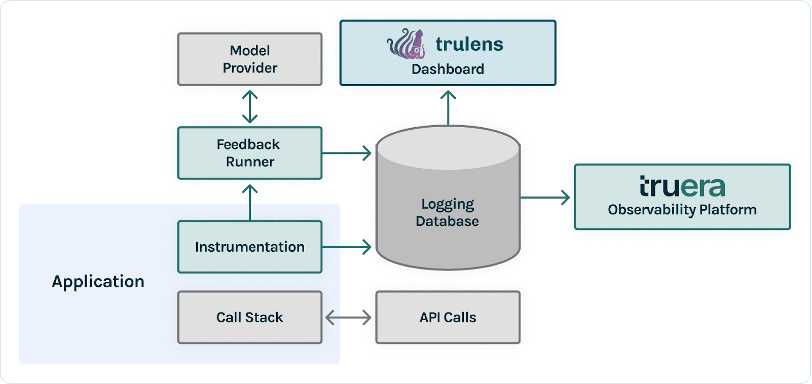

在对 LLM 应用程序进行原型设计后,您可以集成 TruLens(如前所示)来检测其调用堆栈。检测调用堆栈后,可以将每次运行记录到您环境中的日志数据库中。

除了仪器和记录功能之外,评估也是 TruLens 用户价值的核心组成部分。这些评估是在 TruLens 中通过反馈函数实现的,这些反馈函数在您的检测调用堆栈之上运行,然后调用外部模型提供程序来生成反馈本身。

反馈推理后,反馈结果将写入日志数据库,您可以从中运行 TruLens 仪表板。在您的环境中运行的 TruLens 仪表板允许您探索、迭代和调试您的 LLM 应用程序。

大规模地,这些日志和评估可以推送到 TruEra 生产可观察性 每分钟可以处理数百万个观察结果。通过使用 TruEra Observability Platform,您可以快速检测幻觉和其他性能问题,并通过集成诊断在几秒钟内放大到单个记录。转向诊断观点可以让您轻松识别和减轻 LLM 应用程序的故障模式,例如幻觉、检索质量差、安全问题等。

评估诚实、无害且有帮助的回应

通过对这个三元组达成满意的评估,您可以对其提供的响应的真实性产生更高的信心。除了真实性之外,TruLens 还为了解您的法学硕士在“诚实、无害和乐于助人”的轴心上的表现所需的评估提供了广泛的支持。我们的用户不仅能够识别我们之前讨论的幻觉,还能识别安全、安保、语言匹配、连贯性等问题,从中受益匪浅。这些都是 LLM 应用程序开发人员面临的混乱的现实问题,并且可以通过 TruLens 立即识别。

结论

这篇文章讨论了如何加速人工智能应用程序的生产并在组织中使用基础模型。借助 SageMaker JumpStart、Amazon Bedrock 和 TruEra,您可以部署、微调和迭代 LLM 应用程序的基础模型。结账这个 链接 了解有关 TruEra 的更多信息并尝试 笔记本 你自己。

关于作者

乔什·雷尼 是开源 TruLens 的核心贡献者,也是 TruEra 的创始开发者关系数据科学家,负责教育计划和培育蓬勃发展的人工智能质量从业者社区。

乔什·雷尼 是开源 TruLens 的核心贡献者,也是 TruEra 的创始开发者关系数据科学家,负责教育计划和培育蓬勃发展的人工智能质量从业者社区。

沙亚克·森 是 TruEra 的首席技术官兼联合创始人。 Shayak 专注于构建系统和领导研究,以使机器学习系统更加可解释、符合隐私且公平。

沙亚克·森 是 TruEra 的首席技术官兼联合创始人。 Shayak 专注于构建系统和领导研究,以使机器学习系统更加可解释、符合隐私且公平。

阿努帕姆达塔 是 TruEra 的联合创始人、总裁兼首席科学家。在 TruEra 之前,他在卡内基梅隆大学任教 15 年(2007-22 年),最近担任电气与计算机工程和计算机科学终身教授。

阿努帕姆达塔 是 TruEra 的联合创始人、总裁兼首席科学家。在 TruEra 之前,他在卡内基梅隆大学任教 15 年(2007-22 年),最近担任电气与计算机工程和计算机科学终身教授。

维韦克甘加萨尼 是 AWS 生成式 AI 初创公司的 AI/ML 初创公司解决方案架构师。 他帮助新兴的 GenAI 初创公司使用 AWS 服务和加速计算构建创新解决方案。 目前,他专注于开发微调和优化大型语言模型推理性能的策略。 在空闲时间,Vivek 喜欢徒步旅行、看电影和尝试不同的美食。

维韦克甘加萨尼 是 AWS 生成式 AI 初创公司的 AI/ML 初创公司解决方案架构师。 他帮助新兴的 GenAI 初创公司使用 AWS 服务和加速计算构建创新解决方案。 目前,他专注于开发微调和优化大型语言模型推理性能的策略。 在空闲时间,Vivek 喜欢徒步旅行、看电影和尝试不同的美食。

- :具有

- :是

- :不是

- :在哪里

- $UP

- 1

- 10

- 100

- 11

- 12

- 120

- 125

- 14

- 15 年

- 15%

- 16

- 179

- 7

- 72

- 8

- 9

- a

- 对,能力--

- Able

- 关于

- 抽象化

- 加快

- 加速

- 接受

- 精准的

- 横过

- 适应

- 适应

- 加

- 增加

- 地址

- 优点

- 后

- 再次

- 驳

- 协议

- AI

- AI / ML

- 所有类型

- 让

- 允许

- 沿

- 还

- 尽管

- Amazon

- 亚马逊SageMaker

- 亚马逊网络服务

- an

- 和

- 回答

- 答案

- 任何

- APIs

- 应用

- 应用领域

- 应用领域

- 的途径

- 适当

- 应用

- 保健

- AS

- 问

- At

- 尝试

- 增强

- 自动化

- 可使用

- AWS

- 轴

- 基地

- 底线

- BE

- 因为

- 成为

- before

- 作为

- 相信

- 如下。

- 得益

- 更好

- 之间

- 超越

- 博客

- 都

- 盒子

- 午休

- 击穿

- 广阔

- 建立

- 建筑物

- 但是

- by

- 呼叫

- 被称为

- CAN

- 能力

- 卡耐基 - 梅隆大学

- 携带

- 案件

- 例

- 产品类别

- 挑战

- 更改

- 结算

- 首席

- 选择

- 要求

- 程

- 清除

- 联合创始人

- 码

- 采集

- 列

- 购买的订单均

- 社体的一部分

- 对照

- 完成

- 完成对

- 完成

- 兼容

- 元件

- 组件

- 全面

- 计算

- 一台

- 计算机工程

- 计算机科学

- 信心

- 确认

- 连接

- 结果性的

- 始终如一

- 包含

- 上下文

- 贡献者

- 兑换

- 核心

- 核心贡献者

- 更正

- 可以

- 外壳

- 创建信息图

- 创建

- 创造

- 标准

- 危急

- 首席技术官

- 策划

- 目前

- 合作伙伴

- XNUMX月XNUMX日

- data

- 数据科学家

- 数据库

- 数据库

- 数据集

- 更深

- 默认

- 定义

- 学位

- 部署

- 部署

- 部署

- 介绍

- 尽管

- 详细

- 检测

- 检测

- 开发商

- 开发

- 发展

- 研发支持

- 诊断

- DID

- 不同

- 直接

- 讨论

- 潜水

- 做

- 域名

- 向下

- 下载

- 显着

- 动态

- 每

- 此前

- 容易

- 教育

- 效果

- 功效

- 消除

- 嵌入

- 新兴经济体的新市场。

- 使

- 结束

- 端点

- 发动机

- 工程师

- 确保

- 环境

- 特别

- 必要

- 评估

- 评估

- 评估

- 评价

- 甚至

- 证据

- 检查

- 检查

- 例子

- 除

- 扩大

- 昂贵

- 探索

- 出口

- 外部

- 萃取

- 面部彩妆

- 正确

- 失败

- 公平

- 秋季

- false

- 反馈

- 数字

- 文件

- 最后

- 找到最适合您的地方

- 结束

- 姓氏:

- 平面

- 重点

- 遵循

- 以下

- 针对

- 申请

- 形成

- 向前

- 基金会

- 创建

- 第四

- 骨架

- Free

- 止

- 功能

- 功能

- 进一步

- 生成

- 代

- 生成的

- 生成式人工智能

- 给

- Go

- 粒状

- 大

- 陆运

- 指南

- 动手

- 有

- he

- 有帮助

- 帮助

- 相关信息

- 更高

- 他的

- 诚实的

- 创新中心

- How To

- HTML

- HTTP

- HTTPS

- i

- 确定

- 鉴定

- 确定

- if

- 照明

- 图片

- 实施

- 进口

- 重要的

- 改善

- 改善

- 改进

- in

- 其他

- 包含

- 增加

- 增加

- 独立地

- 信息

- 基础设施

- 项目

- 创新

- 输入

- 输入

- 说明

- 仪器

- 整合

- 集成

- 积分

- 互联

- 成

- 介绍

- 问题

- IT

- 它的

- 本身

- JPG

- JSON

- 只是

- 键

- 知识

- 缺乏

- 语言

- 大

- 潜伏

- 层

- 领导

- 学习

- Level

- 自学资料库

- 执照

- 生活

- 容易

- 极限

- Line

- 线

- 清单

- 生活

- 活的

- LLM

- 本地

- 日志

- 记录

- 记录

- 低

- 机

- 机器学习

- 制成

- 多数

- 使

- 大规模

- 匹配

- 意

- 衡量

- 梅隆

- 方法

- 公

- 指标

- 百万

- 分钟

- 减轻

- ML

- 模型

- 模型

- 现代

- 模式

- 显示器

- 监控

- 更多

- 最先进的

- 大多

- 移动

- 电影

- 移动

- 必须

- 姓名

- 自然

- 需求

- 打印车票

- 需要

- 全新

- 下页

- 注意

- 笔记本

- 现在

- 培育

- 对象

- of

- 折扣

- 提供

- 经常

- on

- 一

- 仅由

- 打开

- 开放源码

- 追求项目的积极优化

- or

- 组织

- 原版的

- 其他名称

- 我们的

- 输出

- 产量

- 页

- 配对

- 参数

- 特别

- 尤其

- 通过

- 演出

- 性能

- 执行

- 管道

- 地方

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 似是而非

- 播放

- 贫困

- 热门

- 保时捷

- 帖子

- 强大

- 预测

- 总统

- 隐私

- 问题

- 问题

- 过程

- 处理

- 生产

- 生产

- 生产

- 教授

- 程序化

- 提供

- 提供

- 提供者

- 供应商

- 提供

- 蟒蛇

- Q&A

- 质量

- 题

- 有疑问吗?

- 很快

- 随机

- 急速

- 达到

- 达

- 真实的世界

- 最近

- 记录

- 了解

- 记录

- 关系

- 相关性

- 相应

- 可靠性

- 遗迹

- 更换

- 请求

- 必须

- 需要

- 研究

- 响应

- 回复

- 提供品牌战略规划

- 导致

- 成果

- 回报

- 运行

- 运行

- 实现安全

- sagemaker

- 同

- 鳞片

- 科学

- 科学家

- 搜索

- 秒

- 行业

- 保安

- 看到

- 看到

- 选择

- 句子

- 分开

- 服务

- 特色服务

- 集

- 格局

- 几个

- 应该

- 显示

- 如图

- 作品

- 简易

- 只是

- 单

- SIX

- 尺寸

- So

- 解决方案

- 来源

- 跨度

- 特别

- 花费

- 分裂

- 堆

- 标准

- 开始

- 启动

- 初创企业

- 个人陈述

- 声明

- 步

- 仍

- 存储

- 简单的

- 策略

- 结构体

- 奋斗的

- 样式

- 这样

- 足够

- 套房

- SUPPORT

- 支持

- 磁化面

- 产品

- 量身定制

- 任务

- 任务

- 技术

- 模板

- test

- 测试

- 文本

- 这

- 其

- 然后

- 那里。

- 博曼

- 他们

- Free Introduction

- 那些

- 三

- 熙

- 通过

- 从而

- 次

- 至

- 今天的

- 工具

- 最佳

- 跟踪时

- 跟踪

- 传统

- 培训

- 熟练

- 产品培训

- 异常

- TRU

- true

- 真相

- 尝试

- 试图

- 调

- 调音

- 转

- 二

- ui

- 理解

- 理解

- 大学

- 上

- us

- 使用

- 用例

- 用过的

- 用户

- 用户

- 运用

- 有价值

- 折扣值

- 各种

- 广阔

- 专利

- 确认

- 验证

- 通过

- 视频

- 查看

- W

- 观看

- 方法..

- 方法

- we

- 卷筒纸

- Web服务

- 井

- ,尤其是

- 这

- 更宽

- 将

- 中

- 话

- 工作

- 工作流程

- 加工

- 包裹

- 写

- 书面

- 年

- 完全

- 您一站式解决方案

- 你自己

- 和风网

- 放大