随着越来越多的组织采用生成式人工智能技术——精心策划、完成拨款申请并撰写 样板代码 — 安全团队意识到需要解决一个新问题:如何保护人工智能工具的安全?

Gartner 最近的一项调查显示,三分之一的受访者表示 使用或实施基于人工智能的应用程序安全工具 解决在其组织中使用生成人工智能带来的风险。

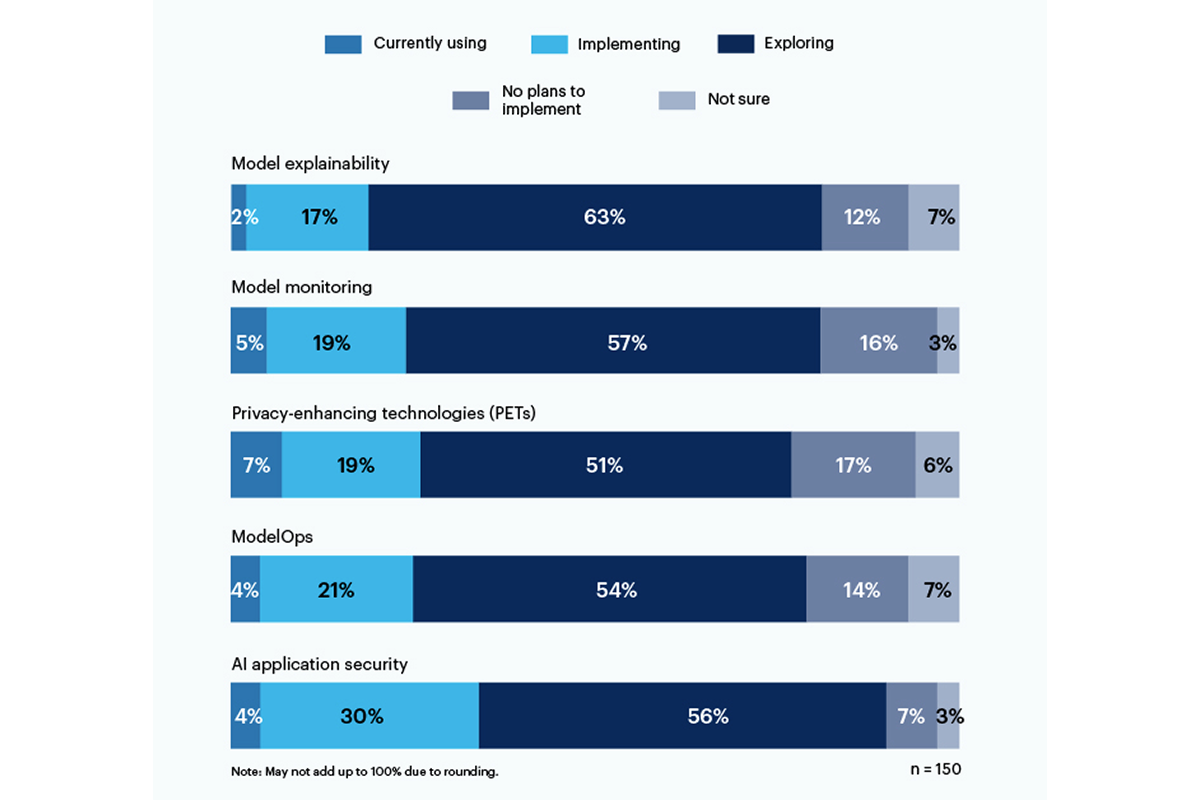

隐私增强技术 (PET) 目前使用率最高,占受访者的 7%,其中 19% 的公司实施了该技术;此类别包括保护个人数据的方法,例如 同态加密, 人工智能生成的合成数据, 安全多方计算, 联合学习及 差异隐私。然而,有 17% 的人没有计划在他们的环境中实施 PET。

只有 19% 的人正在使用或实施模型可解释性工具,但受访者对探索和理解这些工具以解决生成式 AI 风险非常感兴趣 (56%)。 Gartner 表示,可解释性、模型监控和 AI 应用安全工具都可以用于开源或专有模型,以实现企业用户所需的可信度和可靠性。

受访者最担心的风险包括不正确或有偏见的输出(58%)以及人工智能生成的代码中的漏洞或泄露的秘密(57%)。值得注意的是,43% 的受访者将人工智能生成的内容引起的潜在版权或许可问题视为其组织面临的最大风险。

“正在训练的数据模型仍然不透明,因此与偏见和隐私相关的风险很难理解和估计,”一位高管在回应 Gartner 调查时写道。

6月,国家标准技术研究院 (NIST) 成立了一个公共工作组 根据一月份的人工智能风险管理框架来帮助解决这个问题。正如 Gartner 数据显示, 企业并不等待 对于 NIST 指令。

- :是

- :不是

- 7

- a

- 关于

- 根据

- 地址

- 采用

- AI

- 所有类型

- 其中

- 和

- 应用领域

- 应用安全

- 应用领域

- 保健

- AS

- 相关

- At

- 基于

- BE

- 偏见

- 偏

- 但是

- by

- C-套房

- CAN

- 产品类别

- 引

- 码

- 公司

- 完成

- 关心

- 内容

- 版权

- 手艺

- 电流

- data

- 难

- 指令

- do

- 或

- 企业

- 环境

- 评估

- 执行

- 探索

- 针对

- 骨架

- 止

- Gartner公司

- 生成的

- 生成式人工智能

- 授予

- 最大的

- 有

- 帮助

- 创新中心

- 但是

- HTTPS

- 实施

- in

- 包括

- 包括

- 研究所

- 兴趣

- 问题

- IT

- 它的

- 一月

- 六月

- 推出

- 许可证

- 颠覆性技术

- 方法

- 模型

- 模型

- 监控

- 更多

- 最先进的

- 多

- National

- 需求

- 全新

- NIST

- 没有

- of

- on

- 打开

- 开放源码

- or

- 组织

- 组织

- 个人

- 个人资料

- 是否接受宠物

- 球场

- 计划

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 构成

- 潜力

- 隐私

- 所有权

- 保护

- 国家

- 题

- 实现

- 最近

- 可靠性

- 依靠

- 报道

- 受访者

- 响应

- 风险

- 变更管理

- 风险

- 秘密

- 安全

- 保安

- 显示

- 作品

- 显著

- 显著

- So

- 固体

- 来源

- 标准

- 仍

- 这样

- 调查

- 合成的

- 队

- 技术

- 专业技术

- 这

- 其

- 那里。

- 博曼

- Free Introduction

- 至

- 工具

- 最佳

- 产品培训

- 用户评论透明

- 诚信

- 理解

- 理解

- 使用

- 用过的

- 用户

- 运用

- 非常

- 漏洞

- 方法

- 加工

- 写

- 写

- 完全

- 和风网