这篇博文是与 Upstage 的 Hwalsuk Lee 共同撰写的。

今天,我们很高兴地宣布 太阳能 Upstage 开发的基础模型现已可供客户使用 亚马逊SageMaker JumpStart。 Solar 是一个大型语言模型 (LLM),经过 100% 预训练 亚马逊SageMaker 它的性能优于并利用其紧凑的尺寸和强大的跟踪记录来专注于目的培训,使其具有跨语言、领域和任务的多功能性。

您现在可以使用 太阳能迷你聊天 和 太阳能迷你聊天 – 量化 SageMaker JumpStart 中的预训练模型。 SageMaker JumpStart 是 SageMaker 的机器学习 (ML) 中心,除了内置算法之外,还提供对基础模型的访问,以帮助您快速开始使用 ML。

在这篇文章中,我们将介绍如何通过 SageMaker JumpStart 发现和部署 Solar 模型。

太阳能型号是什么?

Solar 是一个紧凑而强大的英语和韩语模型。它专门针对多轮聊天目的进行了微调,在各种自然语言处理任务中展示了增强的性能。

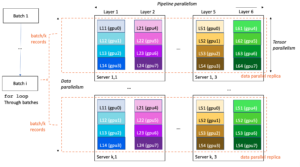

Solar Mini Chat模型基于 太阳能10.7B,有32层 骆驼2 结构,并使用预训练的权重进行初始化 米斯特拉尔7B 与 Llama 2 架构兼容。这种微调使其能够更有效地处理扩展对话,使其特别适合交互式应用程序。它采用了一种称为缩放方法 深度放大 (DUS),由深度缩放和持续预训练组成。与其他缩放方法(例如 专家的混合体 (教育部)。

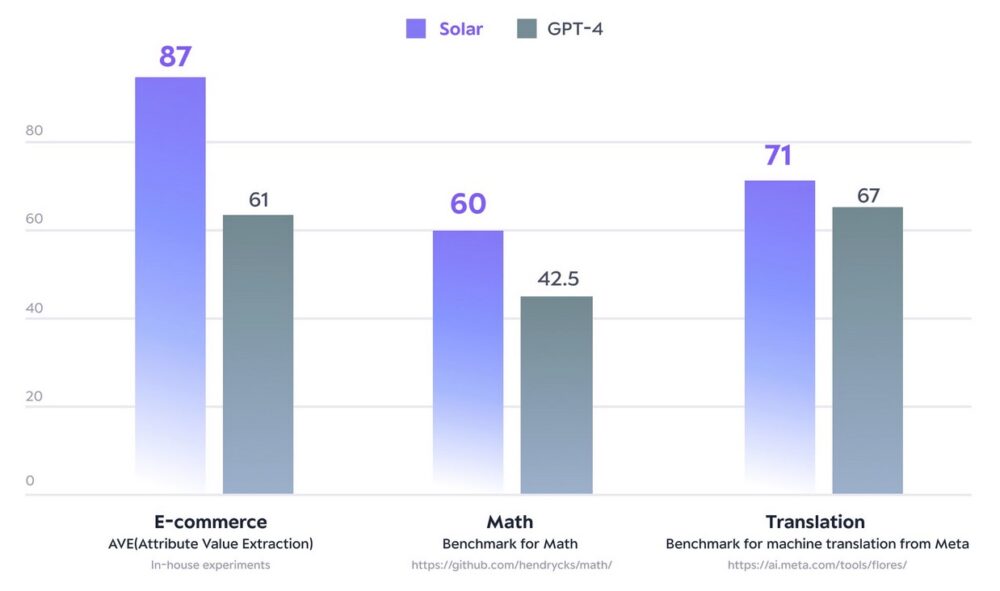

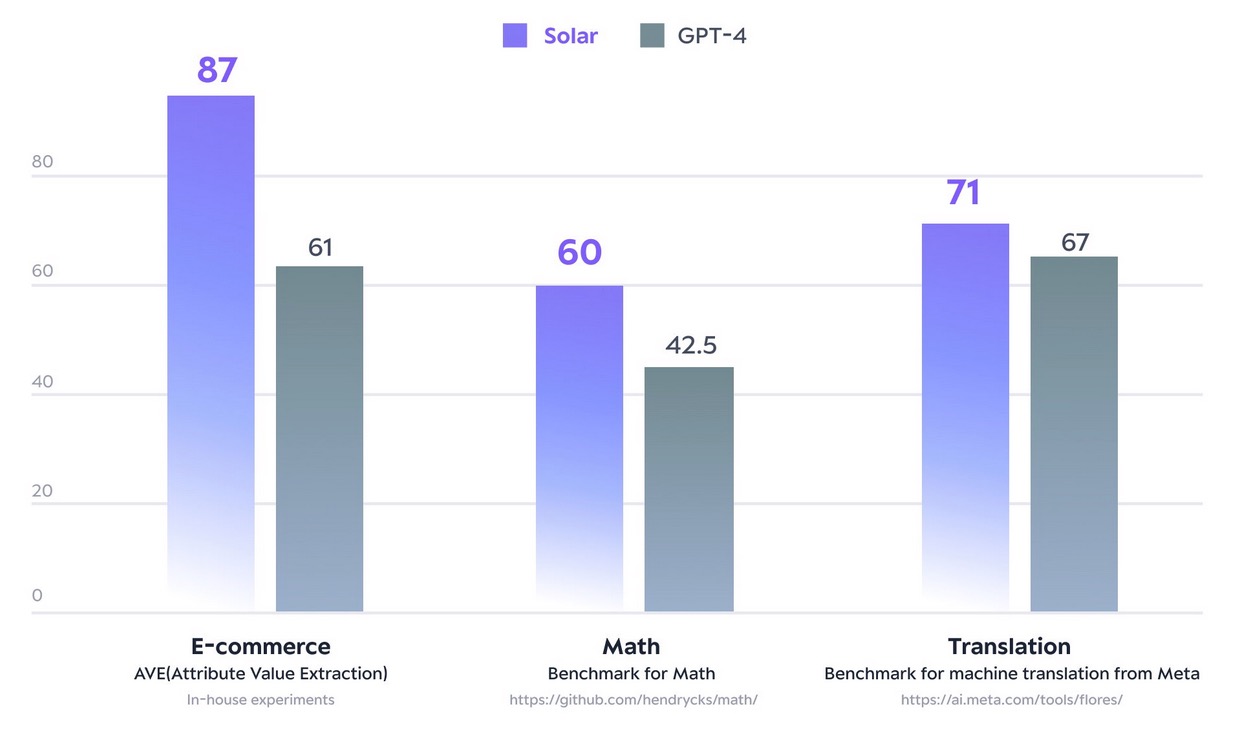

2023 年 10.7 月,Solar XNUMXB 型号掀起波澜,达到了巅峰 打开 LLM 排行榜 的拥抱脸。 Solar 10.7B 使用的参数明显更少,可提供与 GPT-3.5 相当的响应,但速度快 2.5 倍。除了在 Open LLM 排行榜上名列前茅外,Solar 10.7B 在某些领域和任务上还通过专门训练的模型超越了 GPT-4。

下图说明了其中一些指标:

借助 SageMaker JumpStart,您可以部署基于 Solar 10.7B 的预训练模型:Solar Mini Chat 和 Solar Mini Chat 的量化版本,针对英语和韩语聊天应用程序进行了优化。 Solar Mini Chat 模型提供了对韩语细微差别的高级掌握,从而显着提升了聊天环境中的用户交互。它可以对用户输入进行精确响应,确保英语和韩语聊天应用程序中更清晰的沟通和更有效的问题解决。

开始使用 SageMaker JumpStart 中的太阳能模型

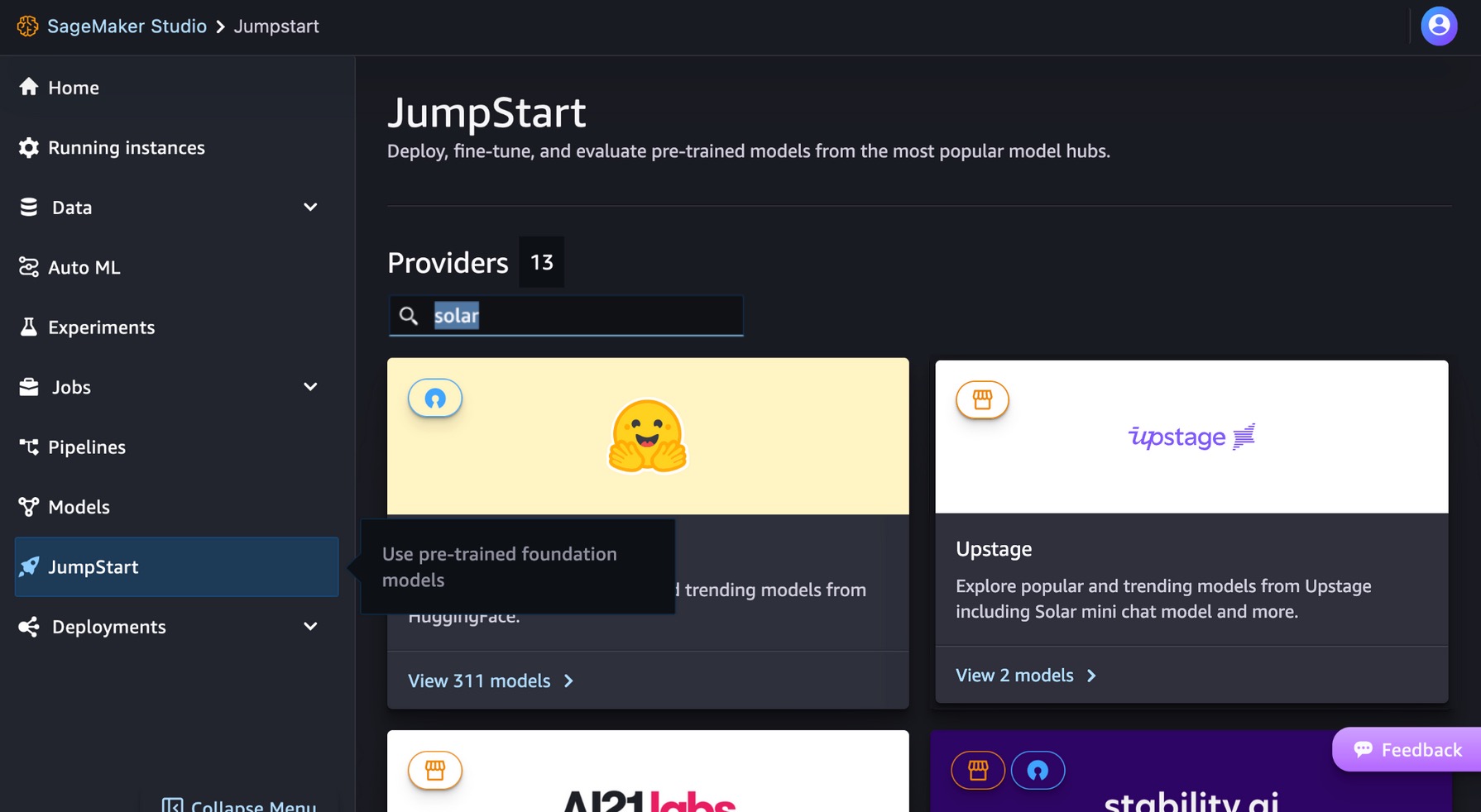

要开始使用 Solar 模型,您可以使用 SageMaker JumpStart(一项完全托管的 ML 中心服务)将预构建的 ML 模型部署到生产就绪的托管环境中。您可以通过 SageMaker JumpStart 访问 Solar 模型 亚马逊SageMaker Studio,一个基于 Web 的集成开发环境 (IDE),您可以在其中访问专用工具来执行所有 ML 开发步骤,从准备数据到构建、训练和部署 ML 模型。

在 SageMaker Studio 控制台上,选择 快速启动 在导航窗格中。您可以在搜索栏中输入“solar”来查找Upstage的太阳能模型。

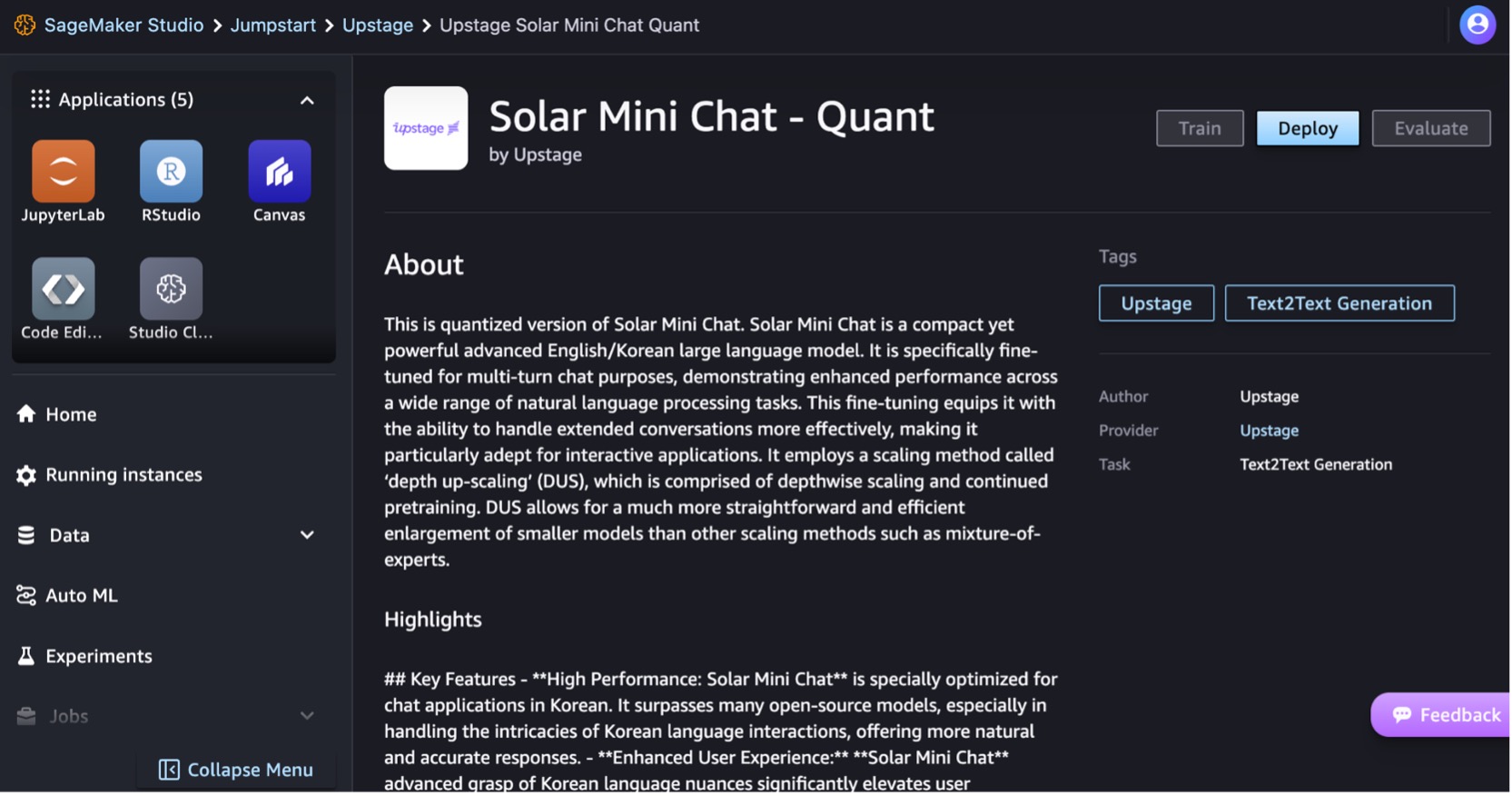

让我们部署 Solar Mini Chat – Quant 模型。选择模型卡可查看有关模型的详细信息,例如许可证、用于训练的数据以及如何使用模型。您还会发现一个 部署 选项,它会将您带到一个登录页面,您可以在其中使用示例有效负载测试推理。

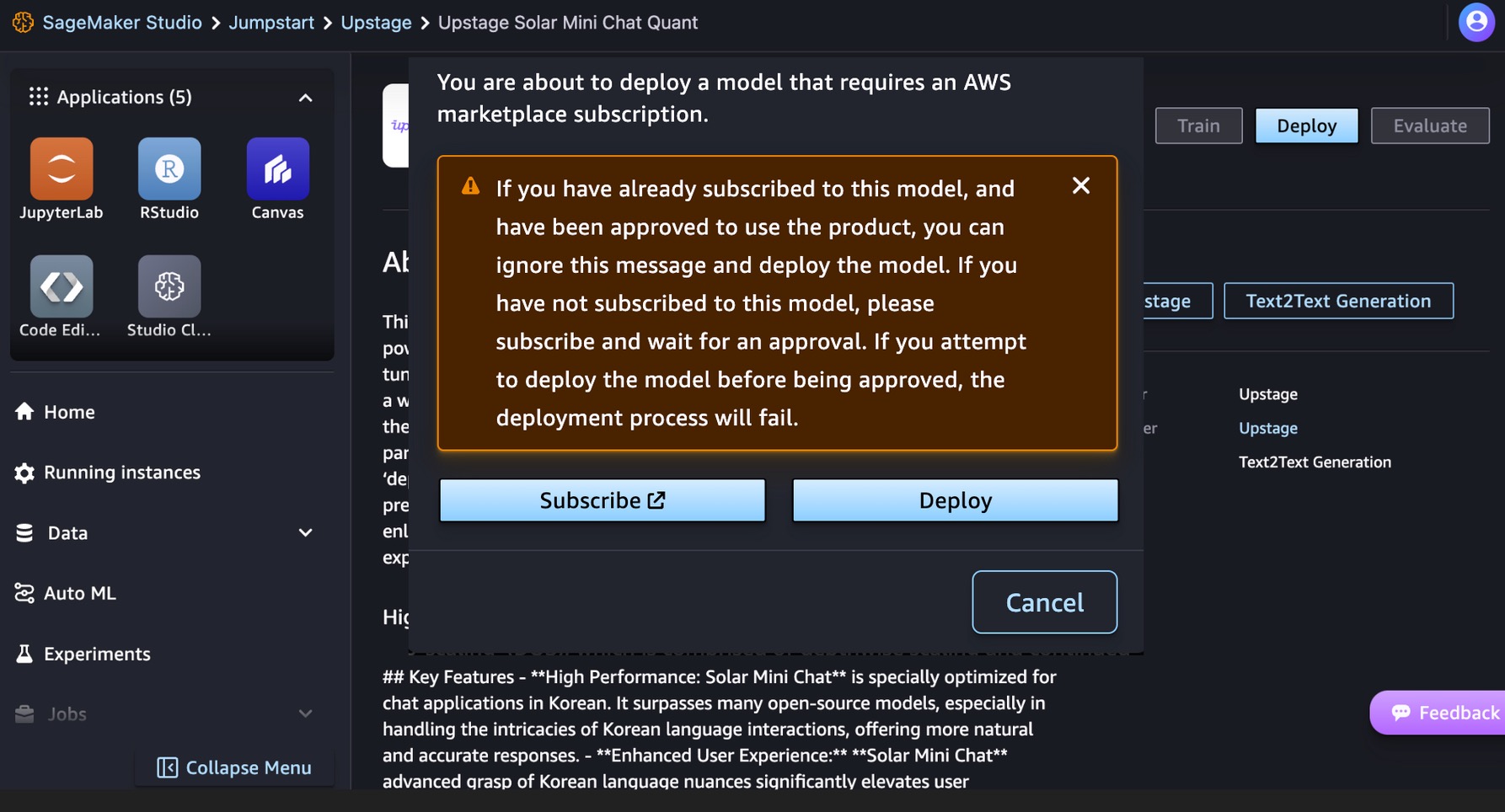

该模型需要一个 AWS Marketplace 订阅。如果您已经订阅了该模型,并且已获准使用该产品,则可以直接部署该模型。

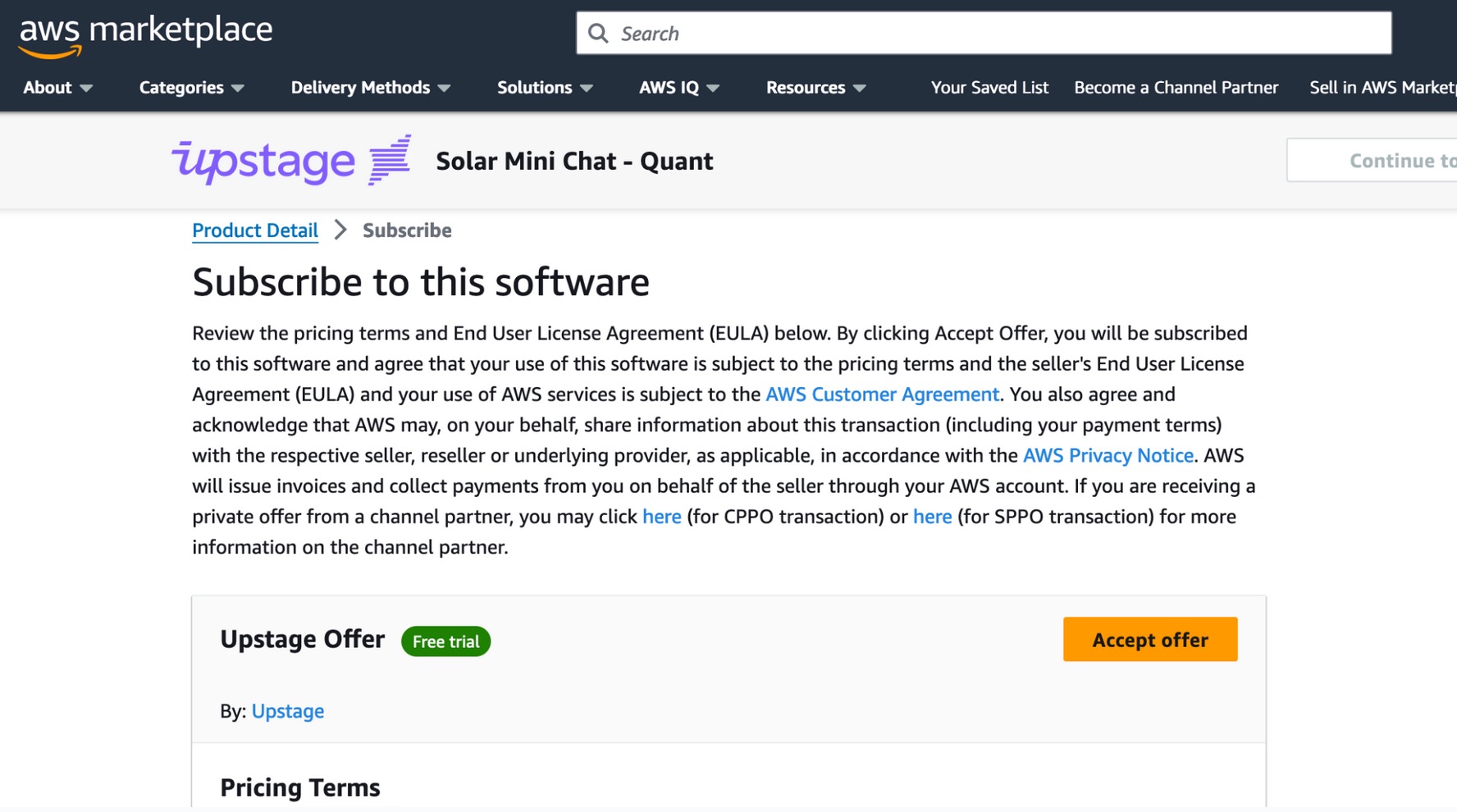

如果您还没有订阅该模型,请选择 订阅,转至 AWS Marketplace,查看定价条款和最终用户许可协议 (EULA),然后选择 接受报价.

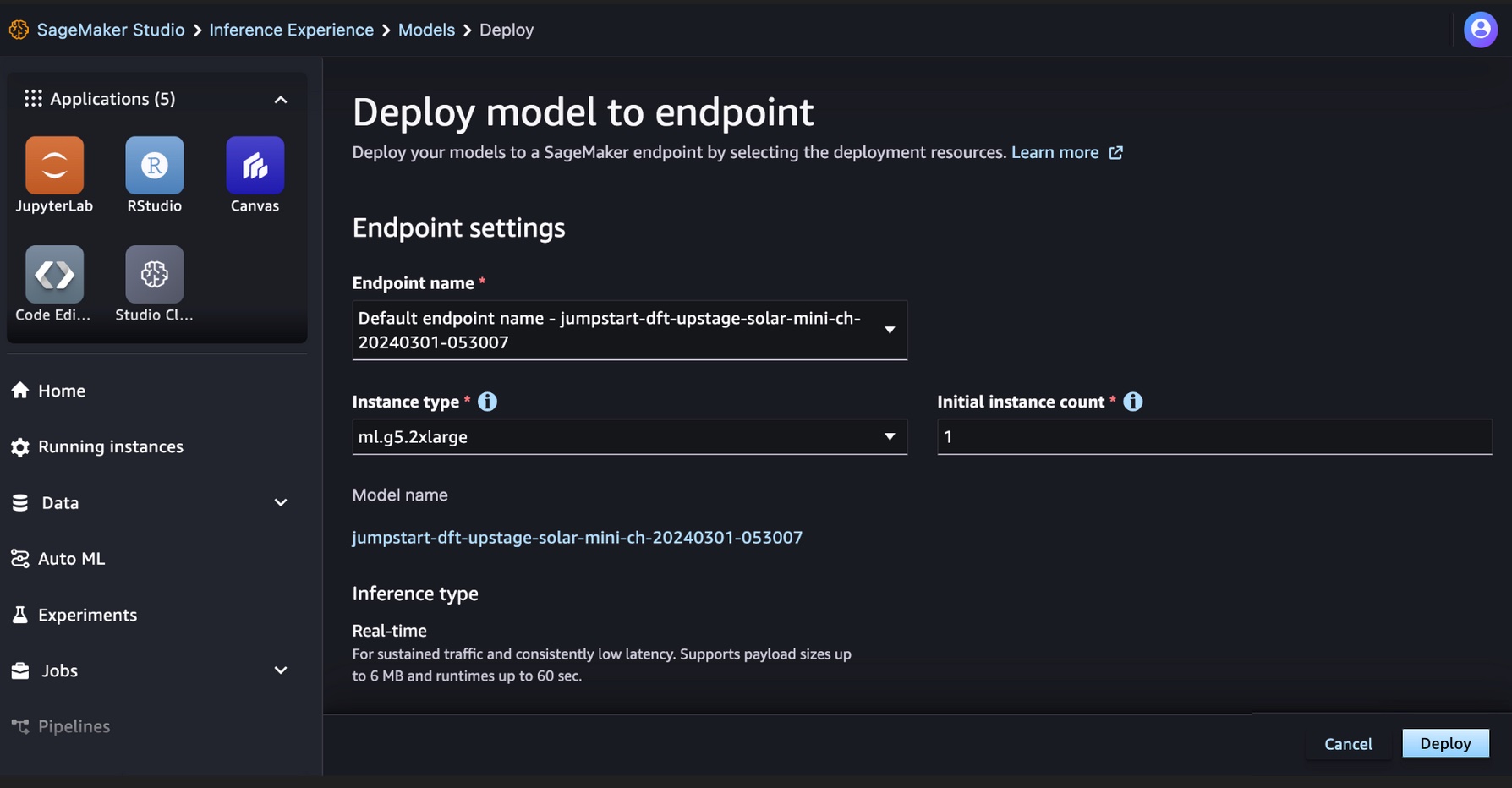

订阅模型后,您可以通过选择部署资源(例如实例类型和初始实例计数)将模型部署到 SageMaker 终端节点。选择 部署 并等待为模型推理创建端点。您可以选择一个 ml.g5.2xlarge 实例作为太阳能模型推理的更便宜的选择。

成功创建 SageMaker 终端节点后,您可以通过各种 SageMaker 应用程序环境对其进行测试。

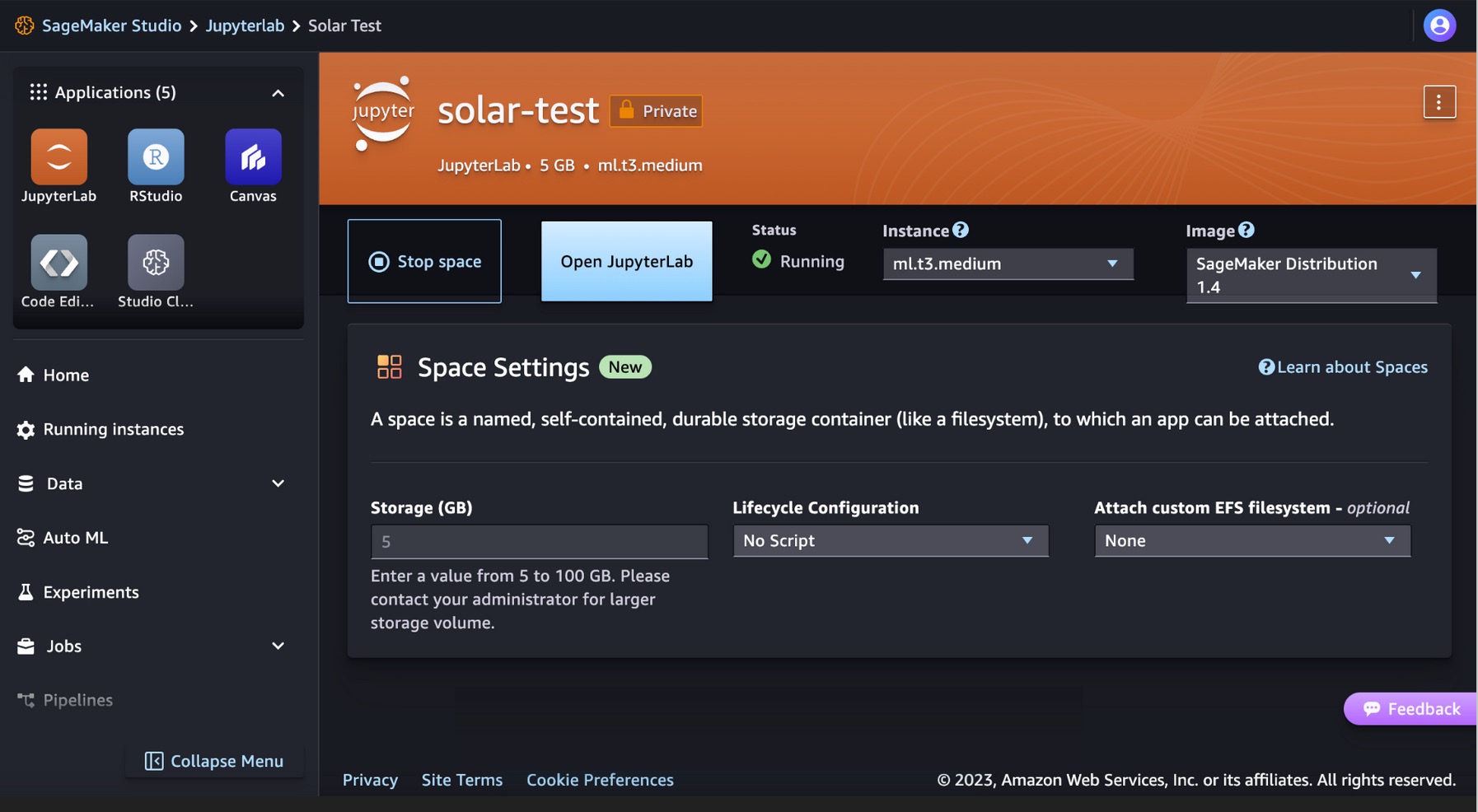

在 SageMaker Studio JupyterLab 中运行 Solar 模型的代码

SageMaker Studio 支持各种应用程序开发环境,包括 JupyterLab,这是一组增强完全托管笔记本产品的功能。它包括几秒钟内启动的内核、具有流行数据科学的预配置运行时、ML 框架和高性能私有块存储。有关更多信息,请参阅 SageMaker JupyterLab.

在 SageMaker Studio 中创建一个 JupyterLab 空间,用于管理运行 JupyterLab 应用程序所需的存储和计算资源。

您可以在 SageMaker JumpStart 上找到显示 Solar 模型部署的代码以及如何使用已部署模型的示例 GitHub回购。您现在可以使用 SageMaker JumpStart 部署模型。以下代码使用 Solar Mini Chat – Quant 模型推理端点的默认实例 ml.g5.2xlarge。

Solar 模型支持与 OpenAI 的聊天完成端点兼容的请求/响应负载。您可以使用 Python 测试单轮或多轮聊天示例。

# Get a SageMaker endpoint

sagemaker_runtime = boto3.client("sagemaker-runtime")

endpoint_name = sagemaker.utils.name_from_base(model_name)

# Multi-turn chat prompt example

input = {

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Can you provide a Python script to merge two sorted lists?"

},

{

"role": "assistant",

"content": """Sure, here is a Python script to merge two sorted lists:

```python

def merge_lists(list1, list2):

return sorted(list1 + list2)

```

"""

},

{

"role": "user",

"content": "Can you provide an example of how to use this function?"

}

]

}

# Get response from the model

response = sagemaker_runtime.invoke_endpoint(EndpointName=endpoint_name, ContentType='application/json', Body=json.dumps (input))

result = json.loads(response['Body'].read().decode())

print result您已成功使用 Solar Mini Chat 模型进行了实时推理。

清理

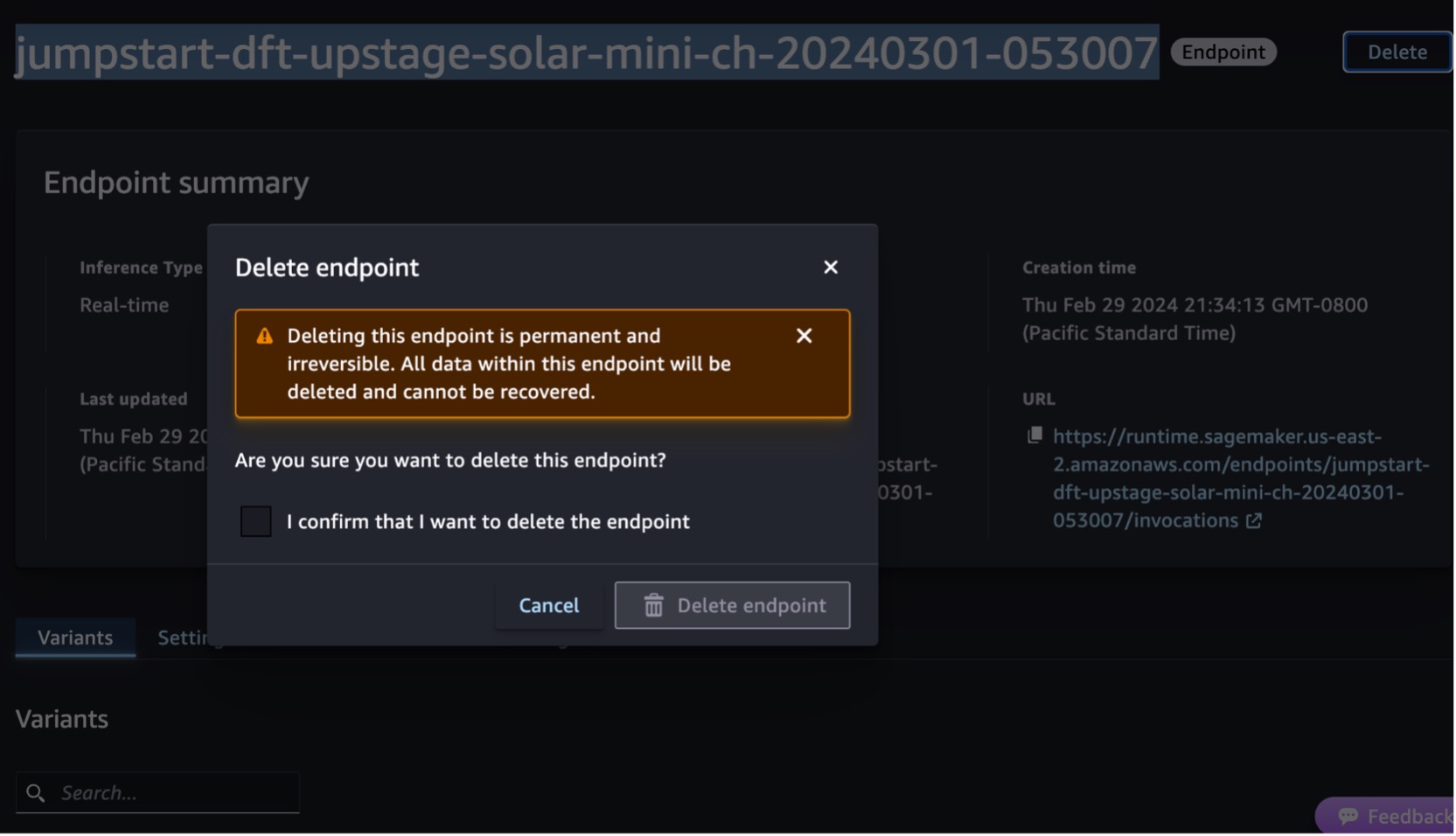

测试端点后,删除 SageMaker 推理端点并删除模型以避免产生费用。

您还可以运行以下代码来删除 SageMaker Studio JupyterLab 笔记本中的端点和模式:

# Delete the endpoint

model.sagemaker_session.delete_endpoint(endpoint_name)

model.sagemaker_session.delete_endpoint_config(endpoint_name)

# Delete the model

model.delete_model()欲了解更多信息,请参阅 删除端点和资源. 此外,您可以 关闭 SageMaker Studio 资源 不再需要的。

结论

在这篇文章中,我们向您展示了如何在 SageMaker Studio 中开始使用 Upstage 的 Solar 模型并部署模型进行推理。我们还向您展示了如何在 SageMaker Studio JupyterLab 上运行 Python 示例代码。

由于 Solar 模型已经过预训练,因此它们可以帮助降低培训和基础设施成本,并支持生成式 AI 应用程序的定制。

尝试一下 SageMaker JumpStart 控制台 or SageMaker Studio 控制台!您还可以观看以下视频, 使用 Amazon SageMaker 尝试“太阳能”.

本指南仅供参考。您仍应进行自己的独立评估,并采取措施确保您遵守自己的特定质量控制实践和标准,以及适用于您、您的内容的当地规则、法律、法规、许可和使用条款,以及本指南中引用的第三方模型。 AWS 对本指南中引用的第三方模型没有控制权或权力,并且不就第三方模型的安全性、无病毒性、可操作性或与您的生产环境和标准兼容做出任何声明或保证。 AWS 不就本指南中的任何信息将导致特定结果或后果做出任何陈述、保证或保证。

作者简介

云灿 是 AWS 的首席开发人员倡导者,热衷于帮助开发人员在最新的 AWS 服务上构建现代应用程序。他本质上是一位务实的开发人员和博主,并且喜欢社区驱动的学习和技术共享。

云灿 是 AWS 的首席开发人员倡导者,热衷于帮助开发人员在最新的 AWS 服务上构建现代应用程序。他本质上是一位务实的开发人员和博主,并且喜欢社区驱动的学习和技术共享。

李和淑 是 Upstage 的首席技术官 (CTO)。他曾在 Samsung Techwin、NCSOFT 和 Naver 担任 AI 研究员。他正在韩国科学技术院 (KAIST) 攻读计算机和电气工程博士学位。

李和淑 是 Upstage 的首席技术官 (CTO)。他曾在 Samsung Techwin、NCSOFT 和 Naver 担任 AI 研究员。他正在韩国科学技术院 (KAIST) 攻读计算机和电气工程博士学位。

李·布兰登 是 AWS 的高级解决方案架构师,主要帮助公共部门的大型教育技术客户。他拥有 20 多年在跨国公司和大型企业领导应用程序开发的经验。

李·布兰登 是 AWS 的高级解决方案架构师,主要帮助公共部门的大型教育技术客户。他拥有 20 多年在跨国公司和大型企业领导应用程序开发的经验。

- :具有

- :是

- :不是

- :在哪里

- 10

- 120

- 152

- 20

- 20 年

- 2023

- 7

- 990

- a

- 对,能力--

- 关于

- 接受

- ACCESS

- 横过

- 增加

- 另外

- 拿手

- 高级

- 主张

- 协议

- AI

- 算法

- 所有类型

- 允许

- 沿

- 已经

- 还

- Amazon

- 亚马逊SageMaker

- 亚马逊SageMaker JumpStart

- 亚马逊网络服务

- an

- 和

- 和基础设施

- 宣布

- 任何

- 应用领域

- 应用程序开发

- 应用领域

- 使用

- 批准

- 架构

- 保健

- AS

- 评定

- 助理

- At

- 增加

- 权威

- 可使用

- 避免

- AWS

- AWS Marketplace

- 酒吧

- 基于

- BE

- 很

- 阻止

- 博客

- 身体

- 布兰登

- 建立

- 建筑物

- 内建的

- 但是

- by

- 被称为

- CAN

- 能力

- 卡

- 一定

- 收费

- 即时通话

- 便宜

- 首席

- 首席技术官

- 更清晰

- 码

- 沟通

- 社区驱动

- 紧凑

- 公司

- 可比

- 兼容

- 完成

- 执行

- 包含

- 计算

- 一台

- 安慰

- 内容

- 持续

- 控制

- 对话

- 企业

- 成本

- 数

- 创建信息图

- 创建

- 首席技术官

- 合作伙伴

- 定制

- data

- 数据科学

- 十二月

- 默认

- 提供

- 示范

- 部署

- 部署

- 部署

- 部署

- 详情

- 发达

- 开发商

- 开发

- 研发支持

- 直接

- 通过各种方式找到

- 不

- 域名

- 向下

- 教育的

- 只

- 高效

- 升高

- 员工

- enable

- 结束

- 端点

- 工程师

- 英语

- 增强

- 确保

- 保证

- 输入

- 环境

- 环境中

- 例子

- 例子

- 兴奋

- 体验

- 扩展

- 面部彩妆

- 快

- 少

- 数字

- 找到最适合您的地方

- 以下

- 针对

- 基金会

- 框架

- 止

- 充分

- 功能

- 生成的

- 生成式人工智能

- 得到

- 全球

- Go

- 把握

- 担保

- 指导

- 处理

- 有

- he

- 胸襟

- 帮助

- 有帮助

- 帮助

- 帮助

- 此处

- 高性能

- 他的

- 托管

- 创新中心

- How To

- HTML

- HTTPS

- 中心

- if

- 说明

- in

- 包括

- 包含

- 独立

- 信息

- 信息化

- 基础设施

- 初始

- 输入

- 输入

- 例

- 研究所

- 集成

- 互动

- 互动

- 成

- IT

- 它的

- JPG

- JSON

- 韩国

- 韩语

- 着陆

- 语言

- 语言

- 大

- 最新

- 法律

- 排行榜

- 领导

- 学习

- 李

- 执照

- 许可证

- 书单

- 骆驼

- LLM

- 本地

- 不再

- 爱

- 降低

- 机

- 机器学习

- 制成

- 使

- 制作

- 管理

- 管理

- 市场

- 措施

- 合并

- 条未读消息

- 元

- 方法

- 方法

- 指标

- ML

- 时尚

- 模型

- 模型

- 现代

- 更多

- 更高效

- 许多

- 自然

- 自然语言处理

- Naver的

- 旅游导航

- 打印车票

- 没有

- 特别是

- 笔记本

- 现在

- 细微之处

- of

- 提供

- 提供

- 官

- on

- 仅由

- 打开

- 操作

- 优化

- 附加选项

- or

- 其他名称

- 输出

- 成果

- 性能优于

- 超过

- 己

- 页

- 面包

- 参数

- 特别

- 尤其

- 多情

- 演出

- 性能

- 执行

- 博士学位

- 照片

- 巅峰

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 热门

- 帖子

- 强大

- 做法

- 务实

- 精确的

- 准备

- 价格

- 主要

- 校长

- 打印

- 私立

- 市场问题

- 处理

- 产品

- 生产

- 提供

- 提供

- 国家

- 目的

- 蟒蛇

- 质量

- 如

- 很快

- 范围

- 达

- 真实

- 实时的

- 记录

- 引用

- 法规

- 必须

- 需要

- 研究员

- 分辨率

- 资源

- 响应

- 回复

- 导致

- 回报

- 检讨

- 角色

- 定位、竞价/采购和分析/优化数字媒体采购,但算法只不过是解决问题的操作和规则。

- 运行

- 运行

- sagemaker

- SageMaker 推理

- 样品

- Samsung

- 缩放

- 科学

- 科学与技术

- 脚本

- 搜索

- 秒

- 扇形

- 安全

- 看到

- 选择

- 选择

- 前辈

- 服务

- 特色服务

- 集

- 共享

- 应该

- 显示

- 显示

- 显著

- 尺寸

- 小

- 太阳的

- 解决方案

- 一些

- 太空

- 专攻

- 具体的

- 特别是

- 标准

- 开始

- 开始

- 步骤

- 仍

- 存储

- 简单的

- 结构体

- 工作室

- 订阅

- 订阅

- 顺利

- 这样

- SUPPORT

- 支持

- 肯定

- 系统

- 采取

- 需要

- 任务

- 专业技术

- 条款

- test

- 测试

- 比

- 这

- 博曼

- 他们

- 第三方

- Free Introduction

- 通过

- 次

- 时

- 至

- 工具

- 跟踪时

- 培训

- 产品培训

- 二

- 类型

- 使用

- 用过的

- 用户

- 使用

- 运用

- 各个

- 多才多艺

- 版本

- 通过

- 视频

- 查看

- 等待

- 走

- 担保

- 了解

- 波浪

- we

- 卷筒纸

- Web服务

- 基于网络的

- 这

- 宽

- 大范围

- 将

- 中

- 工作

- 年

- 完全

- 您一站式解决方案

- YouTube的

- 和风网