与几乎任何人交谈——也就是说,任何人——你的谈话都会遇到什么 马里赫·阿里哈尼 所谓“健康的摩擦”,是指你在谈话中的目标与伴侣的目标发生冲突的时刻,需要澄清、产生混乱或导致分歧的时刻。

对于大型语言模型则不然。

东北大学 Khoury 计算机科学学院助理教授 Alikhani 表示,像 ChatGPT 这样的大型语言模型在确定性方面存在严重问题。

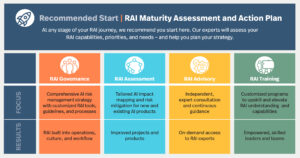

Alikhani 的新项目名为“对话交易中的问责摩擦”(FACT),是东北大学、伊利诺伊大学厄巴纳-香槟分校和南加州大学之间的合作项目。

FACT 项目由国防高级研究项目局的人工智能探索拨款资助,旨在开发更加透明和公平的人工智能工具。

“人类交流成为一种富有成效的工具的原因之一,”阿里哈尼说,“我们在言语和语气中表达了我们的不确定性。我们把它体现在我们的面部表情中。”

她继续说,人与人之间沟通的不确定性所产生的健康摩擦有助于维持意见和观点的多样性。

但大型语言模型(或法学硕士)对表达其不确定性不感兴趣,从而导致了 Alikhani 所说的“阿谀奉承行为”。她说,大型语言模型“希望最大限度地提高用户的满意度”,并且“永远不要在对话中引入任何摩擦,无论[模型]对其陈述是否有信心”。

大型语言模型由于容易产生幻觉而出现其他问题。法学硕士“编造事实。他们非常擅长说服人们相信捏造的事实。”

尽管存在这些问题,阿里哈尼还表示,人类容易过度依赖这些人工智能模型生成的“事实”,这些模型“可能会编造事实来让你开心”。

她说,导致用户过度依赖法学硕士的部分原因是他们的“类人行为”。 “这将操纵我们的认知。”

大型语言模型似乎也会立即产生响应,这是让用户假设正确性的另一个因素。 “我们人工智能科学家很难告诉人们,‘是的,它是连贯的。是的,它很快。是的,它正在适应您的风格。但它会产生幻觉,”阿里哈尼说。

根据他们的新资助,阿里哈尼和她的团队将设计工具来展示法学硕士对其所做声明的确定性水平,并在人类与人工智能的对话中引入健康的摩擦。

“我们如何预测和表达系统的置信度?”阿利哈尼问道。如果人工智能模型“只有 2% 的置信度,它应该将其具体化”。

“这项研究的主要目标之一是对不确定性进行建模,将不确定性具体化”,并教导法学硕士如何在人类与人工智能的对话中描绘这种不确定性。这可能会作为模型确定性的百分位数出现在用户界面中,或者模型可能会以更类似于人类的方式反映其响应的不确定性。

例如,Alikhani 想象了一种情况,患者可能会向大型语言模型询问有关其健康状况的问题。当前一代的法学硕士将尝试提供答案,即使这个答案可能会变得危险。阿利哈尼希望建立的模型可以说:“‘我不知道。你应该打电话给你的护士。”

“稳健性是人工智能问责制的关键,”阿里哈尼说。目前,法学硕士通常会在提问时给出一个答案,几分钟后给出一个完全不同的答案。

在设计既安全又负责任的人工智能时,以前可能有助于完成简单任务的人工智能系统“无法访问大量其他数据集,”阿里哈尼说,“而且他们无法说出可能危险的事情,因为这不在他们的数据中。”

这些数据集包含或排除的内容是克服法学硕士对“性别,但也存在更微妙的偏见,例如[大语言]模型中反映的内群体与外群体以及不同认知偏见”的关键。

现在,阿利卡尼希望设计出为具有“不同承受能力和偏好”的人们提供服务的模型,她说。

“我们不想只是继续为我们拥有数据的人口建立系统,但我们会思考我们把谁抛在了后面,以及我们如何才能阻止这种巨大的不平等差距,而不是让情况变得更糟?”她问。 “我实验室的目标就是朝着这个方向前进。”

- :是

- :不是

- :在哪里

- $UP

- 2%

- a

- 关于

- ACCESS

- 问责制

- 问责

- 高级

- 驳

- 机构

- AI

- 人工智能系统

- 目标

- 几乎

- 还

- an

- 和

- 另一个

- 回答

- 任何

- 任何人

- 出现

- 保健

- 出现

- 人造的

- 人工智能

- AS

- 问

- 问

- 助理

- 承担

- At

- BE

- 因为

- 行为

- 背后

- 之间

- 偏见

- 都

- 建立

- 建筑物

- 束

- 但是

- by

- 加州

- 呼叫

- 被称为

- 呼叫

- CAN

- 肯定

- ChatGPT

- 认识

- 认知

- 相干

- 合作

- 学院

- 购买的订单均

- 相当常见

- 沟通

- 完全

- 一台

- 信心

- 信心

- 混乱

- 继续

- 有助于

- 谈话

- 听起来像对话

- 对话

- 评议会

- 电流

- 危险的

- data

- 数据集

- 国防

- 演示

- 设计

- 设计

- 开发

- 不同

- 方向

- 屏 显:

- 多元化

- do

- 别

- 遭遇

- 公平

- 甚至

- 勘探

- 表达

- 表达

- 面部

- 事实

- 因素

- 正确

- 高效率

- 少数

- 针对

- 摩擦

- 止

- 卓有成效

- 差距

- 产生

- 代

- 目标

- 理想中

- 非常好

- 授予

- 快乐

- 硬

- 有

- 健康管理

- 健康

- 帮助

- 这里

- 持有

- 希望

- 创新中心

- How To

- HTTPS

- 巨大

- 人

- 人类

- if

- 伊利诺伊州

- 想像

- in

- 包括

- 不等式

- 例

- 瞬间

- 代替

- 房源搜索

- 有兴趣

- 接口

- 成

- 介绍

- 问题

- IT

- 它的

- 只是

- 保持

- 键

- 知道

- 实验室

- 语言

- 大

- 后来

- 铅

- 领导团队

- 离开

- 各级

- 谎言

- 喜欢

- LLM

- 制成

- 主要

- 保持

- 使

- 制作

- 制作

- 质量

- 生产力

- 可能

- 分钟

- 模型

- 模型

- 时刻

- 美好瞬间

- 更多

- 移动

- my

- 全新

- 东北大学

- of

- on

- 一

- 意见

- or

- 其他名称

- 我们的

- 输出

- 超过

- 克服

- 病人

- 员工

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 人口

- 预测

- 喜好

- 以前

- 市场问题

- 问题

- 生产

- 教授

- 项目

- 提供

- 放

- 询问

- 题

- 反映

- 反映

- 依托

- 代表

- 要求

- 研究

- 回应

- 回复

- 导致

- 安全

- 对工资盗窃

- 说

- 科学

- 科学家

- 得分了

- 似乎

- 严重

- 服务

- 她

- 应该

- 简易

- 情况

- So

- 南

- 言语

- 个人陈述

- 声明

- Stop 停止

- 样式

- 这样

- 系统

- 产品

- 任务

- 团队

- 科技

- 展示

- 倾向

- 这

- 其

- 博曼

- 他们

- 事

- 认为

- Free Introduction

- 那些

- 通过

- 次

- 至

- TONE

- 工具

- 工具

- 对于

- 向

- 交易

- 透明

- 尝试

- 调音

- 转

- 不确定

- 大学

- us

- 用户

- 用户

- 与

- 非常

- 观点

- 想

- 希望

- 是

- 方法..

- we

- 什么是

- ,尤其是

- 是否

- 这

- WHO

- 将

- 中

- 更坏

- 含

- 完全

- 您一站式解决方案

- 和风网