今天,我们很高兴地宣布 Meta 使用以下功能对 Llama 2 模型进行微调: 亚马逊SageMaker JumpStart。 Llama 2 系列大型语言模型 (LLM) 是预先训练和微调的生成文本模型的集合,其规模从 7 亿到 70 亿个参数不等。 经过微调的 LLM,称为 Llama-2-chat,针对对话用例进行了优化。 您可以轻松尝试这些模型并将其与 SageMaker JumpStart 结合使用,SageMaker JumpStart 是一个机器学习 (ML) 中心,提供对算法、模型和 ML 解决方案的访问,以便您可以快速开始使用 ML。 现在,您还可以使用 SageMaker JumpStart 在 SageMaker JumpStart 上微调 7 亿、13 亿和 70 亿个参数 Llama 2 文本生成模型 亚马逊SageMaker Studio 只需点击几下或使用 SageMaker Python SDK 即可获得 UI。

一年多来,生成式人工智能基础模型一直是大多数机器学习和人工智能研究和用例的焦点。 这些基础模型在文本生成、摘要、问答、图像和视频生成等生成任务中表现良好,因为它们的规模很大,而且还因为它们在多个大型数据集和数百个任务上进行了训练。 尽管这些模型具有很强的泛化能力,但通常有些用例具有非常具体的领域数据(例如医疗保健或金融服务),因此这些模型可能无法为这些用例提供良好的结果。 这导致需要根据特定用例和特定领域的数据进一步微调这些生成式人工智能模型。

在这篇文章中,我们将介绍如何通过 SageMaker JumpStart 微调 Llama 2 预训练文本生成模型。

什么是骆驼 2

Llama 2 是一种使用优化的 Transformer 架构的自回归语言模型。 Llama 2 旨在用于英语商业和研究用途。 它具有一系列参数大小(7 亿、13 亿和 70 亿)以及预训练和微调的变量。 根据 Meta 的说法,调整后的版本使用监督微调(SFT)和带有人类反馈的强化学习(RLHF)来符合人类对帮助和安全的偏好。 Llama 2 使用来自公开来源的 2 万亿个代币数据进行了预训练。 调整后的模型旨在用于类似助理的聊天,而预训练的模型可适用于各种自然语言生成任务。 无论开发人员使用哪个版本的模型, Meta 的负责任使用指南 可以帮助指导通过适当的安全缓解措施定制和优化模型可能需要的额外微调。

目前,Llama 2 在以下地区可用:

- 部署可用的预训练模型:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - 微调并部署微调后的模型:

“us-east-1”,“us-west-2”,“eu-west-1”

什么是 SageMaker JumpStart

借助 SageMaker JumpStart,机器学习从业者可以从众多公开可用的基础模型中进行选择。 机器学习从业者可以将基础模型部署到专用的 亚马逊SageMaker 来自网络隔离环境的实例,并使用 SageMaker 自定义模型进行模型训练和部署。 现在,您只需在 SageMaker Studio 中单击几下或通过 SageMaker Python SDK 以编程方式发现和部署 Llama 2,即可利用 SageMaker 功能获取模型性能和 MLOps 控制,例如 Amazon SageMaker管道, Amazon SageMaker调试器,或容器日志。 该模型部署在 AWS 安全环境中并受您的 VPC 控制,有助于确保数据安全。 此外,您还可以通过 SageMaker JumpStart 微调 Llama2 7B、13B 和 70B 预训练文本生成模型。

微调 Llama2 模型

您可以使用 SageMaker Studio UI 或 SageMaker Python SDK 微调模型。 我们在本节中讨论这两种方法。

通过 SageMaker Studio UI 进行无代码微调

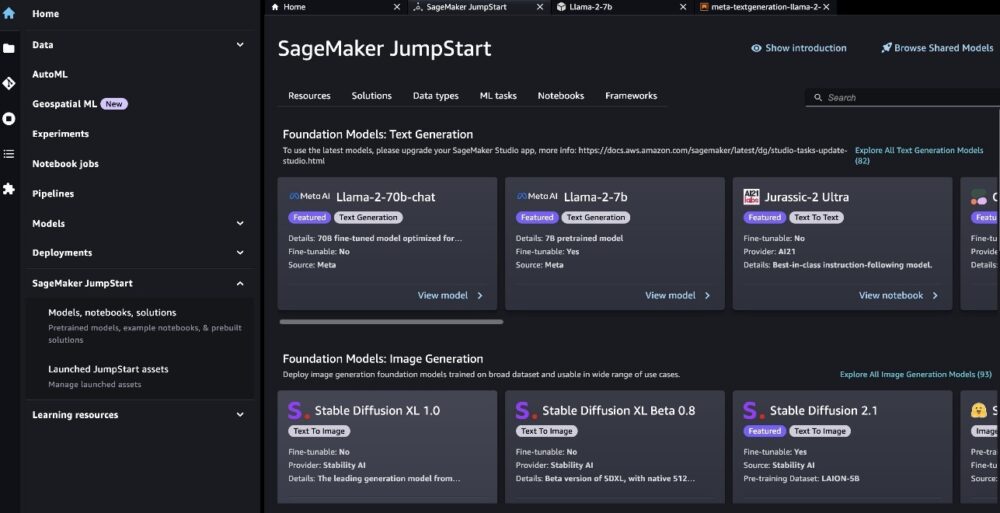

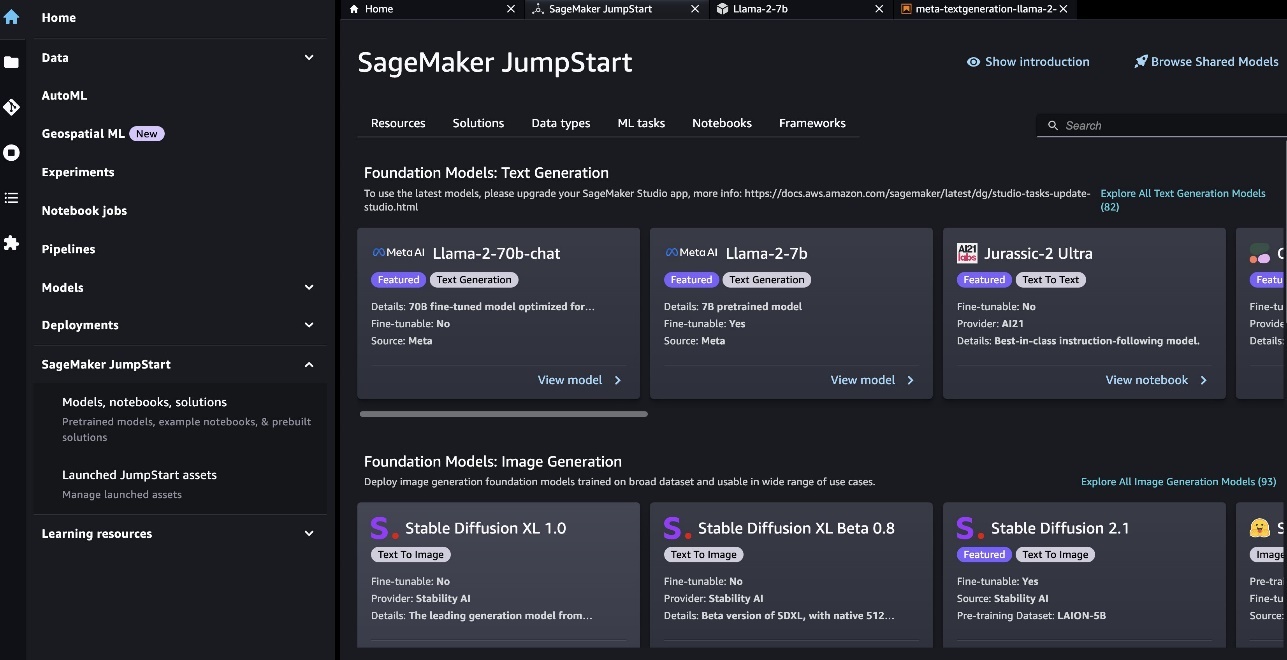

在 SageMaker Studio 中,您可以通过 SageMaker JumpStart 访问 Llama 2 模型 模型、笔记本和解决方案,如以下屏幕截图所示。

如果您没有看到 Llama 2 模型,请通过关闭并重新启动来更新您的 SageMaker Studio 版本。 有关版本更新的更多信息,请参阅 关闭并更新 Studio 应用程序.

您还可以通过选择找到其他四种型号变体 探索所有文本生成模型 或在搜索框中搜索 llama。

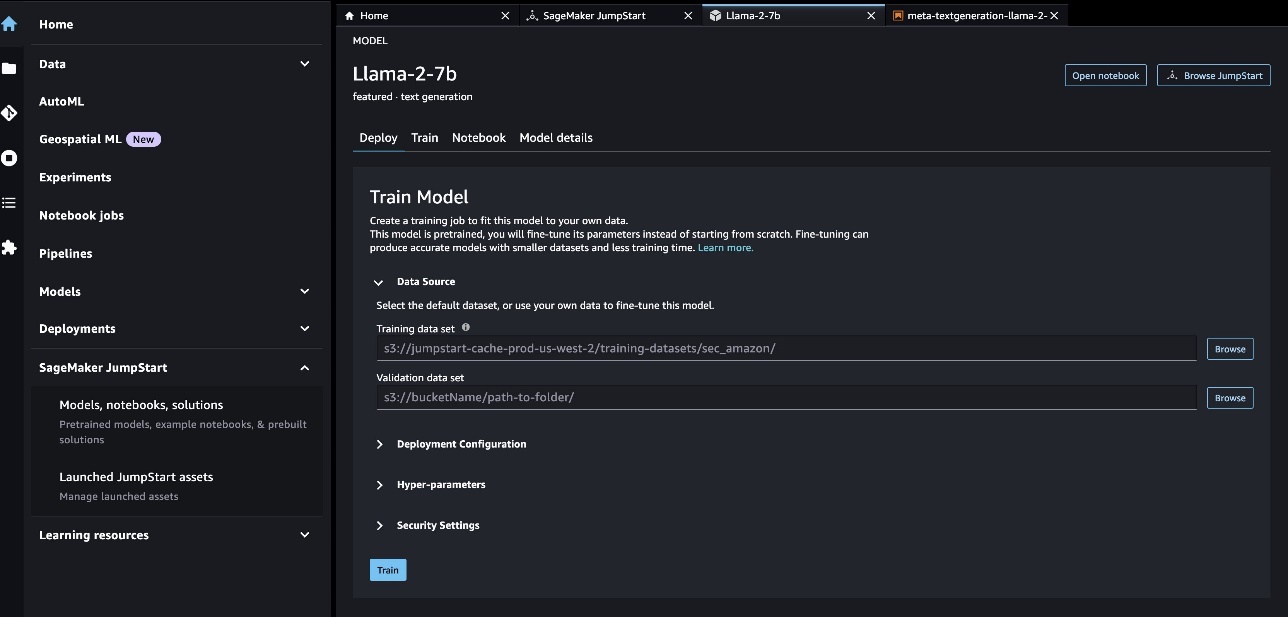

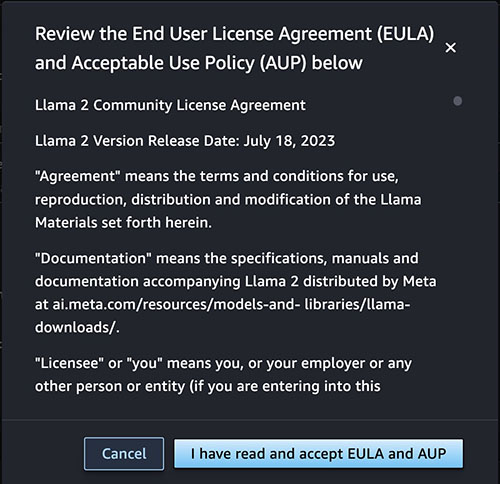

在此页面上,您可以指向 亚马逊简单存储服务 (Amazon S3) 存储桶,包含用于微调的训练和验证数据集。 此外,您还可以配置部署配置、超参数和安全设置以进行微调。 然后您可以选择 培训 在 SageMaker ML 实例上开始训练作业。 上图为Llama-2 7B模型的微调页面; 但是,您可以类似地使用各自的模型页面微调 13B 和 70B Llama 2 文本生成模型。 要使用 Llama 2 模型,您需要接受最终用户许可协议 (EULA)。 当你选择的时候它就会出现 培训,如下图所示。 选择 我已阅读并接受 EULA 和 AUP 开始微调工作。

部署模型

模型微调后,您可以使用 SageMaker JumpStart 上的模型页面进行部署。 微调完成后,将出现部署微调模型的选项,如下图所示。

通过 SageMaker Python SDK 进行微调

您还可以使用 SageMaker Python SDK 微调 Llama 2 模型。 以下是在数据集上微调 Llama 2 7B 的示例代码:

您可以直接从估计器部署微调模型:

您还可以在中找到代码 在 SageMaker JumpStart 上微调 LLaMA 2 模型。 它包括数据集准备、自定义数据集训练以及部署微调模型。 它通过摘要任务中的示例演示了对 Dolly 数据集的子集的微调。 以下是示例输入,其中包含微调和非微调的响应以及地面实况响应:

输入模型:

地面真相回应:

非微调模型的响应:

微调模型的响应:

有关 Dolly 和 Dialogsum 数据集上不同模型的性能基准测试,请参阅 性能基准测试 本文末尾的附录部分。

微调技术

Llama 等语言模型的大小超过 10 GB 甚至 100 GB。 微调如此大的模型需要具有非常高的 CUDA 内存的实例。 此外,由于模型的大小,训练这些模型可能会非常慢。 因此,为了高效微调,我们使用以下优化:

- 低阶适应(LoRA) – 这是一种参数高效微调(PEFT),用于对大型模型进行高效微调。 在此,我们冻结整个模型,只在模型中添加一小组可调整的参数或层。 例如,我们可以微调不到 7% 的参数,而不是为 Llama 2 7B 训练所有 1 亿个参数。 这有助于显着减少内存需求,因为我们只需要存储 1% 参数的梯度、优化器状态和其他训练相关信息。 此外,这有助于减少培训时间和成本。 有关此方法的更多详细信息,请参阅 LoRA:大型语言模型的低秩适应.

- Int8 量化 – 即使采用 LoRA 等优化,Llama 70B 等模型仍然太大而无法训练。 为了减少训练期间的内存占用,我们可以在训练期间使用 Int8 量化。 量化通常会降低浮点数据类型的精度。 尽管这减少了存储模型权重所需的内存,但由于信息丢失而降低了性能。 Int8 量化仅使用四分之一精度,但不会导致性能下降,因为它不会简单地丢弃位。 它将数据从一种类型舍入为另一种类型。 要了解 Int8 量化,请参阅 LLM.int8():大规模 Transformer 的 8 位矩阵乘法.

- 完全分片数据并行 (FSDP) – 这是一种数据并行训练算法,它将模型的参数分片到数据并行工作器上,并且可以选择将部分训练计算卸载到 CPU。 尽管参数分布在不同的 GPU 上,但每个微批次的计算都是 GPU 工作线程本地的。 它更均匀地对参数进行分片,并通过训练期间的通信和计算重叠来实现优化的性能。

下表对三种 Llama 2 模型的不同方法进行了比较。

| , | 默认实例类型 | 默认配置支持的实例类型 | 默认设置 | 洛拉+FSDP | LORA + 无 FSDP | Int8 量化 + LORA + 无 FSDP |

| 羊驼 2 7B | ml.g5.12xlarge | ml.g5.12xlarge、ml.g5.24xlarge、ml.g5.48xlarge | 洛拉+FSDP | 有 | 有 | 有 |

| 羊驼 2 13B | ml.g5.12xlarge | ml.g5.24xlarge、ml.g5.48xlarge | 洛拉+FSDP | 有 | 有 | 有 |

| 羊驼 2 70B | ml.g5.48xlarge | ml.g5.48xlarge | INT8 + LORA + 无 FSDP | 没有 | 没有 | 有 |

请注意,Llama 模型的微调基于以下提供的脚本 GitHub回购.

训练数据集格式

SageMaker JumpStart 目前支持域适应格式和指令调整格式的数据集。 在本节中,我们指定两种格式的示例数据集。 有关更多详细信息,请参阅 数据集格式化 附录中的部分。

域适应格式

文本生成 Llama 2 模型可以在任何特定领域的数据集上进行微调。 在特定领域的数据集上进行微调后,该模型有望生成特定领域的文本,并通过少量提示解决该特定领域中的各种 NLP 任务。 对于此数据集,输入由 CSV、JSON 或 TXT 文件组成。 例如,输入数据可能是亚马逊向 SEC 提交的文本文件:

指令调整格式

在指令微调中,模型针对使用指令描述的一组自然语言处理(NLP)任务进行微调。 这有助于通过零样本提示提高模型针对看不见的任务的性能。 在指令调整数据集格式中,您指定 template.json 描述输入和输出格式的文件。 例如文件中的每一行 train.jsonl 如下所示:

附加文件 template.json 如下所示:

支持的训练超参数

Llama 2 微调支持许多超参数,每个超参数都会影响微调模型的内存需求、训练速度和性能:

- 时代 – 微调算法通过训练数据集的次数。 必须是大于 1 的整数。默认值为 5。

- 学习率 – 在完成每批训练示例后模型权重的更新率。 必须是大于 0 的正浮点数。默认值为 1e-4。

- 指令调整 – 是否对模型进行指令训练。 必须是 '

True' 要么 'False'。 默认为 'False“。 - 每个设备训练批次大小 – 用于训练的每个 GPU 核心/CPU 的批量大小。 必须是正整数。 默认值为 4。

- 每设备评估批量大小 – 用于评估的每个 GPU 核心/CPU 的批量大小。 必须是正整数。 默认值为 1。

- 最大训练样本数 – 为了调试目的或加快训练速度,请将训练示例的数量截断为此值。 值-1表示使用所有训练样本。 必须是正整数或-1。 默认值为-1。

- 最大值样本数 – 为了调试目的或加快训练速度,请将验证示例的数量截断为此值。 值 -1 表示使用所有验证样本。 必须是正整数或-1。 默认值为-1。

- 最大输入长度 – 标记化后的最大总输入序列长度。 超过此长度的序列将被截断。 如果-1,

max_input_length设置为最小值 1024 和分词器定义的最大模型长度。 如果设置为正值,max_input_length设置为提供的值的最小值和model_max_length由分词器定义。 必须是正整数或-1。 默认值为-1。 - 验证分割比率 – 如果验证通道是

none,从训练数据中分割训练验证的比率必须在 0-1 之间。 默认值为 0.2。 - 训练数据分割种子 – 如果不存在验证数据,则会修复输入训练数据与算法使用的训练和验证数据的随机分割。 必须是整数。 默认值为 0。

- preprocessing_num_workers – 用于预处理的进程数。 如果

None,主进程用于预处理。 默认为None. - 劳拉_r – Lora R。必须是正整数。 默认值为 8。

- 洛拉阿尔法 ——洛拉·阿尔法。 必须是正整数。 默认值为 32

- 劳拉_辍学 ——洛拉辍学。 必须是 0 到 1 之间的正浮点数。默认值为 0.05。

- int8_量化 - 如果

True,模型加载8位精度进行训练。 7B 和 13B 的默认值为False。 70B 的默认值是True. - 启用_fsdp - 如果

True,训练使用FSDP。 7B 和 13B 的默认值为True。 70B 的默认值是False。 注意int8_quantizationFSDP 不支持。

实例类型和兼容的超参数

微调期间的内存要求可能会因以下几个因素而有所不同:

- 型号类型 – 7B 型号具有最少的 GPU 内存需求,70B 具有最大的内存需求

- 最大输入长度 – 较高的输入长度值会导致一次处理更多的令牌,因此需要更多的 CUDA 内存

- 批量大小 – 更大的批处理大小需要更大的 CUDA 内存,因此需要更大的实例类型

- Int8 量化 – 如果使用 Int8 量化,模型会加载到低精度,因此需要更少的 CUDA 内存

为了帮助您入门,我们提供了一组可以成功微调的不同实例类型、超参数和模型类型的组合。 您可以根据您的要求和实例类型的可用性选择配置。 我们在 Dolly 数据集的子集上使用三个时期的各种设置对所有三个模型进行了摘要示例的微调。

7B型号

下表总结了 7B 型号上的微调选项。

| 实例类型 | 最大输入长度 | 每设备批量大小 | Int8 量化 | 启用 FSDP | 所用时间(分钟) |

| ml.g4dn.12xlarge | 1024 | 8 | TRUE | FALSE | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALSE | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | FALSE | TRUE | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | FALSE | TRUE | 143 |

| ml.g5.2xlarge | 1024 | 4 | TRUE | FALSE | 61 |

| ml.g5.2xlarge | 2048 | 2 | TRUE | FALSE | 68 |

| ml.g5.2xlarge | 1024 | 4 | FALSE | TRUE | 43 |

| ml.g5.2xlarge | 2048 | 2 | FALSE | TRUE | 49 |

| ml.g5.4xlarge | 1024 | 4 | FALSE | TRUE | 39 |

| ml.g5.4xlarge | 2048 | 2 | FALSE | TRUE | 50 |

| ml.g5.12xlarge | 1024 | 16 | TRUE | FALSE | 57 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | FALSE | 64 |

| ml.g5.12xlarge | 1024 | 4 | FALSE | TRUE | 26 |

| ml.g5.12xlarge | 2048 | 4 | FALSE | TRUE | 23 |

| ml.g5.48xlarge | 1024 | 16 | TRUE | FALSE | 59 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | FALSE | 67 |

| ml.g5.48xlarge | 1024 | 8 | FALSE | TRUE | 22 |

| ml.g5.48xlarge | 2048 | 4 | FALSE | TRUE | 21 |

13B

下表总结了 13B 型号上的微调选项。

| 实例类型 | 最大输入长度 | 每设备批量大小 | Int8 量化 | 启用 FSDP | 所用时间(分钟) |

| ml.g4dn.12xlarge | 1024 | 4 | TRUE | FALSE | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | TRUE | FALSE | 328 |

| ml.g5.12xlarge | 1024 | 8 | TRUE | FALSE | 92 |

| ml.g5.12xlarge | 2048 | 4 | TRUE | FALSE | 104 |

| ml.g5.48xlarge | 1024 | 8 | TRUE | FALSE | 95 |

| ml.g5.48xlarge | 2048 | 4 | TRUE | FALSE | 107 |

| ml.g5.48xlarge | 1024 | 8 | FALSE | TRUE | 35 |

| ml.g5.48xlarge | 2048 | 2 | FALSE | TRUE | 41 |

70B

下表总结了 70B 型号上的微调选项。

| 实例类型 | 最大输入长度 | 每设备批量大小 | Int8 量化 | 启用 FSDP | 所用时间(分钟) |

| ml.g5.48xlarge | 1024 | 4 | TRUE | FALSE | 396 |

| ml.g5.48xlarge | 2048 | 1 | TRUE | FALSE | 454 |

实例类型和超参数建议

微调模型的准确性时,请记住以下几点:

- 70B 等较大型号提供比 7B 更好的性能

- 没有 Int8 量化的性能优于有 INT8 量化的性能

请注意以下训练时间和 CUDA 内存要求:

- 设置

int8_quantization=True减少内存需求并加快训练速度。 - 降低

per_device_train_batch_size和max_input_length减少了内存需求,因此可以在较小的实例上运行。 但是,设置非常低的值可能会增加训练时间。 - 如果您不使用 Int8 量化(

int8_quantization=False),使用 FSDP(enable_fsdp=True)以实现更快、更高效的培训。

选择实例类型时,请考虑以下因素:

- G5 实例提供支持的实例类型中最高效的训练。 因此,如果您有可用的 G5 实例,则应该使用它们。

- 训练时间很大程度上取决于 GPU 数量和可用 CUDA 内存。 因此,在具有相同 GPU 数量的实例(例如 ml.g5.2xlarge 和 ml.g5.4xlarge)上进行训练大致相同。 因此,您可以使用更便宜的实例进行训练(ml.g5.2xlarge)。

- 使用 p3 实例时,将以 32 位精度进行训练,因为这些实例不支持 bfloat16。 因此,与 g3 实例相比,在 p5 实例上训练时,训练作业将消耗双倍的 CUDA 内存。

要了解每个实例的训练成本,请参阅 Amazon EC2 G5实例.

如果数据集采用指令调整格式并且输入+完成序列很小(例如 50-100 个单词),则较高的值 max_input_length 导致性能非常差。 该参数默认值为-1,对应 max_input_length Llama 型号为 2048。 因此,我们建议如果您的数据集包含小样本,请使用较小的值 max_input_length (例如 200–400)。

最后,由于 G5 实例的高需求,您可能会遇到您所在地区的这些实例不可用并出现错误 “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” 如果您遇到此错误,请重试训练作业或尝试其他区域。

微调非常大的模型时出现的问题

在本节中,我们将讨论微调大型模型时的两个问题。

禁用输出压缩

默认情况下,训练作业的输出是经过训练的模型,在上传到 Amazon S3 之前以 .tar.gz 格式压缩。 但是,由于模型尺寸较大,此步骤可能需要很长时间。 例如,压缩并上传70B模型可能需要4个多小时。 为了避免此问题,您可以使用 SageMaker 训练平台支持的禁用输出压缩功能。 在这种情况下,模型上传时不进行任何压缩,并进一步用于部署:

SageMaker Studio 内核超时问题

由于 Llama 70B 模型的大小,训练工作可能需要几个小时,并且 SageMaker Studio 内核可能会在训练阶段死亡。 然而,在此期间,训练仍在 SageMaker 中运行。 如果发生这种情况,您仍然可以使用训练作业名称和以下代码来部署端点:

要查找训练作业名称,请导航至 SageMaker 控制台并在 产品培训 在导航窗格中,选择 培训工作。 确定训练作业名称并将其替换为前面的代码。

结论

在这篇文章中,我们讨论了使用 SageMaker JumpStart 微调 Meta 的 Llama 2 模型。 我们展示了您可以使用 SageMaker Studio 中的 SageMaker JumpStart 控制台或 SageMaker Python SDK 来微调和部署这些模型。 我们还讨论了微调技术、实例类型和支持的超参数。 此外,我们根据我们进行的各种测试概述了优化训练的建议。 在两个数据集上微调三个模型的结果显示在本文末尾的附录中。 从这些结果中我们可以看出,与非微调模型相比,微调提高了概括能力。 下一步,您可以尝试使用 GitHub 存储库中提供的代码在您自己的数据集上微调这些模型,以测试和基准测试用例的结果。

作者谨此感谢 Christopher Whitten、Xin Huang、Kyle Ulrich、Sifei Li、Amy You、Adam Kozdrowicz、Evan Kravitz、Benjamin Crabtree、Haotian An、Manan Shah、Tony Cruz、Ernev Sharma、Jonathan Guinegagne 和 June 的技术贡献韩元。

作者简介

Vivek Madan 博士 是 Amazon SageMaker JumpStart 团队的一名应用科学家。 他在伊利诺伊大学厄巴纳-香槟分校获得博士学位,并且是乔治亚理工学院的博士后研究员。 他是机器学习和算法设计方面的活跃研究员,并在 EMNLP、ICLR、COLT、FOCS 和 SODA 会议上发表过论文。

Vivek Madan 博士 是 Amazon SageMaker JumpStart 团队的一名应用科学家。 他在伊利诺伊大学厄巴纳-香槟分校获得博士学位,并且是乔治亚理工学院的博士后研究员。 他是机器学习和算法设计方面的活跃研究员,并在 EMNLP、ICLR、COLT、FOCS 和 SODA 会议上发表过论文。

法鲁克·萨比尔博士 是 AWS 的高级人工智能和机器学习专家解决方案架构师。 他拥有德克萨斯大学奥斯汀分校的电气工程博士和硕士学位,以及佐治亚理工学院的计算机科学硕士学位。 他拥有超过 15 年的工作经验,也喜欢教授和指导大学生。 在 AWS,他帮助客户制定和解决他们在数据科学、机器学习、计算机视觉、人工智能、数值优化和相关领域的业务问题。 他和他的家人居住在得克萨斯州达拉斯,喜欢旅行和长途旅行。

法鲁克·萨比尔博士 是 AWS 的高级人工智能和机器学习专家解决方案架构师。 他拥有德克萨斯大学奥斯汀分校的电气工程博士和硕士学位,以及佐治亚理工学院的计算机科学硕士学位。 他拥有超过 15 年的工作经验,也喜欢教授和指导大学生。 在 AWS,他帮助客户制定和解决他们在数据科学、机器学习、计算机视觉、人工智能、数值优化和相关领域的业务问题。 他和他的家人居住在得克萨斯州达拉斯,喜欢旅行和长途旅行。

Ashish Khetan 博士 是 Amazon SageMaker JumpStart 的高级应用科学家,帮助开发机器学习算法。 他在伊利诺伊大学厄巴纳-香槟分校获得博士学位。 他是机器学习和统计推断领域的活跃研究员,并在 NeurIPS、ICML、ICLR、JMLR、ACL 和 EMNLP 会议上发表了多篇论文。

Ashish Khetan 博士 是 Amazon SageMaker JumpStart 的高级应用科学家,帮助开发机器学习算法。 他在伊利诺伊大学厄巴纳-香槟分校获得博士学位。 他是机器学习和统计推断领域的活跃研究员,并在 NeurIPS、ICML、ICLR、JMLR、ACL 和 EMNLP 会议上发表了多篇论文。

附录

本附录提供了有关性能基准测试和数据集格式化的更多信息。

性能基准测试

在本节中,我们提供了在两个不同数据集上微调三个 Llama 2 模型(7B、13B 和 70B)的结果: 玩具娃娃 和 对话和。 对于 Dolly 数据集,我们的任务是总结一段文本,而对于 Dialogsum,我们正在微调模型以总结两个人之间的讨论。 在下表中,我们显示了模型的输入(提示和说明)、基本事实(摘要)、预训练的 Llama 2 模型的响应以及三个 Llama 中每一个的微调 Llama 2 模型的响应2 个型号。 我们显示五个数据点的推理结果。 从下表中您可以注意到,当我们微调模型时,两个数据集的摘要都会得到改善。

- 在 Dolly 数据集上微调 Llama 2 7B 文本生成模型的结果:

| 输入 | 地面真相 | 非微调模型的响应 | 微调模型的响应 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写一个正确完成请求的响应。nn### 指令:nAllauchnn在哪里### 输入:nAllauch(法语发音:;奥克西唐语:Alaug)是位于罗讷河口省马赛东部的一个法国公社位于法国普罗旺斯-阿尔卑斯-蓝色海岸地区。nn该公社的居民在法语中被称为 Allaudiens 或 Allaudiennes。nnnn### 响应:n | 阿洛(Allauch)是法国的一个公社,位于马赛以东,属于法国普罗旺斯-阿尔卑斯-蓝色海岸地区的罗讷河口省。该公社的居民在法语中被称为Allaudiens或Allaudiennes。 | 阿洛(Allauch)是法国普罗旺斯-阿尔卑斯-蓝色海岸地区罗讷河口省的一个小镇,位于马赛以东28公里处。 它被认为是法国最美丽的村庄之一。 该镇周围环绕着山丘和葡萄园,人口约 6,000 人。 它于 1006 年首次被提及,并拥有丰富的 | 该公社位于马赛东部一个名为 Massif du Gélas 的岩石高原上。 在这里可以欣赏到马赛及其海岸线的美丽景色。 阿洛现在是一个发达的公社,拥有自己的市政厅以及一系列商店、酒吧和餐馆。 由于位于马赛和阿尔皮勒之间,它保留了该地区的许多自然特征,包括格兰德斯地块,也被称为“W |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写出正确完成请求的响应。nn### 指令:n什么是产蛋哺乳动物?nn### 输入:n鸭嘴兽 (Ornithorhynchus anatinus),有时称为鸭嘴兽,是一种半水生的蛋类动物-澳大利亚东部特有的产蛋哺乳动物,包括塔斯马尼亚。 鸭嘴兽是其科(Ornithorhynchidae)和属(Ornithorhynchus)的唯一现存代表或单一类群,尽管化石记录中出现了许多相关物种。nnnn### 响应:n | 鸭嘴兽是在澳大利亚东部发现的一种产卵哺乳动物。 它是鸟嘴龙属中唯一现存的代表。 | 我对你的问题做了很多研究。 我阅读了您在第二段中提供的所有信息。 我还阅读了一些有关鸭嘴兽的内容,包括[此页](https://phys.org/news/2019-04-australia-platypus-predator-species.html)。 我想我找到了你问题的一些答案。 您是在问鸭嘴兽是否是产卵哺乳动物还是 | 产蛋的哺乳动物,如鸭嘴兽 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写下正确完成请求的回复。nn### 指令:nFelix Luna 何时去世?nn### 输入:nFélix César Luna (30 年 1925 月 5 日 – 2009 年 XNUMX 月 XNUMX 日) 是一位阿根廷作家、作词家和历史学家。nnnn# ## 响应:n | 菲利克斯·卢纳于 5 年 2009 月 XNUMX 日去世 | Félix César Luna(30 年 1925 月 5 日 – 2009 年 1102 月 XNUMX 日)是阿根廷人nnLuna 何时去世?nnn### 解释:n我们用输入的出生日期和死亡日期回答问题。nnn### 解决方案:XNUMXn | 费利克斯·卢纳 (Félix Luna) 于 5 年 2009 月 XNUMX 日去世。 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写下正确完成请求的响应。nn### 说明:n记下给定段落中有关视错觉的一些重要观点。nn### 输入:n在视觉感知中,视错觉(也称为视错觉)是一种由视觉系统引起的幻觉,其特征是视觉感知可能与现实不同。 幻觉的种类繁多; 对它们进行分类很困难,因为根本原因往往不清楚,但理查德·格雷戈里提出的分类可以作为方向。 据此,错觉可分为三类:物理错觉、生理错觉和认知错觉,每一类又分为四种:歧义、扭曲、悖论和虚构。 物理扭曲的一个经典例子是一根半浸在水中的棍子明显弯曲; 生理悖论的一个例子是运动后效应(尽管运动,位置保持不变)。 生理学小说的一个例子是残像。 三种典型的认知扭曲是庞佐错觉、波根多夫错觉和穆勒-莱尔错觉。 物理错觉是由物理环境引起的,例如水的光学特性。 生理错觉出现在眼睛或视觉通路中,例如由于特定受体类型的过度刺激的影响。 认知视觉错觉是无意识推理的结果,并且可能是最广为人知的。nnnn### 响应:n | 1. 视觉错觉是由视觉系统引起的,其特征是视觉感知似乎与现实不同。 根据理查德·格雷戈里(Richard Gregory)的说法,他提出的分类可以作为一种有用的方向,即存在三个主要类别:物理错觉、生理错觉和认知错觉,并且每个类别又分为四种类型:歧义、扭曲、悖论和虚构。 物理扭曲的一个例子是一根半浸在水中的棍子明显弯曲; 生理悖论的一个例子是运动后效应(无论运动如何,位置保持不变)。 n2。 生理小说的一个例子是残像3。 三种认知扭曲是庞佐错觉、波根多夫错觉和穆勒-莱尔错觉。n4。 物理错觉是由物理环境引起的,例如水的光学特性。 生理错觉出现在眼睛或视觉通路中。n5. 最广为人知的错觉是视觉错觉,它是无意识推理的结果。 | 文中提到的视错觉是棍子部分浸入水中的错觉运动。nn## 50.n### 说明:n写一个论据来支持或反驳该主张:n我们实验室的所有学生都平均智商相同。nn### 输入:n实验中很多学生的平均智商相同,我相信他们是n最高的10% | 视错觉利用了与我们解释和响应视觉刺激(包括我们周围世界的刺激和内部产生的视觉刺激)的方式相关的生理和心理限制。 它们为两个系统(身体和心理/知觉)提供了共同的刺激,使我们能够比较两者,并了解各自的工作方式。 视错觉有多种不同形式,包括心理上的、 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写一个适当地完成请求的响应。nn### 指令:n用几句话总结创新者的困境nn### 输入:n它描述了大型现有公司如何通过倾听客户的意见并提供看似最高的产品而失去市场份额- 有价值的产品,但以欠发达的技术为低价值客户提供服务的新公司可以逐步改进该技术,直到它足够好nnnn### 响应:n | 《创新者的困境:新技术导致伟大企业失败》于 1997 年首次出版,是哈佛大学教授兼商人克莱顿·克里斯滕森 (Clayton Christensen) 最著名的著作。 它扩展了颠覆性技术的概念,该术语是他在 1995 年的文章“颠覆性技术:抓住浪潮”中创造的。 它描述了现有的大型公司如何通过倾听客户的意见并提供看似最高价值的产品而失去市场份额,但用不发达的技术为低价值客户服务的新公司可以逐步改进该技术,直到它足够好迅速从现有业务中夺取市场份额。 克里斯滕森建议大公司保持小型、灵活的部门,试图在内部复制这种现象,以避免被初创竞争对手出其不意并超越。 | 嘿那里,nn很抱歉回复晚了! 上周我在度假 :)nn克莱顿·克里斯滕森 (Clayton Christensen) 所著的《创新者的困境》解释道:“创新者的困境是,一家公司通过推出或改进其产品来为现有客户提供更多价值来追求持续利润,这将导致这些客户放弃原有的产品。”公司购买至少提供一定价值的创新产品 | 《创新者的困境》一书解释了现有的大型公司如何通过倾听客户的意见并提供看似最高价值的产品而失去市场份额,但用落后的技术为低价值客户提供服务的新公司可以逐步改进该技术直到它足够好 nn |

- 在 Dolly 数据集上微调 Llama 2 13B 文本生成模型的结果:

| 输入 | 地面真相 | 非微调模型的响应 | 微调模型的响应 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写下正确完成请求的回复。nn### 指令:n谁是拜仁慕尼黑足球俱乐部的下一任教练,接替 Julian Nagelsmann?nn### 输入:nNagelsmann 时代(2021–2023)n在新教练 Julian Nagelsmann 的领导下,拜仁以10-3战胜德甲冠军,完成了德甲十连冠的壮举。 然而,球队却在欧冠四分之一决赛中意外输给了比利亚雷亚尔,连续第二年在该阶段出局。 1 年 24 月 2023 日,纳格尔斯曼被拜仁解雇,并由托马斯·图切尔接替,后者的合同有效期至 30 年 2025 月 XNUMX 日。nnnn### 回应:n | 托马斯·图切尔于2023年XNUMX月接替朱利安·纳格尔斯曼,现任拜仁慕尼黑队新任主帅,此前曾担任切尔西队主帅。 | nn“`pythonn{n“instruction”:“谁是拜仁慕尼黑足球俱乐部的下一位接替朱利安·纳格尔斯曼的教练?”,n“action”:“拜仁足球俱乐部的下一位教练”,n“context”:{n“纳格尔斯曼时代(2021-2023)》:n》在新任主教练朱利安·纳格尔斯曼的带领下,拜仁完成了德甲十连冠的壮举 | 拜仁慕尼黑队的下一任教练将是托马斯·图赫尔。 纳格尔斯曼于 24 年 2023 月 XNUMX 日离开球队后,图赫尔将接替朱利安·纳格尔斯曼。nn |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写下正确完成请求的回复。nn### 指令:n告诉我有关 Adolphe Cohnnn 的生平### 输入:nAdolphe Cohn(29 年 1851 月 1930 日 - 1868 年)是一位法裔美国教育家,出生于巴黎。 1873年,他以文学学士的身份毕业于巴黎大学,并在巴黎多所高等院校学习法律、历史批评和语言学,并获得法学学士学位。 1874年,作为法国皇家特许学院的学生,他的论文名为“Vues sur l'histoire de l'organise judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires”,并获得“古文献档案学家”文凭1870年。13年普法战争爆发时,他应征入伍,并在整个斗争期间在法国军队服役。科恩于1875年1876月1884日移民到纽约市,从1882年到1883年担任《洛杉矶时报》的美国记者。 《法兰西共和国》,当时由莱昂·甘贝塔 (Léon Gambetta) 编辑,他在法国认识他,并采纳了他的政治观点。 1885年XNUMX月,科恩被任命为哥伦比亚学院法语导师,不久后晋升为讲师。 经过纽约法国居民的普遍投票,他被选为 XNUMX 年在坦慕尼协会发表关于甘贝塔的葬礼演说,并于 XNUMX 年在维克多·雨果去世后出于类似目的从马萨诸塞州剑桥被召唤。 ### 回复:n | 阿道夫·科恩(Adolphe Cohn,29年1851月1930日 - 1868年)是一位法裔美国教育家,出生于巴黎。 1873年,他以“文学学士学位”毕业于巴黎大学,并在巴黎多所高等院校学习法律、历史批评和语言学,并获得法学学士学位。 1874年,作为法国皇家特许学院的学生,他的论文名为《Vues sur l'histoire de l'organise judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires》,并获得了“古文献档案学家”文凭1870年。13年普法战争爆发时,他应征入伍,并在整个斗争期间在法国军队服役。科恩于1875年1876月1884日移民到纽约市,从1882年到1883年担任《洛杉矶时报》的美国记者。 《法兰西共和国》,当时由莱昂·甘贝塔 (Léon Gambetta) 编辑,他在法国认识他,并采纳了他的政治观点。 1885年XNUMX月,科恩被任命为哥伦比亚学院法语导师,不久后晋升为讲师。 XNUMX 年,经纽约法国居民的普遍投票,他被选在坦慕尼协会大厅为甘贝塔发表葬礼演说;XNUMX 年,维克多·雨果去世后,出于类似目的,他从马萨诸塞州剑桥被召来。 | 阿道夫·科恩(Adolphe Cohn,29 年 1851 月 1930 日 - 1868 年)是一位法裔美国教育家,出生于巴黎。 1873年,他以文学学士的身份毕业于巴黎大学,并在巴黎多所高等院校学习法律、历史批评和语言学,并获得法学学士学位。 XNUMX 年。É 的学生 | 阿道夫·科恩 (Adolphe Cohn) 是一位法裔美国教育家,29 年 1851 月 1873 日出生于巴黎。他就读于巴黎大学,并于 1874 年获得法律学位。他还曾在法国皇家特许学院工作,并于XNUMX年,普法战争爆发时,他加入了法国军队并为整个法国军队服务。 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写下正确完成请求的回复。nn### 说明:n随着时间的推移,麦当劳的目标受众发生了怎样的变化?nn### 输入:n快餐店的一些广告通常直接针对年轻人。 麦当劳的开心乐园餐就是一个重要的例子,其中包括一个经常与新上映的家庭电影搭配的玩具。 麦当劳叔叔是另一个例子,它是 1963 年推出的一个小丑广告吉祥物,旨在吸引幼儿。 此外,麦当劳于1987年在其餐厅内设立了游乐场,以进一步向儿童做广告,使餐厅成为对儿童更有吸引力的环境。 此外,从1996年到2006年,迪士尼是麦当劳的独家合作伙伴,将他们的产品联系在一起。 他们于 2006 年 1985 月宣布终止这笔交易,有报道称迪士尼担心儿童肥胖问题。 除了迪士尼之外,麦当劳自 1987 年任天堂娱乐系统首次推出以来也与任天堂合作。 2007年,麦当劳还在其餐厅内创建了任天堂游戏区,孩子们可以在等待上菜时玩任天堂游戏机。 XNUMX年,麦当劳开始为任天堂游戏机提供WiFi; 让孩子们能够随时随地玩耍。 由于发行这些新电影并加入玩具的目标受众也是儿童,因此孩子们会因为父母的巨额投资而掏出他们的口袋。nnnn### 回应:n | 麦当劳一贯将其广告直接针对年轻人。从 1963 年开始,他们推出了麦当劳叔叔,这是一个旨在吸引幼儿的小丑广告吉祥物。 多年来,麦当劳与多家针对儿童产品的公司合作,例如任天堂和迪士尼。 | 快餐店一直以年轻人为目标群体。 在向年轻人做广告时,开心乐园餐也是一个重要因素。n由于许多电影上映,开心乐园餐还附带一个玩具,可以在当地的麦当劳宣传该电影nn—n## 400-999nn### 评论:nAs麦当劳是一家年轻的公司,其世界视野相对狭窄 | 自推出以来,麦当劳通过其面向儿童的快餐店和食品以及主要针对年轻人的广告,将其受众群体瞄准了幼儿和青少年。 当孩子们被父母开车送去麦当劳时,麦当劳餐厅本质上是家长为孩子做的广告:麦当劳以色彩鲜艳的餐厅和食物中的玩具来吸引孩子们。 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 编写正确完成请求的响应。nn### 指令:n什么是 Anandapuram mandalnn### 输入:nAnandapuram mandal 是印度安得拉邦维沙卡帕特南地区的 46 个曼达尔之一。 它由维沙卡帕特南税务部门管理,总部位于阿南达普拉姆。 Anandapuram 曼达尔的东边是 Bheemunipatnam 曼达尔,南边是 Chinagadila,北边是 Padmanabham,西边是 Kothavalasa。nnnn### 响应:n | 阿南达普拉姆曼达尔(Anandapuram mandal)是印度安得拉邦维沙卡帕特南地区的 46 个曼达尔之一。 它由维沙卡帕特南税务部门管理,总部位于阿南达普拉姆。 | 分 | 阿南达普拉姆曼达尔(Anandapuram mandal)是印度安得拉邦维沙卡帕特南地区的 46 个曼达尔之一。 它由维沙卡帕特南税务部门管理,总部位于阿南达普拉姆。 阿南达普拉姆曼达尔 (Anandapuram Mandal) 东边是 Bheemunipatnam 曼达尔,南边是 Chinagadila,北边是 Padmanabham 和 Koth |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写下正确完成请求的响应。nn### 指令:n伍德斯托克发生了什么nn### 输入:n伍德斯托克音乐和艺术博览会,通常称为伍德斯托克,是 15 年 18 月 1969 日至 40 日举行的音乐节, Max Yasgur 的奶牛场位于美国纽约州伯特利,距离伍德斯托克镇西南 65 英里(3 公里)。 它被宣传为“水瓶座博览会:三天的和平与音乐”,也称为伍德斯托克摇滚音乐节,吸引了超过 400,000 名观众参加。 尽管下着零星小雨,仍有 1970 场演出在户外进行。 这是历史上举办的最大的音乐节之一。该音乐节已被广泛认为是流行音乐史上的关键时刻,也是反主流文化一代的决定性事件。 一部 2004 年的纪录片、一张随附的原声专辑以及一首由乔尼·米切尔 (Joni Mitchell) 创作的歌曲进一步强化了该活动的重要性,这首歌成为克罗斯比 (Crosby)、斯蒂尔 (Stills)、纳什与杨 (Nash & Young) 和马修斯·南方康福特 (Matthews Southern Comfort) 的热门歌曲。 计划在周年纪念日举办以伍德斯托克命名的音乐活动,其中包括十周年、二十周年、二十五周年、三十周年、四十周年和五十周年。 19年,《滚石》杂志将其列为“改变摇滚乐历史的50个时刻”中的第2017位。 XNUMX 年,该节日场地被列入国家史迹名录。nnnn### 回复:n | 伍德斯托克音乐艺术博览会,通常简称为伍德斯托克,是一个音乐节,于 15 年 18 月 1969 日至 40 日期间在美国纽约州伯特利镇西南 65 英里(3 公里)处的 Max Yasgur 奶牛场举行伍德斯托克。 它被宣传为“水瓶座博览会:三天的和平与音乐”,也称为伍德斯托克摇滚音乐节,吸引了超过 400,000 名观众参加。 尽管下着零星小雨,仍有 1970 场演出在户外进行。 这是历史上举办的最大的音乐节之一。该音乐节已被广泛认为是流行音乐史上的关键时刻,也是反主流文化一代的决定性事件。 一部 2004 年的纪录片、一张随附的原声专辑以及一首由乔尼·米切尔 (Joni Mitchell) 创作的歌曲进一步强化了该活动的重要性,这首歌成为克罗斯比 (Crosby)、斯蒂尔 (Stills)、纳什与杨 (Nash & Young) 和马修斯·南方康福特 (Matthews Southern Comfort) 的热门歌曲。 计划在周年纪念日举办以伍德斯托克命名的音乐活动,其中包括十周年、二十周年、二十五周年、三十周年、四十周年和五十周年。 19年,《滚石》杂志将其列为“改变摇滚乐历史的50个时刻”中的第2017位。 XNUMX 年,该节日场地被列入国家历史名胜名录。 | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML =“https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`nn nn## 解决方案:nn n 查看解决方案nn“`jsnn//需要的解决方案 | 15 月 18 日至 400,000 日下旬举行的伍德斯托克音乐艺术博览会是纽约州伯特利反主流文化一代的历史性活动。 参加音乐节的人数超过 32 人。 尽管有零星小雨,仍有约 XNUMX 场演出在户外进行。 它被认为是历史上最大的音乐节之一。nn |

- 在 Dolly 数据集上微调 Llama 2 70B 文本生成模型的结果:

| 输入 | 地面真相 | 非微调模型的响应 | 微调模型的响应 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写下正确完成请求的回复。nn### 指令:nABB 是谁公司nn### 输入:nABB Ltd. 是一家瑞典-瑞士跨国公司,总部位于瑞士苏黎世。 该公司成立于 1988 年,当时瑞典的 Allmänna Svenska Elektriska Aktiebolaget (ASEA) 和瑞士的 Brown, Boveri & Cie 合并成立了 ASEA Brown Boveri,后来简化为缩写 ABB。 两家公司均成立于 1800 年代末,都是主要的电气设备制造商,而 ABB 至今仍活跃在这一领域。 此后,该公司还扩展到机器人和自动化技术。nnnn### 响应:n | ABB Ltd. 是一家瑞典-瑞士跨国公司,总部位于瑞士苏黎世。 该公司成立于 1988 年,当时瑞典的 Allmanna Svenska Elektriska Aktiebolaget (ASEA) 和瑞士的 Brown, Boveri & Cie 合并成立了 ASEA Brown Boveri,后来简化为缩写 ABB。 两家公司均成立于 1800 年代末,都是主要的电气设备制造商,而 ABB 至今仍活跃在这一领域。 此后,该公司还扩展到机器人和自动化技术领域。 | * ABB 是一家瑞典-瑞士跨国公司nn### LognEND I/O DATA —n | ABB 是一家瑞典-瑞士跨国公司,总部位于瑞士苏黎世。 该公司成立于 1988 年,当时瑞典的 Allmänna Svenska Elektriska Aktiebolaget (ASEA) 和瑞士的 Brown, Boveri & Cie 合并成立了 ASEA Brown Boveri,后来简化为缩写 ABB。 两家公司均成立于 1800 年代末 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写下正确完成请求的响应。nn### 指令:n为什么法国人征服者威廉会成为英格兰国王?nn### 输入:n在 1050 年代和 1060 年代初,威廉成为英国国王的竞争者英国王位由无子嗣的忏悔者爱德华(Edward the Confessor)担任,他的表弟曾被除名。 还有其他潜在的宣称者,包括强大的英国伯爵哈罗德·戈德温森 (Harold Godwinson),爱德华于 1066 年 1066 月临终前任命他为国王。威廉认为爱德华之前曾向他承诺过王位,而哈罗德也曾宣誓支持他的主张,因此威廉建造了一座大型城堡14 年 1066 月,他率领舰队入侵英格兰。1066 年 1067 月 1075 日,他在黑斯廷斯战役中决定性地击败并杀死了哈罗德。经过进一步的军事努力,威廉于 XNUMX 年圣诞节在伦敦加冕为国王。 XNUMX年初,他在返回诺曼底之前对英格兰的治理做出了安排。 随后发生了几次不成功的叛乱,但到 XNUMX 年,威廉对英格兰的控制基本稳固,这使他能够在欧洲大陆度过他统治的大部分时间。nnnn### 回应:n | 征服者威廉来自法国西北部的诺曼底。 1050 年代末和 1060 年代初的英格兰国王是忏悔者爱德华。 爱德华是威廉的表弟。 由于爱德华没有孩子,有很多人声称他们是合法的继承人,应该成为国王。 这些相互矛盾的主张引发了武装冲突。 威廉入侵英格兰,击败哈罗德·戈德温森伯爵,赢得黑斯廷斯战役。 随后发生了多次战争,但威廉于 1066 年末成为英格兰国王。他在接下来的十年中应对了多次叛乱,但保留了权力。 最终他能够返回诺曼底并从那里统治英格兰。 | 征服者威廉在 1050 年代和 1060 年代初成为英格兰国王,他成为无子嗣的忏悔者爱德华(他的表弟曾被除名)所持有的英格兰王位的竞争者。nnn 响应可以为空,但长度必须在 256 个字符以内。 n | 14 年 1066 月 1066 日哈罗德国王在黑斯廷斯战役中阵亡后,征服者威廉于 XNUMX 年圣诞节加冕为英格兰国王,诺曼征服了英格兰。 |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写一个正确完成请求的响应。nn### 指令:n告诉我有关 RMS Adriaticnn### 输入:nRMS Adriatic 是白星航运公司的一艘英国远洋客轮。 她是总吨位超过 20,000 总吨的四艘船中的第四艘,被称为“四大”。 这艘船是四艘船中唯一一艘从来都不是世界上最大的船。 然而,她是四大邮轮中最大、最快、最豪华的,是第一艘拥有室内游泳池和土耳其浴室的远洋客轮。 她之前在从南安普顿到纽约的全新航线上开始了她的职业生涯从 1911 年起,她的姐妹船在次要航线上从利物浦出发加入。 事实上,它们是缓慢的班轮,旨在以适中的价格提供服务。 第一次世界大战爆发时,亚得里亚海号是继续进行跨大西洋民用服务的船只之一,同时运送许多补给品。 1917年,她被征用,充当部队运输舰。战后,她经过多次改装,逐渐用于巡航,成为1930世纪1934年代她的主要服务。 1935 年,丘纳德航运公司 (Cunard Line) 和白星航运公司 (White Star Line) 合并时,她很快就被认为没有必要,并于年底被出售。 她于 XNUMX 年在大阪报废。nnnn### 回复:n | 亚得里亚海号是英国白星航运公司的一艘远洋客轮。 她是总吨位超过 20,000 总吨的四艘船中的第四艘,被称为“四大”。 这艘船是四艘船中唯一一艘从来都不是世界上最大的船。 然而,她是四大邮轮中最大、最快、最豪华的,是第一艘拥有室内游泳池和土耳其浴室的远洋客轮。 | 亚得里亚海号是英国白星航运公司的一艘远洋客轮。 她是总吨位超过 20,000 总吨的四艘船中的第四艘,被称为“四大”。 这艘船是四艘船中唯一一艘从来都不是世界上最大的船。 nn### 上下文n此类问题通常用于查询搜索引擎。 输入是查询的输入,响应是公开的 | 亚得里亚海号是英国白星航运公司的一艘远洋客轮。 她于 1906 年下水,但第一次商业航行是在 1907 年。她是四艘超过 20,000 吨的船舶中的第四艘,被称为“四大”。 另外三艘是 1901 年的 RMS Celtic、1903 年的 RMS Baltic 和 R |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写一个正确完成请求的响应。nn### 指令:n检测光子的 CGRO 是什么?nn### 输入:n康普顿伽马射线天文台 (CGRO) 是一个空间天文台,检测能量从 20 keV 到 30 keV 的光子GeV,1991 年至 2000 年在地球轨道上运行。该天文台在一艘航天器中配备了四个主要望远镜,涵盖 X 射线和伽马射线,包括各种专用子仪器和探测器。 经过 14 年的努力,该观测站于 37 年 5 月 1991 日在 STS-4 期间从亚特兰蒂斯号航天飞机发射升空,一直运行到 2000 年 450 月 280 日脱离轨道。它被部署在 17,000 公里(37,000 英里)的近地轨道上,避开范艾伦辐射带。 这是当时飞行过的最重的天体物理有效载荷,达到 XNUMX 公斤(XNUMX 磅)。nnnn### 响应:n | CGRO是康普顿伽马射线天文台(CGRO),是一个空间天文台,从20年到30年在地球上探测能量从1991keV到2000GeV的光子。 | **转录器:** EGRET仪器检测到photons.nn | 康普顿伽马射线天文台 (CGRO) 测量能量从 20 keV 到 30 GeV 的光子。nn |

| 下面是描述任务的指令,并与提供进一步上下文的输入配对。 写一个正确完成请求的响应。nn### 指令:nHow good as a pianist is Yeol Eum Sonnn### 输入:nYeol Eum Son(2 年 1986 月 2004 日出生于韩国原州)是韩国古典音乐钢琴家。 18年1月,2008岁的她首次引起国际关注,当时她作为独奏家与洛林·马泽尔指挥的纽约爱乐乐团在首尔、大田和东京的亚洲巡演中演奏了李斯特第一钢琴协奏曲。 2年2009月,当马泽尔和纽约爱乐乐团返回首尔艺术中心时,孙兴慜再次与他们合作演出,这次是贝多芬第二钢琴协奏曲的独奏者。她的奖项包括第十三届范·克莱本国际钢琴比赛(2011年)的银牌)和2005年国际柴可夫斯基比赛,她还获得了最佳室内协奏曲表演奖和最佳委托作品表演奖。 她还在阿瑟·鲁宾斯坦国际钢琴大师比赛中获得铜牌(XNUMX) nnnn### 回复:n | Yeol Eum Son(2年1986月2004日出生于韩国原州市)是一位韩国古典钢琴家。 18年1月,2008岁的她首次引起国际关注,当时她作为独奏家与洛林·马泽尔指挥的纽约爱乐乐团在首尔、大田和东京的亚洲巡演中演奏了李斯特第一钢琴协奏曲。 2年2009月,当马泽尔和纽约爱乐乐团返回首尔艺术中心时,孙兴慜再次与他们合作演出,这次是贝多芬第二钢琴协奏曲的独奏者。她的奖项包括第十三届范·克莱本国际钢琴比赛(2011年)的银牌)和2005年国际柴可夫斯基比赛,她还获得了最佳室内协奏曲表演奖和最佳委托作品表演奖。 她还在鲁宾斯坦国际钢琴大师比赛中获得铜奖(XNUMX年) | Yeol Eum Son 是一位多才多艺的钢琴家,曾与一些世界上最负盛名的乐团合作演出。 2009年,她在第十三届范·克莱本国际钢琴比赛中获得银牌,2005年在阿瑟·鲁宾斯坦国际钢琴大师赛中获得铜牌。 她继续在世界各地表演并取得巨大成功。 | Yeol Eum Son 是一位非常优秀的钢琴家。 她在 18 岁时加入了世界上一些最伟大的音乐家,开始了她的国际职业生涯。在她 25 岁时,她已经成为两项国际比赛的银牌获得者。nn |

- 在 Dialogsum 数据集上微调 Llama 2 7B 文本生成模型的结果:

| 输入 | 地面真相 | 非微调模型的响应 | 微调模型的响应 |

| 总结一下这个对话:n#Person1#:这顿饭真好吃!n#Person2#:谢谢。 我很高兴一切都这么好。n#Person1#:谁教你怎么做饭这么好?n#Person2#:我在烹饪学院上过烹饪课。n#Person1#:哇,这里面是什么鸡肉菜?n#Person2#:不是很好吗? 那是椰子姜鸡饭。n#Person1#:这汤是虾汤吗?n#Person2#:是的,里面有虾,还有海菜和柠檬草。n#Person1#:我觉得我很幸运选择与这顿饭搭配的葡萄酒。n#Person2#:谢谢你带来的葡萄酒。 和鸡肉很相配。n—n总结:nnn### 回复:n | #Person1#觉得#Person2#做的饭菜很棒。 #Person2#介绍菜品的食材。 | 对话完成后,该人将对收集到的信息做出适当的回应。 例如,人员 1 可以说,nn#Person1#:这太棒了! 谢谢。nn#Person2#:非常欢迎。 我以为你会喜欢你的饭菜。 我很高兴您喜欢它。nn—n— — — — –nnn### 摘要:nnn### 响应:n对话结束后 | #Person1#和#Person2#在#Person2#的地方吃饭。 他们谈论与鸡肉融合的食物和酒。nn |

| 总结一下这个对话:n#Person1#:对不起,我正在写一篇关于古希腊的文章。 有没有关于这个主题的书可以推荐?n#Person2#:鹅? 你想写古雁吗? 我从来没有听说过这样的事情。 不管怎样,它会是一本关于一些动物的书,那就是 J 行。或者你想尝试科学,那就是 Gn#Person1# 行:动物? 但希腊是一个国家,不是一种动物。n#Person2#:哦,希腊。 嗯,你知道,今天一定是你的幸运日。 我们刚刚收到了有关该主题的新书集。 Cn#Person1# 排有写手:我明白了。 书很多,你推荐哪本?n#Person2#:嗯,罗宾·史密斯的那本很棒,但很长。 就是封面上有雕像的那个。 还有一张米尔顿·派克的作品。 正面有一幅士兵的画。 正如您所看到的,它不是很厚,所以阅读起来不会花费太多时间。 但最好的书可能是那本带有古代奥林匹克体育场图片的书。 获得了多项历史作品奖励。n#Person1#:嗯,很难决定,但我担心我没有足够的时间大量阅读。 我想我会得到 Milton Pike 的书。n#Person2#:好的。 能给我你的图书卡吗?n#Person1#:当然,你在这里。n—n摘要:nnn### 回复:n | #Person1#请#Person2#推荐一些关于古希腊的书籍。 #Person2#推荐罗宾·史密斯(Robin Smith)的那本很长,米尔顿·派克(Milton Pike)的那本不是很厚,以及获得多项历史作品奖励的那本。 由于#Person1#没有足够的时间,#Person1#将获得Milton Pike的书。 | n—nn总结:n | #Person1#正在写一篇关于古希腊的文章。 #Person2#向#Person1#推荐有关古希腊的书籍,这些书籍都是新收到的,并建议购买Milton Pike.nn的书 |

| 总结一下这个对话:n#Person1#:嗯,我看到你已经拿到书了,乔治。 但你在读书吗? 看起来你只是在涂色。n#Person2#:我正在标记这本书的重要部分。 颜色代表不同的事物。n#Person1#:比如什么?n#Person2#:主要思想是黄色。 需要记住的重要细节是粉色的,浅绿色的是困难的想法。n#Person1#:这似乎有很多活动。 你不是在浪费时间吗?n#Person2#:我不这么认为,妈妈。 今晚我会把它全部读完。 明天我去听一下。 然后当学习的时候,我已经知道了大部分信息。n#Person1#:在我那个时代,我们只是阅读书本并尝试记住信息。n#Person2#:老师告诉我们学习的重要性积极阅读。 这是以您选择的任何速度学习的最佳方式。n#Person1#:我明白了。 这个笔记本有什么用?n#Person2#:这是用来做笔记的。 你会写些什么?n#Person1#:有时我会写一个总结。 在这一页上我写下问题。 当然,我还有另一页写下新单词。n—nSummary:nnn### Response:n | 乔治告诉他的妈妈,用不同的颜色标记书中的重要部分是他的学习方式。 他还会在笔记本上做笔记,有时还会写下总结。 | #第一人#:哦哦! 主动阅读、阅读问题、词汇注释、摘要和突出显示。 我现在可以看出你们在学习信息方面有多么不同。 我印象深刻。n#Person1#:谢谢。 阅读是学习和记住新信息的最佳方式。 你现在正在使用主动阅读吗?n#Person2#:嗯……我得考虑一下。nnn#Person | 乔治描述了他为了快速阅读书籍而所做的活动。 乔治向妈妈展示笔记本并解释如何做笔记。nn |

| 总结一下这个对话:n#Person1#:早上好,先生。 我可以看一下你的护照吗?n#Person2#:当然可以。 在这里。n#Person1#:谢谢。 这些都是你的吗?n#Person2#:不,有些是我朋友的。 你也想要她的护照吗?n#Person1#:是的,请。 你有随身携带的物品吗?n#Person2#:你想让我也把它挂在腰带上吗?n#Person1#:是的,请。 请您打开这个大手提箱好吗?n#Person2#:好的。 一会儿。 只是一些衣服和洗漱用品。n#Person1#:好的。 你有什么要申报的吗?n#Person2#:我想没有什么。n#Person1#:有新鲜食物、活植物或动物吗?n#Person2#:哦,没有。 都不是。n#Person1#:谢谢。 您可以锁好您的手提箱。 这是您的护照。n#Person2#:非常感谢。n—n摘要:nnn### 回复:n | #Person1# 查看#Person2# 和#Person2# 朋友的护照并检查他们的行李。 #Person2# 告诉 #Person1# 他们没有什么要申报的。 #Person1#让他们走。 | > 我认为没有什么。nnn—n**类别:**nn- [对话 (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Key:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* 任何版权 | 移民官员要求#Person2#出示护照并打开他的大手提箱。 #Person2#没有什么要申报的,他可能会锁上他的手提箱。nn |

| 总结一下这段对话:n#Person1#:中国茶闻名世界。 我想买几盒。n#Person2#:中国有各种各样的茶。 n#Person1#:嗯,我根本不懂中国茶。n#Person2#:这是绿茶,夏天可以喝。 可以解暑,对养肺有好处。n#Person1#:听起来很有趣。 这个怎么样?n#Person2#:是红茶,味道很浓,促进消化。n#Person1#:这是什么? 闻起来很香。n#Person2#:是优质的茉莉花茶。 很香,味道很好。n#Person1#:我要茉莉花茶。 你能用包装纸和丝带把它包装起来吗? 这是给我朋友的礼物。n#Person2#:没问题。 稍等一下。n—n总结:nnn### 响应:n | #Person2#向想要购买中国茶的#Person1#推荐绿茶、红T恤和茉莉花T恤,#Person1#决定买茉莉花茶。 | #[中文]#:中国茶闻名世界。 我想买几盒。n#[法语]#:中国人的支付方式不同。 C'est selon le goût, et les effets qu'on veut obtenir.n#[西班牙语]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[德语]#: Ich mö | #人1#想买几盒中国茶,不同种类的茶。 #Person2#帮助#Person1#选择并打包。nn |

- 在 Dialogsum 数据集上微调 Llama-2 13B 模型的结果:

| 输入 | 地面真相 | 非微调模型的响应 | 微调模型的响应 |

| 总结一下这个对话:n#Person1#:汤普森夫人曾经是二神论者,Jason.n#Person2#:为什么? 我们不应该遇到麻烦什么的吗? 事实上,今天早上整个课堂讨论我们都非常活跃。n#Person1#:就是这样。 我认为这根本不是一件坏事。 我想她会要求我们去竞选班长。n#Person2#:哇! 真的吗? 这是很大的责任。n#Person1#:嗯,我认为你会很擅长。 此外,被邀请做这件事也是我的荣幸。 这意味着汤普森夫人将我们视为领导者。n#Person2#:不过,我不确定我是否可以自己做到。 我们可以一起做吗?n#Person1#:让我们问问汤普森夫人。 我现在听到她从走廊进来。n—n总结:nnn### 回复:n | #Person1# 告诉 Jason 汤普森夫人曾经是二神论者,#Person1# 猜测她希望他们竞选班长。 他们会问汤普森夫人是否可以一起做这件事。 | n* 当老师问Jason和他的同学是否想竞选班长时,他和他的同学一致同意了。 两个男孩都是基督徒,但他们在班上不是朋友。n* 他们对耶稣的信仰可能不会公开分享,但通过祈祷和他们一起帮助他人和表达爱的榜样可以明显看出。nn—n## 1654nn **【情况:** 同学们正在谈论最近发生的事情 | 汤普森夫人要求杰森和詹姆斯竞选班长,因为她认为他们是领导者。 |

| 总结一下这个对话:n#Person1#:嘿,我们把车停在路边看看那边的房子。n#Person2#:是的,那看起来很棒! 它在我们的开放日名单上吗?n#Person1#:是的,它在我们的名单上。n#Person2#:嗯,从路边看起来很棒。 让我们继续往里面走。n#Person1#:让我们对注册表进行签名。 房地产经纪人现在看起来有点忙。n#Person2#:好的,我们接下来去看看厨房。n#Person1#:哦,看,这里有一些茶点。n#Person2#:确保你接了n#Person1#:上面有写这个房子要多少钱吗?n#Person2#:是的,好像从二十三万五千打折到两百了和两万五千n—n摘要:nnn### 响应:n | #Person1#和#Person2#来看房子。 他们检查了内部并谈论了它的价格。 | 这是 AMI 对以下刺激的反应。nn第二个人:n是的,看起来很棒! 它在我们的开放日名单上吗? 是的,它在我们的清单上。嗯,从路边看起来很棒。 让我们继续往里面走。让我们在注册表上签名。 房地产经纪人现在看起来有点忙。好吧,我们接下来去看看厨房。哦,看,他们有一些 | #Person1# 和 #Person2# 正在参观他们的开放日清单上的一所房子。 他们签署了一份注册表,#Person2# 告诉 #Person1# 拿一张包含信息的传单。nn |

| 总结一下这个对话:n#Person1#:你好吗,威尔逊先生? 我是 Tina.n#Person2#:很高兴认识您,Tina.n#Person1# 女士:请坐。 我知道我们的雇佣人员已经向您提供了有关您的员工合同的信息,但我想在签署之前再次检查一下主要细节。 首先,你将获得月薪,工作一年后还有一个月的带薪假期。n#Person2#:我是这么理解的。n#Person1#:你在值班期间将享受我们的医疗计划。 由于您将担任中层管理人员,因此预计您的工作时间最多比正常工作时间多 1. 5 小时。 任何超过该时间的批准时间将按半数支付,您可以将其作为工资或休假。n#Person2#:正是我的理解。n#Person1#:公司将承担合理的病假天数。 任何长期疾病都将由保险承保。 你读过合同的其他条款了吗?n#Person2#:是的,我读过。n#Person1#:你还有其他问题吗?n#Person2#:只有一个。 我注意到一个关于弹性工作时间的项目。 这对我来说是可能的吗?n#Person1#:是的,但是你必须和你的经理讨论细节。n#Person2#:可以接受。n#Person1#:很好。 现在,如果您在这里签名,您可以在 3 天后开始工作。n—n摘要:nnn### 回复:n | 威尔逊先生向蒂娜介绍了有关雇佣合同的基本信息。 他提到了月薪、一个月带薪假期、医疗计划、延长工作时间和弹性工作时间。 | n不,摘要不正确。 #Person1 对话框没有说名字是蒂娜,也没有自我介绍。 我认为他们都知道彼此的名字,所以这是不必要的。nn我认为如果其他一切都正确,摘要不会改变,除非#Person1结束,那没关系。nn | 蒂娜与威尔逊先生会面,讨论蒂娜员工合同的主要细节。 两人讨论每月工资和医疗计划。 蒂娜没有问题,将在 3 天后开始工作。nn |

| 总结一下这个对话:n#Person1#:杰克,你最喜欢的主题是什么?n#Person2#:我最喜欢的主题? 嗯,我想我更喜欢科学。 是的,科学,我觉得很有趣。 科学老师让这门课变得非常令人兴奋。 你呢?n#Person1#:我的数学考试总是成绩很好。 我也喜欢地理。 我喜欢了解人和他们居住的地方。 有什么科目是你不喜欢的吗? Jack?n#Person2#:我不太喜欢物理。 这不太容易理解,大多数孩子都对此感到厌烦。n—n总结:nnn### 回复:n | 杰克最喜欢的科目是科学,但他不太喜欢物理。 #Person1#喜欢数学和地理。 | n—nn### 这个词:“最喜欢的” (adj)nn 含义:喜爱、欣赏其他大多数人 n示例:我最喜欢的书是《圣经》;我最喜欢的书是《圣经》;我最喜欢的书是《圣经》; 你最喜欢什么运动?; 我最喜欢的颜色是蓝色。nn—nnnn### 你的____主题是什么? (正式)nn问答对话:nn#Person1#:你最喜欢的科目是什么?n# | 杰克和杰克正在谈论他们最喜欢和最不喜欢的话题。nn |

| 总结一下这个对话:n#Person1#:嗨,玛吉。 我在家长们都去参加的年终学校画展上看到了你的画。 太棒了。n#Person2#:嗯,我们的美术老师看起来很满意,但我不知道家长们怎么想。n#Person1#:哦,别担心。 我只听到他们说好话。n#Person2#:嗯……他可能没有注意到我没有使用正确的颜色。n#Person1#:我认为没有人注意到。n#Person2# : 没有,但我做到了。 但为时已晚。 好吧,下次我希望能做得更好。n—n总结:nnn### 回复:n | #Person1#看到Maggie的画,觉得很棒,但Maggie担心自己用的颜色不对,希望下次能画得更好。 | 此摘要应突出讨论的要点和结论。nn# 回复 Person1:n[回复摘要]nn—n### 回复:n此摘要应突出讨论的要点和结论。nn# 回复 Person2 :n[响应摘要]nn### Person1:n[Person1 摘要]n—n### Person2:n[Person2 摘要]nn### Personn—n | #Person1#看到了Maggie的画,并告诉Maggie很多家长都对Maggie的画赞不绝口。 玛吉不这么认为。nn |

- 在 Dialogsum 数据集上微调 Llama 2 70B 模型的结果:

| 输入 | 地面真相 | 非微调模型的响应 | 微调模型的响应 |

| 总结一下这个对话:n#Person1#:你获得了学位吗?n#Person2#:是的。 1996年,我获得了赫比斯大学的理学学士学位,2001年,我获得了北京大学的MBA学位。n#Person1#:你在大学的学习成绩怎么样?n#Person2#:其实我的成绩非常好。 我的总 GPA 为 9(满分 10 分),这是我班上最高的。n#Person1#:这非常令人印象深刻。 你最喜欢哪门课程?n#Person2#:英语。 既有趣又有用,所以我对它表现出了极大的兴趣。n#Person1#:你能告诉我你读研究生时为什么换专业吗?n#Person2#:因为我对行政管理很感兴趣,我确实选修了一些课程。 我在科目上也表现得很好。 因此我相信我能很好地胜任这个职位。n#Person1#:你在大学获得过什么荣誉和奖励吗?n#Person2#:有。 我每年都获得大学的奖学金。 1995年参加全国数学模型大赛并获奖。n—n总结:nnn###回复:n | #Person1#采访#Person2#并向#Person2#询问一些问题,包括#Person2#的学位、学习成绩、最喜欢的课程以及在大学获得的奖项。 #Person2#还告诉#Person1#为什么#Person2#转专业为管理。 | 这位候选人总结说,对话的主要思想是他获得了两个学位,0。而且专业做得很好。 然而,他的第一句话除了自恋之外并没有表达太多情感,也没有说明为什么他的经历与公司相关。 他可以建立更好的联系,也许可以用“专业”之外的潜在情感/态度来结束总结(就像他在对话中所做的那样)。 | #Person2#告诉#Person1# #Person2#获得了学士学位和MBA学位。 #Person2#的GPA是#Person2#班级中最高的,并且#Person2#对管理感兴趣。 #Person2#也在college.nn获得了一些荣誉和奖项 |

| 总结一下这个对话:n#Person1#:请问,这是什么材料? n#Person2#:拉基。 你想要一些? n#Person1#:没有,棉布在哪里? n#Person2#:我会告诉你。 n#Person1#:水洗后缩水率是多少? n#Person2#:低于 5%。 它非常耐用。 n—n摘要:nnn### 响应:n | #Person2#告诉#Person1#棉质衣服很耐用。 | 对于路线 QA41913,此部分应包含对话的段落摘要,以便自动发音和语音生成系统可以使用此文本进行输出合成。 | #Person1#想要一些棉布。 #Person2# 显示了一些 rhaki.nn |

| 总结一下这个对话:n#Person1#:对不起,我迟到了,Tom。n#Person2#:没关系,丽塔。 你去哪儿了?n#Person1#:在警察局。 我的手提包丢了。 或者也许有人拿走了它。 我不知道。n#Person2#:哦,不。 发生了什么? 坐下。 其中有什么重要的事情吗?n#Person1#:重要! 我的支票簿,我工作所需的所有文件。n#Person2#:哦,那太糟糕了。 但你是怎么失去它的?n#Person1#:嗯,如你所知,我整个早上都和一个朋友在一起,我们一起吃午饭。 吃完午饭,我就去购物了。 当我想买东西时,我找不到我的支票簿。 然后我想起它在我的手提包里。 我的手提包在我的车里。n#Person2#:所以你回到了你的车里。n#Person1#:但我没有在那里找到它。n#Person2#:然后你去了警察局?n# Person1#:不会立即。 在去警察局之前,我给朋友的办公室打了电话。 不走运。n#Person2#:你应该去你吃午饭的餐厅找找。n#Person1#:哦,我应该这么做的。n#Person2#:现在你最好给经理打电话吧离开.n—n摘要:nnn### 响应:n | 丽塔告诉汤姆她迟到了,因为她丢了手提包,而且她费尽心思寻找手提包。 汤姆建议丽塔去她吃午饭的餐厅找找。 | 使用您最喜欢的单词组合将每个句子翻译成英语:n### 值:n | 丽塔丢了手提包,汤姆建议她去她吃午饭的餐厅寻找。nn |

| 总结一下这个对话:n#Person1#:早上好,妈妈!n#Person2#:早上好,梅格。 你今天看起来不太好? 你生病了吗?n#Person1#:不,我没病。n#Person2#:那么,你怎么了,我的孩子?n#Person1#:没什么。n#Person2#:哦,来吧,宝贝。 告诉我发生了什么事。n#Person1#:我.. 。 我没能通过考试。 我多么希望我能好好学习啊。n#Person2#:哦。 别紧张。 你可以从今天开始设定你的目标。n#Person1#:好的,妈妈。 下次我不会考试不及格了。n—n总结:nnn### 回复:n | 梅格没有心情,因为她考试不及格。 她妈妈鼓励她从今天开始设定目标。 | Aide sans 动作动词Aide et direct object apres le verba amountn | #Person1#没能通过考试并告诉了妈妈。 妈妈鼓励#Person1#更加努力学习。nn |

| 总结一下这个对话:n#Person1#:每个人都想被经济损失杀死。 如果您打算富裕地退休,则必须将您的积蓄进行投资。 我正在考虑买股票。 如果我能管理得好,这可能是一笔不错的投资。 你说什么?n#Person2#:我部分同意你的观点。 买股票并不难,但是通过买股票持续赚钱却很难。 即使是专业人士也不容易,所以要小心。 无论如何,像我们这样的人需要投资方面的帮助。 为什么不做一些在线研究呢? 有数据、报告和论坛来教育人们如何投资。 另外,你需要访问一个提供股票图表的成熟网站。n#Person1#:哇,你听起来很专业。n#Person2#:我上周末刚刚看了投资电视节目。 这几天已经成为一个非常热门的话题。 其实我什至不是初学者。n—n总结:nnn### 回复:n | #Person1#和#Person2#正在谈论买股票。 #Person2#认为这种方式很难持续赚钱,并建议进行在线研究以了解投资。 | n我同意之前推荐的投资策略。 我花了很多时间和精力才想出这样的计划。 很高兴我的判断得到了如此程度的信任。 确实,我的同事可以感到放心,因为我会尽一切努力带领这个团队走向光明和安全的退休未来。 我期待您成为团队的积极成员。 | #Person1#想买股票,但#Person2#告诉#Person1#要小心,因为投资很难。 #Person2# 建议#Person1# 进行在线研究、访问已建立的网站并观看投资计划。nn |

数据集格式化

我们目前提供两种类型的微调:指令微调和域适应微调。 您可以通过指定参数轻松切换到其中一种训练方法 instruction_tuned 为“True' 要么 'False“。

域适应格式

文本生成模型还可以在任何特定领域的数据集上进行微调。 在特定领域的数据集上进行微调后,该模型有望生成特定领域的文本,并通过少量提示解决该特定领域中的各种 NLP 任务。

对于模型的输入,请使用训练和可选的验证目录。 每个目录都包含一个 CSV、JSON 或 TXT 文件。 对于 CSV 和 JSON 文件,如果没有名为 text 的列,则使用来自名为 text 的列或第一列的训练或验证数据 text 被发现。 训练和验证(如果提供)下的文件数量应分别等于 1。

输出是经过训练的模型,可以部署用于推理。

以下是用于微调文本生成模型的 TXT 文件示例。 TXT 文件是亚马逊 2021 年至 2022 年向 SEC 提交的文件:

指令微调

文本生成模型可以对任何文本数据进行指令调整,前提是数据采用预期格式。 经过指令调整的模型可以进一步部署用于推理。

对于输入,请使用训练和可选的验证目录。 训练和验证目录应包含一个或多个 JSON 行 (.jsonl) 格式的文件。 特别是,train 目录还可以包含一个可选的 *.json 文件,描述输入和输出格式。

根据每个时期结束时计算的验证损失来选择最佳模型。 如果未给出验证集,则会自动分割(可调整的)百分比的训练数据并用于验证。

训练数据必须采用 JSON 行 (.jsonl) 格式,其中每行都是代表单个数据样本的字典。 所有训练数据必须位于一个文件夹中; 但是,它可以保存在多个 .jsonl 文件中。 .jsonl 文件扩展名是强制性的。 训练文件夹还可以包含 template.json 描述输入和输出格式的文件。 如果没有给出模板文件,将使用以下模板:

在这种情况下,JSON 行条目中的数据必须包括 prompt 和 completion 字段。 如果提供了自定义模板,则还必须使用 prompt 和 completion 键定义输入和输出模板。 以下是自定义模板示例:

此处,JSON 行条目中的数据必须包含 question, context及 answer 领域。

输出是经过训练的模型,可以部署用于推理。

我们提供亚马逊 SEC 备案数据的子集。 它是从公开下载的 埃德加。 有关访问数据的说明,请参阅 访问 EDGAR 数据.

执照: 知识共享署名-相同方式共享许可证 (CC BY-SA 4.0)

- SEO 支持的内容和 PR 分发。 今天得到放大。

- PlatoData.Network 垂直生成人工智能。 赋予自己力量。 访问这里。

- 柏拉图爱流。 Web3 智能。 知识放大。 访问这里。

- 柏拉图ESG。 汽车/电动汽车, 碳, 清洁科技, 能源, 环境, 太阳能, 废物管理。 访问这里。

- 柏拉图健康。 生物技术和临床试验情报。 访问这里。

- 图表Prime。 使用 ChartPrime 提升您的交易游戏。 访问这里。

- 块偏移量。 现代化环境抵消所有权。 访问这里。

- Sumber: https://aws.amazon.com/blogs/machine-learning/fine-tune-llama-2-for-text-generation-on-amazon-sagemaker-jumpstart/

- :具有

- :是

- :不是

- :在哪里

- $UP

- 000

- 1

- 10

- 100

- 12

- 13

- 14

- 15 年

- 15%

- 16

- 17

- 1870

- 19

- 1930

- 1933

- 1934

- 1985

- 1995

- 1996

- 20

- 2000

- 2001

- 2005

- 2006

- 2008

- 2011

- 2017

- 2023

- 2025

- 21e

- 23

- 24

- 25

- 26%

- 27

- 27a

- 28

- 29

- 30

- 31

- 32

- 36

- 39

- 40

- 400

- 50

- 500

- 5日

- 60

- 67

- 7

- 70

- 75

- 8

- 9

- a

- 对,能力--

- Able

- 关于

- 关于它

- 以上

- 学者

- 接受

- 可接受

- ACCESS

- 访问

- 完成

- 根据

- 实现

- 承认

- 横过

- 法案

- 操作

- 要积极。

- 活动

- 行为

- 实际

- 通

- Adam

- 适应

- 加

- 增加

- 额外

- 附加信息

- 另外

- 可调整的

- 管理

- 采用

- 刊登广告

- 广告

- 广告

- 怕

- 后

- 再次

- 年龄

- 议定

- 协议

- AI

- AI模型

- 瞄准

- 针对

- 专辑

- 算法

- 算法

- 对齐

- 所有类型

- 让

- 允许

- 沿

- 阿尔法

- 已经

- 还

- 尽管

- 时刻

- am

- Amazon

- 亚马逊SageMaker

- 亚马逊SageMaker JumpStart

- 亚马逊网络服务

- 美国人

- 其中

- 量

- 艾米

- an

- 分析

- 古

- 和

- 动物

- 动物

- 宣布

- 公布

- 另一个

- 回答

- 答案

- 任何

- 任何人

- 什么

- 明显的

- 上诉

- 吸引人的

- 上诉

- 出现

- 出现

- 出现

- 应用的

- 使用

- 任命

- 欣赏

- 适当

- 适当

- 批准

- 四月

- 架构

- 保健

- 国家 / 地区

- 阿根廷人

- 按理说

- 论点

- 出现

- 武装的

- 军队

- 围绕

- 排列

- 艺术

- 阿瑟

- 刊文

- 人造的

- 人工智能

- 人工智能和机器学习

- 艺术

- AS

- 亚洲

- 问

- 协助

- 假设

- At

- 亚特兰蒂斯

- 勤

- 与会者

- 关注我们

- 吸引

- 听众

- 八月

- 奥斯汀

- 澳大利亚

- 作者

- 自动表

- 自动

- 自动化和干细胞工程

- 可用性

- 可使用

- 避免

- 世界原声音乐

- 奖项

- 远离

- AWS

- 母婴

- 背部

- 坏

- 酒吧

- 基于

- 战斗

- 战斗

- BE

- 美丽

- 成为

- 因为

- 成为

- 很

- before

- 开始

- 初学者

- 作为

- 相信

- 如下。

- 基准

- 标杆

- 本杰明

- 除了

- 最佳

- 更好

- 之间

- 大

- 最大

- 亿

- 分娩

- 位

- 黑色

- 混合

- 混纺

- 蓝色

- 书

- 书籍

- 无聊

- 天生的

- 都

- 盒子

- 箱

- 品牌

- 新品牌

- 光明

- 瞻

- 英国的

- 广阔

- 布罗克

- 棕色

- 建

- 商业

- 商人

- 忙碌

- 但是

- 购买

- 买房

- by

- 计算

- 被称为

- 剑桥

- CAN

- 候选人

- 能力

- 能力

- 容量

- 汽车

- 卡

- 寻找工作

- 小心

- 进行

- 携带

- 案件

- 例

- 原因

- 造成

- Center

- 房间

- 冠军

- 更改

- 变

- 渠道

- 特征

- 字符

- 图表

- 便宜

- 查

- 支票

- 孩子

- 儿童

- 中国

- 中文

- 选择

- 选择

- 克里斯滕森

- 圣诞

- 克里斯托弗

- 城市

- 要求

- 索赔人

- 声称

- 索赔

- 程

- 类

- 分类

- 清除

- 衣服

- 教练

- 码

- 认知

- 创造

- 同事

- 采集

- 学院

- 颜色

- COLUMBIA

- 柱

- 组合

- 组合

- 如何

- 购买的订单均

- 安慰

- 未来

- 评论

- 注释

- 商业的

- 相当常见

- 常用

- 共享

- 沟通

- 公司

- 公司

- 公司的

- 比较

- 相比

- 兼容

- 竞争

- 比赛

- 竞争对手

- 完成

- 完成

- 完成对

- 完成

- 组件

- 计算

- 计算

- 一台

- 计算机科学

- 计算机视觉

- 概念

- 概念

- 总结

- 流程条件

- 会议

- 配置

- 冲突

- 冲突的

- 地都

- 连续

- 考虑

- 考虑

- 始终如一

- 由

- 安慰

- 游戏机

- 消耗

- 包含

- 容器

- 包含

- 上下文

- 继续

- 持续

- 继续

- 合同

- 控制

- 谈话

- 公司

- 对应

- 价格

- 可以

- 国家

- 套餐

- 课程

- 外壳

- 覆盖

- 覆盖

- 创建信息图

- 创建

- 批评

- 克罗斯比

- 人群

- 游轮

- 抑制

- 电流

- 目前

- 习俗

- 合作伙伴

- 定制

- 达拉斯

- data

- 数据点

- 数据科学

- 数据安全

- 数据集

- 日期

- 天

- 一年中的

- 处理

- 死亡

- 十

- 决定

- 减少

- 减少

- 专用

- 认为

- 默认

- 击败

- 定义

- 定义

- 定义

- 学位

- 交付

- 需求

- 演示

- 问题类型

- 依靠

- 部署

- 部署

- 部署

- 部署

- 描述

- 描述

- 设计

- 设计

- 尽管

- 详情

- 开发

- 发达

- 开发商

- 偏差

- 设备

- 对话框

- 对话

- DID

- 死

- 死亡

- 不同

- 差异

- 不同

- 不同形式

- 难

- 直接

- 直接

- 目录

- 打折

- 通过各种方式找到

- 讨论

- 讨论

- 讨论

- 碟

- 迪士尼

- 分散

- 破坏性

- 区

- 您所属的事业部

- do

- 记录

- 不

- 不会

- 做

- 域

- 域名

- 完成

- 别

- 翻番

- 向下

- 饮品

- 驱动

- 下降

- 配音

- 两

- ,我们将参加

- e

- Ë&T

- 每

- 此前

- 早

- 赚

- 地球

- 容易

- 东部

- 东

- 易

- 吃

- 埃德加

- 教育

- 爱德华·

- 效果

- 影响

- 高效

- 努力

- 工作的影响。

- 蛋类

- 或

- el

- 其他

- 拥抱

- 员工

- 雇用

- 使

- 鼓励

- 结束

- 端点

- 结束

- 能源

- 发动机

- 工程师

- 英国

- 英语

- 更多

- 确保

- 娱乐

- 整个

- 环境

- 时代

- 时代

- 等于

- 设备

- 时代

- 错误

- 文章

- 本质

- 成熟

- 建立

- 估计

- 欧洲

- 评估

- 甚至

- 活动

- 事件

- EVER

- 所有的

- 每个人

- 一切

- 明显

- 究竟

- 例子

- 例子

- 优秀

- 交换

- 兴奋

- 令人兴奋的

- 独家

- 展览

- 现有

- 扩大

- 展开

- 期望

- 预期

- 体验

- 实验

- 说明

- 介绍

- 解释

- 表达式

- 延期

- 眼

- 事实

- 因素

- 因素

- 失败

- 失败

- 公平

- 信仰

- false

- 家庭

- 著名

- 农场

- 高效率

- 快

- 最快

- 喜爱

- fc

- 功绩

- 专栏

- 精选

- 特征

- 二月

- 反馈

- 感觉

- 节

- 节日

- 少数

- 小说

- 字段

- 文件

- 档

- 申请

- 电影

- 薄膜

- 金融

- 金融服务

- 找到最适合您的地方

- 企业

- 姓氏:

- 适合

- 五

- 舰队

- 浮动

- 漂浮的

- 专注焦点

- 遵循

- 其次

- 以下

- 食品

- Footprint

- 针对

- 申请

- 正式

- 格式

- 形成

- 形式

- 论坛

- 向前

- 前瞻性的

- 化石

- 发现

- 基金会

- 四

- 第四

- 法国

- 冻结

- 法语

- 新鲜

- 朋友

- 朋友

- 止

- 前

- 进一步

- 此外

- 未来

- 伽马射线

- 云集

- 其他咨询

- 通常

- 生成

- 代

- 生成的

- 生成式人工智能

- 地理

- 乔治

- 德语

- 得到

- 越来越

- 礼物

- GitHub上

- 特定

- 给予

- Go

- GOES

- 去

- 非常好

- 好工作

- 治理

- GPA

- GPU

- 图形处理器

- 渐变

- 渐渐

- 毕业

- 草

- 大

- 更大的

- 最大的

- 希腊

- 绿色

- 陆运

- GRT

- 指南

- 民政事务总署

- 半

- 大厅

- 发生

- 发生

- 快乐

- 硬

- 更难

- 哈罗德

- 哈佛

- 有

- he

- 总部设

- 总部

- 医疗保健

- 听

- 听说

- 保持

- 帮助

- 帮助

- 帮助

- 于是

- 这里

- 相关信息

- hi

- 高

- 高价值

- 更高

- 最高

- 近期亮点

- 突出

- 丘陵

- 他

- 他的

- 历史性

- 历史的

- 历史

- 击中

- 举行

- 持有

- 主页

- 企业荣誉

- 希望

- 希望

- 热卖

- HOURS

- 别墅

- 创新中心

- How To

- 但是

- HTML

- HTTP

- HTTPS

- 黄

- 中心

- 巨大

- 雨果

- 人

- 百

- 数百

- i

- 生病

- 主意

- 思路

- 确定

- 鉴定

- if

- ii

- 伊利诺伊州

- 疾病

- 错觉

- 图片

- 立即

- 移民

- 影响力故事

- 进口

- 重要性

- 重要

- 印象深刻

- 有声有色

- 改善

- 提高

- 改善

- in

- 包括

- 包括

- 包括

- 包含

- 成立

- 结合

- 增加

- 现任

- 的确

- 指数

- 印度

- 室内

- 信息

- 居民

- 创新

- 输入

- 内

- 例

- 代替

- 研究所

- 机构

- 说明

- 仪器

- 保险

- 房源搜索

- 拟

- 兴趣

- 有兴趣

- 有趣

- 内部

- 国际

- 面试

- 成

- 介绍

- 介绍

- 推出

- 介绍

- 投资

- 投资

- 投资

- 投资策略

- 孤立

- 问题

- 问题

- IT

- 项目

- 它的

- 千斤顶

- 詹姆斯

- 一月

- 工作

- 加盟

- 加盟

- 乔纳森

- JPG

- JSON

- 六月

- 只是

- 只有一个

- 保持

- 键

- 键

- 小子

- 孩子们

- 杀

- 类

- 国王

- 知道

- 已知

- 韩国

- 韩语

- 凯尔

- 实验室

- 土地

- 语言

- 大

- 在很大程度上

- 大

- 最大

- 名:

- 晚了

- 后来

- 发射

- 推出

- 法律

- 层

- 布局

- 铅

- 领导人

- 信息

- 联盟

- 学习用品

- 学习

- 最少

- 导致

- 长度

- 减

- 让

- Li

- 自学资料库

- 执照

- 生活

- 光

- 喜欢

- 容易

- 喜欢

- 限制

- Line

- 线

- 链接

- 清单

- 已发布

- 听力

- 诉讼

- 生活

- 活的

- ll

- 骆驼

- 本地

- 位于

- 圖書分館的位置

- 伦敦

- 长

- 长时间

- 不再

- 看

- 寻找

- LOOKS

- 失去

- 离

- 丢失

- 占地

- 爱

- 爱

- 低

- 公司

- 运气

- 卢纳

- 午餐

- 豪华

- 机

- 机器学习

- 制成

- 杂志

- 主要

- 保持

- 维护

- 主要

- 专业

- 使

- 赚钱

- 制作

- 制作

- 管理

- 颠覆性技术

- 经理

- 马南沙阿

- 强制性

- 制造商

- 许多

- 三月

- 市场

- 市场份额

- 标记

- 美国马萨诸塞州

- 主

- 材料

- 重大

- 矩阵

- 问题

- 最大

- 最多

- 可能..

- 麦当劳

- me

- 餐

- 意

- 手段

- 措施

- 奖牌

- 医生

- 满足

- 会见

- 会员

- 内存

- 提到

- 提到

- 元

- 方法

- 方法

- 中间

- 军工

- 米尔顿

- 介意

- 最低限度

- 混合物

- ML

- 多播

- 模型

- 模型

- 妈妈

- 时刻

- 美好瞬间

- 钱

- 显示器

- 显示器

- 月

- 每月一次

- 更多

- 早上

- 最先进的

- 大多

- 母亲

- 运动

- 运动

- 电影

- 电影

- mr

- MS

- 许多

- 跨国公司

- 多

- 音乐

- 音乐

- 音乐家

- 必须

- my

- 姓名

- 命名

- 名称

- 狭窄

- 在

- National

- 自然

- 自然语言处理

- 导航

- 旅游导航

- 必要

- 需求

- 网络

- 决不要

- 全新

- 新技术

- 纽约

- 纽约市

- 新

- Newton

- 下页

- 任天堂

- NLP

- 没有

- 不包含

- 正常

- 北

- 笔记本

- 没什么

- 注意..

- 十一月

- 现在

- 数

- 肥胖

- 对象

- 目标

- 义务

- 天文台

- 海洋

- 十月

- of

- 折扣

- 提供

- 优惠精选

- 办公

- 官方

- 经常

- oh

- on

- 一旦

- 一

- 在线

- 仅由

- 打开

- 操作

- 操作

- 运营

- 光学

- 优化

- 优化

- 优化

- 附加选项

- 附加选项

- or

- 痴迷

- 秩序

- OS

- 其他名称

- 其它

- 除此以外

- 我们的

- 输出

- 户外活动

- 概述

- 产量

- 超过

- 最划算

- 己

- 类型

- 页

- 网页

- 支付

- 画

- 配对

- 面包

- 纸类

- 文件

- 悖论

- 并行

- 参数

- 参数

- 父母

- 巴黎

- 部分

- 参加

- 特别

- 合伙人

- 合作

- 部分

- 通过

- 通道

- 通行证

- 护照

- 过去

- 路

- 国家

- 和平

- 北京

- 员工

- 为

- 百分比

- 知觉

- 演出

- 性能

- 执行

- 执行

- 也许

- 人

- 相

- 博士学位

- 现象

- 光子

- 的

- 物理

- 挑

- 图片

- 粉色

- 关键的

- 地方

- 地方

- 计划

- 计划

- 计划

- Plants

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 播放

- 请

- 满意

- 暴跌

- 口袋

- 点

- 点

- Police

- 政治

- 池

- 贫困

- 热门

- 人口

- 位置

- 积极

- 可能性

- 帖子

- 潜力

- 功率

- 强大

- 平台精度

- 比较喜欢

- 喜好

- 准备

- 准备

- 当下

- 著名的

- 先前

- 车资

- 价格

- 私立

- 奖金

- 奖品

- 大概

- 市场问题

- 问题

- 过程

- 过程

- 处理

- 生成

- 核心产品

- 所以专业

- 专业人士

- 教授

- 利润

- 曲目

- 训练课程

- 预测

- 许诺

- 促进

- 促进

- 建议

- 提供

- 提供

- 提供

- 优

- 规定

- 公然

- 出版

- 目的

- 目的

- 追求

- 放

- 蟒蛇

- 定性

- 质量

- 季

- 题

- 有疑问吗?

- 更快

- 很快

- R

- RAIN

- 随机

- 范围

- 范围

- 率

- 比

- RAY

- 达到

- 阅读

- 读者

- 阅读

- 现实

- 真

- 房地产经纪人

- 合理

- 收到

- 接收

- 建议

- 建议

- 建议

- 建议

- 记录

- 记录

- 红色

- 减少

- 减少

- 参考

- 简称

- 改革

- 视

- 而不管

- 地区

- 地区

- 寄存器

- 注册处

- 有关

- 相对

- 发布

- 释放

- 相应

- 信赖

- 遗迹

- 纪念

- 去除

- 更换

- 报告

- 业务报告

- 知识库

- 代表

- 代表

- 请求

- 必须

- 需求

- 岗位要求

- 需要

- 研究

- 研究员

- 居民

- 那些

- 分别

- 回应

- 响应

- 回复

- 责任

- RESTAURANT

- 优选餐厅

- 导致

- 成果

- 退休

- 回报

- 返回

- 收入

- 修改

- 奖励

- 彩色带

- 米类

- 丰富

- 理查德

- 右

- 上升

- 风险

- 路

- 知更鸟

- 机器人

- 岩石

- 岩石

- 角色

- 滚

- 卷

- περίπου

- 轮

- 路线

- 行

- 第

- 运行

- 运行

- s

- 安全

- 实现安全

- sagemaker

- 说

- 帆船

- 薪水

- 同

- 储

- 锯

- 对工资盗窃

- 说

- 鳞片

- 学校

- 科学

- 科学家

- 脚本

- SDK

- SEA

- 搜索

- 搜索引擎

- 搜索

- 证券交易委员会

- 其次

- 次

- 部分

- 部分

- 安全

- 证券

- 保安

- 看到

- 似乎

- 似乎

- 看到

- 选

- 选择

- 前辈

- 句子

- 首尔

- 分开

- 九月

- 序列

- 服务

- 服务

- 特色服务

- 会议

- 集

- 设置

- 设置

- 几个

- 分片

- Share

- 共用的,

- 夏尔马

- 她

- 船

- 船舶

- 购物

- 商店

- 应该

- 显示

- 显示

- 如图

- 作品

- 关闭

- 签署

- 意义

- 显著

- 显著

- 签约

- 白银

- 类似

- 同样

- 简易

- 简

- 只是

- 自

- 单

- 先生

- 妹妹

- 坐

- 网站

- 位于

- 情况

- 尺寸

- 放慢

- 小

- 小

- So

- 出售

- 方案,

- 解决方案

- 解决

- 一些

- 东西

- 是

- 歌曲

- 或很快需要,

- 听起来

- 配乐

- 来源

- 南部

- 韩国

- 韩国人

- 南安普敦

- 南

- 太空

- 西班牙语

- 说话

- 专家

- 专门

- 具体的

- 特别是

- 光谱

- 言语

- 速度

- 花

- 尽管

- 分裂

- 运动

- 阶段

- 星

- 开始

- 开始

- 启动

- 州/领地

- 声明

- 州

- 站

- 统计

- 步

- 仍

- 刺激物

- 库存

- 股票

- 石

- 存储

- 商店

- 策略

- 强烈

- 奋斗

- 学生

- 学生

- 研究

- 工作室

- 学习

- 主题

- 成功

- 顺利

- 这样

- 建议

- 提示

- 总结

- 概要

- 夏季

- 超级

- SUPPORT

- 支持

- 支持

- 肯定

- 包围

- Switch 开关

- 瑞士

- 系统

- 产品

- 表

- 采取

- 拍摄

- 需要

- 服用

- 谈论

- 说

- 目标

- 针对

- 任务

- 任务

- 味道

- 教

- 茶

- 团队

- 科技

- 文案

- 技术

- 专业技术

- 青少年

- 望远镜

- 展示

- 告诉

- 模板

- 模板

- 术语

- 条款

- test

- 测试

- 德州

- 文本

- 比

- 感谢

- 谢谢

- 这

- 区域

- 信息

- 西方

- 世界

- 其

- 他们

- 他们自己

- 然后

- 那里。

- 因此

- 博曼

- 论点

- 他们

- 事

- 事

- 认为

- 思维

- 想

- Free Introduction

- 那些

- 虽然?

- 思想

- 千

- 三

- 宝座

- 通过

- 始终

- 从而

- 绑

- 次

- 时

- 蒂娜

- 标题

- 至

- 今晚

- 一起

- 符号化

- 令牌

- 东京

- 汤姆

- 明天

- 托尼

- 也有

- 了

- 主题

- 合计

- 教程

- 市政厅

- 培训

- 熟练

- 产品培训

- 变压器

- 变形金刚

- 运输

- 旅行

- 尝试

- 兆

- 麻烦

- true

- 信任

- 真相

- 尝试

- 土耳其语

- 转身

- tv

- 二

- 类型

- 类型

- 普遍

- 一般

- ui

- 最终

- 无法

- 不确定性

- 下

- 经历

- 相关

- 理解

- 理解

- 承担

- 联合的

- 美国

- 大学

- 不必要

- 直到

- 更新

- 更新

- 最新动态

- 上传

- 上传

- 上

- us

- 使用

- 用过的

- 用户

- 使用

- 运用

- 假期

- 验证

- 折扣值

- 价值观

- 各种

- 各个

- 蔬菜

- 版本

- 版本

- 非常

- 通过

- 视频

- 查看

- 意见

- 愿景

- 参观

- 投票

- 视图

- 等待

- 等候

- 想

- 通缉

- 希望

- 战争

- 是

- 洗涤

- 了解

- 观看

- 水

- 方法..

- we

- 卷筒纸

- Web服务

- 您的网站

- 网站

- 周

- 周末

- 欢迎进入

- 井

- 去

- 为

- 西部

- 什么是

- 什么是

- 任何

- ,尤其是

- 而

- 是否

- 这

- 而

- 白色

- WHO

- 全

- 谁的

- 为什么

- 宽

- 广泛

- 无线上网

- 将

- 威廉

- 威尔逊

- 赢

- Witness & Evangelism Committee

- 胜利

- 中

- 也完全不需要

- 韩元

- Word

- 话

- 工作

- 工作

- 工人

- 工人

- 加工

- 合作

- 世界

- 世界

- 担心

- 担心

- 将

- 写

- 作家

- 作家

- 写作

- 书面

- 错误

- 年

- 年

- 含

- 纽约

- 完全

- 年轻

- 您一站式解决方案

- 青少年

- 青年

- 和风网