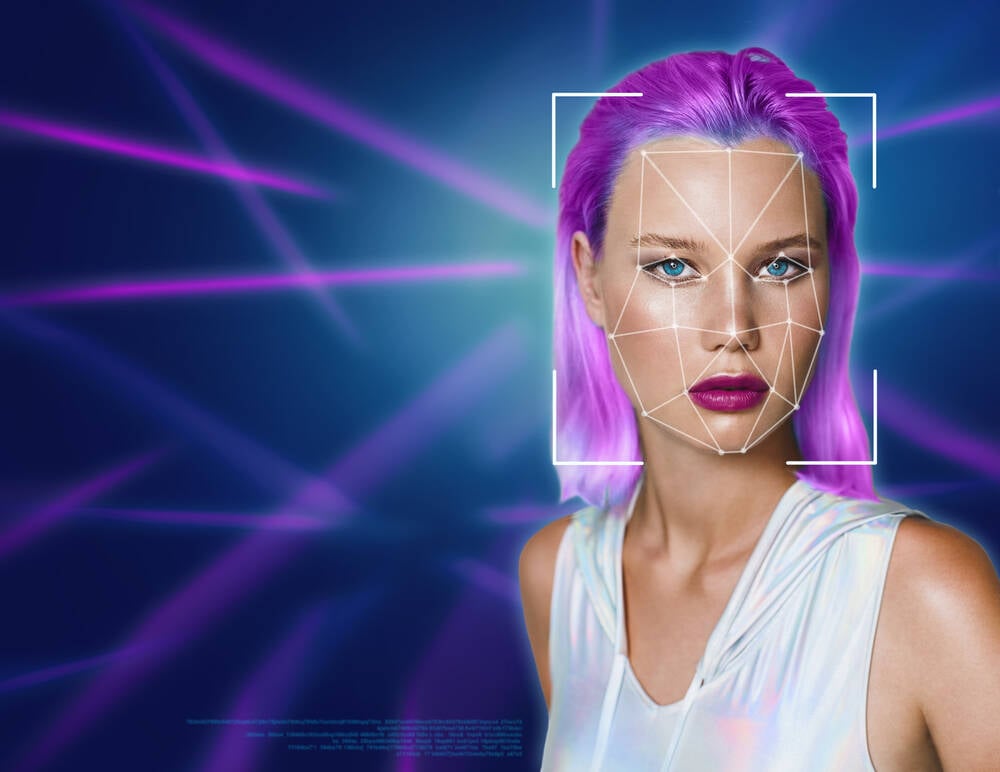

微软本周演示了 VASA-1,这是一个用于创建人们通过静态图像、音频样本和文本脚本进行交谈的视频的框架,并正确地声称向公众发布它太危险了。

这些人工智能生成的视频,人们可以令人信服地动画化,用克隆的声音说出脚本单词,这正是美国联邦贸易委员会的做法 警告说 上个月,继之前 提出规则 防止人工智能技术被用于冒充欺诈。

微软团队在他们的研究中也承认这一点 公告,这解释了出于道德考虑该技术没有被发布。他们坚称,他们正在展示的研究是为了生成虚拟互动角色,而不是为了模仿任何人。因此,没有计划任何产品或 API。

雷德蒙德的研究人员表示:“我们的研究重点是为虚拟人工智能化身生成视觉情感技能,旨在实现积极的应用。” “它无意创建用于误导或欺骗的内容。

“然而,与其他相关内容生成技术一样,它仍然可能被滥用于模仿人类。我们反对任何制造误导性或有害真实人物内容的行为,并有兴趣应用我们的技术来推进伪造检测。”

生物识别认证公司 Token 的主席 Kevin Surace 经常就生成式人工智能发表演讲,他告诉我们 注册 在一封电子邮件中,虽然之前已经有过通过静止帧和克隆语音文件制作动画的面部技术演示,但微软的演示反映了最先进的技术。

“个性化电子邮件和其他商业大众传播的影响是巨大的,”他认为。 “甚至还可以将旧照片制作成动画。从某种程度上来说,这很有趣,而从另一方面来说,它拥有可靠的业务应用程序,我们将在未来的几个月和几年中使用它。”

Deepfakes 的“乐趣”在于 96% 的非自愿色情内容,当 评估 [PDF] 2019 年由网络安全公司 Deeptrace 发布。

尽管如此,微软的研究人员表示,能够创造出看起来很逼真的人并把话放到他们的嘴里有积极的用途。

他们在一份报告中提出:“此类技术有望丰富数字通信,增加有沟通障碍的人的可及性,改变教育和交互式人工智能辅导方法,并在医疗保健领域提供治疗支持和社交互动。” 研究报告 不包含“色情”或“错误信息”等字样。

虽然人工智能生成的视频与 Deepfake 并不完全相同,但存在争议,但后者 定义 通过数字操作而不是生成方法,当可以在不进行剪切和粘贴嫁接的情况下变出令人信服的赝品时,区别就变得无关紧要了。

当被问及微软因担心滥用而未向公众发布这项技术的事实时,Surace 对限制的可行性表示怀疑。

他说:“微软和其他公司目前暂时搁置,直到解决隐私和使用问题。” “谁将如何监管谁出于正确的原因使用它?”

Surace 补充说,已经有类似复杂的开源模型,并指出 EMO。 “人们可以从 GitHub 获取源代码,并围绕它构建一项服务,这可以说可以与微软的产品相媲美,”他观察到。 “由于该领域的开源性质,无论如何对其进行监管都是不可能的。”

也就是说,世界各国都在努力监管人工智能制造的人。 加拿大, 中国,并 UK与其他国家一样,所有国家都有可适用于深度造假的法规,其中一些法规实现了更广泛的政治目标。英国就在本周 使它成为非法的 未经同意创建露骨的深度伪造图像。英国 2023 年在线安全法案已禁止共享此类图像。

一月份,一个由美国立法者组成的两党团体 介绍 2024 年《破坏显式伪造图像和未经同意的编辑法案》(《反抗法案》),该法案为未经同意的深度伪造图像的受害者提供了一种向法庭提出民事索赔的方式。

16 月 XNUMX 日星期二,美国参议院司法委员会、隐私、技术和法律小组委员会举行了 听证会 标题为“人工智能的监督:选举 Deepfakes”。

Deepfake 检测公司 DeepMedia 的首席执行官 Rijul Gupta 在准备好的讲话中表示:

深度造假最令人担忧的方面是它们能够为不良行为者提供看似合理的推诿,使他们能够将真实内容视为虚假内容。这种对公众信任的侵蚀打击了我们社会结构的核心和民主的基础。人脑天生就会相信自己所看到和听到的东西,因此特别容易受到深度造假的欺骗。随着这些技术变得越来越复杂,它们有可能破坏支撑我们社会的共同现实感,造成一种不确定和怀疑的气氛,让公民质疑他们所遇到的每条信息的真实性。

但想想营销应用。 ®

- :具有

- :是

- :不是

- :在哪里

- 16

- 2019

- 2023

- 2024

- 7

- a

- 对,能力--

- Able

- 关于

- 访问

- 承认

- 法案

- 演员

- 添加

- 前进

- 后

- AI

- 致力

- 所有类型

- 允许

- 已经

- 其中

- an

- 和

- 另一个

- 任何

- 任何人

- API

- 应用领域

- 应用的

- 应用

- 四月

- 保健

- 按理说

- 围绕

- 艺术

- AS

- 方面

- At

- 音频

- 认证

- 头像

- 背部

- 坏

- BE

- 因为

- 成为

- 成为

- 很

- 行为

- 作为

- 相信

- 法案

- 生物识别

- 生物认证

- 两党

- 商业

- 大脑

- 英国

- 更广泛

- 建立

- 商业

- 商业应用

- by

- CAN

- 案件

- CEO

- 椅子

- 字符

- 公民

- 民间

- 要求

- 索赔

- 气候

- CO

- 码

- 未来

- 佣金

- 委员会

- 沟通

- 同意

- 注意事项

- 包含

- 内容

- 内容生成

- Contents

- 核心

- 可以

- 国家

- 法庭

- 创建信息图

- 创建

- 创造

- 网络安全

- 危险的

- 欺骗

- 欺骗

- deepfakes

- 蔑视

- 民主

- 线上演示

- 检测

- 数字

- 解除此信息

- 破坏

- 区别

- 不

- 怀疑

- 两

- 教育

- 选举

- 邮箱地址

- 电子邮件

- 遭遇

- 充实

- 伦理

- 甚至

- 所有的

- 介绍

- 表示

- 程度

- 布

- 面孔

- 事实

- 假

- 恐惧

- 联邦

- 美国联邦贸易委员会

- 文件

- 公司

- 重点

- 针对

- 伪造的

- 伪造罪

- Foundations

- FRAME

- 骨架

- 骗局

- 频繁

- 止

- 联邦贸易委员会

- 履行

- 开玩笑

- 产生

- 发电

- 代

- 生成的

- 生成式人工智能

- 真正

- GitHub上

- 理想中

- 非常好

- 团队

- 古普塔

- 有害

- 有

- he

- 医疗保健

- 保持

- 持有

- 创新中心

- 但是

- HTML

- HTTPS

- 人

- 人类

- 图片

- 图片

- 启示

- 不可能

- in

- 增加

- 日益

- 信息

- 拟

- 相互作用

- 互动

- 有兴趣

- 问题

- IT

- 一月

- JPG

- 只是

- 司法

- 名:

- 法律

- 国会议员

- 左

- 立法

- 喜欢

- 寻找

- 制作

- 操作

- 营销

- 质量

- 方法

- 方法

- 微软

- 误传

- 误导

- 滥用

- 模型

- 月

- 个月

- 最先进的

- 许多

- 联合国

- 自然

- 没有

- 现在

- of

- 老年人

- on

- 一

- 在线

- 打开

- 开放源码

- 反对

- or

- 其他名称

- 其它

- 我们的

- 输出

- 产量

- 疏忽

- 尤其

- 员工

- 百分

- 人

- 图片

- 片

- 计划

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 似是而非

- 政治

- 积极

- 可能

- 准备

- 呈现

- 防止

- 先前

- 先

- 隐私

- 产品

- 承诺

- 提供

- 提供

- 优

- 国家

- 公众信任

- 放

- 相当

- RE

- 真实

- 现实

- 现实

- 原因

- 反映

- 调节

- 调节

- 法规

- 有关

- 释放

- 发布

- 释放

- 研究

- 研究人员

- 限制

- 右

- 对手

- s

- 实现安全

- 说

- 同

- 样品

- 脚本

- 看到

- 参议院

- 感

- 服务

- 共用的,

- 共享

- 同样

- 怀疑论

- 技能

- 社会

- 社会

- 固体

- 一些

- 极致

- 来源

- 源代码

- 太空

- 说话

- 喇叭

- 州/领地

- 仍

- 罢工

- 小组委员会

- 这样

- 建议

- SUPPORT

- 说

- 团队

- 科技

- 技术

- 技术

- 技术

- 专业技术

- 文本

- 这

- 法律

- 国家

- 英国

- 世界

- 其

- 他们

- 那里。

- 博曼

- 他们

- 事

- 认为

- Free Introduction

- 本星期

- 那些

- 威胁

- 标题

- 至

- 象征

- 告诉

- 也有

- 贸易

- 转型

- 信任

- 试图

- 周二

- 助教

- Uk

- 不确定

- 下

- 破坏

- 直到

- 推出

- us

- 美国联邦

- 美国联邦贸易委员会

- 美国议员

- 美国参议院

- 用法

- 使用

- 用过的

- 使用

- 非常

- 可行性

- 受害者

- 视频

- 视频

- 在线会议

- 视觉

- 音色

- 脆弱

- 是

- 方法..

- we

- 周

- 井

- 什么是

- ,尤其是

- 这

- 而

- WHO

- 将

- 也完全不需要

- 话

- 工作

- 锻炼

- 世界

- 将

- 年

- 和风网