介绍

在机器学习中,偏差方差权衡是影响任何预测模型性能的基本概念。 它指的是模型的偏差误差和方差误差之间的微妙平衡,因为不可能同时将两者最小化。 取得正确的平衡对于实现最佳模型性能至关重要。

在这篇简短的文章中,我们将定义偏差和方差,解释它们如何影响机器学习模型,并提供一些关于如何在实践中处理它们的实用建议。

了解偏差和方差

在深入研究偏差和方差之间的关系之前,让我们定义这些术语在机器学习中代表什么。

偏差误差是指模型的预测与其试图预测的正确值(基本事实)之间的差异。 换句话说,偏差是模型由于对基础数据分布的错误假设而犯下的错误。 高偏差模型通常过于简单,无法捕捉数据的复杂性,从而导致欠拟合。

另一方面,方差误差是指模型对训练数据中微小波动的敏感性。 高方差模型过于复杂,往往会拟合数据中的噪声,而不是潜在的模式,从而导致过度拟合。 这会导致新的、看不见的数据性能不佳。

高偏差会导致欠拟合,即模型太简单而无法捕捉数据的复杂性。 它对数据做出了强有力的假设,但未能捕捉到输入和输出变量之间的真实关系。 另一方面,高方差会导致过度拟合,其中模型过于复杂并且学习数据中的噪声而不是输入和输出变量之间的潜在关系。 因此,过拟合模型往往过于紧密地拟合训练数据而不能很好地泛化到新数据,而欠拟合模型甚至不能准确地拟合训练数据。

如前所述,偏差和方差是相关的,一个好的模型会在偏差误差和方差误差之间取得平衡。 偏差方差权衡是在这两个误差源之间找到最佳平衡的过程。 具有低偏差和低方差的模型可能在训练数据和新数据上都表现良好,从而最大限度地减少总误差。

偏差方差权衡

在模型复杂性和泛化到未知数据的能力之间取得平衡是偏差方差权衡的核心。 通常,更复杂的模型将具有较低的偏差但具有较高的方差,而更简单的模型将具有较高的偏差但具有较低的方差。

由于不可能同时最小化偏差和方差,因此找到它们之间的最佳平衡对于构建稳健的机器学习模型至关重要。 例如,当我们增加模型的复杂性时,我们也会增加方差。 这是因为更复杂的模型更容易拟合训练数据中的噪声,从而导致过拟合。

另一方面,如果我们让模型过于简单,我们会增加偏差。 这是因为更简单的模型将无法捕获数据中的潜在关系,这将导致欠拟合。

目标是训练一个模型,该模型足够复杂以捕获训练数据中的潜在关系,但又不会复杂到适合训练数据中的噪声。

实践中的偏差方差权衡

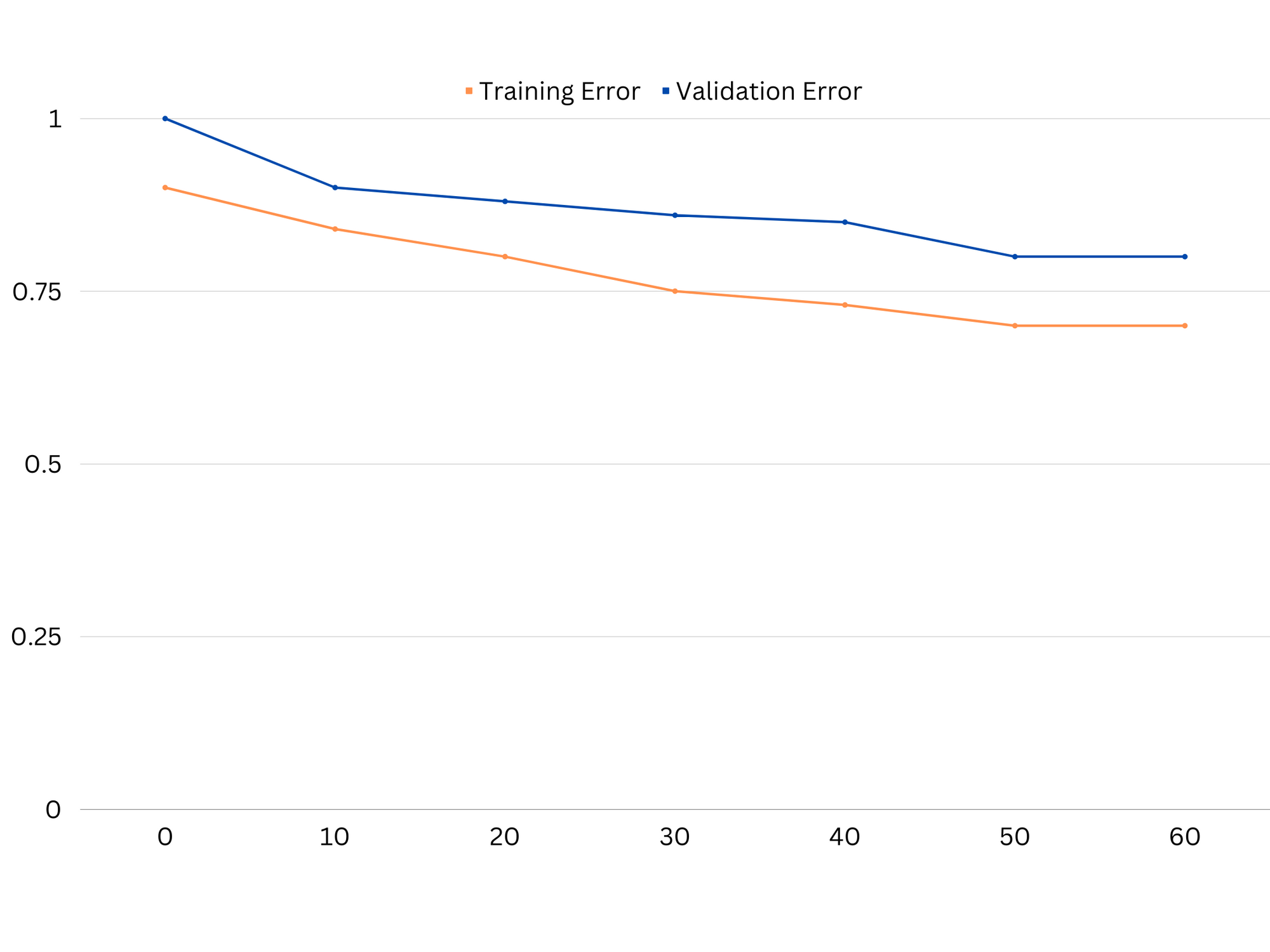

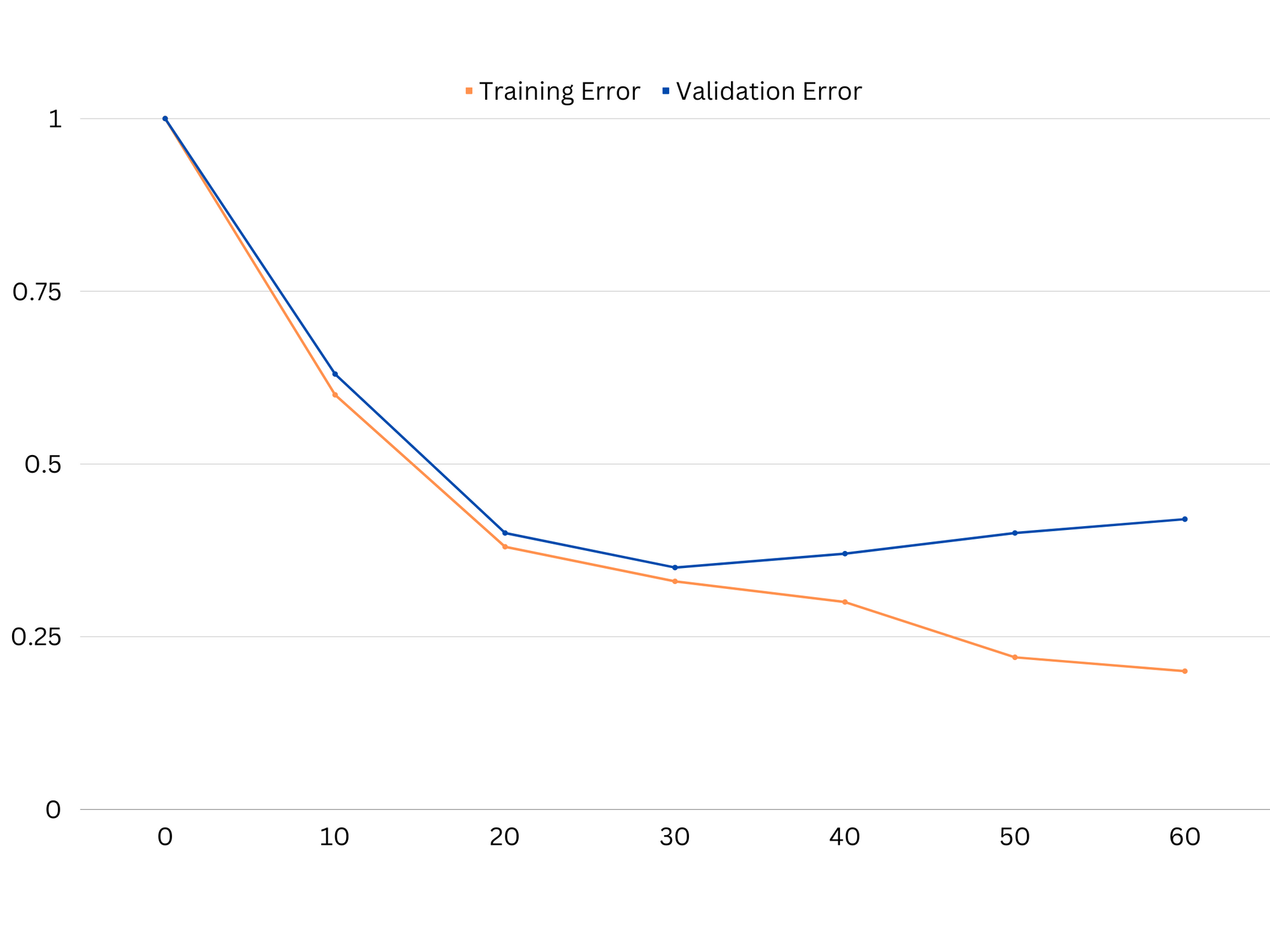

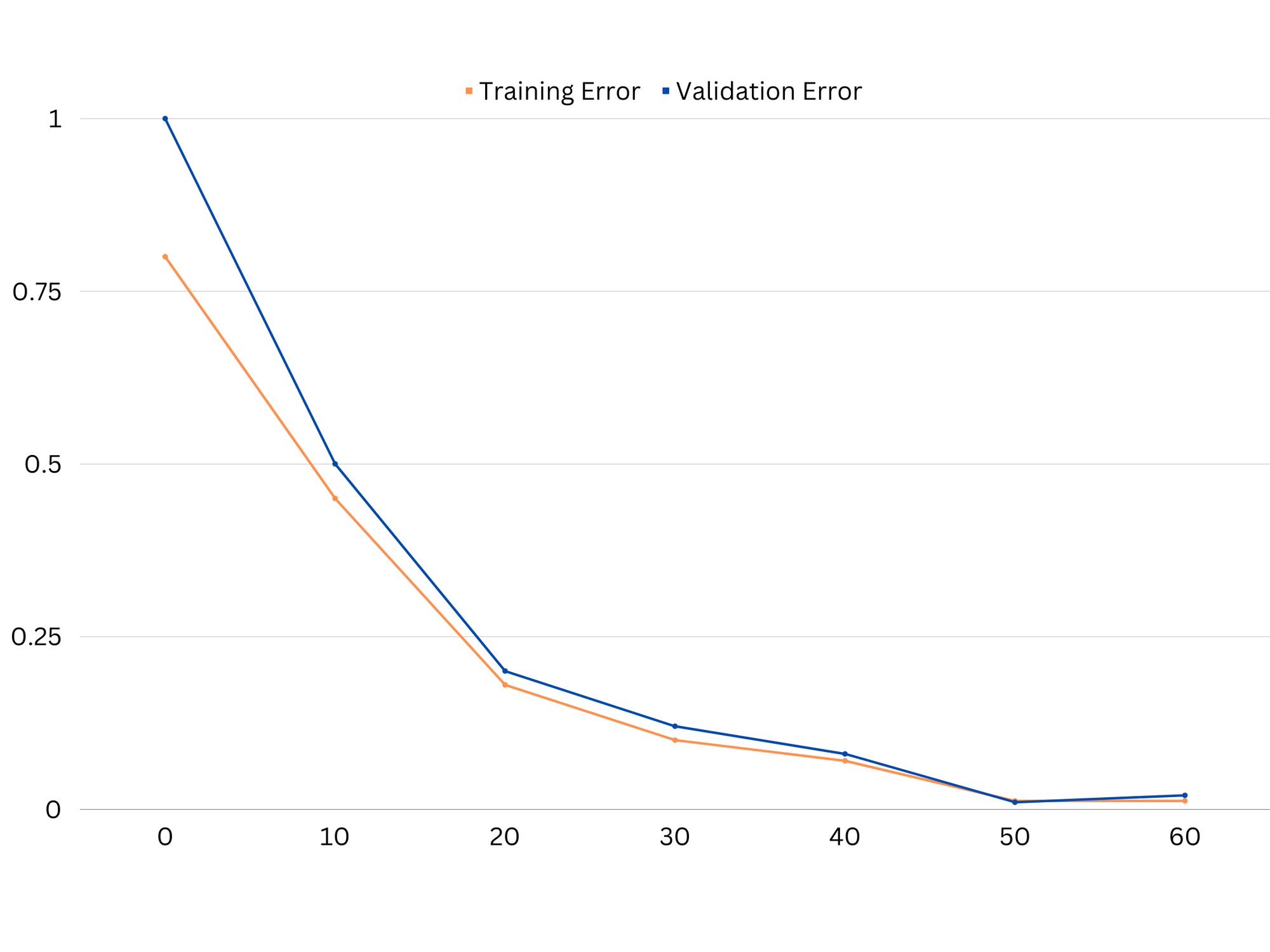

为了诊断模型性能,我们通常会计算和比较训练误差和验证误差。 一个有用的可视化工具是学习曲线图,它显示了模型在整个训练过程中在训练数据和验证数据上的性能。 通过检查这些曲线,我们可以确定模型是否过度拟合(高方差)、欠拟合(高偏差)或良好拟合(偏差和方差之间的最佳平衡)。

欠拟合模型的学习曲线示例。 训练误差和验证误差都很高。

在实践中,训练和验证数据的低性能表明模型过于简单,导致欠拟合。 另一方面,如果模型在训练数据上表现很好,但在测试数据上表现很差,那么模型复杂度可能过高,导致过拟合。 为了解决欠拟合问题,我们可以尝试通过添加更多特征、改变学习算法或选择不同的超参数来增加模型的复杂性。 在过拟合的情况下,我们应该考虑对模型进行正则化或使用交叉验证等技术来提高其泛化能力。

过度拟合模型的学习曲线示例。 训练错误减少,而验证错误开始增加。 该模型无法概括。

正则化是一种可用于减少机器学习模型中的方差误差的技术,有助于解决偏差方差权衡问题。 有许多不同的正则化技术,每种技术都有自己的优点和缺点。 一些流行的正则化技术包括岭回归、套索回归和弹性网络正则化。 所有这些技术都通过向模型的目标函数添加惩罚项来帮助防止过度拟合,这会阻止极端参数值并鼓励使用更简单的模型。

岭回归,也称为 L2 正则化,添加与模型参数的平方成比例的惩罚项。 这种技术往往会产生参数值较小的模型,从而减少方差并提高泛化能力。 但是,它不执行特征选择,因此所有特征都保留在模型中。

查看我们的 Git 学习实践指南,其中包含最佳实践、行业认可的标准以及随附的备忘单。 停止谷歌搜索 Git 命令,实际上 学习 它!

套索回归,或 L1 正则化,添加与模型参数的绝对值成比例的惩罚项。 这种技术可以产生参数值稀疏的模型,通过将一些参数设置为零来有效地执行特征选择。 这可以产生更易于解释的更简单的模型。

弹性网正则化 是 L1 和 L2 正则化的组合,允许在岭回归和套索回归之间取得平衡。 通过控制两个惩罚项之间的比例,弹性网可以实现这两种技术的好处,例如改进泛化和特征选择。

良好拟合模型的学习曲线示例。

结论

偏差方差权衡是机器学习中的一个关键概念,它决定了模型的有效性和优度。 虽然高偏差会导致欠拟合,而高方差会导致过度拟合,但找到两者之间的最佳平衡对于构建能够很好地泛化到新数据的稳健模型是必要的。

借助学习曲线,可以识别过度拟合或欠拟合问题,并且通过调整模型的复杂性或实施正则化技术,可以提高训练和验证数据以及测试数据的性能。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- 柏拉图爱流。 Web3 数据智能。 知识放大。 访问这里。

- 与 Adryenn Ashley 一起铸造未来。 访问这里。

- 使用 PREIPO® 买卖 PRE-IPO 公司的股票。 访问这里。

- Sumber: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :是

- :不是

- :在哪里

- 1

- 12

- 20

- 8

- a

- 对,能力--

- Able

- 关于

- 绝对

- 准确

- 实现

- 通

- 添加

- 地址

- 添加

- 优点

- 忠告

- 影响

- 影响

- 算法

- 所有类型

- 允许

- 还

- an

- 和

- 任何

- 保健

- 刊文

- AS

- 当前余额

- 结余

- BE

- 因为

- 好处

- 之间

- 偏见

- 边界

- 都

- 建筑物

- 但是

- by

- 计算

- CAN

- 能力

- 捕获

- 案件

- 改变

- 选择

- 密切

- 组合

- 比较

- 复杂

- 复杂

- 概念

- 考虑

- 控制

- 核心

- 正确

- 关键

- data

- 处理

- 减少

- 确定

- 确定

- 差异

- 不同

- 显示器

- 分配

- 不

- 两

- 每

- 此前

- 更容易

- 只

- 效用

- 鼓励

- 更多

- 错误

- 故障

- 甚至

- 检查

- 例子

- 说明

- 极端

- 失败

- 失败

- 专栏

- 特征

- 寻找

- 适合

- 配件

- 波动

- 专注焦点

- 针对

- 功能

- 根本

- 其他咨询

- 混帐

- 目标

- 非常好

- 陆运

- 指南

- 手

- 动手

- 有

- 帮助

- 帮助

- 高

- 更高

- 徘徊

- 创新中心

- How To

- 但是

- HTTPS

- 鉴定

- if

- 实施

- 不可能

- 改善

- 改善

- in

- 其他

- 包括

- 包括

- 增加

- 增加

- 输入

- 成

- 介绍

- IT

- 它的

- 保持

- 已知

- L1

- l2

- 铅

- 领导

- 信息

- 学习

- 让

- LG

- 喜欢

- 容易

- ll

- 低

- 降低

- 机

- 机器学习

- 制作

- 提到

- 最小化

- 模型

- 模型

- 更多

- 必要

- 净

- 全新

- 噪声

- 数

- 目标

- of

- 经常

- on

- 最佳

- or

- 其他名称

- 我们的

- 输出

- 产量

- 己

- 参数

- 参数

- 模式

- 演出

- 性能

- 执行

- 施行

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 贫困

- 热门

- 可能

- 实用

- 在练习上

- 预测

- 预测

- 防止

- 问题

- 过程

- 提供

- 宁

- 比

- 减少

- 减少

- 指

- 有关

- 关系

- 关系

- 留

- 代表

- 导致

- 导致

- 成果

- 右

- 戒指

- 健壮

- s

- 选择

- 灵敏度

- 设置

- 阴影

- 片

- 短

- 应该

- 简易

- 同时

- 小

- 小

- So

- 一些

- 来源

- 广场

- 堆栈滥用

- 标准

- Stop 停止

- 强烈

- 这样

- 提示

- 技术

- 术语

- 条款

- test

- 比

- 这

- 其

- 他们

- 那里。

- 博曼

- 他们

- Free Introduction

- 始终

- 至

- 也有

- 工具

- 合计

- 培训

- 产品培训

- 过渡

- true

- 真相

- 尝试

- 二

- 一般

- 无法

- 相关

- 不明

- 用过的

- 运用

- 验证

- 折扣值

- 价值观

- 非常

- we

- 井

- 什么是

- 是否

- 这

- 而

- 将

- 话

- 和风网

- 零