人工智能 (AI) 不仅是商业领域的最新流行语,也是商业领域的最新流行语。它正在迅速重塑行业并重新定义业务流程。然而,随着公司竞相将人工智能和机器学习 (ML) 集成到其运营的各个方面,他们也在引入 新的安全和风险挑战。由于专注于敏捷开发实践以实现竞争优势,安全性退居次席。万维网和移动应用程序的早期就是这种情况,我们在人工智能的冲刺中再次看到了这种情况。

AI 和 ML 系统的构建、训练和操作方式与传统 IT 系统、网站或应用程序的开发流程显着不同。虽然传统 IT 安全中存在的一些相同风险在 AI/ML 中仍然存在相关性,但 几个显着且具有挑战性的差异。与依赖数据库的 Web 应用程序不同,AI 应用程序由 ML 模型提供支持。构建模型的过程涉及收集、清理和提炼数据;根据数据训练 ML 模型;然后大规模运行这些模型,根据学到的知识进行推理和迭代。

传统软件和人工智能/机器学习开发在四个主要领域存在分歧。这些分别是更改状态与动态状态、规则和术语与使用和输入、代理环境与实时系统以及版本控制与来源更改。

开源 AI/ML 工具,例如 流量 和 射线,为构建模型提供方便的框架。但许多开源软件 (OSS) 工具和框架都存在开箱即用的漏洞,可能会导致严重的利用和危害。单独而言,AI/ML 库本身会创建更大的攻击面,因为它们包含大量数据和模型,而这些数据和模型的安全性取决于保存它们的 AI/ML 工具。如果这些工具遭到破坏,攻击者可以访问多个工具。数据库的机密信息、修改模型和植入恶意软件的价值。

AI/ML 设计的安全性

传统 IT 安全缺乏保护 AI/ML 系统的多项关键功能。首先是能够扫描数据科学家用来开发 AI/ML 系统构建块的工具,例如 Jupyter笔记本 和 其他工具 AI/ML 供应链中的安全漏洞。

虽然数据保护是 IT 安全的核心组成部分,但在 AI/ML 中它显得尤为重要,因为实时数据不断用于训练模型。这为攻击者操纵 AI/ML 数据打开了大门,并可能导致模型损坏且无法执行其预期功能。

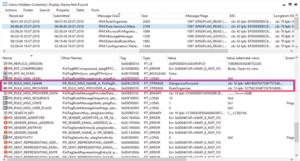

在 AI/ML 环境中,数据保护需要创建将数据链接到模型的不可变记录。因此,如果数据以任何方式修改或更改,想要重新训练模型的用户将看到哈希值(用于确保传输过程中数据的完整性)不匹配。此审计跟踪创建一条记录来跟踪数据文件的编辑时间以及数据的存储位置,以确定是否存在违规行为。

此外,需要扫描 AI/ML 模型来检测命令注入等安全威胁。这是因为模型是一种存在于内存中的资产,但是当保存到磁盘(用于分发给同事)时,该格式可以将代码注入其中。因此,虽然模型将继续像以前一样运行,但它将执行任意代码。

鉴于这些独特的挑战,以下是一些值得考虑的有用的最佳实践:

-

查找漏洞的依赖项: 情境化可见性和强大的查询工具可以实时生成所有机器学习系统的广泛视图。它应该涵盖人工智能/机器学习开发中涉及的所有供应商、云提供商和供应链资源,以提供所有依赖关系和威胁的视图。动态 ML 物料清单 (ML BOM) 可以列出所有组件和依赖项,为组织提供网络中所有 AI/ML 系统的完整来源。

-

安全云权限: 考虑到模型依赖数据进行学习,云容器泄露数据可能是人工智能安全的致命缺陷。云上扫描权限是防止数据丢失的首要任务。

-

优先考虑数据存储安全: 实施集成的安全检查、策略和门,以自动报告策略违规行为并发出警报,以增强模型安全性。

-

扫描开发工具: 就像开发操作演变成开发安全操作一样,AI/ML 开发需要将安全性构建到开发过程中,扫描开发环境和工具(例如 ML Flow)及其依赖项以查找任何漏洞,以及所有 AI/ML 模型和数据输入。

-

定期审核: 自动化工具可以提供必要的不可变账本,作为 AI/ML 环境的时间戳版本。这将支持违规情况下的取证分析,显示谁可能在何时何地违反了政策。此外,审计可以帮助更新保护措施以应对威胁形势。

为了挖掘人工智能的潜力,同时解决其固有的安全风险,组织应考虑实施上面列出的最佳实践,并开始实施 机器学习安全操作.

- :是

- :不是

- :在哪里

- $UP

- 10

- 13

- 14

- 7

- 9

- a

- 对,能力--

- 关于

- 以上

- ACCESS

- 调整

- 添加

- 另外

- 解决

- 优点

- 再次

- 敏捷

- AI

- AI / ML

- 警惕

- 所有类型

- 沿

- 还

- 改变

- 量

- an

- 分析

- 和

- 任何

- 应用领域

- 应用领域

- 使用

- 应用

- 保健

- 地区

- AS

- 财富

- At

- 攻击

- 审计

- 审计

- 自动化

- 自动

- 基于

- BE

- 因为

- 成为

- before

- 开始

- 作为

- 最佳

- 最佳实践

- 法案

- 吹氣梢

- 违反

- 建立

- 建筑物

- 建筑模型

- 建

- 商业

- 但是

- 流行词

- by

- CAN

- 能力

- 案件

- 中央

- 链

- 挑战

- 挑战

- 变

- 更改

- 支票

- 圆

- 云端技术

- 码

- 收藏

- COM的

- 公司

- 竞争的

- 元件

- 组件

- 妥协

- 考虑

- 经常

- 包含

- 集装箱

- 继续

- 控制

- 便捷

- 已损坏

- 可以

- 创建信息图

- 创建

- 创建

- data

- 数据丢失

- 数据保护

- 数据存储

- 数据库

- 数据库

- 一年中的

- 依赖

- 设计

- 检测

- 确定

- 开发

- 研发支持

- 开发工具

- DID

- 不同

- 分配

- 偏离

- 不

- 门

- ,我们将参加

- 动态

- 早

- 执行

- 确保

- 环境

- 环境中

- 所有的

- 进化

- 究竟

- 执行

- 开发

- 少数

- 文件

- 缺陷

- 流

- 专注焦点

- 针对

- 法医

- 格式

- 四

- 框架

- 止

- ,

- 功能

- 盖茨

- 生成

- 特定

- 给予

- 伤害

- 散列

- 有

- 帮助

- 相关信息

- HTTP

- HTTPS

- ICON

- if

- 一成不变

- 不可变的账本

- 实施

- 实施

- 重要性

- in

- 个别地

- 行业

- 信息

- 固有

- 输入

- 整合

- 集成

- 诚信

- 房源搜索

- 拟

- 成

- 介绍

- 参与

- ISN

- IT

- 它的安全性

- 它的

- JPG

- 只是

- 键

- 景观

- 大

- 最新

- 铅

- 学习用品

- 学习

- 分类帐

- 库

- 喜欢

- 链接

- 清单

- 已发布

- 生活

- 实时数据

- 生活

- 离

- 机

- 机器学习

- 主要

- 使

- 恶意软件

- 许多

- 大规模

- 匹配

- 物料

- 可能..

- 内存

- ML

- 联络号码

- 移动应用程序

- 模型

- 模型

- 改性

- 修改

- 许多

- 多

- 必要

- 需要

- 网络

- of

- on

- 仅由

- 打开

- 开放源码

- 操作

- 运营

- or

- 秩序

- 组织

- 组织

- 我们

- 执行

- 权限

- 管道

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 政策

- 政策

- 潜力

- 供电

- 做法

- 防止

- 优先

- 过程

- 过程

- 保护

- 保护

- 保护

- 出处

- 提供

- 供应商

- 代理

- 种族

- 急速

- RE

- 实时的

- 记录

- 重新定义

- 精制

- 经常

- 相应

- 信赖

- 报告

- 必须

- 需要

- 重塑

- 资源

- 分别

- 导致

- 风险

- 风险

- 定位、竞价/采购和分析/优化数字媒体采购,但算法只不过是解决问题的操作和规则。

- 运行

- 运行

- s

- 安全

- 同

- 保存

- 鳞片

- 浏览

- 扫描

- 科学家

- 保安

- 安全风险

- 安全威胁

- 看到

- 看到

- 严重

- 服务

- 几个

- 应该

- 显著

- 显著

- 自

- So

- 软件

- 一些

- 来源

- 采购

- 跨度

- 短跑

- 州

- 存储

- 存储

- 强烈

- 这样

- 遭遇

- 供应

- 供应链

- SUPPORT

- 磁化面

- 产品

- 滑车

- 需要

- 敲打

- 条款

- 这

- 世界

- 其

- 他们自己

- 然后

- 那里。

- 因此

- 博曼

- 他们

- Free Introduction

- 那些

- 威胁

- 威胁

- 至

- 工具

- 工具

- 追踪

- 传统

- 线索

- 培训

- 熟练

- 产品培训

- 独特

- 不像

- 更新

- 使用

- 用过的

- 用户

- 价值观

- 厂商

- 版本

- 版本

- 与

- 查看

- 违反

- 违反

- 能见度

- 漏洞

- 希望

- 是

- 方法..

- we

- 卷筒纸

- Web应用程序

- 网站

- 什么是

- ,尤其是

- 这

- 而

- WHO

- 宽

- 将

- 世界

- 价值

- 将

- 但

- 和风网