人工智能和传统计算机是天作之合。

主要原因是目前硬件芯片的设置方式。 该芯片基于传统的冯诺依曼架构,将内存存储与其主处理器隔离。 每次计算都是噩梦般的周一早上通勤,芯片不断地在每个隔间来回传输数据,形成了臭名昭著的“记忆墙设立的区域办事处外,我们在美国也开设了办事处,以便我们为当地客户提供更多的支持。“

如果您曾经遇到过交通堵塞,您就会知道其中的挫败感:这需要时间并且浪费精力。 随着人工智能算法变得越来越复杂,问题也变得越来越严重。

那么为什么不设计一款基于大脑的芯片,它可能与深度神经网络完美匹配呢?

输入内存计算(CIM)芯片。 正如它们的名字一样,这些芯片在同一地点计算和存储内存。 忘记通勤; 这些芯片是高效的在家工作替代方案,可以解决数据流量瓶颈问题,并有望实现更高的效率和更低的能耗。

或者说,这个理论也是如此。 大多数运行人工智能算法的 CIM 芯片只专注于芯片设计,通过芯片模拟来展示其功能,而不是在成熟的硬件上运行任务。 这些芯片还难以适应多种不同的人工智能任务——图像识别、语音感知——限制了它们与智能手机或其他日常设备的集成。

这个月, 一项研究 in 自然 从头开始升级 CIM。 由斯坦福大学神经拟态硬件专家 HS Philip Wong 博士和加州大学圣地亚哥分校 Gert Cauwenberghs 博士领导的国际团队并没有仅仅关注芯片的设计,而是优化了整个设置,从技术到架构,再到校准硬件的算法。

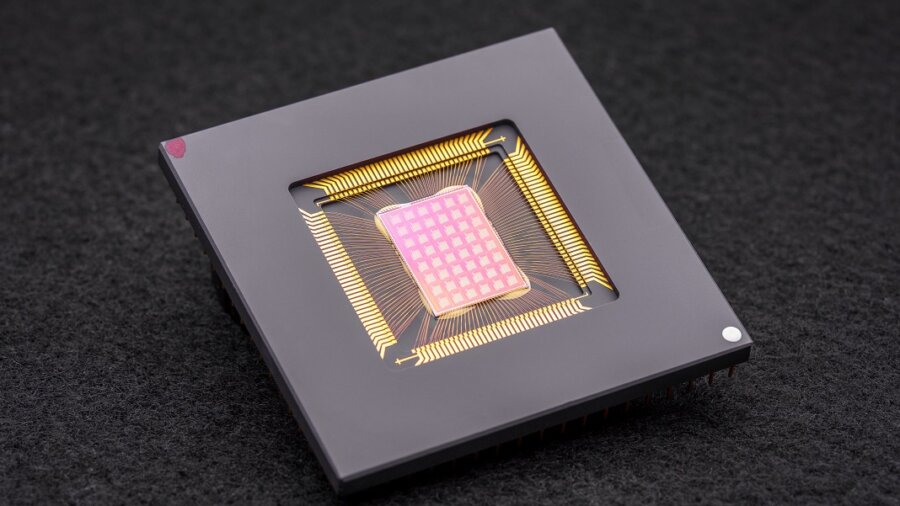

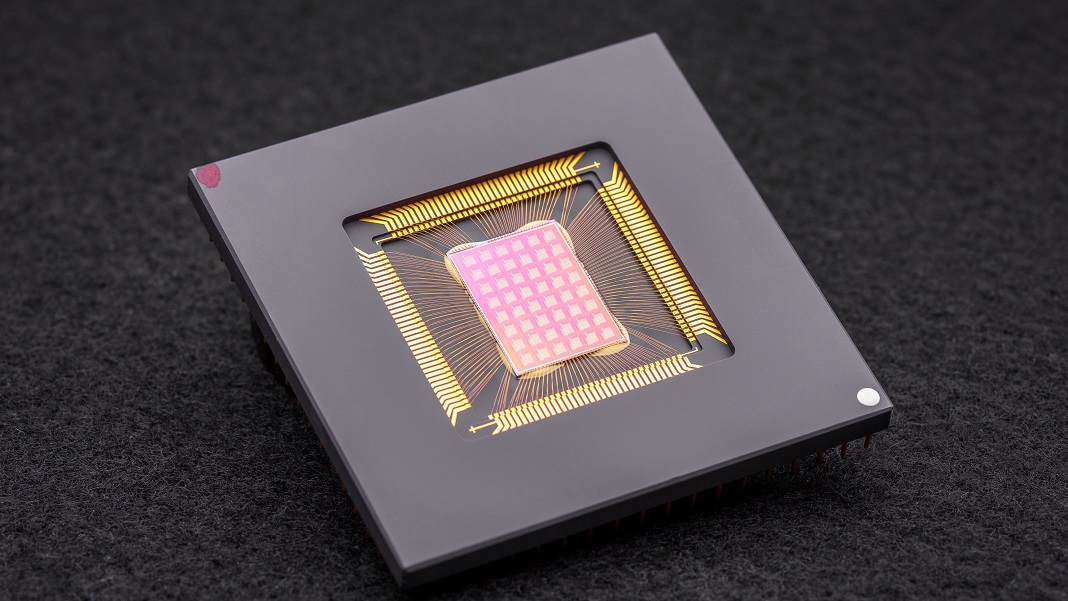

由此产生的 NeuRRAM 芯片是一个强大的神经拟态计算庞然大物,拥有 48 个并行核心和 3 万个存储单元。 该芯片用途极其广泛,能够处理多项 AI 标准任务,例如读取手写数字、识别图像中的汽车和其他物体以及解码语音记录,准确率超过 84%。

虽然成功率可能看起来平庸,但它可以与现有的数字芯片相媲美,而且可以显着节省能源。 对于作者来说,这离将人工智能直接引入我们的设备又近了一步,而无需将数据传输到云端进行计算。

“在芯片上完成这些计算,而不是向云端发送信息和从云端发送信息,可以在未来实现更快、更安全、更便宜、更具可扩展性的人工智能,并让更多人获得人工智能的力量,” 说过 黄。

神经灵感

AI专用芯片 现在已经是惊人的一毛钱了。 从谷歌的张量处理单元(TPU)和特斯拉的Dojo超级计算机架构到百度和亚马逊,科技巨头正在人工智能芯片淘金热中投资数百万美元,以构建支持日益复杂的深度学习算法的处理器。 有的甚至 利用机器学习来设计芯片架构 为AI软件量身定制,让比赛圆满结束。

一个特别有趣的概念直接来自大脑。 当数据通过我们的神经元时,它们通过称为突触的物理“码头”“连接”到网络中。 这些结构像小蘑菇一样位于神经分支的顶部,是多任务处理者:它们通过蛋白质组成的变化来计算和存储数据。

换句话说,与传统计算机不同,神经元不需要将数据从内存传输到 CPU。 这使得大脑比数字设备更具优势:它具有很高的能效,并且可以同时执行多项计算,所有计算都被封装在塞入头骨内的三磅重的果冻中。

为什么不重建大脑的各个方面呢?

输入 神经形态计算。 一种方法是使用 RRAM,即电阻式随机存取存储器设备(也称为“忆阻器”)。 即使断电,RRAM 也会通过改变硬件的电阻来存储内存。 与突触类似,这些组件可以在很小的区域内封装成密集阵列,从而创建能够进行高度复杂计算而无需体积的电路。 当与 CMOS(一种在我们当前的微处理器和芯片中构建电路的制造工艺)相结合时,这对组合 变得更加强大 用于运行深度学习算法。

但这是有代价的。 作者表示:“RRAM-CIM 架构中的高度并行模拟计算带来了卓越的效率,但实现与数字电路相同水平的功能灵活性和计算精度具有挑战性。”

优化精灵

这项新研究深入研究了 RRAM-CIM 芯片的每个部分,并重新设计以供实际使用。

这要从技术开始。 NeuRRAM 拥有 48 个并行计算核心,RRAM 设备在物理上交织到 CMOS 电路中。 与神经元一样,每个核心在不使用时都可以单独关闭,从而在其内存存储在 RRAM 上的同时节省能量。

这些 RRAM 单元(总共 XNUMX 万个)相互连接,以便数据可以双向传输。 作者解释说,这是一个至关重要的设计,使芯片能够灵活地适应多种不同类型的人工智能算法。 例如,深度神经网络的一种,CNN(卷积神经网络),在计算机视觉方面特别出色,但需要数据在单一方向上流动。 相比之下,LSTM(一种常用于音频识别的深度神经网络)会循环处理数据以将信号与时间进行匹配。 与突触一样,该芯片对一个 RRAM“神经元”与另一个 RRAM“神经元”的连接强度进行编码。

这种架构使得微调数据流以最大限度地减少交通拥堵成为可能。 就像将单通道流量扩展到多通道一样,该芯片可以复制网络当前大多数计算密集型问题的“内存”,以便多个核心同时分析问题。

对以前的 CIM 芯片的最后改进是在类脑计算(通常是模拟计算)和数字处理之间架起更坚固的桥梁。 这里,该芯片使用了神经元电路,可以轻松地将模拟计算转换为数字信号。 作者解释说,这比之前的“耗电和耗电”设置有了进步。

优化成功了。 为了测试他们的理论,该团队制造了 NeuRRAM 芯片并开发了算法,为不同的算法(例如运行不同游戏的 Play Station 5)对硬件进行编程。

在众多基准测试中,该芯片的表现堪称冠军。 NeuRRAM 在芯片上运行七层 CNN,使用流行的 MNIST 数据库识别手写数字时的错误率低于百分之一。

它在更困难的任务上也表现出色。 当加载另一个流行的深度神经网络 LSTM 时,该芯片在接受 Google 语音命令识别挑战时的正确率约为 85%。 该芯片在另一种人工智能架构上运行,仅使用八个内核,就能够恢复噪声图像,将错误减少大约 70%。

那又怎样?

一个词:能量。

大多数人工智能算法都是能源消耗者。 NeuRRAM 的运行能源成本是之前最先进的 RRAM-CIM 芯片的一半,进一步将神经形态计算节能的承诺变为现实。

但这项研究的突出之处在于它的策略。 在设计芯片时,科学家常常需要平衡多项任务的效率、多功能性和准确性,而这些指标往往相互矛盾。 当所有计算都直接在硬件上完成时,问题会变得更加困难。 NeuRRAM 证明了同时对抗所有野兽是可能的。

这里使用的策略可用于优化其他神经形态计算设备,例如 相变存储技术s,作者说。

目前,NeuRRAM 是一个概念验证,表明物理芯片(而不是它的模拟)可以按预期工作。 但仍有改进的空间,包括进一步扩展 RRAM 并将其尺寸缩小到有一天可能适合我们的手机。

“也许今天它被用来执行简单的人工智能任务,例如关键字识别或人体检测,但明天它可以实现完全不同的用户体验。 想象一下实时视频分析与语音识别相结合,一切都在一个微型设备中。” 说过 研究作者万维尔博士。 “作为一名研究人员和工程师,我的目标是将实验室的研究创新成果付诸实践。”

图片来源: David Baillot/加州大学圣地亚哥分校