机器学习 (ML) 模型的规模——大型语言模型 (法学硕士)和基础模型(调频)––逐年快速增长,这些模型需要更快、更强大的加速器,特别是对于生成式人工智能。 AWS Inferentia2 旨在提供更高的性能,同时降低法学硕士和生成式人工智能推理的成本。

在这篇文章中,我们展示第二代 AWS Inferentia 如何基于 AWS Inferentia1 引入的功能构建,并满足部署和运行 LLM 和 FM 的独特需求。

第一代 AWS Inferentia 是 2019 年推出的专用加速器,经过优化以加速深度学习推理。 AWS Inferentia 帮助 ML 用户降低推理成本并提高预测吞吐量和延迟。 借助 AWS Inferentia1,与同类推理优化相比,客户的吞吐量提高了 2.3 倍,每次推理成本降低了 70% 亚马逊弹性计算云 (Amazon EC2)实例。

AWS Inferentia2,新版本中的特色 Amazon EC2 Inf2实例 并支持在 亚马逊SageMaker,针对大规模生成式 AI 推理进行了优化,并且是 AWS 的第一个专注于推理的实例,该实例针对分布式推理进行了优化,在加速器之间具有高速、低延迟的连接。

现在,您可以在单个 Inf175 实例上高效部署包含 2 亿个参数的模型,以跨多个加速器进行推理,而无需昂贵的训练实例。 到目前为止,拥有大型模型的客户只能使用为训练而构建的实例,但这是一种资源浪费——因为它们更昂贵,消耗更多能源,而且他们的工作负载没有充分利用所有的资源。可用资源(例如更快的网络和存储)。 与 AWS Inferentia2 相比,借助 AWS Inferentia4,您的吞吐量可提高 10 倍,延迟可降低多达 1 倍。 此外,第二代 AWS Inferentia 增强了对更多数据类型、自定义运算符、动态张量等的支持。

AWS Inferentia2 的内存容量是 AWS Inferentia4 的 16.4 倍,内存带宽是 AWS Inferentia1 的 XNUMX 倍,并且原生支持跨多个加速器对大型模型进行分片。 加速器使用 NeuronLink 和神经元集体通信 最大限度地提高它们之间或加速器和网络适配器之间的数据传输速度。 AWS Inferentia2 更适合需要跨多个加速器进行分片的大型模型,尽管 AWS Inferentia1 仍然是小型模型的绝佳选择,因为与替代方案相比,它提供了更好的性价比。

架构演进

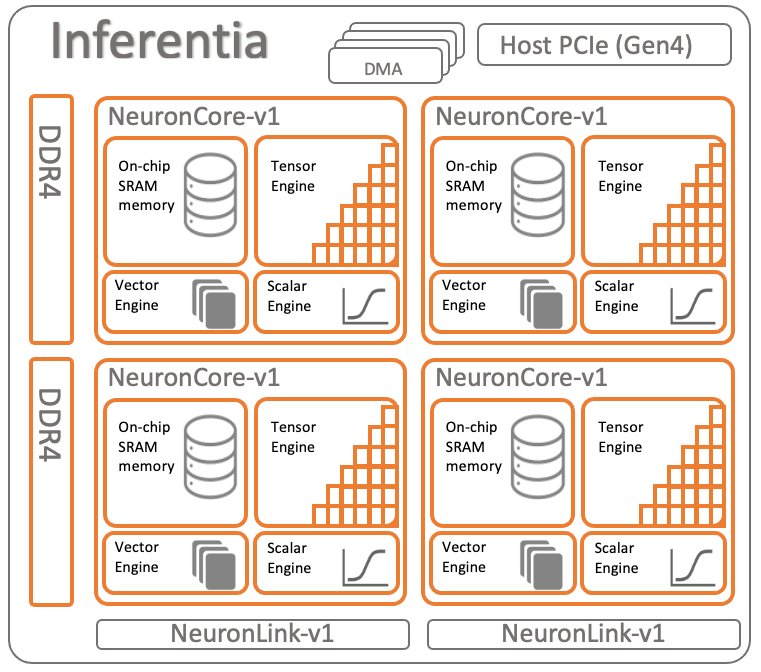

为了比较两代 AWS Inferentia,我们来回顾一下 AWS Inferentia1 的架构。 每个芯片有四个 NeuronCore v1,如下图所示。

每个芯片的规格:

- 计算 – 四核总共提供 128 INT8 TOPS 和 64FP16/BF16 TFLOPS

- 内存 – 8 GB DRAM(50 GB/秒带宽),由所有四个核心共享

- 神经元链接 – 核心之间的链接,用于跨两个或更多核心的分片模型

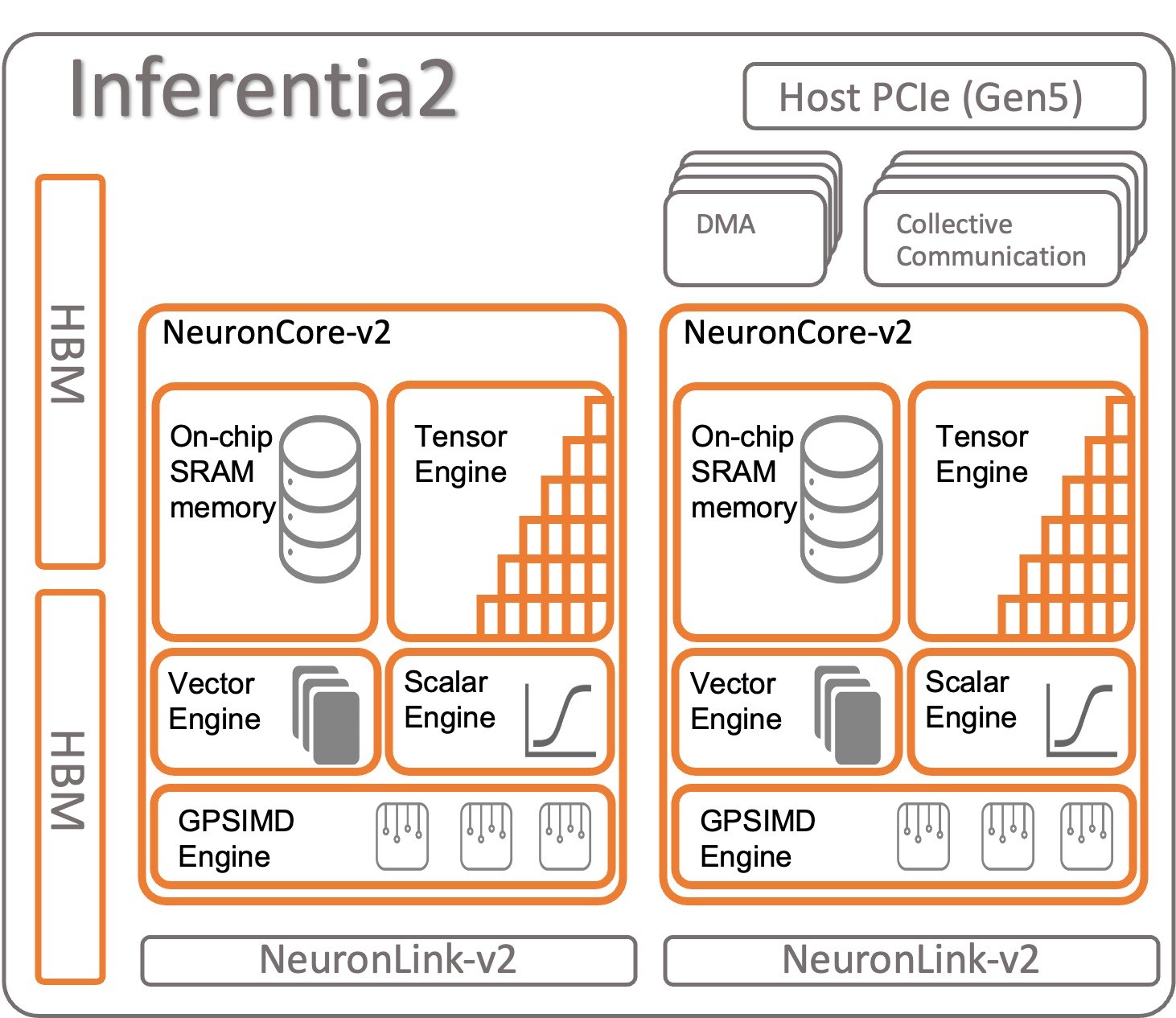

让我们看看 AWS Inferentia2 是如何组织的。 每个 AWS Inferentia2 芯片都有两个基于 NeuronCore-v2 架构。 与 AWS Inferentia1 一样,您可以在每个 NeuronCore 上运行不同的模型,或者组合多个核心来对大模型进行分片。

每个芯片的规格:

- 计算 – 两个内核总共提供 380 INT8 TOPS、190 FP16/BF16/cFP8/TF32 TFLOPS 和 47.5 FP32 TFLOPS

- 内存 – 32 GB HBM,由两个核心共享

- 神经元链接 – 芯片之间的链接(每个设备 384 GB/秒),用于跨两个或更多核心的分片模型

NeuronCore-v2 有一个 具有四个独立发动机的模块化设计:

- ScalarEngine(比 v3 快 1 倍) – 运行浮点数 ––1600 (BF16/FP16) FLOPS

- VectorEngine(比 v10 快 1 倍) – 通过单一运算对数字向量进行运算,以进行归一化、池化等计算。

- TensorEngine(比 v6 快 1 倍) – 执行张量计算,例如 Conv、Reshape、Transpose 等。

- GPSIMD引擎 – 拥有八个完全可编程的 512 位宽通用处理器,供您创建您的 自定义运算符 标准 PyTorch 自定义 C++ 运算符 API。 这是 NeuronCore-v2 中引入的一项新功能。

AWS Inferentia2 NeuronCore-v2 速度更快、更优化。 此外,它还能够加速不同类型和规模的模型,从 ResNet 50 等简单模型到 GPT-3(175 亿个参数)等具有数十亿参数的大型语言模型或基础模型。 与 AWS Inferentia2 相比,AWS Inferentia1 还具有更大、更快的内部内存,如下表所示。

| 芯片 | 神经元核心 | 内存类型 | 内存大小 | 内存带宽 |

| AWS 推理 | x4(v1) | DDR4 | 8GB | 50GB/秒 |

| AWS 推理 2 | x2(v2) | HBM | 32GB | 820GB/秒 |

您在 AWS Inferentia2 中找到的内存是高带宽内存 (HBM) 类型。 每个 AWS Inferentia2 芯片都有 32 GB,可以与其他芯片结合使用 NeuronLink(设备到设备互连)分发非常大的模型。 例如,inf2.48xlarge 拥有 12 个 AWS Inferentia2 加速器,加速内存总计 384 GB。 如上表所示,AWS Inferentia2 内存的速度比 AWS Inferentia16.4 快 1 倍。

其他功能

AWS Inferentia2 提供以下附加功能:

- 硬件支持 – cFP8(新的、可配置的 FP8)、FP16、BF16、TF32、FP32、INT8、INT16 和 INT32。 欲了解更多信息,请参阅 数据类型.

- 惰性张量推理 - 我们讨论 惰性张量推理 在这篇文章的后面。

- 自定义运算符 – 开发人员可以使用标准 PyTorch 自定义运算符编程接口来使用 自定义 C++ 运算符 特征。 自定义运算符由可用的低级原语组成 张量工厂函数 并由 GPSIMD-Engine 加速。

- 控制流(即将推出) – 这是用于模型内部的本机编程语言控制流,最终对从一层到另一层的数据进行预处理和后处理。

- 动态形状(即将推出) – 当您的模型动态更改任何内部层的输出形状时,这非常有用。 例如:根据输入数据减少模型内部输出张量大小或形状的过滤器。

加速 AWS Inferentia1 和 AWS Inferentia2 上的模型

AWS 神经元开发工具包 用于编译和运行您的模型。 它与 PyTorch 和 TensorFlow 原生集成。 这样,您就不需要运行额外的工具。 使用在这些 ML 框架之一中编写的原始代码,并通过几行代码更改,您就可以使用 AWS Inferentia。

让我们看看如何使用 PyTorch 在 AWS Inferentia1 和 AWS Inferentia2 上编译和运行模型。

从 torchvision 加载预训练模型 (ResNet 50)

加载一个预先训练的模型并运行一次以预热:

在 Inferentia1 上跟踪和部署加速模型

要将模型跟踪到 AWS Inferentia,请导入 torch_neuron 并调用跟踪功能。 请记住,模型需要 PyTorch Jit 可追踪才能工作。

跟踪过程结束时,将模型保存为普通 PyTorch 模型。 编译模型一次,然后根据需要多次加载。 Neuron SDK 运行时已集成到 PyTorch 中,并负责自动将运算符发送到 AWS Inferentia1 芯片以加速您的模型。

在你的推理代码中,你总是需要导入 torch_neuron 激活集成运行时。

你可以通过 附加参数 给编译器定制优化模型的方式或启用特殊功能,例如神经元管道核心。 将模型分片到多个核心以提高吞吐量。

在 Inferentia2 上跟踪和部署加速模型

对于 AWS Inferentia2,过程类似。 唯一的区别是您导入的包以 x 结尾: torch_neuronx。 Neuron SDK 会透明地为您处理模型的编译和运行。 您还可以通过 编译器的附加参数 微调操作或激活特定功能。

AWS Inferentia2 还提供了第二种运行模型的方法,称为 惰性张量推理。 在此模式下,您之前无需跟踪或编译模型; 相反,编译器会在您每次运行代码时即时运行。 考虑到跟踪模式有 很多优点 通过惰性张量推理。 但是,如果您仍在开发模型并需要更快地测试它,那么惰性张量推理可能是一个不错的选择。 以下是如何使用 Lazy Tensor 编译和运行模型:

现在您已经熟悉了 AWS Inferentia2,下一步最好是开始使用 PyTorch or Tensorflow 并了解如何设置开发环境并运行教程和示例。 另外,请检查 AWS Neuron 示例 GitHub 存储库,您可以在其中找到有关如何准备模型以在 Inf2、Inf1 和 Trn1 上运行的多个示例。

AWS Inferentia1 和 AWS Inferentia2 之间的功能比较摘要

AWS Inferentia2 编译器是 基于XLA,AWS 是 OpenXLA 倡议。 这是与 AWS Inferentia1 相比的最大区别,这是相关的,因为 PyTorch、TensorFlow 和 JAX 具有本机 XLA 集成。 XLA 带来了许多性能改进,因为它优化了图形以在单个内核启动中计算结果。 它将连续的张量运算融合在一起,并输出最佳的机器代码,以加速模型在 AWS Inferentia2 上的运行。 Neuron SDK 的其他部分也在 AWS Inferentia2 中得到了改进,同时在跟踪和运行模型时保持用户体验尽可能简单。 下表显示了编译器和运行时两个版本中可用的功能。

| 专栏 | 火炬神经元 | 火炬神经元 |

| 张量板 | 有 | 有 |

| 支持的实例 | 信息1 | Inf2 和 Trn1 |

| 推理支持 | 有 | 有 |

| 培训支持 | 没有 | 有 |

| 建筑 | NeuronCore-v1 | NeuronCore-v2 |

| 追踪API | torch_neuron.trace() | torch_neuronx.trace() |

| 分布式推理 | 神经元核心管道 | 集体通讯 |

| IR | 图定义 | LO |

| 编译器 | 神经元CC | 神经元CC |

| 灭菌监测 | 神经元监视器 / 监视器顶部 | 神经元监视器 / 监视器顶部 |

更详细的比较 torch-neuron (Inf1) 和 torch-neuronx (Inf2),参考 torch-neuron (Inf1) 与 torch-neuronx (Inf2 & Trn1) 的推理比较.

模特服务

跟踪模型以部署到 Inf2 后,您有许多部署选项。 您可以以不同的方式运行实时预测或批量预测。 Inf2 可用是因为 EC2 实例本机集成到使用 InfXNUMX 的其他 AWS 服务 深度学习容器 (DLC)例如 亚马逊弹性容器服务 (亚马逊 ECS), Amazon Elastic Kubernetes服务 (Amazon EKS)和 SageMaker。

AWS Inferentia2 与最流行的部署技术兼容。 以下是使用 AWS Inferentia2 部署模型的一些选项的列表:

- SageMaker – 用于准备数据以及构建、训练和部署机器学习模型的完全托管服务

- 火炬服务 – PyTorch集成部署机制

- TensorFlow服务 – TensorFlow集成部署机制

- 深度Java库 – 用于模型部署和训练的开源Java机制

- 海卫一 – 用于模型部署的 NVIDIA 开源服务

基准

下表重点介绍了 AWS Inferentia2 相对于 AWS Inferentia1 的改进。 具体来说,我们测量延迟(模型使用每个加速器进行预测的速度)、吞吐量(每秒进行多少次推理)和每次推理的成本(每次推理的成本是多少美元)。 以毫秒为单位的延迟和以美元为单位的成本越低越好。 吞吐量越高越好。

这个过程中使用了两个模型——都是大型语言模型:ELECTRA Large Discriminator 和 BERT Large Uncased。 本实验中使用的主要库 PyTorch (1.13.1) 和 Hugging Face Transformers (v4.7.0) 在 Python 3.8 上运行。 编译批量大小 = 1 和 10 的模型后(使用上一节中的代码作为参考),每个模型都进行预热(调用一次以初始化上下文),然后连续调用 10 次。 下表显示了这个简单基准测试中收集的平均数字。

| 型号名称 | 批量大小 | 句子长度 | 延迟(ms) | Inf2 相对于 Inf1 的改进(x 倍) | 吞吐量(每秒推理次数) | 每次推理成本 (EC2 us-east-1) ** | |||

| 信息1 | 信息2 | 信息1 | 信息2 | 信息1 | 信息2 | ||||

| ElectraLarge鉴别器 | 1 | 256 | 35.7 | 8.31 | 4.30 | 28.01 | 120.34 | $0.0000023 | $0.0000018 |

| ElectraLarge鉴别器 | 10 | 256 | 343.7 | 72.9 | 4.71 | 2.91 | 13.72 | $0.0000022 | $0.0000015 |

| BertLargeUncased | 1 | 128 | 28.2 | 3.1 | 9.10 | 35.46 | 322.58 | $0.0000018 | $0.0000007 |

| BertLargeUncased | 10 | 128 | 121.1 | 23.6 | 5.13 | 8.26 | 42.37 | $0.0000008 | $0.0000005 |

* c6a.8xlarge 本次基准测试中使用了 32 个 AMD Epyc 7313 CPU。

**EC2 1 月 20 日在 us-east-XNUMX 公开定价:inf2.xlarge:0.7582 美元/小时; inf1.xlarge:0.228 美元/小时。 每次推理成本考虑批次中每个元素的成本。 (每次推理的成本等于模型调用/批量大小的总成本。)

有关训练和推理性能的更多信息,请参阅 Trn1/Trn1n 性能.

结论

AWS Inferentia2 是一项强大的技术,旨在提高深度学习模型推理的性能并降低成本。 它比 AWS Inferentia1 性能更高,与其他同类推理优化 EC4 实例相比,吞吐量提高了 10 倍,延迟降低了 50 倍,性能功耗比提高了 2%。 最终,您支付更少,申请更快,并实现您的可持续发展目标。

将推理代码迁移到 AWS Inferentia2 既简单又直接,它还支持更广泛的模型,包括大型语言模型和生成 AI 的基础模型。

您可以按照以下步骤开始 AWS Neuron 开发工具包文档 设置开发环境并启动您的加速深度学习项目。 为了帮助您入门,Hugging Face 为其添加了 Neuron 支持 最佳 库,它优化模型以加快训练和推理速度,并且有许多示例任务可供在 Inf2 上运行。 另外,请检查我们的 使用大型模型推理容器在 AWS Inferentia2 上部署大型语言模型 了解如何使用模型推理容器将 LLM 部署到 AWS Inferentia2。 有关其他示例,请参阅 AWS Neuron 示例 GitHub 存储库.

关于作者

萨米尔·阿劳霍(SamirAraújo) 是AWS的AI / ML解决方案架构师。 他帮助客户创建AI / ML解决方案,以使用AWS解决其业务挑战。 他一直从事与计算机视觉,自然语言处理,预测,边缘ML等有关的多个AI / ML项目。 他喜欢在业余时间玩硬件和自动化项目,并且对机器人技术特别感兴趣。

萨米尔·阿劳霍(SamirAraújo) 是AWS的AI / ML解决方案架构师。 他帮助客户创建AI / ML解决方案,以使用AWS解决其业务挑战。 他一直从事与计算机视觉,自然语言处理,预测,边缘ML等有关的多个AI / ML项目。 他喜欢在业余时间玩硬件和自动化项目,并且对机器人技术特别感兴趣。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- EVM财务。 去中心化金融的统一接口。 访问这里。

- 量子传媒集团。 IR/PR 放大。 访问这里。

- 柏拉图爱流。 Web3 数据智能。 知识放大。 访问这里。

- Sumber: https://aws.amazon.com/blogs/machine-learning/aws-inferentia2-builds-on-aws-inferentia1-by-delivering-4x-higher-throughput-and-10x-lower-latency/

- :具有

- :是

- :在哪里

- $UP

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 16

- 2019

- 224

- 32

- 50

- 7

- 8

- a

- 关于

- 加快

- 加速

- 加速

- 加速器

- 加速器

- 横过

- 添加

- 额外

- 附加信息

- 添加

- 后

- 再次

- AI

- AI / ML

- 所有类型

- 已经

- 还

- 替代

- 替代品

- 尽管

- 时刻

- Amazon

- Amazon EC2

- 亚马逊网络服务

- AMD公司

- an

- 和

- 另一个

- 任何

- 应用领域

- 的途径

- 四月

- 架构

- 保健

- AS

- At

- 自动

- 自动化和干细胞工程

- 可使用

- AWS

- AWS 推理

- 背部

- 带宽

- 基于

- BE

- 因为

- 很

- 基准

- 更好

- 之间

- 大

- 最大

- 亿

- 十亿美元

- 都

- 带来

- 更广泛

- 建立

- 建立

- 建

- 商业

- 但是

- by

- C + +中

- 被称为

- CAN

- 可以得到

- 能力

- 能力

- 容量

- 关心

- 挑战

- 更改

- 查

- 芯片

- 碎屑

- 码

- 集体

- 结合

- 结合

- 未来

- 即将公开信息

- 可比

- 比较

- 相比

- 对照

- 兼容

- 由

- 计算

- 计算

- 一台

- 计算机视觉

- 连接方式

- 考虑

- 消耗

- 容器

- 集装箱

- 上下文

- 控制

- 核心

- 价格

- 成本

- 可以

- 创建信息图

- 创造

- 习俗

- 合作伙伴

- 定制

- data

- 深

- 深入学习

- 交付

- 交付

- 需求

- 部署

- 部署

- 部署

- 设计

- 设计

- 详细

- 开发

- 开发

- 发展

- 研发支持

- 设备

- 差异

- 不同

- 讨论

- 分发

- 分布

- 不会

- 美元

- 不

- 别

- 动态

- 动态

- 每

- 边缘

- 有效

- element

- enable

- 结束

- 结束

- 能源

- 增强

- 环境

- 等于

- 特别

- 终于

- 所有的

- 例子

- 昂贵

- 体验

- 实验

- 面部彩妆

- 工厂

- 熟悉

- 高效率

- 快

- 专栏

- 精选

- 特征

- 少数

- 过滤

- 找到最适合您的地方

- 姓氏:

- 第一代

- 漂浮的

- 流

- 重点

- 以下

- 针对

- 基金会

- 四

- 框架

- Free

- 止

- 充分

- 功能

- 功能

- 未来

- 一般用途

- 代

- 代

- 生成的

- 生成式人工智能

- 得到

- GitHub上

- 特定

- Go

- 理想中

- 非常好

- 图形

- 大

- 陆运

- 成长

- 民政事务总署

- 硬件

- 有

- he

- 帮助

- 帮助

- 帮助

- 相关信息

- 更高

- 亮点

- 他的

- 创新中心

- How To

- 但是

- HTML

- HTTP

- HTTPS

- if

- 进口

- 改善

- 改善

- 改善

- 改善

- in

- 包含

- 增加

- 独立

- 信息

- 倡议

- 输入

- 内

- 例

- 代替

- 集成

- 集成

- 兴趣

- 接口

- 内部

- 介绍

- 调用

- IT

- 爪哇岛

- JIT

- JPG

- 只是

- 保持

- 保持

- 语言

- 大

- 大规模

- 大

- 潜伏

- 后来

- 发射

- 推出

- 层

- 学习用品

- 学习

- 减

- 库

- 自学资料库

- 喜欢

- 喜欢

- 线

- 友情链接

- 清单

- 加载

- 看

- 降低

- 一蹴即至

- 机

- 机器学习

- 主要

- 使

- 管理

- 许多

- 生产力

- 衡量

- 机制

- 满足

- 会见

- 内存

- 迁移

- 介意

- ML

- 时尚

- 模型

- 模型

- 更多

- 最先进的

- 最受欢迎的产品

- MS

- 许多

- 多

- 本地人

- 自然

- 自然语言处理

- 需求

- 需要

- 网络

- 工业网络

- 全新

- 下页

- 正常

- 现在

- 数字

- Nvidia公司

- of

- 优惠精选

- on

- 一

- 仅由

- 开放源码

- 运营

- 操作

- 运营

- 操作者

- 运营商

- 最佳

- 优化

- 优化

- 附加选项

- 附加选项

- or

- 举办

- 原版的

- 其他名称

- 其它

- 我们的

- 产量

- 超过

- 包

- 参数

- 部分

- 特别

- 部分

- 通过

- 性能

- 施行

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 播放

- 点

- 热门

- 可能

- 帖子

- 强大

- 预测

- 预测

- Prepare

- 以前

- 先前

- 价格

- 过程

- 处理

- 处理器

- 生产

- 代码编程

- 项目

- 项目

- 提供

- 国家

- 蟒蛇

- pytorch

- 范围

- 准备

- 实时的

- 建议

- 减少

- 减少

- 减少

- 有关

- 相应

- 要求

- 资源

- 提供品牌战略规划

- 成果

- 检讨

- 机器人

- 行

- 运行

- 运行

- sagemaker

- 保存

- 保存

- 锯

- SDK

- 其次

- 第二代

- 部分

- 看到

- 提交

- 发送

- 服务

- 特色服务

- 集

- 几个

- 形状

- 分片

- 共用的,

- 显示

- 如图

- 作品

- 类似

- 简易

- 单

- 尺寸

- 尺寸

- 小

- 解决方案

- 解决

- 一些

- 或很快需要,

- 特别

- 具体的

- 特别是

- 速度

- 标准

- 开始

- 开始

- 步

- 仍

- 存储

- 简单的

- 这样

- SUPPORT

- 支持

- 支持

- 永续发展

- 表

- 需要

- 任务

- 技术

- 专业技术

- tensorflow

- test

- 比

- 这

- 图

- 其

- 他们

- 然后

- 博曼

- 他们

- Free Introduction

- 吞吐量

- 次

- 时

- 至

- 一起

- 工具

- 上衣

- 火炬

- 火炬视

- 合计

- 追踪

- 可追溯的

- 追踪

- 培训

- 产品培训

- 转让

- 变形金刚

- 透明地

- 教程

- 二

- 类型

- 类型

- 独特

- 直到

- 升级

- us

- 美元

- 使用

- 用过的

- 用户

- 用户体验

- 用户

- 运用

- v1

- 各种

- 与

- 非常

- 愿景

- 温暖

- 是

- 废物回收

- 方法..

- 方法

- we

- 卷筒纸

- Web服务

- 为

- ,尤其是

- 这

- 而

- WHO

- 宽

- 维基百科上的数据

- 将

- 也完全不需要

- 工作

- 加工

- 书面

- X

- XM

- 完全

- 您一站式解决方案

- 和风网