由于欺诈者可以畅通无阻地访问 ChatGPT,Techradar,互联网上的诈骗现在可能变得更加危险 报告.

广受欢迎的人工智能聊天机器人 ChatGPT 不断成为头条新闻。 ChatGPT 凭借其编写从调试 iframe 代码到复杂计算机编程代码的一切能力,已将 AI 确立为年度技术流行语。

尽管具有巨大的知名度和参与度,但 ChatGPT 引发了对道德和监管的担忧。

也可以参考: ChatGPT 用户“越狱”AI,释放 Dan Alter Ego

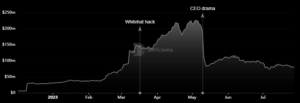

最近 报告 由诺顿实验室的网络安全研究人员发布,列出了威胁行为者滥用 ChatGPT 的三种主要方式。 该报告指出,ChatGPT 可能被滥用,以更有效的方式进行互联网诈骗:通过深度伪造内容生成、网络钓鱼创建和恶意软件创建。

“诺顿实验室预计诈骗者也在关注大型语言模型的能力和测试方法,以增强他们的网络犯罪,使他们更加真实可信,”报告称。

该工具能够产生“大规模的高质量错误信息或虚假信息”,可以帮助机器人农场更有效地加剧不和。 诺顿表示,这可以让恶意行为者毫不费力地“用多种语言灌输怀疑和操纵叙述”。

极具说服力的“错误信息”

以令人信服的方式编写商业计划、战略和公司描述对于 ChatGPT 来说是儿戏。 然而,这种可能性也增加了错误信息的风险,可能会变成骗局。

“不仅 ChatGPT 生成的内容有时会无意中不正确,而且不良行为者还可以使用这些工具故意创建用于以某种方式伤害人们的内容,”报告称。

它产生“大规模高质量错误信息或虚假信息的能力可能会导致不信任并影响不同语言的叙述。”

使用 ChatGPT 撰写产品评论变得越来越容易,但无法跟踪,因为它每次都会使用相同的提供信息生成单独的回复。 尽管它有能力,但它提出了“发现虚假评论和伪劣产品”的挑战。

令人担忧的是,该工具也可能被用于欺凌。

报告指出:“在社交媒体的骚扰活动中使用这些工具来压制或恐吓人们也是一种可能的结果,会对言论产生寒蝉效应。”

网络钓鱼活动中的 ChatGPT

ChatGPT 特别擅长用不同的语言生成听起来像人类的文本,读者不知道文本是由人工智能还是人类生成的。 即使是 ChatGPT 的开发者 OpenAI,也无法识别文本是否由 AI 编写,并表示“不可能可靠地检测到所有 AI 编写的文本”。

ChatGPT 被用于网络钓鱼活动的前景是真实存在的。

“恶意行为者可以使用 ChatGPT 制作看似来自合法来源的网络钓鱼电子邮件或社交媒体帖子,这使得检测和防御这些类型的威胁变得更加困难,”报告称。

随着其受欢迎程度的增加,一个可能的必然结果是“网络钓鱼活动及其复杂性”的数量增加。

该报告建议,“恶意行为者可以向 ChatGPT 提供来自他们想要冒充的公司的非恶意消息的真实示例,并命令 AI 基于相同的恶意意图创建新的消息。”

事实证明,此类活动在欺骗个人披露个人信息或向犯罪实体汇款方面非常成功。 诺顿实验室建议消费者在“点击链接或提供个人信息”时要谨慎。

ChatGPT 可以创建恶意软件

生成代码和调整不同的编程语言只是 ChatGPT 服务的重要组成部分。 因此,欺诈者使用它来生成恶意软件也就不足为奇了。

“通过正确的提示,新手恶意软件作者可以描述他们想要做什么并获得有效的代码片段,”报告称。 这构成了恶意软件攻击的严重威胁,恶意软件攻击的程度足以造成严重破坏。

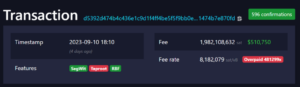

“一个例子是生成代码来检测何时将比特币钱包地址复制到剪贴板,以便可以用恶意软件作者控制的恶意地址替换它,”报告解释说。

因此,这种聊天机器人的可用性将导致恶意软件的复杂性增加。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- 柏拉图区块链。 Web3 元宇宙智能。 知识放大。 访问这里。

- Sumber: https://metanews.com/chatgpt-is-being-used-to-make-quality-scams/

- :是

- 7

- 8

- a

- 对,能力--

- Able

- 关于

- 滥用

- ACCESS

- 根据

- 演员

- 地址

- 高级

- 驳

- AI

- AI供电

- 援助

- 所有类型

- 和

- 期待

- 出现

- 保健

- AS

- At

- 攻击

- 作者

- 作者

- 可用性

- 坏

- 基于

- BE

- 因为

- 成为

- 作为

- 比特币

- 比特币钱包

- 博特

- 欺负

- 商业

- by

- 活动

- CAN

- 不能

- 能力

- 容量

- 原因

- 谨慎

- 挑战

- 聊天机器人

- ChatGPT

- 码

- 公司

- 公司

- 复杂

- 一台

- 关注

- 消费者

- 内容

- 内容生成

- 一直

- 受控

- 可以

- 手艺

- 创建信息图

- 创建

- 刑事

- 网络安全

- 危险的

- 描述

- 开发商

- 不同

- 难

- 揭露

- 不和

- 造谣

- 怀疑

- 每

- 效果

- 有效

- 只

- 电子邮件

- enable

- 订婚

- 实体

- 成熟

- 伦理

- 甚至

- 一切

- 例子

- 例子

- 解释

- 假

- 个农场

- 针对

- 骗子

- 止

- 生成

- 产生

- 产生

- 发电

- 代

- 得到

- 非常好

- 有

- 有

- 头条新闻

- 高度

- 但是

- HTTPS

- 巨大

- 人

- 鉴定

- 不可能

- in

- 增加

- 增加

- 日益

- 表示

- 个人

- 个人

- 信息

- 意图

- 故意地

- 网络

- IT

- 它的

- 键

- 实验室

- 语言

- 语言

- 大

- 铅

- 生活

- 链接

- 小

- 占地

- 使

- 制作

- 恶意软件

- 最大宽度

- 媒体

- 条未读消息

- 可能

- 误传

- 不信任

- 模型

- 钱

- 更多

- 多

- 故事

- 全新

- 初学者

- 数

- of

- on

- 一

- OpenAI

- 秩序

- 成果

- 部分

- 尤其

- 员工

- 个人

- 钓鱼

- 计划

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 播放

- 玩乐于

- 热门

- 声望

- 构成

- 可能

- 帖子

- 潜力

- 生产

- 生成

- 核心产品

- 代码编程

- 编程语言

- 前景

- 证明

- 提供

- 优

- 出版

- 阅读

- 读者

- 真实

- 现实生活

- 现实

- 最近

- 税法法规

- 更换

- 报告

- 研究人员

- 导致

- 评论

- 风险

- 同

- 鳞片

- 诈骗

- 骗子

- 诈骗

- 发送

- 严重

- 特色服务

- 形状

- 沉默

- 只是

- So

- 社会

- 社会化媒体

- 社交媒体帖子

- 一些

- 来源

- 言语

- 尽管

- 说

- 策略

- 样式

- 成功

- 这样

- 科技

- 测试

- 谢谢

- 这

- 其

- 他们

- 博曼

- 威胁

- 威胁者

- 威胁

- 三

- 通过

- 次

- 至

- 工具

- 工具

- 转

- 类型

- 发挥

- 使用

- 用户

- 钱包

- 方法..

- 方法

- 什么是

- 是否

- 这

- 广泛

- 将

- 加工

- 将

- 写

- 书面

- 和风网