ChatGPT, DALL-E, 稳定扩散,以及其他生成式人工智能已经席卷了世界。 他们创造了神话般的诗歌和图像。 它们正在渗透到我们世界的每一个角落,从营销到撰写法律摘要和药物发现。 他们似乎是人机思维融合成功故事的典范。

但在幕后,事情看起来并不那么美好。 这些系统消耗大量能源,需要数据中心排放数千吨碳,这进一步加剧了本已不稳定的气候,并消耗了数十亿美元。 随着神经网络变得更加复杂和广泛使用,能源消耗可能会进一步飙升。

关于生成式人工智能已经有大量的墨水了 碳足迹。 它的能源需求可能是其衰落的原因,阻碍其进一步增长。 使用当前的硬件,生成式人工智能“如果继续依赖标准计算硬件,预计很快就会陷入停滞”。 说过 英特尔实验室的 Hechen Wang 博士。

现在是我们构建可持续人工智能的时候了。

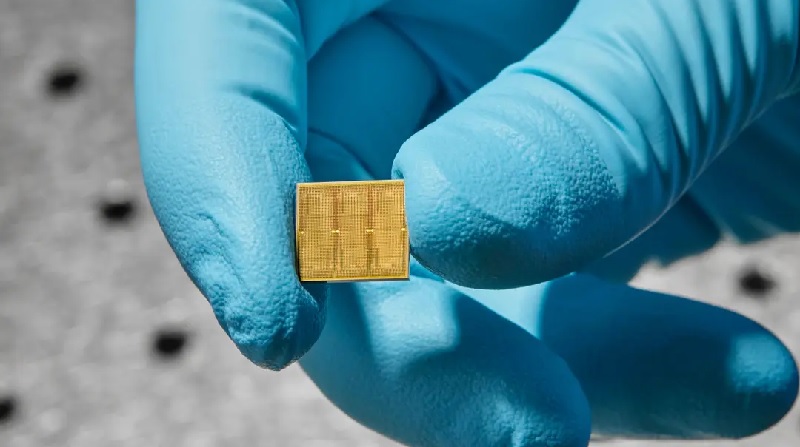

这一周, 一项研究 IBM 朝着这个方向迈出了实际的一步。 他们制造了一款 14 纳米模拟芯片,内含 35 万个存储单元。 与当前的芯片不同,计算直接在这些单元内进行,无需来回传输数据,从而节省能源。

Wang 表示,数据传输会使能耗增加 3 至 10,000 倍,超出实际计算所需的能耗。

该芯片在应对两项语音识别任务时效率很高。 其中之一是 Google Speech Commands,虽小但很实用。 在这里,速度是关键。 另一个是 Librispeech,它是一个庞大的系统,可以帮助将语音转录为文本,这对芯片处理大量数据的能力造成了很大的考验。

当与传统计算机进行比较时,该芯片的性能同样准确,但完成工作的速度更快,能耗也低得多,使用的能量还不到某些任务通常所需能量的十分之一。

该团队表示,“据我们所知,这是模拟芯片在商业相关模型上首次展示商业相关精度水平……具有效率和大规模并行性”。

聪明的字节

这并不是第一款模拟芯片。 然而,它将神经形态计算的想法推向了实用领域——有一天,这种芯片可以为你的手机、智能家居和其他设备提供动力,其效率接近大脑的效率。

嗯什么? 让我们备份一下。

当前的计算机是建立在 冯·诺依曼建筑。 把它想象成一栋有多个房间的房子。 一是中央处理单元(CPU),分析数据。 另一个存储内存。

对于每次计算,计算机都需要在这两个房间之间来回传输数据,这需要时间和精力,并且降低了效率。

相比之下,大脑将计算和记忆结合到一个单间公寓中。 它的蘑菇状连接点(称为突触)都形成神经网络并在同一位置存储记忆。 突触非常灵活,可以根据存储的记忆和新的学习内容调整它们与其他神经元的连接强度(一种称为“权重”的属性)。 我们的大脑通过调整这些突触权重来快速适应不断变化的环境。

IBM 一直走在设计的最前沿 模拟芯片 模仿的 脑计算。 突破 来了2016,当时他们推出了一种基于可擦写 CD 中常见的令人着迷的材料的芯片。 当通电时,这种材料会改变其物理状态和形状,从粘稠的汤变成晶体状结构,类似于数字 0 和 1。

关键是:芯片也可以以混合状态存在。 换句话说,与生物突触类似,人工突触可以编码无数不同的权重(而不仅仅是二进制),使其能够累积多次计算,而无需移动任何一位数据。

杰基尔和海德

这项新研究建立在之前的工作基础上,还使用了相变材料。 基本组件是“内存块”。 每个网格结构中都挤满了数千种相变材料。 这些图块很容易相互通信。

每个块都由可编程本地控制器控制,允许团队精确地调整组件(类似于神经元)。 该芯片还按顺序存储数百条命令,创建了一个黑匣子,使他们能够深入挖掘并分析其性能。

总体而言,该芯片包含 35 万个相变存储结构。 连接数量达到 45 万个突触——与人脑相差甚远,但在 14 纳米芯片上却非常令人印象深刻。

这些令人头脑麻木的数字给人工智能芯片的初始化带来了一个问题:需要寻找的参数太多了。 该团队通过相当于人工智能幼儿园的方式解决了这个问题,在计算开始之前对突触权重进行预编程。 (这有点像在烹饪之前给新的铸铁锅调味。)

未参与这项研究的王解释道,他们“根据硬件的优点和局限性来定制网络训练技术”,然后设置权重以获得最佳结果。

成功了。 在一项初步测试中,该芯片每瓦功率每秒可轻松完成 12.4 万亿次操作。 Wang 表示,其能耗“比最强大的 CPU 和 GPU 高出数十倍甚至数百倍”。

该芯片仅用内存块中的几个经典硬件组件就实现了深度神经网络的核心计算过程。 相比之下,传统计算机需要数百或数千个晶体管(执行计算的基本单元)。

全城传颂

该团队接下来向该芯片挑战两项语音识别任务。 每一个都强调芯片的不同方面。

第一个测试是面对相对较小的数据库时的速度。 使用 谷歌语音命令 在数据库中,该任务要求 AI 芯片在数千人讲 12 个简短单词的大约 65,000 个剪辑中识别出 30 个关键词(“小”在深度学习领域是相对的)。 当使用公认的基准时——MLPerf— 芯片的性能提高了七倍 比之前的工作.

该芯片在面对大型数据库的挑战时也表现出色, 书本演讲。 该语料库包含 1,000 多个小时的英语语音朗读内容,通常用于训练 AI 进行语音解析和自动语音转文本转录。

总体而言,该团队使用 45 个芯片,利用来自 140 亿个相变设备的数据,最终编码了超过 14 万个权重。 与传统硬件相比,该芯片的能效大约提高了 550 倍——每瓦能耗每秒处理近 9 个样本——错误率略高于 XNUMX%。

尽管令人印象深刻,但模拟芯片仍处于起步阶段。 王说,它们显示出“解决与人工智能相关的可持续性问题的巨大前景”,但前进的道路还需要清除更多障碍。

其中一个因素是精细存储技术本身及其周围组件的设计,即芯片的布局方式。 IBM 的新芯片尚未包含所需的所有元件。 下一个关键步骤是将所有内容集成到单个芯片上,同时保持其功效。

在软件方面,我们还需要专门针对模拟芯片定制的算法,以及能够轻松将代码翻译成机器可以理解的语言的软件。 随着这些芯片在商业上的可行性越来越高,开发专用应用程序将使模拟芯片未来的梦想永存。

Wang 表示:“我们花了几十年的时间才塑造出 CPU 和 GPU 能够如此成功运行的计算生态系统。” “为模拟人工智能建立同样的环境可能需要数年时间。”

图片来源: IBM 的 Ryan Lavine

- SEO 支持的内容和 PR 分发。 今天得到放大。

- PlatoData.Network 垂直生成人工智能。 赋予自己力量。 访问这里。

- 柏拉图爱流。 Web3 智能。 知识放大。 访问这里。

- 柏拉图ESG。 汽车/电动汽车, 碳, 清洁科技, 能源, 环境, 太阳能, 废物管理。 访问这里。

- 柏拉图健康。 生物技术和临床试验情报。 访问这里。

- 图表Prime。 使用 ChartPrime 提升您的交易游戏。 访问这里。

- 块偏移量。 现代化环境抵消所有权。 访问这里。

- Sumber: https://singularityhub.com/2023/08/25/ibms-brain-inspired-analog-chip-aims-to-make-ai-more-sustainable/

- :具有

- :是

- :不是

- $UP

- 000

- 1

- 10

- 12

- 14

- 30

- 9

- a

- 对,能力--

- 以上

- 公认

- 积累

- 准确

- 实际

- 适应

- 驳

- AI

- 目标

- 算法

- 所有类型

- 允许

- 允许

- 已经

- 还

- 量

- an

- 分析

- 分析

- 和

- 另一个

- 分析数据

- 公寓

- 应用领域

- 保健

- 人造的

- AS

- 相关

- At

- 自动表

- 背部

- 基于

- 基本包

- BE

- 成为

- 很

- before

- 开始

- 好处

- 之间

- 十亿美元

- 位

- 黑色

- 都

- 盒子

- 大脑

- 突破

- 建立

- 建

- 但是

- by

- 计算

- 被称为

- CAN

- 碳

- 二氧化氯溶液 CDS

- 中心

- 中央

- 挑战

- 更改

- 孩子

- 芯片

- 碎屑

- 清除

- 剪辑

- 码

- 结合

- 商业

- 常用

- 通信

- 组件

- 计算

- 计算

- 一台

- 电脑

- 计算

- 分享链接

- 连接

- 消费

- 包含

- 包含

- 包含

- 继续

- 对比

- 受控

- 调节器

- 常规

- 核心

- 可以

- 创建信息图

- 创建

- 创造

- 信用

- 危急

- 电流

- data

- 数据中心

- 数据库

- 数据集

- 天

- 几十年

- 减少

- 专用

- 深

- 深入学习

- 需求

- 设计

- 设计

- 发展

- 研发支持

- 设备

- 不同

- DIG

- 数字

- 方向

- 直接

- 发现

- 不

- 美元

- 倒台

- dr

- 梦想

- 药物

- 每

- 生态系统

- 功效

- 效率

- 高效

- 分子

- 能源

- 能源消费

- 英语

- 环境

- 一样

- 错误

- 建立

- 甚至

- 终于

- 千变万化

- 所有的

- 一切

- 存在

- 解释

- 因素

- 远

- 孤岛惊魂

- 迷人

- 快

- 少数

- 姓氏:

- 柔软

- 针对

- 第一线

- 申请

- 向前

- 向前

- 发现

- 止

- 进一步

- 未来

- 生成的

- 生成式人工智能

- 谷歌

- 图形处理器

- 格

- 成长

- 手

- 发生

- 硬件

- 有

- 有

- 帮助

- 相关信息

- 高

- 更高

- 高度

- 主页

- 兜帽

- HOURS

- 别墅

- 创新中心

- 但是

- HTML

- HTTPS

- 人

- 数百

- 跨栏

- 杂交种

- IBM

- 主意

- if

- 图片

- 图片

- 有声有色

- in

- 其他

- 增加

- 日益

- 初始

- 整合

- 英特尔

- 成

- 介绍

- 参与

- IT

- 它的

- 本身

- 工作

- JPG

- 只是

- 保持

- 键

- 关键词

- 知识

- 实验室

- 语言

- 大

- 学习

- 法律咨询

- 减

- 各级

- 喜欢

- 容易

- 限制

- 本地

- 圖書分館的位置

- 寻找

- 机

- 维护

- 使

- 许多

- 营销

- 大规模

- 材料

- 物料

- 最大宽度

- 回忆

- 内存

- 百万

- 介意

- 更多

- 最先进的

- 移动

- 多

- 无数的

- 自然

- 近

- 几乎

- 需求

- 打印车票

- 需要

- 网络

- 神经网络

- 神经形态计算

- 神经元

- 全新

- 新芯片

- 下页

- 通常

- 数字

- of

- on

- 一

- 到

- 操作

- 运营

- 最佳

- or

- 其他名称

- 我们的

- 输出

- 超过

- 包装

- 参数

- 径

- 员工

- 为

- 百分

- 性能

- 执行

- 施行

- 电话

- 的

- 进站

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 诗

- 功率

- 强大

- 实用

- 平台精度

- 当下

- 以前

- 大概

- 市场问题

- 问题

- 过程

- 处理

- 承诺

- 财产

- 推

- 很快

- 率

- 阅读

- 境界

- 承认

- 相对的

- 相对

- 相应

- 依靠

- 必须

- 需要

- 休息

- 成果

- 房间数

- περίπου

- 说

- 同

- 保存

- 其次

- 寻找

- 似乎

- 序列

- 集

- XNUMX所

- 形状

- 短

- 显示

- 侧

- 类似

- 只是

- 单

- 平步青云

- 小

- 智能

- 智能家居

- So

- 软件

- 一些

- 或很快需要,

- 极致

- 发言

- 特别是

- 言语

- 语音识别

- 语音到文本

- 速度

- Spot

- 标准

- 州/领地

- 步

- 仍

- 商店

- 存储

- 商店

- 风暴

- 故事

- 非常

- 结构体

- 结构

- 工作室

- 学习

- 成功

- 成功的故事

- 顺利

- 周围

- 永续发展

- 可持续发展

- 突触

- 突触

- 系统

- 产品

- 采取

- 拍摄

- 需要

- 任务

- 任务

- 团队

- 技术

- 专业技术

- test

- 比

- 这

- 世界

- 其

- 他们

- 然后

- 那里。

- 博曼

- 他们

- 事

- 认为

- 那些

- 数千

- 通过

- 次

- 时

- 至

- 音

- 也有

- 了

- 传统

- 培训

- 兆

- 转

- 二

- 下

- 相关

- 理解

- 单元

- 单位

- 宇宙

- 不像

- 用过的

- 运用

- 平时

- 非常

- 可行

- 挥发物

- 是

- we

- 周

- 什么是

- ,尤其是

- 这

- 而

- WHO

- 广泛

- 将

- 中

- 也完全不需要

- 话

- 工作

- 工作

- 世界

- 写作

- 年

- 但

- 您一站式解决方案

- 和风网