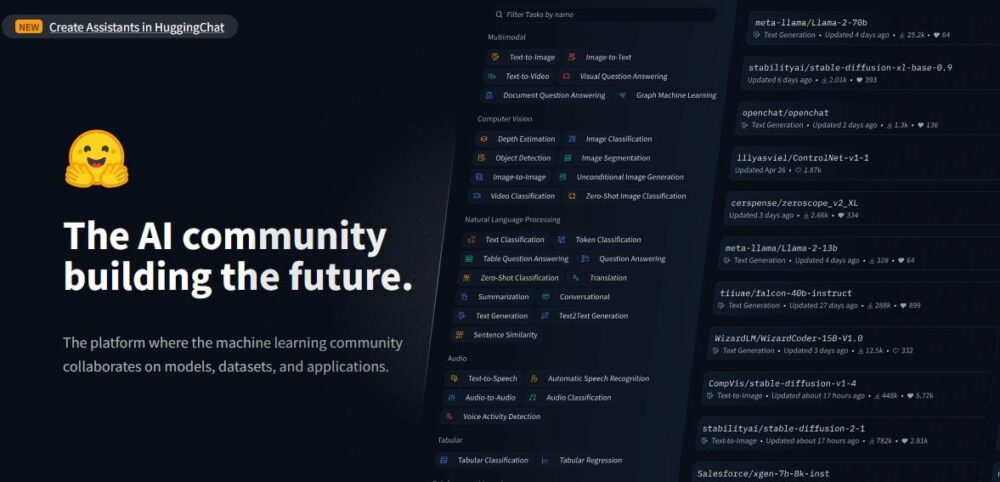

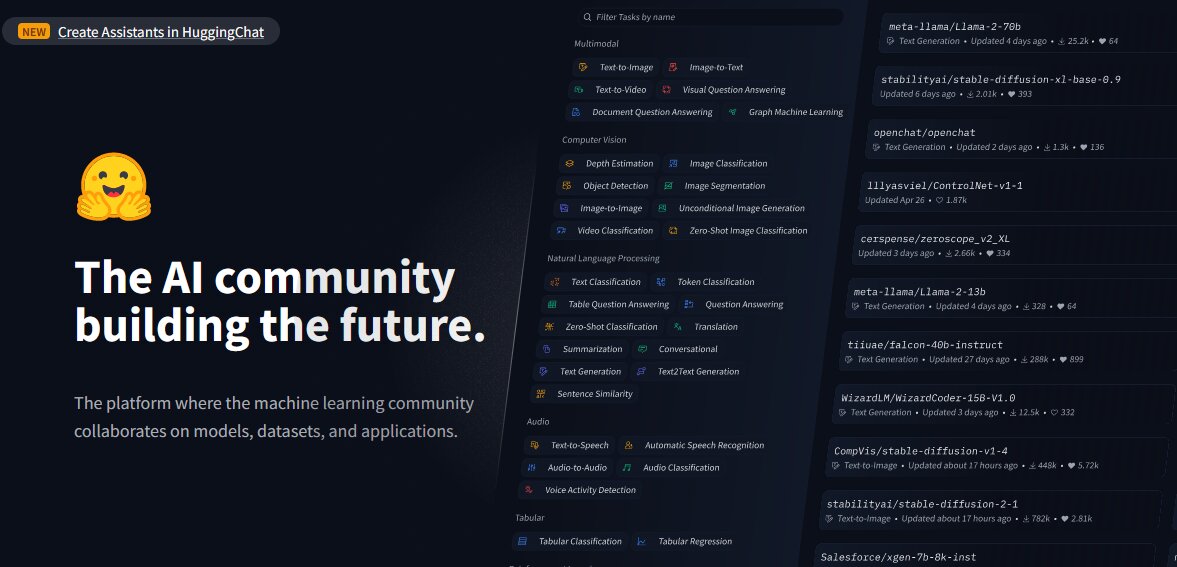

研究人员在 Hugging Face AI 平台上发现了 100 多个恶意机器学习 (ML) 模型,这些模型可以使攻击者将恶意代码注入到用户计算机上。

尽管 Hugging Face 实施了安全措施,但调查结果凸显了“武器化”公开可用模型的风险越来越大,因为它们可以为攻击者创建后门。

JFrog Security Research 的调查结果是一项正在进行的研究的一部分,该研究旨在分析黑客如何使用机器学习来攻击用户。

有害内容

根据由物品 系统总线研究人员开发了一种先进的扫描系统来仔细检查 Hugging Face AI 平台上托管的模型,例如 PyTorch 和 Tensorflow Keras。

Hugging Face 是一个为共享 AI 模型、数据集和应用程序而开发的平台。在分析模型后,研究人员在“看似无害的模型中”发现了有害的有效负载。

尽管 Hugging Face 执行了恶意软件和 pickle 扫描等安全措施,但情况仍然如此。然而,该平台并不限制下载可能有害的模型,并且还允许公开提供 AI模型 被用户滥用和武器化。

根据他们的说法,在检查平台和现有模型时,JFrog 的安全研究人员发现了大约 100 个具有恶意功能的 AI 模型。 报告.

报告指出,其中一些模型能够在用户的计算机上执行代码,“从而为攻击者创建持久的后门”。

研究人员还表示,这些发现排除了误报。他们说,这些准确地反映了平台上恶意模型的流行程度。

也可以参考: 电动汽车市场放缓后,苹果将汽车团队转向人工智能

例子

根据 JFrog 的报告,其中一个“令人震惊”的案件涉及一名 PyTorch 模型。据报道,该模型是由一位名为“baller423”的用户上传的,该用户随后从 Hugging Face 平台上删除。

在进一步检查该模型时,研究人员注意到它包含恶意负载,使其能够在指定主机(210.117.212.93)上建立反向 shell。

JFrog 高级安全研究员 David Cohen 表示:“(它)明显更具侵入性, 潜在的恶意,因为它建立了与外部服务器的直接连接,这表明存在潜在的安全威胁,而不仅仅是漏洞的表现,”他写道。

这利用了“Python 的 pickle 模块的‘_reduce_’方法在加载模型文件时执行任意代码,有效地绕过了传统的检测方法。”

研究人员还认识到,相同的有效负载正在创建与不同 IP 地址的连接,“这表明操作员可能是研究人员,而不是恶意黑客。”

叫醒服务

JFrog 团队指出,这些发现给 Hugging Face 敲响了警钟,表明其平台容易受到操纵和潜在威胁。

“这些事件深刻地提醒人们,Hugging Face 存储库和 Kaggle 等其他流行存储库面临着持续的威胁,除了给 AI/ML 工程师带来挑战之外,这些威胁还可能损害使用这些资源的组织的隐私和安全。”研究人员。

这就是 网络安全威胁 在人工智能工具激增的推动下,世界各地的这种情况正在增加,不良行为者出于恶意目的滥用它们。黑客还利用人工智能来推进网络钓鱼攻击并欺骗人们。

然而,JFrog 团队还有其他发现。

研究人员的游乐场

研究人员还指出 拥抱脸 它已发展成为“希望对抗新出现的威胁的研究人员的游乐场,正如绕过其安全措施的各种策略所证明的那样。”

例如,“baller423”上传的有效负载发起了与属于 Kreonet(韩国研究环境开放网络)的 IP 地址范围的反向 shell 连接。

根据 黑暗阅读, Kreonet 是韩国的一个高速网络,支持高级研究和教育活动; “因此,人工智能研究人员或从业者可能是该模型的幕后黑手。”

“我们可以看到,大多数‘恶意’有效负载实际上是研究人员和/或错误赏金的尝试,目的是为了看似合法的目的而执行代码,”科恩说。

尽管目的合法,但 JFrog 团队警告说,研究人员采用的策略清楚地表明,像 Hugging Face 这样的平台容易受到供应链攻击。据该团队称,这些可以定制以专注于特定的人群,例如人工智能或机器学习工程师。

- :具有

- :是

- :不是

- 100

- 210

- 212

- 7

- 9

- a

- 关于

- 根据

- 精准的

- 活动

- 演员

- 通

- 增加

- 地址

- 地址

- 推进

- 高级

- AI

- AI模型

- 人工智能平台

- AI / ML

- 还

- an

- 分析

- 分析

- 和

- 应用领域

- 随意

- 保健

- 排列

- 刊文

- AS

- 攻击

- 攻击

- 尝试

- 可使用

- 后门

- 坏

- BE

- 很

- 背后

- 属于

- 赏金

- 问题

- 虫子赏金

- by

- 绕行

- 呼叫

- CAN

- 能力

- 汽车

- 例

- 挑战

- 明确地

- CO

- 码

- 科恩

- 打击

- 购买的订单均

- 妥协

- 计算

- 地都

- 连接

- 包含

- 常规

- 可以

- 创建信息图

- 创造

- 定制

- 数据集

- David

- 人口统计

- 演示

- 证明

- 尽管

- 检测

- 发达

- 不同

- 直接

- 发现

- 不同

- 不

- 下载

- 教育的

- 只

- 新兴经济体的新市场。

- 就业

- enable

- 使

- 使

- 工程师

- 环境

- 建立

- 建立

- 进化

- 检查

- 执行

- 执行

- 执行

- 现有

- 外部

- 面部彩妆

- 面对

- 事实

- false

- 文件

- 发现

- 专注焦点

- 针对

- 申请

- 止

- 推动

- 功能

- 进一步

- 得到

- 成长

- 黑客

- 有害

- 有

- he

- 高

- 近期亮点

- 主持人

- 托管

- 创新中心

- 但是

- HTTPS

- 确定

- 器物

- in

- 增加

- 表示

- 表示

- 说明

- 启动

- 注入

- 例

- 意图

- 成

- 侵入

- 涉及

- IP

- IP地址

- IP地址

- IT

- 它的

- JPG

- 凯拉斯

- 韩国

- 学习

- 合法

- 杠杆

- 喜欢

- 装载

- 机

- 机器学习

- 机

- 制成

- 恶意

- 恶意软件

- 操作

- 市场

- 最大宽度

- 可能..

- 措施

- 聚体

- 方法

- 方法

- ML

- 模型

- 模型

- 更多

- 最先进的

- 网络

- 特别是

- 注意到

- of

- on

- 一

- 正在进行

- 到

- 打开

- 开放网络

- 运营商

- or

- 组织

- 其他名称

- 输出

- 超过

- 部分

- 员工

- 钓鱼

- 网络钓鱼攻击

- 平台

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 操场

- 热门

- 可能

- 潜力

- 可能

- 流行

- 隐私

- 隐私和安全

- 公然

- 目的

- pytorch

- 范围

- 宁

- 阅读

- 确认

- 报告

- 据说

- 表示

- 研究

- 研究员

- 研究人员

- 资源

- 限制

- 反转

- 风险

- 说

- 同

- 扫描

- 保安

- 保安措施

- 看到

- 似乎

- 前辈

- 服务

- 服务器

- 共享

- 壳

- 显示

- 南部

- South Korea

- 具体的

- 指定

- 策略

- 学习

- 后来

- 这样

- 支持

- 系统

- 策略

- 团队

- tensorflow

- 比

- 这

- 其

- 他们

- 博曼

- 他们

- 威胁

- 威胁

- 至

- 工具

- 招

- 上传

- 上

- 使用

- 用户

- 用户

- 运用

- 利用

- 漏洞

- 警告

- 是

- 这

- 希望

- 世界

- 写

- 和风网