نظرًا لانتشار التعلم الآلي (ML) بشكل متزايد في مجموعة واسعة من الصناعات ، تجد المؤسسات الحاجة إلى تدريب أعداد كبيرة من نماذج التعلم الآلي وتقديمها لتلبية الاحتياجات المتنوعة لعملائها. بالنسبة لمقدمي البرامج كخدمة (SaaS) على وجه الخصوص ، فإن القدرة على تدريب وخدمة آلاف النماذج بكفاءة وفعالية من حيث التكلفة أمر بالغ الأهمية للبقاء في المنافسة في سوق سريع التطور.

يتطلب تدريب آلاف النماذج وخدمتها بنية تحتية قوية وقابلة للتطوير ، وهذا هو المكان المناسب الأمازون SageMaker استطيع المساعدة. SageMaker عبارة عن نظام أساسي مُدار بالكامل يُمكِّن المطورين وعلماء البيانات من إنشاء نماذج ML وتدريبها ونشرها بسرعة ، مع تقديم مزايا توفير التكلفة لاستخدام البنية التحتية السحابية لـ AWS.

في هذا المنشور ، نستكشف كيف يمكنك استخدام ميزات SageMaker ، بما في ذلك أمازون SageMaker معالجة، ووظائف تدريب SageMaker ، ونقاط النهاية متعددة النماذج من SageMaker (MMEs) ، لتدريب آلاف النماذج وخدمتهم بطريقة فعالة من حيث التكلفة. لبدء استخدام الحل الموصوف ، يمكنك الرجوع إلى دفتر الملاحظات المصاحب على GitHub جيثب:.

حالة الاستخدام: التنبؤ بالطاقة

بالنسبة لهذا المنشور ، نفترض دور شركة ISV التي تساعد عملائها على أن يصبحوا أكثر استدامة من خلال تتبع استهلاكهم للطاقة وتقديم التوقعات. تضم شركتنا 1,000 عميل يرغبون في فهم استخدامهم للطاقة بشكل أفضل واتخاذ قرارات مستنيرة حول كيفية تقليل تأثيرهم على البيئة. للقيام بذلك ، نستخدم مجموعة بيانات تركيبية ونقوم بتدريب نموذج ML بناءً على نبي لكل عميل لعمل تنبؤات باستهلاك الطاقة. مع SageMaker ، يمكننا تدريب وخدمة هذه النماذج البالغ عددها 1,000 نموذج بكفاءة ، وتزويد عملائنا برؤى دقيقة وقابلة للتنفيذ حول استخدامهم للطاقة.

هناك ثلاث ميزات في مجموعة البيانات التي تم إنشاؤها:

- CUSTOMER_ID - هذا رقم صحيح لكل زبون ، يتراوح من 0-999.

- الطابع الزمني - هذه قيمة تاريخ / وقت تشير إلى الوقت الذي تم فيه قياس استهلاك الطاقة. يتم إنشاء الطوابع الزمنية بشكل عشوائي بين تاريخي البدء والانتهاء المحددين في الكود.

- استهلاك - هذه قيمة عائمة تشير إلى استهلاك الطاقة ، ويتم قياسها في بعض الوحدات التعسفية. يتم إنشاء قيم الاستهلاك بشكل عشوائي بين 0-1,000 مع موسمية جيبية.

حل نظرة عامة

لتدريب الآلاف من نماذج ML وتقديمها بكفاءة ، يمكننا استخدام ميزات SageMaker التالية:

- معالجة SageMaker - SageMaker Processing هي خدمة تحضير بيانات مُدارة بالكامل تمكنك من أداء معالجة البيانات ومهام تقييم النماذج على بيانات الإدخال الخاصة بك. يمكنك استخدام معالجة SageMaker لتحويل البيانات الأولية إلى التنسيق المطلوب للتدريب والاستدلال ، بالإضافة إلى تشغيل التقييمات المجمعة وعبر الإنترنت لنماذجك.

- وظائف تدريب SageMaker - يمكنك استخدام وظائف تدريب SageMaker لتدريب النماذج على مجموعة متنوعة من الخوارزميات وأنواع بيانات الإدخال ، وتحديد موارد الحساب اللازمة للتدريب.

- SageMaker MMEs - تمكّنك نقاط النهاية متعددة النماذج من استضافة نماذج متعددة على نقطة نهاية واحدة ، مما يجعل من السهل تقديم التنبؤات من نماذج متعددة باستخدام واجهة برمجة تطبيقات واحدة. يمكن لـ SageMaker MME توفير الوقت والموارد عن طريق تقليل عدد نقاط النهاية اللازمة لخدمة التنبؤات من نماذج متعددة. تدعم MME استضافة النماذج المدعومة من وحدة المعالجة المركزية ووحدة معالجة الرسومات. لاحظ أنه في السيناريو الخاص بنا ، نستخدم 1,000 نموذج ، لكن هذا لا يقتصر على الخدمة نفسها.

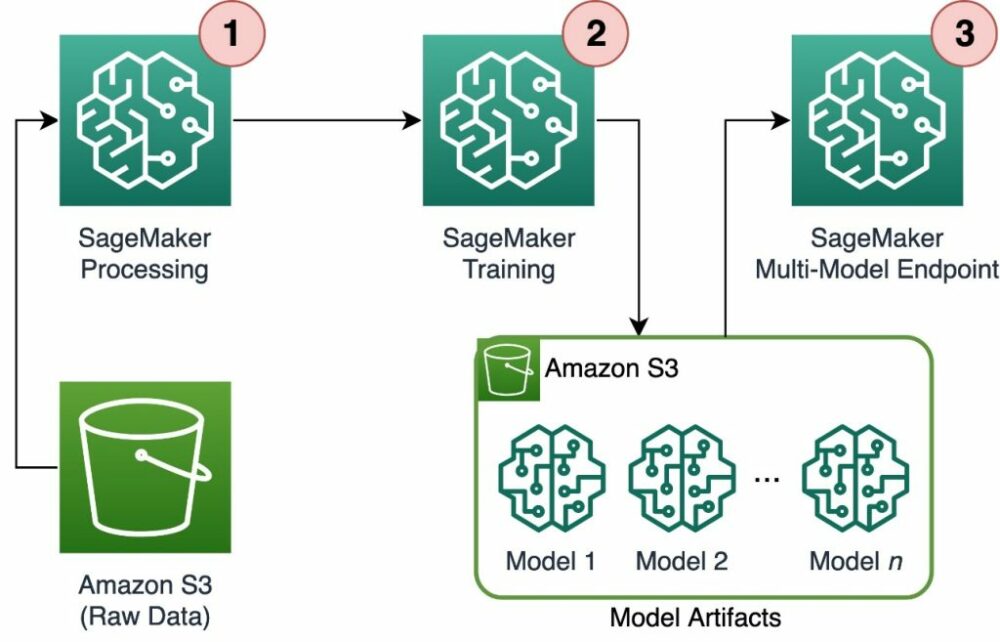

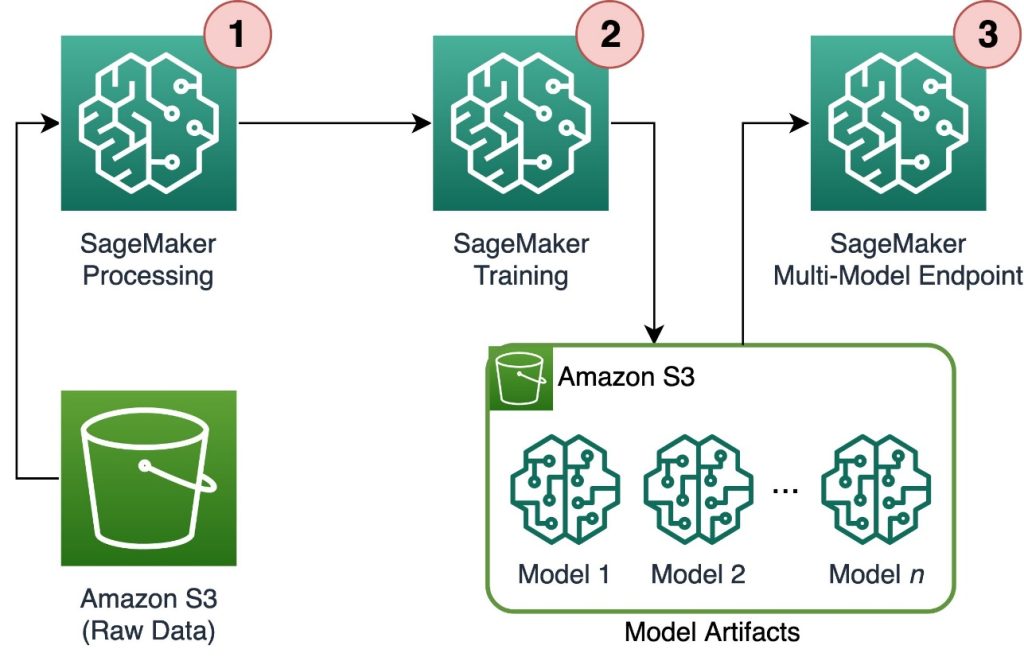

يوضح الرسم البياني التالي بنية الحل.

يتضمن سير العمل الخطوات التالية:

- نستخدم SageMaker Processing لمعالجة البيانات وإنشاء ملف CSV واحد لكل عميل وتخزينه فيه خدمة تخزين أمازون البسيطة (أمازون S3).

- تم تكوين وظيفة تدريب SageMaker لقراءة مخرجات مهمة معالجة SageMaker وتوزيعها بطريقة round robin على مثيلات التدريب. لاحظ أنه يمكن تحقيق ذلك أيضًا باستخدام خطوط أنابيب Amazon SageMaker.

- يتم تخزين القطع الأثرية للنموذج في Amazon S3 من خلال مهمة التدريب ، ويتم تقديمها مباشرة من SageMaker MME.

نطاق التدريب لآلاف النماذج

يمكن توسيع نطاق تدريب الآلاف من النماذج عبر distribution المعلمة من التدريب فئة في SageMaker Python SDK ، والتي تتيح لك تحديد كيفية توزيع البيانات عبر مثيلات تدريب متعددة لوظيفة تدريبية. هناك ثلاثة خيارات لـ distribution المعلمة: FullyReplicated, ShardedByS3Keyو ShardedByRecord. ShardedByS3Key الخيار يعني أن بيانات التدريب يتم تجزئتها بواسطة مفتاح كائن S3 ، مع تلقي كل مثيل تدريب مجموعة فرعية فريدة من البيانات ، لتجنب الازدواجية. بعد نسخ البيانات بواسطة SageMaker إلى حاويات التدريب ، يمكننا قراءة بنية المجلد والملفات لتدريب نموذج فريد لكل ملف عميل. فيما يلي مثال على مقتطف الشفرة:

تقوم كل وظيفة تدريبية في SageMaker بتخزين النموذج المحفوظ في ملف /opt/ml/model مجلد حاوية التدريب قبل أرشفته في ملف model.tar.gz ملف ، ثم تحميله إلى Amazon S3 عند الانتهاء من مهمة التدريب. يمكن للمستخدمين المتمرسين أيضًا أتمتة هذه العملية باستخدام خطوط أنابيب SageMaker. عند تخزين نماذج متعددة عبر نفس الوظيفة التدريبية ، يقوم SageMaker بإنشاء نموذج واحد model.tar.gz ملف يحتوي على جميع الموديلات المدربة. هذا يعني أنه من أجل خدمة النموذج ، سنحتاج إلى تفريغ الأرشيف أولاً. لتجنب هذا نستخدم نقاط التفتيش لحفظ حالة النماذج الفردية. يوفر SageMaker وظيفة لنسخ نقاط التحقق التي تم إنشاؤها أثناء مهمة التدريب إلى Amazon S3. هنا ، يجب حفظ نقاط التفتيش في مكان محدد مسبقًا ، مع الوضع الافتراضي /opt/ml/checkpoints. يمكن استخدام نقاط التفتيش هذه لاستئناف التدريب في وقت لاحق أو كنموذج للنشر على نقطة نهاية. للحصول على ملخص عالي المستوى لكيفية إدارة النظام الأساسي للتدريب SageMaker مسارات التخزين لمجموعات بيانات التدريب ، ونماذج التحف ، ونقاط التفتيش ، والمخرجات بين التخزين السحابي لـ AWS ووظائف التدريب في SageMaker ، يرجى الرجوع إلى مجلدات تخزين تدريب Amazon SageMaker لمجموعات بيانات التدريب ونقاط التحقق والنتائج الأثرية النموذجية والمخرجات.

يستخدم الكود التالي رمزًا وهميًا model.save() تعمل داخل train.py نص يحتوي على منطق التدريب:

مقياس الاستدلال إلى آلاف النماذج باستخدام SageMaker MMEs

تتيح لك وحدات SageMaker MME خدمة نماذج متعددة في نفس الوقت عن طريق إنشاء تكوين نقطة نهاية يتضمن قائمة بجميع النماذج المراد عرضها ، ثم إنشاء نقطة نهاية باستخدام تكوين نقطة النهاية. ليست هناك حاجة لإعادة نشر نقطة النهاية في كل مرة تضيف فيها نموذجًا جديدًا لأن نقطة النهاية ستخدم تلقائيًا جميع الطرز المخزنة في مسارات S3 المحددة. يتم تحقيق ذلك مع خادم متعدد النماذج (MMS) ، وهو إطار عمل مفتوح المصدر لخدمة نماذج ML التي يمكن تثبيتها في حاويات لتوفير الواجهة الأمامية التي تفي بمتطلبات واجهات برمجة تطبيقات حاوية MME الجديدة. بالإضافة إلى ذلك ، يمكنك استخدام خوادم نموذجية أخرى بما في ذلك تورش سيرف و تريتون نصف إله عند الإغريق. يمكن تثبيت MMS في الحاوية المخصصة الخاصة بك عبر ملف مجموعة أدوات الاستدلال SageMaker. لمعرفة المزيد حول كيفية تكوين Dockerfile الخاص بك لتضمين MMS واستخدامه لخدمة النماذج الخاصة بك ، ارجع إلى قم ببناء الحاوية الخاصة بك لنقاط النهاية متعددة النماذج من SageMaker.

يوضح مقتطف الشفرة التالي كيفية إنشاء MME باستخدام SageMaker Python SDK:

عندما تكون MME حية ، يمكننا استدعاؤها لإنشاء تنبؤات. يمكن إجراء الدعوات في أي AWS SDK وكذلك باستخدام SageMaker Python SDK ، كما هو موضح في مقتطف الشفرة التالي:

عند استدعاء أحد النماذج ، يتم تحميل النموذج مبدئيًا من Amazon S3 على المثيل ، مما قد يؤدي إلى بداية باردة عند استدعاء نموذج جديد. النماذج المستخدمة بشكل متكرر يتم تخزينها مؤقتًا في الذاكرة وعلى القرص لتوفير استنتاج منخفض زمن الوصول.

وفي الختام

SageMaker عبارة عن منصة قوية وفعالة من حيث التكلفة للتدريب وخدمة الآلاف من نماذج ML. تعمل ميزاته ، بما في ذلك SageMaker Processing ووظائف التدريب و MME ، على تمكين المؤسسات من تدريب الآلاف من النماذج وتقديمها بكفاءة على نطاق واسع ، مع الاستفادة أيضًا من مزايا توفير التكلفة لاستخدام البنية التحتية السحابية لـ AWS. لمعرفة المزيد حول كيفية استخدام SageMaker للتدريب وخدمة آلاف النماذج ، ارجع إلى معالجة البيانات, تدريب نموذج مع Amazon SageMaker و استضف عدة نماذج في حاوية واحدة خلف نقطة نهاية واحدة.

حول المؤلف

دافيد جاليتيلي مهندس حلول متخصص للذكاء الاصطناعي / تعلم الآلة في منطقة أوروبا والشرق الأوسط وإفريقيا. يقيم في بروكسل ويعمل بشكل وثيق مع العملاء في جميع أنحاء البنلوكس. لقد كان مطورًا منذ أن كان صغيرًا جدًا ، حيث بدأ البرمجة في سن السابعة. بدأ تعلم الذكاء الاصطناعي / تعلم الآلة في الجامعة ، ووقع في حبها منذ ذلك الحين.

دافيد جاليتيلي مهندس حلول متخصص للذكاء الاصطناعي / تعلم الآلة في منطقة أوروبا والشرق الأوسط وإفريقيا. يقيم في بروكسل ويعمل بشكل وثيق مع العملاء في جميع أنحاء البنلوكس. لقد كان مطورًا منذ أن كان صغيرًا جدًا ، حيث بدأ البرمجة في سن السابعة. بدأ تعلم الذكاء الاصطناعي / تعلم الآلة في الجامعة ، ووقع في حبها منذ ذلك الحين.

موريتس دي جروت هو مهندس حلول في Amazon Web Services ، ومقره أمستردام. إنه يحب العمل على الموضوعات المتعلقة بالتعلم الآلي ولديه ميل للشركات الناشئة. في أوقات فراغه ، يستمتع بالتزلج ولعب الاسكواش.

موريتس دي جروت هو مهندس حلول في Amazon Web Services ، ومقره أمستردام. إنه يحب العمل على الموضوعات المتعلقة بالتعلم الآلي ولديه ميل للشركات الناشئة. في أوقات فراغه ، يستمتع بالتزلج ولعب الاسكواش.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/scale-training-and-inference-of-thousands-of-ml-models-with-amazon-sagemaker/

- :لديها

- :يكون

- :ليس

- :أين

- 000

- 000 عميل

- 1

- 10

- 100

- 12

- 15%

- 20

- 7

- a

- القدرة

- من نحن

- دقيق

- تحقق

- في

- تضيف

- إضافة

- مزايا

- بعد

- السن

- AI / ML

- خوارزميات

- الكل

- السماح

- يسمح

- سابقا

- أيضا

- أمازون

- الأمازون SageMaker

- أمازون ويب سيرفيسز

- أمستردام

- an

- و

- أي وقت

- API

- واجهات برمجة التطبيقات

- هندسة معمارية

- أرشيف

- هي

- حجة

- AS

- افترض

- At

- أتمتة

- تلقائيا

- تجنب

- تجنب

- AWS

- على أساس

- BE

- لان

- أصبح

- يصبح

- كان

- قبل

- وراء

- يجري

- الاستفادة

- الفوائد

- أفضل

- ما بين

- على حد سواء

- بروكسل

- نساعدك في بناء

- لكن

- by

- دعوة

- CAN

- حقيبة

- فئة

- عن كثب

- سحابة

- البنية التحتية السحابية

- سحابة التخزين

- الكود

- بارد

- حول الشركة

- تنافسي

- إكمال

- إحصاء

- الاعداد

- تكوين

- استهلاك

- وعاء

- حاويات

- فعاله من حيث التكلفه

- خلق

- خلق

- يخلق

- خلق

- حاسم

- على

- زبون

- العملاء

- البيانات

- تحضير البيانات

- معالجة المعلومات

- قواعد البيانات

- تمور

- القرارات

- الترتيب

- حدد

- تعريف

- نشر

- وصف

- المطور

- المطورين

- مباشرة

- يعرض

- نشر

- وزعت

- عدة

- do

- فعل

- أثناء

- كل

- سهل

- بكفاءة

- EMEA

- تمكين

- تمكن

- النهاية

- نقطة النهاية

- طاقة

- استهلاك الطاقة

- بيئي

- تقييم

- التقييمات

- كل

- المتطورة

- مثال

- اكتشف

- سقط

- الأزياء

- المميزات

- قم بتقديم

- ملفات

- العثور على

- الاسم الأول

- تطفو

- متابعيك

- في حالة

- بالنسبة للشركات الناشئة

- التوقعات

- شكل

- الإطار

- كثيرا

- تبدأ من

- جبهة

- نهاية المقدمة

- تماما

- وظيفة

- وظيفة

- توليد

- ولدت

- دولار فقط واحصل على خصم XNUMX% على جميع

- GitHub جيثب:

- he

- مساعدة

- يساعد

- هنا

- رفيع المستوى

- له

- مضيف

- استضافة

- كيفية

- كيفية

- HTML

- HTTP

- HTTPS

- معرف

- يوضح

- التأثير

- استيراد

- in

- تتضمن

- يشمل

- بما فيه

- على نحو متزايد

- يشير

- فرد

- الصناعات

- وأبلغ

- البنية التحتية

- في البداية

- إدخال

- المدخلات

- في الداخل

- رؤى

- تثبيت

- مثل

- إلى

- IT

- انها

- نفسها

- وظيفة

- المشــاريــع

- JPG

- جسون

- القفل

- كبير

- الى وقت لاحق

- تعلم

- تعلم

- الإعجابات

- تحديد

- قائمة

- حي

- محليا

- موقع

- منطق

- حب

- آلة

- آلة التعلم

- جعل

- يصنع

- تمكن

- يدير

- تجارة

- تعني

- يعني

- تعرف علي

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- ML

- نموذج

- عارضات ازياء

- لحظة

- الأكثر من ذلك

- متعدد

- الاسم

- حاجة

- بحاجة

- إحتياجات

- جديد

- لا

- مفكرة

- عدد

- أرقام

- موضوع

- of

- الوهب

- on

- ONE

- online

- المصدر المفتوح

- خيار

- مزيد من الخيارات

- or

- طلب

- المنظمات

- OS

- أخرى

- لنا

- شركتنا

- خارج

- الناتج

- الخاصة

- المعلمة

- خاص

- pass

- مسار

- إلى

- نفذ

- فترة

- صورة

- المنصة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- لعب

- ممكن

- منشور

- قوة

- قوي

- تنبؤات

- متنبئ

- سائد

- عملية المعالجة

- معالجة

- تزود

- مقدمي

- ويوفر

- توفير

- بايثون

- بسرعة

- بشكل عشوائي

- نطاق

- تتراوح

- بسرعة

- الخام

- عرض

- في الوقت الحقيقي

- يستلم

- تخفيض

- تقليص

- منطقة

- المتطلبات الأساسية

- يتطلب

- الموارد

- نتيجة

- استئنف

- قوي

- النوع

- يجري

- ادارة العلاقات مع

- sagemaker

- خطوط الأنابيب SageMaker

- نفسه

- حفظ

- تحجيم

- حجم

- سيناريو

- العلماء

- الإستراحة

- خدمة

- خوادم

- الخدمة

- خدماتنا

- خدمة

- طقم

- مجزأ

- أظهرت

- يظهر

- الاشارات

- منذ

- عزباء

- قصاصة

- تطبيقات الكمبيوتر

- البرمجيات كخدمة

- حل

- الحلول

- بعض

- متخصص

- محدد

- بداية

- بدأت

- ابتداء

- البدء

- الولايه او المحافظه

- خطوات

- تخزين

- متجر

- تخزين

- فروعنا

- تخزين

- بناء

- ملخص

- الدعم

- استدامة

- اصطناعي

- الهدف

- المهام

- أن

- •

- الدولة

- من مشاركة

- then

- هناك.

- تشبه

- الآلاف

- ثلاثة

- طوال

- الوقت

- إلى

- المواضيع

- تتبع الشحنة

- قطار

- متدرب

- قادة الإيمان

- تحول

- أنواع

- فهم

- فريد من نوعه

- وحدة

- جامعة

- بناء على

- الأستعمال

- تستخدم

- مستعمل

- المستخدمين

- يستخدم

- استخدام

- قيمنا

- القيم

- تشكيلة

- جدا

- بواسطة

- W

- تريد

- وكان

- طريق..

- we

- الويب

- خدمات ويب

- حسن

- متى

- التي

- في حين

- من الذى

- واسع

- مدى واسع

- سوف

- مع

- في غضون

- للعمل

- سير العمل

- أعمال

- سوف

- أنت

- شاب

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت