تمكن سياسات التحكم الفعالة الشركات الصناعية من زيادة ربحيتها من خلال زيادة الإنتاجية إلى الحد الأقصى مع تقليل أوقات التوقف عن العمل غير المجدولة واستهلاك الطاقة. يعد العثور على سياسات التحكم الأمثل مهمة معقدة لأن الأنظمة الفيزيائية، مثل المفاعلات الكيميائية وتوربينات الرياح، غالبًا ما تكون صعبة النمذجة ولأن الانحراف في ديناميكيات العملية يمكن أن يتسبب في تدهور الأداء بمرور الوقت. التعلم المعزز دون اتصال بالإنترنت هو استراتيجية تحكم تسمح للشركات الصناعية ببناء سياسات التحكم بالكامل من البيانات التاريخية دون الحاجة إلى نموذج عملية واضح. لا يتطلب هذا النهج التفاعل مع العملية مباشرة في مرحلة الاستكشاف، مما يزيل أحد العوائق التي تحول دون اعتماد التعلم المعزز في التطبيقات الحرجة للسلامة. في هذا المنشور، سنقوم ببناء حل شامل للعثور على سياسات التحكم المثالية باستخدام البيانات التاريخية فقط الأمازون SageMaker باستخدام راي رليب مكتبة. لمعرفة المزيد حول التعلم المعزز، راجع استخدم التعلم المعزز مع Amazon SageMaker.

استخدم حالات

يتضمن التحكم الصناعي إدارة الأنظمة المعقدة، مثل خطوط التصنيع وشبكات الطاقة والمصانع الكيميائية، لضمان التشغيل الفعال والموثوق. تعتمد العديد من استراتيجيات التحكم التقليدية على قواعد ونماذج محددة مسبقًا، والتي غالبًا ما تتطلب التحسين اليدوي. من الممارسات المعتادة في بعض الصناعات مراقبة الأداء وضبط سياسة التحكم، على سبيل المثال، عندما تبدأ المعدات في التدهور أو تتغير الظروف البيئية. يمكن أن تستغرق إعادة الضبط أسابيع وقد تتطلب حقن إثارات خارجية في النظام لتسجيل استجابته بأسلوب التجربة والخطأ.

لقد ظهر التعلم المعزز كنموذج جديد في التحكم في العمليات لتعلم سياسات التحكم المثلى من خلال التفاعل مع البيئة. تتطلب هذه العملية تقسيم البيانات إلى ثلاث فئات: 1) القياسات المتاحة من النظام المادي، 2) مجموعة الإجراءات التي يمكن اتخاذها على النظام، و3) المقياس الرقمي (المكافأة) لأداء المعدات. يتم تدريب السياسة للعثور على الإجراء، عند ملاحظة معينة، والذي من المرجح أن ينتج أعلى المكافآت المستقبلية.

في التعلم المعزز دون الاتصال بالإنترنت، يمكن للمرء تدريب السياسة على البيانات التاريخية قبل نشرها في الإنتاج. الخوارزمية التي تم تدريبها في منشور المدونة هذا تسمى "التعلم المحافظ Q"(سي كيو إل). تحتوي CQL على نموذج "ممثل" ونموذج "ناقد" وهي مصممة للتنبؤ بأدائها بشكل متحفظ بعد اتخاذ الإجراء الموصى به. في هذا المنشور، يتم توضيح العملية من خلال مشكلة توضيحية للتحكم في عمود العربة. الهدف هو تدريب العميل على موازنة عمود على عربة بينما يقوم في نفس الوقت بتحريك العربة نحو موقع الهدف المحدد. يستخدم إجراء التدريب البيانات غير المتصلة بالإنترنت، مما يسمح للوكيل بالتعلم من المعلومات الموجودة مسبقًا. توضح دراسة حالة عمود العربة هذه عملية التدريب وفعاليتها في التطبيقات الواقعية المحتملة.

حل نظرة عامة

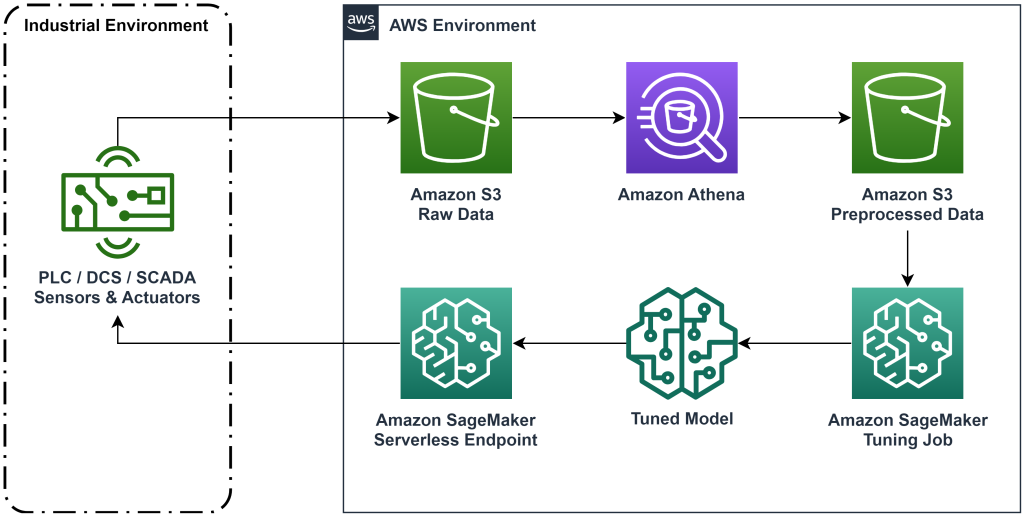

يعمل الحل المقدم في هذا المنشور على أتمتة نشر سير العمل الشامل للتعلم المعزز دون اتصال بالإنترنت باستخدام البيانات التاريخية. يصف الرسم التخطيطي التالي البنية المستخدمة في سير العمل هذا. يتم إنتاج بيانات القياس عند الحافة بواسطة قطعة من المعدات الصناعية (هنا تتم محاكاتها بواسطة AWS لامدا وظيفة). يتم وضع البيانات في أمازون كينسيس Data Firehose، الذي يخزنها فيه خدمة تخزين أمازون البسيطة (أمازون إس 3). يعد Amazon S3 حل تخزين متينًا وعالي الأداء ومنخفض التكلفة يسمح لك بتقديم كميات كبيرة من البيانات لعملية التدريب على التعلم الآلي.

غراء AWS يقوم بفهرسة البيانات ويجعلها قابلة للاستعلام باستخدامها أمازون أثينا. تقوم Athena بتحويل بيانات القياس إلى نموذج يمكن لخوارزمية التعلم المعزز استيعابها ثم تفريغها مرة أخرى في Amazon S3. يقوم Amazon SageMaker بتحميل هذه البيانات في مهمة تدريبية وينتج نموذجًا مُدربًا. يقوم SageMaker بعد ذلك بتقديم هذا النموذج في نقطة نهاية SageMaker. يمكن للمعدات الصناعية بعد ذلك الاستعلام عن نقطة النهاية لتلقي توصيات الإجراء.

الشكل 1: مخطط معماري يوضح سير عمل التعلم المعزز الشامل.

في هذه التدوينة، سنقوم بتقسيم سير العمل في الخطوات التالية:

- صياغة المشكلة. حدد الإجراءات التي يمكن اتخاذها، والقياسات التي يجب تقديم التوصيات بناءً عليها، وحدد رقميًا مدى جودة تنفيذ كل إجراء.

- تحضير البيانات. تحويل جدول القياسات إلى تنسيق يمكن أن تستهلكه خوارزمية التعلم الآلي.

- تدريب الخوارزمية على تلك البيانات.

- حدد أفضل تدريب بناءً على مقاييس التدريب.

- انشر النموذج إلى نقطة نهاية SageMaker.

- تقييم أداء النموذج في الإنتاج.

المتطلبات الأساسية المسبقة

لإكمال هذه الإرشادات، يجب أن يكون لديك حساب AWS وواجهة سطر الأوامر مع تم تثبيت AWS SAM. اتبع هذه الخطوات لنشر قالب AWS SAM لتشغيل سير العمل هذا وإنشاء بيانات التدريب:

- قم بتنزيل مستودع الكود باستخدام الأمر

- تغيير الدليل إلى الريبو:

- بناء الريبو:

- نشر الريبو

- استخدم الأوامر التالية لاستدعاء برنامج bash النصي، الذي يقوم بإنشاء بيانات وهمية باستخدام وظيفة AWS Lambda.

sudo yum install jqcd utilssh generate_mock_data.sh

تجول الحل

صياغة المشكلة

نظامنا في منشور المدونة هذا عبارة عن عربة ذات عمود متوازن في الأعلى. يعمل النظام جيدًا عندما يكون العمود في وضع مستقيم، ويكون موضع العربة قريبًا من موضع المرمى. في الخطوة المطلوبة، قمنا بإنشاء بيانات تاريخية من هذا النظام.

ويبين الجدول التالي البيانات التاريخية التي تم جمعها من النظام.

| موقف العربة | سرعة العربة | زاوية القطب | السرعة الزاوية القطبية | موقف الهدف | القوة الخارجية | مكافأة | الوقت: |

| 0.53 | -0.79 | -0.08 | 0.16 | 0.50 | -0.04 | 11.5 | 5: 37: 54 PM |

| 0.51 | -0.82 | -0.07 | 0.17 | 0.50 | -0.04 | 11.9 | 5: 37: 55 PM |

| 0.50 | -0.84 | -0.07 | 0.18 | 0.50 | -0.03 | 12.2 | 5: 37: 56 PM |

| 0.48 | -0.85 | -0.07 | 0.18 | 0.50 | -0.03 | 10.5 | 5: 37: 57 PM |

| 0.46 | -0.87 | -0.06 | 0.19 | 0.50 | -0.03 | 10.3 | 5: 37: 58 PM |

يمكنك الاستعلام عن معلومات النظام التاريخية باستخدام Amazon Athena من خلال الاستعلام التالي:

يتم تحديد حالة هذا النظام من خلال موضع العربة، وسرعة العربة، وزاوية القطب، والسرعة الزاوية للقطب، وموضع الهدف. الإجراء المتخذ في كل خطوة هو القوة الخارجية المطبقة على العربة. تنتج البيئة المحاكاة قيمة مكافأة أعلى عندما تكون العربة أقرب إلى موضع الهدف ويكون العمود أكثر استقامة.

إعداد البيانات

لتقديم معلومات النظام إلى نموذج التعلم المعزز، قم بتحويلها إلى كائنات JSON باستخدام مفاتيح تصنف القيم إلى فئات الحالة (وتسمى أيضًا الملاحظة) والإجراء والمكافأة. قم بتخزين هذه الكائنات في Amazon S3. فيما يلي مثال لكائنات JSON التي تم إنتاجها من الخطوات الزمنية في الجدول السابق.

|

{“obs”:[[0.53,-0.79,-0.08,0.16,0.5]], “action”:[[-0.04]], “reward”:[11.5] ,”next_obs”:[[0.51,-0.82,-0.07,0.17,0.5]]} |

|

{“obs”:[[0.51,-0.82,-0.07,0.17,0.5]], “action”:[[-0.04]], “reward”:[11.9], “next_obs”:[[0.50,-0.84,-0.07,0.18,0.5]]} |

|

{“obs”:[[0.50,-0.84,-0.07,0.18,0.5]], “action”:[[-0.03]], “reward”:[12.2], “next_obs”:[[0.48,-0.85,-0.07,0.18,0.5]]} |

يحتوي مكدس AWS CloudFormation على مخرج يسمى AthenaQueryToCreateJsonFormatedData. قم بتشغيل هذا الاستعلام في Amazon Athena لإجراء التحويل وتخزين كائنات JSON في Amazon S3. تستخدم خوارزمية التعلم المعزز بنية كائنات JSON لفهم القيم التي ستبني عليها التوصيات ونتائج اتخاذ الإجراءات في البيانات التاريخية.

وكيل القطار

يمكننا الآن أن نبدأ مهمة تدريبية لإنتاج نموذج توصية عمل مدرب. يتيح لك Amazon SageMaker تشغيل وظائف تدريبية متعددة بسرعة لمعرفة مدى تأثير التكوينات المختلفة على النموذج المُدرب الناتج. اتصل بوظيفة Lambda المسماة TuningJobLauncherFunction لبدء مهمة ضبط المعلمات الفائقة التي تقوم بتجربة أربع مجموعات مختلفة من المعلمات الفائقة عند تدريب الخوارزمية.

اختيار أفضل تشغيل التدريب

للعثور على أي من وظائف التدريب أنتجت أفضل نموذج، قم بفحص منحنيات الخسارة الناتجة أثناء التدريب. يقوم نموذج CQL الناقد بتقدير أداء الممثل (يسمى قيمة Q) بعد اتخاذ الإجراء الموصى به. يتضمن جزء من دالة الخسارة الناقدة خطأ الفرق الزمني. يقيس هذا المقياس دقة قيمة Q للناقد. ابحث عن الدورات التدريبية ذات قيمة Q المتوسطة العالية وخطأ الفرق الزمني المنخفض. هذه الورقة، سير عمل للتعلم المعزز الآلي بدون نماذجتفاصيل كيفية اختيار أفضل مسار تدريبي. يحتوي مستودع التعليمات البرمجية على ملف، /utils/investigate_training.py، يؤدي ذلك إلى إنشاء شكل html يصف أحدث مهمة تدريبية. قم بتشغيل هذا الملف واستخدم الإخراج لاختيار أفضل تدريب.

يمكننا استخدام متوسط قيمة Q للتنبؤ بأداء النموذج المدرب. يتم تدريب قيم Q للتنبؤ بشكل متحفظ بمجموع قيم المكافآت المستقبلية المخصومة. بالنسبة للعمليات طويلة الأمد، يمكننا تحويل هذا الرقم إلى متوسط مرجح بشكل كبير عن طريق ضرب قيمة Q في (1-"سعر الخصم"). أفضل تدريب في هذه المجموعة حقق متوسط قيمة Q قدره 539. معدل الخصم لدينا هو 0.99، لذا يتوقع النموذج متوسط مكافأة يبلغ 5.39 على الأقل لكل خطوة زمنية. يمكنك مقارنة هذه القيمة بأداء النظام التاريخي للإشارة إلى ما إذا كان النموذج الجديد سيتفوق على سياسة التحكم التاريخية. في هذه التجربة، كان متوسط مكافأة البيانات التاريخية لكل خطوة زمنية 4.3، لذلك يتوقع نموذج CQL أداءً أفضل بنسبة 25 بالمائة من النظام الذي تم تحقيقه تاريخيًا.

نشر النموذج

تتيح لك نقاط نهاية Amazon SageMaker خدمة نماذج التعلم الآلي بعدة طرق مختلفة لتلبية مجموعة متنوعة من حالات الاستخدام. في هذا المنشور، سنستخدم نوع نقطة النهاية بدون خادم بحيث تتكيف نقطة النهاية الخاصة بنا تلقائيًا مع الطلب، وندفع فقط مقابل استخدام الحوسبة عندما تقوم نقطة النهاية بإنشاء استنتاج. لنشر نقطة نهاية بدون خادم، قم بتضمين أ ProductionVariantServerlessConfig في ال متغير الإنتاج من SageMaker تكوين نقطة النهاية. يوضح مقتطف التعليمات البرمجية التالي كيفية نشر نقطة النهاية بدون خادم في هذا المثال باستخدام مجموعة تطوير برامج Amazon SageMaker لـ Python. ابحث عن نموذج التعليمات البرمجية المستخدم لنشر النموذج في sagemaker-offline-reinforcement-learning-ray-cql.

توجد ملفات النماذج المدربة في عناصر نموذج S3 لكل عملية تدريب. لنشر نموذج التعلم الآلي، حدد موقع ملفات النموذج لأفضل تدريب، واستدعاء وظيفة Lambda المسماة "ModelDeployerFunction"بحدث يحتوي على بيانات النموذج هذه. ستطلق وظيفة Lambda نقطة نهاية بدون خادم SageMaker لخدمة النموذج المُدرب. نموذج حدث لاستخدامه عند استدعاء "ModelDeployerFunction"

تقييم أداء النموذج المدرب

حان الوقت لنرى كيف يعمل نموذجنا المدرّب في الإنتاج! للتحقق من أداء النموذج الجديد، اتصل بوظيفة Lambda المسماة "RunPhysicsSimulationFunction" مع اسم نقطة نهاية SageMaker في الحدث. سيؤدي هذا إلى تشغيل المحاكاة باستخدام الإجراءات الموصى بها بواسطة نقطة النهاية. حدث نموذجي لاستخدامه عند استدعاء RunPhysicsSimulatorFunction:

استخدم استعلام Athena التالي لمقارنة أداء النموذج المُدرب مع أداء النظام التاريخي.

| مصدر العمل | متوسط المكافأة لكل خطوة زمنية |

trained_model |

10.8 |

historic_data |

4.3 |

توضح الرسوم المتحركة التالية الفرق بين حلقة نموذجية من بيانات التدريب وحلقة تم فيها استخدام النموذج المُدرب لاختيار الإجراء الذي سيتم اتخاذه. في الرسوم المتحركة، المربع الأزرق هو العربة، والخط الأزرق هو العمود، والمستطيل الأخضر هو موقع الهدف. يوضح السهم الأحمر القوة المطبقة على العربة في كل خطوة زمنية. يقفز السهم الأحمر الموجود في بيانات التدريب ذهابًا وإيابًا قليلاً لأنه تم إنشاء البيانات باستخدام 50 بالمائة من إجراءات الخبراء و50 بالمائة من الإجراءات العشوائية. لقد تعلم النموذج المدرّب سياسة تحكم تحرك العربة بسرعة إلى موضع الهدف، مع الحفاظ على الاستقرار، كليًا من مراقبة العروض التوضيحية غير المتخصصة.

|

|

تنظيف

لحذف الموارد المستخدمة في سير العمل هذا، انتقل إلى قسم الموارد في مكدس Amazon CloudFormation واحذف حاويات S3 وأدوار IAM. ثم قم بحذف مكدس CloudFormation نفسه.

وفي الختام

يمكن للتعلم المعزز دون اتصال بالإنترنت أن يساعد الشركات الصناعية على أتمتة البحث عن السياسات المثلى دون المساس بالسلامة باستخدام البيانات التاريخية. لتنفيذ هذا النهج في عملياتك، ابدأ بتحديد القياسات التي تشكل النظام الذي تحدده الحالة، والإجراءات التي يمكنك التحكم فيها، والمقاييس التي تشير إلى الأداء المطلوب. ثم الوصول هذا مستودع جيثب لتنفيذ حل تلقائي شامل باستخدام Ray وAmazon SageMaker.

يخدش المنشور سطح ما يمكنك فعله باستخدام Amazon SageMaker RL. جربها، ويرجى إرسال تعليقات إلينا، إما في منتدى مناقشة أمازون SageMaker أو من خلال جهات اتصال AWS المعتادة.

حول المؤلف

والت مايفيلد هو مهندس الحلول في AWS ويساعد شركات الطاقة على العمل بشكل أكثر أمانًا وكفاءة. قبل انضمامه إلى AWS، عمل والت كمهندس عمليات في شركة Hilcorp Energy. يحب البستنة ويطير السمك في أوقات فراغه.

والت مايفيلد هو مهندس الحلول في AWS ويساعد شركات الطاقة على العمل بشكل أكثر أمانًا وكفاءة. قبل انضمامه إلى AWS، عمل والت كمهندس عمليات في شركة Hilcorp Energy. يحب البستنة ويطير السمك في أوقات فراغه.

فيليبي لوبيز هو مهندس حلول أول في AWS مع التركيز على عمليات إنتاج النفط والغاز. قبل انضمامه إلى AWS، عمل فيليبي مع GE Digital وSchlumberger، حيث ركز على تصميم المنتجات وتحسينها للتطبيقات الصناعية.

فيليبي لوبيز هو مهندس حلول أول في AWS مع التركيز على عمليات إنتاج النفط والغاز. قبل انضمامه إلى AWS، عمل فيليبي مع GE Digital وSchlumberger، حيث ركز على تصميم المنتجات وتحسينها للتطبيقات الصناعية.

ينغوي يو هو عالم تطبيقي في Geneative AI Incubator، AWS. لديه خبرة في العمل مع العديد من المنظمات عبر الصناعات على إثباتات مختلفة للمفهوم في التعلم الآلي، بما في ذلك معالجة اللغة الطبيعية، وتحليل السلاسل الزمنية، والصيانة التنبؤية. يستمتع في أوقات فراغه بالسباحة والرسم والمشي لمسافات طويلة وقضاء الوقت مع العائلة والأصدقاء.

ينغوي يو هو عالم تطبيقي في Geneative AI Incubator، AWS. لديه خبرة في العمل مع العديد من المنظمات عبر الصناعات على إثباتات مختلفة للمفهوم في التعلم الآلي، بما في ذلك معالجة اللغة الطبيعية، وتحليل السلاسل الزمنية، والصيانة التنبؤية. يستمتع في أوقات فراغه بالسباحة والرسم والمشي لمسافات طويلة وقضاء الوقت مع العائلة والأصدقاء.

Haozhu وانغ هو عالم أبحاث في Amazon Bedrock ويركز على بناء نماذج مؤسسة Amazon's Titan. كان يعمل سابقًا في Amazon ML Solutions Lab كقائد مشارك لـ Reinforcement Learning Vertical وساعد العملاء على بناء حلول ML متقدمة باستخدام أحدث الأبحاث حول التعلم المعزز ومعالجة اللغة الطبيعية وتعلم الرسم البياني. حصل Haozhu على درجة الدكتوراه في الهندسة الكهربائية وهندسة الكمبيوتر من جامعة ميشيغان.

Haozhu وانغ هو عالم أبحاث في Amazon Bedrock ويركز على بناء نماذج مؤسسة Amazon's Titan. كان يعمل سابقًا في Amazon ML Solutions Lab كقائد مشارك لـ Reinforcement Learning Vertical وساعد العملاء على بناء حلول ML متقدمة باستخدام أحدث الأبحاث حول التعلم المعزز ومعالجة اللغة الطبيعية وتعلم الرسم البياني. حصل Haozhu على درجة الدكتوراه في الهندسة الكهربائية وهندسة الكمبيوتر من جامعة ميشيغان.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- تشارت بريم. ارفع مستوى لعبة التداول الخاصة بك مع ChartPrime. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/optimize-equipment-performance-with-historical-data-ray-and-amazon-sagemaker/

- :لديها

- :يكون

- :ليس

- :أين

- $ UP

- 07

- 08

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 16

- 17

- 25

- 32

- 39

- 50

- 51

- 54

- 7

- 8

- 84

- 9

- a

- من نحن

- الوصول

- دقة

- تحقق

- في

- اكشن

- الإجراءات

- وبالإضافة إلى ذلك

- تبني

- متقدم

- تؤثر

- بعد

- الوكيل

- AI

- خوارزمية

- السماح

- يسمح

- أيضا

- أمازون

- أمازون أثينا

- مختبر أمازون ML Solutions

- الأمازون SageMaker

- أمازون ويب سيرفيسز

- an

- تحليل

- و

- زاوي

- الرسوم المتحركة

- التطبيقات

- تطبيقي

- نهج

- هندسة معمارية

- هي

- AS

- At

- أتمتة

- الأتمتة

- أوتوماتيك

- تلقائيا

- متاح

- المتوسط

- AWS

- تكوين سحابة AWS

- AWS لامدا

- الى الخلف

- الرصيد

- الحواجز

- قاعدة

- على أساس

- سحق

- BE

- لان

- قبل

- أفضل

- أفضل

- ما بين

- قطعة

- المدونة

- الأزرق

- صندوق

- استراحة

- كسر

- نساعدك في بناء

- ابني

- by

- دعوة

- تسمى

- دعوة

- CAN

- حقيبة

- دراسة حالة

- الحالات

- كتالوجات

- الفئات

- سبب

- تغيير

- التحقق

- مادة كيميائية

- اغلاق

- أقرب

- الكود

- الشركات

- حول الشركة

- قارن

- إكمال

- مجمع

- مساومة

- إحصاء

- الكمبيوتر

- هندسة الكمبيوتر

- من التركيز

- مفهوم

- الشروط

- محافظ

- تستهلك

- استهلاك

- جهات الاتصال

- يحتوي

- مراقبة

- تحول

- يخلق

- الناقد

- العملاء

- البيانات

- تقرر

- تعريف

- الطلب

- تظاهر

- يوضح

- نشر

- نشر

- نشر

- نشر

- محدد

- تصميم

- مطلوب

- تفاصيل

- حدد

- التطوير التجاري

- فرق

- مختلف

- رقمي

- مباشرة

- خصم الإخوة الإضافي

- مخفضة

- مناقشة

- do

- هل

- فعل

- إلى أسفل

- الوقت الضائع

- أثناء

- دينامية

- كل

- حافة

- فعالية

- فعال

- بكفاءة

- إما

- ظهرت

- تمكين

- النهائي إلى نهاية

- نقطة النهاية

- طاقة

- استهلاك الطاقة

- مهندس

- الهندسة

- ضمان

- تماما

- البيئة

- بيئي

- حلقة

- معدات

- خطأ

- تقديرات

- الحدث/الفعالية

- بحث

- مثال

- الخبره في مجال الغطس

- تجربة

- تجارب

- خبير

- استكشاف

- أضعافا مضاعفة

- خارجي

- للعائلات

- ردود الفعل

- الشكل

- قم بتقديم

- ملفات

- العثور على

- سمك

- ركز

- التركيز

- اتباع

- متابعيك

- في حالة

- القوة

- النموذج المرفق

- شكل

- عليها

- دورة تأسيسية

- أربعة

- الاصدقاء

- تبدأ من

- وظيفة

- مستقبل

- حدائق خارجية

- GAS

- جمعت

- ge

- توليد

- ولدت

- يولد

- توليد

- توليدي

- الذكاء الاصطناعي التوليدي

- GIF

- GitHub جيثب:

- منح

- معطى

- هدف

- رسم بياني

- أخضر

- تجمع

- الثابت

- يملك

- he

- مساعدة

- ساعد

- يساعد

- هنا

- مرتفع

- أعلى

- أعلى

- له

- تاريخي

- تاريخيا

- كيفية

- كيفية

- HTML

- HTTPS

- ضبط Hyperparameter

- تحديد

- if

- تنفيذ

- التنفيذ

- in

- تتضمن

- يشمل

- بما فيه

- القيمة الاسمية

- حاضنة

- تشير

- إشارة

- صناعي

- الصناعات

- معلومات

- تثبيت

- التفاعل

- تفاعل

- السطح البيني

- إلى

- IT

- انها

- نفسها

- وظيفة

- المشــاريــع

- انضمام

- JPG

- جسون

- يقفز

- م

- مفاتيح

- مختبر

- لغة

- كبير

- آخر

- إطلاق

- تعلم

- تعلم

- تعلم

- الأقل

- اسمحوا

- يتيح

- المكتبة

- على الأرجح

- الإعجابات

- مما سيحدث

- خط

- خطوط

- الأحمال

- تقع

- موقع

- بحث

- خسارة

- منخفض

- منخفضة التكلفة

- آلة

- آلة التعلم

- الحفاظ على

- صيانة

- جعل

- يصنع

- إدارة

- كتيب

- تصنيع

- كثير

- تعظيم

- مايو..

- تعني

- قياس

- قياسات

- الإجراءات

- تعرف علي

- متري

- المقاييس

- ميشيغان

- ML

- نموذج

- تصميم

- عارضات ازياء

- مراقبة

- الأكثر من ذلك

- التحركات

- يتحرك

- متعدد

- ضرب

- الاسم

- عين

- طبيعي

- معالجة اللغات الطبيعية

- التنقل

- حاجة

- جديد

- عدد

- الأجسام

- of

- حاليا

- غالبا

- زيت

- on

- ONE

- فقط

- طريقة التوسع

- عملية

- عمليات

- الأمثل

- التحسين

- الأمثل

- or

- طلب

- المنظمات

- لنا

- نتيجة

- يتفوق على

- الناتج

- على مدى

- الخاصة

- اللوحة

- ورق

- نموذج

- جزء

- إلى

- فى المائة

- نفذ

- أداء

- تنفيذ

- ينفذ

- رسالة دكتوراه

- مادي

- اختيار

- قطعة

- الشتلات

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- من فضلك

- سياسات الخصوصية والبيع

- سياسة

- ان يرتفع المركز

- منشور

- محتمل

- ممارسة

- تنبأ

- توقع

- تنبؤ

- يقدم

- قدم

- سابق

- سابقا

- قبل

- المشكلة

- الإجراءات

- عملية المعالجة

- العمليات

- معالجة

- إنتاج

- أنتج

- ينتج عنه

- الإنتــاج

- إنتاجية

- المنتجات

- المزيد من الربح

- البراهين

- وضع

- بايثون

- بسرعة

- عشوائية

- معدل

- RAY

- العالم الحقيقي

- تسلم

- تلقى

- توصية مجاناً

- ساندي خ. ميليك

- موصى به

- سجل

- أحمر

- تقليص

- الخدمة الموثوقة

- مستودع

- تطلب

- يتطلب

- بحث

- الموارد

- استجابة

- مما أدى

- النتائج

- مكافأة

- الجوائز

- الأدوار

- القواعد

- يجري

- يدير

- بسلام

- السلامة

- sagemaker

- سام

- النطاقات

- عالم

- سيناريو

- بحث

- القسم

- انظر تعريف

- إرسال

- كبير

- مسلسلات

- خدمة

- Serverless

- يخدم

- خدماتنا

- طقم

- باكجات

- عدة

- إظهار

- يظهر

- الاشارات

- محاكاة

- معا

- قصاصة

- So

- تطبيقات الكمبيوتر

- تطوير البرمجيات

- ادوات \ عده تطوير البرمجيات

- حل

- الحلول

- بعض

- الإنفاق

- استقرار

- كومة

- المسرح

- معيار

- بداية

- يبدأ

- الولايه او المحافظه

- خطوة

- خطوات

- تخزين

- متجر

- فروعنا

- استراتيجيات

- الإستراتيجيات

- بناء

- دراسة

- هذه

- المساحة

- نظام

- أنظمة

- جدول

- أخذ

- اتخذت

- مع الأخذ

- مهمة

- قالب

- من

- أن

- •

- الدولة

- من مشاركة

- then

- تشبه

- ثلاثة

- عبر

- الوقت

- السلاسل الزمنية

- عملاق

- إلى

- تيشرت

- نحو

- تقليدي

- قطار

- متدرب

- قادة الإيمان

- تحول

- تحول

- التحويلات

- صحيح

- محاولة

- نوع

- فهم

- جامعة

- بناء على

- us

- الأستعمال

- تستخدم

- مستعمل

- يستخدم

- استخدام

- قيمنا

- القيم

- تشكيلة

- مختلف

- ● السرعة

- عمودي

- مجلدات

- تجول

- وكان

- طرق

- we

- الويب

- خدمات ويب

- أسابيع

- حسن

- ابحث عن

- متى

- التي

- في حين

- سوف

- ريح

- مع

- بدون

- عمل

- سير العمل

- عامل

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت