الأمازون SageMaker يوفر مجموعة من خوارزميات مدمجة, نماذج مدربة مسبقًاو قوالب الحلول الجاهزة لمساعدة علماء البيانات وممارسي التعلم الآلي (ML) على البدء في التدريب ونشر نماذج التعلم الآلي بسرعة. يمكنك استخدام هذه الخوارزميات والنماذج لكل من التعلم الخاضع للإشراف وغير الخاضع للإشراف. يمكنهم معالجة أنواع مختلفة من بيانات الإدخال ، بما في ذلك الجدول والصورة والنص.

بدءًا من اليوم ، تقدم خوارزمية SageMaker LightGBM تدريبًا موزعًا باستخدام داسك إطار لكل من التصنيف الجدولي ومهام الانحدار. إنها متاحة من خلال SageMaker بيثون SDK. يمكن أن يكون تنسيق البيانات المدعوم إما CSV أو الباركيه. يتم إجراء تجارب قياس الأداء واسعة النطاق على ثلاث مجموعات بيانات متاحة للجمهور مع إعدادات مختلفة للتحقق من أدائها.

يهتم العملاء بشكل متزايد بنماذج التدريب على مجموعات البيانات الكبيرة باستخدام SageMaker LightGBM ، والتي قد تستغرق يومًا أو أكثر. في هذه الحالات ، قد تتمكن من تسريع العملية من خلال توزيع التدريب على أجهزة أو عمليات متعددة في مجموعة. يناقش هذا المنشور كيف يساعدك SageMaker LightGBM في إعداد التدريب الموزع وإطلاقه ، دون تكلفة وصعوبة إدارة مجموعات التدريب الخاصة بك بشكل مباشر.

بيان المشكلة

أصبح التعلم الآلي أداة أساسية لاستخراج الرؤى من كميات كبيرة من البيانات. من التعرف على الصور والكلام إلى معالجة اللغة الطبيعية والتحليلات التنبؤية ، تم تطبيق نماذج ML على مجموعة واسعة من المشاكل. مع استمرار نمو مجموعات البيانات من حيث الحجم والتعقيد ، يمكن أن تصبح أساليب التدريب التقليدية مستهلكة للوقت وكثيفة الموارد بشكل متزايد. هذا هو المكان الذي يلعب فيه التدريب الموزع.

التدريب الموزع هو تقنية تسمح بالمعالجة المتوازية لكميات كبيرة من البيانات عبر أجهزة أو أجهزة متعددة. من خلال تقسيم البيانات وتدريب نماذج متعددة على التوازي ، يمكن أن يقلل التدريب الموزع بشكل كبير من وقت التدريب ويحسن أداء النماذج على البيانات الضخمة. في السنوات الأخيرة ، كان التدريب الموزع آلية شائعة في تدريب الشبكات العصبية العميقة على حالات الاستخدام مثل نماذج اللغة الكبيرة (LLMs) ، وإنشاء الصور وتصنيفها ، ومهام إنشاء النص باستخدام أطر عمل مثل PyTorch و TensorFlow و MXNet. في هذا المنشور ، نناقش كيف يمكن تطبيق التدريب الموزع على البيانات الجدولية (نوع شائع من البيانات موجود في العديد من الصناعات مثل التمويل والرعاية الصحية والتجزئة) باستخدام خوارزمية Dask و LightGBM لمهام مثل الانحدار والتصنيف.

Dask هي مكتبة حوسبة متوازية مفتوحة المصدر تسمح بالمعالجة المتوازية الموزعة لمجموعات البيانات الكبيرة في Python. إنه مصمم للعمل مع نظام Python والنظام البيئي الحالي لعلوم البيانات مثل NumPy و Pandas. عندما يتعلق الأمر بالتدريب الموزع ، يمكن استخدام Dask لموازنة تحميل البيانات والمعالجة المسبقة ومهام التدريب النموذجية ، وهو يتكامل جيدًا مع خوارزميات ML الشائعة مثل LightGBM. LightGBM هو إطار عمل معزز متدرج يستخدم خوارزميات التعلم القائمة على الأشجار ، والتي تم تصميمها لتكون فعالة وقابلة للتطوير لتدريب النماذج الكبيرة على البيانات الضخمة. من خلال الجمع بين هاتين المكتبتين القويتين ، تم دمج LightGBM v3.2.0 الآن مع Dask للسماح بالتعلم الموزع عبر أجهزة متعددة لإنتاج نموذج واحد.

كيف يعمل التدريب الموزع

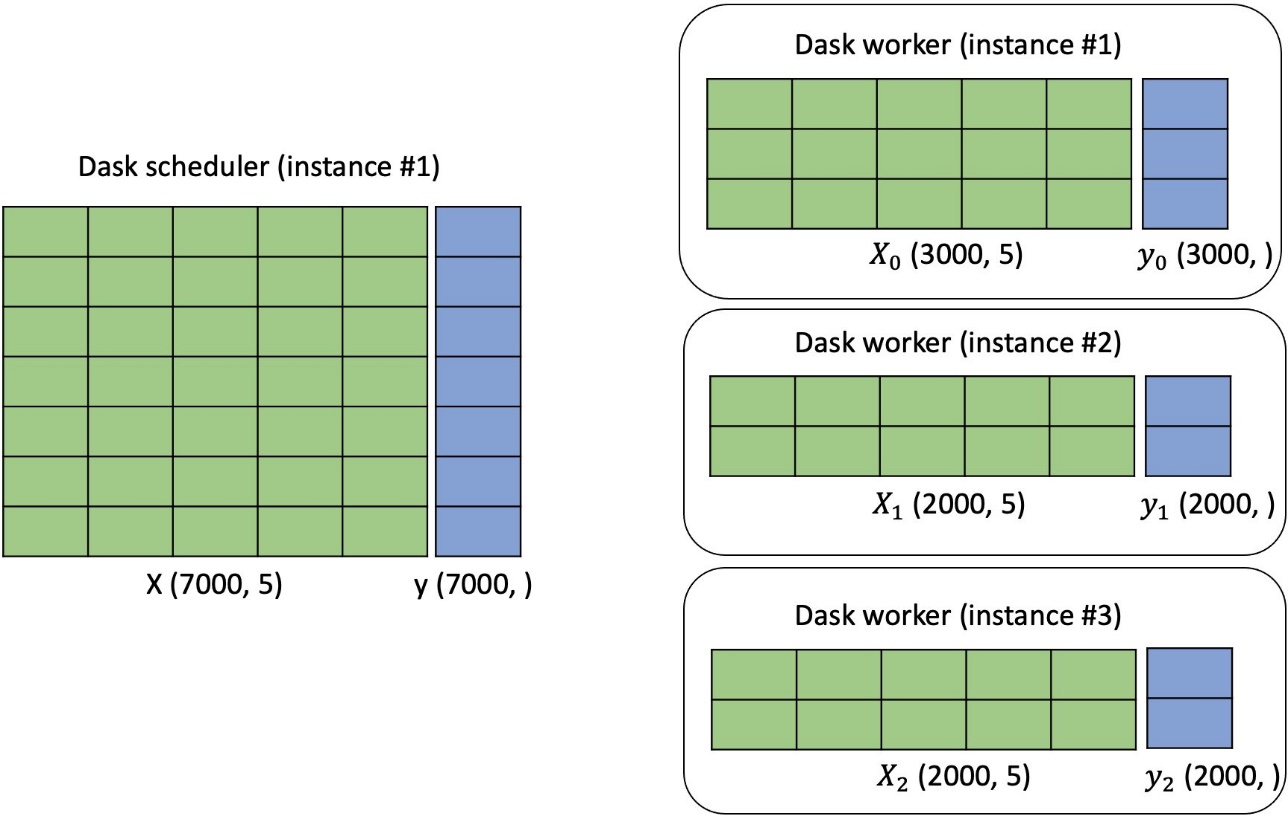

التدريب الموزع على الخوارزميات المستندة إلى الشجرة هو أسلوب يتم استخدامه عندما تكون مجموعة البيانات كبيرة جدًا بحيث لا يمكن معالجتها على مثيل واحد أو عندما لا تكون الموارد الحسابية لمثيل واحد كافية لتدريب النموذج المستند إلى الشجرة بكمية معقولة من الوقت. يسمح بتدريب نموذج عبر مثيلات أو آلات متعددة ، بدلاً من جهاز واحد. يتم ذلك عن طريق تقسيم مجموعة البيانات إلى مجموعات فرعية أصغر تسمى قطع، وتوزيعها على المثيلات المتاحة. ثم يقوم كل مثيل بتدريب نموذج على مجموعة البيانات المخصصة له ، ويتم دمج النتائج لاحقًا باستخدام خوارزميات التجميع لتشكيل نموذج واحد.

في النماذج المستندة إلى الأشجار مثل LightGBM ، تكمن التكلفة الحسابية الرئيسية في بناء هيكل الشجرة. يتم ذلك عادةً عن طريق فرز واختيار مجموعات فرعية من البيانات.

الآن ، دعنا نستكشف كيف يقوم LightGBM بالتدريب الموازي. يمكن لـ LightGBM استخدام ثلاثة أنواع من التوازي:

- توازي البيانات - هذا هو الشكل الأساسي لتوازي البيانات. يتم تقسيم البيانات أفقيًا إلى مجموعات فرعية أصغر ويتم توزيعها بين مثيلات متعددة. يقوم كل مثيل ببناء المدرج التكراري المحلي الخاص به ، ويتم دمج جميع الرسوم البيانية ، ثم يتم إجراء الانقسام باستخدام ملف تقليل التشتت الخوارزمية. يتم إنشاء المدرج التكراري في الحالات المحلية عن طريق تقسيم المجموعة الفرعية من البيانات المحلية إلى صناديق منفصلة ، وحساب عدد نقاط البيانات في كل حاوية. تساعد هذه الخوارزمية القائمة على الرسم البياني في تسريع التدريب وتقليل استخدام الذاكرة.

- ميزة التوازي - في توازي الميزات ، يكون كل جهاز مسؤولاً عن تدريب مجموعة فرعية من ميزات النموذج ، بدلاً من مجموعة فرعية من البيانات. يمكن أن يكون هذا مفيدًا عند العمل مع مجموعات البيانات التي تحتوي على عدد كبير من الميزات ، لأنها تتيح استخدامًا أكثر كفاءة للموارد. إنه يعمل من خلال العثور على أفضل نقطة انقسام محلية في كل حالة ، ثم يقوم بتوصيل أفضل تقسيم مع المثيلات الأخرى. يحافظ تطبيق LightGBM على جميع ميزات البيانات في كل جهاز لتقليل تكلفة توصيل أفضل الانقسامات.

- موازاة التصويت - في موازاة التصويت ، يتم تقسيم البيانات إلى مجموعات فرعية أصغر وتوزيعها على أجهزة متعددة. تقوم كل آلة بتدريب نموذج على مجموعة البيانات الفرعية المخصصة لها ، ويتم دمج النتائج لاحقًا لتشكيل نموذج واحد أكبر. ومع ذلك ، بدلاً من استخدام التدرجات من جميع الأجهزة لتحديث معلمات النموذج ، يتم استخدام آلية التصويت لتحديد التدرجات التي يجب استخدامها. يمكن أن يكون هذا مفيدًا عند العمل مع مجموعات البيانات التي تحتوي على الكثير من الضوضاء أو القيم المتطرفة ، لأنها يمكن أن تساعد في تقليل تأثير هذه على النموذج النهائي. في وقت كتابة هذا المنشور ، كان تكامل LightGBM مع Dask يدعم فقط أنواع البيانات والتصويت المتوازية.

سيقوم SageMaker بإعداد وإدارة مجموعة Dask تلقائيًا عند استخدام مثيلات متعددة مع حاوية LightGBM المدمجة.

حل نظرة عامة

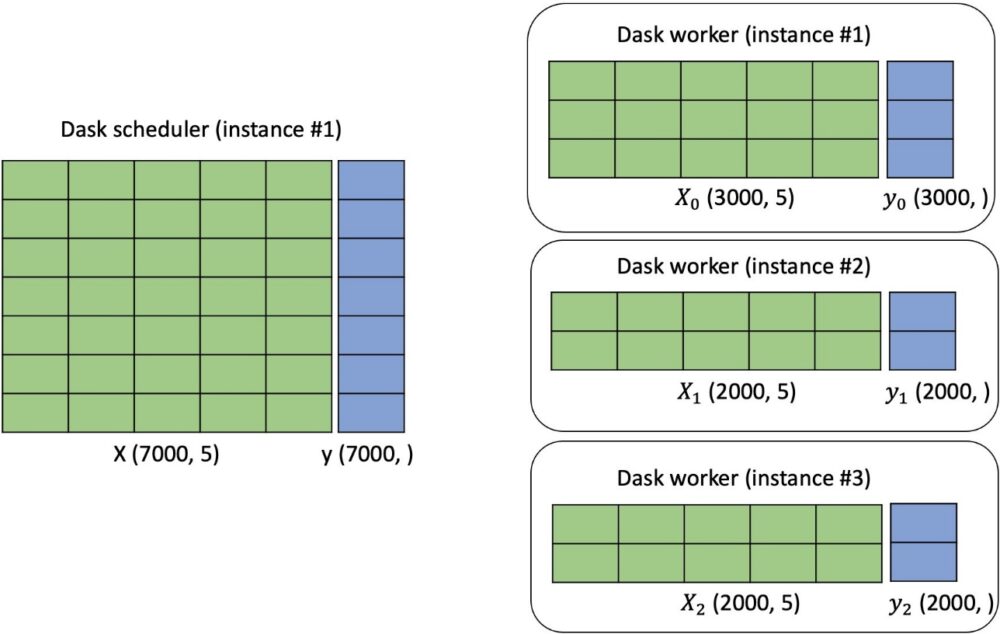

عندما تبدأ مهمة تدريبية باستخدام LightGBM بحالات متعددة ، نقوم أولاً بإنشاء مجموعة Dask. يعمل مثيل واحد كمجدول Dask ، والمثيلات المتبقية لها عمال Dask ، حيث يكون لكل عامل مؤشرات ترابط متعددة. كل عامل في العنقود لديه جزء من البيانات لإجراء الحسابات الموزعة ، كما هو موضح في الشكل التالي.

تمكين التدريب الموزع

متطلبات بيانات الإدخال هي كما يلي:

- يمكن أن يكون تنسيق بيانات الإدخال المدعوم للتدريب إما CSV أو باركيه. يُسمح لك بوضع أكثر من ملف بيانات واحد تحت كل من قنوات التدريب وقنوات التحقق من الصحة. إذا تم تحديد ملفات متعددة ، فستقوم الخوارزمية بتجميعها جميعًا على أنها بيانات تدريب أو التحقق من الصحة. يمكن أن يكون اسم ملف البيانات أي سلسلة طالما أنه ينتهي بـ .csv أو .parquet.

- لكل ملف بيانات ، تتطلب الخوارزمية أن يكون المتغير الهدف في العمود الأول وأنه لا ينبغي أن يحتوي على سجل رأس. هذا يتبع اتفاقية خوارزمية SageMaker XGBoost.

- إذا كانت تنبئك تتضمن ميزات فئوية ، فيمكنك تقديم ملف JSON مسمى

cat_index.jsonفي نفس موقع بيانات التدريب الخاصة بك. يجب أن يحتوي هذا الملف على قاموس Python ، حيث يمكن أن يكون المفتاح أي سلسلة والقيمة هي قائمة من الأعداد الصحيحة الفريدة. يجب أن يشير كل عدد صحيح في قائمة القيم إلى فهرس العمود الخاص بالميزات الفئوية المقابلة في ملف البيانات الخاص بك. يبدأ المؤشر بالقيمة 1 ، لأن القيمة 0 تتوافق مع المتغير المستهدف. الcat_index.jsonيجب وضع الملف تحت دليل بيانات التدريب ، كما هو موضح في المثال التالي. - نوع المثيل الذي يدعمه التدريب الموزع هو وحدة المعالجة المركزية.

دعنا نستخدم البيانات بتنسيق CSV كمثال. يمكن تنظيم بيانات القطار والتحقق من الصحة على النحو التالي:

يمكنك تحديد نوع الإدخال ليكون إما text/csv or application/x-parquet:

قبل التدريب الموزع ، يمكنك استرداد المعلمات الفائقة الافتراضية لـ LightGBM وتجاوزها بقيم مخصصة:

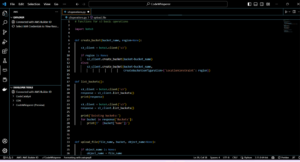

لتمكين التدريب الموزع ، يمكنك ببساطة تحديد الحجة instance_count في الفصل sagemaker.estimator.Estimator أن يكون أكثر من 1. يتم الاعتناء ببقية العمل تحت غطاء المحرك. انظر رمز المثال التالي:

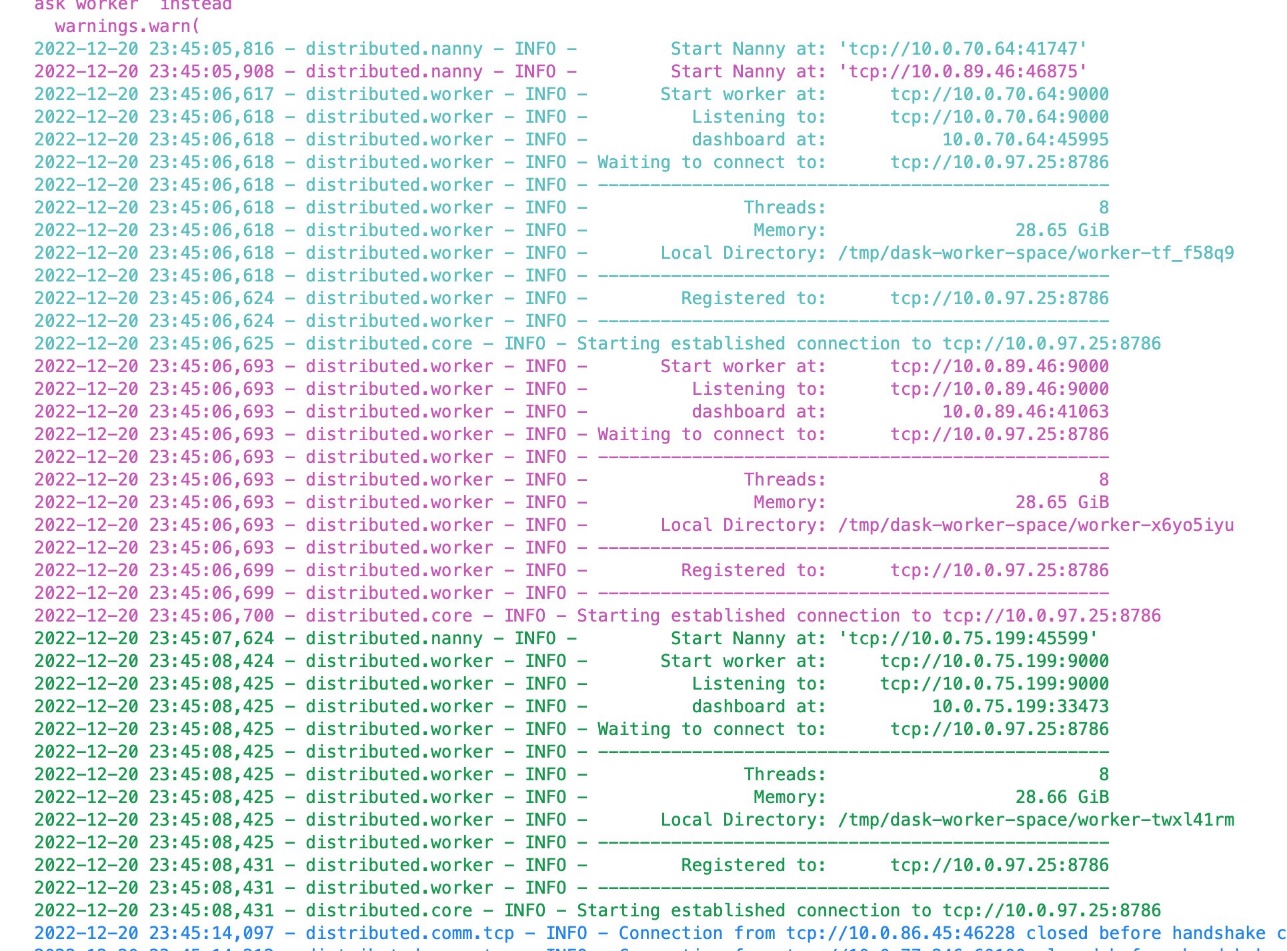

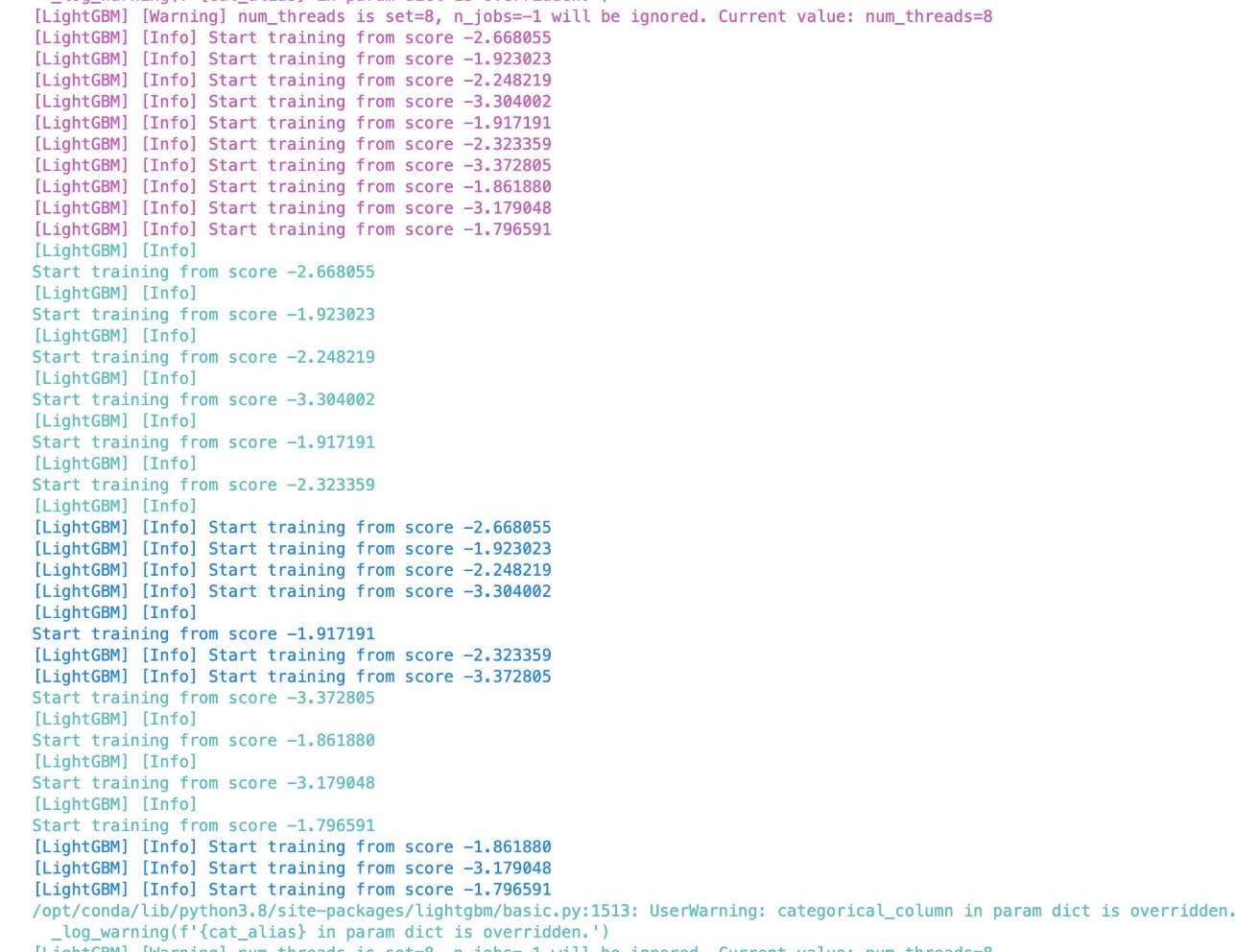

تُظهر لقطات الشاشة التالية سجل عمل تدريب ناجح من دفتر الملاحظات. سجلات مختلفة الأمازون الحوسبة المرنة السحابية تتميز أجهزة (Amazon EC2) بألوان مختلفة.

التدريب الموزع متوافق أيضًا مع SageMaker ضبط النموذج التلقائي. لمزيد من التفاصيل ، انظر سبيل المثال دفتر.

المقارنة

لقد أجرينا تجارب معيارية للتحقق من صحة أداء التدريب الموزع في SageMaker LightGBM على ثلاث مجموعات بيانات مختلفة متاحة للجمهور لمهام التصنيف الانحدار والثنائي ومتعدد الفئات. تفاصيل التجربة كالتالي:

- يتم تقسيم كل مجموعة بيانات إلى بيانات التدريب والتحقق من الصحة والاختبار وفقًا لقاعدة الانقسام 80/20/10. لكل مجموعة بيانات ونوع مثيل وعددها ، نقوم بتدريب LightGBM على بيانات التدريب ؛ تسجيل المقاييس مثل الوقت القابل للفوترة (لكل حالة) ، ووقت التشغيل الإجمالي ، ومتوسط خسارة التدريب في نهاية آخر شجرة مبنية على جميع الحالات ، وفقدان التحقق من الصحة في نهاية آخر شجرة مبنية ؛ وتقييم أدائها على بيانات الاختبار المستمر.

- لكل تجربة ، نستخدم نفس المجموعة بالضبط من قيم المعلمات الفائقة ، حيث يبلغ عدد الأشجار 500 شجرة باستثناء مجموعة بيانات الإقراض. بالنسبة لمجموعة بيانات الإقراض ، نستخدم 100 كعدد الأشجار لأنه يكفي للحصول على أفضل النتائج في بيانات اختبار الانتظار.

- تم حساب متوسط كل رقم معروض في الجدول على ثلاث تجارب.

- نظرًا لأنه يتم تدريب كل نموذج بمجموعة واحدة ثابتة من قيم المعلمات الفائقة ، يمكن تحسين أرقام قياس التقييم في بيانات اختبار الانتظار بشكل أكبر باستخدام تحسين المعلمة الفائقة.

الوقت القابل للفوترة يشير إلى وقت ساعة الحائط المطلق. إجمالي وقت التشغيل هو الوقت المرن الذي يدير التدريب الموزع ، والذي يتضمن الوقت والوقت القابل للفوترة لتدوير المثيلات وتثبيت التبعيات. بالنسبة لفقدان التحقق من الصحة في نهاية آخر شجرة مبنية ، لم نقم بعمل المتوسط على جميع المثيلات كخسارة تدريب لأن جميع بيانات التحقق من الصحة تم تعيينها لمثيل واحد ، وبالتالي فإن هذا المثيل فقط لديه مقياس فقدان التحقق . نفاد الذاكرة (OOM) يعني أن مجموعة البيانات أصابت خطأ نفاد الذاكرة أثناء التدريب. وظيفة الخسارة ومقاييس التقييم المستخدمة هي ثنائي ومتعدد الطبقات logloss, L2, دقة, F1, روك الجامعة الأمريكية, ماكرو F1, F1 مايكرو ، R2, MAEو MSE.

التوقع هو أنه مع زيادة عدد المثيلات ، ينخفض الوقت القابل للفوترة (لكل مثيل) وإجمالي وقت التشغيل ، بينما يظل متوسط خسارة التدريب وفقدان التحقق من الصحة في نهاية آخر شجرة مبنية ونتائج التقييم على بيانات اختبار الانتظار هي نفس.

أجرينا ثلاث تجارب:

- قياس الأداء على مجموعتي بيانات متاحتين للجمهور باستخدام CSV كتنسيق بيانات الإدخال

- ضع علامة مرجعية على مجموعة بيانات مختلفة باستخدام Parquet كتنسيق بيانات الإدخال

- قارن أداء النموذج على أنواع المثيلات المختلفة مع إعطاء عدد معين من المثيلات

مجموعات البيانات التي استخدمناها هي بيانات إقراض النادي, بيانات الكودو بيانات سيارات الأجرة في مدينة نيويورك. يتم تقديم إحصاءات البيانات على النحو التالي.

| بيانات | المقاس | عدد الأمثلة | عدد الميزات | نوع المشكلة |

| قرض النادي | ~ 10 جرام | 1، 439، 141 | 955 | التصنيف الثنائي |

| الكود | ~ 10 جرام | 18، 268، 221 | 9 | تصنيف متعدد الفئات (عدد الفئات في الهدف: 10) |

| تاكسي مدينة نيويورك | ~ 0.5 جرام | 83، 601، 440 | 8 | تراجع |

يحتوي الجدول التالي على نتائج قياس الأداء لمجموعتي البيانات الأولين باستخدام CSV كتنسيق إدخال البيانات. لأغراض توضيحية ، قمنا بإزالة الميزات الفئوية لبيانات قرض نادي الإقراض. يتم عرض إحصائيات البيانات في الجدول. تتوافق نتائج التجربة مع توقعاتنا.

| بيانات | عدد المثيلات (m5.2xlarge) | الوقت القابل للفوترة لكل مثيل (بالثواني) | إجمالي وقت التشغيل (بالثواني) | متوسط خسارة التدريب على جميع المثيلات في نهاية آخر شجرة تم بناؤها | فقدان التحقق من الصحة في نهاية آخر شجرة تم بناؤها | مقاييس التقييم على بيانات اختبار الانتظار | ||

| قرض النادي | . | . | . | اللوغوس الثنائي | اللوغوس الثنائي | صحة (٪) | F1 (٪) | ROC الجامعة الأمريكية (٪) |

| . | 1 | خارج الذاكرة | ||||||

| . | 2 | خارج الذاكرة | ||||||

| . | 4 | 461 | 614 | 0.034 | 0.039 | 98.9 | 96.6 | 99.7 |

| . | 6 | 375 | 561 | 0.034 | 0.039 | 98.9 | 96.6 | 99.7 |

| . | 8 | 359 | 549 | 0.034 | 0.039 | 98.9 | 96.7 | 99.7 |

| . | 10 | 338 | 522 | 0.036 | 0.037 | 98.9 | 96.6 | 99.7 |

| . | ||||||||

| الكود | . | . | . | متعدد الطبقات logloss | متعدد الطبقات logloss | صحة (٪) | F1 ماكرو (٪) | F1 مايكرو (٪) |

| . | 1 | 5329 | 5414 | 0.937 | 0.947 | 65.6 | 59.3 | 65.6 |

| . | 2 | 3175 | 3294 | 0.94 | 0.942 | 65.5 | 59 | 65.5 |

| . | 4 | 2593 | 2695 | 0.937 | 0.942 | 65.6 | 59.3 | 65.6 |

| . | 8 | 2253 | 2377 | 0.938 | 0.943 | 65.6 | 59.3 | 65.6 |

| . | 10 | 2160 | 2285 | 0.937 | 0.942 | 65.6 | 59.3 | 65.6 |

يحتوي الجدول التالي على نتائج قياس الأداء باستخدام بيانات سيارات الأجرة في مدينة نيويورك مع الباركيه كتنسيق بيانات الإدخال. بالنسبة لبيانات سيارات الأجرة في مدينة نيويورك ، نستخدم ملف سجلات تاكسي الرحلة الصفراء من 2009 إلى 2022. نحن نتبع سبيل المثال دفتر لإجراء معالجة الميزات. تستهلك البيانات المعالجة 8.5 جيجا بايت من ذاكرة القرص عند حفظها بتنسيق CSV ، و 0.55 جيجا فقط عند حفظها بتنسيق باركيه.

لوحظ نمط مماثل موضح في الجدول السابق. مع زيادة عدد المثيلات ، ينخفض الوقت القابل للفوترة (لكل مثيل) وإجمالي وقت التشغيل ، بينما يظل متوسط خسارة التدريب وفقدان التحقق من الصحة في نهاية الشجرة المبنية الأخيرة ونتائج التقييم على بيانات اختبار الانتظار كما هي.

| بيانات | عدد المثيلات (m5.4xlarge) | الوقت القابل للفوترة لكل مثيل (بالثواني) | إجمالي وقت التشغيل (بالثواني) | متوسط خسارة التدريب على جميع المثيلات في نهاية آخر شجرة تم بناؤها | فقدان التحقق من الصحة في نهاية آخر شجرة تم بناؤها | مقاييس التقييم على بيانات اختبار الانتظار | ||

| تاكسي مدينة نيويورك | . | . | . | L2 | L2 | R2 (٪) | MSE | MAE |

| . | 1 | 951 | 1036 | 6.543 | 6.543 | 54.7 | 42.8 | 2.7 |

| . | 2 | 635 | 727 | 6.545 | 6.545 | 54.7 | 42.8 | 2.7 |

| . | 4 | 501 | 628 | 6.637 | 6.639 | 53.4 | 44.1 | 2.8 |

| . | 6 | 435 | 552 | 6.74 | 6.74 | 52 | 45.4 | 2.8 |

| . | 8 | 410 | 510 | 6.919 | 6.924 | 52.3 | 44.9 | 2.9 |

نجري أيضًا تجارب قياس الأداء ونقارن الأداء في ظل أنواع مثيلات مختلفة باستخدام مجموعة بيانات الكود. بالنسبة لعدد مثيل معين ، عندما يصبح نوع المثيل أكبر ، ينخفض الوقت القابل للفوترة وإجمالي وقت التشغيل.

| . | مل | مل | مل | |||

| عدد المثيلات | الوقت القابل للفوترة لكل مثيل (بالثواني) | إجمالي وقت التشغيل (بالثواني) | الوقت القابل للفوترة لكل مثيل (بالثواني) | إجمالي وقت التشغيل (بالثواني) | الوقت القابل للفوترة لكل مثيل (بالثواني) | إجمالي وقت التشغيل (بالثواني) |

| 1 | 5329 | 5414 | 2793 | 2904 | 1302 | 1394 |

| 2 | 3175 | 3294 | 1911 | 2000 | 1006 | 1098 |

| 4 | 2593 | 2695 | 1451 | 1557 | 891 | 973 |

وفي الختام

بفضل قوة إطار الحوسبة الموزعة في Dask وخوارزمية تعزيز التدرج الفعال لـ LightGBM ، يمكن لعلماء البيانات والمطورين تدريب النماذج على مجموعات البيانات الكبيرة بشكل أسرع وأكثر كفاءة من استخدام أساليب العقدة المفردة التقليدية. تجعل خوارزمية SageMaker LightGBM عملية إعداد التدريب الموزع باستخدام إطار عمل Dask لكل من التصنيف المجدول ومهام الانحدار أسهل بكثير. الخوارزمية متاحة الآن من خلال SageMaker Python SDK. يمكن أن يكون تنسيق البيانات المدعوم إما CSV أو باركيه. تم إجراء تجارب قياس الأداء واسعة النطاق على ثلاث مجموعات بيانات متاحة للجمهور مع إعدادات مختلفة للتحقق من أدائها.

يمكنك إحضار مجموعة البيانات الخاصة بك وتجربة هذه الخوارزميات الجديدة على SageMaker ، وتحقق من ملف سبيل المثال دفتر لاستخدام الخوارزميات المضمنة المتوفرة على GitHub.

عن المؤلفين

الدكتور شين هوانغ هو عالم تطبيقي في Amazon SageMaker JumpStart وخوارزميات Amazon SageMaker المدمجة. يركز على تطوير خوارزميات التعلم الآلي القابلة للتطوير. تتركز اهتماماته البحثية في مجال معالجة اللغة الطبيعية ، والتعلم العميق القابل للتفسير على البيانات المجدولة ، والتحليل القوي لتجميع الزمكان غير المعياري. وقد نشر العديد من الأوراق البحثية في ACL و ICDM ومؤتمرات KDD والجمعية الملكية للإحصاء: مجلة Series A.

الدكتور شين هوانغ هو عالم تطبيقي في Amazon SageMaker JumpStart وخوارزميات Amazon SageMaker المدمجة. يركز على تطوير خوارزميات التعلم الآلي القابلة للتطوير. تتركز اهتماماته البحثية في مجال معالجة اللغة الطبيعية ، والتعلم العميق القابل للتفسير على البيانات المجدولة ، والتحليل القوي لتجميع الزمكان غير المعياري. وقد نشر العديد من الأوراق البحثية في ACL و ICDM ومؤتمرات KDD والجمعية الملكية للإحصاء: مجلة Series A.

ويل بدر هو اختصاصي رئيسي في الذكاء الاصطناعي / تعلم الآلة SA يعمل كجزء من فريق التعلم الآلي العالمي في أمازون. ويل متحمس لاستخدام التكنولوجيا بطرق مبتكرة للتأثير بشكل إيجابي على المجتمع. في أوقات فراغه ، يحب الغوص ولعب كرة القدم واستكشاف جزر المحيط الهادئ.

ويل بدر هو اختصاصي رئيسي في الذكاء الاصطناعي / تعلم الآلة SA يعمل كجزء من فريق التعلم الآلي العالمي في أمازون. ويل متحمس لاستخدام التكنولوجيا بطرق مبتكرة للتأثير بشكل إيجابي على المجتمع. في أوقات فراغه ، يحب الغوص ولعب كرة القدم واستكشاف جزر المحيط الهادئ.

الدكتور لي تشانغ هو مدير المنتج الرئيسي - التقني لخوارزميات Amazon SageMaker JumpStart و Amazon SageMaker المضمنة ، وهي خدمة تساعد علماء البيانات وممارسي التعلم الآلي على البدء في التدريب ونشر نماذجهم ، وتستخدم التعلم المعزز مع Amazon SageMaker. فاز عمله السابق كعضو فريق بحث رئيسي ومخترع رئيسي في IBM Research بجائزة اختبار ورقة الوقت في IEEE INFOCOM.

الدكتور لي تشانغ هو مدير المنتج الرئيسي - التقني لخوارزميات Amazon SageMaker JumpStart و Amazon SageMaker المضمنة ، وهي خدمة تساعد علماء البيانات وممارسي التعلم الآلي على البدء في التدريب ونشر نماذجهم ، وتستخدم التعلم المعزز مع Amazon SageMaker. فاز عمله السابق كعضو فريق بحث رئيسي ومخترع رئيسي في IBM Research بجائزة اختبار ورقة الوقت في IEEE INFOCOM.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- بلاتوبلوكشين. Web3 Metaverse Intelligence. تضخيم المعرفة. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/amazon-sagemaker-built-in-lightgbm-now-offers-distributed-training-using-dask/

- 1

- 10

- 100

- 11

- 7

- 77

- 9

- a

- ماهرون

- من نحن

- مطلق

- في

- الأفعال

- تجميع

- AI / ML

- خوارزمية

- خوارزميات

- الكل

- يسمح

- أمازون

- Amazon EC2

- آلة التعلم الأمازون

- الأمازون SageMaker

- أمازون سيج ميكر جومب ستارت

- من بين

- كمية

- المبالغ

- تحليل

- تحليلات

- و

- أباتشي

- تطبيقي

- المنطقة

- حجة

- تعيين

- أوتوماتيك

- تلقائيا

- متاح

- المتوسط

- جائزة

- AWS

- الأساسية

- لان

- أصبح

- يصبح

- يجري

- المقارنة

- أفضل

- كبير

- البيانات الكبيرة

- تعزيز

- جلب

- ابني

- بنيت

- مدمج

- تسمى

- يهمني

- الحالات

- معين

- قنوات

- التحقق

- فئة

- فصول

- تصنيف

- ناد

- كتلة

- المجموعات

- الكود

- عمود

- الجمع بين

- الجمع بين

- مشترك

- التواصل

- مجتمع

- قارن

- متوافق

- تعقيد

- الحسابات

- إحصاء

- الحوسبة

- إدارة

- المؤتمرات

- وعاء

- يحتوي

- استمر

- اتفاقية

- المقابلة

- يتوافق

- التكلفة

- خلق

- على

- البيانات

- نقاط البيانات

- علم البيانات

- قواعد البيانات

- يوم

- تخفيض

- عميق

- التعلم العميق

- الترتيب

- نشر

- تصميم

- تفاصيل

- المطورين

- تطوير

- الأجهزة

- مختلف

- صعوبة

- مباشرة

- بحث

- وزعت

- الحوسبة الموزعة

- التدريب الموزع

- توزيع

- منقسم

- أثناء

- كل

- أسهل

- النظام الإيكولوجي

- فعال

- بكفاءة

- إما

- تمكين

- ينتهي

- خطأ

- أساسي

- تقييم

- تقييم

- حتى

- كل

- مثال

- إلا

- القائمة

- توقع

- التوقعات

- تجربة

- اكتشف

- واسع

- أسرع

- الميزات

- المميزات

- الشكل

- قم بتقديم

- ملفات

- نهائي

- تمويل

- العثور على

- الاسم الأول

- ثابت

- ويركز

- اتباع

- متابعيك

- متابعات

- النموذج المرفق

- شكل

- وجدت

- الإطار

- الأطر

- تبدأ من

- وظيفة

- إضافي

- جيل

- دولار فقط واحصل على خصم XNUMX% على جميع

- GitHub جيثب:

- معطى

- العالمية

- Go

- التدرجات

- النمو

- الرعاية الصحية

- مساعدة

- يساعد

- ضرب

- غطاء محرك السيارة

- كيفية

- لكن

- HTML

- HTTPS

- تحسين Hyperparameter

- IBM

- محدد

- IEEE

- صورة

- التأثير

- التنفيذ

- استيراد

- تحسن

- تحسن

- in

- تتضمن

- يشمل

- بما فيه

- الزيادات

- على نحو متزايد

- مؤشر

- تشير

- الصناعات

- مبتكرة

- إدخال

- رؤى

- تثبيت

- مثل

- بدلًا من ذلك

- المتكاملة

- يدمج

- التكامل

- يستفد

- السريرية

- الجزر

- قضية

- IT

- وظيفة

- مجلة

- جسون

- القفل

- لغة

- كبير

- أكبر

- اسم العائلة

- إطلاق

- تعلم

- الإقراض

- Li

- المكتبات

- المكتبة

- قائمة

- جار التحميل

- قرض

- محلي

- موقع

- طويل

- يعد

- خسارة

- الكثير

- آلة

- آلة التعلم

- الآلات

- الماكرو

- الرئيسية

- تحتفظ

- يصنع

- إدارة

- إدارة

- كثير

- ملحوظ

- رئيسي

- مطابقة

- يعني

- آلية

- عضو

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- طرق

- متري

- المقاييس

- ربما

- ML

- نموذج

- عارضات ازياء

- الأكثر من ذلك

- أكثر فعالية

- أكثر

- متعدد

- الاسم

- عين

- طبيعي

- معالجة اللغات الطبيعية

- الشبكات

- الشبكات العصبية

- جديد

- ضجيج

- مفكرة

- عدد

- أرقام

- نمباي

- مدينة نيويورك

- عروض

- ONE

- المصدر المفتوح

- الأمثل

- التحسين

- أخرى

- الخاصة

- سلمي

- الباندا

- ورق

- أوراق

- موازية

- المعلمات

- جزء

- مرور

- عاطفي

- الماضي

- مسار

- نمط

- نفذ

- أداء

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- بلايستشن

- البوينت

- نقاط

- الرائج

- منشور

- قوة

- قوي

- التحليلات التنبؤية

- قدم

- رئيسي

- مشاكل

- عملية المعالجة

- معالجتها

- العمليات

- معالجة

- إنتاج

- المنتج

- تزود

- ويوفر

- علانية

- نشرت

- أغراض

- وضع

- بايثون

- pytorch

- بسرعة

- نطاق

- معقول

- الأخيرة

- اعتراف

- سجل

- تخفيض

- يقلل

- يشير

- لا تزال

- المتبقية

- إزالة

- المتطلبات الأساسية

- يتطلب

- بحث

- موارد كثيفة

- الموارد

- مسؤول

- REST

- النتائج

- بيع بالتجزئة

- قوي

- ملكي

- قاعدة

- تشغيل

- SA

- sagemaker

- نفسه

- تحجيم

- علوم

- عالم

- العلماء

- لقطات

- الإستراحة

- ثواني

- اختيار

- مسلسلات

- السلسلة أ

- الخدمة

- طقم

- ضبط

- إعدادات

- ينبغي

- إظهار

- أظهرت

- بشكل ملحوظ

- مماثل

- ببساطة

- عزباء

- المقاس

- الأصغر

- كرة القدم

- جاليات

- حل

- متخصص

- خطاب

- التعرف على الكلام

- سرعة

- غزل

- انقسم

- الإنشقاقات

- فريق العمل

- بدأت

- يبدأ

- إحصائي

- إحصائيات

- تخزين

- بناء

- منظم

- ناجح

- هذه

- كاف

- جناح

- مدعومة

- الدعم

- جدول

- أخذ

- يأخذ

- الهدف

- المهام

- فريق

- تكنولوجيا

- tensorflow

- تجربه بالعربي

- •

- المنطقة

- من مشاركة

- وبالتالي

- ثلاثة

- عبر

- الوقت

- استهلاك الوقت

- إلى

- اليوم

- جدا

- أداة

- الإجمالي

- تقليدي

- قطار

- متدرب

- قادة الإيمان

- القطارات

- الأشجار

- محاكمة

- محاكمات

- رحلة

- أنواع

- عادة

- مع

- فريد من نوعه

- تحديث

- الأستعمال

- تستخدم

- التحقق من صحة

- التحقق من صحة

- قيمنا

- القيم

- مختلف

- حجم

- تصويت

- طرق

- التي

- في حين

- من الذى

- واسع

- مدى واسع

- ويكيبيديا

- سوف

- بدون

- وون

- للعمل

- عامل

- العمال

- عامل

- أعمال

- سوف

- جاري الكتابة

- XGBoost

- سنوات

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت