تمتلك صناعة ألعاب الفيديو قاعدة مستخدمين تقدر بأكثر من 3 مليارات مستخدم في جميع أنحاء العالم1. إنها تتكون من كميات هائلة من اللاعبين الذين يتفاعلون تقريبًا مع بعضهم البعض كل يوم. لسوء الحظ ، كما هو الحال في العالم الحقيقي ، لا يتواصل جميع اللاعبين بشكل مناسب ومحترم. في محاولة لإنشاء بيئة ألعاب مسؤولة اجتماعيًا والحفاظ عليها ، طُلب من خدمات AWS الاحترافية إنشاء آلية تكشف عن لغة غير لائقة (الكلام السام) في تفاعلات لاعب الألعاب عبر الإنترنت. كانت النتيجة الإجمالية للأعمال هي تحسين عمليات المنظمة من خلال أتمتة عملية يدوية موجودة وتحسين تجربة المستخدم من خلال زيادة السرعة والجودة في اكتشاف التفاعلات غير الملائمة بين اللاعبين ، مما يؤدي في النهاية إلى تعزيز بيئة ألعاب أكثر نظافة وصحة.

كان طلب العميل هو إنشاء كاشف للغة الإنجليزية يقوم بتصنيف مقتطفات الصوت والنص إلى فئات اللغة السامة المحددة الخاصة بهم. لقد أرادوا أولاً تحديد ما إذا كانت المقتطفات اللغوية المعينة سامة ، ثم تصنيف المقتطف في فئة محددة من السمية يحددها العميل مثل الألفاظ النابية أو اللغة المسيئة.

حل AWS ProServe حالة الاستخدام هذه من خلال جهد مشترك بين مركز ابتكار الذكاء الاصطناعي التوليدي (GAIIC) وفريق ProServe ML Delivery Team (MLDT). AWS GAIIC هي مجموعة داخل AWS ProServe تجمع العملاء بالخبراء لتطوير حلول الذكاء الاصطناعي التكوينية لمجموعة واسعة من حالات استخدام الأعمال باستخدام نماذج إثبات المفهوم (PoC). تقوم AWS ProServe MLDT بعد ذلك بأخذ PoC من خلال الإنتاج من خلال توسيع نطاق الحل وتقويته ودمجه من أجل العميل.

سيتم عرض حالة استخدام العميل هذه في رسالتين منفصلتين. هذا المنشور (الجزء الأول) بمثابة غوص عميق في المنهجية العلمية. سوف يشرح عملية التفكير والتجريب وراء الحل ، بما في ذلك تدريب النموذج وعملية التطوير. سيتعمق الجزء 1 في الحل المنتج ، موضحًا قرارات التصميم وتدفق البيانات وتوضيح نموذج التدريب وبنية النشر.

يغطي هذا المنشور المواضيع التالية:

- التحديات التي كان يتعين على AWS ProServe حلها في حالة الاستخدام هذه

- السياق التاريخي لنماذج اللغات الكبيرة (LLMs) ولماذا تعتبر هذه التقنية مناسبة تمامًا لحالة الاستخدام هذه

- AWS GAIIC's PoC و AWS ProServe MLDT's حل من منظور علم البيانات والتعلم الآلي (ML)

تحدي البيانات

كان التحدي الرئيسي الذي واجهه AWS ProServe بتدريب مصنف لغة سامة هو الحصول على بيانات مصنفة كافية من العميل لتدريب نموذج دقيق من البداية. تلقت AWS حوالي 100 عينة من البيانات المصنفة من العميل ، وهو أقل بكثير من 1,000 عينة موصى بها لضبط LLM في مجتمع علوم البيانات.

كتحدٍ ملازم إضافي ، تُعرف مصنّفات معالجة اللغة الطبيعية (NLP) تاريخيًا أنها مكلفة للغاية للتدريب وتتطلب مجموعة كبيرة من المفردات ، تُعرف باسم الإحضارلإنتاج تنبؤات دقيقة. سيكون حل البرمجة اللغوية العصبية الصارم والفعال ، إذا تم توفير كميات كافية من البيانات المصنفة ، هو تدريب نموذج لغة مخصص باستخدام البيانات المصنفة الخاصة بالعميل. سيتم تدريب النموذج فقط باستخدام مفردات لعبة اللاعبين ، مما يجعلها مخصصة للغة التي تمت ملاحظتها في الألعاب. كان لدى العميل قيود التكلفة والوقت التي جعلت هذا الحل غير قابل للتطبيق. أُجبرت AWS ProServe على إيجاد حل لتدريب مصنف دقيق للسمية اللغوية باستخدام مجموعة بيانات صغيرة نسبيًا. يكمن الحل فيما يعرف بـ نقل التعلم.

تتمثل الفكرة وراء التعلم بالنقل في استخدام معرفة نموذج مدرب مسبقًا وتطبيقه على مشكلة مختلفة ولكنها متشابهة نسبيًا. على سبيل المثال ، إذا تم تدريب مصنف الصور على التنبؤ بما إذا كانت الصورة تحتوي على قطة ، فيمكنك استخدام المعرفة التي اكتسبها النموذج أثناء تدريبه للتعرف على الحيوانات الأخرى مثل النمور. بالنسبة لحالة استخدام اللغة هذه ، احتاج AWS ProServe إلى العثور على مصنف لغة تم تدريبه مسبقًا وتم تدريبه على اكتشاف اللغة السامة وضبطها باستخدام البيانات المصنفة الخاصة بالعميل.

كان الحل هو العثور على LLM وضبطه لتصنيف اللغة السامة. LLMs هي شبكات عصبية تم تدريبها باستخدام عدد هائل من المعلمات ، عادةً بترتيب المليارات ، باستخدام بيانات غير مسماة. قبل الدخول في حل AWS ، يقدم القسم التالي نظرة عامة على تاريخ LLM وحالات استخدامها التاريخية.

الاستفادة من قوة LLMs

أصبحت LLMs مؤخرًا نقطة محورية للشركات التي تبحث عن تطبيقات جديدة لـ ML ، منذ أن استحوذ ChatGPT على مشاركة العقل العامة من خلال كونه تطبيق المستهلك الأسرع نموًا في التاريخ2، للوصول إلى 100 مليون مستخدم نشط بحلول كانون الثاني (يناير) 2023 ، بعد شهرين فقط من صدوره. ومع ذلك ، فإن LLM ليست تقنية جديدة في مساحة ML. لقد تم استخدامها على نطاق واسع لأداء مهام البرمجة اللغوية العصبية مثل تحليل المشاعر وتلخيص المجموعات واستخراج الكلمات الرئيسية وترجمة الكلام وتصنيف النص.

نظرًا للطبيعة المتسلسلة للنص ، كانت الشبكات العصبية المتكررة (RNNs) هي أحدث ما تم التوصل إليه في نمذجة البرمجة اللغوية العصبية. على وجه التحديد ، فإن جهاز التشفير تمت صياغة بنية الشبكة لأنها أنشأت بنية RNN قادرة على أخذ مدخلات ذات طول تعسفي وتوليد ناتج بطول تعسفي. كان هذا مثاليًا لمهام البرمجة اللغوية العصبية مثل الترجمة حيث يمكن التنبؤ بعبارة مخرجة من لغة واحدة من عبارة إدخال بلغة أخرى ، عادةً بأعداد مختلفة من الكلمات بين الإدخال والإخراج. هندسة المحولات3 (Vaswani، 2017) كان تحسنًا كبيرًا في جهاز فك التشفير ؛ قدم مفهوم الانتباه الذاتي، مما سمح للنموذج بتركيز انتباهه على كلمات مختلفة في عبارات الإدخال والإخراج. في وحدة فك التشفير النموذجية ، يتم تفسير كل كلمة بواسطة النموذج بطريقة متطابقة. نظرًا لأن النموذج يعالج كل كلمة في عبارة الإدخال بالتسلسل ، فقد تُفقد المعلومات الدلالية في البداية بنهاية العبارة. غيرت آلية الانتباه الذاتي هذا عن طريق إضافة طبقة انتباه لكل من وحدة التشفير وفك التشفير ، بحيث يمكن للنموذج وضع أوزان مختلفة لكلمات معينة من عبارة الإدخال عند إنشاء كلمة معينة في عبارة الإخراج. وهكذا وُلد أساس نموذج المحولات.

كانت بنية المحولات هي الأساس لاثنين من أكثر LLMs شهرة وشعبية مستخدمة اليوم ، تمثيلات التشفير ثنائية الاتجاه من المحولات (BERT)4 (Radford، 2018) والمحول التوليدي مسبق الصنع (GPT)5 (ديفلين 2018). الإصدارات اللاحقة من نموذج GPT ، وهي GPT3 و GPT4 ، هي المحرك الذي يشغل تطبيق ChatGPT. الجزء الأخير من الوصفة الذي يجعل LLMs قويًا للغاية هو القدرة على استخلاص المعلومات من نصوص ضخمة دون وضع علامات أو معالجة مسبقة عبر عملية تسمى ULMFiT. تحتوي هذه الطريقة على مرحلة ما قبل التدريب حيث يمكن جمع النص العام ويتم تدريب النموذج على مهمة التنبؤ بالكلمة التالية بناءً على الكلمات السابقة ؛ الفائدة هنا هي أن أي نص إدخال يستخدم للتدريب يأتي مُسمَّماً مسبقًا بناءً على ترتيب النص. LLMs قادرة حقًا على التعلم من البيانات على نطاق الإنترنت. على سبيل المثال ، تم تدريب نموذج BERT الأصلي مسبقًا على BookCorpus ومجموعات بيانات نصوص ويكيبيديا الإنجليزية بالكامل.

أدى نموذج النمذجة الجديد هذا إلى ظهور مفهومين جديدين: النماذج الأساسية (FMs) والذكاء الاصطناعي التوليدي. على عكس تدريب نموذج من البداية باستخدام بيانات خاصة بالمهمة ، وهي الحالة المعتادة للتعلم الكلاسيكي الخاضع للإشراف ، يتم تدريب LLM مسبقًا لاستخراج المعرفة العامة من مجموعة بيانات نصية عريضة قبل تكييفها مع مهام أو مجالات محددة ذات نطاق أصغر بكثير. مجموعة البيانات (عادةً بترتيب مئات العينات). يبدأ سير عمل ML الجديد الآن بنموذج مدرب مسبقًا يُطلق عليه نموذج الأساس. من المهم البناء على الأساس الصحيح ، وهناك عدد متزايد من الخيارات ، مثل الجديد أمازون تيتان FMs، التي ستصدرها AWS كجزء من أمازون بيدروك. تعتبر هذه النماذج الجديدة أيضًا إنتاجية لأن مخرجاتها قابلة للتفسير البشري وفي نفس نوع البيانات مثل بيانات الإدخال. بينما كانت نماذج ML السابقة وصفية ، مثل تصنيف صور القطط مقابل الكلاب ، فإن LLMs تكون إنتاجية لأن ناتجها هو المجموعة التالية من الكلمات بناءً على كلمات الإدخال. يتيح لهم ذلك تشغيل تطبيقات تفاعلية مثل ChatGPT التي يمكن أن تكون معبرة في المحتوى الذي ينشئونه.

عقدت Hugging Face شراكة مع AWS لإضفاء الطابع الديمقراطي على FMs وجعلها سهلة الوصول إليها والبناء معها. قام Hugging Face بإنشاء ملف المحولات API التي توحد أكثر من 50 معمارية مختلفة للمحولات في أطر ML المختلفة ، بما في ذلك الوصول إلى أوزان النماذج المدربة مسبقًا في نموذج المحور، والتي نمت إلى أكثر من 200,000 نموذج حتى كتابة هذا المنشور. في الأقسام التالية ، نستكشف إثبات المفهوم والحل و FMs التي تم اختبارها واختيارها كأساس لحل حالة استخدام تصنيف الكلام السام للعميل.

AWS GAIIC إثبات المفهوم

اختارت AWS GAIIC تجربة نماذج الأساس LLM مع بنية BERT لضبط مصنف اللغة السامة. تم اختبار ما مجموعه ثلاثة نماذج من محور نموذج Hugging Face:

تستند جميع معماريات النماذج الثلاثة إلى بيرتويت بنيان. يتم تدريب BERTweet على أساس روبرتا إجراء ما قبل التدريب. إجراء RoBERTa قبل التدريب هو نتيجة دراسة تكرار للتدريب المسبق لـ BERT والتي قيمت آثار ضبط المعلمة الفائقة وحجم مجموعة التدريب لتحسين وصفة تدريب نماذج BERT6 (ليو 2019). سعت التجربة إلى إيجاد طريقة ما قبل التدريب التي حسنت نتائج أداء BERT دون تغيير البنية الأساسية. وجدت خاتمة الدراسة أن التعديلات التالية قبل التدريب حسنت بشكل كبير من أداء BERT:

- تدريب النموذج على دفعات أكبر على المزيد من البيانات

- إزالة هدف توقع الجملة التالية

- التدريب على التسلسلات الأطول

- تغيير نمط التقنيع بشكل ديناميكي المطبق على بيانات التدريب

يستخدم نموذج bertweet-base الإجراء السابق للتدريب المسبق من دراسة RoBERTa للتدريب المسبق على بنية BERT الأصلية باستخدام 850 مليون تغريدة باللغة الإنجليزية. إنه أول نموذج لغة عام واسع النطاق تم تدريبه مسبقًا للتغريدات الإنجليزية.

يُعتقد أن ملفات FM المدربة مسبقًا التي تستخدم التغريدات تناسب حالة الاستخدام لسببين نظريين رئيسيين:

- يشبه طول التغريدة طول العبارة غير الملائمة أو السامة الموجودة في محادثات الألعاب عبر الإنترنت

- تأتي التغريدات من مجموعة كبيرة ومتنوعة من المستخدمين المختلفين ، على غرار السكان الموجودين في منصات الألعاب

قررت AWS أولاً ضبط BERTweet ببيانات العميل المصنفة للحصول على أساس. بعد ذلك ، اختارت ضبط اثنين من ملفات FM الأخرى في كراهية bertweet-base-offensive و bertweet-base-hare التي تم تدريبها مسبقًا بشكل أكبر على التغريدات السامة الأكثر صلة لتحقيق دقة أعلى محتملة. يستخدم نموذج bertweet-base-offensive قاعدة BertTweet FM ويتم تدريبه مسبقًا على 14,100 تغريدة مشروحة تم اعتبارها مسيئة7 (زامبيري 2019). يستخدم نموذج BertTweet-base-hate أيضًا قاعدة BertTweet FM الأساسية ولكن تم تدريبه مسبقًا على 19,600 تغريدة تم اعتبارها كلامًا يحض على الكراهية8 (باسيلي 2019).

لتعزيز أداء نموذج PoC بشكل أكبر ، اتخذت AWS GAIIC قرارين للتصميم:

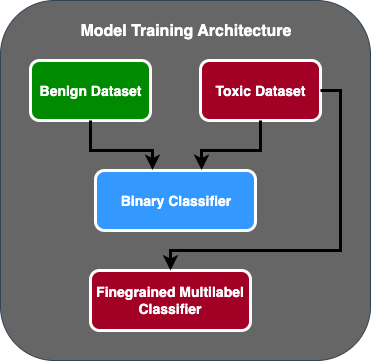

- تم إنشاء تدفق تنبؤ من مرحلتين حيث يعمل النموذج الأول كمصنف ثنائي يصنف ما إذا كان جزء من النص سامًا أم غير سام. النموذج الثاني هو نموذج دقيق الحبيبات يصنف النص بناءً على الأنواع السامة التي يحددها العميل. فقط إذا تنبأ النموذج الأول بأن النص سام ، يتم تمريره إلى النموذج الثاني.

- تم زيادة بيانات التدريب وإضافة مجموعة فرعية من مجموعة بيانات نصية سامة مصنفة من طرف ثالث من مسابقة Kaggle العامة (سمية بانوراما) إلى 100 عينة أصلية تم استلامها من العميل. قاموا بتعيين ملصقات Jigsaw إلى ملصقات السمية المحددة من قبل العميل وقاموا بتقسيم 80٪ كبيانات تدريب و 20٪ كبيانات اختبار للتحقق من صحة النموذج.

تم استخدام AWS GAIIC الأمازون SageMaker أجهزة الكمبيوتر المحمولة لإجراء تجارب الضبط الدقيق ووجدت أن نموذج bertweet-base-offensive حقق أفضل الدرجات في مجموعة التحقق من الصحة. يلخص الجدول التالي درجات القياس الملحوظة.

| الموديل | دقة | تذكر | F1 | AUC |

| ثنائي | . 92 | . 90 | . 91 | . 92 |

| بالغة الدقة | . 81 | . 80 | . 81 | . 89 |

من هذه النقطة ، قامت GAIIC بتسليم PoC إلى فريق AWS ProServe ML Delivery لإنتاج PoC.

AWS ProServe ML Delivery حل حل

لإنتاج بنية النموذج ، طلب العميل من فريق AWS ProServe ML Delivery Team (MLDT) من قبل العميل إنشاء حل قابل للتطوير وسهل الصيانة. كان هناك عدد قليل من تحديات الصيانة لنهج نموذج من مرحلتين:

- تتطلب النماذج ضعف مقدار مراقبة النموذج ، مما يجعل توقيت إعادة التدريب غير متسق. قد تكون هناك أوقات يتعين فيها إعادة تدريب أحد النماذج أكثر من الآخر.

- زيادة تكاليف تشغيل نموذجين مقابل واحد.

- تتباطأ سرعة الاستدلال لأن الاستدلال يمر عبر نموذجين.

لمواجهة هذه التحديات ، كان على AWS ProServe MLDT اكتشاف كيفية تحويل بنية النموذج المكون من مرحلتين إلى بنية نموذجية واحدة مع الاستمرار في الحفاظ على دقة البنية المكونة من مرحلتين.

كان الحل هو مطالبة العميل أولاً بمزيد من بيانات التدريب ، ثم ضبط نموذج bertweet-base-offensive على جميع الملصقات ، بما في ذلك العينات غير السامة ، في نموذج واحد. كانت الفكرة هي أن ضبط نموذج واحد بمزيد من البيانات سيؤدي إلى نتائج مماثلة مثل ضبط بنية نموذج من مرحلتين على بيانات أقل. لضبط بنية النموذج ذات المرحلتين ، حدَّث AWS ProServe MLDT رأس التصنيف متعدد العلامات للنموذج المدرَّب مسبقًا ليشمل عقدة إضافية لتمثيل الفئة غير السامة.

ما يلي هو عينة رمز لكيفية ضبط نموذج مدرب مسبقًا من محور نموذج Hugging Face باستخدام منصة المحولات الخاصة بهم وتغيير رأس التصنيف متعدد الملصقات للنموذج للتنبؤ بالعدد المطلوب من الفئات. استخدمت AWS ProServe MLDT هذا المخطط كأساس للضبط الدقيق. يفترض أن لديك بيانات القطار وبيانات التحقق الخاصة بك جاهزة وبتنسيق الإدخال الصحيح.

أولاً ، يتم استيراد وحدات Python بالإضافة إلى النموذج المطلوب تدريبه مسبقًا من محور نموذج Hugging Face:

ثم يتم تحميل النموذج المُدرَّب مسبقًا وإعداده للضبط الدقيق. هذه هي الخطوة التي يتم فيها تحديد عدد الفئات السامة وجميع معلمات النموذج:

يبدأ ضبط النموذج بإدخال المسارات إلى مجموعات بيانات التدريب والتحقق من الصحة:

تلقت AWS ProServe MLDT ما يقرب من 5,000 عينة بيانات أخرى مصنفة ، 3,000 عينة غير سامة و 2,000 عينة سامة ، وتم ضبط جميع نماذج قاعدة بيرتويت الثلاثة ، مع دمج جميع الملصقات في نموذج واحد. استخدموا هذه البيانات بالإضافة إلى 5,000 عينة من PoC لضبط النماذج الجديدة ذات المرحلة الواحدة باستخدام نفس مجموعة القطار بنسبة 80٪ ، وطريقة مجموعة الاختبار بنسبة 20٪. يوضح الجدول التالي أن درجات الأداء كانت مماثلة لتلك الخاصة بنموذج المرحلتين.

| الموديل | دقة | تذكر | F1 | AUC |

| قاعدة بيرتويت (1-المرحلة) | . 76 | . 72 | . 74 | . 83 |

| بيرتويت-قاعدة-كره (1-المرحلة) | . 85 | . 82 | . 84 | . 87 |

| bertweet-base-offensive (1-stage) (XNUMX-المرحلة) | . 88 | . 83 | . 86 | . 89 |

| bertweet-base-offensive (2-stage) (XNUMX-المرحلة) | . 91 | . 90 | . 90 | . 92 |

قدم نهج النموذج أحادي المرحلة تحسينات في التكلفة والصيانة مع تقليل الدقة بنسبة 3٪ فقط. بعد موازنة المفاضلات ، اختار العميل AWS ProServe MLDT لإنتاج نموذج المرحلة الواحدة.

من خلال ضبط نموذج واحد مع المزيد من البيانات المصنفة ، تمكنت AWS ProServe MLDT من تقديم حل يلبي عتبة العميل فيما يتعلق بدقة النموذج ، فضلاً عن تلبية طلباتهم لسهولة الصيانة ، مع خفض التكلفة وزيادة المتانة.

وفي الختام

كان عميل ألعاب كبير يبحث عن طريقة لاكتشاف اللغة السامة في قنوات الاتصال الخاصة به لتعزيز بيئة ألعاب مسؤولة اجتماعيًا. قامت AWS GAIIC بإنشاء PoC لكاشف اللغة السامة عن طريق ضبط LLM لاكتشاف اللغة السامة. قامت AWS ProServe MLDT بعد ذلك بتحديث تدفق التدريب النموذجي من نهج من مرحلتين إلى نهج من مرحلة واحدة وإنتاج LLM للعميل لاستخدامه على نطاق واسع.

في هذا المنشور ، توضح AWS الفعالية والتطبيق العملي لضبط LLM لحل حالة استخدام العميل هذه ، وتشارك السياق حول تاريخ نماذج الأساس و LLM ، وتقدم سير العمل بين AWS Generative AI Innovation Center و AWS ProServe ML فريق التوصيل. في المنشور التالي في هذه السلسلة ، سوف نتعمق أكثر في كيفية قيام AWS ProServe MLDT بإنتاج نموذج المرحلة الواحدة الناتج باستخدام SageMaker.

إذا كنت مهتمًا بالعمل مع AWS لبناء حل ذكاء اصطناعي عام ، فيرجى التواصل مع GAIIC. سيقومون بتقييم حالة الاستخدام الخاصة بك ، وبناء إثبات عام للمفهوم قائم على الذكاء الاصطناعي ، ولديهم خيارات لتوسيع التعاون مع AWS لتنفيذ PoC الناتجة في الإنتاج.

مراجع حسابات

- ديموغرافيات اللاعب: حقائق وإحصائيات عن الهواية الأكثر شهرة في العالم

- سجل ChatGPT رقمًا قياسيًا لقاعدة المستخدمين الأسرع نموًا - ملاحظة المحللين

- فاسواني وآخرون ، "الاهتمام هو كل ما تحتاجه"

- Radford et al. ، "تحسين فهم اللغة عن طريق التدريب الأولي التوليدي"

- Devlin et al. ، "BERT: التدريب المسبق للمحولات ثنائية الاتجاه العميقة لفهم اللغة"

- Yinhan Liu et al. ، "RoBERTa: أسلوب تدريب ما قبل برتقالي محسن بشكل قوي"

- Marcos Zampieri وآخرون ، "مهمة SemEval-2019 6: تحديد وتصنيف اللغة الهجومية في وسائل التواصل الاجتماعي (OffensEval)"

- Valerio Basile et al. ، "SemEval-2019 Task 5: Multilingual Detection of Khat Beast against Immigration and Women in Twitter"

عن المؤلفين

جيمس بوكيز هو عالم بيانات مع خدمات AWS الاحترافية ومقرها في مقاطعة أورانج بولاية كاليفورنيا. وهو حاصل على درجة البكالوريوس في علوم الكمبيوتر من جامعة كاليفورنيا في إيرفين ولديه عدة سنوات من الخبرة في العمل في مجال البيانات بعد أن لعب العديد من الأدوار المختلفة. يعمل اليوم على تنفيذ ونشر حلول ML قابلة للتطوير لتحقيق نتائج الأعمال لعملاء AWS.

جيمس بوكيز هو عالم بيانات مع خدمات AWS الاحترافية ومقرها في مقاطعة أورانج بولاية كاليفورنيا. وهو حاصل على درجة البكالوريوس في علوم الكمبيوتر من جامعة كاليفورنيا في إيرفين ولديه عدة سنوات من الخبرة في العمل في مجال البيانات بعد أن لعب العديد من الأدوار المختلفة. يعمل اليوم على تنفيذ ونشر حلول ML قابلة للتطوير لتحقيق نتائج الأعمال لعملاء AWS.

هان مان هو مدير أول في علوم البيانات والتعلم الآلي مع خدمات AWS الاحترافية ومقرها سان دييغو ، كاليفورنيا. حصل على درجة الدكتوراه في الهندسة من جامعة نورث وسترن ولديه عدة سنوات من الخبرة كمستشار إداري يقدم المشورة للعملاء في مجالات التصنيع والخدمات المالية والطاقة. اليوم ، يعمل بشغف مع العملاء الرئيسيين من مجموعة متنوعة من قطاعات الصناعة لتطوير حلول ML و GenAI وتنفيذها على AWS.

هان مان هو مدير أول في علوم البيانات والتعلم الآلي مع خدمات AWS الاحترافية ومقرها سان دييغو ، كاليفورنيا. حصل على درجة الدكتوراه في الهندسة من جامعة نورث وسترن ولديه عدة سنوات من الخبرة كمستشار إداري يقدم المشورة للعملاء في مجالات التصنيع والخدمات المالية والطاقة. اليوم ، يعمل بشغف مع العملاء الرئيسيين من مجموعة متنوعة من قطاعات الصناعة لتطوير حلول ML و GenAI وتنفيذها على AWS.

صفاء تينازيتيبي هو عالم بيانات متكامل مع خدمات AWS الاحترافية. لديه بكالوريوس في علوم الكمبيوتر من جامعة Emory وله اهتمامات في MLOps والأنظمة الموزعة و web3.

صفاء تينازيتيبي هو عالم بيانات متكامل مع خدمات AWS الاحترافية. لديه بكالوريوس في علوم الكمبيوتر من جامعة Emory وله اهتمامات في MLOps والأنظمة الموزعة و web3.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/aws-performs-fine-tuning-on-a-large-language-model-llm-to-classify-toxic-speech-for-a-large-gaming-company/

- :لديها

- :يكون

- :ليس

- :أين

- 000

- 1

- 100

- 14

- 16

- 19

- 200

- 2017

- 2018

- 2019

- 2023

- 50

- 7

- a

- القدرة

- ماهرون

- من نحن

- الوصول

- دقة

- دقيق

- التأهيل

- تحقق

- نشط

- الأفعال

- وأضاف

- مضيفا

- إضافة

- العنوان

- تقديم المشورة

- بعد

- ضد

- AI

- AL

- الكل

- سمح

- يسمح

- أيضا

- أمازون

- أمازون ويب سيرفيسز

- كمية

- المبالغ

- an

- المحلل

- تحليل

- و

- الحيوانات

- آخر

- أي وقت

- تطبيق

- التطبيقات

- تطبيقي

- التقديم

- نهج

- بشكل مناسب

- ما يقرب من

- هندسة معمارية

- هي

- الحجج

- فنـون

- AS

- تقييم

- أسوشيتد

- يفترض

- At

- اهتمام

- أتمتة

- AWS

- الخدمات المهنية AWS

- قاعدة

- على أساس

- خط الأساس

- أساس

- BE

- لان

- أصبح

- كان

- قبل

- البداية

- وراء

- يجري

- أقل من

- تستفيد

- أفضل

- ما بين

- أكبر

- مليار

- المليارات

- حظر

- مولود

- على حد سواء

- اختراق

- واسع

- نساعدك في بناء

- يبني

- الأعمال

- الأعمال

- لكن

- by

- CA

- كاليفورنيا

- تسمى

- CAN

- قادر على

- القبض

- حقيبة

- الحالات

- قط

- الفئات

- التصنيف

- الفئة

- القطط

- مركز

- معين

- تحدى

- التحديات

- غير

- متغير

- قنوات

- شات جي بي تي

- اختار

- اختيار

- فئة

- فصول

- تصنيف

- صنف

- عميل

- الكود

- للاتعاون

- الجمع بين

- تأتي

- يأتي

- التواصل

- Communication

- مجتمع

- حول الشركة

- مماثل

- منافسة

- الكمبيوتر

- علوم الكمبيوتر

- مفهوم

- المفاهيم

- اختتام

- نظرت

- يتكون

- القيود

- consultants

- مستهلك

- يحتوي

- محتوى

- سياق الكلام

- تصحيح

- التكلفة

- مكلفة

- التكاليف

- استطاع

- مقاطعة

- يغطي

- خلق

- خلق

- على

- زبون

- العملاء

- البيانات

- علم البيانات

- عالم البيانات

- قواعد البيانات

- يوم

- قررت

- القرارات

- تعتبر

- عميق

- غوص عميق

- أعمق

- حدد

- تعريف

- نقل

- تم التوصيل

- التوصيل

- الخوض

- دمقرطة

- التركيبة السكانية

- يوضح

- نشر

- نشر

- تصميم

- مطلوب

- بكشف أو

- كشف

- حدد

- تطوير

- التطوير التجاري

- فعل

- دييغو

- مختلف

- اختلاف

- وزعت

- الانظمة الموزعة

- هل

- نطاق

- المجالات

- مضاعفة

- يطلق عليها اسم

- أثناء

- E & T

- كل

- سهولة

- سهل

- الطُرق الفعّالة

- فعالية

- الآثار

- جهد

- النهاية

- طاقة

- محرك

- الهندسة

- انجليزي

- تعزيز

- كاف

- أدخل

- كامل

- البيئة

- عصر

- مقدر

- تقييم

- EVER

- كل

- مثال

- القائمة

- الخبره في مجال الغطس

- تجربة

- تجارب

- خبرائنا

- شرح

- شرح

- اكتشف

- معبر

- مد

- واسع

- على نطاق واسع

- احتفل على

- استخراج

- الوجه

- واجه

- حقائق

- الأزياء

- أسرع

- الأسرع نموا

- قليل

- الشكل

- نهائي

- مالي

- الخدمات المالية

- الاسم الأول

- تناسب

- تدفق

- تركز

- متابعيك

- في حالة

- شكل

- وجدت

- دورة تأسيسية

- الأطر

- تبدأ من

- إضافي

- اكتسبت

- لعبة

- ألعاب

- الألعاب

- صناعة الألعاب

- جمعت

- العلاجات العامة

- توليد

- توليد

- توليدي

- الذكاء الاصطناعي التوليدي

- دولار فقط واحصل على خصم XNUMX% على جميع

- معطى

- يذهب

- الذهاب

- تجمع

- متزايد

- نابعة

- كان

- يملك

- وجود

- he

- رئيس

- صحة

- هنا

- أعلى

- تاريخي

- تاريخيا

- تاريخ

- كيفية

- كيفية

- لكن

- HTTPS

- محور

- الانسان

- مئات

- ضبط Hyperparameter

- فكرة

- المثالي

- مطابق

- تحديد

- if

- صورة

- صور

- المهاجرين

- تنفيذ

- تحقيق

- استيراد

- أهمية

- واردات

- تحسن

- تحسن

- تحسين

- تحسينات

- in

- تتضمن

- بما فيه

- في ازدياد

- العالمية

- معلومات

- متأصل

- متأصل

- الابتكار

- إدخال

- دمج

- التفاعل

- التفاعلات

- التفاعلية

- يستفد

- السريرية

- إلى

- أدخلت

- يدخل

- IT

- انها

- يناير

- بانوراما

- مشترك

- م

- القفل

- الكلمات المفتاحية

- المعرفة

- معروف

- وصفها

- ملصقات

- لغة

- كبير

- على نطاق واسع

- الى وقت لاحق

- وضع

- طبقة

- تعلم

- الطول

- أقل

- مثل

- LLM

- تحميل

- يعد

- أبحث

- ضائع

- الكثير

- خفض

- آلة

- آلة التعلم

- صنع

- الرئيسية

- المحافظة

- صيانة

- جعل

- يصنع

- القيام ب

- رجل

- إدارة

- مدير

- كتيب

- تصنيع

- كثير

- هائل

- مايو..

- آلية

- الوسائط

- قابل

- طريقة

- آلية العمل

- متري

- مليون

- ML

- MLOps

- نموذج

- تصميم

- عارضات ازياء

- التعديلات

- الوحدات

- مراقبة

- المقبلة.

- الأكثر من ذلك

- أكثر

- الاكثر شهره

- كثيرا

- أي

- طبيعي

- معالجة اللغات الطبيعية

- الطبيعة

- بحاجة

- شبكة

- الشبكات

- الشبكات العصبية

- جديد

- التالي

- البرمجة اللغوية العصبية

- العقدة

- الآن

- عدد

- أرقام

- الحصول على

- of

- خصم

- هجومي

- غالبا

- on

- ONE

- online

- الألعاب عبر الإنترنت

- فقط

- عمليات

- معارض

- الأمثل

- مزيد من الخيارات

- or

- برتقال

- طلب

- أصلي

- أخرى

- خارج

- نتيجة

- النتائج

- الناتج

- على مدى

- الكلي

- نظرة عامة

- الخاصة

- أزواج

- نموذج

- المعلمة

- المعلمات

- جزء

- شراكة

- مرت

- الماضي

- نمط

- نفذ

- أداء

- ينفذ

- مرحلة جديدة

- رسالة دكتوراه

- عبارات

- قطعة

- المنصة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- لعبت

- لاعب

- لاعبين

- من فضلك

- اضغط لتتحدث

- البوينت

- الرائج

- سكان

- منشور

- المنشورات

- يحتمل

- قوة

- قوي

- القوى

- دقة

- تنبأ

- وتوقع

- توقع

- تنبؤ

- تنبؤات

- تتوقع

- سابق

- سابقا

- المشكلة

- الإجراءات

- عملية المعالجة

- العمليات

- معالجة

- إنتاج

- الإنتــاج

- شتم

- محترف

- تعزيز

- تعزيز

- دليل

- دليل على المفهوم

- المقدمة

- ويوفر

- جمهور

- وضع

- بايثون

- جودة

- نطاق

- الوصول

- الوصول إلى

- استعداد

- حقيقي

- العالم الحقيقي

- الأسباب

- تلقى

- مؤخرا

- وصفة

- الاعتراف

- موصى به

- سجل

- نسبيا

- الافراج عن

- صدر

- ذات الصلة

- تكرار

- مثل

- تطلب

- مسؤول

- الألعاب مسؤولة

- نتيجة

- مما أدى

- النتائج

- رويترز

- حق

- صارم

- ارتفاع

- متانة

- الأدوار

- يجري

- تشغيل

- sagemaker

- نفسه

- سان

- سان دييغو

- تحجيم

- حجم

- التحجيم

- علوم

- علمي

- عالم

- خدش

- الثاني

- القسم

- أقسام

- كبير

- عقوبة

- عاطفة

- مستقل

- تسلسل

- مسلسلات

- يخدم

- خدماتنا

- طقم

- باكجات

- عدة

- مشاركة

- عرضت

- يظهر

- مماثل

- منذ

- عزباء

- المقاس

- يبطئ

- صغير

- الأصغر

- So

- العدالة

- وسائل التواصل الاجتماعي

- اجتماعيا

- فقط

- حل

- الحلول

- حل

- حل

- بعض

- بحث

- الفضاء

- محدد

- على وجه التحديد

- خطاب

- سرعة

- انقسم

- يبدأ

- الولايه او المحافظه

- الإحصائيات

- خطوة

- لا يزال

- بناء

- دراسة

- جوهريا

- هذه

- كاف

- أنظمة

- جدول

- تناسب

- يأخذ

- مع الأخذ

- مهمة

- المهام

- فريق

- تكنولوجيا

- تجربه بالعربي

- اختبار

- من

- أن

- •

- الدولة

- من مشاركة

- منهم

- then

- نظري

- هناك.

- تشبه

- هم

- فكر

- ثلاثة

- عتبة

- عبر

- وهكذا

- الوقت

- مرات

- توقيت

- عملاق

- إلى

- اليوم

- المواضيع

- الإجمالي

- قطار

- متدرب

- قادة الإيمان

- تحويل

- محول

- محولات

- خدمات ترجمة

- حقا

- منعطف أو دور

- سقسقة

- تويت

- اثنان

- نوع

- أنواع

- نموذجي

- عادة

- في النهاية

- التي تقوم عليها

- فهم

- لسوء الحظ

- جامعة

- جامعة كاليفورنيا

- تحديث

- تستخدم

- حالة الاستخدام

- مستعمل

- مستخدم

- تجربة المستخدم

- المستخدمين

- يستخدم

- استخدام

- التحقق من صحة

- التحقق من صحة

- تشكيلة

- كبير

- الإصدارات

- القطاعات

- جدا

- بواسطة

- فيديو

- ألعاب الفيديو

- عمليا

- صوت

- vs

- تريد

- مطلوب

- وكان

- طريق..

- we

- الويب

- خدمات ويب

- Web3

- وزن

- حسن

- معروف

- كان

- متى

- سواء

- التي

- في حين

- لماذا

- واسع

- مدى واسع

- ويكيبيديا

- سوف

- مع

- في غضون

- بدون

- نسائي

- كلمة

- كلمات

- سير العمل

- عامل

- أعمال

- العالم

- سوف

- جاري الكتابة

- سنوات

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت