شارك في تأليف هذا المقال أناتولي خومينكو، مهندس التعلم الآلي، وعبد النور بزوه، الرئيس التنفيذي للتكنولوجيا في Talent.com.

تأسست في 2011، Talent.com هي واحدة من أكبر مصادر التوظيف في العالم. تجمع الشركة بين قوائم الوظائف المدفوعة من عملائها وقوائم الوظائف العامة في منصة واحدة قابلة للبحث. مع أكثر من 30 مليون وظيفة مدرجة في أكثر من 75 دولة، يقدم Talent.com وظائف عبر العديد من اللغات والصناعات وقنوات التوزيع. والنتيجة هي منصة تربط ملايين الباحثين عن عمل بالوظائف المتاحة.

تتمثل مهمة Talent.com في تجميع جميع الوظائف المتاحة على الويب لمساعدة الباحثين عن عمل في العثور على أفضل ما يناسبهم مع تزويدهم بأفضل تجربة بحث. ينصب تركيزها على الملاءمة، لأن ترتيب الوظائف الموصى بها مهم للغاية لإظهار الوظائف الأكثر صلة باهتمامات المستخدمين. يعد أداء خوارزمية المطابقة الخاصة بـ Talent.com أمرًا بالغ الأهمية لنجاح الأعمال ومساهمًا رئيسيًا في تجربة مستخدميها. من الصعب التنبؤ بالوظائف ذات الصلة بالباحث عن عمل بناءً على الكمية المحدودة من المعلومات المقدمة، والتي عادةً ما تحتوي على عدد قليل من الكلمات الرئيسية والموقع.

في ضوء هذه المهمة، تضافرت جهود Talent.com وAWS لإنشاء محرك توصية وظيفية باستخدام أحدث تقنيات معالجة اللغات الطبيعية (NLP) وتقنيات التدريب على نماذج التعلم العميق مع الأمازون SageMaker لتوفير تجربة لا مثيل لها للباحثين عن عمل. يوضح هذا المنشور نهجنا المشترك في تصميم نظام التوصية الوظيفية، بما في ذلك هندسة الميزات، وتصميم بنية نموذج التعلم العميق، وتحسين المعلمات الفائقة، وتقييم النموذج الذي يضمن موثوقية وفعالية الحل الذي نقدمه لكل من الباحثين عن عمل وأصحاب العمل. تم تطوير النظام من قبل فريق من علماء التعلم الآلي التطبيقي (ML) المتخصصين ومهندسي تعلم الآلة وخبراء الموضوع بالتعاون بين AWS وTalent.com.

أدى نظام التوصيات إلى زيادة بنسبة 8.6% في نسبة النقر إلى الظهور (CTR) في اختبارات A/B عبر الإنترنت مقارنةً بالحل السابق المستند إلى XGBoost، مما ساعد على ربط الملايين من مستخدمي Talent.com بوظائف أفضل.

نظرة عامة على الحل

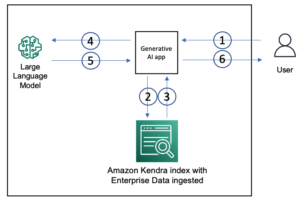

يتم توضيح نظرة عامة على النظام في الشكل التالي. يأخذ النظام استعلام بحث المستخدم كمدخل ويخرج قائمة مرتبة من الوظائف حسب الأهمية. يتم قياس مدى ملاءمة الوظيفة من خلال احتمالية النقر (احتمال قيام الباحث عن عمل بالنقر فوق وظيفة لمزيد من المعلومات).

يتضمن النظام أربعة مكونات رئيسية:

- معمارية النموذج - جوهر محرك توصيات الوظائف هذا هو نموذج Triple Tower Pointwise القائم على التعلم العميق، والذي يتضمن برنامج تشفير الاستعلام الذي يقوم بتشفير استعلامات بحث المستخدم، وبرنامج تشفير المستندات الذي يقوم بتشفير الأوصاف الوظيفية، وبرنامج تشفير التفاعل الذي يعالج وظيفة المستخدم السابقة ميزات التفاعل. يتم توصيل مخرجات الأبراج الثلاثة وتمريرها عبر رأس التصنيف للتنبؤ باحتمالات النقر الخاصة بالمهمة. من خلال تدريب هذا النموذج على استعلامات البحث وتفاصيل الوظيفة وبيانات تفاعل المستخدم التاريخية من Talent.com، يوفر هذا النظام توصيات وظيفية مخصصة وذات صلة كبيرة للباحثين عن عمل.

- هندسة الميزات – نقوم بتنفيذ مجموعتين من هندسة الميزات لاستخراج المعلومات القيمة من البيانات المدخلة وإدخالها في الأبراج المقابلة في النموذج. المجموعتان عبارة عن هندسة ميزات قياسية وزخارف Sentence-BERT (SBERT) المضبوطة بدقة. نحن نستخدم الميزات الهندسية القياسية كمدخلات في برنامج تشفير التفاعل ونقوم بتغذية تضمين SBERT المشتق في برنامج تشفير الاستعلام وبرنامج تشفير المستندات.

- تحسين النموذج وضبطه – نحن نستخدم منهجيات تدريب متقدمة لتدريب النظام واختباره ونشره باستخدام SageMaker. يتضمن ذلك تدريب SageMaker Distributed Data Parallel (DDP)، وSageMaker Automatic Model Tuning (AMT)، وجدولة معدل التعلم، والإيقاف المبكر لتحسين أداء النموذج وسرعة التدريب. ساعد استخدام إطار تدريب DDP في تسريع تدريبنا النموذجي بمعدل أسرع بثماني مرات تقريبًا.

- تقييم النموذج – نقوم بإجراء التقييم عبر الإنترنت وعلى الإنترنت. نقوم بتقييم أداء النموذج باستخدام المنطقة تحت المنحنى (AUC) ومتوسط الدقة عند K (mAP@K) في التقييم دون الاتصال بالإنترنت. أثناء اختبار A/B عبر الإنترنت، نقوم بتقييم تحسينات نسبة النقر إلى الظهور.

وفي الأقسام التالية، نعرض تفاصيل هذه المكونات الأربعة.

تصميم معماري لنموذج التعلم العميق

لقد قمنا بتصميم نموذج Triple Tower Deep Pointwise (TTDP) باستخدام بنية التعلم العميق ثلاثية الأبراج ونهج النمذجة الزوجية. توفر بنية البرج الثلاثي ثلاث شبكات عصبية عميقة متوازية، حيث يقوم كل برج بمعالجة مجموعة من الميزات بشكل مستقل. يسمح نمط التصميم هذا للنموذج بتعلم تمثيلات متميزة من مصادر مختلفة للمعلومات. بعد الحصول على التمثيلات من الأبراج الثلاثة، يتم ربطها وتمريرها عبر رأس التصنيف لإجراء التنبؤ النهائي (0-1) على احتمالية النقر (إعداد النمذجة النقطية).

تتم تسمية الأبراج الثلاثة بناءً على المعلومات التي تعالجها: يقوم برنامج تشفير الاستعلام بمعالجة استعلام بحث المستخدم، ويقوم برنامج تشفير المستندات بمعالجة المحتويات التوثيقية لوظيفة المرشح بما في ذلك المسمى الوظيفي واسم الشركة، ويستخدم برنامج تشفير التفاعل الميزات ذات الصلة المستخرجة من تفاعلات المستخدم السابقة والتاريخ (تمت مناقشته أكثر في القسم التالي).

يلعب كل برج من هذه الأبراج دورًا حاسمًا في تعلم كيفية التوصية بالوظائف:

- تشفير الاستعلام - يستقبل مشفر الاستعلام تضمينات SBERT المستمدة من استعلام البحث عن وظيفة الخاص بالمستخدم. نحن نعزز التضمينات من خلال نموذج SBERT الذي قمنا بضبطه بدقة. يقوم برنامج التشفير هذا بمعالجة وفهم هدف البحث عن وظيفة للمستخدم، بما في ذلك التفاصيل والفروق الدقيقة التي تم التقاطها بواسطة التضمينات الخاصة بالمجال الخاص بنا.

- أداة تشفير المستندات - يقوم برنامج تشفير المستندات بمعالجة المعلومات الخاصة بكل قائمة وظائف. على وجه التحديد، فإنه يأخذ تضمينات SBERT للنص المتسلسل من المسمى الوظيفي والشركة. من البديهي أن المستخدمين سيكونون أكثر اهتمامًا بالوظائف المرشحة الأكثر صلة باستعلام البحث. من خلال تعيين الوظائف واستعلامات البحث لنفس مساحة المتجه (المحددة بواسطة SBERT)، يمكن للنموذج أن يتعلم التنبؤ باحتمالية الوظائف المحتملة التي سينقر عليها الباحث عن عمل.

- تشفير التفاعل – يتعامل برنامج تشفير التفاعل مع تفاعلات المستخدم السابقة مع قوائم الوظائف. يتم إنتاج الميزات عبر خطوة هندسية قياسية للميزات، والتي تتضمن حساب مقاييس الشعبية للأدوار الوظيفية والشركات، وإنشاء درجات تشابه السياق، واستخراج معلمات التفاعل من مشاركات المستخدم السابقة. كما أنه يعالج الكيانات المسماة المحددة في المسمى الوظيفي واستعلامات البحث باستخدام نموذج التعرف على الكيانات المسماة (NER) المدرب مسبقًا.

يولد كل برج مخرجات مستقلة بالتوازي، ويتم بعد ذلك ربطها جميعًا معًا. يتم بعد ذلك تمرير ناقل الميزات المدمج هذا للتنبؤ باحتمالية النقر على قائمة الوظائف لاستعلام المستخدم. توفر بنية الأبراج الثلاثية المرونة في التقاط العلاقات المعقدة بين المدخلات أو الميزات المختلفة، مما يسمح للنموذج بالاستفادة من نقاط القوة في كل برج أثناء تعلم تمثيلات أكثر تعبيرًا للمهمة المحددة.

يتم ترتيب احتمالات النقر المتوقعة للوظائف المرشحة من الأعلى إلى الأدنى، مما يؤدي إلى إنشاء توصيات وظيفية مخصصة. من خلال هذه العملية، نضمن أن كل جزء من المعلومات - سواء كان هدف البحث الخاص بالمستخدم أو تفاصيل قائمة الوظائف أو التفاعلات السابقة - يتم التقاطه بالكامل بواسطة برج محدد مخصص لها. يتم أيضًا التقاط العلاقات المعقدة بينهما من خلال الجمع بين مخرجات البرج.

هندسة الميزات

نقوم بتنفيذ مجموعتين من العمليات الهندسية المميزة لاستخراج معلومات قيمة من البيانات الأولية وإدخالها في الأبراج المقابلة في النموذج: هندسة الميزات القياسية ودمجات SBERT المضبوطة بدقة.

هندسة الميزات القياسية

تبدأ عملية إعداد البيانات لدينا بهندسة الميزات القياسية. بشكل عام، نحدد أربعة أنواع من الميزات:

- الأكثر رواجا - نقوم بحساب درجات الشعبية على مستوى الوظيفة الفردية، ومستوى المهنة، ومستوى الشركة. يوفر هذا مقياسًا لمدى جاذبية وظيفة أو شركة معينة.

- التشابه النصي – لفهم العلاقة السياقية بين العناصر النصية المختلفة، نقوم بحساب درجات التشابه، بما في ذلك تشابه السلسلة بين استعلام البحث والمسمى الوظيفي. يساعدنا هذا في قياس مدى ملاءمة الوظيفة الشاغرة لبحث الباحث عن عمل أو سجل طلباته.

- تفاعل - بالإضافة إلى ذلك، نقوم باستخراج ميزات التفاعل من تفاعلات المستخدم السابقة مع قوائم الوظائف. ومن الأمثلة الرئيسية على ذلك التشابه المضمن بين المسميات الوظيفية التي تم النقر عليها في الماضي والمسميات الوظيفية للمرشح. يساعدنا هذا المقياس على فهم التشابه بين الوظائف السابقة التي أبدى المستخدم اهتمامًا بها مقابل فرص العمل القادمة. وهذا يعزز دقة محرك التوصية الوظيفية الخاص بنا.

- ملفي الشخصي – أخيرًا، نقوم باستخراج معلومات الاهتمامات الوظيفية المحددة من قبل المستخدم من ملف تعريف المستخدم ومقارنتها مع المرشحين الجدد للوظائف. وهذا يساعدنا على فهم ما إذا كان المرشح للوظيفة يتوافق مع اهتمامات المستخدم.

إحدى الخطوات الحاسمة في إعداد البيانات لدينا هي تطبيق نموذج NER المُدرب مسبقًا. من خلال تطبيق نموذج NER، يمكننا تحديد وتصنيف الكيانات المسماة ضمن المسميات الوظيفية واستعلامات البحث. وبالتالي، يتيح لنا هذا حساب درجات التشابه بين هذه الكيانات المحددة، مما يوفر مقياسًا أكثر تركيزًا وإدراكًا للسياق للارتباط. تعمل هذه المنهجية على تقليل التشويش في بياناتنا وتمنحنا طريقة أكثر دقة وحساسة للسياق لمقارنة الوظائف.

صقل SBERT التضمين

لتعزيز أهمية ودقة نظام التوصية الوظيفية لدينا، نستخدم قوة SBERT، وهو نموذج قوي قائم على المحولات، معروف بكفاءته في التقاط المعاني والسياقات الدلالية من النص. ومع ذلك، فإن التضمينات العامة مثل SBERT، على الرغم من فعاليتها، قد لا تلتقط بشكل كامل الفروق الدقيقة والمصطلحات الفريدة المتأصلة في مجال معين مثل مجالنا، والذي يتمحور حول التوظيف والبحث عن الوظائف. للتغلب على ذلك، نقوم بضبط تضمينات SBERT باستخدام بياناتنا الخاصة بالمجال. تعمل عملية الضبط الدقيق هذه على تحسين النموذج لفهم ومعالجة اللغة والمصطلحات والسياق الخاصة بالصناعة بشكل أفضل، مما يجعل التضمينات أكثر انعكاسًا لمجالنا المحدد. ونتيجة لذلك، توفر التضمينات المكررة أداءً محسنًا في التقاط المعلومات الدلالية والسياقية داخل مجالنا، مما يؤدي إلى توصيات وظيفية أكثر دقة وذات مغزى لمستخدمينا.

ويوضح الشكل التالي خطوة الضبط الدقيق لـ SBERT.

نقوم بضبط تضمينات SBERT باستخدام خسارة ثلاثية باستخدام مقياس مسافة جيب التمام الذي يتعلم تضمين النص حيث يكون للنصوص المرساة والإيجابية تشابه جيب التمام أعلى من النصوص المرساة والنصوص السلبية. نحن نستخدم استعلامات بحث المستخدمين كنصوص أساسية. نحن نجمع بين المسميات الوظيفية وأسماء أصحاب العمل كمدخلات للنصوص الإيجابية والسلبية. يتم أخذ عينات النصوص الإيجابية من إعلانات الوظائف التي نقر عليها المستخدم المقابل، في حين يتم أخذ عينات النصوص السلبية من إعلانات الوظائف التي لم ينقر عليها المستخدم. فيما يلي نموذج لتنفيذ إجراء الضبط الدقيق:

التدريب على النماذج باستخدام SageMaker Distributed Data Parallel

نحن نستخدم SageMaker Distributed Data Parallel (SMDDP)، وهي إحدى ميزات النظام الأساسي SageMaker ML المبني على PyTorch DDP. فهو يوفر بيئة محسنة لتشغيل وظائف تدريب PyTorch DDP على منصة SageMaker. لقد تم تصميمه لتسريع التدريب على نماذج التعلم العميق بشكل كبير. ويحقق ذلك عن طريق تقسيم مجموعة بيانات كبيرة إلى أجزاء أصغر وتوزيعها عبر وحدات معالجة الرسومات المتعددة. يتم تكرار النموذج على كل وحدة معالجة رسومات. تقوم كل وحدة معالجة رسومات بمعالجة البيانات المخصصة لها بشكل مستقل، ويتم تجميع النتائج ومزامنتها عبر جميع وحدات معالجة الرسومات. يعتني DDP بالاتصال المتدرج للحفاظ على مزامنة النسخ المتماثلة للنماذج وتداخلها مع حسابات التدرج لتسريع التدريب. يستخدم SMDDP خوارزمية AllReduce المحسنة لتقليل الاتصال بين وحدات معالجة الرسومات، وتقليل وقت المزامنة وتحسين سرعة التدريب الإجمالية. تتكيف الخوارزمية مع ظروف الشبكة المختلفة، مما يجعلها فعالة للغاية لكل من البيئات المحلية والسحابية. في بنية SMDDP (كما هو موضح في الشكل التالي)، يتم أيضًا قياس التدريب الموزع باستخدام مجموعة من العقد المتعددة. وهذا لا يعني فقط وجود وحدات معالجة رسومات متعددة في مثيل الحوسبة، ولكن العديد من المثيلات التي تحتوي على وحدات معالجة رسومات متعددة، مما يزيد من سرعة التدريب.

لمزيد من المعلومات حول هذه البنية، راجع مقدمة إلى مكتبة SageMaker الموازية للبيانات الموزعة.

بفضل SMDDP، تمكنا من تقليل وقت التدريب لنموذج TTDP الخاص بنا بشكل كبير، مما جعله أسرع بثماني مرات. تعني أوقات التدريب الأسرع أنه يمكننا تكرار نماذجنا وتحسينها بسرعة أكبر، مما يؤدي إلى توصيات أفضل للوظائف لمستخدمينا في فترة زمنية أقصر. يعد هذا المكسب في الكفاءة مفيدًا في الحفاظ على القدرة التنافسية لمحرك توصيات الوظائف لدينا في سوق العمل سريع التطور.

يمكنك تعديل البرنامج النصي للتدريب الخاص بك مع SMDDP بثلاثة أسطر فقط من التعليمات البرمجية، كما هو موضح في مقطع التعليمات البرمجية التالي. باستخدام PyTorch كمثال، الشيء الوحيد الذي عليك القيام به هو استيراد عميل PyTorch الخاص بمكتبة SMDDP (smdistributed.dataparallel.torch.torch_smddp). يسجل العميل smddp كواجهة خلفية لـ PyTorch.

بعد أن يكون لديك برنامج PyTorch النصي الذي تم تكييفه لاستخدام مكتبة البيانات الموازية الموزعة، يمكنك ذلك إطلاق مهمة تدريب موزعة باستخدام SageMaker Python SDK.

تقييم أداء النموذج

عند تقييم أداء نظام التوصيات، من المهم اختيار المقاييس التي تتوافق بشكل وثيق مع أهداف العمل وتوفر فهمًا واضحًا لفعالية النموذج. في حالتنا، نستخدم AUC لتقييم أداء التنبؤ بالنقر على الوظيفة لنموذج TTDP الخاص بنا وmAP@K لتقييم جودة قائمة الوظائف المصنفة النهائية.

تشير AUC إلى المنطقة الواقعة أسفل منحنى خاصية تشغيل المستقبِل (ROC). إنه يمثل احتمال أن يتم تصنيف المثال الإيجابي الذي تم اختياره عشوائيًا في مرتبة أعلى من المثال السلبي الذي تم اختياره عشوائيًا. ويتراوح من 0 إلى 1، حيث يشير 1 إلى المصنف المثالي ويمثل 0.5 تخمينًا عشوائيًا. يعد mAP@K مقياسًا شائع الاستخدام لتقييم جودة أنظمة استرجاع المعلومات، مثل محرك التوصية بالوظائف لدينا. إنه يقيس متوسط دقة استرداد العناصر ذات الصلة بـ K الأعلى لاستعلام أو مستخدم معين. يتراوح من 0 إلى 1، حيث يشير 1 إلى الترتيب الأمثل ويشير 0 إلى أقل دقة ممكنة عند قيمة K المحددة. نقوم بتقييم AUC وmAP@1 وmAP@3. بشكل جماعي، تسمح لنا هذه المقاييس بقياس قدرة النموذج على التمييز بين الفئات الإيجابية والسلبية (AUC) ونجاحه في تصنيف العناصر الأكثر صلة في الأعلى (mAP@K).

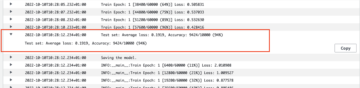

استنادًا إلى تقييمنا دون الاتصال بالإنترنت، تفوق نموذج TTDP على النموذج الأساسي - نموذج الإنتاج الحالي القائم على XGBoost - بنسبة 16.65% لـ AUC، و20% لـ mAP@1، و11.82% لـ mAP@3.

علاوة على ذلك، قمنا بتصميم اختبار أ/ب عبر الإنترنت لتقييم النظام المقترح وقمنا بإجراء الاختبار على نسبة مئوية من مستخدمي البريد الإلكتروني في الولايات المتحدة لمدة 6 أسابيع. في المجمل، تم إرسال ما يقرب من 22 مليون رسالة بريد إلكتروني باستخدام الوظيفة التي أوصى بها النظام الجديد. وبلغت الزيادة الناتجة في النقرات مقارنة بنموذج الإنتاج السابق 8.6%. يعمل موقع Talent.com على زيادة النسبة المئوية تدريجيًا لطرح النظام الجديد لجميع سكانه وقنواته.

وفي الختام

إن إنشاء نظام توصية وظيفية هو مسعى معقد. لكل باحث عن عمل احتياجات وتفضيلات وخبرات مهنية فريدة لا يمكن استنتاجها من خلال استعلام بحث قصير. في هذا المنشور، تعاونت Talent.com مع AWS لتطوير حل شامل قائم على التعلم العميق للتوصية بالوظائف والذي يقوم بتصنيف قوائم الوظائف للتوصية بها للمستخدمين. استمتع فريق Talent.com حقًا بالتعاون مع فريق AWS طوال عملية حل هذه المشكلة. يمثل هذا علامة بارزة في رحلة Talent.com التحويلية، حيث يستفيد الفريق من قوة التعلم العميق لتمكين أعماله.

تم تحسين هذا المشروع باستخدام SBERT لإنشاء تضمينات نصية. وفي وقت كتابة هذا التقرير، قدمت AWS الأمازون تيتان التضمينات كجزء من نماذجهم التأسيسية (FMs) المقدمة من خلال أمازون بيدروك، وهي خدمة مُدارة بالكامل توفر مجموعة مختارة من النماذج التأسيسية عالية الأداء من شركات الذكاء الاصطناعي الرائدة. نحن نشجع القراء على استكشاف تقنيات التعلم الآلي المقدمة في منشور المدونة هذا والاستفادة من الإمكانات التي توفرها AWS، مثل SMDDP، مع الاستفادة من نماذج AWS Bedrock الأساسية لإنشاء وظائف البحث الخاصة بهم.

مراجع حسابات

عن المؤلفين

يي شيانغ هي عالمة تطبيقية II في Amazon Machine Learning Solutions Lab، حيث تساعد عملاء AWS عبر مختلف الصناعات على تسريع اعتماد الذكاء الاصطناعي والسحابة.

يي شيانغ هي عالمة تطبيقية II في Amazon Machine Learning Solutions Lab، حيث تساعد عملاء AWS عبر مختلف الصناعات على تسريع اعتماد الذكاء الاصطناعي والسحابة.

تونغ وانغ هو عالم تطبيقي كبير في Amazon Machine Learning Solutions Lab ، حيث يساعد عملاء AWS في مختلف الصناعات على تسريع تبني الذكاء الاصطناعي والسحابة.

تونغ وانغ هو عالم تطبيقي كبير في Amazon Machine Learning Solutions Lab ، حيث يساعد عملاء AWS في مختلف الصناعات على تسريع تبني الذكاء الاصطناعي والسحابة.

دميتري بيسبالوف هو عالم تطبيقي كبير في Amazon Machine Learning Solutions Lab ، حيث يساعد عملاء AWS في مختلف الصناعات على تسريع تبني الذكاء الاصطناعي والسحابة.

دميتري بيسبالوف هو عالم تطبيقي كبير في Amazon Machine Learning Solutions Lab ، حيث يساعد عملاء AWS في مختلف الصناعات على تسريع تبني الذكاء الاصطناعي والسحابة.

أناتولي خومينكو هو أحد كبار مهندسي التعلم الآلي في Talent.com ولديه شغف بمعالجة اللغة الطبيعية من خلال التوفيق بين الأشخاص الجيدين والوظائف الجيدة.

أناتولي خومينكو هو أحد كبار مهندسي التعلم الآلي في Talent.com ولديه شغف بمعالجة اللغة الطبيعية من خلال التوفيق بين الأشخاص الجيدين والوظائف الجيدة.

عبد النور بزوح هو مدير تنفيذي يتمتع بخبرة تزيد عن 25 عامًا في بناء وتقديم الحلول التقنية التي تصل إلى ملايين العملاء. شغل عبد النور منصب الرئيس التنفيذي للتكنولوجيا (CTO) في Talent.com عندما قام فريق AWS بتصميم وتنفيذ هذا الحل المحدد لـ Talent.com.

عبد النور بزوح هو مدير تنفيذي يتمتع بخبرة تزيد عن 25 عامًا في بناء وتقديم الحلول التقنية التي تصل إلى ملايين العملاء. شغل عبد النور منصب الرئيس التنفيذي للتكنولوجيا (CTO) في Talent.com عندما قام فريق AWS بتصميم وتنفيذ هذا الحل المحدد لـ Talent.com.

ديل جاك هو أحد كبار إستراتيجيي الذكاء الاصطناعي في مركز ابتكار الذكاء الاصطناعي التوليدي حيث يساعد عملاء AWS على ترجمة مشكلات العمل إلى حلول الذكاء الاصطناعي.

ديل جاك هو أحد كبار إستراتيجيي الذكاء الاصطناعي في مركز ابتكار الذكاء الاصطناعي التوليدي حيث يساعد عملاء AWS على ترجمة مشكلات العمل إلى حلول الذكاء الاصطناعي.

يانجون تشي هو مدير أول للعلوم التطبيقية في مختبر حلول التعلم الآلي في أمازون. إنها تبتكر وتطبق التعلم الآلي لمساعدة عملاء AWS على تسريع تبني الذكاء الاصطناعي والسحابة.

يانجون تشي هو مدير أول للعلوم التطبيقية في مختبر حلول التعلم الآلي في أمازون. إنها تبتكر وتطبق التعلم الآلي لمساعدة عملاء AWS على تسريع تبني الذكاء الاصطناعي والسحابة.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/from-text-to-dream-job-building-an-nlp-based-job-recommender-at-talent-com-with-amazon-sagemaker/

- :لديها

- :يكون

- :ليس

- :أين

- $ UP

- 1

- 100

- 11

- 16

- 2011

- 22

- 25

- 30

- 31

- 32

- 7

- 75

- 8

- a

- القدرة

- ماهرون

- من نحن

- تسريع

- دقة

- دقيق

- في

- تكيف

- يتكيف

- إضافة

- تبني

- متقدم

- مميزات

- بعد

- ضد

- AI

- خوارزمية

- محاذاة

- الكل

- السماح

- السماح

- يسمح

- أيضا

- بالرغم ان

- أمازون

- آلة التعلم الأمازون

- الأمازون SageMaker

- أمازون ويب سيرفيسز

- كمية

- an

- مرساة

- و

- تطبيق

- تطبيقي

- ينطبق

- نهج

- ما يقرب من

- هندسة معمارية

- هي

- المنطقة

- حول

- AS

- تقييم

- تعيين

- At

- جذاب

- الجامعة الأمريكية بالقاهرة

- أوتوماتيك

- متاح

- المتوسط

- AWS

- الخلفية

- على أساس

- خط الأساس

- BE

- لان

- كان

- أفضل

- أفضل

- ما بين

- حظر

- المدونة

- على حد سواء

- ابني

- بنيت

- الأعمال

- لكن

- by

- حساب

- حساب

- CAN

- مرشح

- المرشحين

- قدرات

- أسر

- القبض

- اسر

- يهمني

- حقيبة

- مركز

- مراكز

- تحدي

- قنوات

- مميز

- رئيس

- الرئيس التنفيذي للتكنولوجيا

- اختار

- اختيار

- فصول

- تصنيف

- واضح

- انقر

- زبون

- عميل

- عن كثب

- سحابة

- اعتماد السحابة

- كتلة

- الكود

- تعاونت

- التعاون

- للاتعاون

- جماعي

- COM

- مجموعة

- دمج

- الجمع بين

- يجمع بين

- عادة

- Communication

- الشركات

- حول الشركة

- قارن

- مقارنة

- مقارنة

- القدرة التنافسية

- إكمال

- مجمع

- مكونات

- الحسابات

- إحصاء

- الحوسبة

- الشروط

- إدارة

- التواصل

- بناء على ذلك

- بناء

- الواردة

- محتويات

- سياق الكلام

- السياقات

- قريني

- مساهم

- جوهر

- المقابلة

- دولة

- خلق

- حاسم

- CTO

- منحنى

- العملاء

- البيانات

- تحضير البيانات

- التاريخ والوقت

- DDP

- المخصصة

- مخصصة

- عميق

- التعلم العميق

- حدد

- تعريف

- تقديم

- نشر

- مستمد

- تصميم

- تصميم

- تصميم

- تفاصيل

- تطوير

- المتقدمة

- فعل

- مختلف

- ناقش

- مسافة

- خامد

- تميز

- وزعت

- التدريب الموزع

- توزيع

- توزيع

- do

- وثيقة

- نطاق

- حلم

- مدفوع

- أثناء

- كل

- في وقت مبكر

- الطُرق الفعّالة

- فعالية

- كفاءة

- فعال

- عناصر

- البريد الإلكتروني

- رسائل البريد الإلكتروني

- تضمين

- أرباب العمل

- توظيف

- تمكين

- شجع

- النهائي إلى نهاية

- محاولة

- التعاقدات

- محرك

- مهندس

- مهندسة

- الهندسة

- المهندسين

- تعزيز

- يعزز

- ضمان

- يضمن

- الكيانات

- كيان

- البيئة

- البيئات

- تأسيس

- تقييم

- تقييم

- تقييم

- كل

- مثال

- أعدم

- تنفيذي

- القائمة

- الخبره في مجال الغطس

- خبرة

- خبرائنا

- اكتشف

- معبر

- استخراج

- أسرع

- الميزات

- المميزات

- قليل

- الشكل

- نهائي

- مرونة

- تركز

- ركز

- متابعيك

- في حالة

- القوات

- أربعة

- الإطار

- تبدأ من

- تماما

- وظائف

- إضافي

- ربح

- مقياس

- توليد

- يولد

- توليد

- توليدي

- الذكاء الاصطناعي التوليدي

- معطى

- يعطي

- الأهداف

- خير

- وحدة معالجة الرسوميات:

- وحدات معالجة الرسومات

- تدريجيا

- يملك

- he

- رئيس

- عقد

- مساعدة

- ساعد

- مساعدة

- يساعد

- مرتفع

- عالية الأداء

- أعلى

- جدا

- تاريخي

- تاريخ

- كيفية

- كيفية

- لكن

- HTML

- HTTP

- HTTPS

- تحسين Hyperparameter

- المثالي

- محدد

- تحديد

- if

- ii

- يوضح

- التنفيذ

- تحقيق

- استيراد

- أهمية

- تحسن

- تحسن

- تحسينات

- تحسين

- in

- يشمل

- بما فيه

- القيمة الاسمية

- في ازدياد

- مستقل

- بشكل مستقل

- يشير

- فرد

- الصناعات

- خاص بالصناعة

- معلومات

- متأصل

- الابتكار

- إدخال

- المدخلات

- مثل

- دور فعال

- نية

- تفاعل

- التفاعلات

- مصلحة

- يستفد

- السريرية

- إلى

- أدخلت

- IT

- العناصر

- انها

- رطانة

- وظيفة

- قائمة العمل

- المسميات الوظيفية

- المشــاريــع

- انضم

- مشترك

- رحلة

- م

- احتفظ

- القفل

- الكلمات المفتاحية

- معروف

- مختبر

- تُشير

- لغة

- اللغات

- كبير

- أكبر

- أخيرا

- قيادة

- تعلم

- تعلم

- مستوى

- الرافعة المالية

- المكتبة

- مثل

- محدود

- خطوط

- قائمة

- المدرج

- قائمة

- مصانع

- قوائم

- تحميل

- موقع

- خسائر

- منخفض

- أدنى

- آلة

- آلة التعلم

- الرئيسية

- الحفاظ على

- جعل

- القيام ب

- تمكن

- مدير

- كثير

- رسم الخرائط

- تجارة

- مباراة

- اعواد الثقاب

- مطابقة

- الرياضيات

- أمر

- مايو..

- تعني

- ذات مغزى

- المعاني

- يعني

- قياس

- الإجراءات

- طريقة

- المنهجيات

- آلية العمل

- متري

- المقاييس

- ربما

- معلم

- مليون

- ملايين

- الرسالة

- ML

- نموذج

- تصميم

- عارضات ازياء

- الأكثر من ذلك

- أكثر

- متعدد

- الاسم

- عين

- أسماء

- طبيعي

- معالجة اللغات الطبيعية

- حاجة

- إحتياجات

- سلبي

- السلبيات

- شبكة

- الشبكات

- عصبي

- الشبكات العصبية

- جديد

- التالي

- البرمجة اللغوية العصبية

- العقد

- ضجيج

- تظليل

- تم الحصول عليها

- احتلال

- of

- عرض

- عرضت

- امين شرطة منزل فؤاد

- حاليا

- on

- ONE

- online

- فقط

- افتتاح

- تعمل

- الفرص

- الأمثل

- التحسين

- الأمثل

- المثلى

- or

- طلب

- لنا

- لنا

- خارج

- تفوقت

- الناتج

- النتائج

- على مدى

- الكلي

- تغلب

- نظرة عامة

- الخاصة

- مدفوع

- زوج

- موازية

- المعلمات

- أساسي

- جزء

- خاص

- مرت

- شغف

- الماضي

- نمط

- مجتمع

- نسبة مئوية

- نفذ

- أداء

- مخصصه

- قطعة

- المنصة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- يلعب

- شعبية

- سكان

- ان يرتفع المركز

- إيجابي

- ممكن

- منشور

- محتمل

- قوة

- قوي

- دقة

- تنبأ

- وتوقع

- تنبؤ

- التفضيلات

- يقدم

- قدم

- سابق

- رئيسي

- المشكلة

- مشاكل

- الإجراءات

- عملية المعالجة

- العمليات

- معالجة

- أنتج

- الإنتــاج

- محترف

- ملفي الشخصي

- تنفيذ المشاريع

- المقترح

- تزود

- المقدمة

- ويوفر

- توفير

- جمهور

- بايثون

- pytorch

- Qi

- جودة

- الاستفسارات

- بسرعة

- عشوائية

- المرتبة

- تصنيف

- الرتب

- معدل

- الخام

- القراء

- اعتراف

- نوصي

- توصية مجاناً

- ساندي خ. ميليك

- موصى به

- تخفيض

- يقلل

- تقليص

- الرجوع

- يشير

- مكرر

- سجلات

- صلة

- العلاقات

- مدى صلة

- ذات الصلة

- الموثوقية

- منسوخة

- يمثل

- نتيجة

- مما أدى

- النتائج

- النوع

- الأدوار

- لفة

- تشغيل

- sagemaker

- الضبط التلقائي لنموذج SageMaker

- نفسه

- حجم

- جدولة

- علوم

- عالم

- العلماء

- سيناريو

- بحث

- البحث

- القسم

- أقسام

- اختيار

- كبير

- أرسلت

- يخدم

- الخدمة

- خدماتنا

- طقم

- باكجات

- الإعداد

- هي

- قصير

- إظهار

- أظهرت

- يظهر

- هام

- بشكل ملحوظ

- عزباء

- الأصغر

- حل

- الحلول

- حل

- مصادر

- الفضاء

- محدد

- على وجه التحديد

- تفاصيل

- سرعة

- بسرعة

- معيار

- دولة من بين الفن

- خطوة

- وقف

- تخزين

- الاستراتيجيين

- نقاط القوة

- خيط

- موضوع

- جوهريا

- تحقيق النجاح

- هذه

- تزامن

- نظام

- أنظمة

- أخذ

- يأخذ

- الموهوبين

- مهمة

- فريق

- تقنيات

- تكنولوجيا

- تجربه بالعربي

- الاختبار

- نص

- نصي

- من

- أن

- •

- المنطقة

- المعلومات

- من مشاركة

- منهم

- then

- تشبه

- هم

- شيء

- ثلاثة

- عبر

- طوال

- الوقت

- مرات

- عملاق

- عنوان

- عناوين

- إلى

- سويا

- تيشرت

- شعلة

- الإجمالي

- برج

- قطار

- قادة الإيمان

- التحويلية

- ترجمه

- الثلاثي

- حقا

- اثنان

- أنواع

- مع

- فهم

- فهم

- يفهم

- فريد من نوعه

- منقطع النظير

- المقبلة

- رفع

- us

- تستخدم

- مستعمل

- مستخدم

- المستخدمين

- يستخدم

- استخدام

- عادة

- الاستفادة من

- يستخدم

- القيمة

- قيمنا

- بواسطة

- vs

- وكان

- we

- الويب

- خدمات ويب

- أسابيع

- كان

- متى

- في حين

- التي

- في حين

- سوف

- مع

- في غضون

- عامل

- العالم

- جاري الكتابة

- سنوات

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت