تستخدم المؤسسات خدمات التعلم الآلي (ML) والذكاء الاصطناعي لتحسين تجربة العملاء وتقليل التكلفة التشغيلية وإطلاق العنان لإمكانيات جديدة لتحسين نتائج الأعمال. تدعم البيانات حالات استخدام تعلم الآلة والذكاء الاصطناعي وهي أحد الأصول الإستراتيجية للمؤسسة. نظرًا لأن البيانات تنمو بمعدل أسي ، تتطلع المؤسسات إلى إنشاء منصة بيانات متكاملة وفعالة من حيث التكلفة وفعالة من أجل معالجة البيانات مسبقًا وأداء هندسة الميزات وبناء نماذج ML وتدريبها وتشغيلها على نطاق واسع. لتحقيق ذلك ، تقدم AWS منصة بيانات حديثة وموحدة يتم تشغيلها بواسطة خدمة تخزين أمازون البسيطة (Amazon S3) كمخزن بيانات مع أدوات مصممة خصيصًا ومحركات معالجة لدعم التحليلات وأعباء عمل ML. للحصول على تجربة ML موحدة ، يمكنك استخدام أمازون ساجميكر ستوديو، والتي تقدم التكامل الأصلي مع جلسات AWS Glue التفاعلية لأداء هندسة الميزات على نطاق واسع مع حماية البيانات الحساسة. في هذا المنشور ، نوضح كيفية تنفيذ هذا الحل.

الأمازون SageMaker هي خدمة تعلّم آلية مُدارة بالكامل تتيح لك إنشاء نماذج وتدريبها ونشرها على نطاق واسع لمجموعة واسعة من حالات الاستخدام. للتدريب النموذجي ، يمكنك استخدام أي من خوارزميات مدمجة داخل SageMaker لبدء التدريب ونشر نماذج ML بسرعة.

تعد هندسة الميزات مكونًا رئيسيًا في عملية بناء النموذج وتطويره. غراء AWS أحد الخيارات الموصى بها لتحقيق هندسة الميزات على نطاق واسع. تمكّنك AWS Glue من تشغيل تكامل البيانات وتحويلها بطريقة موزعة على بنية أساسية Apache Spark بدون خادم ، وتسهّل استخدام مكتبة Spark ML الشهيرة لهندسة الميزات وتطوير النماذج. بالإضافة إلى ذلك ، يمكنك استخدام AWS Glue لمعالجة البيانات المتزايدة من خلالها إشارات مرجعية للوظيفة، واستيعاب البيانات من أكثر من 100 مصدر باستخدام موصلات، وقم بتشغيل أحمال عمل شائكة أو غير متوقعة باستخدام ملفات التحجيم التلقائي.

من المتطلبات المهمة الأخرى للتطبيقات المستندة إلى ML هو أمان البيانات والتحكم في الوصول. من الشائع أن يكون لديك سيطرة أكثر إحكامًا على من يمكنه الوصول إلى البيانات الأكثر حساسية كجزء من هندسة الميزات وعملية بناء النموذج باتباع مبدأ الوصول الأقل امتيازًا. لتحقيق ذلك ، يمكنك الاستفادة من تكامل AWS Glue مع تكوين بحيرة AWS لزيادة الحوكمة وإدارة أصول بحيرة البيانات. باستخدام Lake Formation ، يمكنك تكوين سياسات الأمان والتحكم الدقيق في الوصول إلى البيانات أعلى بحيرة بيانات Amazon S3. يتم تحديد السياسات في موقع مركزي ، مما يسمح بتحليلات متعددة وخدمات ML ، مثل AWS Glue ، أمازون أثيناو SageMaker للتفاعل مع البيانات المخزنة في Amazon S3.

يتضمن AWS Glue ملف الكشف عن معلومات التعريف الشخصية (PII) التحويل الذي يوفر القدرة على اكتشاف أو إخفاء أو إزالة الكيانات كما هو مطلوب ، لزيادة الامتثال والحوكمة. باستخدام تحويل PII ، يمكنك اكتشاف بيانات PII في مجموعات البيانات وتطبيق التحكم الدقيق في الوصول تلقائيًا باستخدام Lake Formation لتقييد البيانات الحساسة لمجموعات مختلفة من المستخدمين.

حالة الاستخدام

نحن نركز على حالة استخدام نموذج النزعة التي تتضمن مجموعة بيانات تسويقية للعملاء وتتضمن شخصين مستخدمين: مهندس بيانات وعالم بيانات. تحتوي مجموعة البيانات على معلومات لكل عميل ، بما في ذلك مصدر العميل المتوقع وملاحظات الاتصال والدور الوظيفي وبعض العلامات ومشاهدات الصفحة لكل زيارة والمزيد. تتضمن مجموعة البيانات أيضًا معلومات حساسة مثل أرقام الهواتف الشخصية.

مهندس البيانات مسؤول عن بناء خط أنابيب معالجة البيانات من البداية إلى النهاية ، بما في ذلك إعداد البيانات والمعالجة المسبقة والتحكم في الوصول. عالم البيانات مسؤول عن هندسة الميزات ، وتدريب ونشر نموذج ML. لاحظ أنه لا يُسمح لعالم البيانات بالوصول إلى أي بيانات حساسة لمعلومات تحديد الهوية الشخصية (PII) لهندسة الميزات أو تدريب نموذج ML.

كجزء من حالة الاستخدام هذه ، يقوم مهندس البيانات ببناء خط أنابيب للمعالجة المسبقة لمجموعة البيانات ، ومسح مجموعة البيانات بحثًا عن أي معلومات PII ، ويقيد وصول عمود PII إلى مستخدم عالم البيانات. نتيجة لذلك ، عندما يستخدم عالم البيانات مجموعة البيانات لأداء هندسة الميزات وبناء نماذج ML ، فلن يتمكن من الوصول إلى العمود الحساس لمعلومات التعريف الشخصية (أرقام الهواتف ، في هذه الحالة). تتضمن عملية هندسة الميزات تحويل أعمدة من سلسلة النوع إلى تنسيق مثالي لنماذج ML. كحالة استخدام متقدمة ، يمكنك توسيع نمط الوصول هذا لتنفيذ أمان على مستوى الصف وعلى مستوى الخلية باستخدام Lake Formation.

حل نظرة عامة

يحتوي الحل على الخطوات عالية المستوى التالية:

- قم بإعداد الموارد باستخدام تكوين سحابة AWS.

- قم بإجراء معالجة مسبقة لمجموعة البيانات ، بما في ذلك اكتشاف معلومات تحديد الهوية الشخصية والتحكم الدقيق في الوصول ، في جلسة تفاعلية مع AWS Glue.

- قم بإجراء هندسة الميزات في جلسة تفاعلية مع AWS Glue.

- تدريب ونشر نموذج ML باستخدام خوارزمية XGBoost المضمنة من SageMaker.

- تقييم نموذج ML.

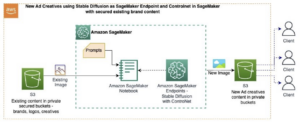

يوضح الرسم البياني التالي بنية الحل.

المتطلبات الأساسية المسبقة

لإكمال هذا البرنامج التعليمي ، يجب أن تكون لديك المتطلبات الأساسية التالية:

قم بإعداد الموارد باستخدام AWS CloudFormation

يتضمن هذا المنشور قالب CloudFormation لإعداد سريع. يمكنك مراجعته وتخصيصه ليناسب احتياجاتك. إذا كنت تفضل إعداد الموارد على وحدة تحكم إدارة AWS و AWS CLI بدلاً من AWS CloudFormation ، راجع الإرشادات الموجودة في الملحق في نهاية هذا المنشور.

يُنشئ نموذج CloudFormation الموارد التالية:

- دلاء S3 مع عينة مجموعة بيانات

- An AWS لامدا وظيفة لتحميل مجموعة البيانات

- إدارة الهوية والوصول AWS (IAM) والمستخدمين والأدوار والسياسات

- إعدادات بحيرة بيانات تكوين البحيرة والأذونات

- ملفات تعريف مستخدمي SageMaker

لإنشاء مواردك ، أكمل الخطوات التالية:

- قم بتسجيل الدخول إلى وحدة التحكم.

- اختار قم بتشغيل Stack:

- اختار التالى.

- في حالة DataEngineerPwd و DataScientistPwd، أدخل كلمة المرور الخاصة بك لمستخدمي مهندس البيانات وعالم البيانات.

- في حالة اسم قاعدة البيانات، أدخل

demo. - في حالة اسم الجدول الغراء، أدخل

web_marketing. - في حالة S3BucketNameForInput، أدخل

blog-studio-pii-dataset-. - في حالة S3BucketNameForOutput، أدخل

blog-studio-output-. - في حالة معرف SageMakerDomainId، أدخل معرف مجال SageMaker الذي أعددته في خطوات المتطلبات الأساسية.

- اختار التالى.

- في الصفحة التالية ، اختر التالى.

- راجع التفاصيل الموجودة في الصفحة الأخيرة وحدد أقر بأن AWS CloudFormation قد تنشئ موارد IAM.

- اختار إنشاء.

يمكن أن يستغرق إنشاء الحزم ما يصل إلى 10 دقائق. ينشئ المكدس أدوار IAM وملفات تعريف مستخدم SageMaker لشخصين: مهندس بيانات وعالم بيانات. يقوم أيضًا بإنشاء عرض قاعدة بيانات وجدول web_marketing مع عينة مجموعة بيانات.

في وقت إنشاء المكدس ، تتمتع شخصية مهندس البيانات بإمكانية الوصول الكامل إلى الجدول ، لكن شخصية عالم البيانات ليس لديها أي وصول إلى الجدول حتى الآن.

المعالجة المسبقة لمجموعة البيانات

لنبدأ في المعالجة المسبقة للبيانات في جلسة تفاعلية مع AWS Glue. يريد مهندس البيانات التحقق من البيانات لمعرفة ما إذا كانت هناك بيانات حساسة أم لا ، ومنح الحد الأدنى من إذن الوصول إلى شخصية عالم البيانات. يمكنك تنزيل دفتر ملاحظات من هذا الموقع.

- قم بتسجيل الدخول إلى وحدة التحكم باستخدام مستخدم مهندس البيانات.

- في وحدة تحكم SageMaker ، اختر المستخدمين.

- حدد مستخدم مهندس البيانات واختر فتح ستوديو.

- قم بإنشاء دفتر ملاحظات جديد واختر SparkAnalytics 1.0 تحديث For صورة و الغراء PySpark For نواة.

- ابدأ جلسة تفاعلية بالسحر التالي لتثبيت الإصدار الأحدث من Boto3 (هذا مطلوب لاستخدام ملف

create_data_cells_filterطريقة): - بدء الجلسة:

- أنشئ AWS Glue DynamicFrame من الجدول الذي تم إنشاؤه حديثًا ، و حل أنواع الاختيار استنادًا إلى مخطط الكتالوج ، لأننا نريد استخدام المخطط المحدد في الكتالوج بدلاً من المخطط المستنتج تلقائيًا استنادًا إلى البيانات:

- تحقق في الجدول مما إذا كانت هناك أي بيانات PII باستخدام اكتشاف AWS Glue PII:

- تحقق مما إذا كانت الأعمدة المصنفة على أنها معلومات تحديد الهوية الشخصية تحتوي على بيانات حساسة أم لا (إذا لم يكن الأمر كذلك ، فقم بتحديث خريطة مصنفة لإسقاط الأعمدة غير الحساسة):

- قم بإعداد أذونات Lake Formation باستخدام عامل تصفية خلية البيانات للأعمدة المكتشفة تلقائيًا ، وقصر الأعمدة على شخصية عالم البيانات:

- سجّل الدخول إلى Studio كعالم بيانات لترى أن أعمدة معلومات تحديد الهوية الشخصية غير مرئية. يمكنك تنزيل دفتر ملاحظات من هذا الموقع.

- قم بإنشاء دفتر ملاحظات جديد واختر SparkAnalytics 1.0 تحديث For صورة و الغراء PySpark For نواة:

أداء هندسة الميزات

نستخدم مكتبة Apache Spark ML لأداء هندسة الميزات بصفتنا مستخدمًا لعالم البيانات ثم إعادة كتابة الإخراج إلى Amazon S3.

- في الخلية التالية ، نطبق ميزات من مكتبة Apache Spark ML:

StringIndexerتعيين عمود سلسلة من التسميات إلى عمود فهارس التسمية.OneHotEncoderتعيّن ميزة فئوية ، ممثلة كفهرس تسمية ، إلى متجه ثنائي مع قيمة واحدة على الأكثر تشير إلى وجود ميزة فئوية محددة. يستخدم هذا التحويل لخوارزميات ML التي تتوقع ميزات مستمرة.VectorAssemblerهو محول يجمع قائمة معينة من الأعمدة في عمود متجه واحد ، والذي يستخدم بعد ذلك في تدريب نماذج ML للخوارزميات مثل الانحدار اللوجستي وأشجار القرار.

- يمكن إنشاء DataFrame النهائي المحول باستخدام مكتبة خطوط الأنابيب. يتم تحديد خط الأنابيب كسلسلة من المراحل. يتم تشغيل هذه المراحل بالترتيب ويتم تحويل إدخال DataFrame أثناء مروره عبر كل مرحلة.

- بعد ذلك ، قمنا بتقسيم مجموعة البيانات إلى تدريب ، والتحقق من صحة ، واختبار DataFrame وحفظها في حاوية S3 لتدريب نموذج ML (قدم معرف حساب AWS الخاص بك في الكود التالي):

تدريب ونشر نموذج ML

في القسم السابق ، أكملنا هندسة الميزات ، والتي تضمنت تحويل أعمدة السلسلة مثل region, jobroleو usedpromo بتنسيق مثالي لنماذج ML. قمنا أيضًا بتضمين أعمدة مثل pageviewspervisit و totalwebvisits، مما سيساعدنا على التنبؤ بميل العميل لشراء منتج.

نقوم الآن بتدريب نموذج ML من خلال قراءة مجموعة بيانات القطار والتحقق من الصحة باستخدام خوارزمية XGBoost المضمنة من SageMaker. ثم نقوم بنشر النموذج وإجراء فحص الدقة. يمكنك تنزيل دفتر ملاحظات من هذا الموقع.

في الخلية التالية ، نقرأ البيانات من دلو S3 الثاني ، والذي يتضمن ناتج عمليات هندسة الميزات لدينا. ثم نستخدم الخوارزمية المدمجة XGBoost لتدريب النموذج.

- افتح دفتر ملاحظات جديدًا. يختار العلوم البيانات For صورة و بيثون 3 For نواة (أدخل معرف حساب AWS الخاص بك في الكود التالي):

- عند اكتمال التدريب ، يمكننا نشر النموذج باستخدام خدمات استضافة SageMaker:

تقييم نموذج ML

نستخدم مجموعة بيانات الاختبار لتقييم النموذج وحذف نقطة نهاية الاستدلال عندما ننتهي لتجنب أي رسوم مستمرة.

- قم بتقييم النموذج بالرمز التالي:

كانت نتيجة الدقة لتشغيل العينة 84.6٪. قد يكون هذا مختلفًا قليلاً بالنسبة للتشغيل بسبب التقسيم العشوائي لمجموعة البيانات.

- يمكننا حذف نقطة نهاية الاستدلال بالكود التالي:

تنظيف

الآن إلى الخطوة الأخيرة ، تنظيف الموارد.

- إفراغ المستويين اللذين تم إنشاؤهما من خلال مكدس CloudFormation.

- احذف التطبيقات المرتبطة بالمستخدم

profiles data-scientistوdata-engineerداخل الاستوديو. - احذف مكدس CloudFormation.

وفي الختام

في هذا المنشور ، أظهرنا حلاً يمكّن الأشخاص مثل مهندسي البيانات وعلماء البيانات من أداء هندسة الميزات على نطاق واسع. باستخدام جلسات AWS Glue التفاعلية ، يمكنك بسهولة تحقيق هندسة الميزات على نطاق واسع من خلال الكشف التلقائي عن معلومات تحديد الهوية الشخصية (PII) والتحكم الدقيق في الوصول دون الحاجة إلى إدارة أي بنية أساسية أساسية. باستخدام Studio كنقطة دخول واحدة ، يمكنك الحصول على تجربة مبسطة ومتكاملة لبناء سير عمل ML من طرف إلى طرف: من إعداد وتأمين البيانات إلى بناء نماذج ML والتدريب عليها وضبطها ونشرها. لمعرفة المزيد ، قم بزيارة بدء جلسات AWS Glue التفاعلية و أمازون ساجميكر ستوديو.

نحن متحمسون جدًا لهذه القدرة الجديدة ونحرص على رؤية ما ستبنيه بها!

الملحق: قم بإعداد الموارد عبر وحدة التحكم و AWS CLI

أكمل التعليمات الواردة في هذا القسم لإعداد الموارد باستخدام وحدة التحكم و AWS CLI بدلاً من نموذج CloudFormation.

المتطلبات الأساسية المسبقة

لإكمال هذا البرنامج التعليمي ، يجب أن يكون لديك حق الوصول إلى AWS CLI (انظر بدء استخدام AWS CLI) أو استخدم وصول سطر الأوامر من أوس كلاودشيل.

تكوين مجموعة IAM والمستخدمين والأدوار والسياسات

في هذا القسم ، نقوم بإنشاء اثنين من مستخدمي IAM: مهندس بيانات وعالم بيانات ، ينتميان إلى مجموعة منصة بيانات مجموعة IAM. ثم نضيف سياسة IAM واحدة إلى مجموعة IAM.

- على وحدة تحكم IAM ، إنشاء سياسة في علامة التبويب JSON لإنشاء سياسة IAM مدارة جديدة باسم

DataPlatformGroupPolicy. تسمح السياسة للمستخدمين في المجموعة بالوصول إلى Studio ، ولكن فقط باستخدام ملف تعريف مستخدم SageMaker مع علامة تطابق اسم مستخدم IAM الخاص بهم. استخدم مستند سياسة JSON التالي لتوفير الأذونات: - إنشاء مجموعة IAM تسمى

data-platform-group. - ابحث وأرفق سياسة AWS المُدارة باسم DataPlatformGroupPolicy بالمجموعة.

- إنشاء مستخدمي IAM يسمى مهندس البيانات وعالم البيانات ضمن مجموعة منصة البيانات لمجموعة IAM.

- قم بإنشاء سياسة مُدارة جديدة المسمى SageMakerExecutionPolicy (قدم منطقتك ومعرف الحساب في الكود التالي):

- قم بإنشاء سياسة مُدارة جديدة عين

SageMakerAdminPolicy: - إنشاء دور IAM لـ SageMaker لمهندس البيانات (مهندس البيانات) ، والذي يتم استخدامه كدور تنفيذ لملف تعريف المستخدم المقابل. على ال إرفاق سياسة الأذونات الصفحة ، يتم إرفاق AmazonSageMakerFullAccess (سياسة AWS المُدارة) افتراضيًا. قمت بإزالة هذه السياسة لاحقًا للحفاظ على الحد الأدنى من الامتياز.

- في حالة اسم الدور، استخدم اصطلاح التسمية المقدم في بداية هذا القسم لتسمية الدور SageMakerStudioExecutionRole_data-engineer.

- في حالة علامات ، أضف اسم المستخدم الرئيسي ومهندس بيانات القيمة.

- اختار خلق دور.

- لإضافة السياسات المتبقية ، على الأدوار الصفحة ، اختر اسم الدور الذي أنشأته للتو.

- تحت أذونات، قم بإزالة سياسة AmazonSageMakerFullAccess.

- على إرفاق سياسة الأذونات الصفحة ، حدد سياسة AWS المُدارة AwsGlueSessionUserRestrictedServiceRole ، والسياسات المُدارة للعملاء SageMakerExecutionPolicy و SageMakerAdminPolicy التي قمت بإنشائها.

- اختار إرفاق السياسات.

- عدل علاقة ثقة دورك:

- إنشاء دور IAM لـ SageMaker لعالم البيانات (عالم البيانات) ، والذي يستخدم كدور تنفيذ لملف تعريف المستخدم المقابل.

- في حالة اسم الدور، قم بتسمية الدور SageMakerStudioExecutionRole_data- عالم.

- في حالة علامات ، أضف اسم المستخدم الرئيسي وعالم بيانات القيمة.

- اختار خلق دور.

- لإضافة السياسات المتبقية ، على الأدوار الصفحة ، اختر اسم الدور الذي أنشأته للتو.

- تحت أذونات، قم بإزالة سياسة AmazonSageMakerFullAccess.

- على إرفاق سياسة الأذونات الصفحة ، حدد سياسة AWS المُدارة AwsGlueSessionUserRestrictedServiceRole ، وسياسة العميل المُدارة SageMakerExecutionPolicy التي قمت بإنشائها.

- اختار إرفاق السياسات.

- عدل علاقة ثقة دورك:

تكوين ملفات تعريف مستخدمي SageMaker

لإنشاء ملفات تعريف مستخدم SageMaker بامتداد studiouserid علامة ، أكمل الخطوات التالية:

- استخدم AWS CLI أو CloudShell لإنشاء ملف تعريف مستخدم Studio لمهندس البيانات (قدم معرف حسابك ومعرف مجال Studio في الكود التالي):

- كرر الخطوة لإنشاء ملف تعريف مستخدم لعالم البيانات ، واستبدال معرف الحساب ومعرف مجال Studio:

أنشئ حاويات S3 وحمِّل عينة مجموعة البيانات

في هذا القسم ، تقوم بإنشاء حاويتين S3. تحتوي المجموعة الأولى على عينة مجموعة بيانات متعلقة بالتسويق عبر الإنترنت. يتم استخدام الدلو الثاني بواسطة عالم البيانات لتخزين الإخراج من مهام هندسة الميزات ، ويتم استخدام مجموعة بيانات الإخراج هذه لتدريب نموذج ML.

أولاً ، قم بإنشاء حاوية S3 لبيانات الإدخال:

- تحميل مجموعة البيانات.

- في وحدة تحكم Amazon S3 ، اختر الدلاء في جزء التنقل.

- اختار إنشاء دلو.

- في حالة بلد المنشأ، اختر المنطقة مع مجال SageMaker الذي يتضمن ملفات تعريف المستخدمين التي قمت بإنشائها.

- في حالة اسم الدلو، أدخل

blog-studio-pii-dataset-. - اختار إنشاء دلو.

- حدد الحاوية التي أنشأتها واخترها تحميل.

- في مجلة اختيار الملفات القسم، اختر إضافة ملفات وقم بتحميل مجموعة البيانات التي قمت بتنزيلها.

الآن تقوم بإنشاء دلو لبيانات الإخراج: - على الدلاء الصفحة ، اختر إنشاء دلو.

- في حالة بلد المنشأ، اختر المنطقة مع مجال SageMaker الذي يتضمن ملفات تعريف المستخدمين التي قمت بإنشائها.

- في حالة اسم الدلو، أدخل

blog-studio-output-. - اختار إنشاء دلو.

أنشئ قاعدة بيانات وجدول AWS Glue

في هذا القسم ، تقوم بإنشاء قاعدة بيانات وجدول AWS Glue لمجموعة البيانات.

- على وحدة تحكم تشكيل البحيرة ، تحت كتالوج البيانات في جزء التنقل ، اختر قواعد بيانات.

- اختار أضف قاعدة البيانات.

- في حالة الاسم، أدخل العرض.

- اختار إنشاء قاعدة البيانات.

- تحت كتالوج البيانات، اختر طاولات الطعام.

- في حالة الاسم، أدخل

web_marketing. - في حالة قاعدة البيانات، حدد

demo. - في حالة تضمين المسار، أدخل مسار حاوية S3 لبيانات الإدخال.

- في حالة تصنيف، اختر CSV.

- تحت مخطط، اختر تحميل المخطط.

- أدخل مجموعة JSON التالية في مربع النص:

- اختار تحميل.

- اختار تقدم.

- تحت تفاصيل الجدول، اختر تحرير الجدول.

- تحت خصائص الجدول، اختر أضف.

- في حالة القفل، أدخل

skip.header.line.countولل القيم، أدخل 1. - اختار حفظ.

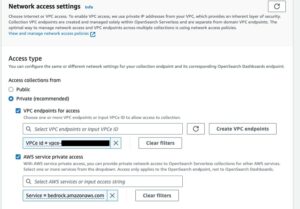

تكوين أذونات تكوين البحيرة

في هذا القسم ، تقوم بإعداد أذونات Lake Formation للسماح بدور IAM SageMakerStudioExecutionRole_data-engineer لإنشاء قاعدة بيانات وتسجيل موقع S3 داخل Lake Formation.

أولاً ، قم بتسجيل موقع بحيرة البيانات لإدارة الجداول الموجودة أسفل الموقع في أذونات تكوين البحيرة:

- اختار مواقع بحيرة البيانات.

- اختار تسجيل الموقع.

- في حالة مسار Amazon S3، أدخل

s3://blog-studio-pii-dataset-/(الحاوية التي تحتوي على مجموعة البيانات). - اختار تسجيل الموقع.

أنت الآن تمنح قاعدة بيانات Lake Formation وأذونات الجدول لأدوار IAMSageMakerStudioExecutionRole_data-engineerوSageMakerStudioExecutionRole_data-scientistأولاً ، امنح إذن قاعدة البيانات لـSageMakerStudioExecutionRole_data-engineer: - تحت أذونات، اختر أذونات بحيرة البيانات.

- تحت إذن البيانات، اختر منحة.

- في حالة مدراء، اختر مستخدمي IAM وأدوارها، وحدد الدور

SageMakerStudioExecutionRole_data-engineer. - في حالة علامات السياسة أو موارد الكتالوج، اختر موارد كتالوج البيانات المسماة.

- في حالة قواعد بيانات، اختر العرض.

- في حالة أذونات قاعدة البيانات ، حدد فائق.

- اختار منحة.

بعد ذلك ، امنح إذن الجدول لـSageMakerStudioExecutionRole_data-engineer: - تحت إذن البيانات، اختر منحة.

- في حالة مدراء، اختر مستخدمي IAM وأدوارها، وحدد الدور

SageMakerStudioExecutionRole_data-engineer. - في حالة علامات السياسة أو موارد الكتالوج، اختر موارد كتالوج البيانات المسماة.

- في حالة قواعد بيانات، اختر

demo. - في حالة طاولات الطعام، اختر

web_marketing. - في حالة طاولات ومكاتب أذونات ، حدد فائق.

- في حالة مقبول أذونات ، حدد فائق.

- اختار منحة.

أخيرًا ، امنح إذن قاعدة البيانات لـSageMakerStudioExecutionRole_data-scientist: - تحت إذن البيانات، اختر منحة.

- في حالة مدراء، اختر مستخدمي IAM وأدوارها، وحدد الدور

SageMakerStudioExecutionRole_data-scientist. - في حالة علامات السياسة أو موارد الكتالوج، اختر موارد كتالوج البيانات المسماة.

- في حالة قواعد بيانات، اختر

demo. - في حالة أذونات قاعدة البيانات ، حدد وصف.

- اختار منحة.

حول المؤلف

برافين كومار، لاعب كريكيت هندي هو مهندس حلول تحليلات في AWS يتمتع بخبرة في تصميم وبناء وتنفيذ منصات البيانات والتحليلات الحديثة باستخدام الخدمات السحابية الأصلية. مجالات اهتماماته هي التكنولوجيا بدون خادم ، ومستودعات البيانات السحابية الحديثة ، والتدفق ، وتطبيقات ML.

نوريتاكا سيكياما هو مهندس رئيسي للبيانات الضخمة في فريق AWS Glue. إنه يستمتع بالتعاون مع فرق مختلفة لتقديم نتائج مثل هذه المشاركة. في أوقات فراغه ، يستمتع بلعب ألعاب الفيديو مع عائلته.

- متقدم (300،XNUMX)

- AI

- ai الفن

- مولد الفن ai

- الروبوت ai

- الأمازون SageMaker

- الذكاء الاصطناعي

- شهادة الذكاء الاصطناعي

- الذكاء الاصطناعي في البنوك

- روبوت ذكاء اصطناعي

- روبوتات الذكاء الاصطناعي

- برنامج ذكاء اصطناعي

- بيانات AWS الضخمة

- غراء AWS

- تكوين بحيرة AWS

- التعلم الآلي من AWS

- سلسلة كتلة

- مؤتمر blockchain ai

- عملة عبقرية

- الذكاء الاصطناعي للمحادثة

- مؤتمر التشفير ai

- دال

- التعلم العميق

- google ai

- آلة التعلم

- أفلاطون

- أفلاطون ع

- الذكاء افلاطون البيانات

- لعبة أفلاطون

- أفلاطون داتا

- بلاتوغمينغ

- مقياس ai

- بناء الجملة

- قيادة الفكر

- زفيرنت