نعم .. أنا أتحدث عن تطبيقات الذكاء الاصطناعي - تطبيقات الذكاء الاصطناعي التي لا تعد ولا تحصى والتطبيقات القادمة التي تهمس البشر حول ما يجب القيام به…. كيفية القيام بذلك ... ولكن ليس عن الهمس الذين يتفاعلون مع روبوتات الدردشة التي تعمل بالذكاء الاصطناعي.

وفقًا IDC التوقعات ، يمكن أن يصل سوق الذكاء الاصطناعي العالمي إلى أكثر من 500 مليار دولار بحلول عام 2024 - بزيادة أكثر من 50٪ من عام 2021. وهذا يشير إلى أننا انتقلنا من تجارب الأعمال إلى قبول أنها جزء لا يتجزأ من استراتيجية المؤسسة لجميع الأحجام. إنها أداة ضرورية لتحويل البيانات إلى رؤى لتحفيز العمل بناءً على قرارات أفضل. لا أحد يناقش فوائد الذكاء الاصطناعي لتقليل مخاطر الأعمال وتضخيم عائد الاستثمار بالابتكار. ولكن ، كما هو الحال دائمًا ، هناك ... ولكن ... الذكاء الاصطناعي غير المتحيز أسهل في القول من فعله.

تحتاج نماذج الذكاء الاصطناعي هذه ، التي تعتبر بالغة الأهمية للأعمال التجارية ، إلى العمل بشكل موثوق به مع وضوح الرؤية والمساءلة. خلاف ذلك ، فإن الفشل ، في هذه الحالة ، له عواقب وخيمة تؤثر على التدفق النقدي لأي شركة وقد يؤدي حتى إلى مسائل قانونية. الطريقة الوحيدة لتجنب ذلك هي الأتمتة والشفافية للإجابة على سؤال واحد "هل يمكنك إثبات أن هذا التطبيق / عبء العمل للذكاء الاصطناعي مبني بشكل أخلاقي." اكا ... كيف تحكم؟ وهل يمكنك أن تثبت أنه يحكم باستمرار؟

هذا هو المكان الذي تحب فيه الشركات IBM استثمروا في حوكمة الذكاء الاصطناعي لتنظيم العملية الشاملة لتوجيه وإدارة ومراقبة أنشطة الذكاء الاصطناعي للمنظمة. وتتمثل المهمة الأساسية في ضمان بقاء جميع وحدات الأعمال استباقية وبث إطار الحوكمة في المبادرات لتعزيز القدرة على تلبية المبادئ واللوائح الأخلاقية. على وجه الخصوص ، فإن الصناعات الخاضعة للتنظيم مثل الخدمات المصرفية والمالية مطلوبة قانونًا لتقديم الأدلة لإرضاء المنظمين.

ينمو تأثير الذكاء الاصطناعي بشكل كبير في قطاع الخدمات المالية بسبب الضغط الهائل للتحول الرقمي. كما قيل ، القول أسهل من الفعل لأن:

1. قم بتشغيل تطبيقات الذكاء الاصطناعي بثقة:

في بعض الحالات ، تُبنى النماذج دون وضوح أو فهرسة ؛ وغني عن القول ، أن المراقبة تنزلق بعيدًا في خضم كل شيء لتتبع دورة الحياة من البداية إلى النهاية. بينما تكافح البنوك مع التطبيقات القديمة ، أصبحت أتمتة العمليات لخلق الشفافية وإمكانية الشرح أكثر صعوبة ، وبالتالي أصبح الصندوق الأسود. لا أحد يعرف لماذا / كيف اتخذت القرارات. التطبيقات الجديدة المتشابكة مع التطبيقات القديمة لا ترى ضوء النهار أبدًا على الرغم من وجود عائد استثمار ضخم مرتبط بها بسبب الجودة والمخاطر غير المتوقعة.

يقودنا ذلك إلى النقطة الثانية - إدارة مخاطر السمعة

2. إدارة مخاطر السمعة جنبا إلى جنب مع المخاطر الشاملة

لقد طلبت #chatGPT و # بارد - من هي بادما تشوكا. # شاتجبت رفضت الإجابة حتى لو قمت بتغيير السؤال بعدة طرق. ومع ذلك ، أعطاني Bard إجابة مفصلة ، بما في ذلك ملفي الشخصي على LinkedIn ... ولكن البيانات من مواقع مختلفة حيث لا يزال ملفي الشخصي القديم موجودًا كجزء من السير الذاتية للمتحدثين. من تلك النقطة فصاعدًا ، لم أفتح بعد Bard. وبسرعة تم إطفائي ، ويعرف أيضًا باسم مخاطر السمعة. لنفترض أنه يمكنني إيقاف تشغيل روبوت محادثة بسيط عندما أدرك أن البيانات قد تكون غير متسقة. كيف لا يمكنني التأكد قبل أن أقرر شراء تطبيق مغمور بالذكاء الاصطناعي لإجراء الأعمال الهامة؟ تعتبر مخاطر السمعة عاملاً أساسياً تنساه الشركات في بعض الأحيان. إذا قمت بتحديد مخاطر السمعة ، يمكن للمرء أن يرى التأثير الهائل على العمل إذا لم يكن الشخص استباقيًا.

للإضافة إلى التعقيد ، الثالث هو ...

3. كيف يمكن للشركة أن تستجيب لتغيير لوائح الذكاء الاصطناعي؟

لتجنب مخاطر السمعة ، يجب أن يكون فريق الذكاء الاصطناعي الناجح والمسؤول على دراية بكل اللوائح التنظيمية المحلية والعالمية ، حيث يسقط مثل فيديو تيك توك مع إشعار لحظة. وقد يكلف عدم الامتثال في النهاية منظمة ملايين الدولارات كغرامات حول العمل مثل قانون الاتحاد الأوروبي للذكاء الاصطناعي المقترح. قد يصل إلى 30 مليون يورو أو 6٪ من عائدات الشركة العالمية - OUCH.

حسنًا ، ليس كل شيء يجب أن يكون ورديًا في البداية ... طالما أننا نعرف كيفية تغيير الوضع من حالة مخيفة إلى حالة وردية.

بدون مفاجأة ... دائمًا ما يكون الأشخاص والعمليات والتكنولوجيا. لذلك أولاً ، قم بإنشاء هيئة إدارة متعددة الوظائف لتثقيف وتوجيه ومراقبة المبادرات بناءً على الأهداف. ثم قم بقياس تقنية وعمليات الذكاء الاصطناعي الحالية ، وفهم الثغرات ، ثم علاجها لإثباتها في المستقبل. ثم تراجع إلى مجموعة من مهام سير عمل الحوكمة المؤتمتة بما يتماشى مع متطلبات الامتثال. أخيرًا ، قم بإعداد نظام مراقبة لتنبيه المالكين إذا كانت العتبة المقبولة تقترب. من الجانب التكنولوجي ، يتطلب الذكاء الاصطناعي المصمم جيدًا والتنفيذ الجيد والمتصل جيدًا وحدات بناء متعددة. وتأكد من أنه يحتوي على بعض الإمكانيات أو جميعها:

تكامل البيانات عبر عمليات النشر المتنوعة

· استخدام الأدوات الحالية المفتوحة والمرنة التي تلتزم بحوكمة الذكاء الاصطناعي

· تأكد من توفير وصول الخدمة الذاتية مع عناصر التحكم في الخصوصية - طريقة للتتبع

· التصميم مع وضع الأتمتة وحوكمة الذكاء الاصطناعي في الاعتبار

يمكن الاتصال وقابلة للتخصيص للعديد من أصحاب المصلحة من خلال سير عمل قابل للتخصيص

بمجرد تغيير التطبيق من مخيف إلى Rosy ... فإن السؤال التالي هو كيف تثبت ...

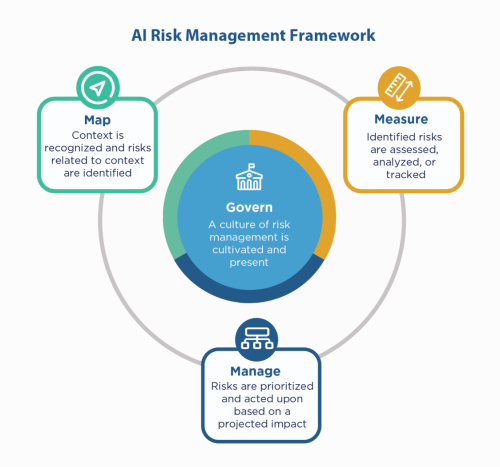

أولاً ، التراجع عن مبادئ الذكاء الاصطناعي الخاصة بالشركة - قم بالبناء عليها ، ومع ذلك ما زلت بحاجة إلى "إظهار" امتثالك ، خاصة في البيئات المنظمة مثل الخدمات المالية. نظرًا لأن الخدمات المالية يجب أن تشتكي مع NIST 800-53 ، فيمكنهم الاطلاع على إطار عمل NIST AI لإدارة المخاطر (AI RMF). اقترحت NIST عناصر التحكم في أربع عائلات - الحوكمة والخريطة والقياس والإدارة. استخدام ذلك كعامل إرشادي واختبار الإجهاد للتطبيقات لتحديد الثغرات التي يجب معالجتها ومراقبتها.

يمكن لشركة IBM التحقق من صحة النماذج الخاصة بك قبل وضعها في الإنتاج ، ويمكن مراقبتها من أجل الإنصاف والجودة والانجراف. يمكن أن توفر أيضًا وثائق تشرح سلوك النموذج والتنبؤات لتلبية متطلبات المنظمين والمراجعين. يمكن أن توفر هذه التفسيرات وضوح الرؤية وتخفيف آلام التدقيق ، وزيادة الشفافية والقدرة على تحديد المخاطر المحتملة.

استمع إلى همسات الذكاء الاصطناعي تلك بثقة!

#الخدمات المالية # استجابه # خواطر #نيستيرمف

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- بلاتوبلوكشين. Web3 Metaverse Intelligence. تضخيم المعرفة. الوصول هنا.

- سك المستقبل مع أدرين أشلي. الوصول هنا.

- المصدر https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :يكون

- $ UP

- 2021

- 2024

- 7

- a

- القدرة

- من نحن

- مقبول

- الوصول

- المساءلة

- في

- عمل

- اكشن

- أنشطة

- انضمت

- AI

- قانون AI

- حوكمة الذكاء الاصطناعي

- يعرف أيضا باسم

- ملاحظه

- الكل

- دائما

- و

- إجابة

- التطبيق

- تطبيق

- التطبيقات

- التطبيقات

- هي

- حول

- AS

- أسوشيتد

- At

- التدقيق

- المدققين

- الآلي

- أتمتة

- أتمتة

- الى الخلف

- البنوك والمصارف

- البنوك

- على أساس

- BE

- لان

- قبل

- يجري

- مؤشر

- الفوائد

- أفضل

- مليار

- اسود

- Blocks

- الجسدي

- صندوق

- يجلب

- نساعدك في بناء

- ابني

- بنيت

- الأعمال

- يشترى

- by

- CAN

- قدرات

- حقيبة

- الحالات

- النقد

- تدفق مالي

- متغير

- chatbot

- chatbots

- وضوح

- إغلاق

- الشركات

- حول الشركة

- تعقيد

- الالتزام

- متوافقة

- إدارة

- بثقة

- التواصل

- النتائج

- بشكل متواصل

- ضوابط

- التكلفة

- استطاع

- خلق

- حرج

- حالياًّ

- للتخصيص

- دورة

- البيانات

- مناقشة

- اتخاذ القرار

- القرارات

- تخفيض

- تصميم

- مفصلة

- حدد

- رقمي

- التحول الرقمي

- ماسة

- مباشرة

- توجيه

- عدة

- توثيق

- دولار

- إسقاط

- أسهل

- تثقيف

- النهائي إلى نهاية

- ضمان

- مشروع

- البيئات

- خاصة

- أساسي

- أخلاقي

- EU

- يورو

- حتى

- كل

- كل شىء

- دليل

- القائمة

- موجود

- شرح

- أضعافا مضاعفة

- فشل

- الإنصاف

- فال

- الأسر

- أخيرا

- مالي

- الخدمات المالية

- غرامة

- Finextra

- الاسم الأول

- مرن

- تدفق

- في حالة

- الإطار

- تبدأ من

- من 2021

- مستقبل

- منح

- العالمية

- الحكم

- متزايد

- يملك

- كيفية

- كيفية

- HTTPS

- ضخم

- البشر

- i

- تحديد

- التأثير

- in

- بما فيه

- القيمة الاسمية

- يشير

- الصناعات

- تأثير

- المبادرات

- الابتكار

- رؤى

- متكامل

- سلامة

- تفاعل

- استثمرت

- IT

- انها

- وظيفة

- علم

- إرث

- شروط وأحكام

- المسائل القانونية

- الحياة

- مثل

- خط

- لينكدين:

- محلي

- طويل

- بحث

- صنع

- جعل

- إدارة

- إدارة

- إدارة

- رسم خريطة

- تجارة

- المسائل

- مايو..

- قياس

- تعرف علي

- ربما

- مليون

- ملايين

- نموذج

- عارضات ازياء

- لحظة

- مراقبة

- مراقبة

- مراقبة

- الأكثر من ذلك

- متعدد

- ضروري

- حاجة

- لا داعي

- جديد

- التالي

- نيست

- أهداف

- of

- عرض

- قديم

- on

- ONE

- جاكيت

- طريقة التوسع

- منظمة

- وإلا

- الكلي

- أصحاب

- الم

- جزء

- مجتمع

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- البوينت

- ممكن

- تنبؤات

- الضغط

- ابتدائي

- مبادئ

- خصوصية

- استباقية

- عملية المعالجة

- العمليات

- الإنتــاج

- ملفي الشخصي

- دليل

- المقترح

- إثبات

- تزود

- وضع

- جودة

- سؤال

- بسرعة

- الوصول

- أدرك

- ما هو مقنن

- الصناعات المنظمة

- اللائحة

- قوانين

- الجهات التنظيمية

- سمعة

- مطلوب

- المتطلبات الأساسية

- يتطلب

- الرد

- مسؤول

- نتيجة

- إيرادات

- المخاطرة

- نماذج إدارة المخاطر

- المخاطر

- العائد على الاستثمار

- Rosy

- s

- قال

- الثاني

- القطاع

- خدمة ذاتية، إخدم نفسك بنفسك

- خدماتنا

- طقم

- ينبغي

- إظهار

- جانب

- الاشارات

- منذ

- المواقع

- حالة

- الأحجام

- So

- بعض

- شرارة

- مكبرات الصوت

- أصحاب المصلحة

- إقامة

- لا يزال

- الإستراتيجيات

- تعزيز

- إجهاد

- يكافح

- ناجح

- نظام

- الحديث

- فريق

- تكنولوجيا

- تجربه بالعربي

- أن

- •

- منهم

- تشبه

- الثالث

- عتبة

- عبر

- إلى

- أداة

- أدوات

- مسار

- تحول

- الشفافية

- هائل

- منعطف أو دور

- تحول

- في النهاية

- فهم

- الوحدات

- المقبلة

- us

- تستخدم

- التحقق من صحة

- مختلف

- فيديو

- رؤية

- طريق..

- طرق

- ابحث عن

- في حين

- من الذى

- مع

- بدون

- للعمل

- سير العمل

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت