Machine learning (ML) hjælper organisationer med at øge omsætningen, drive virksomhedsvækst og reducere omkostningerne ved at optimere kerneforretningsfunktioner på tværs af flere vertikaler, såsom efterspørgselsprognose, kreditscoring, prisfastsættelse, forudsigelse af kundeafgang, identificering af næstbedste tilbud, forudsigelse af sene forsendelser og forbedring af produktionskvaliteten. Traditionelle ML-udviklingscyklusser tager måneder og kræver knappe datavidenskab og ML-ingeniørfærdigheder. Analytikeres ideer til ML-modeller sidder ofte i lange efterslæb og afventer datavidenskabsteamets båndbredde, mens dataforskere fokuserer på mere komplekse ML-projekter, der kræver deres fulde færdighedssæt.

For at hjælpe med at bryde dette dødvande har vi introducerede Amazon SageMaker Canvas, en kodefri ML-løsning, der kan hjælpe virksomheder med at accelerere leveringen af ML-løsninger ned til timer eller dage. SageMaker Canvas gør det muligt for analytikere nemt at bruge tilgængelige data i datasøer, datavarehuse og operationelle datalagre; bygge ML-modeller; og brug dem til at lave forudsigelser interaktivt og til batch-scoring på massedatasæt – alt sammen uden at skrive en enkelt kodelinje.

I dette indlæg viser vi, hvordan SageMaker Canvas muliggør samarbejde mellem dataforskere og forretningsanalytikere, opnår hurtigere time to market og accelererer udviklingen af ML-løsninger. Analytikere får deres eget ML-arbejdsområde uden kode i SageMaker Canvas uden at skulle blive ML-ekspert. Analytikere kan derefter dele deres modeller fra Canvas med nogle få klik, som dataforskere vil kunne arbejde med i Amazon SageMaker Studio, et end-to-end ML integreret udviklingsmiljø (IDE). Ved at arbejde sammen kan forretningsanalytikere bringe deres domæneviden og resultaterne af eksperimentet med, mens dataforskere effektivt kan skabe pipelines og strømline processen.

Lad os dykke dybt i, hvordan arbejdsgangen vil se ud.

Forretningsanalytikere bygger en model og deler den derefter

For at forstå, hvordan SageMaker Canvas forenkler samarbejdet mellem forretningsanalytikere og dataforskere (eller ML-ingeniører), går vi først til processen som forretningsanalytiker. Inden du går i gang, se Annoncering af Amazon SageMaker Canvas – en visuel, ingen kode maskinindlæringskapacitet for forretningsanalytikere for instruktioner om at bygge og teste modellen med SageMaker Canvas.

Til dette indlæg bruger vi en ændret version af Datasæt til registrering af svindel med kreditkort fra Kaggle, et velkendt datasæt til et binært klassifikationsproblem. Datasættet er oprindeligt meget ubalanceret - det har meget få poster klassificeret som en negativ klasse (unormale transaktioner). Uanset målfunktionsfordelingen kan vi stadig bruge dette datasæt, fordi SageMaker Canvas håndterer denne ubalance, da den træner og tuner en model automatisk. Dette datasæt består af omkring 9 millioner celler. Du kan også downloade en reduceret version af dette datasæt. Datasættets størrelse er meget mindre, omkring 500,000 celler, fordi det er blevet tilfældigt undersamplet og derefter oversamplet med SMOTE-teknikken for at sikre, at så lidt information som muligt går tabt under denne proces. At køre et helt eksperiment med dette reducerede datasæt koster dig $0 under SageMaker Canvas Free Tier.

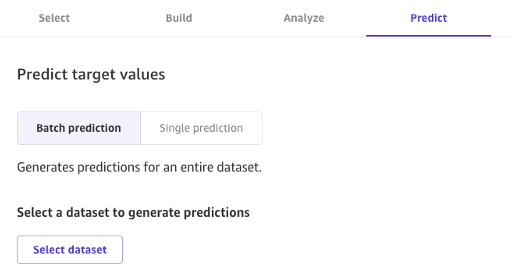

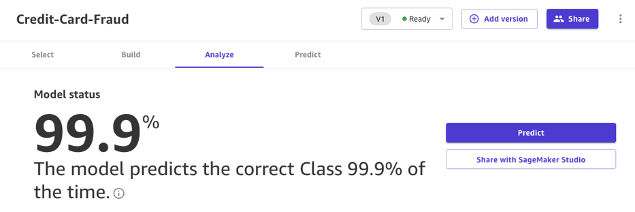

Efter at modellen er bygget, kan analytikere bruge den til at lave forudsigelser direkte i Canvas for enten individuelle anmodninger eller for et helt inputdatasæt i bulk.

Modeller bygget med Canvas Standard Build kan også nemt deles med et klik på en knap med dataforskere og ML-ingeniører, der bruger SageMaker Studio. Dette giver en dataforsker mulighed for at validere ydeevnen af den model, du har bygget, og give feedback. ML-ingeniører kan hente din model og integrere den med eksisterende arbejdsgange og produkter, der er tilgængelige for din virksomhed og dine kunder. Bemærk, at det i skrivende stund ikke er muligt at dele en model bygget med Canvas Quick Build eller en tidsserieprognosemodel.

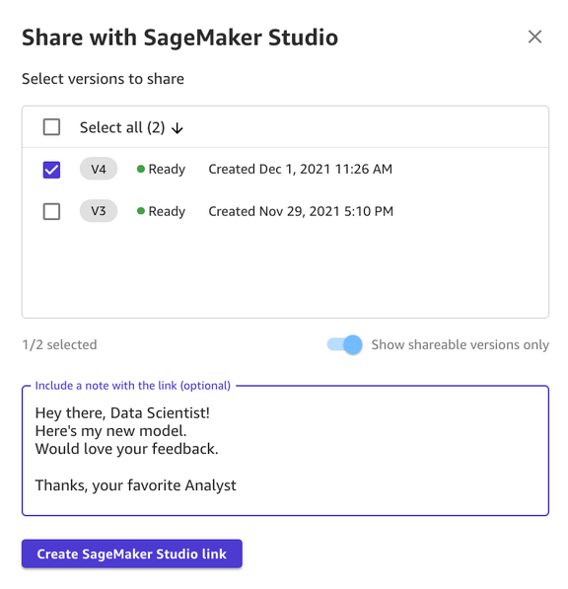

At dele en model via Canvas UI er ligetil:

- Vælg en model på siden, der viser de modeller, du har oprettet.

- Vælg Del.

- Vælg en eller flere versioner af den model, du vil dele.

- Du kan eventuelt inkludere en note, der giver mere kontekst om modellen eller den hjælp, du leder efter.

- Vælg Opret SageMaker Studio Link.

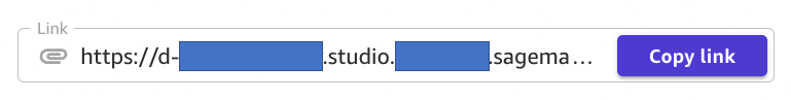

- Kopier det genererede link.

Og det er det! Du kan nu dele linket med dine kolleger via Slack, e-mail eller en hvilken som helst anden metode, du foretrækker. Dataforskeren skal være i det samme SageMaker Studio-domæne for at få adgang til din model, så sørg for, at dette er tilfældet med din organisations administrator.

Dataforskere får adgang til modeloplysningerne fra SageMaker Studio

Lad os nu spille rollen som dataforsker eller ML-ingeniør og se tingene fra deres synspunkt ved hjælp af SageMaker Studio.

Linket, der deles af analytikeren, fører os ind i SageMaker Studio, den første cloud-baserede IDE til end-to-end ML workflow.

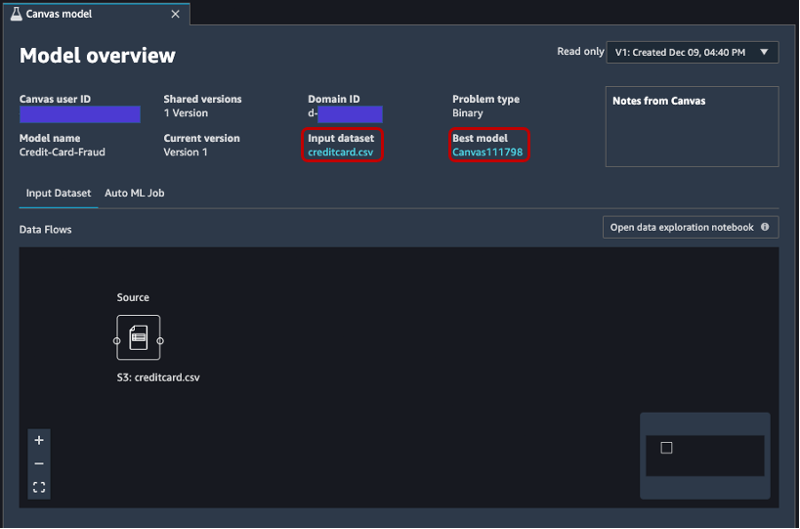

Fanen åbner automatisk, og viser en oversigt over den model, analytikeren har lavet i SageMaker Canvas. Du kan hurtigt se modellens navn, ML-problemtypen, modelversionen og hvilken bruger der har oprettet modellen (under feltet Canvas bruger-id). Du har også adgang til detaljer om inputdatasættet og den bedste model, som SageMaker var i stand til at producere. Det vil vi dykke ned i senere i indlægget.

På Indtast datasæt fanen, kan du også se datastrømmen fra kilden til inputdatasættet. I dette tilfælde bruges kun én datakilde, og ingen join-handlinger er blevet anvendt, så en enkelt kilde vises. Du kan analysere statistik og detaljer om datasættet ved at vælge Åbn notesbog til dataudforskning. Denne notesbog giver dig mulighed for at udforske de data, der var tilgængelige før træning af modellen, og den indeholder en analyse af målvariablen, et udsnit af inputdata, statistik og beskrivelser af kolonner og rækker, samt anden nyttig information for dataforskeren til at vide mere om datasættet. For at lære mere om denne rapport, se Rapport om dataudforskning.

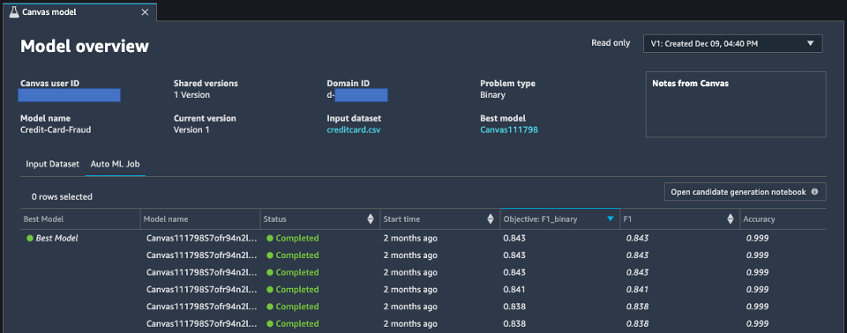

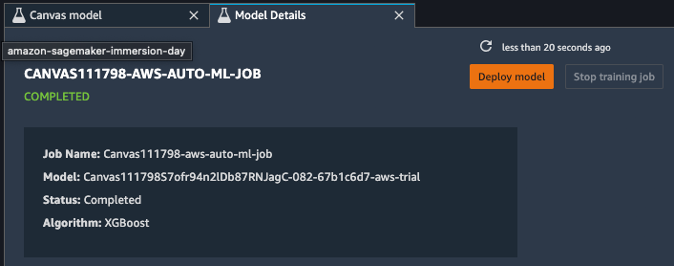

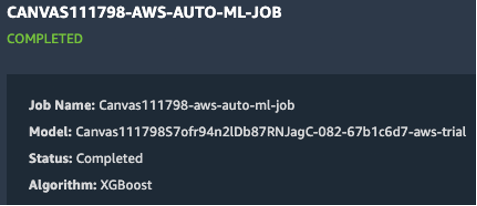

Efter at have analyseret inputdatasættet, lad os gå videre til den anden fane i modeloversigten, AutoML job. Denne fane indeholder en beskrivelse af AutoML-jobbet, da du valgte Standard Build-indstillingen i SageMaker Canvas.

AutoML-teknologien under SageMaker Canvas eliminerer de tunge løft ved at bygge ML-modeller. Den bygger, træner og tuner automatisk den bedste ML-model baseret på dine data ved at bruge en automatiseret tilgang, mens den giver dig mulighed for at bevare fuld kontrol og synlighed. Denne synlighed på de genererede kandidatmodeller såvel som de hyperparametre, der bruges under AutoML-processen, er indeholdt i kandidatgenerationsnotesbog, som er tilgængelig på denne fane.

AutoML job fanen indeholder også en liste over hver model, der er bygget som en del af AutoML-processen, sorteret efter F1 objektiv metric. For at fremhæve den bedste model ud af de lancerede uddannelsesjob, bruges et tag med en grøn cirkel i Bedste model kolonne. Du kan også nemt visualisere andre målinger, der bruges under trænings- og evalueringsfasen, såsom nøjagtighedsscore og AUC (Area Under the Curve). For at lære mere om de modeller, du kan træne under et AutoML-job og de målinger, der bruges til at evaluere den trænede models ydeevne, se Modelsupport, målinger og validering.

For at lære mere om modellen kan du nu højreklikke på den bedste model og vælge Åbn i modeldetaljer. Alternativt kan du vælge Bedste model linket øverst i Modeloversigt sektion, du besøgte første gang.

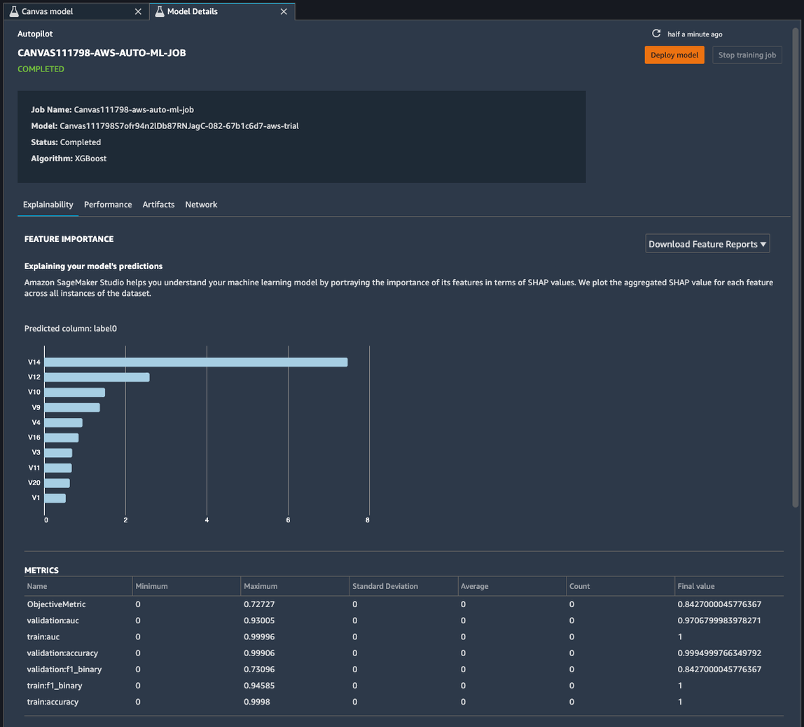

Siden med modeldetaljer indeholder et væld af nyttige oplysninger om den model, der klarede sig bedst med disse inputdata. Lad os først fokusere på oversigten øverst på siden. Det foregående skærmbillede viser, at ud af hundredvis af modeltræningsløb klarede en XGBoost-model bedst på inputdatasættet. I skrivende stund kan SageMaker Canvas træne tre typer ML-algoritmer: lineær indlærer, XGBoost og en flerlagsperceptron (MLP), hver med en bred vifte af forbehandlingspipelines og hyperparametre. For at lære mere om hver algoritme, se side med understøttede algoritmer.

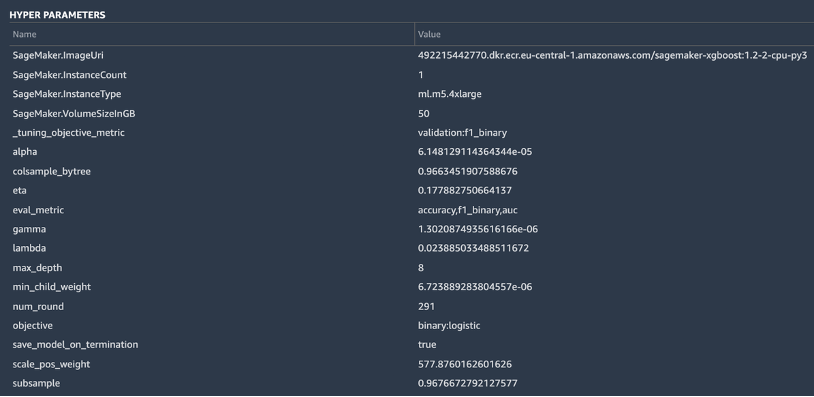

SageMaker indeholder også en forklarende funktionalitet takket være en skalerbar og effektiv implementering af KernelSHAP, baseret på konceptet om en Shapley-værdi fra området for kooperativ spilteori, der tildeler hver funktion en vigtighedsværdi for en bestemt forudsigelse. Dette giver mulighed for gennemsigtighed om, hvordan modellen nåede frem til sine forudsigelser, og det er meget nyttigt at definere egenskabernes betydning. En komplet forklaringsrapport, inklusive vigtighed af funktioner, kan downloades i PDF-, notebook- eller rådataformat. I denne rapport vises et bredere sæt metrics samt en komplet liste over hyperparametre, der bruges under AutoML-jobbet. For at lære mere om, hvordan SageMaker leverer integrerede forklaringsværktøjer til AutoML-løsninger og standard ML-algoritmer, se Brug integrerede forklaringsværktøjer og forbedre modelkvaliteten ved hjælp af Amazon SageMaker Autopilot.

Endelig viser de andre faner i denne visning oplysninger om ydeevnedetaljer (forvirringsmatrix, præcisionsgenkaldelseskurve, ROC-kurve), artefakter, der bruges til input og genereres under AutoML-jobbet, og netværksdetaljer.

På dette tidspunkt har dataforskeren to valg: implementere modellen direkte eller oprette en træningspipeline, der kan planlægges eller udløses manuelt eller automatisk. De følgende afsnit giver lidt indsigt i begge muligheder.

Implementer modellen direkte

Hvis dataforskeren er tilfreds med resultaterne opnået af AutoML-jobbet, kan de implementere modellen direkte fra Modeloplysninger side. Det er så enkelt som at vælge Implementer model ud for modelnavnet.

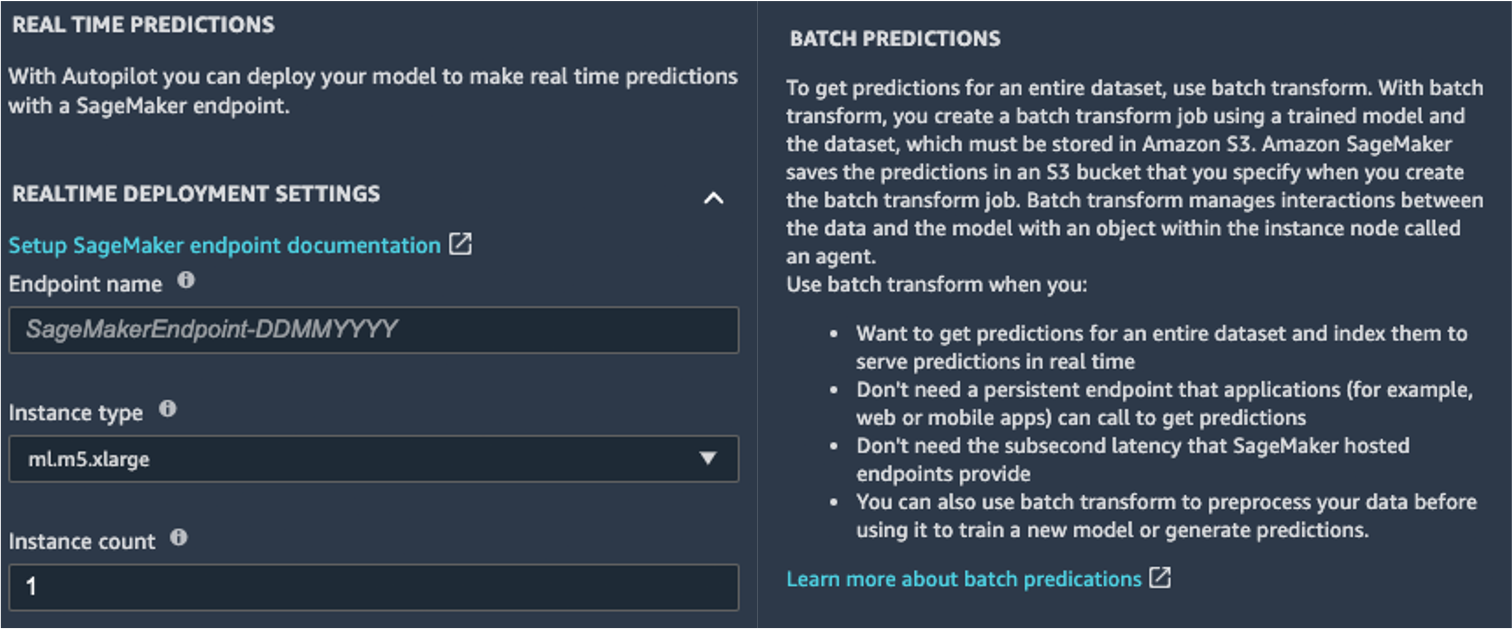

SageMaker viser dig to muligheder for implementering: et slutpunkt i realtid, drevet af Amazon SageMaker-slutpunkter, og batch-inferens, drevet af Amazon SageMaker batch transformation.

SageMaker giver også andre slutningsmåder. For at lære mere, se Implementer modeller til inferens.

For at aktivere forudsigelsestilstanden i realtid giver du blot slutpunktet et navn, en forekomsttype og et forekomstantal. Fordi denne model ikke kræver store computerressourcer, kan du bruge en CPU-baseret instans med et indledende antal på 1. Du kan lære mere om de forskellige slags instanser, der er tilgængelige og deres specifikationer på Amazon SageMaker-prisside (i On-Demand-priser sektion, vælg Realtidsslutning fanen). Hvis du ikke ved, hvilken instans du skal vælge til din implementering, kan du også bede SageMaker om at finde den bedste for dig i henhold til dine KPI'er ved at bruge SageMaker Inference Recommend. Du kan også angive yderligere valgfrie parametre med hensyn til, om du vil registrere anmodnings- og svardata til eller fra slutpunktet. Dette kan vise sig nyttigt, hvis du planlægger det overvågning af din model. Du kan også vælge, hvilket indhold du vil levere som en del af dit svar – om det kun er forudsigelsen eller forudsigelsessandsynligheden, sandsynligheden for alle klasser og måletiketterne.

For at køre et batch-scoringjob og få forudsigelser for et helt sæt input på én gang, kan du starte batchtransformationsjobbet fra AWS Management Console eller via SageMaker Python SDK. For at lære mere om batchtransformation, se Brug Batch Transform og eksempelnotesbøgerne.

Definer en træningspipeline

ML-modeller kan meget sjældent, hvis nogensinde, betragtes som statiske og uforanderlige, fordi de driver fra den baseline, de er blevet trænet på. Data fra den virkelige verden udvikler sig over tid, og der kommer flere mønstre og indsigter ud af dem, som måske eller måske ikke er fanget af den originale model trænet på historiske data. For at løse dette problem kan du oprette en træningspipeline, der automatisk genoptræner dine modeller med de seneste tilgængelige data.

Ved at definere denne pipeline er en af mulighederne for dataforskeren igen at bruge AutoML til træningspipelinen. Du kan starte et AutoML-job programmatisk ved at starte create_auto_ml_job() API'en fra AWS Boto3 SDK. Du kan kalde denne operation fra en AWS Lambda funktion inden for en AWS-trinfunktioner workflow, eller fra en LambdaStep in Amazon SageMaker Pipelines.

Alternativt kan dataforskeren bruge den viden, artefakter og hyperparametre, der er opnået fra AutoML-jobbet, til at definere en komplet træningspipeline. Du har brug for følgende ressourcer:

- Den algoritme, der fungerede bedst til brugssagen – Du har allerede fået disse oplysninger fra resuméet af den Canvas-genererede model. Til denne brugssag er det den indbyggede XGBoost-algoritme. For instruktioner om, hvordan du bruger SageMaker Python SDK til at træne XGBoost-algoritmen med SageMaker, se Brug XGBoost med SageMaker Python SDK.

- Hyperparametrene udledt af AutoML-jobbet – Disse er tilgængelige i Forklarlighed afsnit. Du kan bruge dem som input, når du definerer træningsjobbet med SageMaker Python SDK.

- Funktionsingeniørkoden, der er angivet i artefaktersektionen – Du kan bruge denne kode både til at forbehandle dataene før træning (for eksempel via Amazon SageMaker Processing), eller før inferens (for eksempel som en del af en SageMaker-inferenspipeline).

Du kan kombinere disse ressourcer som en del af en SageMaker-pipeline. Vi udelader implementeringsdetaljerne i dette indlæg - følg med for mere indhold, der kommer om dette emne.

Konklusion

SageMaker Canvas lader dig bruge ML til at generere forudsigelser uden at skulle skrive nogen kode. En forretningsanalytiker kan selvstændigt begynde at bruge det med lokale datasæt, såvel som data, der allerede er lagret på Amazon Simple Storage Service (Amazon S3), Amazon rødforskydning, eller Snefnug. Med blot et par klik kan de forberede og tilslutte deres datasæt, analysere estimeret nøjagtighed, verificere, hvilke kolonner der har indflydelse, træne den bedst ydende model og generere nye individuelle forudsigelser eller batch-forudsigelser, alt sammen uden behov for at trække en ekspert dataforsker ind. Derefter kan de efter behov dele modellen med et team af dataforskere eller MLOps-ingeniører, som importerer modellerne til SageMaker Studio og arbejder sammen med analytikeren for at levere en produktionsløsning.

Forretningsanalytikere kan uafhængigt få indsigt fra deres data uden at have en grad i ML og uden at skulle skrive en enkelt linje kode. Dataforskere kan nu få ekstra tid til at arbejde på mere udfordrende projekter, der bedre kan bruge deres omfattende viden om AI og ML.

Vi tror på, at dette nye samarbejde åbner døren til at bygge mange flere kraftfulde ML-løsninger til din virksomhed. Du har nu analytikere, der producerer værdifuld forretningsindsigt, mens du lader dataforskere og ML-ingeniører hjælpe med at forfine, justere og udvide efter behov.

Yderligere ressourcer

- For at lære mere om, hvordan SageMaker yderligere kan hjælpe forretningsanalytikere, se Amazon SageMaker til forretningsanalytikere.

- For at finde ud af mere om, hvordan SageMaker tillader datavidenskabsfolk at udvikle, træne og implementere deres ML-modeller, tjek Amazon SageMaker for dataforskere.

- For mere information om, hvordan SageMaker kan hjælpe MLOps-ingeniører med at strømline ML-livscyklussen ved hjælp af MLOps, se Amazon SageMaker til MLOps-ingeniører.

Om forfatterne

Davide Gallitelli er en Specialist Solutions Architect for AI/ML i EMEA-regionen. Han er baseret i Bruxelles og arbejder tæt sammen med kunder i hele Benelux. Han har været udvikler, siden han var meget ung, og begyndte at kode i en alder af 7. Han begyndte at lære AI/ML på universitetet, og er blevet forelsket i det siden da.

Davide Gallitelli er en Specialist Solutions Architect for AI/ML i EMEA-regionen. Han er baseret i Bruxelles og arbejder tæt sammen med kunder i hele Benelux. Han har været udvikler, siden han var meget ung, og begyndte at kode i en alder af 7. Han begyndte at lære AI/ML på universitetet, og er blevet forelsket i det siden da.

Mark Roy er en Principal Machine Learning Architect for AWS, der hjælper kunder med at designe og bygge AI/ML-løsninger. Marks arbejde dækker en bred vifte af ML use cases med en primær interesse i computervision, deep learning og skalering af ML på tværs af virksomheden. Han har hjulpet virksomheder i mange brancher, herunder forsikring, finansielle tjenesteydelser, medier og underholdning, sundhedspleje, forsyningsselskaber og fremstilling. Mark har seks AWS-certificeringer, inklusive ML Specialty Certification. Før han kom til AWS, var Mark arkitekt, udvikler og teknologileder i over 25 år, heraf 19 år inden for finansielle tjenesteydelser.

Mark Roy er en Principal Machine Learning Architect for AWS, der hjælper kunder med at designe og bygge AI/ML-løsninger. Marks arbejde dækker en bred vifte af ML use cases med en primær interesse i computervision, deep learning og skalering af ML på tværs af virksomheden. Han har hjulpet virksomheder i mange brancher, herunder forsikring, finansielle tjenesteydelser, medier og underholdning, sundhedspleje, forsyningsselskaber og fremstilling. Mark har seks AWS-certificeringer, inklusive ML Specialty Certification. Før han kom til AWS, var Mark arkitekt, udvikler og teknologileder i over 25 år, heraf 19 år inden for finansielle tjenesteydelser.

- Coinsmart. Europas bedste Bitcoin og Crypto Exchange.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. FRI ADGANG.

- CryptoHawk. Altcoin radar. Gratis prøveversion.

- Kilde: https://aws.amazon.com/blogs/machine-learning/build-share-deploy-how-business-analysts-and-data-scientists-achieve-faster-time-to-market-using-no- code-ml-and-amazon-sagemaker-canvas/

- "

- 000

- 100

- 7

- 9

- Om

- fremskynde

- accelererende

- adgang

- Ifølge

- tværs

- Yderligere

- admin

- AI

- algoritme

- algoritmer

- Alle

- tillade

- allerede

- Amazon

- analyse

- analytiker

- api

- tilgang

- OMRÅDE

- omkring

- Automatiseret

- til rådighed

- AWS

- Baseline

- bliver

- BEDSTE

- grænse

- Bruxelles

- bygge

- Bygning

- bygger

- indbygget

- virksomhed

- ringe

- tilfælde

- Certificering

- valg

- Circle

- klassificering

- kode

- samarbejde

- Kolonne

- kommer

- Virksomheder

- selskab

- komplekse

- Compute

- Konceptet

- forvirring

- indeholder

- indhold

- kontrol

- kooperativ

- Core

- Omkostninger

- kredit

- skøger

- Kunder

- data

- datalogi

- dataforsker

- levering

- Efterspørgsel

- indsætte

- implementering

- Design

- Detektion

- udvikle

- Udvikler

- Udvikling

- forskellige

- fordeling

- Er ikke

- domæne

- ned

- nemt

- effektiv

- Endpoint

- ingeniør

- Engineering

- Ingeniører

- Enterprise

- Underholdning

- Miljø

- anslået

- eksempel

- eksperiment

- udforskning

- udvide

- hurtigere

- Feature

- tilbagemeldinger

- finansielle

- finansielle tjenesteydelser

- Fornavn

- flow

- Fokus

- efter

- format

- bedrageri

- Gratis

- fuld

- funktion

- funktionalitet

- spil

- generere

- få

- Give

- Grøn

- Vækst

- have

- sundhedspleje

- hjælpe

- hjælper

- Fremhæv

- stærkt

- historisk

- besidder

- Hvordan

- How To

- HTTPS

- Hundreder

- betydning

- Forbedre

- omfatter

- Herunder

- Forøg

- individuel

- industrier

- oplysninger

- indsigt

- forsikring

- integrere

- integreret

- interesse

- IT

- Job

- Karriere

- deltage

- viden

- Etiketter

- seneste

- lancere

- LÆR

- læring

- Line (linje)

- LINK

- Liste

- lidt

- lokale

- Lang

- leder

- kærlighed

- maskine

- machine learning

- ledelse

- manuelt

- Produktion

- markere

- Marked

- Matrix

- Medier

- Metrics

- million

- ML

- model

- modeller

- måned

- bevæge sig

- netværk

- notesbog

- Tilbud

- åbner

- Produktion

- Option

- Indstillinger

- ordrer

- organisation

- organisationer

- Andet

- ydeevne

- forestillinger

- fase

- planlægning

- Leg

- Synspunkt

- mulig

- vigtigste

- forudsigelse

- Forudsigelser

- prissætning

- primære

- Main

- Problem

- behandle

- producere

- produktion

- Produkter

- projekter

- give

- giver

- trækker

- kvalitet

- hurtigt

- rækkevidde

- Raw

- realtid

- reducere

- indberette

- kræver

- Ressourcer

- svar

- Resultater

- indtægter

- Kør

- kører

- skalerbar

- skalering

- Videnskab

- Videnskabsmand

- forskere

- SDK

- valgt

- Series

- Tjenester

- sæt

- Del

- delt

- Simpelt

- SIX

- Størrelse

- færdigheder

- slæk

- So

- Løsninger

- SOLVE

- starte

- påbegyndt

- statistik

- opbevaring

- forhandler

- Studio

- support

- mål

- hold

- Teknologier

- Test

- The Source

- hele

- tid

- sammen

- værktøjer

- top

- traditionelle

- Kurser

- tog

- Transaktioner

- Transform

- Gennemsigtighed

- ui

- forstå

- universitet

- us

- brug

- værdi

- Specifikation

- synlighed

- vision

- Hvad

- hvorvidt

- WHO

- inden for

- uden

- Arbejde

- arbejdede

- arbejder

- virker

- skrivning

- år