Amazonas grundfjeld leverer en bred vifte af modeller fra Amazon og tredjepartsudbydere, herunder Anthropic, AI21, Meta, Cohere og Stability AI, og dækker en bred vifte af use cases, herunder tekst- og billedgenerering, indlejring, chat, agenter på højt niveau med ræsonnement og orkestrering med mere. Vidensbaser for Amazon Bedrock giver dig mulighed for at bygge effektive og tilpassede Retrieval Augmented Generation (RAG) applikationer oven på AWS og tredjeparts vektorbutikker ved hjælp af både AWS og tredjeparts modeller. Knowledge Bases for Amazon Bedrock automatiserer synkronisering af dine data med dit vektorlager, herunder differentiering af dataene, når de opdateres, dokumentindlæsning og chunking, samt semantisk indlejring. Det giver dig mulighed for problemfrit at tilpasse dine RAG-prompter og genfindingsstrategier – vi leverer kildetilskrivningen, og vi håndterer hukommelseshåndtering automatisk. Knowledge Bases er fuldstændig serverløs, så du behøver ikke at administrere nogen infrastruktur, og når du bruger Knowledge Bases, bliver du kun opkrævet for de modeller, vektordatabaser og lagerplads, du bruger.

RAG er en populær teknik, der kombinerer brugen af private data med store sprogmodeller (LLM'er). RAG starter med et indledende trin til at hente relevante dokumenter fra et datalager (oftest et vektorindeks) baseret på brugerens forespørgsel. Den anvender derefter en sprogmodel til at generere et svar ved at overveje både de hentede dokumenter og den oprindelige forespørgsel.

I dette indlæg demonstrerer vi, hvordan man opbygger en RAG-arbejdsgang ved hjælp af vidensbaser til Amazon Bedrock til en brugssag til lægemiddelopdagelse.

Oversigt over vidensbaser for Amazon Bedrock

Vidensbaser til Amazon Bedrock understøtter en bred vifte af almindelige filtyper, herunder .txt, .docx, .pdf, .csv og mere. For at muliggøre effektiv hentning fra private data er en almindelig praksis først at opdele disse dokumenter i håndterbare bidder. Knowledge Bases har implementeret en standard chunking-strategi, der fungerer godt i de fleste tilfælde, så du kan komme hurtigere i gang. Hvis du ønsker mere kontrol, giver Knowledge Bases dig mulighed for at styre chunking-strategien gennem et sæt forudkonfigurerede muligheder. Du kan kontrollere den maksimale tokenstørrelse og mængden af overlap, der skal oprettes på tværs af bidder for at give sammenhængende kontekst til indlejringen. Knowledge Bases for Amazon Bedrock styrer processen med at synkronisere data fra din Amazon Simple Storage Service (Amazon S3) bucket, opdeler det i mindre bidder, genererer vektorindlejringer og gemmer indlejringerne i et vektorindeks. Denne proces kommer med intelligent diffing, gennemløb og fejlstyring.

Ved kørsel bruges en indlejringsmodel til at konvertere brugerens forespørgsel til en vektor. Vektorindekset forespørges derefter for at finde dokumenter, der ligner brugerens forespørgsel, ved at sammenligne dokumentvektorer med brugerforespørgselsvektoren. I det sidste trin tilføjes semantisk lignende dokumenter hentet fra vektorindekset som kontekst for den oprindelige brugerforespørgsel. Når der genereres et svar til brugeren, bliver de semantisk lignende dokumenter bedt om i tekstmodellen sammen med kildetilskrivning for sporbarhed.

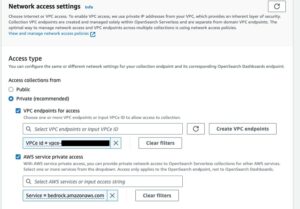

Vidensbaser for Amazon Bedrock understøtter flere vektordatabaser, herunder Amazon OpenSearch Serverløs, Amazon Aurora, Pinecone og Redis Enterprise Cloud. Retrieve og RetrieveAndGenerate API'erne giver dine applikationer mulighed for direkte at forespørge indekset ved hjælp af en samlet og standardsyntaks uden at skulle lære separate API'er for hver anden vektordatabase, hvilket reducerer behovet for at skrive tilpassede indeksforespørgsler mod dit vektorlager. Retrieve API'et tager den indkommende forespørgsel, konverterer den til en indlejringsvektor og forespørger backend-lageret ved hjælp af de algoritmer, der er konfigureret på vektordatabaseniveauet; RetrieveAndGenerate API bruger en brugerkonfigureret LLM leveret af Amazon Bedrock og genererer det endelige svar i naturligt sprog. Den oprindelige sporbarhedssupport informerer den anmodende applikation om de kilder, der bruges til at besvare et spørgsmål. Til virksomhedsimplementeringer understøtter Knowledge Bases AWS Key Management Service (AWS KMS) kryptering, AWS CloudTrail integration og meget mere.

I de følgende afsnit demonstrerer vi, hvordan man opbygger en RAG-arbejdsgang ved hjælp af Knowledge Bases for Amazon Bedrock, understøttet af OpenSearch Serverless vektormotoren, for at analysere et ustruktureret klinisk forsøgsdatasæt til brug for lægemiddelopdagelse. Disse data er informationsrige, men kan være meget heterogene. Korrekt håndtering af specialiseret terminologi og begreber i forskellige formater er afgørende for at opdage indsigt og sikre analytisk integritet. Med Knowledge Bases for Amazon Bedrock kan du få adgang til detaljerede oplysninger gennem enkle, naturlige forespørgsler.

Byg en vidensbase for Amazon Bedrock

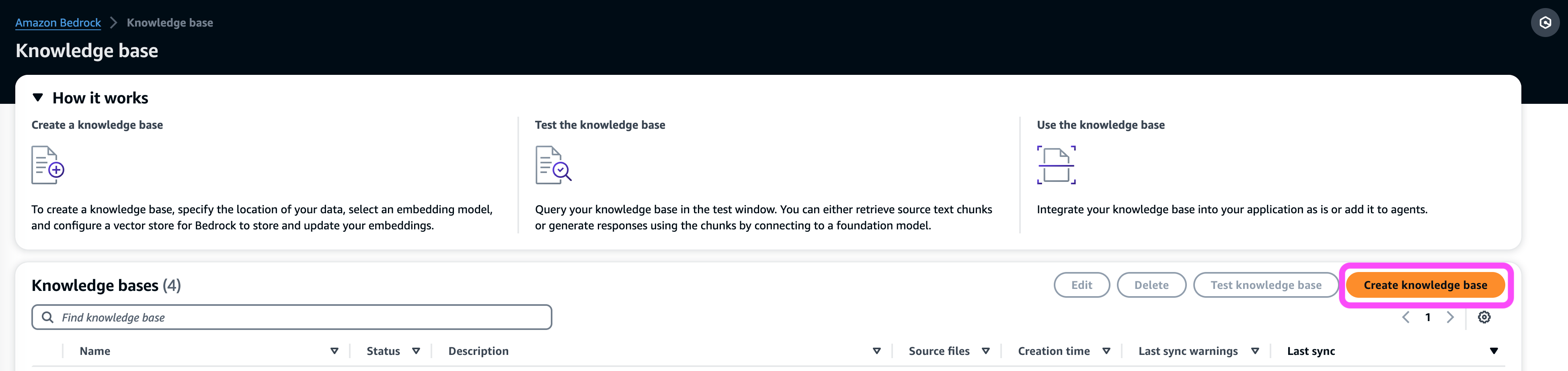

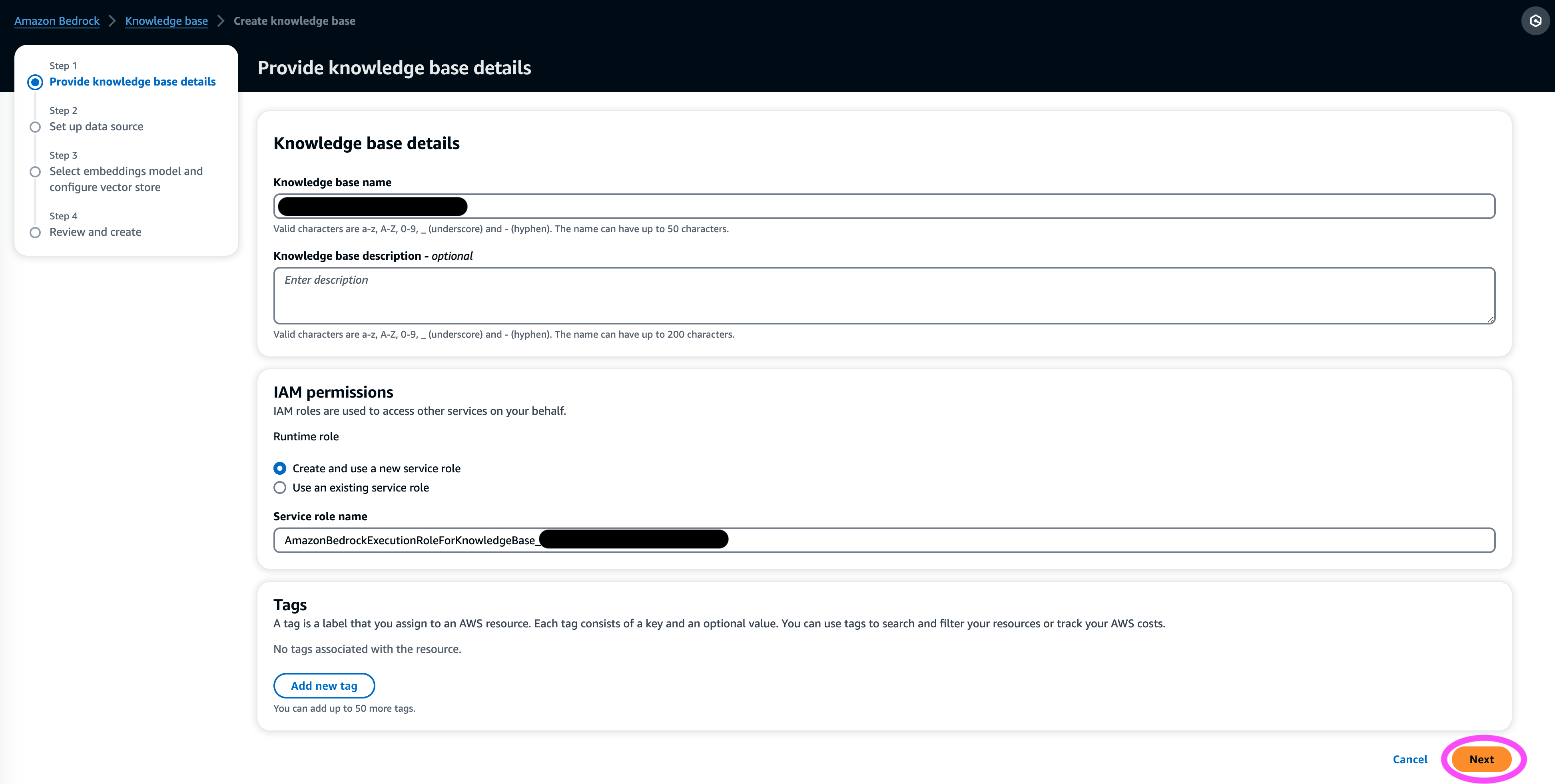

I dette afsnit demonstrerer vi processen med at skabe en videnbase for Amazon Bedrock via konsollen. Udfør følgende trin:

- På Amazon Bedrock-konsollen, under Orchestration i navigationsruden skal du vælge Vidensdatabase.

- Vælg Skab vidensbase.

- I Vidensbase detaljer skal du indtaste et navn og en valgfri beskrivelse.

- I IAM-tilladelser sektion, vælg Opret og brug en ny servicerolle.

- Til Tjenestenavn rolle, indtast et navn til din rolle, som skal starte med

AmazonBedrockExecutionRoleForKnowledgeBase_. - Vælg Næste.

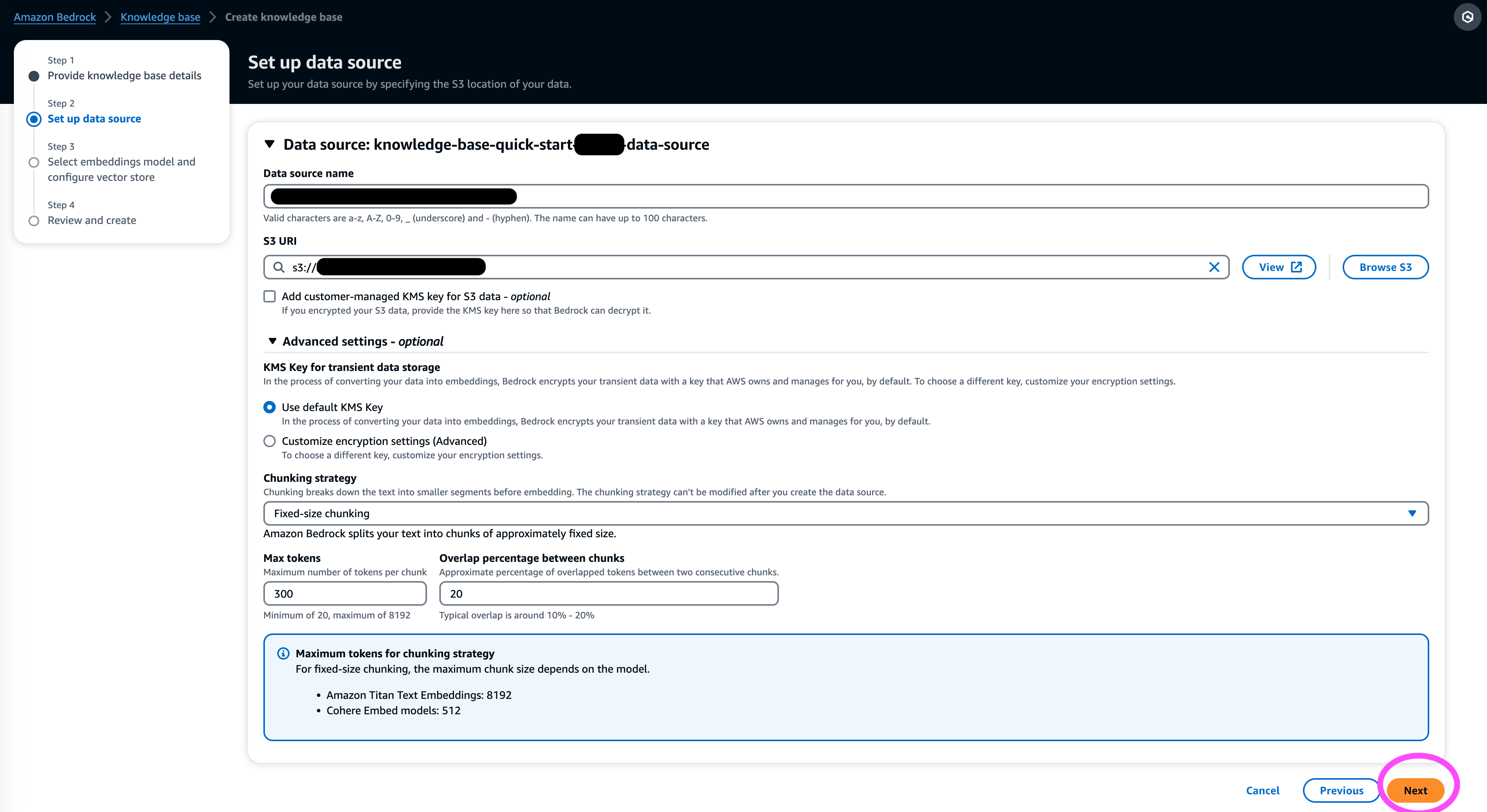

- I Datakilde skal du indtaste et navn til din datakilde og den S3 URI, hvor datasættet sidder. Knowledge Bases understøtter følgende filformater:

- Almindelig tekst (.txt)

- Markdown (.md)

- HyperText Markup Language (.html)

- Microsoft Word-dokument (.doc/.docx)

- Kommaseparerede værdier (.csv)

- Microsoft Excel-regneark (.xls/.xlsx)

- Portable Document Format (.pdf)

- Under Yderligere indstillinger¸ vælg din foretrukne chunking-strategi (til dette indlæg vælger vi Fast størrelse chunking) og angiv klumpstørrelsen og overlejringen i procent. Alternativt kan du bruge standardindstillingerne.

- Vælg Næste.

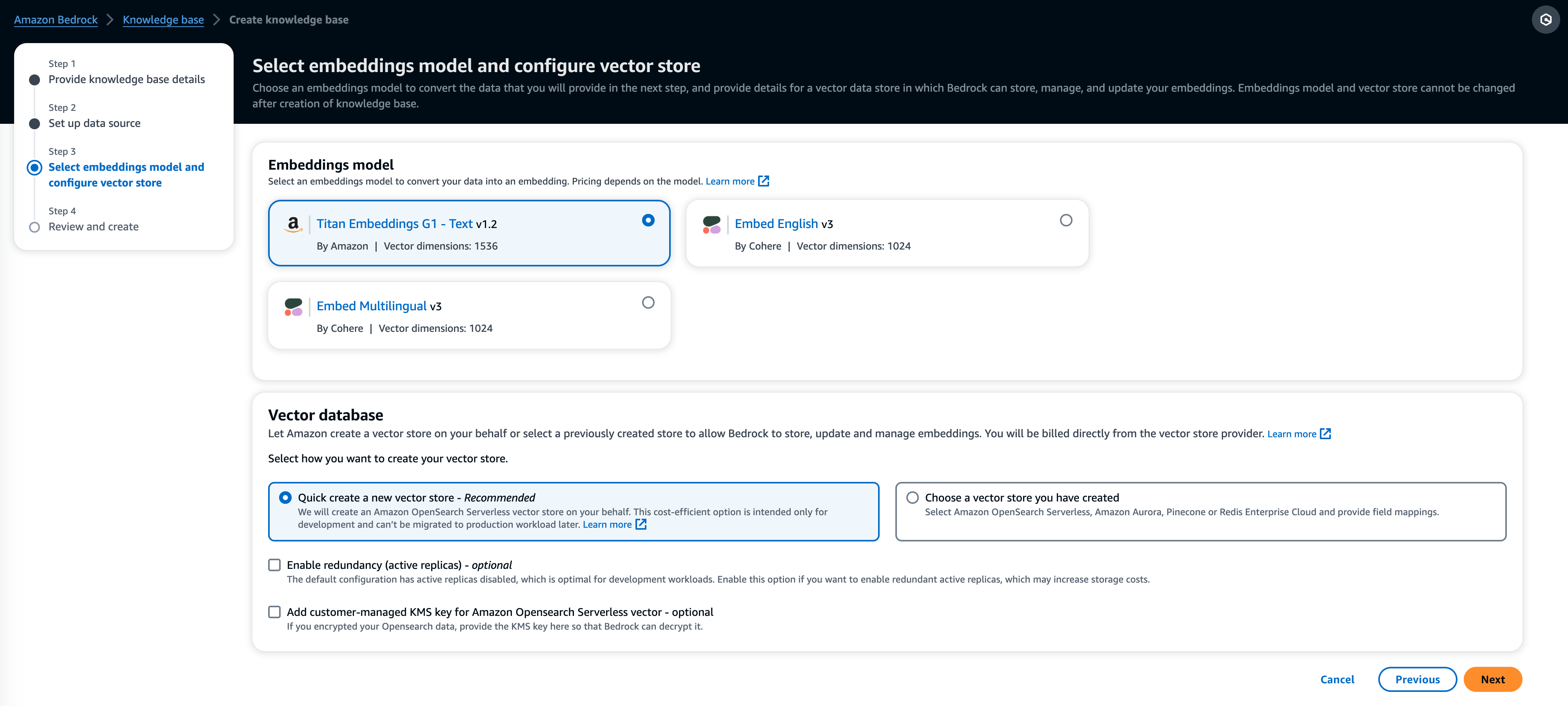

- I Indstøbningsmodel sektion, skal du vælge Titan Embeddings-modellen fra Amazon Bedrock.

- I Vektor database sektion, vælg Opret hurtigt en ny vektorbutik, som styrer processen med at oprette en vektorbutik.

- Vælg Næste.

- Gennemgå indstillingerne og vælg Skab vidensbase.

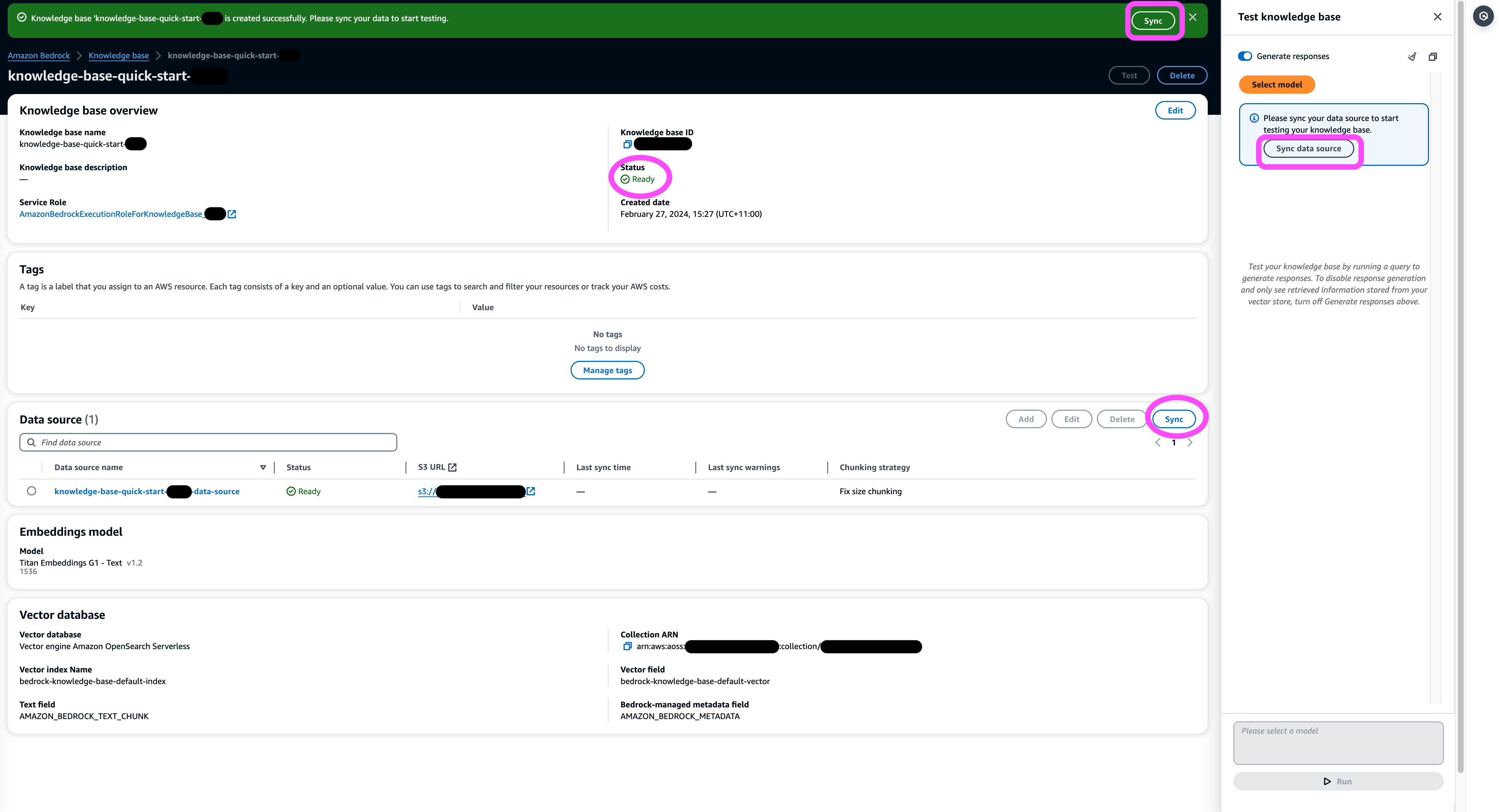

- Vent på, at oprettelsen af videnbasen er fuldført, og bekræft, at dens status er Ready.

- I Datakilde sektion, eller på banneret øverst på siden eller pop op-vinduet i testvinduet, skal du vælge Synkroniser at udløse processen med at indlæse data fra S3-bøtten, opdele dem i bidder af den størrelse, du har angivet, generere vektorindlejringer ved hjælp af den valgte tekstindlejringsmodel og gemme dem i vektorlageret, der administreres af Knowledge Bases for Amazon Bedrock.

Synkroniseringsfunktionen understøtter indlæsning, opdatering og sletning af dokumenter fra vektorindekset baseret på ændringer i dokumenter i Amazon S3. Du kan også bruge StartIngestionJob API til at udløse synkroniseringen via AWS SDK.

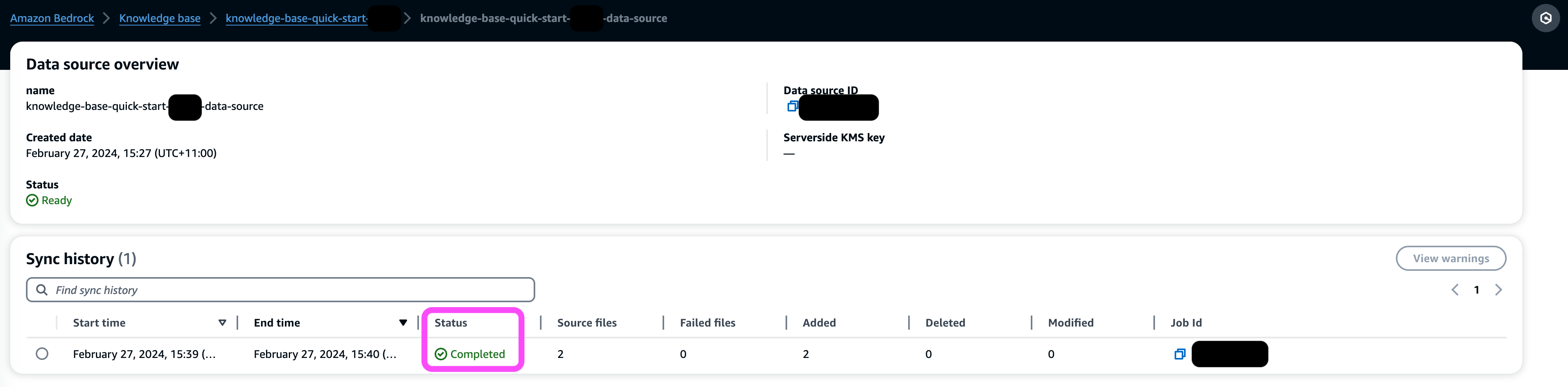

Når synkroniseringen er fuldført, viser synkroniseringshistorikken status Afsluttet.

Spørg vidensbasen

I dette afsnit demonstrerer vi, hvordan du får adgang til detaljerede oplysninger i videnbasen gennem ligetil og naturlige forespørgsler. Vi bruger et ustruktureret syntetisk datasæt bestående af PDF-filer, sidetallet på hver spænder fra 10-100 sider, som simulerer en klinisk forsøgsplan for en foreslået ny medicin, herunder statistiske analysemetoder og deltagersamtykkeformularer. Vi bruger vidensbaserne til Amazon Bedrock retrieve_and_generate , retrieve API'er med Amazon Bedrock LangChain integration.

Før du kan skrive scripts, der bruger Amazon Bedrock API, skal du installere den relevante version af AWS SDK i dit miljø. For Python-scripts vil dette være AWS SDK til Python (Boto3):

Aktiver desuden adgang til Amazon Titan Embeddings-modellen og Anthropic Claude v2 eller v1. For mere information, se Modeladgang.

Generer spørgsmål ved hjælp af Amazon Bedrock

Vi kan bruge Anthropic Claude 2.1 til Amazon Bedrock til at foreslå en liste over spørgsmål, der skal stilles til det kliniske forsøgsdatasæt:

Brug Amazon Bedrock RetrieveAndGenerate API

For en fuldt administreret RAG-oplevelse kan du bruge de native Knowledge Bases for Amazon Bedrock RetrieveAndGenerate API for at få svarene direkte:

Den citerede informationskilde kan fås via følgende kode (med noget af outputtet redigeret for kortheds skyld):

Ved at videregive sessions-id'et for RetrieveAndGenerate API, kan du bevare samtalekonteksten og stille opfølgende spørgsmål. For eksempel, uden konteksten, hvis du beder om flere detaljer fra det forrige svar, vil det muligvis ikke være i stand til at svare korrekt:

Men ved at videregive sessions-id'et er RAG-pipelinen i stand til at identificere den tilsvarende kontekst og returnere relevante svar:

Følgende tabel viser de hentede svar på alle de tilsvarende spørgsmål.

| Spørgsmål | Svar |

| Hvad er formålet med undersøgelsen? Sørg for, at du forstår målene for forskningen, og hvad undersøgelsesprocedurerne vil indebære. | Formålet med undersøgelsen er at teste, om lithium er effektivt til at forhindre gentagen selvmordsvold hos patienter med depression eller bipolar lidelse. |

| Hvad er risici og potentielle fordele? Skemaet skal forklare alle forudsigelige risici, bivirkninger eller gener, du måtte opleve ved at deltage. | De mulige risici eller gener omfatter: interviewspørgsmålene, der forårsager ubehag, bivirkninger fra lithiummedicinen såsom kvalme, løs afføring, tørst, vandladningsændringer, rysten, hovedpine, svedtendens, træthed, nedsat koncentrationsevne, hududslæt, skjoldbruskkirtelforandringer, forværring af acne /psoriasis, lithium-toksicitet og risici, hvis medicinen pludselig stoppes. De potentielle fordele er, at testene kan føre til ny information til at hjælpe deltageren, og lithium kan hjælpe med at forhindre gentagen selvmordsvold for personer med depression eller bipolar lidelse. |

| Hvad vil deltagelse indebære? Få detaljer om, hvilke tests, medicin, livsstilsændringer eller procedurer du skal igennem, hvor lang tid det vil tage, og hvor længe undersøgelsen vil vare. | Deltagelse vil indebære udfyldelse af et interview og spørgeskemaer, der dækker tænkning, adfærd, mental sundhedsbehandling, medicin, alkohol- og stofbrug, hjem og social støtte og forståelse af forskningsundersøgelsen. Dette tager omkring to timer og kan gøres i flere sessioner, personligt og via telefon. Hvis man er berettiget til det fulde studie, vil der være omkring 20 studiebesøg over et år. Dette vil involvere at tage undersøgelsesmedicin, få kontrolleret vitale tegn, udfylde spørgeskemaer, gennemgå bivirkninger og fortsætte normal medicinsk og mental sundhedspleje. |

| Er der nogen omkostninger eller betalinger? Spørg, om du vil være ansvarlig for eventuelle omkostninger i forbindelse med undersøgelsen eller få betalt for at deltage. | Ja, der er omkostninger og betalinger diskuteret i søgeresultaterne. Du vil ikke blive opkrævet for nogen behandlinger eller procedurer, der er en del af undersøgelsen. Du skal dog stadig betale sædvanlig VA egenbetaling for pleje og medicin, der ikke er relateret til undersøgelsen. Du vil ikke blive betalt for deltagelse, men undersøgelsen vil godtgøre udgifter i forbindelse med deltagelse såsom transport, parkering osv. Refusionsbeløb og proces er angivet. |

| Hvordan vil mit privatliv blive beskyttet? Skemaet skal forklare, hvordan dine personlige helbredsoplysninger vil blive holdt fortrolige før, under og efter forsøget. | Dit privatliv vil blive beskyttet ved at gennemføre interviews i privat regi, opbevare skriftlige noter i låste filer og kontorer, gemme elektronisk information i krypterede og adgangskodebeskyttede filer og indhente et fortrolighedscertifikat fra Department of Health and Human Services for at forhindre videregivelse af oplysninger, der identificerer dig . Oplysninger, der identificerer dig, kan blive delt med læger, der er ansvarlige for din pleje eller for revisioner og evalueringer af offentlige myndigheder, men samtaler og papirer om undersøgelsen vil ikke identificere dig. |

Forespørg ved hjælp af Amazon Bedrock Retrieve API

For at tilpasse din RAG-arbejdsgang kan du bruge Retrieve API til at hente de relevante bidder baseret på din forespørgsel og videregive den til enhver LLM leveret af Amazon Bedrock. For at bruge Retrieve API skal du definere det som følger:

Hent den tilsvarende kontekst (med noget af outputtet redigeret for kortheds skyld):

Udtræk konteksten for promptskabelonen:

Importer Python-modulerne, og opsæt skabelonen til svarprompt for spørgsmål i konteksten, og generer derefter det endelige svar:

Forespørgsel ved hjælp af Amazon Bedrock LangChain-integration

For at skabe en ende-til-ende tilpasset Q&A-applikation giver Knowledge Bases for Amazon Bedrock integration med LangChain. For at konfigurere LangChain retriever skal du angive videnbase-id'et og angive antallet af resultater, der skal returneres fra forespørgslen:

Opsæt nu LangChain RetrievalQA og generer svar fra videnbasen:

Dette vil generere tilsvarende svar svarende til dem, der er anført i den tidligere tabel.

Ryd op

Sørg for at slette følgende ressourcer for at undgå at pådrage sig yderligere omkostninger:

Konklusion

Amazon Bedrock leverer et bredt sæt af dybt integrerede tjenester til at drive RAG-applikationer i alle skalaer, hvilket gør det nemt at komme i gang med at analysere dine virksomhedsdata. Vidensbaser for Amazon Bedrock integreres med Amazon Bedrock-fundamentmodeller for at bygge skalerbare dokumentindlejringspipelines og dokumenthentningstjenester til at drive en bred vifte af interne og kundevendte applikationer. Vi er spændte på fremtiden, og din feedback vil spille en afgørende rolle i at vejlede udviklingen af dette produkt. For at lære mere om mulighederne i Amazon Bedrock og vidensbaser, se Vidensbase for Amazon Bedrock.

Om forfatterne

Mark Roy er en Principal Machine Learning Architect for AWS, der hjælper kunder med at designe og bygge AI/ML-løsninger. Marks arbejde dækker en bred vifte af ML use cases med en primær interesse i computervision, deep learning og skalering af ML på tværs af virksomheden. Han har hjulpet virksomheder i mange brancher, herunder forsikring, finansielle tjenesteydelser, medier og underholdning, sundhedspleje, forsyningsselskaber og fremstilling. Mark har seks AWS-certificeringer, inklusive ML Specialty Certification. Før han kom til AWS, var Mark arkitekt, udvikler og teknologileder i over 25 år, heraf 19 år inden for finansielle tjenesteydelser.

Mark Roy er en Principal Machine Learning Architect for AWS, der hjælper kunder med at designe og bygge AI/ML-løsninger. Marks arbejde dækker en bred vifte af ML use cases med en primær interesse i computervision, deep learning og skalering af ML på tværs af virksomheden. Han har hjulpet virksomheder i mange brancher, herunder forsikring, finansielle tjenesteydelser, medier og underholdning, sundhedspleje, forsyningsselskaber og fremstilling. Mark har seks AWS-certificeringer, inklusive ML Specialty Certification. Før han kom til AWS, var Mark arkitekt, udvikler og teknologileder i over 25 år, heraf 19 år inden for finansielle tjenesteydelser.

Mani Khanuja er en Tech Lead – Generative AI Specialists, forfatter til bogen – Applied Machine Learning and High Performance Computing på AWS, og medlem af bestyrelsen for Women in Manufacturing Education Foundation Board. Hun leder maskinlæringsprojekter (ML) inden for forskellige domæner såsom computervision, naturlig sprogbehandling og generativ AI. Hun hjælper kunder med at bygge, træne og implementere store maskinlæringsmodeller i stor skala. Hun taler i interne og eksterne konferencer såsom re:Invent, Women in Manufacturing West, YouTube-webinarer og GHC 23. I sin fritid kan hun godt lide at gå lange løbeture langs stranden.

Mani Khanuja er en Tech Lead – Generative AI Specialists, forfatter til bogen – Applied Machine Learning and High Performance Computing på AWS, og medlem af bestyrelsen for Women in Manufacturing Education Foundation Board. Hun leder maskinlæringsprojekter (ML) inden for forskellige domæner såsom computervision, naturlig sprogbehandling og generativ AI. Hun hjælper kunder med at bygge, træne og implementere store maskinlæringsmodeller i stor skala. Hun taler i interne og eksterne konferencer såsom re:Invent, Women in Manufacturing West, YouTube-webinarer og GHC 23. I sin fritid kan hun godt lide at gå lange løbeture langs stranden.

Dr. Baichuan Sun, der i øjeblikket tjener som Sr. AI/ML Solution Architect hos AWS, fokuserer på generativ AI og anvender sin viden inden for datavidenskab og maskinlæring til at levere praktiske, cloud-baserede forretningsløsninger. Med erfaring i ledelsesrådgivning og AI-løsningsarkitektur adresserer han en række komplekse udfordringer, herunder robotteknologi, computervision, tidsserieprognoser og forudsigelig vedligeholdelse, blandt andre. Hans arbejde er baseret på en solid baggrund inden for projektledelse, software R&D og akademiske aktiviteter. Uden for arbejdet nyder Dr. Sun balancen mellem at rejse og tilbringe tid med familie og venner.

Dr. Baichuan Sun, der i øjeblikket tjener som Sr. AI/ML Solution Architect hos AWS, fokuserer på generativ AI og anvender sin viden inden for datavidenskab og maskinlæring til at levere praktiske, cloud-baserede forretningsløsninger. Med erfaring i ledelsesrådgivning og AI-løsningsarkitektur adresserer han en række komplekse udfordringer, herunder robotteknologi, computervision, tidsserieprognoser og forudsigelig vedligeholdelse, blandt andre. Hans arbejde er baseret på en solid baggrund inden for projektledelse, software R&D og akademiske aktiviteter. Uden for arbejdet nyder Dr. Sun balancen mellem at rejse og tilbringe tid med familie og venner.

Derrick Choo er en Senior Solutions Architect hos AWS med fokus på at accelerere kundernes rejse til skyen og transformere deres forretning gennem adoption af cloud-baserede løsninger. Hans ekspertise er inden for fuld stack applikations- og maskinlæringsudvikling. Han hjælper kunder med at designe og bygge end-to-end-løsninger, der dækker frontend-brugergrænseflader, IoT-applikationer, API- og dataintegrationer og maskinlæringsmodeller. I sin fritid nyder han at bruge tid sammen med sin familie og eksperimentere med fotografering og video.

Derrick Choo er en Senior Solutions Architect hos AWS med fokus på at accelerere kundernes rejse til skyen og transformere deres forretning gennem adoption af cloud-baserede løsninger. Hans ekspertise er inden for fuld stack applikations- og maskinlæringsudvikling. Han hjælper kunder med at designe og bygge end-to-end-løsninger, der dækker frontend-brugergrænseflader, IoT-applikationer, API- og dataintegrationer og maskinlæringsmodeller. I sin fritid nyder han at bruge tid sammen med sin familie og eksperimentere med fotografering og video.

Frank Winkler er Senior Solutions Architect og Generative AI Specialist hos AWS baseret i Singapore, med fokus på Machine Learning og Generative AI. Han arbejder med globale digitale indfødte virksomheder for at udvikle skalerbare, sikre og omkostningseffektive produkter og tjenester på AWS. I sin fritid bruger han tid sammen med sin søn og datter og rejser for at nyde bølgerne på tværs af ASEAN.

Frank Winkler er Senior Solutions Architect og Generative AI Specialist hos AWS baseret i Singapore, med fokus på Machine Learning og Generative AI. Han arbejder med globale digitale indfødte virksomheder for at udvikle skalerbare, sikre og omkostningseffektive produkter og tjenester på AWS. I sin fritid bruger han tid sammen med sin søn og datter og rejser for at nyde bølgerne på tværs af ASEAN.

Nihir Chadderwala er Sr. AI/ML Solutions Architect i Global Healthcare and Life Sciences-teamet. Hans ekspertise er i at bygge Big Data og AI-drevne løsninger på kundeproblemer, især inden for biomedicin, biovidenskab og sundhedsområdet. Han er også begejstret for krydsfeltet mellem kvanteinformationsvidenskab og kunstig intelligens og nyder at lære og bidrage til dette rum. I sin fritid nyder han at spille tennis, rejse og lære om kosmologi.

Nihir Chadderwala er Sr. AI/ML Solutions Architect i Global Healthcare and Life Sciences-teamet. Hans ekspertise er i at bygge Big Data og AI-drevne løsninger på kundeproblemer, især inden for biomedicin, biovidenskab og sundhedsområdet. Han er også begejstret for krydsfeltet mellem kvanteinformationsvidenskab og kunstig intelligens og nyder at lære og bidrage til dette rum. I sin fritid nyder han at spille tennis, rejse og lære om kosmologi.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/use-rag-for-drug-discovery-with-knowledge-bases-for-amazon-bedrock/

- :har

- :er

- :ikke

- :hvor

- $OP

- 1

- 10

- 100

- 11

- 120

- 121

- 13

- 14

- 150

- 160

- 19

- 20

- 23

- 25

- 29

- 35 %

- 40

- 41

- 5 spørgsmål

- 7

- 8

- 9

- a

- I stand

- Om

- akademisk

- accelererende

- adgang

- tværs

- tilføjet

- Yderligere

- adresser

- Justeret

- Vedtagelse

- Efter

- mod

- agenturer

- midler

- forude

- AI

- AI-drevne

- AI / ML

- Procenter

- algoritmer

- Alle

- tillade

- tillader

- sammen

- også

- Amazon

- Amazon Web Services

- blandt

- beløb

- beløb

- an

- analyse

- Analytisk

- analysere

- analysere

- ,

- besvare

- besvarelse

- svar

- Antropisk

- enhver

- api

- API'er

- Anvendelse

- applikationer

- anvendt

- gælder

- passende

- arkitektur

- ER

- AS

- Asean

- spørg

- vurdere

- tildelt

- Assistant

- forbundet

- At

- revisioner

- augmented

- forfatter

- automater

- automatisk

- undgå

- væk

- AWS

- Backed

- Bagende

- baggrund

- Balance

- banner

- bund

- baseret

- BE

- Beach

- været

- før

- adfærd

- fordele

- Big

- Big data

- biomedicinsk

- fødsel

- blod

- board

- bestyrelse

- bog

- både

- bred

- bygge

- Bygning

- virksomhed

- men

- by

- CAN

- kapaciteter

- hvilken

- tilfælde

- tilfælde

- forårsager

- certifikat

- Certificering

- certificeringer

- kæder

- udfordringer

- Ændringer

- opladet

- afgifter

- chatte

- afkrydset

- Vælg

- citeret

- Klinisk

- Cloud

- kode

- SAMMENHÆNGENDE

- kombinerer

- kommer

- Fælles

- almindeligt

- Virksomheder

- selskab

- sammenlignet

- sammenligne

- fuldføre

- fuldstændig

- færdiggøre

- komplekse

- computer

- Computer Vision

- computing

- koncentration

- begreber

- kortfattet

- gennemført

- udførelse

- konferencer

- fortroligt

- fortrolighed

- konfigureret

- Bekræfte

- samtykke

- Overvejer

- Bestående

- Konsol

- rådgivning

- indhold

- sammenhæng

- sammenhænge

- fortsæt

- fortsættende

- bidrager

- kontrol

- Samtale

- konvertere

- korrekt

- Tilsvarende

- Kosmologi

- omkostningseffektiv

- Omkostninger

- kunne

- dækker

- Dækker

- skabe

- oprettet

- Oprettelse af

- skabelse

- CSP

- For øjeblikket

- skik

- kunde

- Kunder

- tilpasse

- tilpassede

- data

- datalogi

- Database

- databaser

- datter

- Dage

- er faldet

- dyb

- dyb læring

- dybt

- Standard

- definere

- demo

- demonstrere

- Afdeling

- indsætte

- depression

- beskrivelse

- Design

- detaljeret

- detaljer

- opdage

- Udvikler

- Udvikling

- forskellige

- digital

- direkte

- direktører

- Offentliggørelse

- opdagelse

- drøftet

- sygdom

- do

- Læger

- dokumentet

- dokumenter

- domæne

- Domæner

- Don

- færdig

- Dont

- doser

- dr

- medicin

- i løbet af

- hver

- tidligere

- Uddannelse

- effekt

- Effektiv

- effekter

- virkningsfuldhed

- enten

- Uddybe

- elektronisk

- berettiget

- andet

- indlejring

- beskæftiger

- muliggøre

- krypteret

- kryptering

- ende

- ende til ende

- Engine (Motor)

- nyde

- sikre

- Indtast

- Enterprise

- Underholdning

- Miljø

- især

- væsentlig

- etc.

- evaluere

- evalueringer

- eksempel

- Excel

- ophidset

- udgifter

- erfaring

- eksperimentere

- ekspertise

- Forklar

- ekstern

- Faktisk

- Manglende

- familie

- hurtigere

- træthed

- tilbagemeldinger

- File (Felt)

- Filer

- endelige

- finansielle

- finansielle tjenesteydelser

- Finde

- Fornavn

- fokuserede

- fokuserer

- efterfulgt

- efter

- følger

- Til

- overskuelig

- formular

- format

- formularer

- Foundation

- Gratis

- venner

- fra

- frontend

- fuld

- Fuld stak

- fuldt ud

- funktion

- yderligere

- fremtiden

- generere

- genererer

- generere

- generation

- generative

- Generativ AI

- få

- Global

- global digital

- Go

- Mål

- Goes

- Regering

- regeringsorganer

- jordet

- garanteret

- vejledende

- håndtere

- Håndtering

- Have

- have

- he

- hovedpine

- Helse

- Health Care

- sundhedsinformation

- sundhedspleje

- hjælpe

- hjulpet

- hjælpe

- hjælper

- hende

- Høj

- højt niveau

- hans

- historie

- besidder

- Home

- HOURS

- Hvordan

- How To

- Men

- HTML

- http

- HTTPS

- menneskelig

- ID

- identificerer

- identificere

- if

- billede

- implementeringer

- implementeret

- importere

- in

- omfatter

- Herunder

- Indgående

- indeks

- industrier

- oplysninger

- oplyser

- Infrastruktur

- initial

- indgang

- indsigt

- installere

- forsikring

- integreret

- Integrerer

- integration

- integrationer

- integritet

- Intelligent

- interaktion

- interesse

- grænseflader

- interne

- vejkryds

- Interview

- interview spørgsmål

- Interviews

- ind

- involvere

- tingenes internet

- IT

- ITS

- sammenføjning

- rejse

- jpg

- lige

- holde

- holdt

- Nøgle

- Kend

- Kendskab til

- viden

- Sprog

- stor

- Efternavn

- føre

- leder

- Leads

- LÆR

- læring

- Lets

- Niveau

- niveauer

- Livet

- Life Sciences

- livsstil

- ligesom

- synes godt om

- Liste

- Børsnoterede

- LLM

- lastning

- placering

- låst

- Lang

- maskine

- machine learning

- vedligeholdelse

- lave

- Making

- administrere

- håndterbar

- lykkedes

- ledelse

- administrerer

- Produktion

- mange

- markere

- Mark's

- maksimal

- Kan..

- me

- Medier

- medicinsk

- Medicinsk forskning

- medicin

- medicin

- medicin

- medlem

- Hukommelse

- mentale

- Mental sundhed

- Meta

- metoder

- måske

- ML

- model

- modeller

- Moduler

- overvåges

- månedligt

- mere

- mest

- meget

- flere

- skal

- my

- navn

- indfødte

- Natural

- Natural Language Processing

- Navigation

- Behov

- Ny

- ingen

- Ingen

- normal

- Noter

- nummer

- numre

- opnå

- opnået

- opnå

- of

- kontorer

- on

- ONE

- dem

- kun

- Indstillinger

- or

- orkestrering

- original

- Andet

- Andre

- udfald

- output

- uden for

- i løbet af

- overlapning

- side

- sider

- betalt

- brød

- papirer

- parkering

- del

- deltager

- deltagere

- deltager

- deltagelse

- passerer

- Passing

- Adgangskode

- patienter

- Betal

- betalinger

- Mennesker

- procentdel

- ydeevne

- periode

- person,

- personale

- telefon

- fotografering

- stykker

- pipeline

- fly

- plato

- Platon Data Intelligence

- PlatoData

- Leg

- spiller

- Populær

- mulig

- Indlæg

- potentiale

- magt

- Praktisk

- praksis

- foretrækkes

- Graviditet

- forhindre

- forebyggelse

- tidligere

- primære

- Main

- Forud

- Beskyttelse af personlige oplysninger

- private

- problemer

- procedurer

- behandle

- forarbejdning

- Produkt

- Produkter

- Progress

- projekt

- projektledelse

- projekter

- prompter

- passende

- foreslå

- foreslog

- beskyttet

- give

- forudsat

- udbydere

- giver

- formål

- Python

- Spørgsmål og svar

- Quantum

- kvanteinformation

- forespørgsler

- query

- spørgsmål

- Spørgsmål

- F & U

- klud

- rækkevidde

- spænder

- udslæt

- RE

- modtage

- reducere

- henvise

- region

- relaterede

- relevant

- gentaget

- anmoder

- forskning

- Ressourcer

- svar

- ansvarlige

- resultere

- Resultater

- hentning

- afkast

- gennemgå

- Rich

- Risiko

- risici

- robotteknik

- roller

- løber

- runtime

- siger

- skalerbar

- Scale

- skalaer

- skalering

- Videnskab

- VIDENSKABER

- score

- scripts

- SDK

- problemfrit

- Søg

- Sektion

- sektioner

- sikker

- Vælg

- valgt

- selvstyret

- semantiske

- senior

- adskille

- Series

- Serverless

- tjeneste

- Tjenester

- servering

- Session

- sessioner

- sæt

- indstilling

- indstillinger

- delt

- hun

- bør

- Shows

- side

- underskrive

- Skilte

- lignende

- Simpelt

- Singapore

- sidder

- SIX

- Størrelse

- hud

- mindre

- So

- Social

- Software

- solid

- løsninger

- Løsninger

- nogle

- dens

- Kilde

- Kilder

- Space

- span

- Taler

- specialist

- specialister

- specialiserede

- Specialty

- specifikke

- specifikt

- specificeret

- udgifterne

- tilbringer

- delt

- splits

- regneark

- Stabilitet

- stable

- standard

- starte

- påbegyndt

- Starter

- starter

- statistiske

- statistik

- Status

- Trin

- Steps

- Stadig

- stoppet

- standsning

- opbevaring

- butik

- forhandler

- lagring

- ligetil

- Strategi

- Studere

- sådan

- selvmord

- Sol

- support

- Understøtter

- sikker

- synkronisere.

- synkronisering

- syntaks

- syntetisk

- systemet

- bord

- Tag

- taget

- tager

- tager

- Talks

- hold

- tech

- teknik

- Teknologier

- skabelon

- tennis

- terminologi

- prøve

- tests

- tekst

- at

- Fremtiden

- The Source

- deres

- Them

- selv

- derefter

- Der.

- Disse

- de

- Tænker

- tredjepart

- denne

- dem

- Gennem

- kapacitet

- tid

- Tidsserier

- titan

- til

- sammen

- token

- top

- top 5

- Sporbarhed

- Tog

- omdanne

- transport

- Traveling

- rejser

- behandling

- behandlinger

- retssag

- udløse

- prøv

- to

- typen

- typer

- under

- forstå

- forståelse

- forenet

- ustruktureret

- opdateret

- opdatering

- brug

- brug tilfælde

- anvendte

- Bruger

- bruger

- ved brug af

- sædvanlig

- sædvanligvis

- forsyningsselskaber

- v1

- Værdier

- forskellige

- langt

- udgave

- via

- Vold

- vision

- Besøg

- afgørende

- ønsker

- var

- bølger

- we

- web

- webservices

- Webinarer

- uger

- GODT

- Vest

- Hvad

- Hvad er

- hvornår

- hvorvidt

- som

- WHO

- bred

- Bred rækkevidde

- vilje

- vindue

- med

- uden

- Dame

- ord

- Arbejde

- workflow

- arbejder

- virker

- ville

- skriver

- skriftlig

- år

- år

- Du

- Din

- youtube

- zephyrnet