I en stadig mere datacentreret verden skal virksomheder fokusere på at indsamle både værdifuld fysisk information og generere den information, som de har brug for, men som de ikke let kan fange. Dataadgang, regulering og overholdelse er en stigende kilde til friktion for innovation inden for analyse og kunstig intelligens (AI).

For stærkt regulerede sektorer såsom finansielle tjenesteydelser, sundhedspleje, biovidenskab, bilindustrien, robotteknologi og fremstilling er problemet endnu større. Det forårsager barrierer for systemdesign, datadeling (intern og ekstern), indtægtsgenerering, analyse og maskinlæring (ML).

Syntetiske data er et værktøj, der løser mange dataudfordringer, især AI og analyseproblemer som beskyttelse af privatlivets fred, overholdelse af lovgivning, tilgængelighed, dataknaphed og skævhed. Dette inkluderer også datadeling og time to data (og derfor time to market).

Syntetiske data genereres algoritmisk. Det afspejler statistiske egenskaber og mønstre fra kildedataene. Men vigtigst af alt indeholder den ingen følsomme, private eller personlige datapunkter.

Du stiller spørgsmål til de syntetiske data og får de samme svar, som du ville få ud fra de rigtige data.

I vores tidligere indlæg, vi demonstrerede, hvordan man bruger modstridende netværk som Generative Adversarial Networks (GANS) til at generere datasæt i tabelform for at forbedre uddannelsen i kreditsvindelmodeller.

For at forretningsinteressenter kan anvende syntetiske data til deres ML- og analyseprojekter, er det bydende nødvendigt ikke kun at sikre sig, at de genererede syntetiske data passer til formålet og de forventede downstream-applikationer, men også at de er i stand til at måle og demonstrere kvaliteten af de genererede data.

Med stigende juridiske og etiske forpligtelser til at bevare privatlivets fred er en af syntetiske datas styrker evnen til at fjerne følsomme og originale oplysninger under syntesen. Ud over kvalitet har vi derfor brug for målinger til at evaluere risikoen for eventuelle private informationslækager og vurdere, at genereringsprocessen ikke er at "memorere" eller kopiere nogen af de originale data.

For at opnå alt dette kan vi kortlægge kvaliteten af syntetiske data i dimensioner, som hjælper brugerne, interessenterne og os til bedre at forstå de genererede data.

De tre dimensioner af syntetisk datakvalitetsevaluering

De genererede syntetiske data måles mod tre nøgledimensioner:

- Fidelity

- Utility

- Privatliv

Dette er nogle af spørgsmålene om alle genererede syntetiske data, som bør besvares af en kvalitetsrapport for syntetiske data:

- Hvor ens er disse syntetiske data sammenlignet med det originale træningssæt?

- Hvor nyttige er disse syntetiske data til vores downstream-applikationer?

- Er der lækket nogen information fra de originale træningsdata til de syntetiske data?

- Er nogen data, der anses for følsomme i den virkelige verden (fra andre datasæt, der ikke bruges til træning af modellen), utilsigtet blevet syntetiseret af vores model?

De målinger, der oversætter hver enkelt af disse dimensioner for slutbrugerne, er noget fleksible. Når alt kommer til alt, kan de data, der skal genereres, variere med hensyn til distributioner, størrelse og adfærd. De skal også være lette at forstå og fortolke.

I sidste ende skal metrikkerne være fuldstændigt datadrevne og ikke kræve nogen forudgående viden eller domænespecifik information. Men hvis brugeren ønsker at anvende specifikke regler og begrænsninger, der gælder for et specifikt forretningsdomæne, bør de være i stand til at definere dem under synteseprocessen for at sikre, at den domænespecifikke troskab er opfyldt.

Vi ser på hver af disse metrics mere detaljeret i de følgende afsnit.

Målinger til at forstå troskab

I ethvert datavidenskabsprojekt skal vi forstå, om en bestemt prøvepopulation er relevant for det problem, vi løser. Tilsvarende skal vi for processen med at vurdere relevansen af de genererede syntetiske data vurdere det mht. troskab sammenlignet med originalen.

Visuelle repræsentationer af disse målinger gør dem lettere at forstå. Vi kunne illustrere, om kardinaliteten og forholdet mellem kategorier blev respekteret, korrelationerne mellem de forskellige variable blev holdt, og så videre.

Visualisering af data hjælper ikke kun med at evaluere kvaliteten af de syntetiske data, men passer også ind som et af de indledende trin i datavidenskabens livscyklus for en bedre forståelse af dataene.

Lad os dykke ned i nogle troskabsmetrics mere detaljeret.

Udforskende statistiske sammenligninger

Inden for de eksplorative statistiske sammenligninger udforskes funktionerne i de originale og syntetiske datasæt ved hjælp af nøglestatistiske mål, såsom middelværdi, median, standardafvigelse, distinkte værdier, manglende værdier, minima, maksima, kvartilintervaller for kontinuerlige funktioner og antallet af poster pr. kategori, manglende værdier pr. kategori og de fleste forekommende tegn for kategoriske attributter.

Denne sammenligning bør udføres mellem det originale hold-out-datasæt og de syntetiske data. Denne evaluering ville afsløre, om de sammenlignede datasæt er statistisk ens. Hvis de ikke er det, vil vi have en forståelse af, hvilke funktioner og mål der er forskellige. Du bør overveje at genoptræne og regenerere de syntetiske data med forskellige parametre, hvis der er en væsentlig forskel.

Denne test fungerer som en indledende screening for at sikre, at de syntetiske data har rimelig troskab til det originale datasæt og derfor med fordel kan gennemgå mere strenge tests.

Histogram lighedsscore

Histogrammets lighedsscore måler hver funktions marginale fordelinger af de syntetiske og originale datasæt.

Lighedsscoren er afgrænset mellem nul og én, med en score på én, der indikerer, at de syntetiske datafordelinger perfekt overlapper fordelingen af de originale data.

En score tæt på én ville give brugerne tillid til, at holdout-datasættet og det syntetiske datasæt er statistisk ens.

Gensidig informationsscore

Den gensidige informationsscore måler den gensidige afhængighed af to træk, numerisk eller kategorisk, og angiver, hvor meget information der kan opnås fra et træk ved at observere et andet.

Gensidig information kan måle ikke-lineære relationer, hvilket giver en mere omfattende forståelse af den syntetiske datakvalitet, da den lader os forstå omfanget af variablens relationsbevarelse.

En score på én indikerer, at den gensidige afhængighed mellem funktioner er blevet perfekt fanget i de syntetiske data.

Korrelationsscore

Korrelationsscoren måler, hvor godt korrelationerne i det originale datasæt er blevet fanget i de syntetiske data.

Korrelationer mellem to eller flere kolonner er ekstremt vigtige for ML-applikationer, som hjælper med at afdække relationer mellem funktioner og målvariablen og hjælper med at skabe en veltrænet model.

Korrelationsscoren er afgrænset mellem nul og én, med en score på én, der indikerer, at korrelationerne er blevet perfekt matchet.

I modsætning til strukturerede tabeldata, som vi ofte støder på i dataproblemer, har nogle typer strukturerede data en særlig adfærd, hvor tidligere observationer har en sandsynlighed for at påvirke den følgende observation. Disse er kendt som tidsserier eller sekventielle data - for eksempel et datasæt med timemålinger af rumtemperatur.

Denne adfærd betyder, at der er et krav om at definere visse målinger, der specifikt kan måle kvaliteten af disse tidsseriedatasæt

Autokorrelation og partiel autokorrelationsscore

Selvom den ligner korrelation, viser autokorrelation forholdet mellem en tidsserie ved dens nutidsværdi, da den relaterer til dens tidligere værdier. Fjernelse af virkningerne af de tidligere tidsforsinkelser giver delvis autokorrelation. Derfor måler autokorrelationsscoren, hvor godt de syntetiske data har fanget de signifikante autokorrelationer, eller delvise korrelationer, fra det originale datasæt.

Metrik til at forstå nytte

Nu har vi måske statistisk indset, at de syntetiske data ligner det originale datasæt. Derudover skal vi også vurdere, hvor godt det syntetiserede datasæt klarer sig på almindelige datavidenskabelige problemer, når det trænes på flere ML-algoritmer.

Brug af følgende nytte målinger, sigter vi efter at opbygge tillid til, at vi faktisk kan opnå ydeevne på downstream-applikationer med hensyn til, hvordan de originale data har fungeret.

Forudsigelsesscore

Måling af ydeevnen af syntetiske data sammenlignet med de originale reelle data kan udføres gennem ML-modeller. Nedstrømsmodelscoren fanger kvaliteten af de syntetiske data ved at sammenligne ydeevnen af ML-modeller trænet på både de syntetiske og originale datasæt og valideret på tilbageholdte testdata fra det originale datasæt. Dette giver en Træn Synthetic Test Real (TSTR) score og en Train Real Test Real (TRTR) score hhv.

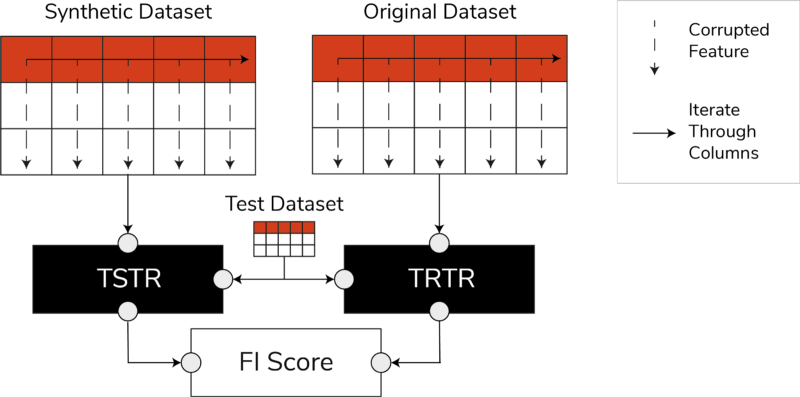

TSTR, TRTR-score og Feature Importance Score (Billede af forfatter)

Scoren inkorporerer en bred vifte af de mest betroede ML-algoritmer til enten regression eller klassifikationsopgaver. Brug af flere klassifikatorer og regressorer sikrer, at scoren er mere generaliserbar på tværs af de fleste algoritmer, så de syntetiske data kan blive betragtet som nyttige i fremtiden.

I sidste ende, hvis TSTR-scoren og TRTR-scoren er sammenlignelige, indikerer dette, at de syntetiske data har den kvalitet, der skal bruges til at træne effektive ML-modeller til applikationer i den virkelige verden.

Funktionens betydningsscore

I høj grad relateret til forudsigelsesscoren, udvider funktionen vigtighed (FI) den ved at tilføje fortolkning til TSTR- og TRTR-scorerne.

F1-scoren sammenligner ændringerne og stabiliteten af funktionens vigtighedsrækkefølge opnået med forudsigelsesscoren. Et syntetisk datasæt anses for at være til stor nytte, hvis det giver samme rækkefølge af egenskabsvigtighed som de originale rigtige data.

QScore

For at sikre, at en model, der er trænet på vores nygenererede data, vil give de samme svar på de samme spørgsmål som en model, der trænes ved hjælp af de originale data, bruger vi Qscore. Dette måler nedstrøms ydeevnen af de syntetiske data ved at køre mange tilfældige aggregeringsbaserede forespørgsler på både de syntetiske og originale (og holdout) datasæt.

Ideen her er, at begge disse forespørgsler skal returnere lignende resultater.

En høj QScore sikrer, at downstream-applikationer, der anvender forespørgsels- og aggregeringsoperationer, kan give næsten samme værdi som det originale datasæt.

Metrics til at forstå privatliv

Med Beskyttelse af personlige oplysninger regler, der allerede er på plads, er det en etisk forpligtelse og et lovkrav at sikre, at følsomme oplysninger er beskyttet.

Før disse syntetiske data kan deles frit og bruges til downstream-applikationer, skal vi overveje de privatlivsmålinger, der kan hjælpe interessenten med at forstå, hvor de genererede syntetiske data står i forhold til de originale data med hensyn til omfanget af lækket information. Desuden skal vi træffe kritiske beslutninger om, hvordan de syntetiske data kan deles og bruges.

Præcis kampscore

En direkte og intuitiv evaluering af privatlivets fred er at lede efter kopier af de rigtige data blandt de syntetiske optegnelser. Den nøjagtige matchscore tæller antallet af rigtige rekorder, der kan findes blandt det syntetiske sæt.

Scoren skal være nul, hvilket angiver, at ingen reel information er til stede, som den er i de syntetiske data. Denne metric fungerer som en screeningsmekanisme, før vi evaluerer yderligere privatlivsmetrics.

Naboers privatlivsscore

Desuden måler naboernes privatlivsscore forholdet mellem syntetiske optegnelser, der kan være for tæt i lighed med de rigtige. Dette betyder, at selv om de ikke er direkte kopier, er de potentielle punkter for privatlivslækage og en kilde til nyttig information til slutningsangreb.

Scoren beregnes ved at udføre en højdimensionel søgning efter de nærmeste naboer på de syntetiske data overlappet med de originale data.

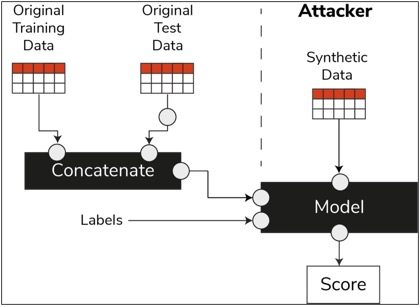

Medlemsslutningsscore

I datavidenskabens livscyklus, når en model er blevet trænet, behøver den ikke længere adgang til træningsprøverne og kan lave forudsigelser om usete data. Tilsvarende, i vores tilfælde, når synthesizer-modellen er trænet, kan prøver af syntetiske data genereres uden behov for de originale data.

Gennem en type angreb kaldet "medlemskabsslutningsangreb", kan angribere forsøge at afsløre de data, der blev brugt til at oprette de syntetiske data, uden at have adgang til de originale data. Dette resulterer i et kompromittering af privatlivets fred.

Medlemsslutningsscoren måler sandsynligheden for, at et medlemskabsslutningsangreb lykkes.

En lav score antyder muligheden for at konkludere, at en bestemt post var medlem af træningsdatasættet, der førte til oprettelsen af de syntetiske data. Med andre ord kan angrebene udlede detaljer om en individuel post og derved kompromittere privatlivets fred.

En høj medlemsslutningsscore indikerer, at det er usandsynligt, at en angriber vil afgøre, om en bestemt post var en del af det originale datasæt, der blev brugt til at oprette de syntetiske data. Dette betyder også, at ingen persons oplysninger blev kompromitteret gennem de syntetiske data.

Holdout-konceptet

En vigtig bedste praksis, som vi skal følge, er at sikre, at de syntetiske data er generelle nok og ikke passer til de originale data, som de blev trænet på. I et typisk datavidenskabsflow sætter vi testdata til side, mens vi bygger ML-modeller såsom en Random Forest-klassifikator, træner modellerne ved hjælp af træningsdataene og evaluerer metrics på usete testdata.

Tilsvarende for syntetiske data holder vi en prøve af de originale data til side – generelt omtalt som et hold-out-datasæt eller usete tilbageholdte testdata – og evaluerer de genererede syntetiske data i forhold til hold-out-datasættet.

Holdout-datasættet forventes at være en repræsentation af de originale data, men endnu ikke set, da de syntetiske data blev genereret. Derfor er det vigtigt at have ens score for alle metrikker, når man sammenligner originalen med holdout og de syntetiske datasæt.

Når lignende scores opnås, kan vi fastslå, at de syntetiske datapunkter ikke er et resultat af memorisering af de originale datapunkter, samtidig med at den samme troskab og anvendelighed bevares.

Afsluttende tanker

Verden er begyndt at forstå den strategiske betydning af syntetiske data. Som dataforskere og datageneratorer er det vores pligt at skabe tillid til de syntetiske data, som vi genererer, og sørge for, at det er til et formål.

Syntetiske data er ved at udvikle sig til et must-have i datavidenskabens udviklingsværktøj. MIT Technology Review har bemærkede syntetiske data som en af banebrydende teknologier i 2022. Vi kan ikke forestille os at bygge fremragende værdifulde AI-modeller uden syntetiske data, hævder Gartner.

Ifølge McKinsey, minimerer syntetiske data omkostninger og barrierer, som du ellers ville have, når du udvikler algoritmer eller får adgang til data.

Generering af syntetiske data handler om at kende downstream-applikationerne og forstå afvejningen mellem de forskellige dimensioner for kvaliteten af syntetiske data.

Resumé

Som bruger af de syntetiske data er det vigtigt at definere konteksten for den use case, som hver prøve af syntetiske materialer vil blive brugt til i fremtiden. Ligesom med reelle data er kvaliteten af de syntetiske data afhængig af den tilsigtede use case, samt de parametre, der er valgt til syntetisering.

For eksempel er det nyttigt at holde afvigende værdier i de syntetiske data som i de originale data for en brugssag om bedrageri. Det er dog ikke nyttigt i tilfælde af sundhedspleje med hensyn til privatlivets fred, da outliers generelt kan være informationslækage.

Desuden eksisterer der en afvejning mellem troskab, nytte og privatliv. Data kan ikke optimeres for alle tre samtidigt. Disse målinger gør det muligt for interessenterne at prioritere, hvad der er væsentligt for hver use case og administrere forventninger fra de genererede syntetiske data.

I sidste ende, når vi ser værdierne af hver metrik, og når de lever op til forventningerne, kan interessenter være sikre på de løsninger, de bygger ved hjælp af de syntetiske data.

Usecases for strukturerede syntetiske data dækker en bred vifte af anvendelser fra testdata til softwareudvikling til oprettelse af syntetiske kontrolarme i kliniske forsøg.

Ræk ud for at udforske disse muligheder, eller byg en PoC for at demonstrere værdien.

Faris Haddad er Data & Insights Lead i AABG Strategic Pursuits-teamet. Han hjælper virksomheder med at blive datadrevne.

Faris Haddad er Data & Insights Lead i AABG Strategic Pursuits-teamet. Han hjælper virksomheder med at blive datadrevne.

- Avanceret (300)

- AI

- ai kunst

- ai kunst generator

- en robot

- Amazon maskinindlæring

- kunstig intelligens

- certificering af kunstig intelligens

- kunstig intelligens i banksektoren

- kunstig intelligens robot

- kunstig intelligens robotter

- software til kunstig intelligens

- AWS maskinindlæring

- blockchain

- blockchain konference ai

- coingenius

- samtale kunstig intelligens

- kryptokonference ai

- dalls

- dyb læring

- du har google

- machine learning

- plato

- platon ai

- Platon Data Intelligence

- Platon spil

- PlatoData

- platogaming

- skala ai

- syntaks

- Teknisk vejledning

- zephyrnet