Synstab kommer i forskellige former. For nogle er det fra fødslen, for andre er det en langsom nedstigning over tid, som kommer med mange udløbsdatoer: Den dag, hvor du ikke kan se billeder, genkende dig selv eller dine kæres ansigter eller endda læse din mail. I vores tidligere blogindlæg Giv synshandicappede mulighed for at høre dokumenter ved hjælp af Amazon Textract og Amazon Polly, viste vi dig vores tekst til tale-applikation kaldet "Læs for mig". Tilgængeligheden er nået langt, men hvad med billeder?

På 2022 AWS re:Invent-konferencen i Las Vegas demonstrerede vi "Beskriv for mig" på AWS Builders' Fair, et websted, der hjælper synshandicappede med at forstå billeder gennem billedtekst, ansigtsgenkendelse og tekst-til-tale, en teknologi, vi omtaler som "Image to Speech." Gennem brugen af flere AI/ML-tjenester genererer "Beskriv for mig" en billedtekst af et inputbillede og vil læse det tilbage i en klar, naturligt lydende stemme på en række forskellige sprog og dialekter.

I dette blogindlæg leder vi dig gennem løsningsarkitekturen bag "Describe For Me", og designovervejelserne i vores løsning.

Løsningsoversigt

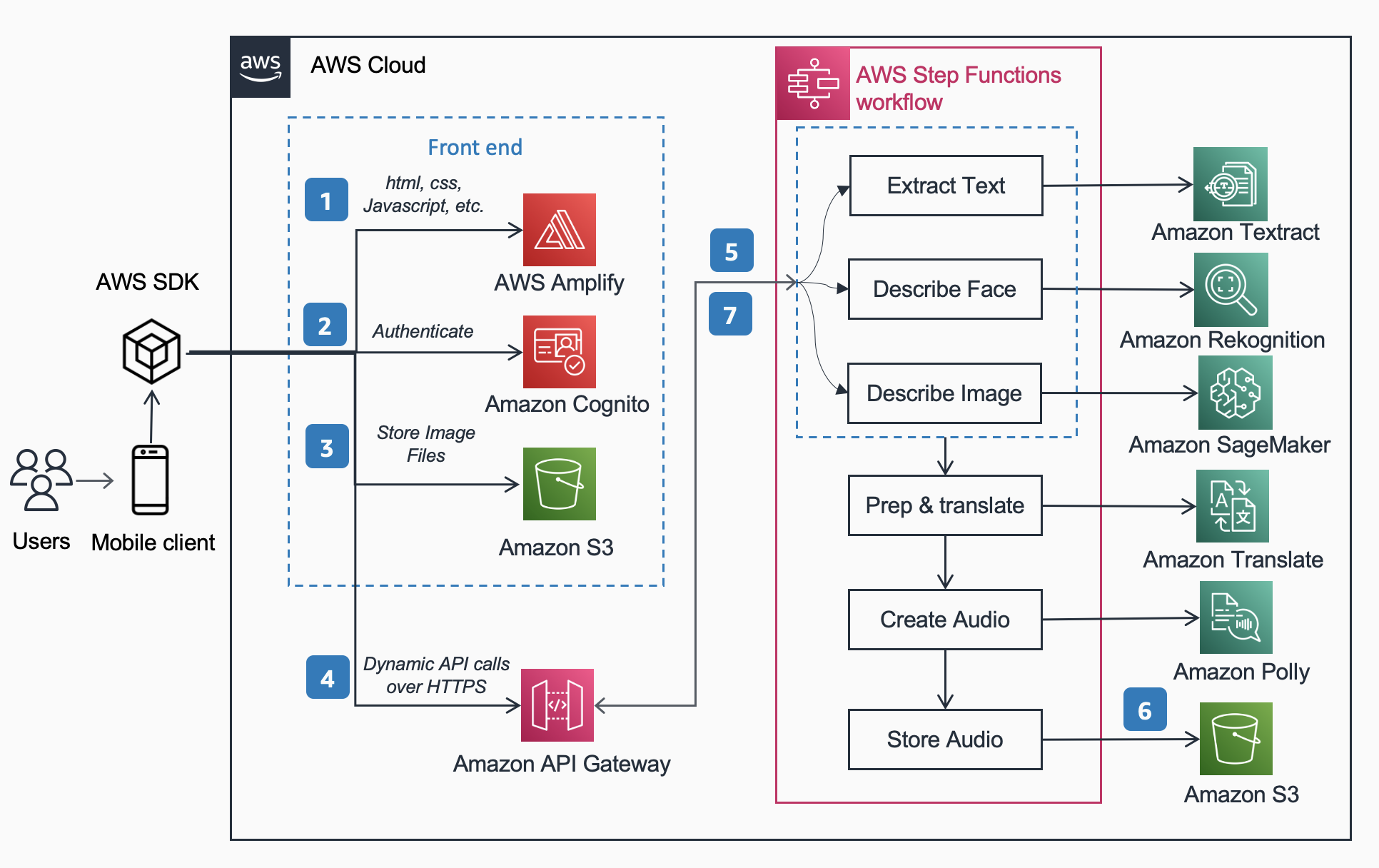

Den følgende referencearkitektur viser arbejdsgangen for en bruger, der tager et billede med en telefon og afspiller en MP3 af billedteksten til billedet.

Arbejdsgangen inkluderer nedenstående trin,

- AWS Amplify distribuerer DescribeForMe-webappen bestående af HTML, JavaScript og CSS til slutbrugeres mobile enheder.

- Amazon Cognito Identitetspulje giver midlertidig adgang til Amazon S3 spand.

- Brugeren uploader en billedfil til Amazon S3 spand ved hjælp af AWS SDK gennem webappen.

- DescribeForMe-webappen påberåber sig backend AI-tjenesterne ved at sende Amazon S3 objekt Indtast nyttelasten til Amazon API Gateway

- Amazon API Gateway instansierer en AWS-trinfunktioner workflow. Statens Maskin orkestrerer tjenesterne Artificial Intelligence/Machine Learning (AI/ML). Amazon-anerkendelse, Amazon SageMaker, amazontekst, Amazon Oversæt, , Amazon Polly ved brug af AWS lambda funktioner.

- AWS-trinfunktioner workflow opretter en lydfil som output og gemmer den i Amazon S3 i MP3-format.

- En forudsigneret URL med placeringen af lydfilen gemt i Amazon S3 sendes tilbage til brugerens browser gennem Amazon API Gateway. Brugerens mobilenhed afspiller lydfilen ved hjælp af den forudsignerede URL.

Løsningsgennemgang

I dette afsnit fokuserer vi på designovervejelserne for, hvorfor vi valgte

- parallel bearbejdning inden for en AWS-trinfunktioner workflow

- samlet sekvens-til-sekvens præ-trænet machine learning model OFA (One For All) fra Knusende ansigt til Amazon SageMaker til billedtekst

- Amazon-anerkendelse til ansigtsgenkendelse

For et mere detaljeret overblik over, hvorfor vi valgte en serverløs arkitektur, synkron arbejdsgang, arbejdsgang med eksprestrinfunktioner, hovedløs arkitektur og de opnåede fordele, kan du læse vores tidligere blogindlæg Giv synshandicappede mulighed for at høre dokumenter ved hjælp af Amazon Textract og Amazon Polly.

Parallelbehandling

Brug af parallel behandling inden for Step Functions-arbejdsgangen reducerede beregningstiden med op til 48 %. Når brugeren har uploadet billedet til S3-bøtten, instansierer Amazon API Gateway en AWS Step Functions-arbejdsgang. Derefter behandler nedenstående tre lambda-funktioner billedet i Step Functions-arbejdsgangen parallelt.

- Den første Lambda funktion kaldet

describe_imageanalyserer billedet ved hjælp af OFA_IMAGE_CAPTION model hostet på et SageMaker-endepunkt i realtid for at give billedtekst. - Den anden Lambda-funktion kaldet

describe_facestjekker først, om der er ansigter, der bruger Amazon Rekognitions Detect Faces API, og hvis det er sandt, kalder det Compare Faces API. Grunden til dette er, at Sammenlign ansigter vil give en fejl, hvis der ikke er nogen ansigter fundet på billedet. Det er også hurtigere at kalde Opdag ansigter først end blot at køre Sammenlign ansigter og håndteringsfejl, så for billeder uden ansigter i dem, vil behandlingstiden være hurtigere. - Den tredje Lambda funktion kaldet

extract_texthåndterer tekst-til-tale ved hjælp af Amazon Textract og Amazon Comprehend.

Det er passende at udføre Lambda-funktionerne i rækkefølge, men den hurtigere og mere effektive måde at gøre dette på er gennem parallel behandling. Følgende tabel viser den gemte beregnede tid for tre eksempelbilleder.

| Billede | Mennesker | Sekventiel tid | Parallel Tid | Tidsbesparelse (%) | Caption |

|

0 | 1869ms | 1702ms | 8% | En tabby kat krøllet sammen i en blød hvid seng. |

|

1 | 4277ms | 2197ms | 48 % | En kvinde i grøn bluse og sort cardigan smiler til kameraet. Jeg genkender én person: Kanbo. |

|

4 | 6603ms | 3904ms | 40 % | Folk, der står foran Amazonasfærerne. Jeg genkender 3 personer: Kanbo, Jack og Ayman. |

Billede Caption

Hugging Face er et open source-fællesskab og en datavidenskabsplatform, der giver brugerne mulighed for at dele, bygge, træne og implementere maskinlæringsmodeller. Efter at have udforsket de tilgængelige modeller i Hugging Face-modelhubben, valgte vi at bruge OFA model fordi som beskrevet af forfatterne, er det "en opgave-agnostisk og modalitets-agnostisk ramme, der understøtter Task Comprehensiveness".

OFA er et skridt mod "One For All", da det er en samlet multimodal præ-trænet model, der effektivt kan overføres til en række downstream-opgaver. Mens OFA-modellen understøtter mange opgaver, herunder visuel forankring, sprogforståelse og billedgenerering, brugte vi OFA-model til billedtekstning i Describe For Me-projektet for at udføre billedet til tekstdelen af applikationen. Tjek det officielle lager af OFA (ICML 2022), papir at lære om OFA's samlende arkitekturer, opgaver og modaliteter gennem en enkel sekvens-til-sekvens læringsramme.

For at integrere OFA i vores applikation klonede vi reposen fra Hugging Face og containeriserede modellen for at implementere den til et SageMaker-slutpunkt. Det notesbog i denne repo er en fremragende guide til at implementere OFA store model i en Jupyter notesbog i SageMaker. Efter containerisering af dit inferensscript er modellen klar til at blive implementeret bag et SageMaker-slutpunkt som beskrevet i SageMaker dokumentation. Når modellen er implementeret, skal du oprette et HTTPS-slutpunkt, som kan integreres med lambdafunktionen "describe_image", der analyserer billedet for at skabe billedteksten. Vi implementerede den lille OFA-model, fordi den er en mindre model og kan implementeres på kortere tid, mens den opnår lignende ydeevne.

Eksempler på billed-til-tale-indhold genereret af "Beskriv for mig" er vist nedenfor:

Aurora borealis, eller nordlys, fylder nattehimlen over en silhuet af et hus.

En hund sover på et rødt tæppe på et trægulv ved siden af en åben kuffert fyldt med legetøj.

En tabby kat krøllet sammen i en blød hvid seng.

Ansigtsgenkendelse

Amazon Rekognition Image giver Opdag ansigter operation, der leder efter vigtige ansigtstræk såsom øjne, næse og mund for at registrere ansigter i et inputbillede. I vores løsning udnytter vi denne funktionalitet til at registrere personer i inputbilledet. Hvis en person opdages, bruger vi så Sammenlign ansigter operation for at sammenligne ansigtet i inputbilledet med de ansigter, som "Describe For Me" er blevet trænet med og beskrive personen ved navn. Vi valgte at bruge Rekognition til ansigtsgenkendelse på grund af den høje nøjagtighed, og hvor nemt det var at integrere i vores applikation med out-of-the-box-funktionerne.

En gruppe mennesker poserer til et billede i et værelse. Jeg genkender 4 personer: Jack, Kanbo, Alak og Trac. Der var også tekst på billedet. Der står: AWS re: Opfind

Potentielle anvendelsestilfælde

Alternativ tekstgenerering til webbilleder

Alle billeder på et websted skal have en alternativ tekst, så skærmlæsere kan tale dem til synshandicappede. Det er også godt til søgemaskineoptimering (SEO). Oprettelse af alternative billedtekster kan være tidskrævende, da en tekstforfatter har til opgave at levere dem i et designdokument. Describe For Me API kunne automatisk generere alt-tekst til billeder. Det kan også bruges som et browser-plugin til automatisk at tilføje billedtekst til billeder, der mangler alt-tekst på ethvert websted.

Lydbeskrivelse til video

Lydbeskrivelse giver et fortællespor til videoindhold for at hjælpe synshandicappede med at følge med i film. Efterhånden som billedteksten bliver mere robust og præcis, kan en arbejdsgang, der involverer oprettelsen af et lydspor baseret på beskrivelser af nøgledele af en scene, være mulig. Amazon Rekognition kan allerede registrere sceneændringer, logoer og kreditsekvenser og genkendelse af berømtheder. En fremtidig version af describe vil give mulighed for at automatisere denne nøglefunktion til film og videoer.

Konklusion

I dette indlæg diskuterede vi, hvordan man bruger AWS-tjenester, inklusive AI og serverløse tjenester, for at hjælpe synshandicappede med at se billeder. Du kan lære mere om Describe For Me-projektet og bruge det ved at besøge describeforme.com. Lær mere om de unikke funktioner ved Amazon SageMaker, Amazon-anerkendelse og AWS-partnerskab med Hugging Face.

Tredjeparts ML Model Ansvarsfraskrivelse til vejledning

Denne vejledning er kun til informationsformål. Du bør stadig udføre din egen uafhængige vurdering og træffe foranstaltninger for at sikre, at du overholder dine egne specifikke kvalitetskontrolpraksisser og standarder og de lokale regler, love, regler, licenser og brugsvilkår, der gælder for dig, dit indhold og den tredjeparts Machine Learning-model, der henvises til i denne vejledning. AWS har ingen kontrol eller autoritet over tredjeparts Machine Learning-model, der henvises til i denne vejledning, og giver ingen erklæringer eller garantier for, at tredjeparts Machine Learning-modellen er sikker, virusfri, operationel eller kompatibel med dit produktionsmiljø og standarder. AWS giver ingen erklæringer, garantier eller garantier for, at nogen information i denne vejledning vil resultere i et bestemt resultat eller resultat.

Om forfatterne

Jack Marchetti er en senior løsningsarkitekt hos AWS med fokus på at hjælpe kunder med at modernisere og implementere serverløse, begivenhedsdrevne arkitekturer. Jack er juridisk blind og bor i Chicago med sin kone Erin og katten Minou. Han er også manuskriptforfatter og instruktør med primært fokus på julefilm og gyser. Se Jacks filmografi på hans IMDb-side.

Jack Marchetti er en senior løsningsarkitekt hos AWS med fokus på at hjælpe kunder med at modernisere og implementere serverløse, begivenhedsdrevne arkitekturer. Jack er juridisk blind og bor i Chicago med sin kone Erin og katten Minou. Han er også manuskriptforfatter og instruktør med primært fokus på julefilm og gyser. Se Jacks filmografi på hans IMDb-side.

Alak Eswaradass er Senior Solutions Architect hos AWS med base i Chicago, Illinois. Hun brænder for at hjælpe kunder med at designe cloud-arkitekturer ved at bruge AWS-tjenester til at løse forretningsmæssige udfordringer. Alak er begejstret for at bruge SageMaker til at løse en række forskellige ML use cases for AWS kunder. Når hun ikke arbejder, nyder Alak at tilbringe tid med sine døtre og udforske naturen med sine hunde.

Alak Eswaradass er Senior Solutions Architect hos AWS med base i Chicago, Illinois. Hun brænder for at hjælpe kunder med at designe cloud-arkitekturer ved at bruge AWS-tjenester til at løse forretningsmæssige udfordringer. Alak er begejstret for at bruge SageMaker til at løse en række forskellige ML use cases for AWS kunder. Når hun ikke arbejder, nyder Alak at tilbringe tid med sine døtre og udforske naturen med sine hunde.

Kandyce Bohannon er en Senior Solutions Architect baseret i Minneapolis, MN. I denne rolle arbejder Kandyce som teknisk rådgiver for AWS-kunder, da de moderniserer teknologistrategier, især relateret til data og DevOps, for at implementere bedste praksis i AWS. Derudover brænder Kandyce for at vejlede fremtidige generationer af teknologer og vise kvinder i teknologi gennem programmet AWS She Builds Tech Skills.

Kandyce Bohannon er en Senior Solutions Architect baseret i Minneapolis, MN. I denne rolle arbejder Kandyce som teknisk rådgiver for AWS-kunder, da de moderniserer teknologistrategier, især relateret til data og DevOps, for at implementere bedste praksis i AWS. Derudover brænder Kandyce for at vejlede fremtidige generationer af teknologer og vise kvinder i teknologi gennem programmet AWS She Builds Tech Skills.

Trac Do er Solutions Architect hos AWS. I sin rolle arbejder Trac med virksomhedskunder for at understøtte deres cloud-migreringer og applikationsmoderniseringsinitiativer. Han brænder for at lære kundernes udfordringer og løse dem med robuste og skalerbare løsninger ved hjælp af AWS-tjenester. Trac bor i øjeblikket i Chicago med sin kone og 3 drenge. Han er en stor luftfartsentusiast og er i gang med at færdiggøre sit Private Pilot License.

Trac Do er Solutions Architect hos AWS. I sin rolle arbejder Trac med virksomhedskunder for at understøtte deres cloud-migreringer og applikationsmoderniseringsinitiativer. Han brænder for at lære kundernes udfordringer og løse dem med robuste og skalerbare løsninger ved hjælp af AWS-tjenester. Trac bor i øjeblikket i Chicago med sin kone og 3 drenge. Han er en stor luftfartsentusiast og er i gang med at færdiggøre sit Private Pilot License.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoAiStream. Web3 Data Intelligence. Viden forstærket. Adgang her.

- Udmøntning af fremtiden med Adryenn Ashley. Adgang her.

- Køb og sælg aktier i PRE-IPO-virksomheder med PREIPO®. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/introducing-an-image-to-speech-generative-ai-application-using-amazon-sagemaker-and-hugging-face/

- :har

- :er

- :ikke

- $OP

- 100

- 2022

- 7

- a

- Om

- over

- adgang

- nøjagtighed

- præcis

- opnå

- tilføje

- Derudover

- rådgiver

- Efter

- AI

- AI-tjenester

- AI / ML

- Støtte

- Alle

- tillade

- tillader

- sammen

- allerede

- også

- alternativ

- Amazon

- Amazon API Gateway

- Amazon Comprehend

- Amazon-anerkendelse

- Amazon SageMaker

- amazontekst

- Amazon Web Services

- an

- analyser

- ,

- enhver

- api

- app

- Anvendelse

- Indløs

- arkitektur

- ER

- kunstig

- kunstig intelligens

- AS

- vurdering

- At

- lyd

- Aurora

- myndighed

- forfattere

- automatisk

- Automatisering

- til rådighed

- luftfart

- AWS

- AWS-trinfunktioner

- tilbage

- Bagende

- baseret

- BE

- fordi

- bliver

- været

- bag

- jf. nedenstående

- fordele

- BEDSTE

- bedste praksis

- Big

- Sort

- Blog

- Boks

- browser

- bygge

- bygger

- virksomhed

- men

- by

- kaldet

- ringer

- Opkald

- værelse

- CAN

- kapaciteter

- billedtekster

- tilfælde

- KAT

- Celebrity

- udfordringer

- Ændringer

- kontrollere

- Kontrol

- Chicago

- valgte

- jul

- klar

- Cloud

- Kom

- kommer

- samfund

- sammenligne

- kompatibel

- færdiggøre

- forstå

- Compute

- Konference

- overvejelser

- Bestående

- indhold

- kontrol

- kontrol

- kunne

- skabe

- skaber

- Oprettelse af

- skabelse

- kredit

- CSS

- For øjeblikket

- Kunder

- data

- datalogi

- Datoer

- dag

- demonstreret

- indsætte

- indsat

- beskrive

- beskrevet

- beskrivelse

- Design

- detaljeret

- opdaget

- Detektion

- enhed

- Enheder

- Direktør

- drøftet

- do

- dokumentet

- dokumenter

- gør

- Dog

- gør

- effektivt

- effektiv

- ende

- Endpoint

- Engine (Motor)

- sikre

- Enterprise

- entusiast

- entusiastiske

- Miljø

- fejl

- fejl

- især

- Endog

- fremragende

- udløb

- Udforskning

- Express

- Øjne

- Ansigtet

- ansigter

- ansigtsbehandling

- ansigtsgenkendelse

- retfærdig

- hurtigere

- Feature

- Funktionalitet

- File (Felt)

- udfylde

- fyldt

- Fornavn

- Gulvlampe

- Fokus

- fokuserede

- følger

- efter

- Til

- format

- formularer

- fundet

- Framework

- fra

- forsiden

- funktion

- funktionalitet

- funktioner

- fremtiden

- gateway

- generere

- genereret

- genererer

- generation

- generationer

- generative

- Generativ AI

- godt

- tilskud

- Grøn

- gruppe

- garantier

- vejledning

- vejlede

- Håndterer

- Håndtering

- Have

- he

- høre

- hjælpe

- hjælpe

- hjælper

- hende

- Høj

- hans

- horror

- hostede

- hus

- Hvordan

- How To

- HTML

- HTTPS

- Hub

- i

- if

- Illinois

- billede

- billeder

- gennemføre

- in

- omfatter

- Herunder

- uafhængig

- oplysninger

- Informational

- initiativer

- indgang

- integrere

- integreret

- Intelligens

- ind

- indføre

- påberåber sig

- involverer

- IT

- Jack

- JavaScript

- jpg

- Nøgle

- Sprog

- Sprog

- stor

- LAS

- Las Vegas

- Love

- LÆR

- læring

- Leverage

- Licens

- licenser

- Lives

- lokale

- placering

- Lang

- UDSEENDE

- off

- elskede

- maskine

- machine learning

- lave

- mange

- foranstaltninger

- mentoring

- mangler

- ML

- Mobil

- mobil enhed

- mobilenheder

- model

- modeller

- modernisere

- mere

- mere effektiv

- munden

- Film

- flere

- navn

- næste

- nat

- ingen

- næse

- notesbog

- nummer

- of

- officiel

- on

- engang

- ONE

- dem

- kun

- åbent

- open source

- drift

- operationelle

- optimering

- or

- Andre

- vores

- ud

- Resultat

- udendørs

- output

- i løbet af

- oversigt

- egen

- Parallel

- særlig

- Partnerskab

- dele

- part

- lidenskabelige

- Mennesker

- Udfør

- ydeevne

- periode

- person,

- telefon

- billede

- Billeder

- pilot

- perron

- plato

- Platon Data Intelligence

- PlatoData

- spiller

- spiller

- Vær venlig

- plugin

- pool

- del

- mulig

- Indlæg

- praksis

- tidligere

- primære

- private

- behandle

- forarbejdning

- produktion

- Program

- projekt

- give

- giver

- leverer

- formål

- kvalitet

- RE

- Læs

- læsere

- klar

- realtid

- grund

- anerkendelse

- genkende

- Rød

- Reduceret

- regler

- relaterede

- Repository

- påkrævet

- resultere

- robust

- roller

- Værelse

- regler

- kører

- sagemaker

- Besparelser

- skalerbar

- scene

- Videnskab

- Skærm

- skærmlæsere

- SDK

- Søg

- søgemaskine

- Anden

- Sektion

- sikker

- se

- afsendelse

- senior

- sendt

- SEO

- Serverless

- Tjenester

- Del

- hun

- bør

- fremvisning

- viste

- vist

- Shows

- lignende

- Simpelt

- ganske enkelt

- websted

- færdigheder

- Himmel

- langsom

- mindre

- So

- løsninger

- Løsninger

- SOLVE

- Løsning

- nogle

- tale

- specifikke

- tale

- udgifterne

- standarder

- Tilstand

- Trin

- Steps

- Stadig

- opbevaret

- forhandler

- strategier

- sådan

- egnede

- support

- Understøtter

- tabby

- bord

- Tag

- tager

- Opgaver

- opgaver

- tech

- Teknisk

- teknologer

- Teknologier

- midlertidig

- vilkår

- Tekst-til-tale

- end

- at

- Staten

- deres

- Them

- derefter

- Der.

- de

- Tredje

- tredjepart

- denne

- tre

- Gennem

- tid

- til

- mod

- spor

- Tog

- uddannet

- overførsel

- sand

- forstå

- forståelse

- forenet

- enestående

- på

- URL

- brug

- anvendte

- Bruger

- brugere

- ved brug af

- udnyttet

- Ved hjælp af

- række

- forskellige

- VEGAS

- udgave

- video

- Videoer

- Specifikation

- Voice

- var

- Vej..

- we

- web

- webservices

- Hjemmeside

- GODT

- Hvad

- hvornår

- som

- mens

- hvid

- hvorfor

- kone

- vilje

- med

- inden for

- uden

- kvinde

- Dame

- kvinder inden for teknologi

- arbejder

- virker

- ville

- Du

- Din

- dig selv

- zephyrnet