Den generative AI-boom er computerbundet. Det har den unikke egenskab, at tilføjelse af mere computer direkte resulterer i et bedre produkt. Normalt er F&U-investeringer mere direkte knyttet til, hvor værdifuldt et produkt var, og det forhold er markant sublineært. Men det er i øjeblikket ikke tilfældet med kunstig intelligens, og som et resultat er en fremherskende faktor, der driver industrien i dag, simpelthen omkostningerne ved uddannelse og konklusioner.

Selvom vi ikke kender de sande tal, har vi hørt fra velrenommerede kilder, at udbuddet af computere er så begrænset, at efterspørgslen overstiger den med en faktor på 10(!). Så vi synes, det er rimeligt at sige, at lige nu, adgang til computerressourcer - til den laveste samlede pris - er blevet en afgørende faktor for AI-virksomheders succes.

Faktisk har vi set mange virksomheder bruge mere end 80 % af deres samlede rejste kapital på computerressourcer!

I dette indlæg forsøger vi at nedbryde omkostningsfaktorerne for en AI-virksomhed. De absolutte tal vil selvfølgelig ændre sig over tid, men vi ser ikke umiddelbart lettelse fra AI-virksomheder, der er bundet af deres adgang til computerressourcer. Så forhåbentlig er dette en nyttig ramme for at tænke gennem landskabet.

Hvorfor er AI-modeller så beregningsmæssigt dyre?

Der er en bred vifte af generative AI-modeller, og slutnings- og træningsomkostninger afhænger af modellens størrelse og type. Heldigvis er de mest populære modeller i dag for det meste transformer-baserede arkitekturer, som omfatter populære store sprogmodeller (LLM'er) såsom GPT-3, GPT-J eller BERT. Mens det nøjagtige antal operationer til inferens og indlæring af transformere er modelspecifik (se dette papir), er der en ret præcis tommelfingerregel, der kun afhænger af antallet af parametre (dvs. vægten af de neurale netværk) af modellen og antallet af input- og output-tokens.

Tokens er i det væsentlige korte sekvenser af nogle få tegn. De svarer til ord eller dele af ord. Den bedste måde at få en intuition for tokens på er at prøve tokenisering med offentligt tilgængelige online tokenizere (f.eks. OpenAI). For GPT-3, den gennemsnitlige længde af et token er på 4 tegn.

Tommelfingerreglen for transformere er, at en fremadgående pass (dvs. slutning) for en model med p parametre for en input- og en outputsekvens af længde n poletter hver, tager ca 2*n*s flydende komma operationer (FLOPS)¹. Træning til samme model tager ca 6*s FLOPS pr. token (dvs. det ekstra tilbageløb kræver yderligere fire operationer²). Du kan anslå de samlede træningsomkostninger ved at gange dette med mængden af tokens i træningsdataene.

Hukommelseskrav til transformere afhænger også af modelstørrelsen. Til slutninger har vi brug for p modelparametre, der passer ind i hukommelsen. Til læring (dvs. tilbage-udbredelse) skal vi gemme yderligere mellemværdier pr. parameter mellem fremadgående og bagudgående passage. Hvis vi antager, at vi bruger 32-bit flydende kommatal, er dette yderligere 8 bytes pr. parameter. For at træne en model med 175 milliarder parametre skal vi have over en terabyte data i hukommelsen - dette overstiger enhver GPU, der eksisterer i dag og kræver, at vi deler modellen op på kort. Hukommelseskrav til inferens og træning kan optimeres ved at bruge flydende kommaværdier af kortere længder, hvor 16-bit bliver almindeligt og 8-bit forventes i den nærmeste fremtid.

Tabellen ovenfor har størrelser og beregningsomkostninger for flere populære modeller. GPT-3 har cirka 175 milliarder parametre, som for et input og output på 1,024 tokens resulterer i en beregningsomkostning på cirka 350 billioner flydende kommaoperationer (dvs. Teraflops eller TFLOPS). Træning af en model som GPT-3 tager omkring 3.14*10^23 flydende kommaoperationer. Andre modeller som Meta's LLaMA har endnu højere beregningskrav. At træne en sådan model er en af de mere beregningsintensive opgaver, menneskeheden har påtaget sig hidtil.

For at opsummere: AI-infrastruktur er dyr, fordi de underliggende algoritmiske problemer er ekstremt beregningsmæssigt svære. Den algoritmiske kompleksitet ved at sortere en databasetabel med en million poster er ubetydelig sammenlignet med kompleksiteten ved at generere et enkelt ord med GPT-3. Det betyder, at du ønsker at vælge den mindste model, der løser din use case.

Den gode nyhed er, at for transformere kan vi nemt estimere, hvor meget computer og hukommelse en model af en vis størrelse vil forbruge. Og så bliver det næste overvejelse at vælge den rigtige hardware.

Tids- og omkostningsargumentet for GPU'er

Hvordan oversættes beregningsmæssig kompleksitet til tid? En processorkerne kan typisk udføre 1-2 instruktioner pr. cyklus, og processorens clockhastigheder har været stabile omkring 3 GHz i de sidste 15 år på grund af slutningen af Dennard skalering. At udføre en enkelt GPT-3-inferensoperation uden at udnytte nogen parallel arkitektur ville tage i størrelsesordenen 350 TFLOPS/(3 GHz*1 FLOP) eller 116,000 sekunder eller 32 timer. Dette er vildt upraktisk; i stedet har vi brug for specialiserede chips, der accelererer denne opgave.

I praksis kører alle AI-modeller i dag på kort, der bruger et meget stort antal specialiserede kerner. For eksempel har en NVIDIA A100 GPU 512 "tensorkerner", der kan udføre en 4×4 matrix multiplikation (som svarer til 64 multiplikationer og additioner eller 128 FLOPS) i en enkelt cyklus. AI-acceleratorkort omtales ofte som GPU'er (grafikbehandlingsenheder), da arkitekturen oprindeligt blev udviklet til desktop-spil. I fremtiden forventer vi, at kunstig intelligens i stigende grad bliver en særskilt produktfamilie.

A100 har en nominel ydeevne på 312 TFLOPS hvilket i teorien ville reducere inferensen for GPT-3 til omkring 1 sekund. Dette er dog en forsimplet beregning af flere grunde. For det første er flaskehalsen i de fleste tilfælde ikke GPU'ens computerkraft, men evnen til at hente data fra den specialiserede grafikhukommelse til tensorkernerne. For det andet ville de 175 milliarder vægte fylde 700 GB og vil ikke passe ind i grafikhukommelsen på nogen GPU. Teknikker såsom partitionering og vægtstreaming skal bruges. Og for det tredje er der en række optimeringer (f.eks. ved at bruge kortere flydende komma-repræsentationer, såsom FP16, FP8 eller sparsomme matricer), som bliver brugt til at accelerere beregningen. Men samlet set giver ovenstående matematik os en intuition af de samlede beregningsomkostninger for nutidens LLM'er.

Træning af en transformermodel tager omkring tre gange så lang tid pr. token som at lave slutninger. Men i betragtning af, at træningsdatasættet er omkring 300 millioner gange større end en slutningsprompt, tager træning længere tid med en faktor på 1 mia. På en enkelt GPU ville træning tage årtier; i praksis gøres dette på store computerklynger i dedikerede datacentre eller, mere sandsynligt, i skyen. Træning er også sværere at parallelisere end inferens, da opdaterede vægte skal udveksles mellem noder. Hukommelse og båndbredde mellem GPU'er bliver ofte en langt vigtigere faktor, hvor højhastighedsforbindelser og dedikerede stoffer er almindelige. Til træning af meget store modeller kan det være den primære udfordring at skabe et passende netværksopsætning. Ser man ind i fremtiden, vil AI-acceleratorer have netværksfunktioner på kortet eller endda på chippen.

Hvordan oversættes denne beregningsmæssige kompleksitet til omkostninger? En GPT-3-inferens, som, som vi så ovenfor, tager cirka 1 sekund på en A100 ville have en rå beregningsomkostning mellem $0.0002 og $0.0014 for 1,000 tokens (dette sammenlignes med OpenAI's prissætning på $0.002/1000 tokens). En bruger, der genererer 100 slutningsanmodninger om dagen, vil koste i størrelsesordenen dollars om året. Dette er et meget lavt prispunkt og gør de fleste tilfælde af tekstbaseret AI af mennesker økonomisk levedygtige.

Kurser GPT-3 er derimod meget dyrere. Igen beregner vi kun beregningsomkostningerne for 3.14*10^23 FLOPS ved ovenstående satser, hvilket giver os et estimat på $560,000 på A100-kort for en enkelt træningsløb. I praksis vil vi til træning ikke få nær 100% effektivitet i GPU'en; men vi kan også bruge optimeringer til at reducere træningstiden. Andre estimater af GPT-3 træningsomkostninger spænder fra $500,000 til $ 4.6 millioner, afhængig af hardwareantagelser. Bemærk, at dette er prisen for en enkelt kørsel og ikke den samlede pris. Der vil sandsynligvis være behov for flere kørsler, og cloud-udbydere vil have langsigtede forpligtelser (mere om dette nedenfor). Træning af topmodeller er fortsat dyrt, men inden for rækkevidde af en velfinansieret opstart.

For at opsummere kræver generativ AI massive investeringer i AI-infrastruktur i dag. Der er ingen grund til at tro, at dette vil ændre sig i den nærmeste fremtid. At træne en model som GPT-3 er en af de mest beregningsintensive opgaver, menneskeheden nogensinde har påtaget sig. Og mens GPU'er bliver hurtigere, og vi finder måder at optimere træningen på, ophæver den hurtige udvidelse af AI begge disse effekter.

Overvejelser for AI-infrastruktur

Indtil nu har vi forsøgt at give dig noget intuition for den skala, der kræves for at træne og konkludere AI-modeller, og hvilke underliggende parametre der driver dem. Med den kontekst ønsker vi nu at give nogle praktiske vejledninger til, hvordan man beslutter, hvilken AI-infrastruktur der skal bruges.

Ekstern vs. intern infrastruktur

Lad os se det i øjnene: GPU'er er seje. Mange ingeniører og ingeniørorienterede grundlæggere har en skævhed i forhold til at klargøre deres egen AI-hardware, ikke kun fordi det giver finmasket kontrol over modeltræning, men fordi der bare er noget sjovt ved at udnytte store mængder computerkraft (udstilling A).

Virkeligheden er dog den mange startups – især app-virksomheder – behøver ikke at bygge deres egen AI-infrastruktur på dag 1. I stedet giver hostede modeltjenester som OpenAI eller Hugging Face (til sprog) og Replicate (til billedgenerering) grundlæggere mulighed for hurtigt at søge efter produkt-markedspasning uden behov for at administrere den underliggende infrastruktur eller modeller.

Disse tjenester er blevet så gode, at mange virksomheder aldrig opgraderer fra dem. Udviklere kan opnå meningsfuld kontrol over modellens ydeevne gennem hurtig konstruktion og højere ordens finjusteringsabstraktioner (dvs. finjustering gennem API-kald). Prissætningen for disse tjenester er forbrugsbaseret, så det er også ofte billigere end at køre separat infrastruktur. Vi har set app-virksomheder, der genererer mere end $50 millioner i ARR, og værdiansættes over $1 milliard, som kører hostede modeltjenester under hætten.

På bagsiden, nogle startups - især dem, der træner nye fundamentmodeller eller bygger vertikalt integrerede AI-applikationer — kan ikke undgå at køre deres egne modeller direkte på GPU'er. Enten fordi modellen reelt er produktet, og teamet søger efter "model-market fit", eller fordi finmasket kontrol over træning og/eller slutninger er påkrævet for at opnå visse evner eller reducere marginalomkostninger i stor skala. Uanset hvad, kan styring af infrastrukturen blive en kilde til konkurrencefordele.

Cloud vs. datacenter opbygget

I de fleste tilfælde er skyen det rigtige sted for din AI-infrastruktur. Mindre forudgående omkostninger, muligheden for at skalere op og ned, regional tilgængelighed og mindre distraktion fra at bygge dit eget datacenter er overbevisende for de fleste nystartede virksomheder og større virksomheder.

Men der er et par undtagelser fra denne regel:

- Hvis du opererer i meget stor skala, kan det blive mere omkostningseffektivt at drive dit eget datacenter. Det nøjagtige prispunkt varierer baseret på geografisk placering og opsætning, men det kræver typisk infrastrukturforbrug på mere end 50 millioner dollars om året.

- Du har brug for meget specifik hardware, som du ikke kan få hos en cloud-udbyder. For eksempel GPU-typer, der ikke er almindeligt tilgængelige, samt usædvanlige hukommelses-, lager- eller netværkskrav.

- Du kan ikke finde en sky, der er acceptabel af geopolitiske hensyn.

Hvis du ønsker at bygge dit eget datacenter, har der været en omfattende pris/ydelsesanalyse af GPU'er til din egen opsætning (f.eks. Tim Dettmers analyse). Ud over prisen og ydeevnen af selve kortet afhænger hardwarevalg også af strøm, plads og køling. For eksempel har to RTX 3080 Ti-kort tilsammen samme råberegningskapacitet som en A100, men det respektive strømforbrug er 700W vs. 300W. De 3,500 kWh effektforskel ved markedspriser på $0.10/kWh over en treårig livscyklus øger prisen på RTX3080 Ti med næsten 2x (ca. $1,000).

Alt dette sagt, forventer vi, at langt de fleste startups bruger cloud computing.

Sammenligning af cloud-tjenesteudbydere

Amazon Web Services (AWS), Microsoft Azure og Google Cloud Platform (GCP) tilbyder alle GPU-instanser, men nye udbydere ser også ud til at fokusere specifikt på AI-arbejdsbelastninger. Her er en ramme, som vi har set mange grundlæggere bruge til at vælge en cloud-udbyder:

Pris: Tabellen nedenfor viser priser for en række større og mindre specialskyer pr. 7. april 2023. Disse data er kun vejledende, da tilfældene varierer betydeligt med hensyn til netværksbåndbredde, omkostninger til dataudgang, ekstra omkostninger fra CPU og netværk, tilgængelig rabatter og andre faktorer.

Beregningskapacitet på specifik hardware er en handelsvare. Naivt ville vi forvente nogenlunde ensartede priser, men det er ikke tilfældet. Og selvom der eksisterer væsentlige funktionsforskelle mellem skyerne, er de utilstrækkelige til at forklare, at priserne for en on-demand NVIDIA A100 varierer med en faktor på næsten 4x blandt udbydere.

I den øverste ende af prisskalaen opkræver de store offentlige skyer en præmie baseret på brands omdømme, dokumenteret pålidelighed og behovet for at håndtere en bred vifte af arbejdsbelastninger. Mindre specialiserede AI-udbydere tilbyder lavere priser, enten ved at drive specialbyggede datacentre (f.eks. Coreweave) eller ved at arbitrage andre skyer (f.eks. Lambda Labs).

Rent praktisk forhandler de fleste større købere priser direkte med cloud-udbyderne, og forpligter sig ofte til et minimumsforbrugskrav samt minimumstidsforpligtelser (vi har set 1-3 år). Prisforskellene mellem skyerne skrumper noget efter forhandling, men vi har set placeringen i tabellen ovenfor forblive relativt stabil. Det er også vigtigt at bemærke, at mindre virksomheder kan få aggressive priser fra specialskyer uden store forbrugsforpligtelser.

tilgængelighed: De mest kraftfulde GPU'er (f.eks. Nvidia A100'er) har konsekvent været mangelvare i de sidste 12 måneder.

Det ville være logisk at tro, at de tre bedste cloud-udbydere har den bedste tilgængelighed i betragtning af deres store købekraft og pulje af ressourcer. Men noget overraskende har mange startups ikke fundet ud af, at det er sandt. De store skyer har en masse hardware, men har også store kundebehov at tilfredsstille - f.eks. er Azure den primære vært for ChatGPT - og tilføjer/leaser konstant kapacitet for at imødekomme efterspørgslen. I mellemtiden har Nvidia forpligtet sig til at gøre hardware tilgængelig bredt på tværs af branchen, herunder tildelinger til nye specialudbydere. (De gør dette både for at være retfærdige og for at reducere deres afhængighed af nogle få store kunder, som også konkurrerer med dem.)

Som følge heraf finder mange startups flere tilgængelige chips, inklusive de banebrydende Nvidia H100s, hos mindre cloud-udbydere. Hvis du er villig til at arbejde med et nyere infrastrukturfirma, kan du muligvis reducere ventetider på hardware og muligvis spare penge i processen.

Beregn leveringsmodel: De store skyer tilbyder i dag kun instanser med dedikerede GPU'er, grunden er, at GPU-virtualisering stadig er et uløst problem. Specialiserede AI-skyer tilbyder andre modeller, såsom containere eller batchjobs, der kan håndtere individuelle opgaver uden at pådrage sig opstarts- og nedtagningsomkostningerne for en instans. Hvis du er fortrolig med denne model, kan den reducere omkostningerne betydeligt.

Netværksforbindelser: Specifikt til træning er netværksbåndbredde en vigtig faktor i udbydervalget. Klynger med dedikerede stoffer mellem noder, såsom NVLink, er nødvendige for at træne visse store modeller. Til billedgenerering kan gebyrer for udgående trafik også være en væsentlig omkostningsdriver.

Kunde support: Store cloud-udbydere betjener en enorm pulje af kunder på tværs af tusindvis af produkt-SKU'er. Det kan være svært at få kundesupportens opmærksomhed eller få løst et problem, medmindre du er en stor kunde. Mange specialiserede AI-skyer tilbyder på den anden side hurtig og responsiv support selv for små kunder. Dette er dels fordi de opererer i mindre skala, men også fordi deres arbejdsbelastninger er mere homogene - så de er mere tilskyndet til at fokusere på AI-specifikke funktioner og fejl.

Sammenligning af GPU'er

Alt andet lige vil top-end GPU'erne klare sig bedst på næsten alle arbejdsbelastninger. Men som du kan se i tabellen nedenfor, er den bedste hardware også væsentligt dyrere. At vælge den rigtige type GPU til din specifikke applikation kan reducere omkostningerne betydeligt og kan gøre forskellen mellem en levedygtig og ikke-levedygtig forretningsmodel.

At beslutte, hvor langt ned på listen, der skal gå - det vil sige at bestemme de mest omkostningseffektive GPU-valg til din applikation - er stort set en teknisk beslutning, der ligger uden for denne artikels omfang. Men vi vil nedenfor dele nogle af de udvælgelseskriterier, vi har set er de vigtigste:

Træning vs. slutning: Som vi så i det første afsnit ovenfor, kræver træning af en Transformer-model, at vi lagrer 8 bytes data til træning ud over modelvægtene. Dette betyder, at en typisk high-end forbruger-GPU med 12 GB hukommelse knap nok kan bruges til at træne en model med 4 milliarder parametre. I praksis udføres træning af store modeller på klynger af maskiner med fortrinsvis mange GPU'er pr. server, masser af VRAM og højbåndbreddeforbindelser mellem serverne (dvs. klynger bygget ved hjælp af top-end datacenter GPU'er).

Specifikt vil mange modeller være mest omkostningseffektive på NVIDIA H100, men i dag er det svært at finde og kræver normalt et langsigtet engagement på mere end et år. NVIDIA A100 kører det meste af modeltræning i dag; det er lettere at finde, men for store klynger kan det også kræve et langsigtet engagement.

Hukommelseskrav: Store LLM'er har parametertællinger, der er for høje til at passe på ethvert kort. De skal deles på flere kort og kræver en opsætning svarende til træning. Med andre ord har du sandsynligvis brug for H100s eller A100s selv for LLM-inferens. Men mindre modeller (f.eks. Stable Diffusion) kræver meget mindre VRAM. Mens A100 stadig er populær, har vi set startups bruge A10, A40, A4000, A5000 og A6000 eller endda RTX-kort.

Hardware support: Mens langt de fleste arbejdsbelastninger i virksomheder, som vi har talt med, kører på NVIDIA, er nogle få begyndt at eksperimentere med andre leverandører. Det mest almindelige er Google TPU, men Intels Gaudi 2 ser også ud til at få noget trækkraft. Udfordringen med disse leverandører er, at ydeevnen af din model ofte er meget afhængig af tilgængeligheden af softwareoptimeringer til disse chips. Du bliver sandsynligvis nødt til at lave en PoC for at forstå ydeevnen.

Latenskrav: Generelt kan mindre latensfølsomme arbejdsbelastninger (f.eks. batchdatabehandling eller applikationer, der ikke kræver interaktive UI-svar) bruge mindre kraftfulde GPU'er. Dette kan reducere beregningsomkostningerne med så meget som 3-4x (f.eks. sammenligne A100'er med A10'er på AWS). Brugervendte apps har på den anden side ofte brug for top-end-kort for at levere en engagerende brugeroplevelse i realtid. Optimering af modeller er ofte nødvendigt for at bringe omkostningerne til et overskueligt område.

Spikiness: Generative AI-virksomheder ser ofte dramatiske stigninger i efterspørgslen, da teknologien er så ny og spændende. Det er ikke usædvanligt at se anmodningsvolumen stige med 10 gange på en dag, baseret på en ny produktudgivelse, eller vokse 50 % om ugen konsekvent. Håndtering af disse spidser er ofte nemmere på lavere-end GPU'er, da flere computerknudepunkter sandsynligvis er tilgængelige på efterspørgsel. Det giver ofte også mening at betjene denne form for trafik med billigere ressourcer - på bekostning af ydeevnen - hvis den kommer fra mindre engagerede eller mindre tilbageholdende brugere.

Optimering og planlægning af modeller

Softwareoptimeringer kan i høj grad påvirke modellernes køretid - og 10x gevinster er ikke ualmindeligt. Du skal dog afgøre, hvilke metoder der vil være mest effektive med netop din model og dit system.

Nogle teknikker fungerer med en ret bred vifte af modeller. Ved at bruge kortere flydende komma-repræsentationer (dvs. FP16 eller FP8 vs. den originale FP32) eller kvantisering (INT8, INT4, INT2) opnås en speedup, der ofte er lineær med reduktionen af bits. Dette kræver nogle gange ændring af modellen, men der er i stigende grad tilgængelige teknologier, som automatiserer arbejdet med blandet eller kortere præcision. Beskæring af neurale netværk reducerer antallet af vægte ved at ignorere vægte med lave værdier. Sammen med effektiv sparsom matrixmultiplikation kan dette opnå en væsentlig fremskyndelse på moderne GPU'er. Et andet sæt optimeringsteknikker adresserer flaskehalsen i hukommelsesbåndbredden (f.eks. ved at streame modelvægte).

Andre optimeringer er meget modelspecifikke. For eksempel har Stable Diffusion gjort store fremskridt med hensyn til mængden af VRAM, der kræves til konklusioner. Endnu en klasse af optimeringer er hardwarespecifikke. NVIDIAs TensorML indeholder en række optimeringer, men vil kun virke på NVIDIA-hardware. Sidst, men ikke mindst, kan planlægning af AI-opgaver skabe enorme præstationsflaskehalse eller forbedringer. Allokering af modeller til GPU'er på en måde, der minimerer udskiftning af vægte, udvælgelse af den bedste GPU til en opgave, hvis flere er tilgængelige, og minimering af nedetid ved at samle arbejdsbelastninger på forhånd er almindelige teknikker.

I sidste ende er modeloptimering stadig lidt af en sort kunst, og de fleste startups, som vi taler med, arbejder med tredjeparter for at hjælpe med nogle af disse softwareaspekter. Ofte er der ikke tale om traditionelle MLops-leverandører, men derimod virksomheder, der specialiserer sig i optimeringer til specifikke generative modeller (f.eks. OctoML eller SegMind).

Hvordan vil omkostningerne til AI-infrastruktur udvikle sig?

I løbet af de sidste par år har vi set eksponentiel vækst af begge model parametre , GPU computerkraft. Det er uklart, om denne tendens vil fortsætte.

I dag er det almindeligt accepteret, at der er en sammenhæng mellem optimalt antal parametre og størrelsen af træningsdatasættet (se Deepminds Chinchilla arbejde for mere om dette). De bedste LLM'er i dag er uddannet på Almindelig gennemgang (en samling på 4.5 milliarder websider, eller omkring 10 % af alle eksisterende websider). Træningskorpuset omfatter også Wikipedia og en samling af bøger, selvom begge er meget mindre (det samlede antal bøger, der findes, anslås at være kun omkring 100 mio). Andre ideer, såsom transskribering af video- eller lydindhold, er blevet foreslået, men ingen af disse kommer i nærheden af størrelsen. Det er ikke klart, om vi kunne få et ikke-syntetisk træningsdatasæt, der er 10x større end det, der allerede er blevet brugt.

GPU-ydeevnen vil fortsætte med at stige, men også i et langsommere tempo. Moores lov er stadig intakt og giver mulighed for flere transistorer og flere kerner, men strøm og I/O er ved at blive begrænsende faktorer. Derudover er mange af de lavthængende frugter til optimeringer blevet plukket.

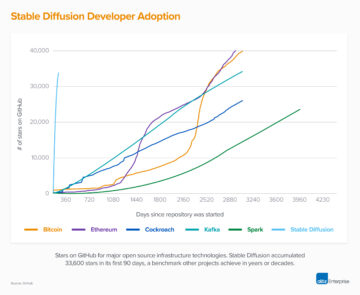

Men intet af dette betyder, at vi ikke forventer en stigning i efterspørgslen efter computerkapacitet. Selvom væksten i model- og træningssæt aftager, vil væksten i AI-industrien og stigningen i antallet af AI-udviklere sætte skub i efterspørgslen efter flere og hurtigere GPU'er. En stor del af GPU-kapaciteten bruges til test af udviklere under udviklingsfasen af en model, og denne efterspørgsel skaleres lineært med antal ansatte. Der er ingen tegn på, at den GPU-mangel, vi har i dag, vil aftage i den nærmeste fremtid.

Vil disse fortsatte høje omkostninger til AI-infrastruktur skabe en voldgrav, der gør det umuligt for nye deltagere at indhente velfinansierede etablerede virksomheder? Vi kender ikke svaret på dette spørgsmål endnu. Uddannelsesomkostningerne for en LLM kan ligne en voldgrav i dag, men open source-modeller som Alpaca eller Stable Diffusion har vist, at disse markeder stadig er tidlige og kan ændre sig hurtigt. Over tid vil omkostningsstrukturen for den nye AI-softwarestak (se vores tidligere indlæg) kan begynde at ligne den traditionelle softwareindustri.

I sidste ende ville dette være en god ting: Historien har vist, at dette fører til levende økosystemer med hurtig innovation og masser af muligheder for iværksættergrundlæggere.

Tak til Moin Nadeem og Shangda Xu for deres input og vejledning under skriveprocessen.

¹ Intuitionen her er, at for enhver parameter (dvs. vægt) i et neuralt netværk, skal en inferensoperation (dvs. fremadgående pass) udføre to flydende kommaoperationer pr. parameter. For det første multiplicerer den værdien af inputknudepunktet i det neurale netværk med parameteren. For det andet tilføjer det resultatet af summeringen til outputknudepunktet i det neurale netværk. Parametrene i koderen bruges én gang pr. input-token, og parametrene i dekoderen bruges én gang pr. output-token. Hvis vi antager, at en model har p parametre og input og output har begge en længde n poletter, samlede flydende komma operationer er n * s. Der er mange andre operationer (f.eks. normalisering, indkodning/afkodning af indlejringen), der sker i en model, men den tid det tager at udføre dem er lille i sammenligning.

² Indlæring kræver først en fremadgående passage gennem transformeren som beskrevet ovenfor, efterfulgt af en baglæns passage, der medfører fire yderligere operationer pr. parameter for at beregne gradienten og justere vægten. Bemærk, at beregning af gradienten kræver bevarelse af de beregnede nodeværdier fra det fremadgående gennemløb. For GPT-3, Sprogmodeller er få-skudte elever diskuterer uddannelsesomkostninger.

* * *

De synspunkter, der er udtrykt her, er dem fra det enkelte AH Capital Management, LLC ("a16z") personale, der er citeret, og er ikke synspunkter fra a16z eller dets tilknyttede selskaber. Visse oplysninger indeholdt heri er indhentet fra tredjepartskilder, herunder fra porteføljeselskaber af fonde forvaltet af a16z. Selvom det er taget fra kilder, der menes at være pålidelige, har a16z ikke uafhængigt verificeret sådanne oplysninger og fremsætter ingen erklæringer om informationernes vedvarende nøjagtighed eller deres passende for en given situation. Derudover kan dette indhold omfatte tredjepartsreklamer; a16z har ikke gennemgået sådanne annoncer og støtter ikke noget reklameindhold indeholdt deri.

Dette indhold er kun givet til informationsformål og bør ikke påberåbes som juridisk, forretningsmæssig, investerings- eller skatterådgivning. Du bør rådføre dig med dine egne rådgivere om disse spørgsmål. Henvisninger til værdipapirer eller digitale aktiver er kun til illustrationsformål og udgør ikke en investeringsanbefaling eller tilbud om at levere investeringsrådgivningstjenester. Ydermere er dette indhold ikke rettet mod eller beregnet til brug af nogen investorer eller potentielle investorer og kan under ingen omstændigheder stoles på, når der træffes en beslutning om at investere i en fond, der administreres af a16z. (Et tilbud om at investere i en a16z-fond vil kun blive givet af private placement-memorandummet, tegningsaftalen og anden relevant dokumentation for en sådan fond og bør læses i deres helhed.) Eventuelle investeringer eller porteføljeselskaber nævnt, refereret til eller beskrevne er ikke repræsentative for alle investeringer i køretøjer, der administreres af a16z, og der kan ikke gives sikkerhed for, at investeringerne vil være rentable, eller at andre investeringer foretaget i fremtiden vil have lignende karakteristika eller resultater. En liste over investeringer foretaget af fonde forvaltet af Andreessen Horowitz (undtagen investeringer, hvortil udstederen ikke har givet tilladelse til, at a16z offentliggør såvel som uanmeldte investeringer i offentligt handlede digitale aktiver) er tilgængelig på https://a16z.com/investments /.

Diagrammer og grafer, der er angivet i, er udelukkende til informationsformål og bør ikke stoles på, når der træffes nogen investeringsbeslutning. Tidligere resultater er ikke vejledende for fremtidige resultater. Indholdet taler kun fra den angivne dato. Alle fremskrivninger, estimater, prognoser, mål, udsigter og/eller meninger udtrykt i disse materialer kan ændres uden varsel og kan afvige fra eller være i modstrid med andres meninger. Se venligst https://a16z.com/disclosures for yderligere vigtige oplysninger.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoAiStream. Web3 Data Intelligence. Viden forstærket. Adgang her.

- Udmøntning af fremtiden med Adryenn Ashley. Adgang her.

- Kilde: https://a16z.com/2023/04/27/navigating-the-high-cost-of-ai-compute/

- :har

- :er

- :ikke

- $ 1 milliarder

- $OP

- 000

- 1

- 100

- 116

- 15 år

- 2023

- 500

- 7

- 8

- a

- a16z

- evne

- I stand

- Om

- over

- absolutte

- fremskynde

- accelerator

- acceleratorer

- acceptabel

- accepteret

- adgang

- nøjagtighed

- præcis

- opnå

- tværs

- tilføje

- Desuden

- Yderligere

- Derudover

- tilføjelser

- adresser

- Tilføjer

- fremme

- fremskridt

- Fordel

- Reklame

- rådgivning

- rådgivende

- rådgivning

- påvirke

- søsterselskaber

- Efter

- igen

- aggressive

- Aftale

- AI

- algoritmisk

- Alle

- tildelinger

- tillade

- allerede

- også

- Skønt

- blandt

- beløb

- beløb

- an

- analyse

- ,

- Andreessen

- Andreessen Horowitz

- En anden

- besvare

- Forventet

- enhver

- api

- app

- optræder

- kommer til syne

- Anvendelse

- applikationer

- cirka

- apps

- april

- arkitektur

- ER

- argument

- omkring

- Kunst

- artikel

- kunstig

- kunstig intelligens

- AS

- aspekter

- Aktiver

- sikkerhed

- At

- opmærksomhed

- lyd

- automatisere

- tilgængelighed

- til rådighed

- gennemsnit

- undgå

- AWS

- Azure

- båndbredde

- baseret

- BE

- fordi

- bliver

- bliver

- blive

- været

- være

- Tro

- troede

- jf. nedenstående

- BEDSTE

- Bedre

- mellem

- Beyond

- skævhed

- Big

- Billion

- Bit

- Sort

- Bøger

- boom

- både

- Bound

- brand

- Pause

- bringe

- bred

- bredt

- bugs

- bygge

- Bygning

- bygget

- virksomhed

- forretningsmodel

- men

- købere

- by

- beregne

- beregnet

- beregning

- Opkald

- CAN

- Kan få

- kan ikke

- kapaciteter

- Kapacitet

- kapital

- kort

- Kort

- tilfælde

- tilfælde

- brydning

- center

- Centers

- vis

- udfordre

- lave om

- karakteristika

- tegn

- afgift

- ChatGPT

- billigere

- chip

- Chips

- valg

- Vælg

- omstændigheder

- klasse

- klar

- ur

- Luk

- Cloud

- cloud computing

- Cloud platform

- samling

- Kom

- kommer

- behagelig

- engagement

- engageret

- begå

- råvare

- Fælles

- Virksomheder

- selskab

- sammenlignet

- sammenligne

- sammenligning

- overbevisende

- konkurrere

- konkurrencedygtig

- kompleksitet

- omfattende

- beregning

- Compute

- computing

- computerkraft

- Tilslutninger

- overvejelse

- overvejelser

- konstant

- udgøre

- forbruge

- forbruger

- forbrug

- Beholdere

- indhold

- sammenhæng

- fortsæt

- fortsatte

- modsætning

- kontrol

- Cool

- Core

- Koste

- omkostningseffektiv

- Omkostninger

- kunne

- Kursus

- skabe

- Oprettelse af

- kriterier

- For øjeblikket

- kunde

- Kunde support

- Kunder

- banebrydende

- cyklus

- data

- Data Center

- datacentre

- databehandling

- datasæt

- Database

- Dato

- dag

- årtier

- beslutte

- beslutning

- dedikeret

- DeepMind

- levere

- levering

- Efterspørgsel

- afhængighed

- afhængig

- Afhængigt

- afhænger

- beskrevet

- desktop

- Bestem

- bestemmelse

- udviklet

- udviklere

- Udvikling

- afvige

- forskel

- forskelle

- Broadcasting

- digital

- Digitale aktiver

- direkte

- offentliggøre

- rabatter

- distinkt

- do

- dokumentation

- gør

- gør

- dollars

- færdig

- Dont

- ned

- nedetid

- dramatisk

- køre

- driver

- kørsel

- grund

- i løbet af

- e

- Tidligt

- lettere

- nemt

- økosystemer

- Effektiv

- effektivt

- effekter

- effektivitet

- effektiv

- enten

- indlejring

- smergel

- ende

- godkende

- varige

- beskæftiget

- engagerende

- Engineering

- Ingeniører

- helhed

- indkommende

- iværksætter

- Ækvivalent

- især

- væsentlige

- skøn

- anslået

- skøn

- Endog

- NOGENSINDE

- udvikle sig

- eksempel

- overstiger

- spændende

- Eksklusive

- udføre

- udførelse

- eksisterer

- udvidelse

- forvente

- dyrt

- erfaring

- Forklar

- eksponentiel

- Eksponentiel vækst

- udtrykt

- ekstremt

- stoffer

- Ansigtet

- faktorer

- retfærdig

- retfærdigt

- familie

- FAST

- hurtigere

- Feature

- Funktionalitet

- Gebyrer

- få

- økonomisk

- Finde

- ende

- Fornavn

- passer

- fast

- Flip

- flydende

- Fokus

- efterfulgt

- Til

- prognoser

- Heldigvis

- Videresend

- fundet

- Foundation

- stiftere

- fire

- fraktion

- Framework

- fra

- Brændstof

- sjovt

- fond

- fonde

- Endvidere

- fremtiden

- gevinster

- spil

- Generelt

- generere

- generation

- generative

- Generativ AI

- geografiske

- geopolitiske

- få

- få

- Giv

- given

- giver

- Go

- godt

- Google Cloud

- Google Cloud Platform

- GPU

- GPU'er

- eksamen

- grafik

- grafer

- Grow

- Vækst

- vejledning

- hånd

- håndtere

- Håndtering

- ske

- Hård Ost

- Hardware

- udnyttelse

- Have

- antal ansatte

- hørt

- hjælpe

- hjælpsom

- link.

- Høj

- High-End

- stærkt

- historie

- hætte

- Forhåbentlig

- Horowitz

- host

- hostede

- HOURS

- Hvordan

- How To

- Men

- HTML

- HTTPS

- kæmpe

- Enormt

- Mennesker

- i

- ideer

- if

- billede

- umiddelbar

- vigtigt

- umuligt

- forbedringer

- in

- I andre

- tilskyndes

- omfatter

- omfatter

- Herunder

- Forøg

- Stigninger

- stigende

- uafhængigt

- angivet

- individuel

- industrien

- oplysninger

- Informational

- Infrastruktur

- Innovation

- indgang

- instans

- i stedet

- anvisninger

- integreret

- Intelligens

- interaktiv

- ind

- Invest

- investering

- investeringsrådgivning

- Investeringer

- Investorer

- Udsteder

- IT

- ITS

- selv

- Karriere

- lige

- Holde

- Venlig

- Kend

- Labs

- landskab

- Sprog

- stor

- vid udstrækning

- større

- Efternavn

- Latency

- Lov

- Leads

- læring

- Politikker

- Længde

- Livet

- ligesom

- Sandsynlig

- Liste

- Llama

- LLM

- placering

- logisk

- Lang

- langsigtet

- længere

- Se

- ligner

- leder

- Lot

- Lav

- lavere

- laveste

- Maskiner

- lavet

- større

- Flertal

- lave

- maerker

- Making

- administrere

- lykkedes

- ledelse

- styring

- menneskeheden

- mange

- Marked

- Markeder

- massive

- materialer

- matematik

- Matrix

- Matters

- max-bredde

- Kan..

- meningsfuld

- midler

- I mellemtiden

- Mød

- Memorandum

- Hukommelse

- nævnte

- metoder

- microsoft

- Microsoft Azure

- million

- minimering

- minimum

- blandet

- MLOps

- model

- modeller

- Moderne

- penge

- måned

- mere

- mest

- Mest Populære

- meget

- flere

- multiplicere

- navigering

- I nærheden af

- næsten

- nødvendig

- Behov

- behov

- behov

- netværk

- netværk

- net

- neurale netværk

- neurale netværk

- Ny

- nyt produkt

- nyheder

- næste

- ingen

- node

- noder

- Varsel..

- nu

- nummer

- numre

- Nvidia

- opnå

- opnået

- of

- tilbyde

- tilbyde

- tit

- on

- On-Demand

- engang

- ONE

- online

- kun

- åbent

- open source

- OpenAI

- drift

- drift

- Produktion

- Udtalelser

- Muligheder

- optimal

- optimering

- Optimer

- optimeret

- optimering

- or

- ordrer

- original

- oprindeligt

- Andet

- Andre

- vores

- ud

- output

- overgår

- i løbet af

- samlet

- egen

- Parallel

- parameter

- parametre

- særlig

- parter

- dele

- passerer

- forbi

- Udfør

- ydeevne

- tilladelse

- Personale

- fase

- pick

- plukket

- Place

- perron

- plato

- Platon Data Intelligence

- PlatoData

- Vær venlig

- PoC

- Punkt

- pool

- Populær

- portefølje

- eventuelt

- Indlæg

- magt

- vigtigste

- Praktisk

- praksis

- Precision

- Premium

- tidligere

- pris

- Priser

- prissætning

- primære

- private

- sandsynligvis

- Problem

- problemer

- behandle

- forarbejdning

- Processor

- Produkt

- rentabel

- fremskrivninger

- ejendom

- prospektive

- udsigter

- gennemprøvet

- give

- forudsat

- udbyder

- udbydere

- offentlige

- offentligt

- køb

- formål

- spørgsmål

- hurtigt

- F & U

- hævet

- rækkevidde

- Ranking

- hurtige

- hurtigt

- Sats

- priser

- Raw

- nå

- Læs

- realtid

- Reality

- grund

- årsager

- Anbefaling

- reducere

- reducerer

- referencer

- benævnt

- regional

- forhold

- relativt

- frigive

- relevant

- pålidelighed

- pålidelig

- relief

- forblive

- resterne

- repræsentativt

- hæderlige

- omdømme

- anmode

- anmodninger

- kræver

- påkrævet

- krav

- Krav

- Kræver

- Ressourcer

- dem

- lydhør

- resultere

- Resultater

- revideret

- RTX

- RTX 3080

- RTX 3080 Ti

- Herske

- Kør

- kører

- Said

- samme

- Gem

- Scale

- skalaer

- planlægning

- rækkevidde

- Søg

- søgning

- Anden

- sekunder

- Sektion

- Værdipapirer

- se

- set

- valg

- forstand

- følsom

- adskille

- Sequence

- tjener

- Servere

- tjeneste

- Tjenester

- sæt

- setup

- flere

- Del

- Kort

- mangel

- bør

- vist

- Shows

- side

- underskrive

- lignende

- ganske enkelt

- siden

- enkelt

- Situationen

- Størrelse

- størrelser

- bremser

- lille

- mindre

- So

- indtil nu

- Software

- Løser

- nogle

- noget

- noget

- Kilde

- Kilder

- Space

- taler

- Taler

- specialisere

- specialiserede

- Specialty

- specifikke

- specifikt

- tilbringe

- udgifterne

- spikes

- delt

- stabil

- stable

- starte

- Opstart

- påbegyndt

- Nystartede

- Stadig

- opbevaring

- butik

- streaming

- struktur

- emne

- abonnement

- væsentlig

- succes

- sådan

- egnede

- opsummere

- forsyne

- support

- systemet

- bord

- Tag

- tager

- Tal

- mål

- Opgaver

- opgaver

- skat

- hold

- Teknisk

- teknikker

- Teknologier

- Teknologier

- vilkår

- Test

- end

- at

- Fremtiden

- oplysninger

- Landskabet

- deres

- Them

- Der.

- deri

- Disse

- de

- ting

- tror

- Tænker

- Tredje

- tredje partier

- tredjepart

- denne

- dem

- tusinder

- tre

- Gennem

- Tied

- tid

- gange

- til

- i dag

- nutidens

- sammen

- token

- tokenization

- Tokens

- også

- top

- I alt

- mod

- trækkraft

- handles

- traditionelle

- Trafik

- Tog

- uddannet

- Kurser

- transformers

- Oversætte

- Trend

- forsøgte

- trillion

- sand

- to

- typen

- typer

- typisk

- typisk

- ui

- Ualmindelig

- under

- underliggende

- forstå

- enestående

- enheder

- opdateret

- på

- us

- brug

- brug tilfælde

- anvendte

- Bruger

- Brugererfaring

- brugere

- ved brug af

- sædvanligvis

- Værdifuld

- værdi

- værdiansættes

- Værdier

- række

- Vast

- Køretøjer

- leverandører

- verificeres

- lodret

- meget

- levedygtig

- levende

- video

- visninger

- mængder

- vs

- vente

- ønsker

- var

- Vej..

- måder

- we

- web

- webservices

- uge

- vægt

- GODT

- Hvad

- hvornår

- som

- mens

- WHO

- bred

- Bred rækkevidde

- bredt

- Wikipedia

- vilje

- villig

- med

- inden for

- uden

- ord

- ord

- Arbejde

- arbejder

- ville

- skrivning

- år

- år

- endnu

- Du

- Din

- zephyrnet