Open source store sprogmodeller (LLM'er) er blevet populære, hvilket giver forskere, udviklere og organisationer adgang til disse modeller for at fremme innovation og eksperimenter. Dette tilskynder til samarbejde fra open source-fællesskabet for at bidrage til udvikling og forbedring af LLM'er. Open source LLM'er giver gennemsigtighed til modelarkitekturen, træningsprocessen og træningsdata, som giver forskere mulighed for at forstå, hvordan modellen fungerer og identificere potentielle skævheder og adressere etiske bekymringer. Disse open source LLM'er demokratiserer generativ kunstig intelligens ved at gøre avanceret NLP-teknologi (natural language processing) tilgængelig for en bred vifte af brugere til at bygge missionskritiske forretningsapplikationer. GPT-NeoX, LLaMA, Alpaca, GPT4All, Vicuna, Dolly og OpenAssistant er nogle af de populære open source LLM'er.

OpenChatKit er en open source LLM, der bruges til at bygge generelle og specialiserede chatbot-applikationer, udgivet af Together Computer i marts 2023 under Apache-2.0-licensen. Denne model giver udviklere mulighed for at have mere kontrol over chatbottens adfærd og skræddersy den til deres specifikke applikationer. OpenChatKit giver et sæt værktøjer, basisbot og byggeklodser til at bygge fuldt tilpassede, kraftfulde chatbots. Nøglekomponenterne er som følger:

- En instruktionstunet LLM, finjusteret til chat fra EleutherAIs GPT-NeoX-20B med over 43 millioner instruktioner på 100 % kulstofnegativ beregning. Det

GPT-NeoXT-Chat-Base-20Bmodellen er baseret på EleutherAIs GPT-NeoX-model og er finjusteret med data, der fokuserer på dialog-stil interaktioner. - Tilpasningsopskrifter til at finjustere modellen for at opnå høj nøjagtighed på dine opgaver.

- Et udvideligt hentningssystem, der gør det muligt for dig at udvide bot-svar med information fra et dokumentlager, API eller en anden live-opdateringsinformationskilde på inferenstidspunkt.

- En modereringsmodel, finjusteret fra GPT-JT-6B, designet til at filtrere, hvilke spørgsmål botten svarer på.

Den stigende skala og størrelse af deep learning-modeller udgør forhindringer for succesfuldt at implementere disse modeller i generative AI-applikationer. For at imødekomme kravene til lav latenstid og høj gennemløb bliver det vigtigt at anvende sofistikerede metoder som modelparallelisme og kvantisering. Mange brugere, der mangler færdigheder i anvendelsen af disse metoder, støder på vanskeligheder med at starte hosting af store modeller til generative AI-brugssager.

I dette indlæg viser vi, hvordan man implementerer OpenChatKit-modeller (GPT-NeoXT-Chat-Base-20B and GPT-JT-Moderation-6B) modeller på Amazon SageMaker ved hjælp af DJL Serving og open source-model parallelbiblioteker som DeepSpeed og Hugging Face Accelerate. Vi bruger DJL Serving, som er en højtydende universel modelserveringsløsning drevet af Deep Java Library (DJL), der er programmeringssprogsagnostisk. Vi demonstrerer, hvordan Hugging Face Accelerate-biblioteket forenkler implementeringen af store modeller i flere GPU'er og derved reducerer byrden ved at køre LLM'er på en distribueret måde. Lad os komme igang!

Udvidbart afhentningssystem

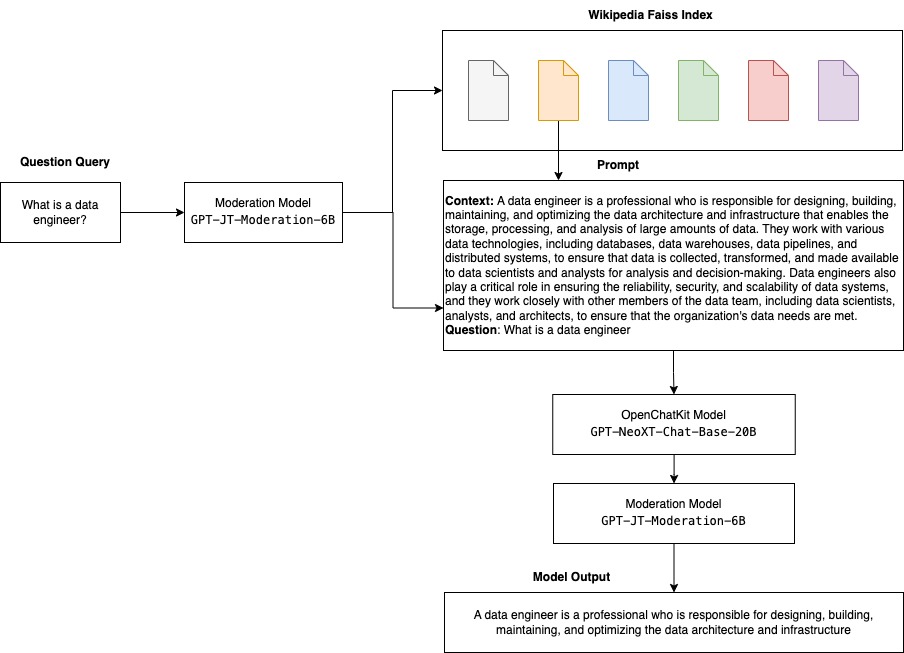

Et udvideligt genfindingssystem er en af nøglekomponenterne i OpenChatKit. Det giver dig mulighed for at tilpasse bot-svaret baseret på en videnbase for lukket domæne. Selvom LLM'er er i stand til at bevare faktuel viden i deres modelparametre og kan opnå bemærkelsesværdig ydeevne på downstream NLP-opgaver, når de er finjusteret, forbliver deres kapacitet til at få adgang til og forudsige lukket domæneviden nøjagtigt begrænset. Derfor, når de bliver præsenteret for videntunge opgaver, lider deres præstationer under opgavespecifikke arkitekturer. Du kan bruge OpenChatKit-hentningssystemet til at øge viden i deres svar fra eksterne videnkilder såsom Wikipedia, dokumentlagre, API'er og andre informationskilder.

Hentningssystemet gør det muligt for chatbotten at få adgang til aktuelle oplysninger ved at indhente relevante detaljer som svar på en specifik forespørgsel, og derved levere den nødvendige kontekst til, at modellen kan generere svar. For at illustrere funktionaliteten af dette genfindingssystem yder vi support til et indeks over Wikipedia-artikler og tilbyder eksempelkode, der demonstrerer, hvordan man kalder en websøgnings-API til informationssøgning. Ved at følge den medfølgende dokumentation kan du integrere genfindingssystemet med ethvert datasæt eller API under inferensprocessen, hvilket giver chatbotten mulighed for at inkorporere dynamisk opdaterede data i sine svar.

Moderation model

Modereringsmodeller er vigtige i chatbot-applikationer for at håndhæve indholdsfiltrering, kvalitetskontrol, brugersikkerhed og juridiske og overholdelsesmæssige årsager. Moderering er en vanskelig og subjektiv opgave, og afhænger meget af chatbot-applikationens domæne. OpenChatKit giver værktøjer til at moderere chatbot-applikationen og overvåge inputtekstprompter for upassende indhold. Moderationsmodellen giver en god baseline, der kan tilpasses og tilpasses forskellige behov.

OpenChatKit har en modereringsmodel med 6 milliarder parametre, GPT-JT-Moderation-6B, som kan moderere chatbotten for at begrænse input til de modererede emner. Selvom selve modellen har en vis mådehold indbygget, trænede TogetherComputer en GPT-JT-Moderation-6B model med Ontocord.ai's OIG-moderation datasæt. Denne model kører sammen med hovedchatbotten for at kontrollere, at både brugerinput og svar fra botten ikke indeholder upassende resultater. Du kan også bruge dette til at registrere eventuelle spørgsmål uden for domænet til chatbotten og tilsidesætte, når spørgsmålet ikke er en del af chatbottens domæne.

Følgende diagram illustrerer OpenChatKit-arbejdsgangen.

Brugssager til udvidbart hentningssystem

Selvom vi kan anvende denne teknik i forskellige industrier til at bygge generative AI-applikationer, diskuterer vi til dette indlæg brugssager i den finansielle industri. Retrieval augmented generation kan anvendes i finansiel forskning til automatisk at generere forskningsrapporter om specifikke virksomheder, brancher eller finansielle produkter. Ved at hente relevant information fra interne vidensbaser, finansielle arkiver, nyhedsartikler og forskningsartikler kan du generere omfattende rapporter, der opsummerer nøgleindsigter, økonomiske målinger, markedstendenser og investeringsanbefalinger. Du kan bruge denne løsning til at overvåge og analysere finansielle nyheder, markedsstemning og tendenser.

Løsningsoversigt

Følgende trin er involveret for at bygge en chatbot ved hjælp af OpenChatKit-modeller og implementere dem på SageMaker:

- Download chatbasen

GPT-NeoXT-Chat-Base-20Bmodel og pak de modelartefakter, der skal uploades til Amazon Simple Storage Service (Amazon S3). - Brug en SageMaker large model inference (LMI) container, konfigurer egenskaberne, og opsæt tilpasset inferenskode for at implementere denne model.

- Konfigurer modelparallelle teknikker og brug inferensoptimeringsbiblioteker i DJL-serveringsegenskaber. Vi vil bruge Hugging Face Accelerate som motor til DJL-servering. Derudover definerer vi tensorparallelle konfigurationer for at opdele modellen.

- Opret en SageMaker-model og -slutpunktskonfiguration, og implementer SageMaker-slutpunktet.

Du kan følge med ved at køre notesbogen i GitHub repo.

Download OpenChatKit-modellen

Først downloader vi OpenChatKit-basismodellen. Vi bruger huggingface_hub Og brug snapshot_download at downloade modellen, som downloader et helt lager ved en given revision. Downloads foretages samtidigt for at fremskynde processen. Se følgende kode:

DJL Serveringsejendomme

Du kan bruge SageMaker LMI-beholdere til at være vært for store generative AI-modeller med tilpasset slutningskode uden at angive din egen slutningskode. Dette er yderst nyttigt, når der ikke er nogen tilpasset forbehandling af inputdata eller efterbehandling af modellens forudsigelser. Du kan også implementere en model ved hjælp af tilpasset slutningskode. I dette indlæg demonstrerer vi, hvordan man implementerer OpenChatKit-modeller med tilpasset inferenskode.

SageMaker forventer, at modellens artefakter er i tjæreformat. Vi opretter hver OpenChatKit-model med følgende filer: serving.properties , model.py.

serving.properties konfigurationsfilen angiver til DJL Serving, hvilke modelparalleliserings- og inferensoptimeringsbiblioteker du gerne vil bruge. Følgende er en liste over indstillinger, vi bruger i denne konfigurationsfil:

Dette indeholder følgende parametre:

- motor – Motoren til DJL at bruge.

- option.entryPoint – Indgangspunktet Python-fil eller -modul. Dette skal passe med den motor, der bruges.

- option.s3url – Indstil dette til URI'en for den S3-spand, der indeholder modellen.

- option.modelid – Hvis du vil downloade modellen fra huggingface.co, kan du indstille

option.modelidtil model-id'et for en forudtrænet model, der er hostet i et modellager på huggingface.co (https://huggingface.co/models). Containeren bruger dette model-id til at downloade det tilsvarende modellager på huggingface.co. - option.tensor_parallel_degree – Indstil dette til antallet af GPU-enheder, som DeepSpeed skal bruge for at partitionere modellen. Denne parameter styrer også antallet af arbejdere pr. model, der vil blive startet op, når DJL Serving kører. For eksempel, hvis vi har en 8 GPU-maskine, og vi opretter otte partitioner, vil vi have en arbejder pr. model til at betjene anmodningerne. Det er nødvendigt at justere parallelitetsgraden og identificere den optimale værdi for en given modelarkitektur og hardwareplatform. Det kalder vi evne slutningstilpasset parallelisme.

Der henvises til Konfigurationer og indstillinger for en udtømmende liste over muligheder.

OpenChatKit-modeller

OpenChatKit basismodelimplementeringen har følgende fire filer:

- model.py – Denne fil implementerer håndteringslogikken for hovedmodellen OpenChatKit GPT-NeoX. Den modtager anmodningen om inferensinput, indlæser modellen, indlæser Wikipedia-indekset og betjener svaret. Henvise til

model.py(oprettet del af notesbogen) for yderligere detaljer.model.pybruger følgende nøgleklasser:- OpenChatKitService – Dette håndterer overførsel af data mellem GPT-NeoX-modellen, Faiss-søgning og samtaleobjekt.

WikipediaIndex,Conversationobjekter initialiseres, og inputchatsamtaler sendes til indekset for at søge efter relevant indhold fra Wikipedia. Dette genererer også et unikt ID for hver påkaldelse, hvis der ikke leveres et med det formål at gemme meddelelserne i Amazon DynamoDB. - Chatmodel – Denne klasse indlæser modellen og tokenizer og genererer svaret. Det håndterer opdeling af modellen på tværs af flere GPU'er ved hjælp af

tensor_parallel_degree, og konfigurererdtypes,device_map. Prompterne sendes til modellen for at generere svar. Et stopkriterieStopWordsCriteriaer konfigureret til, at generationen kun producerer bot-svaret ved inferens. - Modereringsmodel – Vi bruger to moderationsmodeller i

ModerationModelklasse: inputmodellen til at indikere over for chatmodellen, at inputtet er upassende til at tilsidesætte slutningsresultatet, og outputmodellen til at tilsidesætte slutningsresultatet. Vi klassificerer inputprompten og outputsvaret med følgende mulige etiketter:- afslappet

- kræver forsigtighed

- har brug for intervention (dette er markeret for at blive modereret af modellen)

- kræver muligvis forsigtighed

- kræver sandsynligvis forsigtighed

- OpenChatKitService – Dette håndterer overførsel af data mellem GPT-NeoX-modellen, Faiss-søgning og samtaleobjekt.

- wikipedia_prepare.py – Denne fil håndterer download og forberedelse af Wikipedia-indekset. I dette indlæg bruger vi et Wikipedia-indeks til rådighed på datasæt for Hugging Face. For at søge i Wikipedia-dokumenterne efter relevant tekst, skal indekset downloades fra Hugging Face, fordi det ikke er pakket andre steder. Det

wikipedia_prepare.pyfilen er ansvarlig for at håndtere download, når den importeres. Kun en enkelt proces i multiplen, der kører for inferens, kan klone depotet. Resten venter, indtil filerne er til stede i det lokale filsystem. - wikipedia.py – Denne fil bruges til at søge i Wikipedia-indekset efter kontekstuelt relevante dokumenter. Inputforespørgslen er tokeniseret, og indlejringer oprettes ved hjælp af

mean_pooling. Vi beregner cosinus-lighedsafstandsmetrikker mellem forespørgselsindlejringen og Wikipedia-indekset for at hente kontekstuelt relevante Wikipedia-sætninger. Henvise tilwikipedia.pyfor implementeringsdetaljer.

- samtale.py – Denne fil bruges til at gemme og hente samtaletråden i DynamoDB til videregivelse til modellen og brugeren.

conversation.pyer tilpasset fra open-source OpenChatKit-lageret. Denne fil er ansvarlig for at definere det objekt, der gemmer samtaledrejningerne mellem mennesket og modellen. Hermed er modellen i stand til at beholde en session for samtalen, så en bruger kan henvise til tidligere beskeder. Fordi SageMaker-endepunktkaldelser er statsløse, skal denne samtale gemmes et sted uden for slutpunktforekomsterne. Ved opstart opretter instansen en DynamoDB-tabel, hvis den ikke eksisterer. Alle opdateringer til samtalen gemmes derefter i DynamoDB baseret påsession_idnøgle, som genereres af slutpunktet. Enhver påkaldelse med et sessions-id vil hente den tilknyttede samtalestreng og opdatere den efter behov.

Byg en LMI-inferenscontainer med tilpassede afhængigheder

Indekssøgningen bruger Facebooks Faiss bibliotek til at udføre lighedssøgningen. Fordi dette ikke er inkluderet i basis-LMI-billedet, skal containeren tilpasses for at installere dette bibliotek. Den følgende kode definerer en Dockerfile, der installerer Faiss fra kilden sammen med andre biblioteker, der er nødvendige for bot-slutpunktet. Vi bruger sm-docker værktøj til at bygge og skubbe billedet til Amazon Elastic Container Registry (Amazon ECR) fra Amazon SageMaker Studio. Henvise til Brug af Amazon SageMaker Studio Image Build CLI til at bygge containerbilleder fra dine Studio-notesbøger for flere detaljer.

DJL-containeren har ikke Conda installeret, så Faiss skal klones og kompileres fra kilden. For at installere Faiss skal afhængighederne til brug af BLAS API'er og Python-understøttelse være installeret. Efter at disse pakker er installeret, er Faiss konfigureret til at bruge AVX2 og CUDA, før den kompileres med Python-udvidelserne installeret.

pandas, fastparquet, boto3og git-lfs installeres efterfølgende, fordi disse er nødvendige for at downloade og læse indeksfilerne.

Opret modellen

Nu hvor vi har Docker-billedet i Amazon ECR, kan vi fortsætte med at oprette SageMaker-modelobjektet til OpenChatKit-modellerne. Vi sætter ind GPT-NeoXT-Chat-Base-20B input og output moderering modeller ved hjælp af GPT-JT-Moderation-6B. Henvise til skabe_model for flere detaljer.

Konfigurer slutpunktet

Dernæst definerer vi slutpunktskonfigurationerne for OpenChatKit-modellerne. Vi implementerer modellerne ved hjælp af instanstypen ml.g5.12xlarge. Henvise til create_endpoint_config for flere detaljer.

Implementer slutpunktet

Til sidst opretter vi et endepunkt ved hjælp af den model og endepunktskonfiguration, vi definerede i de foregående trin:

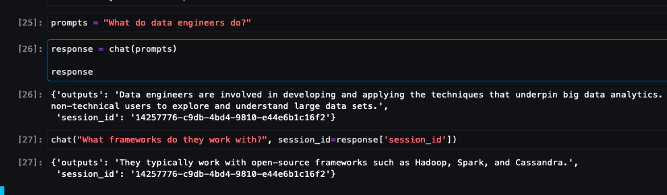

Kør inferens fra OpenChatKit-modeller

Nu er det tid til at sende slutningsanmodninger til modellen og få svarene. Vi sender inputtekstprompten og modelparametre som f.eks temperature, top_kog max_new_tokens. Kvaliteten af chatbot-svarene er baseret på de angivne parametre, så det anbefales at benchmarke modellens ydeevne i forhold til disse parametre for at finde den optimale indstilling til din brug. Input-prompten sendes først til inputmodereringsmodellen, og outputtet sendes til ChatModel at generere svarene. Under dette trin bruger modellen Wikipedia-indekset til at hente kontekstuelt relevante sektioner til modellen som en prompt for at få domænespecifikke svar fra modellen. Til sidst sendes modelsvaret til outputmodereringsmodellen for at tjekke for klassificering, og derefter returneres svarene. Se følgende kode:

Se eksempler på chatinteraktioner nedenfor.

Ryd op

Følg instruktionerne i oprydningssektionen for at slette de ressourcer, der er leveret som en del af dette indlæg for at undgå unødvendige gebyrer. Henvise til Amazon SageMaker-priser for detaljer om omkostningerne ved slutningstilfældene.

Konklusion

I dette indlæg diskuterede vi vigtigheden af open source LLM'er og hvordan man implementerer en OpenChatKit-model på SageMaker for at bygge næste generations chatbot-applikationer. Vi diskuterede forskellige komponenter i OpenChatKit-modeller, modereringsmodeller og hvordan man bruger en ekstern videnkilde som Wikipedia til retrieval augmented generation (RAG) arbejdsgange. Du kan finde trin-for-trin instruktioner i GitHub notesbog. Fortæl os om de fantastiske chatbot-applikationer, du bygger. Skål!

Om forfatterne

Dhawal Patel er Principal Machine Learning Architect hos AWS. Han har arbejdet med organisationer lige fra store virksomheder til mellemstore startups om problemer relateret til distribueret computing og kunstig intelligens. Han fokuserer på Deep learning, herunder NLP og Computer Vision domæner. Han hjælper kunder med at opnå højtydende modelslutning på SageMaker.

Dhawal Patel er Principal Machine Learning Architect hos AWS. Han har arbejdet med organisationer lige fra store virksomheder til mellemstore startups om problemer relateret til distribueret computing og kunstig intelligens. Han fokuserer på Deep learning, herunder NLP og Computer Vision domæner. Han hjælper kunder med at opnå højtydende modelslutning på SageMaker.

Vikram Elango er Sr. AIML Specialist Solutions Architect hos AWS, baseret i Virginia, USA. Han er i øjeblikket fokuseret på generativ AI, LLM'er, prompt engineering, optimering af store modelslutninger og skalering af ML på tværs af virksomheder. Vikram hjælper finans- og forsikringsbranchens kunder med design og tankelederskab med at bygge og implementere maskinlæringsapplikationer i stor skala. I sin fritid nyder han at rejse, vandre, lave mad og campere med sin familie.

Vikram Elango er Sr. AIML Specialist Solutions Architect hos AWS, baseret i Virginia, USA. Han er i øjeblikket fokuseret på generativ AI, LLM'er, prompt engineering, optimering af store modelslutninger og skalering af ML på tværs af virksomheder. Vikram hjælper finans- og forsikringsbranchens kunder med design og tankelederskab med at bygge og implementere maskinlæringsapplikationer i stor skala. I sin fritid nyder han at rejse, vandre, lave mad og campere med sin familie.

Andrew Smith er en Cloud Support Engineer i SageMaker, Vision & Other-teamet hos AWS, baseret i Sydney, Australien. Han støtter kunder, der bruger mange AI/ML-tjenester på AWS med ekspertise i at arbejde med Amazon SageMaker. Uden for arbejdet nyder han at bruge tid sammen med venner og familie samt lære om forskellige teknologier.

Andrew Smith er en Cloud Support Engineer i SageMaker, Vision & Other-teamet hos AWS, baseret i Sydney, Australien. Han støtter kunder, der bruger mange AI/ML-tjenester på AWS med ekspertise i at arbejde med Amazon SageMaker. Uden for arbejdet nyder han at bruge tid sammen med venner og familie samt lære om forskellige teknologier.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- EVM Finans. Unified Interface for Decentralized Finance. Adgang her.

- Quantum Media Group. IR/PR forstærket. Adgang her.

- PlatoAiStream. Web3 Data Intelligence. Viden forstærket. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/build-custom-chatbot-applications-using-openchatkit-models-on-amazon-sagemaker/

- :har

- :er

- :ikke

- :hvor

- $OP

- 1

- 10

- 100

- 11

- 14

- 15 %

- 17

- 195

- 20

- 2023

- 30

- 40

- 7

- 8

- a

- evne

- I stand

- Om

- fremskynde

- adgang

- nøjagtighed

- præcist

- opnå

- tværs

- Yderligere

- Derudover

- adresse

- fremskreden

- Efter

- bagefter

- mod

- AI

- ai use cases

- AI / ML

- AIML

- tilpasse

- Alle

- tillade

- tillader

- sammen

- langs med

- også

- Skønt

- forbløffende

- Amazon

- Amazon SageMaker

- Amazon SageMaker Studio

- Amazon Web Services

- an

- analysere

- ,

- besvare

- svar

- enhver

- api

- API'er

- Anvendelse

- applikationer

- Indløs

- APT

- arkitektur

- arkiv

- ER

- artikler

- kunstig

- kunstig intelligens

- AS

- forbundet

- At

- augmented

- Australien

- automatisk

- til rådighed

- undgå

- AWS

- bund

- baseret

- Baseline

- BE

- fordi

- bliver

- bliver

- før

- være

- jf. nedenstående

- benchmark

- mellem

- fordomme

- BIN

- Blocks

- krop

- Bot

- både

- bygge

- Bygning

- bygget

- byrde

- virksomhed

- Business Applications

- by

- ringe

- CAN

- Kapacitet

- kulstof

- tilfælde

- tilfælde

- CD

- afgifter

- chatbot

- chatbots

- kontrollere

- klasse

- klasser

- klassificering

- Klassificere

- lukket

- Cloud

- CO

- kode

- samarbejde

- samfund

- Virksomheder

- Compliance

- komponenter

- omfattende

- Compute

- computer

- Computer Vision

- computing

- Bekymringer

- Konfiguration

- konfigureret

- indeholder

- Container

- Beholdere

- indeholder

- indhold

- sammenhæng

- bidrage

- kontrol

- kontrol

- Samtale

- samtaler

- Tilsvarende

- Koste

- skabe

- oprettet

- skaber

- Oprettelse af

- kriterier

- Nuværende

- For øjeblikket

- skik

- Kunder

- tilpasse

- tilpassede

- data

- datasæt

- dyb

- dyb læring

- definerede

- definerer

- definere

- Degree

- krav

- demokratisering

- demonstrere

- demonstrerer

- afhænger

- indsætte

- implementering

- Design

- konstrueret

- detaljer

- udviklere

- udvikling

- Enheder

- forskellige

- svært

- vanskeligheder

- diskutere

- drøftet

- afstand

- distribueret

- distribueret computing

- do

- Docker

- dokumentet

- dokumentation

- dokumenter

- gør

- Er ikke

- domæne

- Domæner

- Dont

- downloade

- downloads

- i løbet af

- dynamisk

- hver

- andet

- andetsteds

- indlejring

- selvstændige

- muliggør

- muliggør

- tilskynder

- Endpoint

- håndhæve

- Engine (Motor)

- ingeniør

- Engineering

- virksomheder

- Hele

- indrejse

- væsentlig

- etisk

- NOGENSINDE

- eksempel

- eksisterer

- forventer

- ekspertise

- udvidelser

- ekstern

- ekstremt

- Ansigtet

- familie

- Mode

- File (Felt)

- Filer

- filtrere

- filtrering

- Endelig

- finansielle

- finansielle nyheder

- finansielle produkter

- Finde

- Fornavn

- Markeret

- fokuserede

- fokuserer

- fokusering

- følger

- efter

- følger

- Til

- format

- Foster

- fire

- venner

- fra

- fuldt ud

- funktionalitet

- generelle formål

- generere

- genereret

- genererer

- generation

- generative

- Generativ AI

- få

- Git

- given

- godt

- GPU

- GPU'er

- Håndterer

- Håndtering

- Hardware

- Have

- he

- hjælper

- Høj

- Høj ydeevne

- hans

- host

- hostede

- Hosting

- Hvordan

- How To

- HTML

- http

- HTTPS

- KrammerFace

- menneskelig

- ID

- identificere

- if

- illustrerer

- billede

- billeder

- implementering

- redskaber

- importere

- betydning

- vigtigt

- in

- medtaget

- Herunder

- indarbejde

- stigende

- indeks

- angiver

- angiver

- industrier

- industrien

- oplysninger

- Innovation

- indgang

- indgange

- indvendig

- indsigt

- installere

- installeret

- instans

- anvisninger

- forsikring

- integrere

- Intelligens

- interaktioner

- interne

- indgriben

- ind

- investering

- investeringsanbefalinger

- involverede

- IT

- ITS

- selv

- Java

- jpg

- json

- Nøgle

- Kend

- viden

- Etiketter

- Sprog

- stor

- Store virksomheder

- Latency

- Leadership" (virkelig menneskelig ledelse)

- læring

- mindst

- Politikker

- lad

- Leverage

- biblioteker

- Bibliotek

- Licens

- ligesom

- GRÆNSE

- Liste

- Llama

- LLM

- belastninger

- lokale

- placering

- logik

- Lot

- Lav

- maskine

- machine learning

- lavet

- Main

- lave

- Making

- mange

- Marts

- Marked

- markedstemning

- Market Trends

- maske

- matchende

- Mød

- beskeder

- metoder

- Metrics

- million

- ML

- model

- modeller

- mådehold

- Moduler

- Overvåg

- mere

- flere

- navn

- Natural

- Natural Language Processing

- nødvendig

- Behov

- behov

- behov

- negativ

- nyheder

- næste generation

- NLP

- ingen

- notesbog

- nummer

- talrige

- objekt

- objekter

- forhindringer

- opnå

- of

- tilbyde

- on

- ONE

- kun

- open source

- optimal

- optimering

- Option

- Indstillinger

- or

- organisation

- organisationer

- OS

- Andet

- ud

- output

- uden for

- i løbet af

- overstyring

- egen

- pakke

- emballeret

- pakker

- pandaer

- papirer

- Parallel

- parameter

- parametre

- del

- passerer

- Bestået

- Passing

- sti

- Mønster

- ydeevne

- udfører

- perron

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- Populær

- mulig

- Indlæg

- potentiale

- strøm

- vigtigste

- forudsige

- Forudsigelser

- forberede

- præsentere

- forelagt

- tidligere

- Main

- problemer

- behandle

- forarbejdning

- producere

- Produkter

- Programmering

- egenskaber

- give

- forudsat

- giver

- leverer

- formål

- Skub ud

- Python

- pytorch

- kvalitet

- spørgsmål

- Spørgsmål

- rækkevidde

- spænder

- Læsning

- årsager

- modtager

- anbefalinger

- anbefales

- reducere

- relaterede

- frigivet

- relevant

- resterne

- bemærkelsesværdig

- Rapporter

- Repository

- anmode

- anmodninger

- påkrævet

- forskning

- forskere

- Ressourcer

- svar

- reaktioner

- ansvarlige

- REST

- begrænset

- resultere

- Resultater

- tilbageholde

- afkast

- Kør

- kører

- Sikkerhed

- sagemaker

- Scale

- skalering

- Søg

- søgning

- Sektion

- sektioner

- se

- send

- sendt

- dømme

- stemningen

- tjener

- tjener

- Tjenester

- servering

- Session

- sæt

- indstilling

- indstillinger

- bør

- Vis

- Simpelt

- siden

- enkelt

- betydelige

- Størrelse

- Snapshot

- So

- løsninger

- Løsninger

- nogle

- sofistikeret

- Kilde

- Kilder

- specialist

- specialiserede

- specifikke

- specificeret

- hastighed

- udgifterne

- påbegyndt

- opstart

- Nystartede

- Trin

- Steps

- standsning

- opbevaring

- opbevaret

- forhandler

- lagring

- String

- Studio

- Succesfuld

- sådan

- lider

- opsummere

- tilført

- leverer

- support

- Understøtter

- sydney

- systemet

- bord

- Opgaver

- opgaver

- hold

- teknikker

- Teknologier

- Teknologier

- at

- The Source

- deres

- Them

- derefter

- Der.

- derved

- derfor

- Disse

- denne

- tænkte

- tænkt lederskab

- kapacitet

- tid

- til

- sammen

- tokeniseret

- værktøjer

- uddannet

- Kurser

- Gennemsigtighed

- Traveling

- Tendenser

- sand

- vender

- to

- typen

- under

- forstå

- enestående

- Universal

- indtil

- Opdatering

- opdateret

- opdateringer

- uploadet

- us

- brug

- brug tilfælde

- anvendte

- Bruger

- brugere

- bruger

- ved brug af

- nytte

- værdi

- forskellige

- VICUNA

- Virginia

- vision

- vente

- ønsker

- we

- web

- webservices

- GODT

- Hvad

- hvornår

- som

- bred

- Bred rækkevidde

- Wikipedia

- vilje

- med

- uden

- Arbejde

- arbejdede

- arbejdstager

- arbejdere

- workflow

- arbejdsgange

- arbejder

- virker

- ville

- X

- Du

- Din

- zephyrnet