Introduktion

En gang imellem kan en person tage et abstrakt koncept, der tilsyneladende er for vagt til formel undersøgelse og tilbyde en elegant formel definition. Claude Shannon gjorde det med oplysninger, og Andrey Kolmogorov gjorde det med tilfældighed. I de sidste par år har forskere forsøgt at gøre det samme for begrebet retfærdighed i maskinlæring. Desværre har dette været sværere. Ikke alene er begrebet sværere at definere, men det er også umuligt for en enkelt definition at opfylde alle ønskelige retfærdighedsmålinger. Arvind Narayanan, en datalog ved Princeton University, har været medvirkende til at kontekstualisere forskellige synspunkter og hjælpe dette nye felt med at etablere sig.

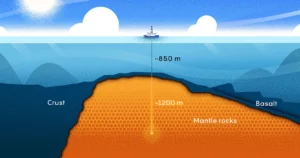

Hans karriere har spændt over alle abstraktionsniveauer, fra teori til politik, men rejsen, der til sidst førte til hans nuværende arbejde, begyndte i 2006. Det år sponsorerede Netflix en konkurrence, der ville uddele $1 million til den, der forbedrede nøjagtigheden af deres anbefalingssystem ved at 10 %. Netflix leverede et angiveligt anonymt datasæt af brugere og deres vurderinger, med personligt identificerbare oplysninger fjernet. Men Narayanan viste, at med en sofistikeret statistisk teknik behøver du kun nogle få datapunkter for at afsløre identiteten af en "anonym" bruger i datasættet.

Siden da har Narayanan fokuseret på andre områder, hvor teori møder praksis. Gennem Princeton Web Transparency and Accountability Project, afslørede hans team hemmelige måder, hvorpå websteder sporer brugere og udtrækker følsomme data. Hans team fandt ud af, at en gruppe som National Security Agency kunne bruge webbrowserdata (specifikt cookies placeret af tredjeparter) ikke kun til at opdage brugerens virkelige identitet, men også til at rekonstruere 62 % til 73 % af deres browserhistorik . Det viste de — at riffe på berømt New Yorker tegneserie — på internettet ved hjemmesider nu, at du er en hund.

I de seneste år har Narayanan henvendt sig specifikt til machine learning — en anvendelse af kunstig intelligens, der giver maskiner mulighed for at lære af data. Selvom han hilser fremskridt inden for kunstig intelligens velkommen, påpeger han, hvordan sådanne systemer kan fejle selv med gode intentioner, og hvordan disse ellers nyttige teknologier kan blive værktøjer til at retfærdiggøre diskrimination. I dette lys danner de tilsyneladende usammenhængende prikker, der har defineret Narayanans forskningsbane, en slags konstellation.

Quanta talte med Narayanan om hans arbejde med afanonymisering, vigtigheden af statistisk intuition og de mange faldgruber ved AI-systemer. Interviewet er blevet komprimeret og redigeret for klarhedens skyld.

Introduktion

Har du altid ønsket at forske i matematik og naturvidenskab?

Jeg er vokset op meget interesseret i begge dele, men primært i matematik. Jeg var god til at løse gåder og havde endda en vis succes ved den internationale matematiske olympiade. Men jeg havde en kæmpe misforståelse om forskellen mellem gådeløsning og forskning i matematik.

Og så tidligt fokuserede jeg min forskning på kryptografi, især teoretisk kryptografi, fordi jeg stadig arbejdede under den vrangforestilling, at jeg var meget god til matematik. Og så har resten af min karriere været en rejse for at indse, at det faktisk slet ikke er min styrke.

Det må have fungeret som en god baggrund for dit afanonymiseringsarbejde.

Du har ret. Det, der tillod de-anonymiseringsforskningen, er den færdighed, jeg kalder statistisk intuition. Det er faktisk ikke formel matematisk viden. Det er at være i stand til at have en intuition i dit hoved som: "Hvis jeg tager dette komplekse datasæt og anvender denne transformation på det, hvad er et plausibelt resultat?"

Intuitionen kan ofte være forkert, og det er OK. Men det er vigtigt at have intuition, fordi den kan guide dig mod veje, der kan være frugtbare.

Introduktion

Hvordan hjalp statistisk intuition med dit arbejde med Netflix-dataene?

Jeg havde forsøgt at udtænke en anonymiseringsordning for højdimensionelle data. Det mislykkedes fuldstændig, men i processen med at fejle havde jeg udviklet den intuition, at højdimensionelle data ikke kan anonymiseres effektivt. Selvfølgelig hævdede Netflix, med deres konkurrence, at have gjort præcis det.

Jeg havde min naturlige skepsis over for virksomheders markedsføringserklæringer, så jeg var motiveret til at bevise, at de var forkerte. Min rådgiver, Vitaly Shmatikov, og jeg arbejdede på det i et par intense uger. Da vi indså, at arbejdet virkelig havde en indflydelse, begyndte jeg at gøre mere.

Hvad var den samlede effekt? Hørte du tilbage fra Netflix og andre virksomheder, hvis data viste sig at være knap så anonyme?

Nå, en positiv effekt er, at det ansporede videnskaben om forskelligt privatliv. Men i forhold til hvordan virksomhederne reagerede, har der været et par forskellige reaktioner. I mange tilfælde gør virksomheder, der ellers ville have frigivet datasæt til offentligheden, det nu ikke længere - de våbengør privatlivets fred som en måde at bekæmpe gennemsigtighedsindsatsen.

Facebook er kendt for at gøre dette. Når forskere går til Facebook og siger: "Vi har brug for adgang til nogle af disse data for at studere, hvordan information udbredes på platformen," kan Facebook nu sige: "Nej, det kan vi ikke give dig. Det vil kompromittere vores brugeres privatliv."

Du skrev engang en papir argumenterer for, at udtrykket "personligt identificerbare oplysninger" kan være vildledende. Hvordan det?

Jeg tror, at der er forvirring blandt politikere, der skyldes to forskellige måder, hvorpå udtrykket bruges. Den ene er oplysninger om dig, der er meget følsomme, såsom dit cpr-nummer. En anden betydning er information, der kan indekseres i nogle datasæt og derved bruges til at finde mere information om dig.

Disse to har forskellige betydninger. Jeg har ingen beef med begrebet PII i første forstand. Visse oplysninger om personer er meget følsomme, og vi bør behandle dem mere omhyggeligt. Men selvom din e-mailadresse ikke nødvendigvis er særlig følsom for de fleste, er det stadig en unik identifikator, der kan bruges til at finde dig i andre datasæt. Så længe kombinationen af attributter om en person er tilgængelig for alle andre i verden, er det alt hvad du behøver for at afanonymisere.

Introduktion

Hvordan kom du til at studere retfærdighed?

Jeg underviste i et fairness and machine learning kursus i 2017. Det gav mig en god idé om de åbne problemer på området. Og sammen med det holdt jeg et foredrag, der hed "21 Retfærdighedsdefinitioner og deres politik." Jeg forklarede, at udbredelsen af tekniske definitioner ikke var på grund af tekniske årsager, men fordi der er ægte moralske spørgsmål i hjertet af alt dette. Der er ingen måde, du kan have ét enkelt statistisk kriterium, der fanger alle normative ønsker - alle de ting, du ønsker. Foredraget blev godt modtaget, så de to sammen overbeviste mig om, at jeg skulle begynde at komme ind på dette emne.

Også dig holdt en tale på at detektere AI slangeolie, hvilket også blev godt modtaget. Hvordan hænger det sammen med retfærdighed i maskinlæring?

Så motivationen for dette var, at der helt klart sker en masse ægte teknisk innovation i AI, som tekst-til-billede programmet DALL E 2 eller skakprogrammet Alpha Zero. Det er virkelig fantastisk, at denne udvikling er gået så hurtigt. Meget af den innovation fortjener at blive fejret.

Problemet kommer, når vi bruger denne meget løse og brede paraplybetegnelse "AI" for sådanne ting såvel som mere fyldte applikationer, såsom statistiske metoder til forudsigelse af kriminel risiko. I den sammenhæng er typen af teknologi meget forskellig. Det er to meget forskellige slags applikationer, og de potentielle fordele og skader er også meget forskellige. Der er næsten ingen forbindelse overhovedet mellem dem, så at bruge det samme udtryk for begge er grundigt forvirrende.

Folk bliver vildledt til at tro, at alle disse fremskridt, de ser med billedgenerering, faktisk vil omsættes til fremskridt mod sociale opgaver som at forudsige kriminel risiko eller forudsige, hvilke børn der vil droppe ud af skolen. Men det er slet ikke tilfældet. Først og fremmest kan vi kun gøre lidt bedre end tilfældige chancer til at forudsige, hvem der kan blive anholdt for en forbrydelse. Og den nøjagtighed opnås med virkelig enkle klassificeringer. Det bliver ikke bedre med tiden, og det bliver ikke bedre, efterhånden som vi indsamler flere datasæt. Så alle disse observationer står i modsætning til brugen af deep learning til for eksempel billedgenerering.

Hvordan vil du skelne mellem forskellige typer maskinlæringsproblemer?

Dette er ikke en udtømmende liste, men der er tre almindelige kategorier. Den første kategori er perception, som omfatter opgaver som at beskrive indholdet af et billede. Den anden kategori er, hvad jeg kalder "automatisering af dømmekraft", såsom når Facebook vil bruge algoritmer til at bestemme, hvilken tale der er for giftig til at forblive på platformen. Og den tredje er at forudsige fremtidige sociale udfald blandt mennesker - om nogen ville blive arresteret for en forbrydelse, eller hvis et barn vil droppe ud af skolen.

I alle tre tilfælde er de opnåelige nøjagtigheder meget forskellige, de potentielle farer ved unøjagtig AI er meget forskellige, og de etiske implikationer, der følger, er meget forskellige.

For eksempel er ansigtsgenkendelse i min klassifikation et opfattelsesproblem. Mange mennesker taler om, at ansigtsgenkendelse er unøjagtig, og nogle gange har de ret. Men jeg tror ikke, det skyldes, at der er grundlæggende grænser for nøjagtigheden af ansigtsgenkendelse. Den teknologi er blevet forbedret, og den bliver bedre. Det er netop derfor, vi bør være bekymrede over det fra et etisk perspektiv - når du lægger det i hænderne på politiet, som måske er uansvarlige, eller stater, der ikke er gennemsigtige omkring brugen af det.

Introduktion

Hvad gør sociale forudsigelsesproblemer så meget sværere end opfattelsesproblemer?

Perceptionsproblemer har et par karakteristika. For det første er der ingen tvetydighed om, hvorvidt der er en kat i et billede. Så du har grundsandheden. For det andet har du stort set ubegrænset træningsdata, fordi du kan bruge alle billederne på nettet. Og hvis du er Google eller Facebook, kan du bruge alle de billeder, som folk har uploadet til din app. Så disse to faktorer - manglen på tvetydighed og datatilgængelighed - gør det muligt for klassifikatorer at fungere rigtig godt.

Det er forskelligt fra forudsigelsesproblemer, som ikke har disse to karakteristika. Der er en tredje forskel, jeg bør nævne, som i en vis forstand er den vigtigste: De moralske konsekvenser af at sætte disse forudsigelsesmodeller i værk er meget forskellige fra at bruge et sprogoversættelsesværktøj på din telefon eller et billedmærkningsværktøj.

Men det er ikke den samme alvor som det værktøj, der blev brugt til at afgøre, om nogen skal f.eks. tilbageholdes før retssagen. Det har konsekvenser for folks frihed. Så ironien er, at det område, hvor AI fungerer dårligst, ikke er blevet bedre over tid, og det er usandsynligt, at det forbedres i fremtiden, er det område, der har alle disse utroligt vigtige konsekvenser.

Meget af dit arbejde har krævet at tale med eksperter uden for dit felt. Hvordan er det at samarbejde med andre på denne måde?

Tværfaglige samarbejder har været nogle af de mest fornøjelige samarbejder. Jeg tror, at et sådant samarbejde vil have sine frustrerende øjeblikke, fordi folk ikke taler det samme sprog.

Min opskrift på det er: kultur, så sprog, så substans. Hvis du ikke forstår deres kultur - såsom hvilken slags stipendium de værdsætter - bliver det virkelig svært. Hvad der er værdifuldt for én person, kan virke irrelevant for en anden. Så de kulturelle aspekter skal navigeres først. Så kan man begynde at etablere et fælles sprog og ordforråd og endelig komme til substansen i samarbejdet.

Hvor optimistisk er du med hensyn til, om vi sikkert og klogt kan tage ny teknologi i brug?

En del af problemet er et vidensgab. Beslutningstagere, offentlige myndigheder, virksomheder og andre mennesker, der køber disse AI-værktøjer, erkender muligvis ikke de alvorlige grænser for forudsigelig nøjagtighed.

Men i sidste ende tror jeg, det er et politisk problem. Nogle mennesker ønsker at reducere omkostningerne, så de vil have et automatiseret værktøj, som eliminerer job. Så der er et meget stærkt pres for at tro på, hvad end disse leverandører siger om deres forudsigelsesværktøjer.

Det er to forskellige problemer. Folk som mig kan måske hjælpe med at løse informationskløften. Men at løse det politiske problem kræver aktivisme. Det kræver, at vi udnytter den demokratiske proces. Det er godt at se, at der er mange, der gør det. Og i det lange løb tror jeg, at vi kan skubbe tilbage mod de skadelige og misbrugende anvendelser af AI. Jeg tror ikke, det kommer til at ændre sig på et øjeblik, men gennem en lang, langtrukken, langvarig aktivismeproces, der allerede har stået på i et årti eller mere. Jeg er sikker på, at det vil fortsætte i lang tid.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://www.quantamagazine.org/he-protects-privacy-and-ai-fairness-with-statistics-20230310/

- :er

- ][s

- $ 1 millioner

- $OP

- 2017

- a

- evne

- I stand

- Om

- om det

- ABSTRACT

- adgang

- ansvarlighed

- nøjagtighed

- opnået

- ACM

- Handling

- Aktivisme

- faktisk

- adresse

- adressering

- vedtage

- fremskridt

- Fordel

- mod

- agenturer

- agentur

- AI

- algoritmer

- Alle

- allerede

- altid

- forbløffende

- tvetydigheden

- blandt

- ,

- anonym

- En anden

- nogen

- app

- Anvendelse

- applikationer

- Indløs

- ER

- OMRÅDE

- områder

- anholdt

- kunstig

- kunstig intelligens

- AS

- aspekter

- At

- attributter

- Automatiseret

- tilgængelighed

- til rådighed

- tildeling

- tilbage

- baggrund

- BE

- fordi

- bliver

- Oksekød

- begyndte

- være

- Tro

- fordele

- Bedre

- mellem

- bred

- Browsing

- Købe

- by

- ringe

- kaldet

- CAN

- kan ikke

- fanger

- Karriere

- omhyggeligt

- tilfælde

- tilfælde

- KAT

- kategorier

- Boligtype

- fejret

- vis

- chance

- lave om

- karakteristika

- skak

- hævdede

- klarhed

- klassificering

- tydeligt

- samarbejde

- samarbejde

- samarbejder

- indsamler

- kombination

- Kom

- Fælles

- Virksomheder

- konkurrence

- fuldstændig

- komplekse

- kompromis

- computer

- Konceptet

- pågældende

- forvirrende

- forvirring

- tilslutning

- Konsekvenser

- indhold

- sammenhæng

- fortsæt

- kontrast

- cookies

- Omkostninger

- kunne

- Par

- Kursus

- Kriminalitet

- Criminal

- kryptografi

- kulturelle

- Medarbejder kultur

- Nuværende

- Klip

- reducere omkostningerne

- farer

- data

- datapunkter

- datasæt

- datasæt

- årti

- beslutningstagere

- dyb

- dyb læring

- definerede

- demokratisk

- fortjener

- tilbageholdt

- Bestem

- udviklet

- udtænke

- DID

- forskel

- forskellige

- forskellige problemer

- opdage

- skelne

- Dog

- gør

- Dont

- Drop

- Tidligt

- effektivt

- indsats

- eliminerer

- fornøjelig

- især

- væsentlige

- etablere

- oprettelse

- etisk

- Endog

- til sidst

- præcist nok

- eksperter

- forklarede

- ekstrakt

- Ansigtet

- ansigtsgenkendelse

- faktorer

- FAIL

- mislykkedes

- retfærdig

- fairness

- få

- felt

- kæmpe

- Endelig

- Finde

- Fornavn

- fokuserede

- følger

- Til

- formular

- formel

- fundet

- Frihed

- fra

- frustrerende

- fundamental

- fremtiden

- kløft

- generation

- få

- få

- Giv

- giver

- Go

- gå

- godt

- Regering

- Ground

- gruppe

- vejlede

- hænder

- Happening

- Hård Ost

- skadelig

- skader

- Have

- have

- hoved

- høre

- Hjerte

- hjælpe

- hjælpe

- historie

- Hvordan

- HTTPS

- kæmpe

- i

- idé

- identifikator

- Identity

- billede

- billeder

- KIMOs Succeshistorier

- implikationer

- betydning

- vigtigt

- umuligt

- Forbedre

- forbedret

- forbedring

- in

- I andre

- forkert

- omfatter

- utroligt

- oplysninger

- Innovation

- instans

- øjeblikkelig

- medvirkende

- Intelligens

- intentioner

- interesseret

- internationalt

- Internet

- Interview

- involverede

- spørgsmål

- IT

- ITS

- selv

- Karriere

- rejse

- Barn

- børn

- Venlig

- Kend

- viden

- kendt

- mærkning

- Mangel

- Sprog

- LÆR

- læring

- Led

- niveauer

- lys

- ligesom

- grænser

- Liste

- Lang

- lang tid

- længere

- Lot

- maskine

- machine learning

- Maskiner

- maerker

- mange

- Marketing

- matematik

- matematiske

- betyder

- opfylder

- metoder

- Metrics

- måske

- million

- modeller

- Moments

- mere

- mest

- motiveret

- Motivation

- national

- national sikkerhed

- Natural

- nødvendigvis

- Behov

- Netflix

- Ny

- nummer

- of

- tilbyde

- Olie

- on

- ONE

- åbent

- Optimistisk

- Andet

- Andre

- Ellers

- Resultat

- uden for

- samlet

- parter

- forbi

- Mennesker

- folks

- opfattelsen

- Udfør

- måske

- person,

- Personligt

- perspektiv

- telefon

- stykker

- perron

- plato

- Platon Data Intelligence

- PlatoData

- plausibel

- punkter

- Police

- politik

- politiske beslutningstagere

- politisk

- positiv

- potentiale

- praksis

- præcist

- forudsige

- forudsigelse

- recept

- tryk

- primært

- Beskyttelse af personlige oplysninger

- Problem

- problemer

- behandle

- Program

- Progress

- Bevise

- forudsat

- offentlige

- Skub ud

- skub tilbage

- sætte

- Sætte

- Puslespil

- Quantamagazin

- Spørgsmål

- tilfældig

- hurtige

- ratings

- reaktioner

- virkelige verden

- gik op for

- realisere

- årsager

- modtaget

- nylige

- anerkendelse

- genkende

- Anbefaling

- frigivet

- forblive

- fjernet

- påkrævet

- Kræver

- forskning

- forsker

- forskere

- REST

- afsløre

- Risiko

- Kør

- sikkert

- samme

- Ordningen

- Skole

- Videnskab

- Videnskabsmand

- Anden

- sikkerhed

- se

- forstand

- følsom

- alvorlig

- sæt

- sæt

- bør

- Simpelt

- enkelt

- skepsis

- dygtighed

- So

- Social

- Løsning

- nogle

- Nogen

- sofistikeret

- tale

- specifikt

- tale

- Sponsoreret

- starte

- påbegyndt

- udsagn

- Stater

- statistiske

- Stadig

- styrke

- stærk

- Studere

- studere

- stof

- succes

- sådan

- systemet

- Systemer

- Tag

- Tal

- taler

- opgaver

- hold

- Teknisk

- Teknologier

- Teknologier

- vilkår

- at

- Området

- Fremtiden

- oplysninger

- verdenen

- deres

- Them

- teoretisk

- derved

- Disse

- ting

- Tænker

- Tredje

- tredje partier

- grundigt

- tre

- Gennem

- tid

- til

- sammen

- også

- værktøj

- værktøjer

- emne

- mod

- spor

- Kurser

- bane

- Transformation

- Oversætte

- Oversættelse

- Gennemsigtighed

- gennemsigtig

- behandle

- Drejede

- typer

- Ultimativt

- paraply

- under

- forstå

- enestående

- universitet

- ubegrænset

- uploadet

- us

- brug

- Bruger

- brugere

- Værdifuld

- værdi

- leverandører

- visninger

- Vej..

- måder

- web

- WebP

- websites

- uger

- Hilser velkommen

- GODT

- Hvad

- Hvad er

- hvorvidt

- som

- mens

- WHO

- hvem

- Wikipedia

- vilje

- med

- Arbejde

- arbejdede

- virker

- world

- ville

- Forkert

- år

- år

- Du

- Din

- youtube

- zephyrnet