I dette indlæg taler vi om, hvordan generativ AI ændrer den konverserende AI-industri ved at give nye kunde- og botbyggeroplevelser, og de nye funktioner i Amazon Lex der drager fordel af disse fremskridt.

Efterhånden som efterspørgslen efter konversations-AI fortsætter med at vokse, søger udviklere måder at forbedre deres chatbots med menneskelignende interaktioner og avancerede funktioner såsom FAQ-håndtering. Nylige gennembrud inden for generativ AI fører til betydelige forbedringer i naturlig sprogforståelse, der gør samtalesystemer mere intelligente. Ved at træne store neurale netværksmodeller på datasæt med billioner af tokens har AI-forskere udviklet teknikker, der gør det muligt for bots at forstå mere komplekse spørgsmål, give nuancerede og mere naturligt menneskelydende svar og håndtere en bred vifte af emner. Med disse nye generative AI-innovationer kan du skabe virtuelle assistenter, der føles mere naturlige, intuitive og hjælpsomme under tekst- eller stemmebaserede selvbetjeningsinteraktioner. De hurtige fremskridt inden for generativ AI bringer automatiserede chatbots og virtuelle assistenter væsentligt tættere på målet om at have virkelig intelligente, fritflydende samtaler. Med yderligere fremskridt inden for dyb læring og neurale netværksteknikker er samtalesystemer klar til at blive endnu mere fleksible, relaterbare og menneskelignende. Denne nye generation af AI-drevne assistenter kan give problemfri selvbetjeningsoplevelser på tværs af et væld af brugssager.

Hvordan Amazon Bedrock ændrer landskabet for konversations-AI

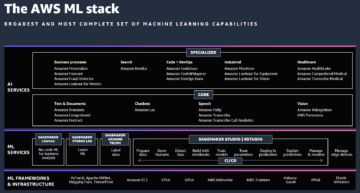

Amazonas grundfjeld er en brugervenlig måde at bygge og skalere generative AI-applikationer med grundlæggende modeller (FM'er). Amazon Bedrock tilbyder en række FM'er fra førende udbydere, så AWS-kunder har fleksibilitet og valgmuligheder til at bruge de bedste modeller til deres specifikke brugssituation.

I dagens hurtige verden forventer vi hurtig og effektiv kundeservice fra enhver virksomhed. At levere fremragende kundeservice kan dog være betydeligt udfordrende, når mængden af forespørgsler overstiger de menneskelige ressourcer, der bruges til at løse dem. Virksomheder kan overkomme denne udfordring effektivt, mens de også yder personlig kundeservice ved at drage fordel af fremskridt inden for generativ AI drevet af store sprogmodeller (LLM'er).

I årenes løb har AWS investeret i at demokratisere adgangen til – og forstærke forståelsen af – AI, machine learning (ML) og generativ AI. LLM'er kan være yderst nyttige i kontaktcentre ved at give automatiserede svar på ofte stillede spørgsmål, analysere kundestemninger og hensigter om at dirigere opkald på passende vis, generere opsummeringer af samtaler for at hjælpe agenter og endda automatisk generere e-mails eller chat-svar på almindelige kundeforespørgsler. Ved at håndtere gentagne opgaver og få indsigt fra samtaler giver LLM'er kontaktcenteragenter mulighed for at fokusere på at levere højere værdi gennem personlig service og løsning af komplekse problemer.

Forbedring af kundeoplevelsen med ofte stillede spørgsmål til samtale

Generativ AI har et enormt potentiale til at give hurtige, pålidelige svar på ofte stillede kundespørgsmål på en samtale måde. Med adgang til autoriserede videnskilder og LLM'er kan din eksisterende Amazon Lex-bot give nyttige, naturlige og præcise svar på ofte stillede spørgsmål, der går ud over opgaveorienteret dialog. Vores Retrieval Augmented Generation (RAG) tilgang gør det muligt for Amazon Lex at udnytte både bredden af viden, der er tilgængelig i repositories, såvel som flydende LLM'er. Du kan blot stille dit spørgsmål i frit, samtalesprog og modtage et naturligt, skræddersyet svar inden for få sekunder. Den nye samtale-FAQ-funktion i Amazon Lex giver botudviklere og samtaledesignere mulighed for at fokusere på at definere forretningslogik i stedet for at designe udtømmende FAQ-baserede samtalestrømme i en bot.

Vi introducerer et indbygget QnAIntent, der bruger en LLM til at forespørge efter en autoriseret videnkilde og give et meningsfuldt og kontekstuelt svar. Derudover kan udviklere konfigurere QnAIntent til at pege på specifikke videnbasesektioner, hvilket sikrer, at kun specifikke dele af videnindholdet forespørges på runtime for at opfylde brugeranmodninger. Denne kapacitet opfylder behovet for, at stærkt regulerede industrier, såsom finansielle tjenesteydelser og sundhedspleje, kun leverer svar på et kompatibelt sprog. Funktionen til samtale med ofte stillede spørgsmål i Amazon Lex giver organisationer mulighed for at forbedre indeslutningsraterne og samtidig undgå de høje omkostninger ved ubesvarede forespørgsler og menneskelige repræsentanter.

Opbygning af en Amazon Lex-bot ved hjælp af den beskrivende bot-builder

At bygge samtalebots fra bunden er en tidskrævende proces, der kræver dyb viden om, hvordan brugere interagerer med bots for at forudse potentielle anmodninger og kode passende svar. I dag bruger samtaledesignere og udviklere mange dage på at skrive kode for at hjælpe med at køre alle mulige brugerhandlinger (hensigter), de forskellige måder, brugere formulerer deres anmodninger på (ytringer), og de nødvendige oplysninger fra brugeren for at fuldføre disse handlinger (spillemaskiner).

Den nye beskrivende botbygningsfunktion i Amazon Lex bruger generativ AI til at accelerere botbygningsprocessen. I stedet for at skrive kode kan samtaledesignere og botudviklere nu beskrive på almindeligt engelsk, hvad de ønsker, at botten skal udrette (f.eks. "Tag reservationer til mit hotel ved hjælp af navn og kontaktoplysninger, rejsedatoer, værelsestype og betalingsoplysninger"). . Ved kun at bruge denne enkle prompt vil Amazon Lex automatisk generere hensigter, træningsudtalelser, slots, prompter og et samtaleflow for at bringe den beskrevne bot til live. Ved at levere et baseline-botdesign reducerer denne funktion enormt tiden og kompleksiteten ved at bygge samtale-chatbots, hvilket giver bygherren mulighed for at omprioritere indsatsen for at finjustere samtaleoplevelsen.

Ved at udnytte kraften i generativ AI med LLM'er gør Amazon Lex det muligt for udviklere og ikke-tekniske brugere at bygge bots blot ved at beskrive deres mål. I stedet for omhyggeligt at kode hensigter, ytringer, slots og så videre, kan udviklere give en naturlig sprogprompt, og Amazon Lex vil automatisk generere en grundlæggende bot-flow klar til yderligere forfining. Denne funktion er i første omgang kun tilgængelig på engelsk, men udviklere kan yderligere tilpasse den AI-genererede bot efter behov før implementering, hvilket sparer mange timers manuel udviklingsarbejde.

Forbedring af brugeroplevelsen med assisteret slotopløsning

Efterhånden som forbrugerne bliver mere fortrolige med chatbots og interaktive stemmesvar (IVR)-systemer, forventer de højere niveauer af intelligens, der er indbygget i selvbetjeningsoplevelser. At tvetydige svar, der er mere konversationsorienterede, er afgørende for succes, da brugerne forventer mere naturlige, menneskelignende oplevelser. Med stigende forbrugertillid til chatbot-funktioner er der også en forventning om øget ydeevne fra naturlig sprogforståelse (NLU). I det sandsynlige scenarie, hvor en semantisk simpel eller kompleks ytring ikke bliver løst korrekt til en slot, kan brugertilliden svinde. I sådanne tilfælde kan en LLM dynamisk assistere den eksisterende Amazon Lex NLU-model og sikre nøjagtig slotopløsning, selv når brugerudtalelsen er uden for grænserne for slotmodellen. I Amazon Lex giver den assisterede slot-opløsningsfunktion botudvikleren endnu et værktøj til at øge indeslutningen.

Under kørsel, når NLU undlader at løse et slot under en samtalesvending, ringer Amazon Lex til den LLM, der er valgt af botudvikleren for at hjælpe med at løse slot. Hvis LLM'en er i stand til at give en værdi ved genforsøg af slot, kan brugeren fortsætte med samtalen som normalt. For eksempel, hvis en bot spørger "Hvilken by bor forsikringstageren i?" og brugeren svarer "Jeg bor i Springfield", vil LLM være i stand til at løse værdien til "Springfield." De understøttede slottyper for denne funktion inkluderer AMAZON.City, AMAZON.Country, AMAZON.Number, AMAZON.Date, AMAZON.AlphaNumeric (uden regex) og AMAZON.PhoneNumber og AMAZON.Confirmation. Denne funktion er kun tilgængelig på engelsk i skrivende stund.

Forbedring af bygherrens oplevelse med træning af generering af ytringer

Et af de smertepunkter, som botbyggere og konversationsdesignere ofte støder på, er at forudse variationen og mangfoldigheden af svar, når de påberåber sig en hensigt eller anmoder om slotinformation. Når en botudvikler opretter en ny hensigt, skal der gives eksempler på ytringer for at træne ML-modellen i, hvilke typer svar den kan og bør acceptere. Det kan ofte være svært at forudse de permutationer på ordsprog og syntaks, som kunderne bruger. Med ytringsgenerering bruger Amazon Lex grundlæggende modeller som f.eks Amazon Titan at generere træningsytringer med blot et enkelt klik uden behov for nogen hurtig ingeniørarbejde.

Ytringsgenerering bruger hensigtsnavnet, eksisterende ytringer og eventuelt hensigtsbeskrivelsen til at generere nye ytringer med en LLM. Botudviklere og konversationsdesignere kan redigere eller slette de genererede ytringer, før de accepterer dem. Denne funktion fungerer med både nye og eksisterende hensigter.

Konklusion

Nylige fremskridt inden for generativ AI har uden tvivl gjort automatiserede forbrugeroplevelser bedre. Med Amazon Lex er vi forpligtet til at tilføre generativ kunstig intelligens i alle aspekter af byggeren og brugeroplevelsen. Funktionerne nævnt i dette indlæg er kun begyndelsen – og vi kan ikke vente med at vise dig, hvad der kommer.

For at lære mere, se Amazon Lex dokumentation, og prøv disse funktioner på Amazon Lex-konsollen.

Om forfatterne

Anuradha Durfee er en Senior Product Manager på Amazon Lex-teamet og har mere end 7 års erfaring i konversations-AI. Hun er fascineret af stemmebrugergrænseflader og at gøre teknologi mere tilgængelig gennem intuitivt design.

Anuradha Durfee er en Senior Product Manager på Amazon Lex-teamet og har mere end 7 års erfaring i konversations-AI. Hun er fascineret af stemmebrugergrænseflader og at gøre teknologi mere tilgængelig gennem intuitivt design.

Sandeep Srinivasan er Senior Product Manager på Amazon Lex-teamet. Som en skarp observatør af menneskelig adfærd brænder han for kundeoplevelse. Han tilbringer sine vågne timer i krydsfeltet mellem mennesker, teknologi og fremtiden.

Sandeep Srinivasan er Senior Product Manager på Amazon Lex-teamet. Som en skarp observatør af menneskelig adfærd brænder han for kundeoplevelse. Han tilbringer sine vågne timer i krydsfeltet mellem mennesker, teknologi og fremtiden.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/elevate-your-self-service-assistants-with-new-generative-ai-features-in-amazon-lex/

- :har

- :er

- :ikke

- 100

- 7

- a

- I stand

- Om

- fremskynde

- Acceptere

- acceptere

- adgang

- tilgængelig

- udrette

- præcis

- tværs

- aktioner

- Desuden

- adresse

- fremskreden

- fremskridt

- fremskridt

- Fordel

- midler

- AI

- AI-drevne

- Alle

- tillade

- tillade

- tillader

- også

- Amazon

- Amazon Lex

- Amazon Web Services

- amplificering

- an

- analysere

- ,

- En anden

- svar

- foregribe

- foregribe

- enhver

- applikationer

- tilgang

- passende

- passende

- ER

- Array

- AS

- spørg

- udseende

- hjælpe

- assistenter

- bistået

- At

- augmented

- autoriseret

- Automatiseret

- automatisk

- til rådighed

- undgå

- AWS

- bund

- Baseline

- grundlæggende

- BE

- bliver

- før

- adfærd

- BEDSTE

- Bedre

- Beyond

- Bot

- både

- bots

- bounds

- bredde

- gennembrud

- bringe

- Bringe

- bygge

- Builder

- bygherrer

- Bygning

- indbygget

- virksomhed

- virksomheder

- men

- by

- ringe

- Opkald

- CAN

- kapaciteter

- kapacitet

- tilfælde

- tilfælde

- center

- Centers

- udfordre

- udfordrende

- skiftende

- chatbot

- chatbots

- valg

- By

- klik

- tættere

- kode

- Kodning

- Kom

- engageret

- Fælles

- almindeligt

- fuldføre

- komplekse

- kompleksitet

- kompatibel

- tillid

- bekræftelse

- Konsol

- forbruger

- Forbrugere

- kontakt

- kontaktcenter

- Indeslutning

- indhold

- kontekstuelle

- fortsæt

- fortsætter

- Samtale

- konversation

- samtale AI

- samtaler

- Omkostninger

- land

- skabe

- skaber

- kunde

- Kundeoplevelse

- Kundeservice

- Kunder

- tilpasse

- datasæt

- Dato

- Datoer

- Dage

- dyb

- dyb læring

- definere

- leverer

- Efterspørgsel

- demokratisering

- implementering

- beskrive

- beskrevet

- beskriver

- beskrivelse

- Design

- designere

- designe

- udviklet

- Udvikler

- udviklere

- Udvikling

- Dialog

- svært

- Mangfoldighed

- gør

- i løbet af

- dynamisk

- effektiv

- effektivt

- indsats

- OPHØJE

- forhøjet

- emails

- selvstændige

- muliggør

- Engineering

- Engelsk

- forbedre

- sikre

- sikring

- Endog

- Hver

- eksempel

- fremragende

- eksisterende

- forvente

- forventning

- erfaring

- Oplevelser

- mislykkes

- bekendt

- FAQ

- hurtig

- Feature

- Funktionalitet

- føler sig

- finansielle

- finansielle tjenesteydelser

- Fleksibilitet

- fleksibel

- flow

- strømme

- Fokus

- Til

- grundlæggende

- hyppigt

- fra

- Opfylde

- yderligere

- fremtiden

- vinder

- generere

- genereret

- generere

- generation

- generative

- Generativ AI

- mål

- gå

- Grow

- håndtere

- Håndtering

- seletøj

- Have

- have

- he

- sundhedspleje

- hjælpe

- hjælpsom

- Høj

- højere

- stærkt

- hans

- holder

- Hotel

- HOURS

- Hvordan

- Men

- HTTPS

- menneskelig

- Human Resources

- if

- uhyre

- bydende nødvendigt

- Forbedre

- forbedringer

- in

- omfatter

- Forøg

- industrier

- industrien

- info

- oplysninger

- i første omgang

- innovationer

- Forespørgsler

- indsigt

- i stedet

- Intelligens

- Intelligent

- hensigt

- interagere

- interaktioner

- interaktiv

- grænseflader

- vejkryds

- ind

- indføre

- intuitiv

- investeret

- spørgsmål

- IT

- jpg

- lige

- bare en

- Keen

- viden

- landskab

- Sprog

- stor

- førende

- LÆR

- læring

- niveauer

- Livet

- Sandsynlig

- leve

- LLM

- logik

- maskine

- machine learning

- lavet

- lave

- Making

- leder

- måde

- manuel

- mange

- meningsfuld

- nævnte

- omhyggeligt

- savnet

- ML

- model

- modeller

- mere

- mangfoldighed

- skal

- my

- navn

- Natural

- Behov

- behov

- netværk

- neurale

- neurale netværk

- Ny

- Nye funktioner

- nlu

- ikke-teknisk

- normal

- nu

- nummer

- of

- Tilbud

- tit

- on

- ONE

- kun

- or

- ordrer

- organisationer

- vores

- ud

- Overvind

- Smerte

- lidenskabelige

- betaling

- Mennesker

- ydeevne

- Personlig

- Almindeligt

- plato

- Platon Data Intelligence

- PlatoData

- Punkt

- punkter

- klar

- politik

- mulig

- Indlæg

- potentiale

- magt

- strøm

- behandle

- Produkt

- produktchef

- Progress

- prompter

- korrekt

- give

- forudsat

- udbydere

- giver

- leverer

- forespørgsler

- spørgsmål

- Spørgsmål

- Hurtig

- rækkevidde

- hurtige

- priser

- hellere

- klar

- modtage

- nylige

- reducerer

- henvise

- regulært udtryk

- reguleret

- regulerede brancher

- pålidelig

- repetitiv

- repræsentativt

- anmodninger

- Kræver

- forskere

- Løsning

- løse

- løst

- løse

- Ressourcer

- svar

- reaktioner

- stigende

- Værelse

- R

- Kør

- runtime

- besparelse

- Scale

- scenarie

- ridse

- sømløs

- sekunder

- sektioner

- søger

- valgt

- Selvbetjening

- senior

- stemningen

- tjeneste

- Tjenester

- hun

- bør

- Vis

- signifikant

- betydeligt

- Simpelt

- ganske enkelt

- slot

- spillemaskiner

- So

- Kilde

- Kilder

- specifikke

- tilbringe

- succes

- sådan

- Understøttet

- syntaks

- Systemer

- skræddersyet

- Tag

- tager

- Tal

- aflytning

- opgaver

- hold

- teknikker

- Teknologier

- end

- at

- Fremtiden

- oplysninger

- Landskabet

- deres

- Them

- Der.

- Disse

- de

- denne

- dem

- Gennem

- tid

- tidskrævende

- til

- i dag

- nutidens

- Tokens

- værktøj

- Emner

- Tog

- Kurser

- overførsler

- rejse

- enorm

- billioner

- virkelig

- prøv

- TUR

- typen

- typer

- forstå

- forståelse

- utvivlsomt

- på

- brug

- brug tilfælde

- anvendte

- Bruger

- Brugererfaring

- brugervenlig

- brugere

- bruger

- ved brug af

- værdi

- forskellige

- Virtual

- Voice

- bind

- vente

- ønsker

- Vej..

- måder

- we

- web

- webservices

- GODT

- Hvad

- Hvad er

- hvornår

- som

- mens

- bred

- Bred rækkevidde

- vilje

- med

- inden for

- uden

- Arbejde

- virker

- world

- skrivning

- år

- endnu

- Du

- Din

- zephyrnet