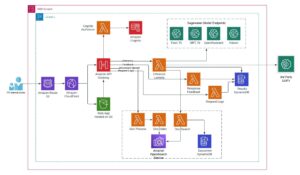

Amazon SageMaker er en fuldt administreret tjeneste, der gør det muligt for udviklere og datavidenskabsfolk hurtigt og nemt at bygge, træne og implementere maskinlæringsmodeller (ML) i stor skala. SageMaker gør det nemt at implementere modeller i produktionen direkte gennem API-kald til tjenesten. Modeller er pakket i containere til robuste og skalerbare implementeringer.

SageMaker tilbyder en række muligheder for at implementere modeller. Disse muligheder varierer i mængden af kontrol, du har, og det arbejde, der er nødvendigt i din ende. Det AWS SDK giver dig mest kontrol og fleksibilitet. Det er en lav-niveau API tilgængelig til Java, C++, Go, JavaScript, Node.js, PHP, Ruby og Python. Det SageMaker Python SDK er et Python API på højt niveau, der abstraherer nogle af trinene og konfigurationen og gør det nemmere at implementere modeller. AWS kommandolinjegrænseflade (AWS CLI) er et andet værktøj på højt niveau, som du kan bruge til interaktivt at arbejde med SageMaker for at implementere modeller uden at skrive din egen kode.

Vi lancerer to nye muligheder, der yderligere forenkler processen med at pakke og implementere modeller ved hjælp af SageMaker. En måde er til programmatisk implementering. Til det tilbyder vi forbedringer i Python SDK. For mere information, se Pak og implementer nemt klassiske ML og LLM'er med Amazon SageMaker, del 1: PySDK-forbedringer. Den anden måde er interaktiv implementering. Til det lancerer vi en ny interaktiv oplevelse i Amazon SageMaker Studio. Det vil hjælpe dig med hurtigt at implementere dine egne trænede eller grundlæggende modeller (FM'er) fra Amazon SageMaker JumpStart med optimeret konfiguration og opnå forudsigelig ydeevne til den laveste pris. Læs videre for at se, hvordan den nye interaktive oplevelse ser ud.

Ny interaktiv oplevelse i SageMaker Studio

Dette indlæg forudsætter, at du har trænet en eller flere ML-modeller eller bruger FM'er fra SageMaker JumpStart-modelhubben og er klar til at implementere dem. Træning af en model ved hjælp af SageMaker er ikke en forudsætning for at implementere model ved hjælp af SageMaker. En vis fortrolighed med SageMaker Studio forudsættes også.

Vi guider dig igennem, hvordan du gør følgende:

- Opret en SageMaker-model

- Implementer en SageMaker-model

- Implementer en SageMaker JumpStart large language model (LLM)

- Implementer flere modeller bag ét slutpunkt

- Test model inferens

- Fejlfinding af fejl

Opret en SageMaker-model

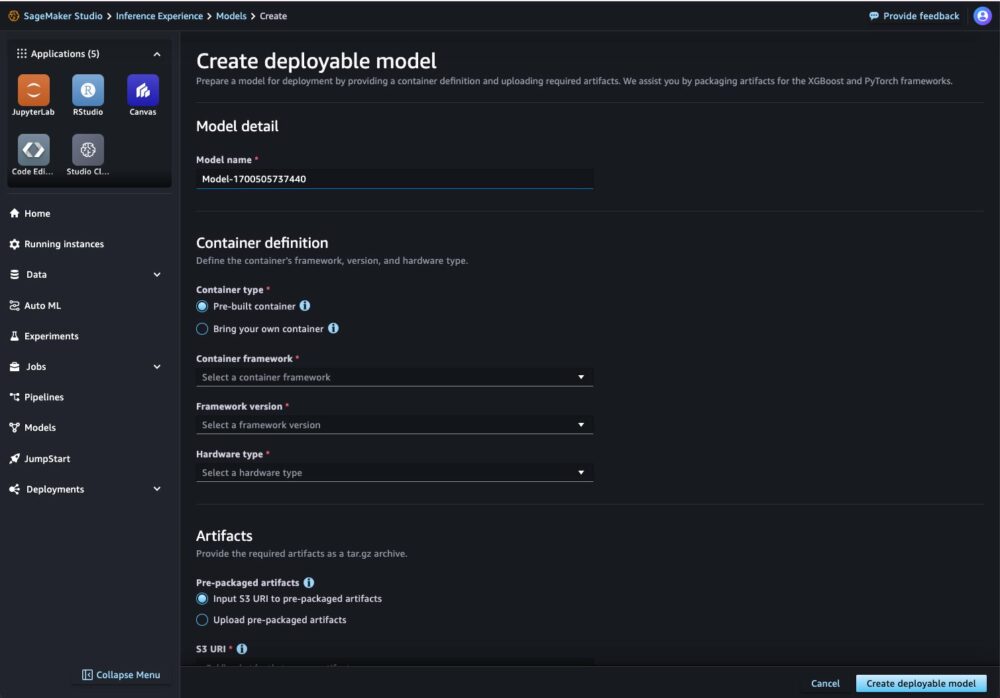

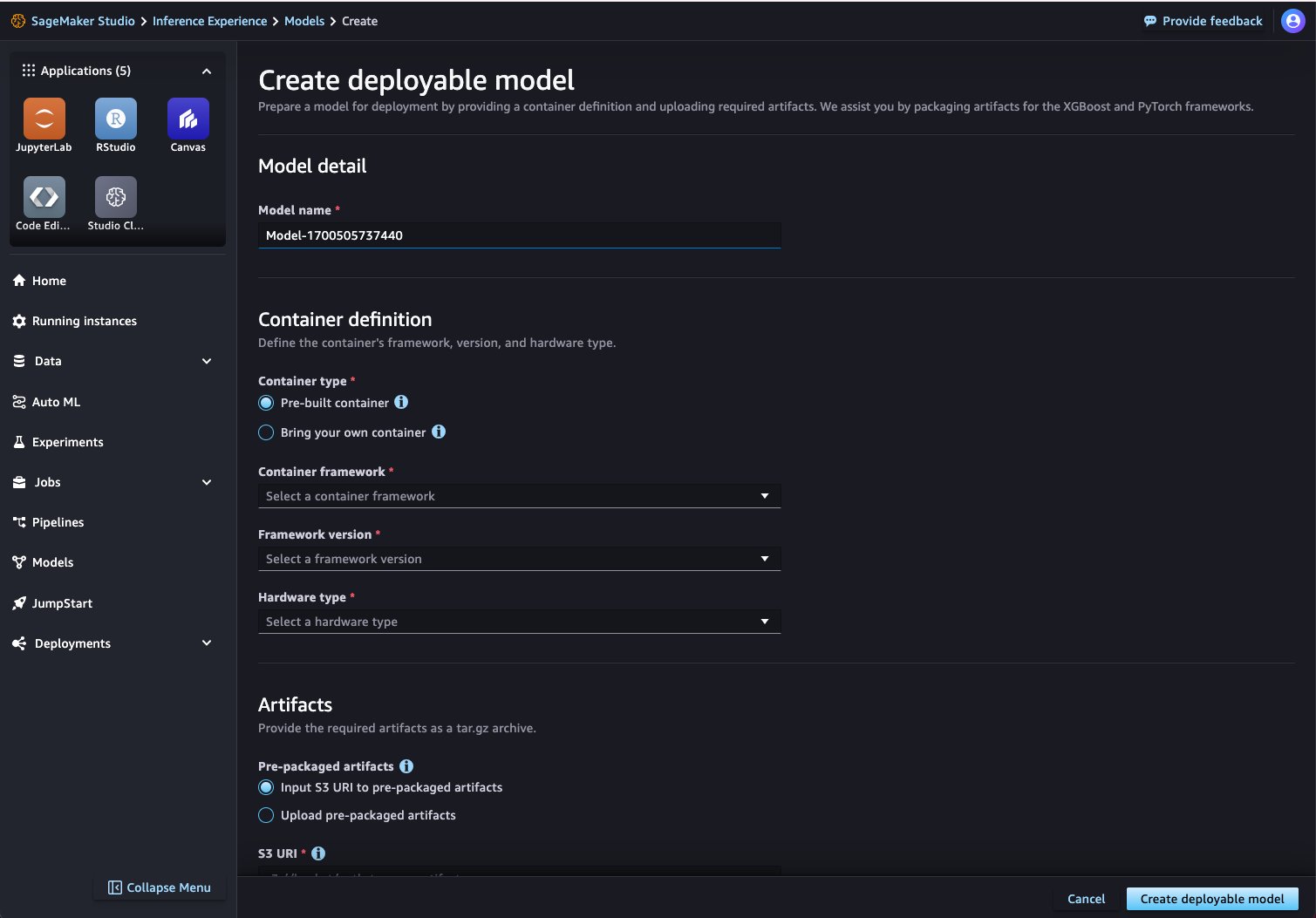

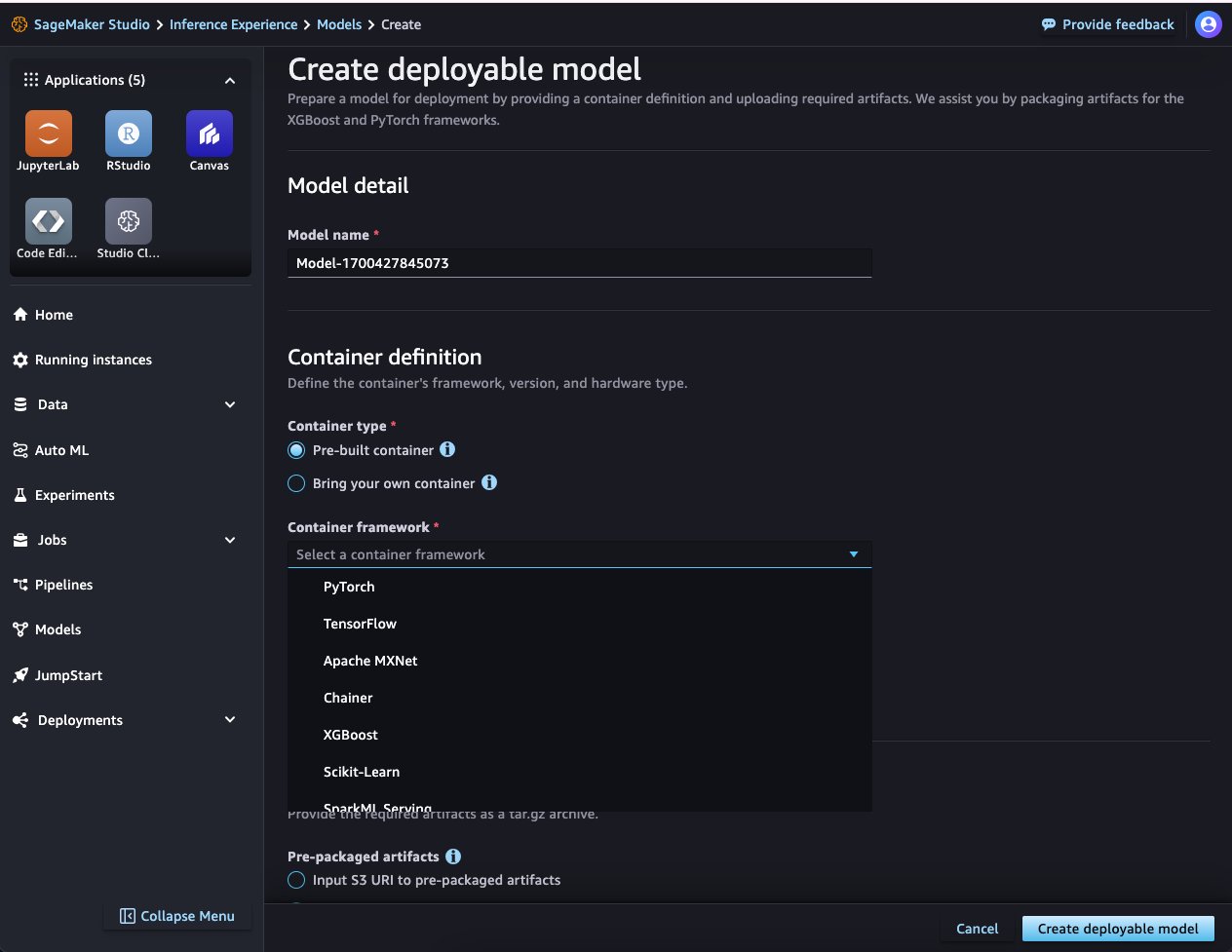

Det første trin i opsætningen af et SageMaker-slutpunkt til inferens er at oprette et SageMaker-modelobjekt. Dette modelobjekt består af to ting: en beholder til modellen og den trænede model, der vil blive brugt til at konkludere. Den nye interaktive UI-oplevelse gør SageMaker-modeloprettelsesprocessen ligetil. Hvis du er ny i SageMaker Studio, skal du se Udviklervejledning at komme i gang.

- Vælg i SageMaker Studio-grænsefladen Modeller i navigationsruden.

- På Deployerbare modeller fanebladet, vælg Opret.

Nu skal du blot angive modelbeholderdetaljerne, placeringen af dine modeldata og en AWS identitets- og adgangsstyring (IAM) rolle for SageMaker at påtage sig på dine vegne.

- Til modelbeholderen kan du bruge et af de forudbyggede SageMaker Docker-billeder, som det giver til populære rammer og biblioteker. Hvis du vælger at bruge denne mulighed, skal du vælge en containerramme, en tilsvarende rammeversion og en hardwaretype fra listen over understøttede typer.

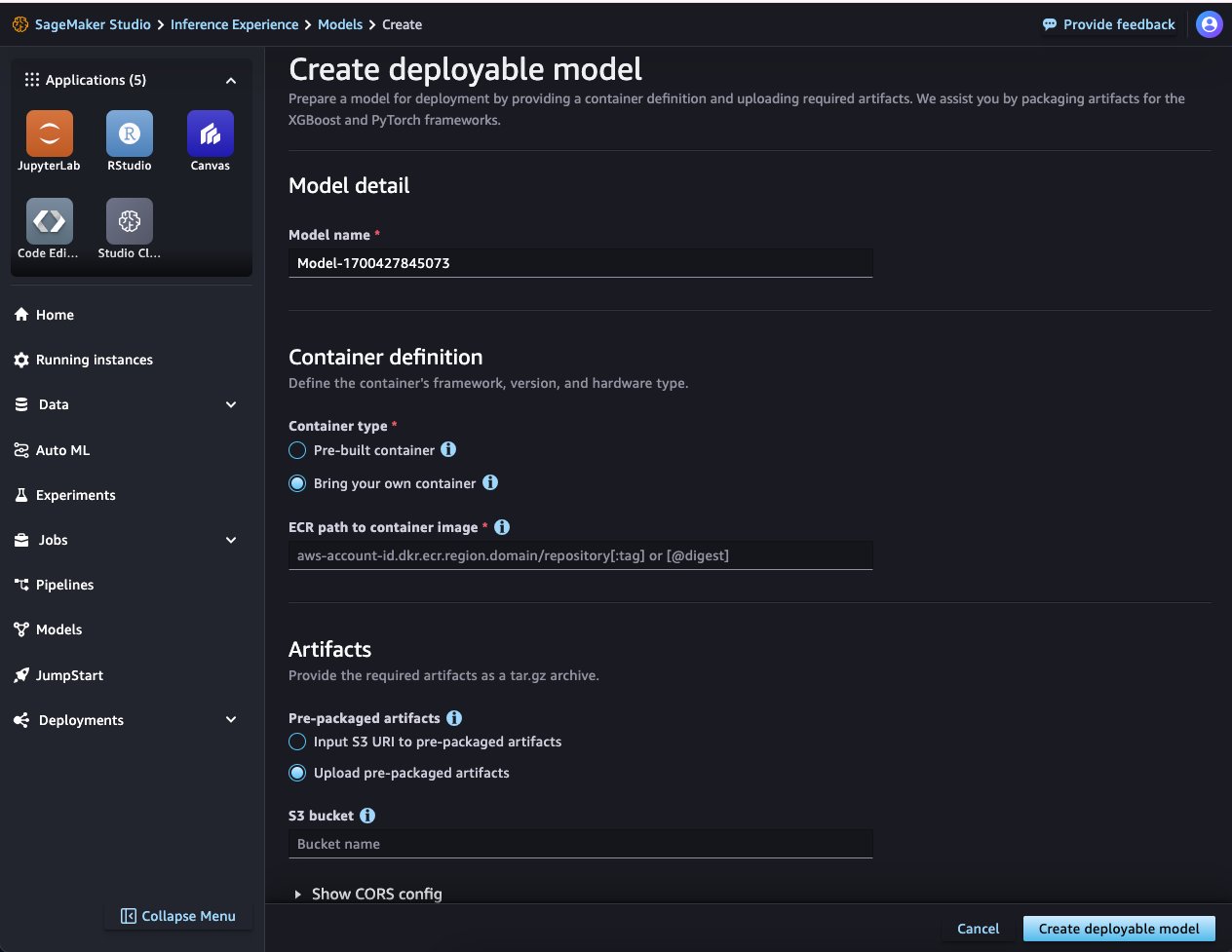

Alternativt kan du angive en sti til din egen container gemt i Amazon Elastic Container Registry (Amazon ECR).

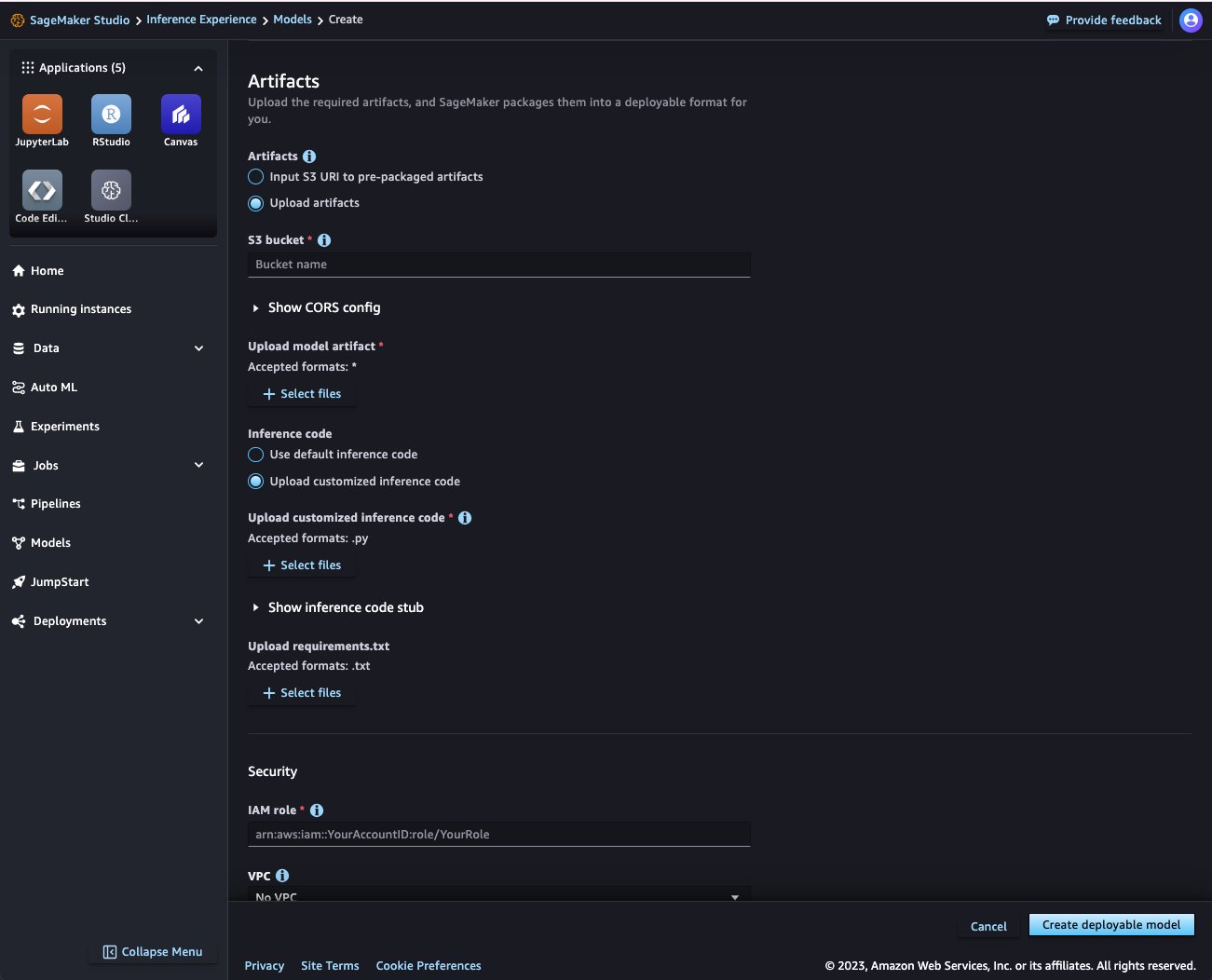

- Upload derefter dine modelartefakter. SageMaker Studio giver to måder at uploade modelartefakter på:

- Først kan du angive en

model.tar.gzenten i en Amazon Simple Storage Service (Amazon S3) spand eller i din lokale sti. Det hermodel.tar.gzskal være struktureret i et format, der er kompatibelt med den container, du bruger. - Alternativt understøtter det upload af rå artefakter til PyTorch- og XGBoost-modeller. For disse to rammer skal du angive modelartefakter i det format, containeren forventer. For PyTorch ville dette for eksempel være en

model.pth. Bemærk, at dine modelartefakter også inkluderer et slutningsscript til forbehandling og efterbehandling. Hvis du ikke angiver et inferensscript, implementeres standardinferensbehandlerne for den container, du har valgt.

- Først kan du angive en

- Når du har valgt din beholder og artefakt, skal du angive en IAM-rolle.

- Vælg Opret en implementeringsmodel at skabe en SageMaker-model.

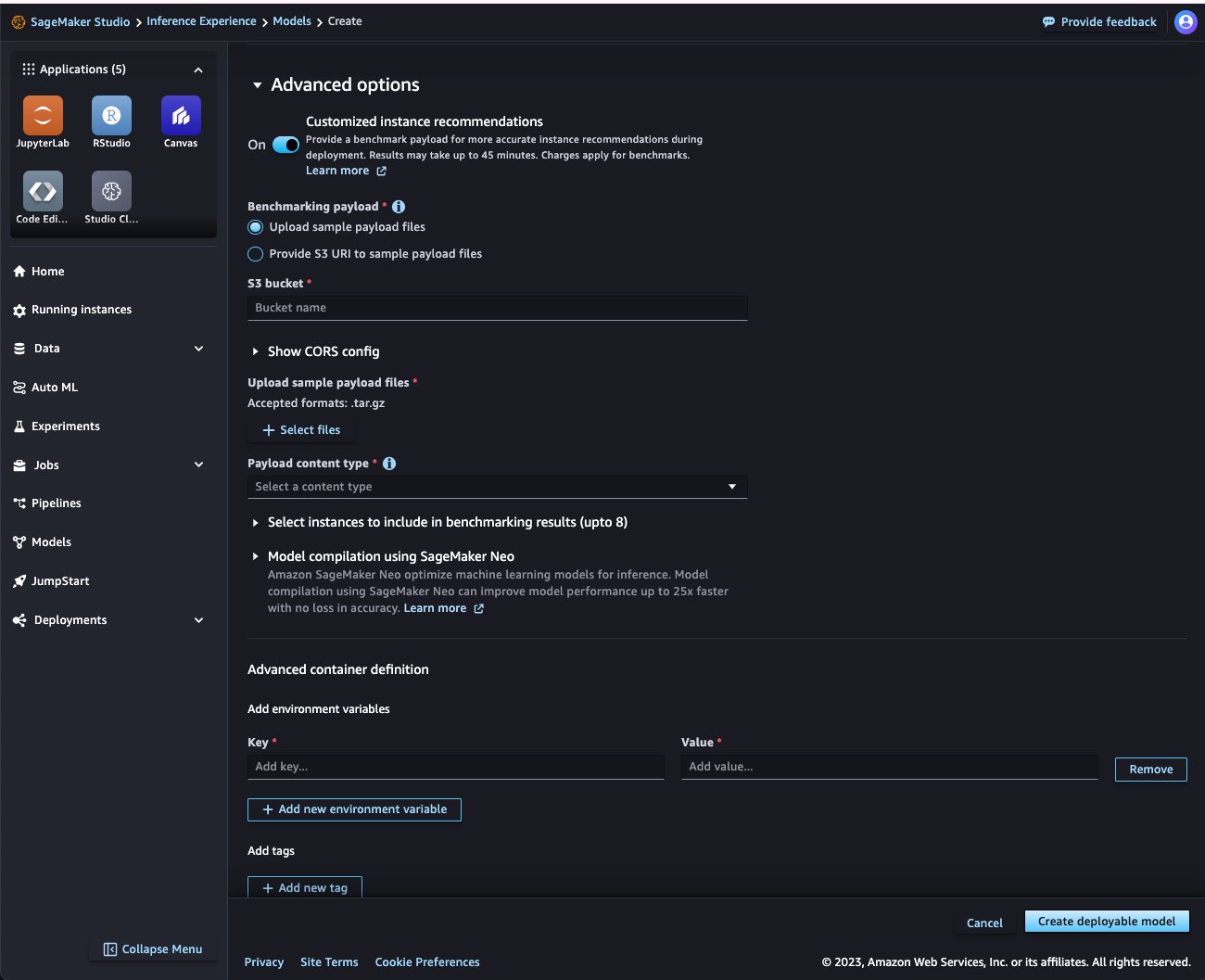

De foregående trin viser den enkleste arbejdsgang. Du kan yderligere tilpasse modeloprettelsesprocessen. For eksempel kan du angive VPC-detaljer og aktivere netværksisolering for at sikre, at containeren ikke kan foretage udgående opkald på det offentlige internet. Du kan udvide Avancerede indstillinger afsnittet for at se flere muligheder.

Du kan få vejledning om hardwaren for det bedste pris/ydelsesforhold for at implementere dit slutpunkt ved at køre et SageMaker Inference Recommender-benchmarkingjob. For yderligere at tilpasse SageMaker-modellen kan du indsætte alle tunbare miljøvariabler på containerniveau. Inference Recommender vil også tage en række af disse variabler for at finde den optimale konfiguration til din modelservering og container.

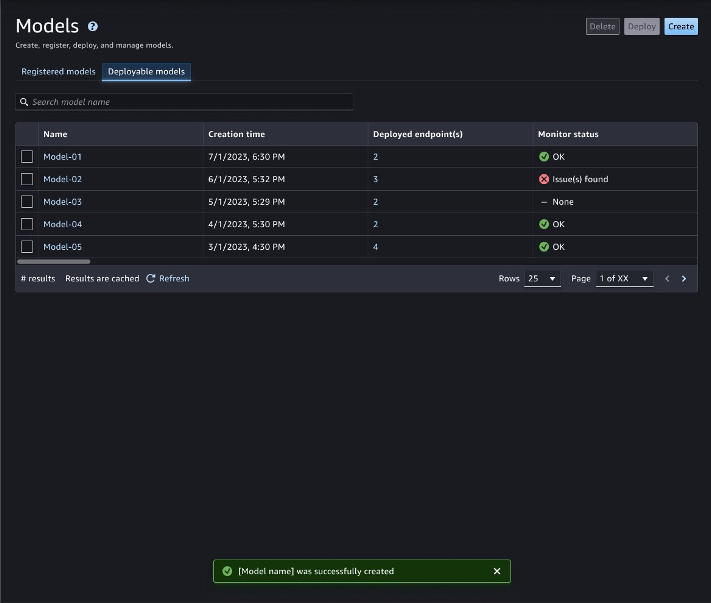

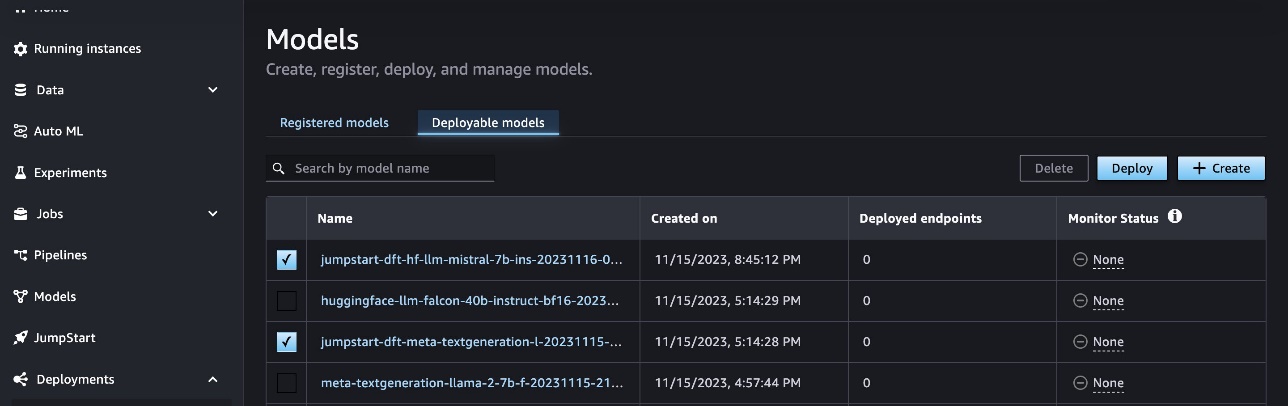

Når du har oprettet din model, kan du se den på Deployerbare modeller fanen. Hvis der blev fundet et problem i modeloprettelsen, vil du se status i Overvåg status kolonne. Vælg modellens navn for at se detaljerne.

Implementer en SageMaker-model

I det mest grundlæggende scenarie er alt hvad du skal gøre at vælge en deployerbar model fra Modeller side eller en LLM fra SageMaker JumpStart-siden, vælg en forekomsttype, indstil det indledende antal forekomster og implementer modellen. Lad os se, hvordan denne proces ser ud i SageMaker Studio til din egen SageMaker-model. Vi diskuterer brug af LLM'er senere i dette indlæg.

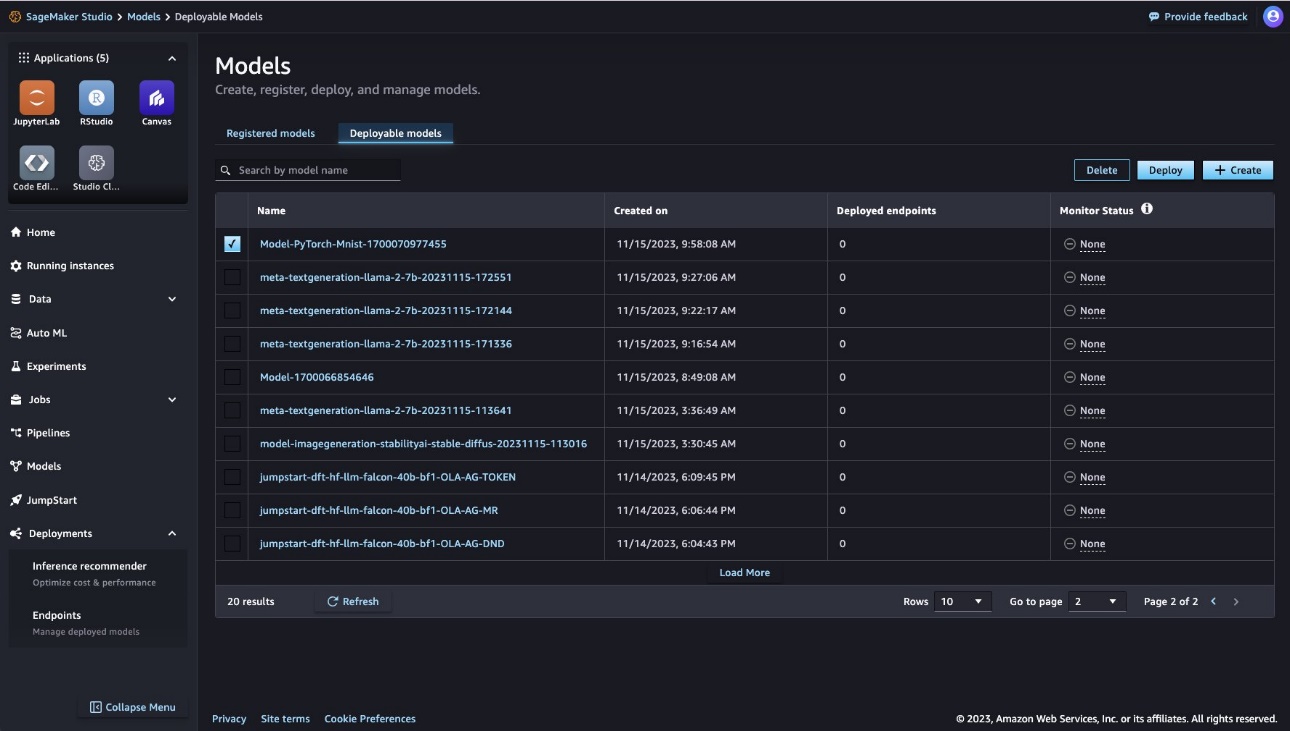

- På Modeller side, vælg den Deployerbare modeller fane.

- Vælg den model, der skal implementeres, og vælg Implementer.

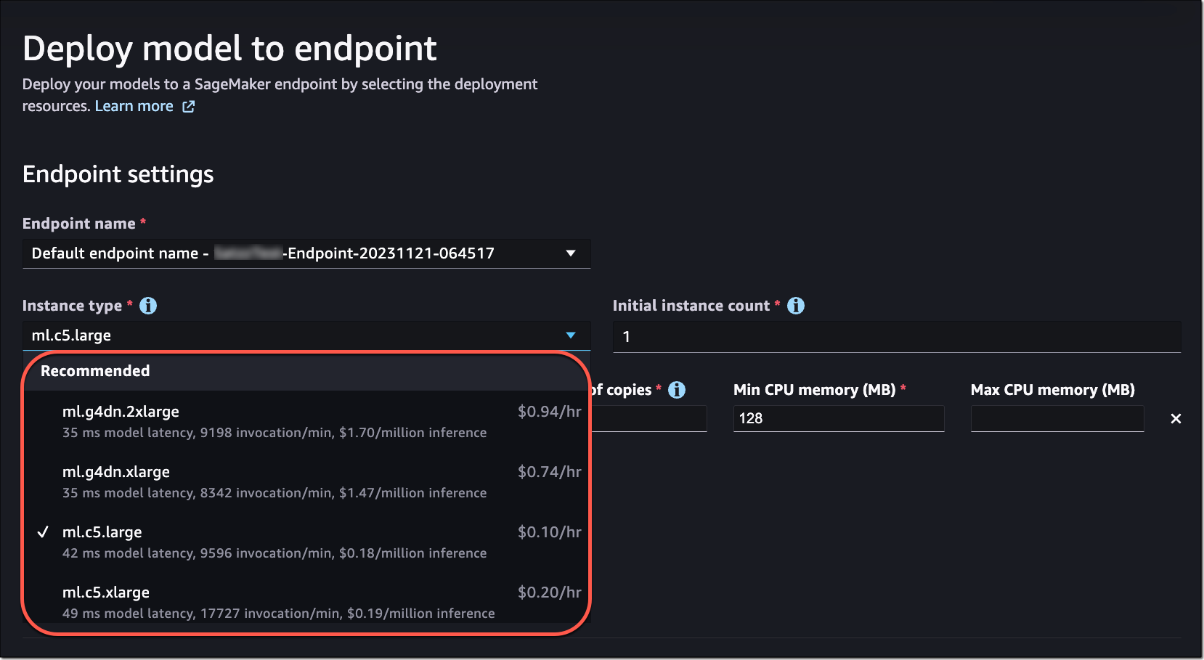

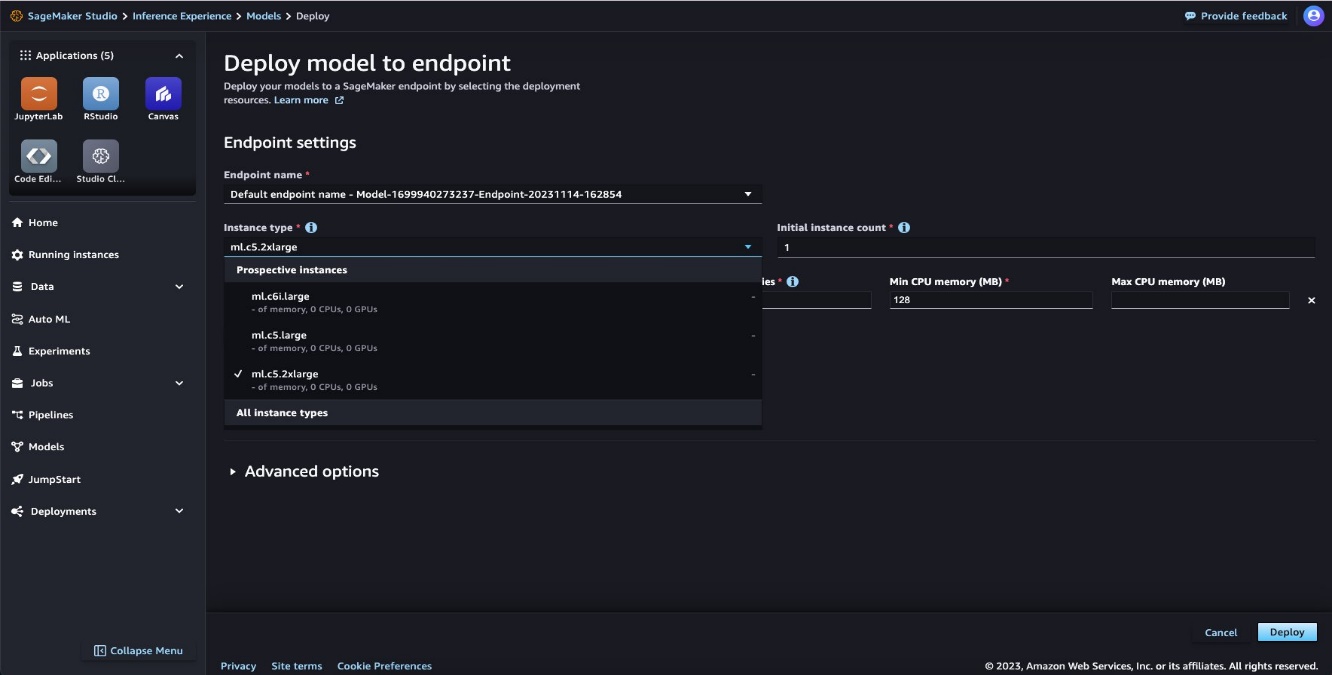

- Det næste trin er at vælge en instanstype, som SageMaker vil placere bag inferensslutpunktet.

Du vil have en instans, der leverer den bedste ydeevne til den laveste pris. SageMaker gør det nemt for dig at træffe denne beslutning ved at vise anbefalinger. Hvis du havde benchmarket din model ved hjælp af SageMaker Inference Recommender under oprettelse af SageMaker-modellen, vil du se anbefalingerne fra det benchmark i rullemenuen.

Ellers vil du se en liste over potentielle forekomster i menuen. SageMaker bruger sin egen heuristik til at udfylde listen i så fald.

- Angiv det indledende antal forekomster, og vælg derefter Implementer.

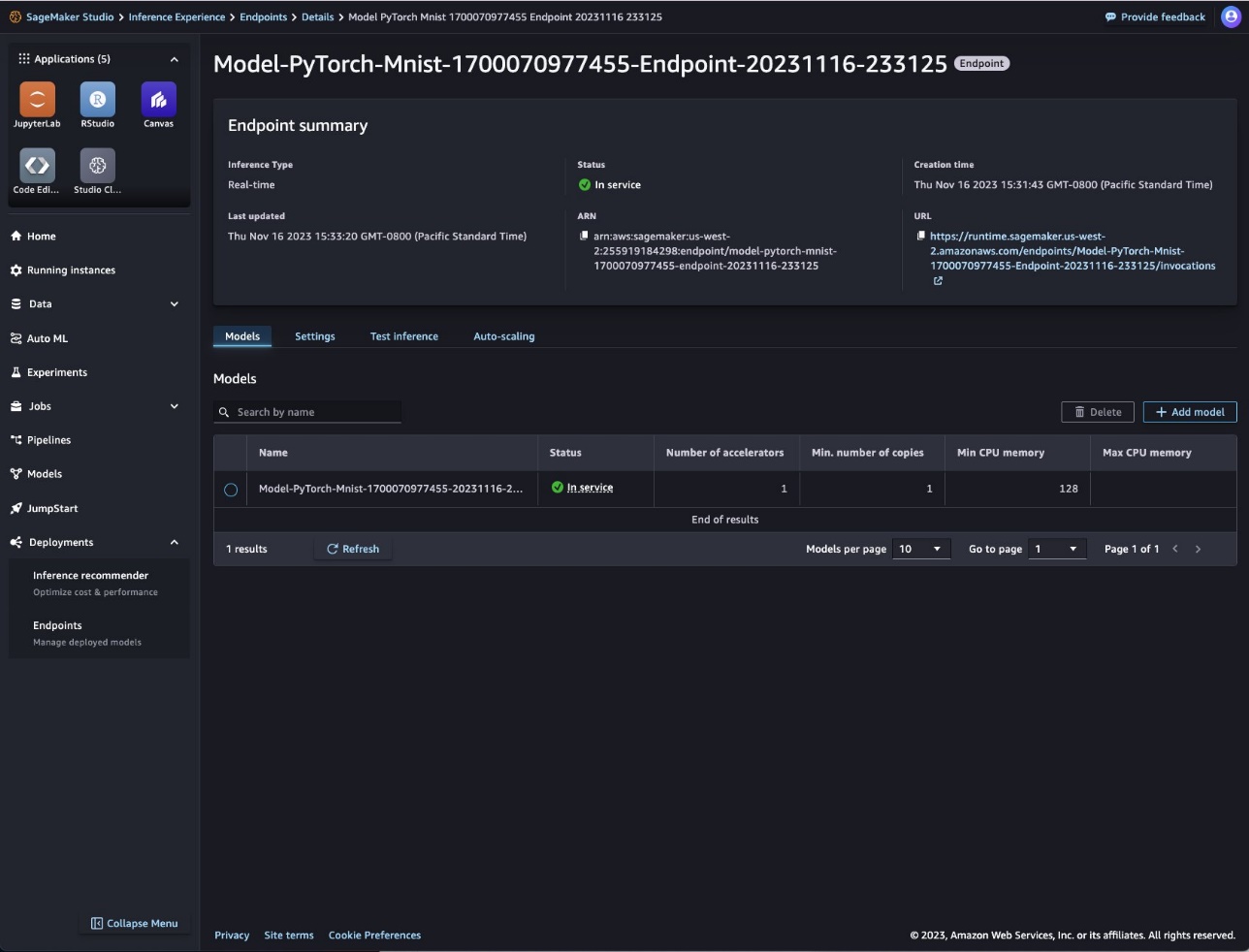

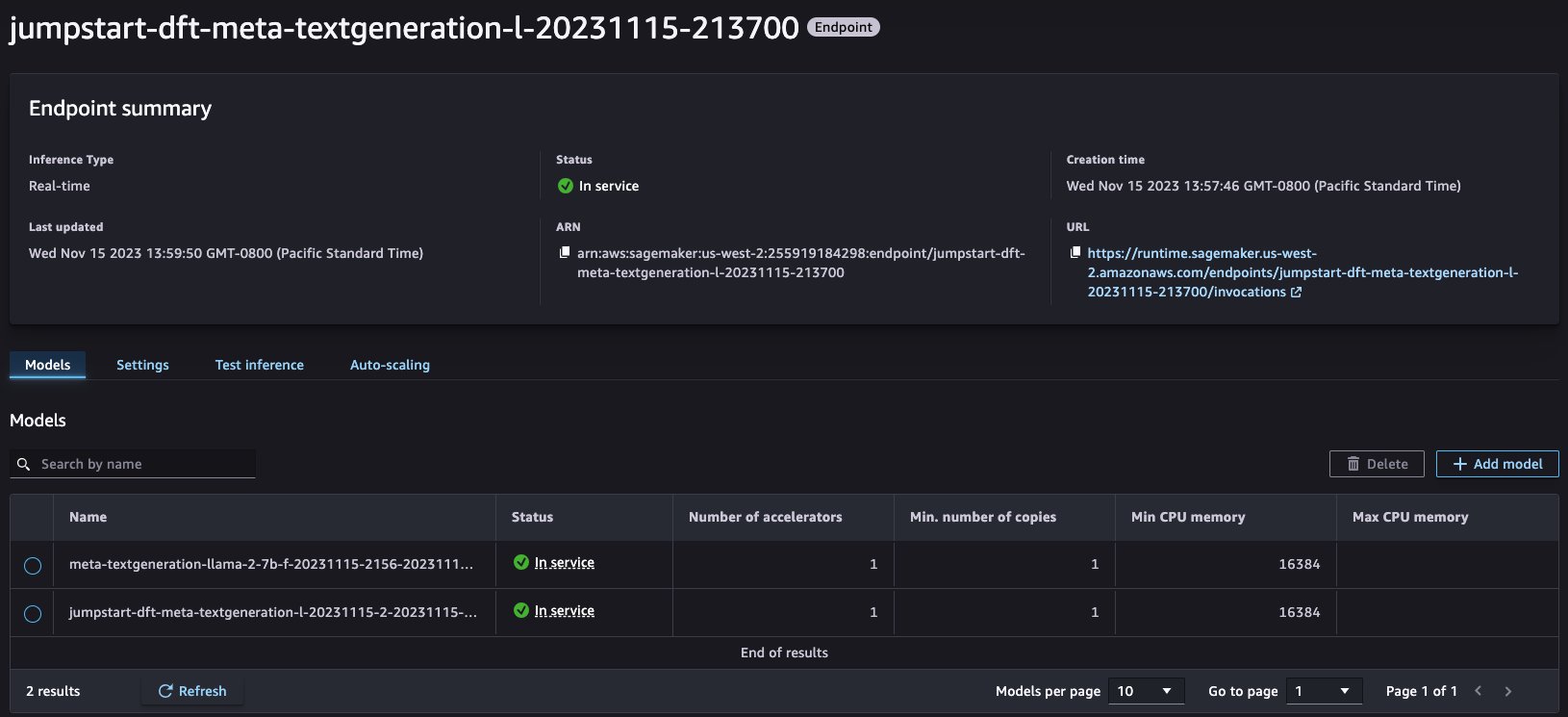

SageMaker vil oprette en slutpunktskonfiguration og implementere din model bag dette slutpunkt. Når modellen er implementeret, vil du se slutpunktet og modelstatus som I drift. Bemærk, at endepunktet kan være klar før modellen.

Dette er også stedet i SageMaker Studio, hvor du skal administrere endepunktet. Du kan navigere til siden med slutpunktsdetaljer ved at vælge Endpoints under implementeringer i navigationsruden. Brug Tilføj model , Slette knapper for at ændre modellerne bag endepunktet uden at skulle genskabe et endepunkt. Det Test slutning fanen giver dig mulighed for at teste din model ved at sende testanmodninger til en af de ibrugsatte modeller direkte fra SageMaker Studio-grænsefladen. Du kan også redigere politikken for automatisk skalering på Automatisk skalering fanen på denne side. Flere detaljer om tilføjelse, fjernelse og test af modeller er dækket i de følgende afsnit. Du kan se netværks-, sikkerheds- og beregningsoplysningerne for dette slutpunkt på Indstillinger fane.

Tilpas implementeringen

Det foregående eksempel viste, hvor ligetil det er at implementere en enkelt model med et minimumskrav til konfiguration fra din side. SageMaker udfylder de fleste af felterne for dig, men du kan tilpasse konfigurationen. For eksempel genererer den automatisk et navn til slutpunktet. Du kan dog navngive slutpunktet efter dine præferencer eller bruge et eksisterende slutpunkt på Endpoint navn Drop down menu. For eksisterende endepunkter vil du kun se de endepunkter, der er i drift på det tidspunkt. Du kan bruge Avancerede indstillinger sektion for at angive en IAM-rolle, VPC-detaljer og tags.

Implementer en SageMaker JumpStart LLM

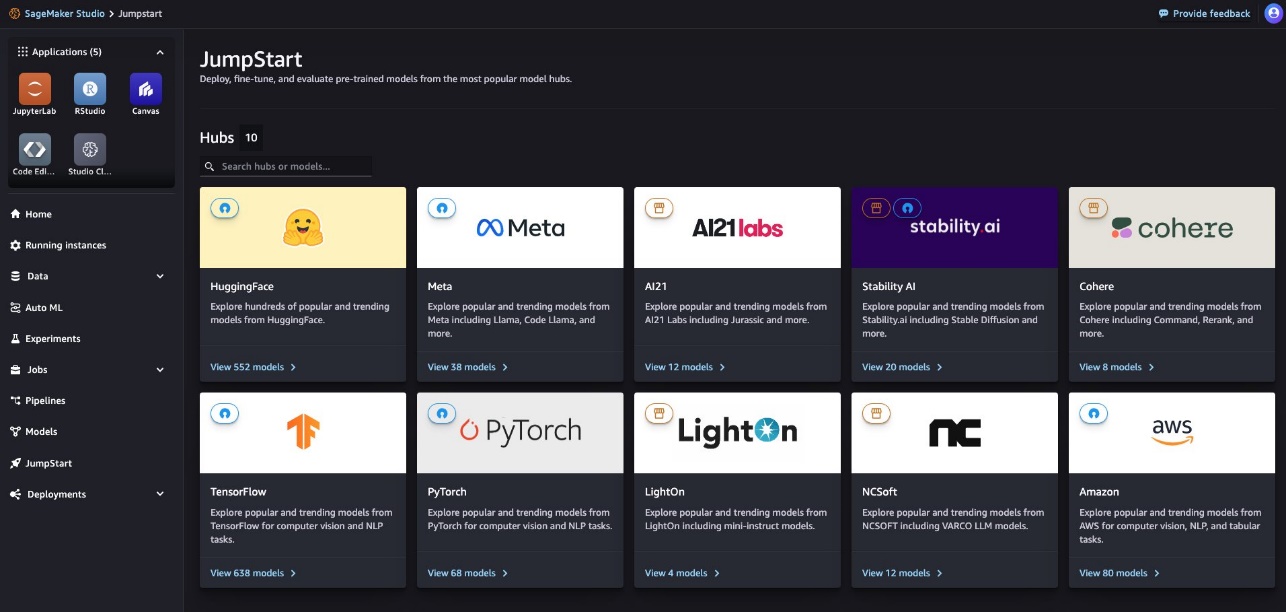

For at implementere en SageMaker JumpStart LLM skal du udføre følgende trin:

- Naviger til Forspring side i SageMaker Studio.

- Vælg et af partnernavnene for at gennemse listen over tilgængelige modeller fra denne partner, eller brug søgefunktionen for at komme til modelsiden, hvis du kender navnet på modellen.

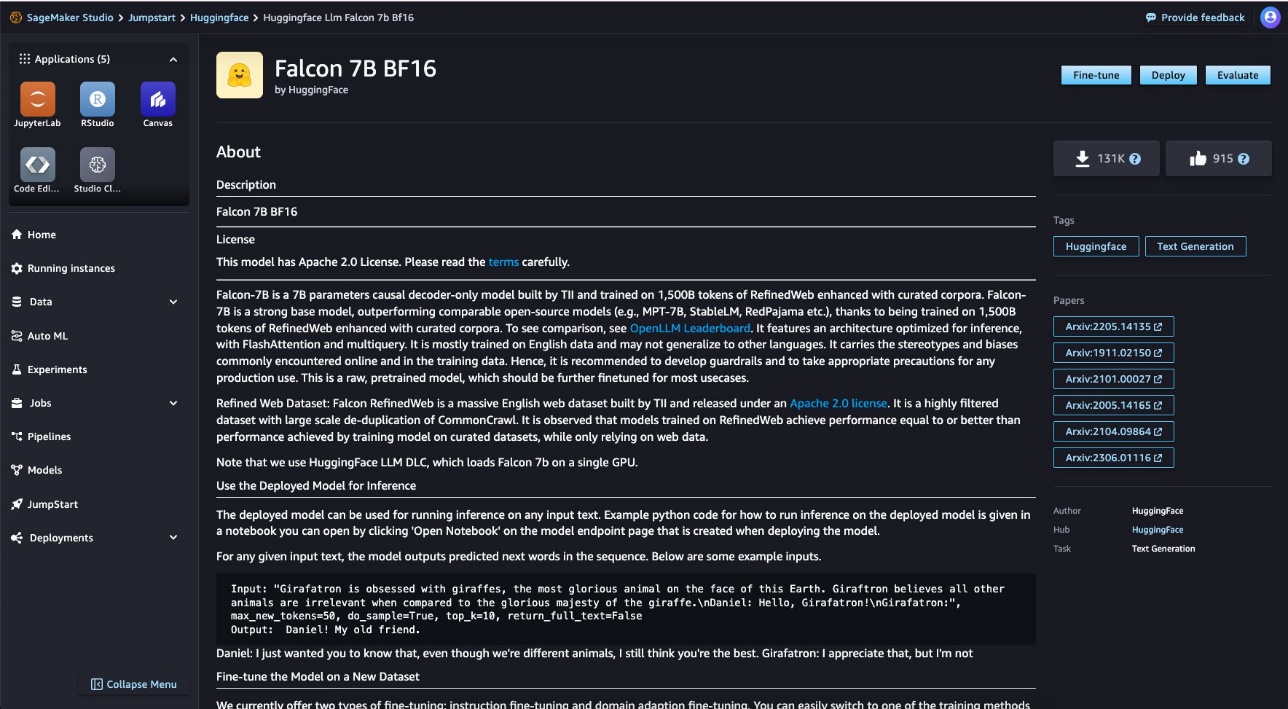

- Vælg den model, du vil implementere.

- Vælg Implementer.

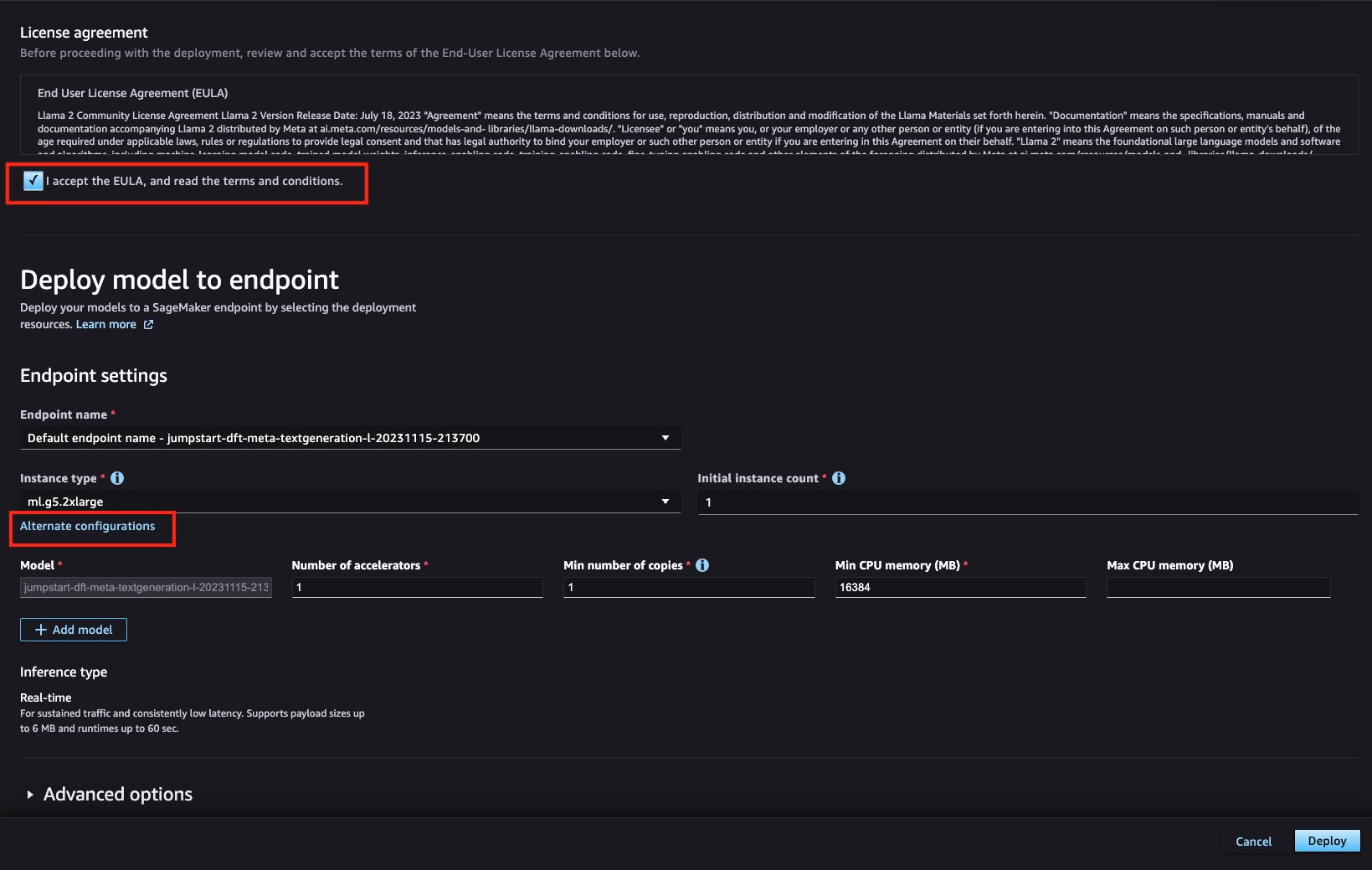

Bemærk, at brugen af LLM'er er underlagt EULA og udbyderens vilkår og betingelser.

- Accepter licensen og vilkårene.

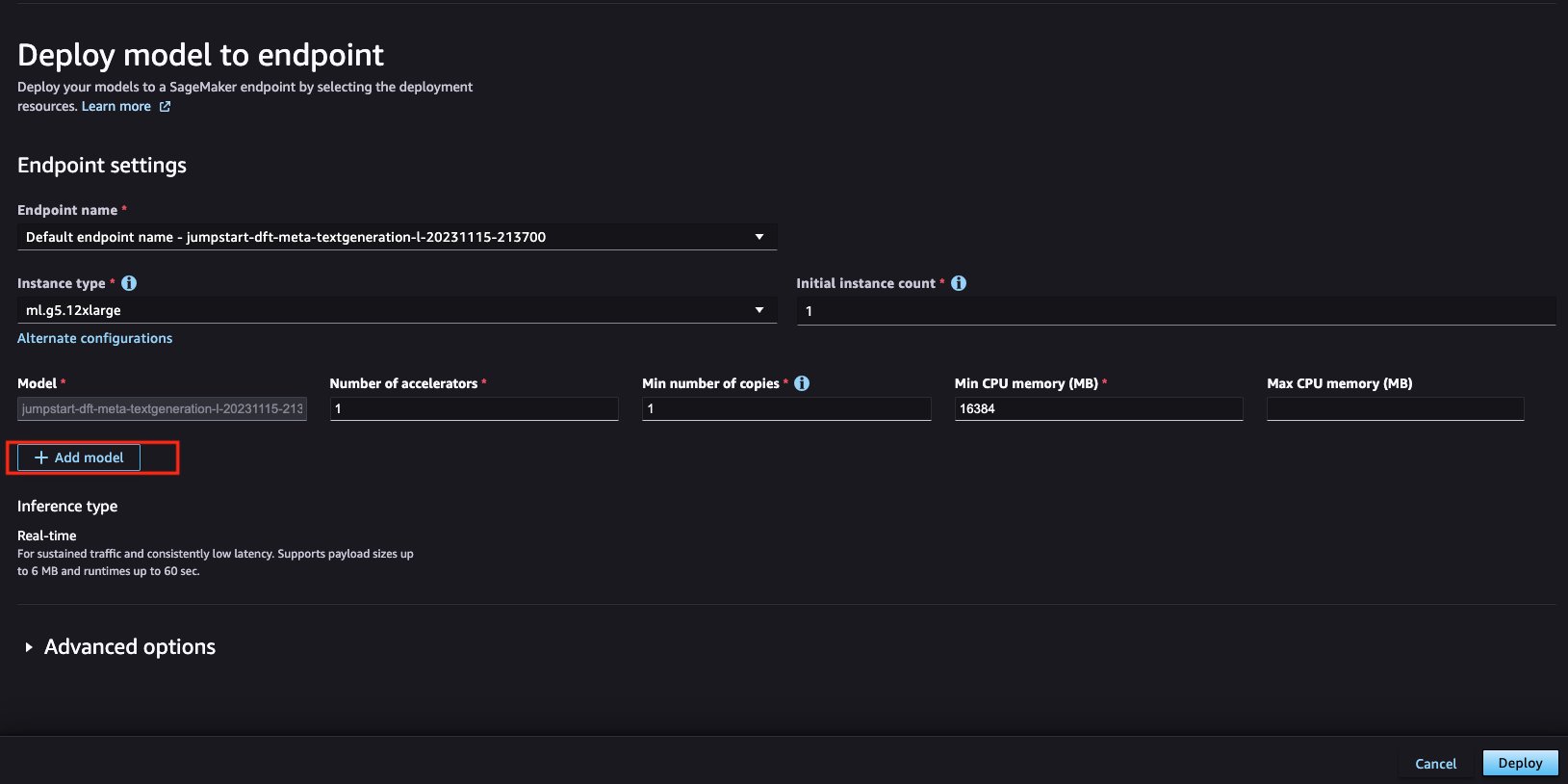

- Angiv en instanstype.

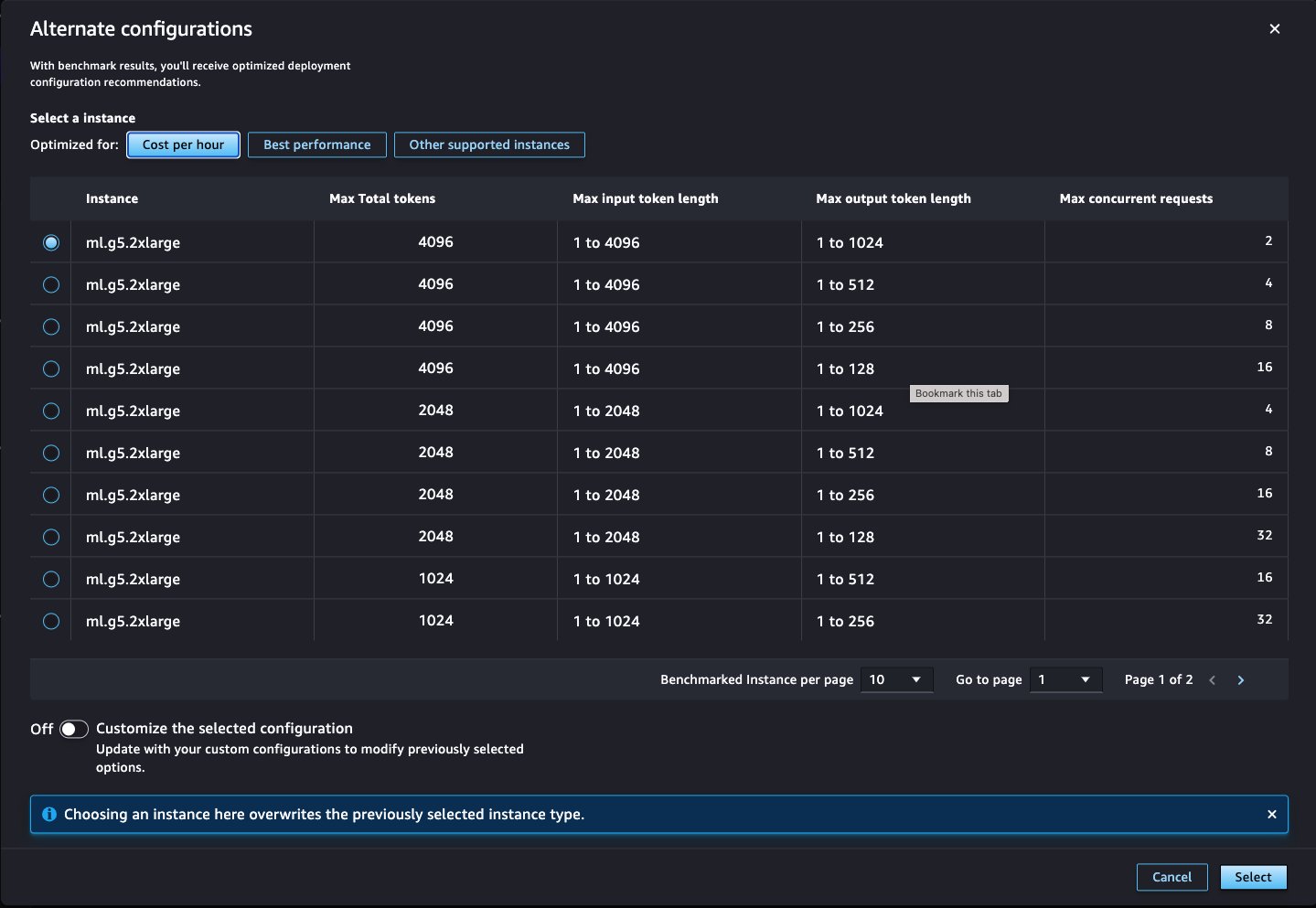

Mange modeller fra JumpStart-modelhubben leveres med en pris-ydelsesoptimeret standardinstanstype til implementering. For modeller, der ikke kommer med denne standard, vil du blive forsynet med en liste over understøttede forekomsttyper på Forekomsttype Drop down menu. For benchmarkede modeller, hvis du ønsker at optimere implementeringen specifikt for enten omkostninger eller ydeevne for at imødekomme din specifikke brugssituation, kan du vælge Alternative konfigurationer for at se flere muligheder, der er blevet benchmarket med forskellige kombinationer af samlede tokens, inputlængde og maksimal samtidighed. Du kan også vælge mellem andre understøttede forekomster for den pågældende model.

- Hvis du bruger en alternativ konfiguration, skal du vælge din instans og vælge Type.

- Vælg Implementer at implementere modellen.

Du vil se slutpunktet og modelstatus ændres til I drift. Du har også muligheder for at tilpasse implementeringen til at opfylde dine krav i dette tilfælde.

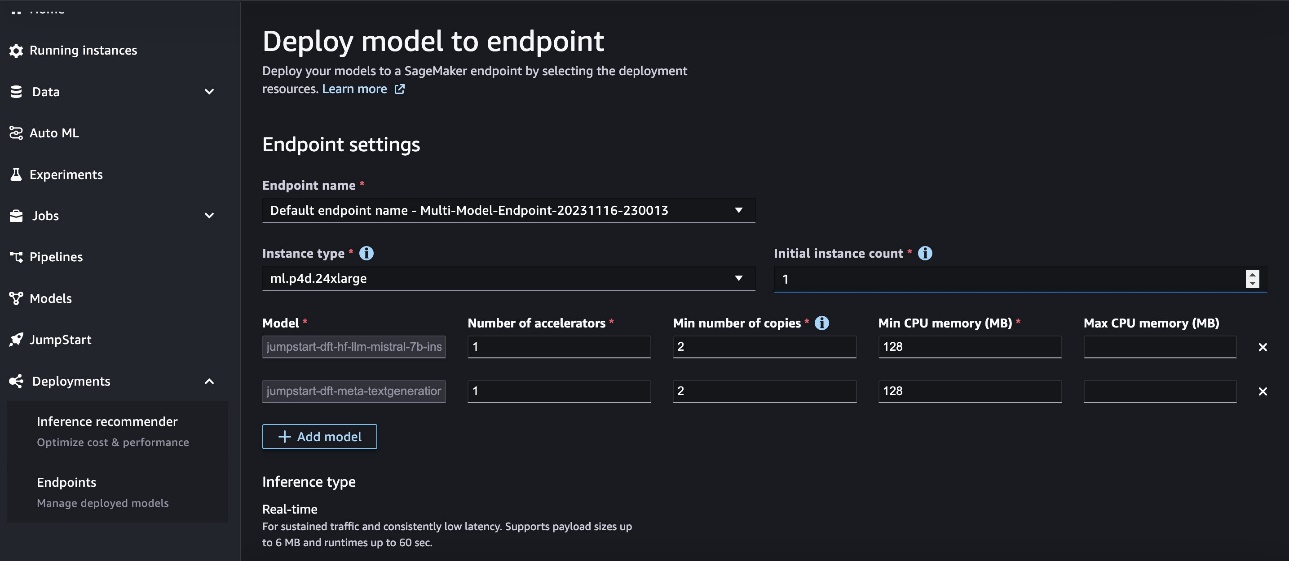

Implementer flere modeller bag ét slutpunkt

SageMaker giver dig mulighed for at implementere flere modeller bag et enkelt slutpunkt. Dette reducerer hostingomkostningerne ved at forbedre endpoint-udnyttelsen sammenlignet med at bruge endpoints med kun én model bag sig. Det reducerer også implementeringsomkostningerne, fordi SageMaker administrerer indlæsning af modeller i hukommelsen og skalerer dem baseret på trafikmønstrene til dit slutpunkt. SageMaker Studio gør det nu ligetil at gøre dette.

- Kom i gang ved at vælge de modeller, du vil implementere, og vælg derefter Implementer.

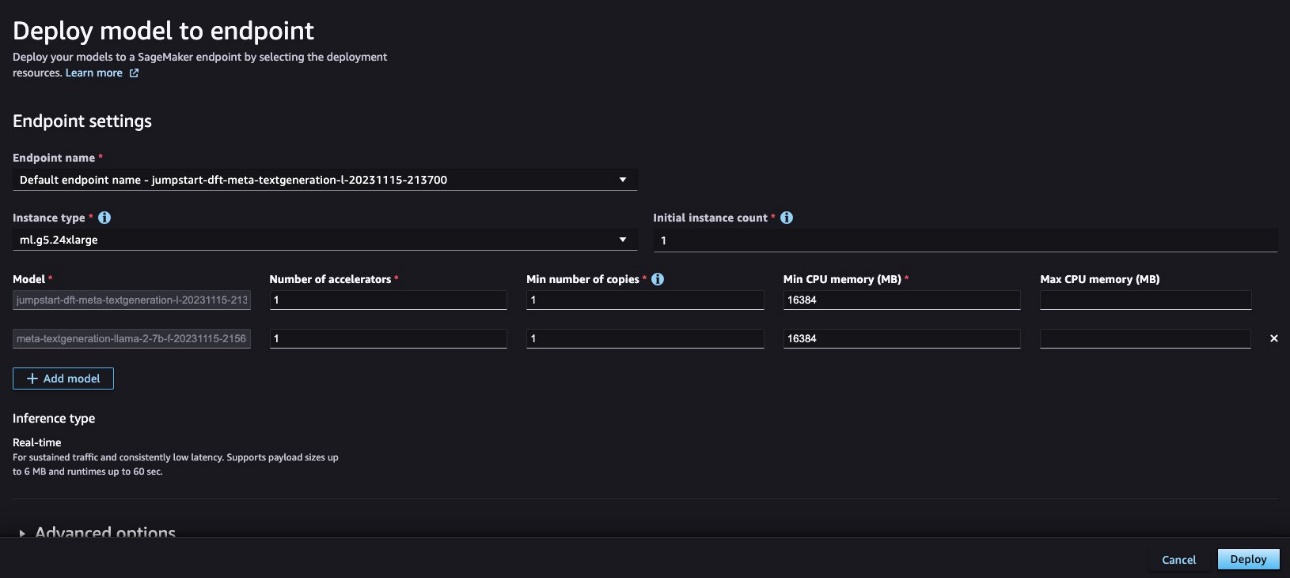

- Derefter kan du oprette et slutpunkt med flere modeller, der har en tildelt mængde beregning, som du definerer.

I dette tilfælde bruger vi en ml.p4d.24xlarge instans til slutpunktet og allokerer det nødvendige antal ressourcer til vores to forskellige modeller. Bemærk, at dit slutpunkt er begrænset til de instanstyper, der understøttes af denne funktion.

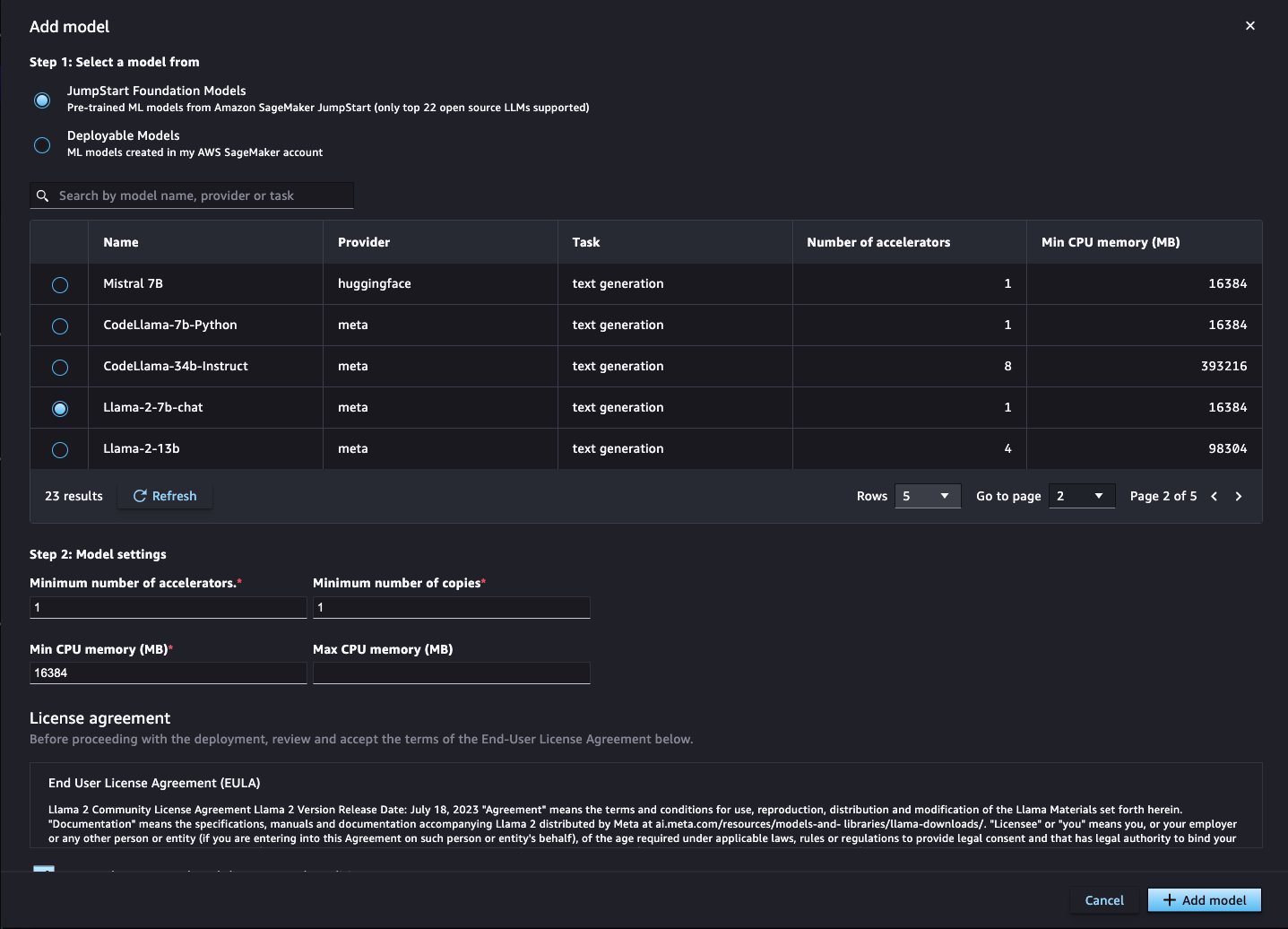

- Hvis du starter flowet fra Deployerbare modeller fanen og ønsker at tilføje en SageMaker JumpStart LLM, eller omvendt, kan du gøre det til et slutpunkt, der fronter flere modeller ved at vælge Tilføj model efter start af implementeringsarbejdsgangen.

- Her kan du vælge en anden FM fra SageMaker JumpStart model hub eller en model ved hjælp af Deployerbare modeller option, som refererer til modeller, som du har gemt som SageMaker-modelobjekter.

- Vælg dine modelindstillinger:

- Hvis modellen bruger en CPU-instans, skal du vælge antallet af CPU'er og minimumsantallet af kopier for modellen.

- Hvis modellen bruger en GPU-instans, skal du vælge antallet af acceleratorer og minimumsantallet af kopier for modellen.

- Vælg Tilføj model.

- Vælg Implementer at implementere disse modeller til et SageMaker-slutpunkt.

Når endepunktet er oppe og klar (I drift status), vil du have to modeller installeret bag et enkelt slutpunkt.

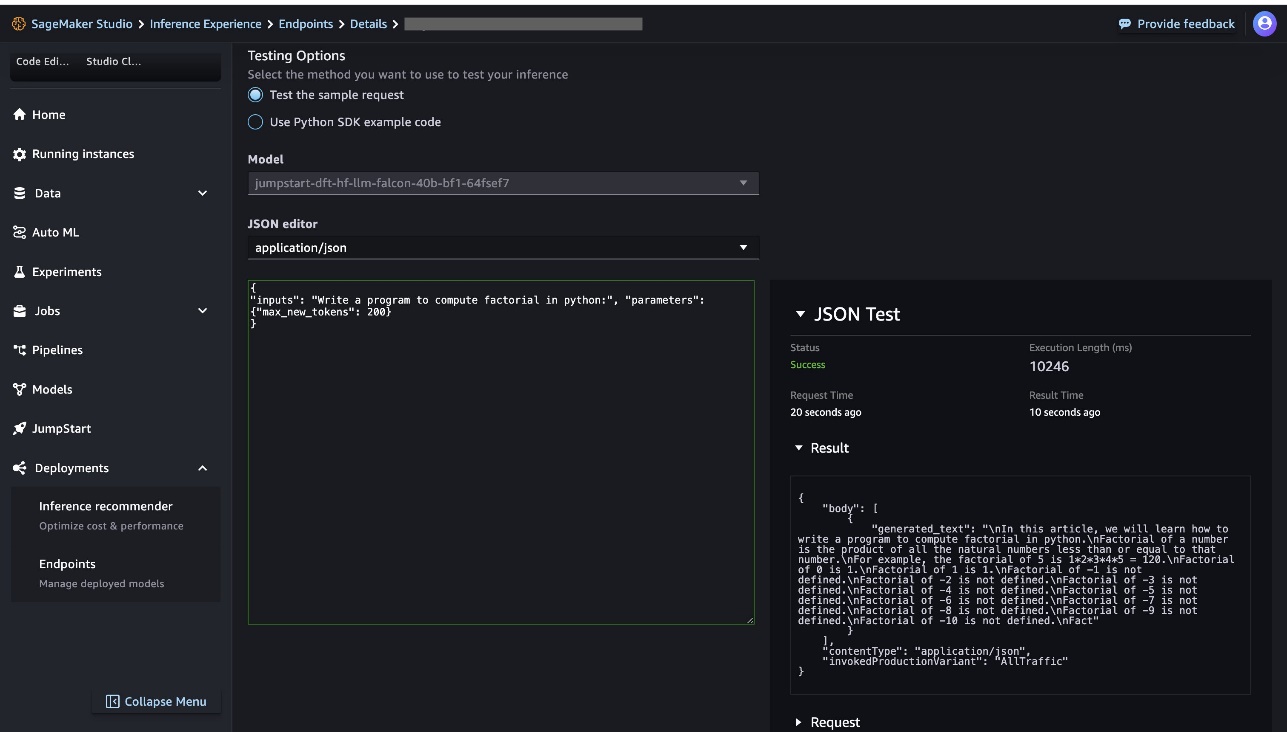

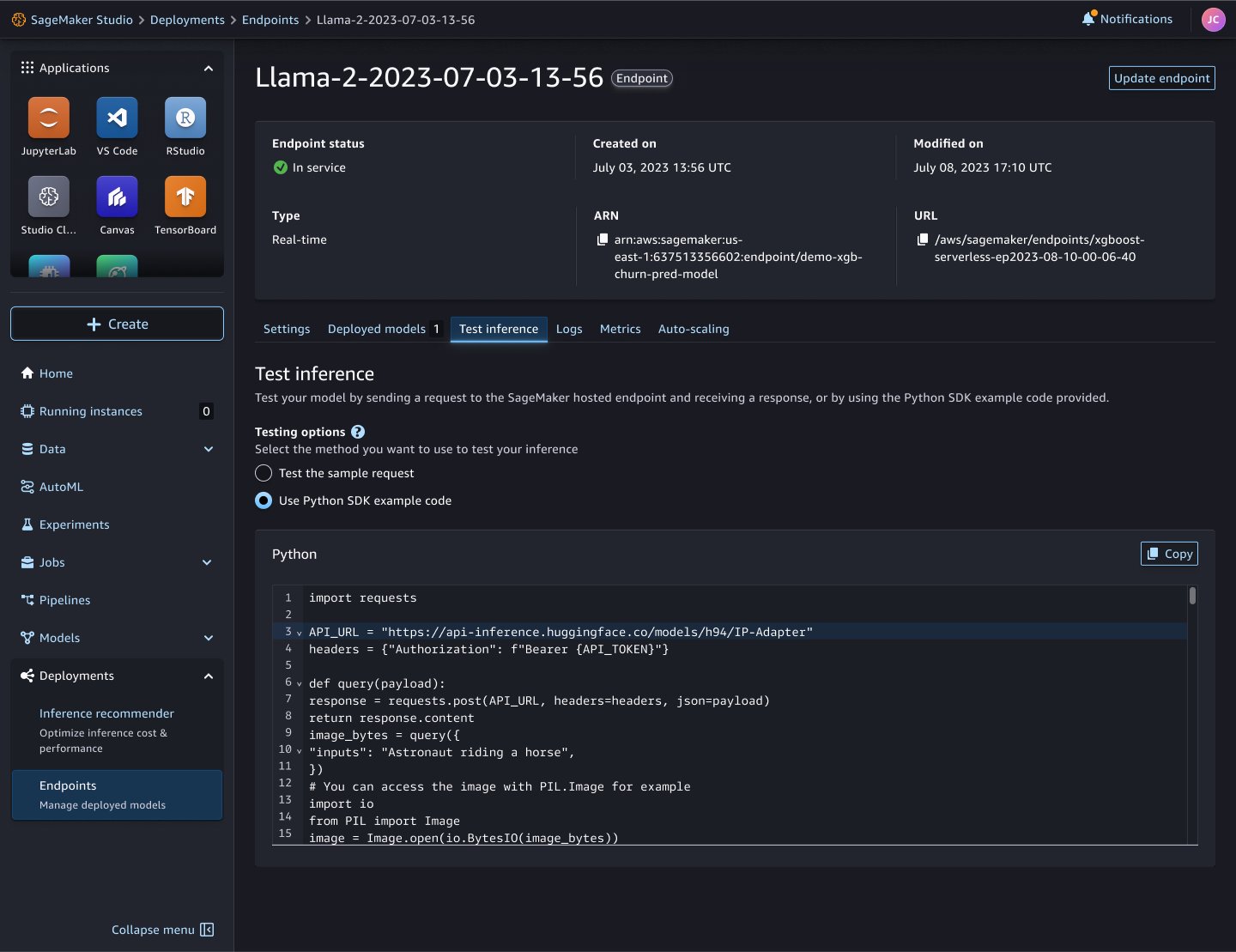

Test model inferens

SageMaker Studio gør det nu ligetil at teste modelslutningsanmodninger. Du kan sende nyttelastdataene direkte ved hjælp af den understøttede indholdstype, såsom applikation eller JSON, tekst eller CSV, eller bruge Python SDK-eksempelkode til at lave en anmodning fra dit programmeringsmiljø som en notebook eller lokalt integreret udviklingsmiljø (IDE).

Bemærk, at Python SDK-eksempelkodeindstillingen kun er tilgængelig for SageMaker JumpStart-modeller, og den er skræddersyet til den specifikke modelbrugstilfælde med input/outputdatatransformation.

Fejlfinding af fejl

For at hjælpe med at fejlfinde og se dybere ind i modelimplementering er der værktøjstip på ressourcen Status etiket for at vise tilsvarende fejl- og årsagsmeddelelser. Der er også links til amazoncloudwatch loggrupper på siden med slutpunktsdetaljer. For enkelt-model slutpunkter er linket til CloudWatch container logs bekvemt placeret i Resumé afsnittet i slutpunktsdetaljerne. For endepunkter med flere modeller er links til CloudWatch-loggene placeret på hver række af Modeller bordvisning. Følgende er nogle almindelige fejlscenarier til fejlfinding:

- Fejl ved modelping-sundhedstjek – Modelimplementeringen kunne mislykkes, fordi serveringsbeholderen ikke bestod modelping-sundhedstjekket. For at fejlfinde problemet skal du se følgende containerlogfiler udgivet af CloudWatch-loggrupperne:

- Inkonsekvent model- og slutpunktskonfiguration forårsagede implementeringsfejl – Hvis implementeringen mislykkedes af en af følgende fejlmeddelelser, betyder det, at den valgte model til implementering brugte en anden IAM-rolle, VPC-konfiguration eller netværksisolationskonfiguration. Afhjælpningen er at opdatere modeldetaljerne for at bruge den samme IAM-rolle, VPC-konfiguration og netværksisoleringskonfiguration under implementeringsforløbet. Hvis du tilføjer en model til et eksisterende slutpunkt, kan du genskabe modelobjektet, så det matcher målendepunktskonfigurationerne.

- Ikke nok kapacitet til at implementere flere modeller på den eksisterende endpoint-infrastruktur – Hvis implementeringen mislykkedes med følgende fejlmeddelelse, betyder det, at den aktuelle slutpunktsinfrastruktur ikke har nok computer- eller hukommelseshardwareressourcer til at implementere modellen. Afhjælpningen er at øge det maksimale antal forekomster på slutpunktet eller slette eventuelle eksisterende modeller, der er implementeret på slutpunktet for at gøre plads til nye modelimplementeringer.

- Ikke-understøttet instanstype til implementering af flere endpoint-modeller – Hvis implementeringen mislykkedes med følgende fejlmeddelelse, betyder det, at den valgte forekomsttype i øjeblikket ikke understøttes for slutpunktsimplementeringen med flere modeller. Afhjælpningen er at ændre instanstypen til en instans der understøtter denne funktion og prøve implementeringen igen.

For andre modelimplementeringsproblemer henvises til Understøttede funktioner.

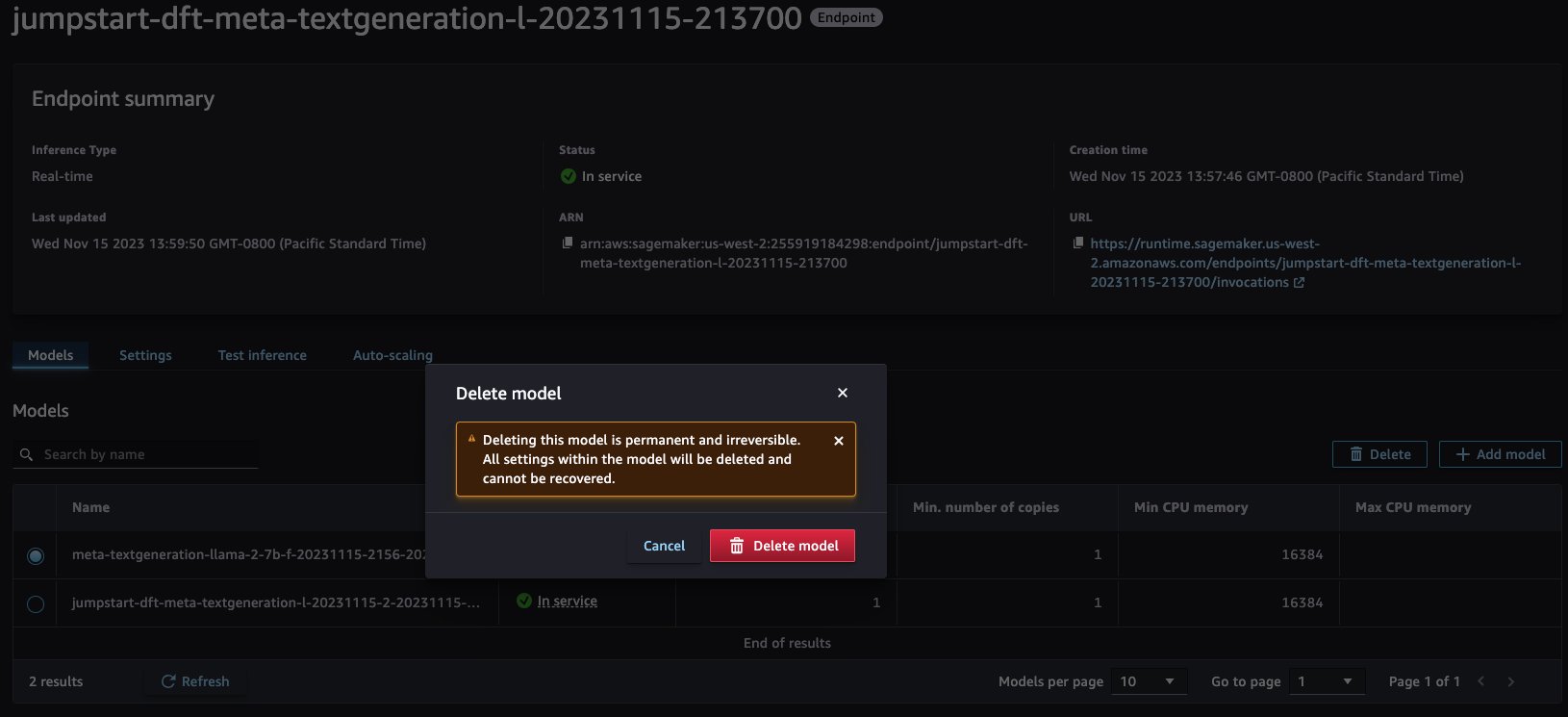

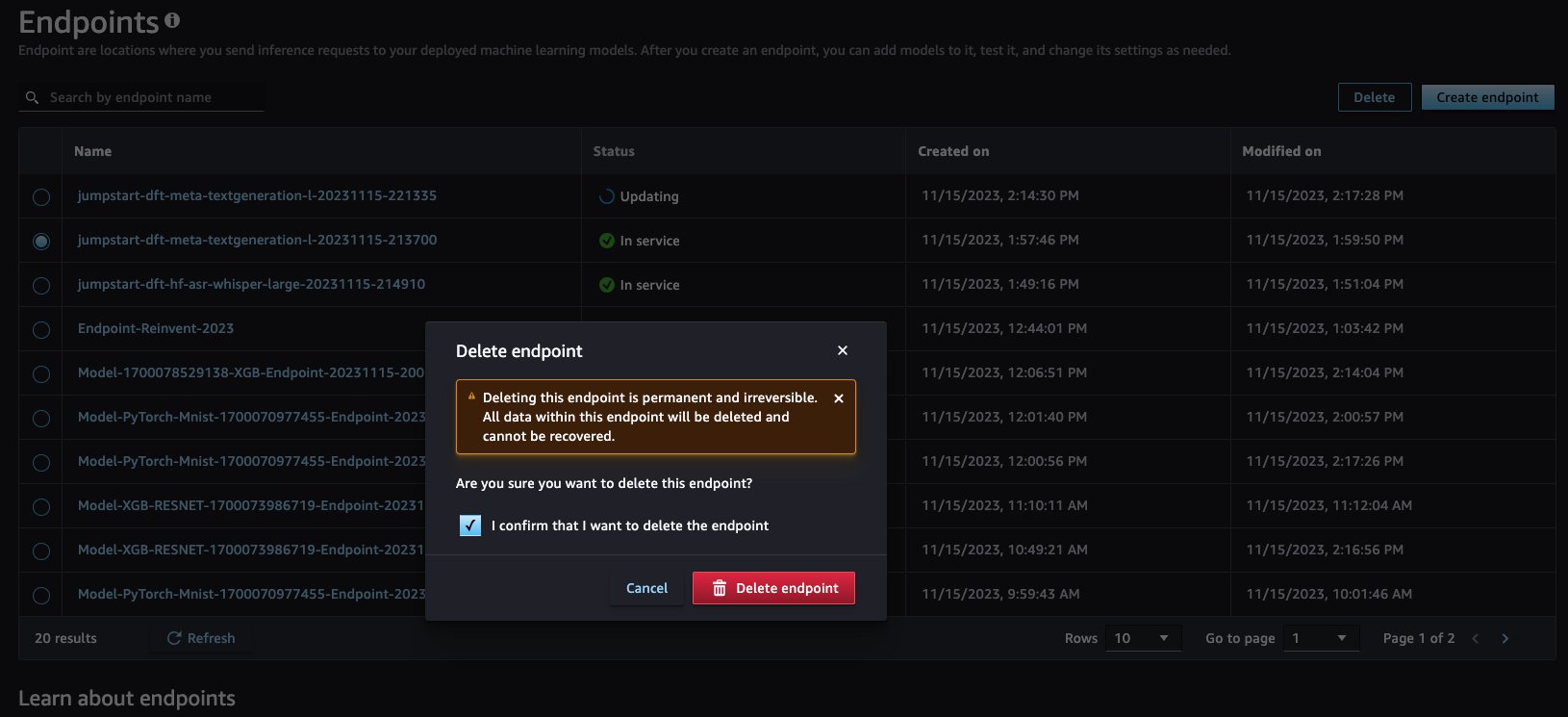

Ryd op

Oprydning er også ligetil. Du kan fjerne en eller flere modeller fra dit eksisterende SageMaker-slutpunkt ved at vælge den specifikke model på SageMaker-konsollen. For at slette hele slutpunktet skal du navigere til Endpoints side, vælg det ønskede slutpunkt, vælg Slette, og accepter ansvarsfraskrivelsen for at fortsætte med sletningen.

Konklusion

Den forbedrede interaktive oplevelse i SageMaker Studio giver datavidenskabsfolk mulighed for at fokusere på modelbygning og bringe deres artefakter til SageMaker, mens de abstraherer kompleksiteten af implementeringen. For dem, der foretrækker en kodebaseret tilgang, så tjek lavkodeækvivalenten med ModelBuilder klasse.

Besøg SageMaker for at lære mere ModelBuilder Python-grænseflade dokumentation og de guidede implementere arbejdsgange i SageMaker Studio. Der er ingen ekstra omkostninger for SageMaker SDK og SageMaker Studio. Du betaler kun for de underliggende ressourcer, der bruges. For mere information om, hvordan du implementerer modeller med SageMaker, se Implementer modeller til slutninger.

Særlig tak til Sirisha Upadhyayala, Melanie Li, Dhawal Patel, Sam Edwards og Kumara Swami Borra.

Om forfatterne

Raghu Ramesha er senior ML Solutions Architect hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at opbygge, implementere og migrere ML-produktionsarbejdsbelastninger til SageMaker i stor skala. Han har specialiseret sig i maskinlæring, kunstig intelligens og computersyn og har en mastergrad i datalogi fra UT Dallas. I sin fritid nyder han at rejse og fotografere.

Raghu Ramesha er senior ML Solutions Architect hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at opbygge, implementere og migrere ML-produktionsarbejdsbelastninger til SageMaker i stor skala. Han har specialiseret sig i maskinlæring, kunstig intelligens og computersyn og har en mastergrad i datalogi fra UT Dallas. I sin fritid nyder han at rejse og fotografere.

Deepak Garg er Solutions Architect hos AWS. Han elsker at dykke dybt ned i AWS-tjenester og dele sin viden med kunderne. Deepak har baggrund i Content Delivery Networks og Telecommunications

Deepak Garg er Solutions Architect hos AWS. Han elsker at dykke dybt ned i AWS-tjenester og dele sin viden med kunderne. Deepak har baggrund i Content Delivery Networks og Telecommunications

Ram Vegiraju er en ML-arkitekt hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at bygge og optimere deres AI/ML-løsninger på Amazon SageMaker. I sin fritid elsker han at rejse og skrive.

Ram Vegiraju er en ML-arkitekt hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at bygge og optimere deres AI/ML-løsninger på Amazon SageMaker. I sin fritid elsker han at rejse og skrive.

Marc Karp er en ML-arkitekt hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at designe, implementere og administrere ML-arbejdsbelastninger i stor skala. I sin fritid nyder han at rejse og udforske nye steder.

Marc Karp er en ML-arkitekt hos Amazon SageMaker Service-teamet. Han fokuserer på at hjælpe kunder med at designe, implementere og administrere ML-arbejdsbelastninger i stor skala. I sin fritid nyder han at rejse og udforske nye steder.

Shiva Raaj Kotini arbejder som Principal Product Manager i Amazon SageMaker Inference-produktporteføljen. Han fokuserer på modelimplementering, præstationsjustering og optimering i SageMaker til slutninger.

Shiva Raaj Kotini arbejder som Principal Product Manager i Amazon SageMaker Inference-produktporteføljen. Han fokuserer på modelimplementering, præstationsjustering og optimering i SageMaker til slutninger.

Alwin (Qiyun) Zhao er senior softwareudviklingsingeniør hos Amazon SageMaker Inference Platform-teamet. Han er den ledende udvikler af udrulningsværn og skyggeimplementeringer, og han fokuserer på at hjælpe kunder med at administrere ML-arbejdsbelastninger og -implementeringer i stor skala med høj tilgængelighed. Han arbejder også på udvikling af platformsarkitektur for hurtig og sikker implementering af ML-job og afvikling af ML-onlineeksperimenter med lethed. I sin fritid nyder han at læse, spille og rejse.

Alwin (Qiyun) Zhao er senior softwareudviklingsingeniør hos Amazon SageMaker Inference Platform-teamet. Han er den ledende udvikler af udrulningsværn og skyggeimplementeringer, og han fokuserer på at hjælpe kunder med at administrere ML-arbejdsbelastninger og -implementeringer i stor skala med høj tilgængelighed. Han arbejder også på udvikling af platformsarkitektur for hurtig og sikker implementering af ML-job og afvikling af ML-onlineeksperimenter med lethed. I sin fritid nyder han at læse, spille og rejse.

Gaurav Bhanderi er en Front End-ingeniør med AI-platformsteam i SageMaker. Han arbejder på at levere kundevendte UI-løsninger inden for AWS org. I sin fritid nyder han at vandre og udforske lokale restauranter.

Gaurav Bhanderi er en Front End-ingeniør med AI-platformsteam i SageMaker. Han arbejder på at levere kundevendte UI-løsninger inden for AWS org. I sin fritid nyder han at vandre og udforske lokale restauranter.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/package-and-deploy-classical-ml-and-llms-easily-with-amazon-sagemaker-part-2-interactive-user-experiences-in-sagemaker-studio/

- :har

- :er

- :ikke

- :hvor

- $OP

- 1

- 10

- 100

- 11

- 114

- 116

- 150

- 7

- 8

- a

- abstracts

- acceleratorer

- Acceptere

- adgang

- Ifølge

- opnå

- tilføje

- tilføje

- Yderligere

- Efter

- AI

- AI / ML

- Alle

- tildele

- allokeret

- tillader

- også

- Amazon

- Amazon SageMaker

- Amazon Web Services

- beløb

- an

- ,

- En anden

- enhver

- api

- Anvendelse

- tilgang

- arkitektur

- ER

- AS

- antage

- antaget

- antager

- At

- auto

- automatisk

- tilgængelighed

- til rådighed

- AWS

- baggrund

- baseret

- grundlæggende

- BE

- fordi

- været

- før

- vegne

- bag

- benchmark

- benchmarkes

- benchmarking

- BEDSTE

- Bringe

- bygge

- Bygning

- men

- by

- C + +

- Opkald

- CAN

- Kan få

- Kapacitet

- tilfælde

- forårsagede

- lave om

- afgift

- kontrollere

- Vælg

- vælge

- valgt

- kode

- Kolonne

- kombinationer

- Kom

- Fælles

- sammenlignet

- fuldføre

- kompleksiteter

- kompatibel

- komponent

- komponenter

- Compute

- computer

- Datalogi

- Computer Vision

- betingelser

- Konfiguration

- konsekvent

- Konsol

- Container

- Beholdere

- indhold

- kontrol

- bekvemt

- Tilsvarende

- Koste

- Omkostninger

- kunne

- dækket

- skabe

- skabelse

- Nuværende

- For øjeblikket

- kunde

- Kunder

- tilpasse

- Dallas

- data

- beslutning

- dyb

- Deepak

- dybere

- Standard

- definere

- Degree

- leverer

- leverer

- levering

- demonstrere

- indsætte

- indsat

- implementering

- implementering

- implementeringer

- Design

- ønskes

- detaljer

- Udvikler

- udviklere

- Udvikling

- forskellige

- direkte

- diskutere

- dykning

- do

- Docker

- Er ikke

- Domæner

- Dont

- i løbet af

- hver

- lette

- lettere

- nemt

- let

- edwards

- enten

- muliggøre

- muliggør

- ende

- Endpoint

- ingeniør

- forbedret

- nok

- sikre

- Miljø

- Ækvivalent

- fejl

- udviklinger

- eksempel

- udførelse

- eksisterende

- Udvid

- forventer

- erfaring

- Oplevelser

- eksperimenter

- Udforskning

- vender

- FAIL

- mislykkedes

- Kendskab

- FAST

- Feature

- Fields

- Finde

- Fornavn

- Fleksibilitet

- flow

- Fokus

- fokuserer

- efter

- Til

- format

- fundet

- grundlæggende

- Framework

- rammer

- Gratis

- fra

- forsiden

- forreste ende

- fuldt ud

- yderligere

- spil

- genererer

- få

- giver

- Go

- GPU

- Gruppens

- vejledning

- guidet

- havde

- Hardware

- Have

- he

- Helse

- hjælpe

- hjælpe

- Høj

- højt niveau

- hans

- besidder

- Hosting

- hosting omkostninger

- Hvordan

- How To

- Men

- HTML

- http

- HTTPS

- Hub

- Identity

- if

- billeder

- implementeret

- forbedringer

- forbedring

- in

- omfatter

- Forøg

- oplysninger

- Infrastruktur

- initial

- indgang

- instans

- integreret

- interaktiv

- grænseflade

- Internet

- ind

- isolation

- spørgsmål

- spørgsmål

- IT

- ITS

- Java

- JavaScript

- Job

- Karriere

- jpg

- json

- Kend

- viden

- etiket

- Sprog

- stor

- senere

- lancering

- føre

- LÆR

- læring

- Længde

- Niveau

- Li

- biblioteker

- Licens

- ligesom

- Line (linje)

- LINK

- links

- Liste

- LLM

- lastning

- lokale

- placeret

- placering

- log

- Se

- UDSEENDE

- elsker

- laveste

- maskine

- machine learning

- lavet

- lave

- maerker

- administrere

- lykkedes

- leder

- administrerer

- herres

- Match

- max

- maksimal

- Kan..

- midler

- Mød

- melanie

- Hukommelse

- Menu

- besked

- beskeder

- migrere

- minimum

- ML

- model

- modeller

- mere

- mest

- flere

- skal

- navn

- navne

- Naviger

- Navigation

- nødvendig

- Behov

- behov

- behøve

- netværk

- net

- Ny

- næste

- ingen

- node

- node.js

- Bemærk

- notesbog

- nu

- nummer

- objekt

- objekter

- of

- tilbyde

- on

- ONE

- online

- kun

- optimal

- optimering

- Optimer

- optimeret

- Option

- Indstillinger

- or

- Andet

- vores

- ud

- egen

- pakke

- emballeret

- emballage

- side

- brød

- del

- partner

- passerer

- sti

- mønstre

- Betal

- ydeevne

- fotografering

- PHP

- ping

- Place

- Steder

- perron

- Platforme

- plato

- Platon Data Intelligence

- PlatoData

- Vær venlig

- politik

- Populær

- portefølje

- Indlæg

- Forudsigelig

- foretrække

- Main

- Fortsæt

- behandle

- Produkt

- produktchef

- produktion

- programmatisk

- prospektive

- give

- forudsat

- udbyder

- giver

- offentlige

- offentliggjort

- sætte

- Python

- pytorch

- hurtigt

- rækkevidde

- forholdet

- Raw

- Læs

- Læsning

- klar

- grund

- anbefalinger

- reducerer

- henvise

- refererer

- Fjern

- fjernelse

- anmode

- anmodninger

- påkrævet

- Krav

- ressource

- Ressourcer

- Restauranter

- robust

- roller

- roller

- Værelse

- RÆKKE

- kører

- sagemaker

- SageMaker Inference

- Sam

- samme

- gemt

- skalerbar

- Scale

- skalering

- scenarie

- scenarier

- Videnskab

- forskere

- script

- SDK

- Søg

- Anden

- Sektion

- sektioner

- sikker

- sikkerhed

- se

- Vælg

- valgt

- udvælgelse

- send

- afsendelse

- senior

- tjeneste

- Tjenester

- servering

- sæt

- indstilling

- indstillinger

- Shadow

- deling

- Vis

- viste

- side

- Simpelt

- forenkle

- enkelt

- Software

- softwareudvikling

- Løsninger

- nogle

- specialiseret

- specifikke

- specifikt

- starte

- påbegyndt

- Starter

- Status

- Trin

- Steps

- opbevaring

- opbevaret

- ligetil

- struktureret

- Studio

- emne

- sådan

- Understøttet

- Understøtter

- sikker

- bord

- skræddersyet

- Tag

- mål

- hold

- vilkår

- vilkår og betingelser

- prøve

- Test

- tekst

- Tak

- at

- deres

- Them

- derefter

- Der.

- Disse

- ting

- denne

- dem

- Gennem

- tid

- til

- Tokens

- værktøj

- I alt

- Trafik

- Tog

- uddannet

- Kurser

- Transformation

- Traveling

- tuning

- to

- typen

- typer

- ui

- underliggende

- Opdatering

- Uploading

- brug

- brug tilfælde

- anvendte

- Bruger

- bruger

- ved brug af

- Ved hjælp af

- række

- udgave

- vice

- Specifikation

- vision

- Besøg

- gå

- ønsker

- var

- Vej..

- måder

- we

- web

- webservices

- Hvad

- som

- mens

- WHO

- Hele

- vilje

- med

- inden for

- uden

- Arbejde

- workflow

- virker

- ville

- skrivning

- XGBoost

- Du

- Din

- zephyrnet