Dette blogindlæg er skrevet sammen med Hwalsuk Lee på Upstage.

I dag er vi glade for at kunne meddele, at Solar fundamentmodel udviklet af Upstage er nu tilgængelig for kunder, der bruger Amazon SageMaker JumpStart. Solar er en stor sprogmodel (LLM) 100% fortrænet med Amazon SageMaker der overgår og bruger sin kompakte størrelse og kraftfulde track records til at specialisere sig i formålstræning, hvilket gør den alsidig på tværs af sprog, domæner og opgaver.

Du kan nu bruge Solar Mini Chat , Solar Mini Chat – Kvant fortrænede modeller inden for SageMaker JumpStart. SageMaker JumpStart er maskinlæring (ML) hub af SageMaker, der giver adgang til fundamentmodeller ud over indbyggede algoritmer for at hjælpe dig hurtigt i gang med ML.

I dette indlæg gennemgår vi, hvordan du opdager og implementerer Solar-modellen via SageMaker JumpStart.

Hvad er Solar-modellen?

Solar er en kompakt og kraftfuld model til engelsk og koreansk sprog. Det er specifikt finjusteret til multi-turn-chatformål og demonstrerer forbedret ydeevne på tværs af en bred vifte af naturlige sprogbehandlingsopgaver.

Solar Mini Chat-modellen er baseret på Solar 10.7B, med en 32-lags Lama 2 struktur, og initialiseret med fortrænede vægte fra Mistral 7B kompatibel med Llama 2-arkitekturen. Denne finjustering udstyrer den med evnen til at håndtere udvidede samtaler mere effektivt, hvilket gør den særlig velegnet til interaktive applikationer. Den anvender en skaleringsmetode kaldet dybdeopskalering (DUS), som består af dybdemæssig skalering og fortsat fortræning. DUS giver mulighed for en meget mere ligetil og effektiv forstørrelse af mindre modeller end andre skaleringsmetoder som f.eks. blanding af eksperter (MoE).

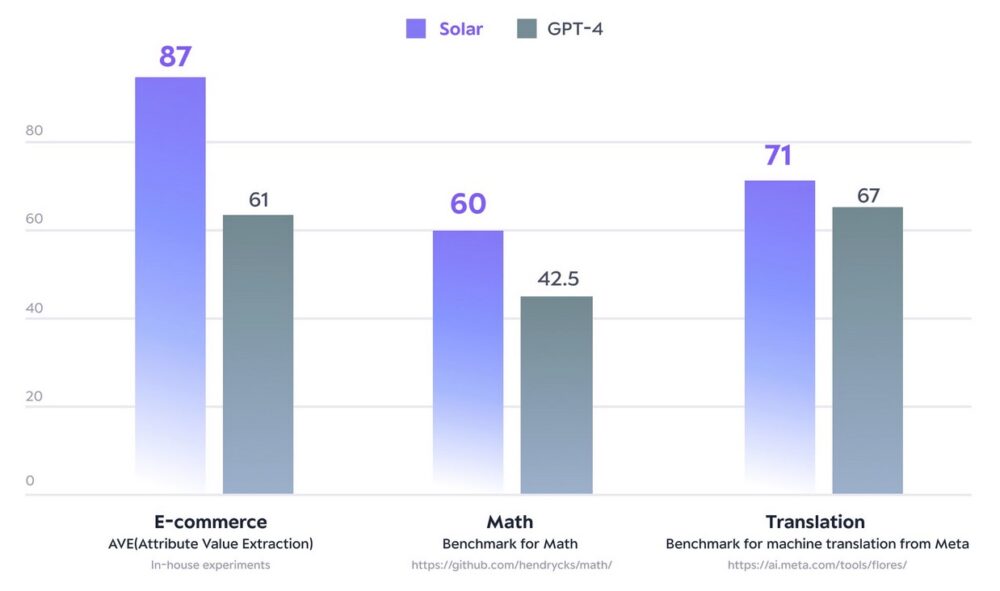

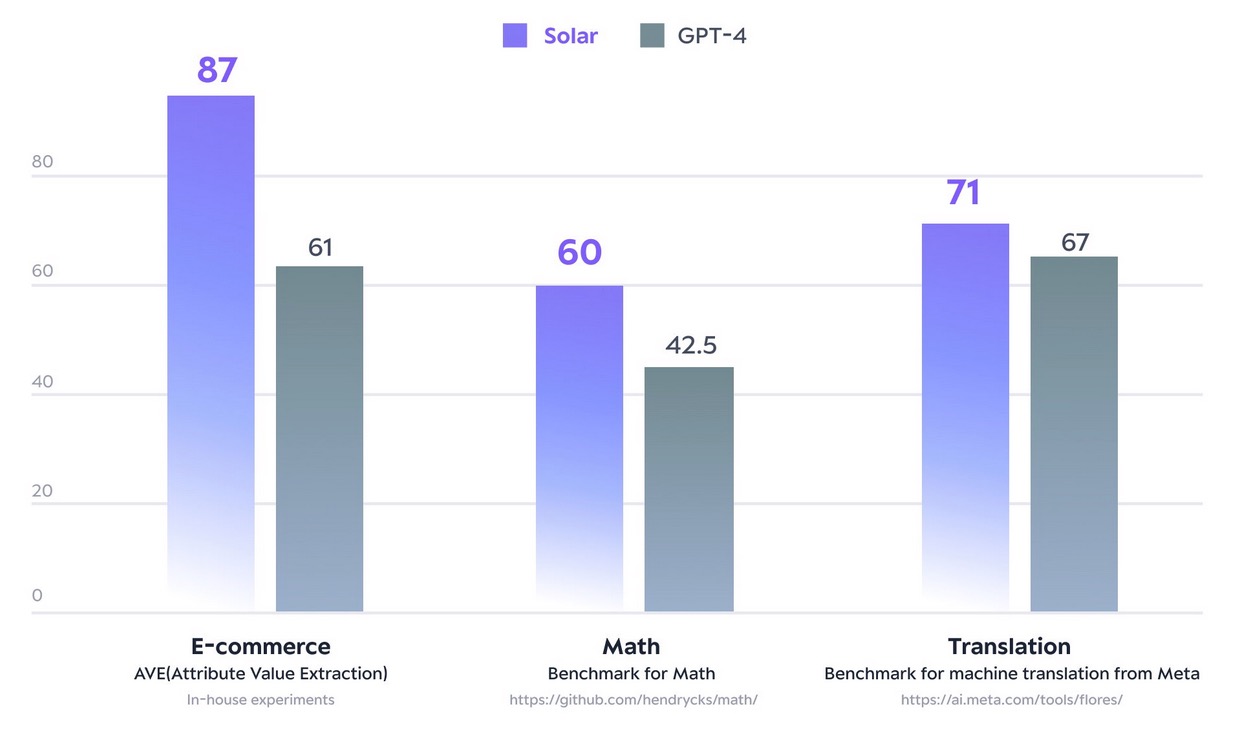

I december 2023 lavede Solar 10.7B-modellen bølger ved at nå toppen af Åbn LLM Leaderboard af kramme ansigt. Ved at bruge markant færre parametre leverer Solar 10.7B svar, der kan sammenlignes med GPT-3.5, men er 2.5 gange hurtigere. Sammen med at toppe Open LLM Leaderboard overgår Solar 10.7B GPT-4 med specialtrænede modeller på bestemte domæner og opgaver.

Følgende figur illustrerer nogle af disse målinger:

Med SageMaker JumpStart kan du implementere Solar 10.7B-baserede forudtrænede modeller: Solar Mini Chat og en kvantiseret version af Solar Mini Chat, optimeret til chatapplikationer på engelsk og koreansk. Solar Mini Chat-modellen giver en avanceret forståelse af koreanske sprognuancer, som markant løfter brugerinteraktioner i chatmiljøer. Det giver præcise svar på brugerinput, hvilket sikrer klarere kommunikation og mere effektiv problemløsning i engelske og koreanske chatapplikationer.

Kom godt i gang med Solar-modeller i SageMaker JumpStart

For at komme i gang med Solar-modeller kan du bruge SageMaker JumpStart, en fuldt administreret ML-hub-tjeneste til at implementere forudbyggede ML-modeller i et produktionsklart hostet miljø. Du kan få adgang til Solar-modeller gennem SageMaker JumpStart i Amazon SageMaker Studio, et webbaseret integreret udviklingsmiljø (IDE), hvor du kan få adgang til specialbyggede værktøjer til at udføre alle ML-udviklingstrin, fra forberedelse af data til opbygning, træning og implementering af dine ML-modeller.

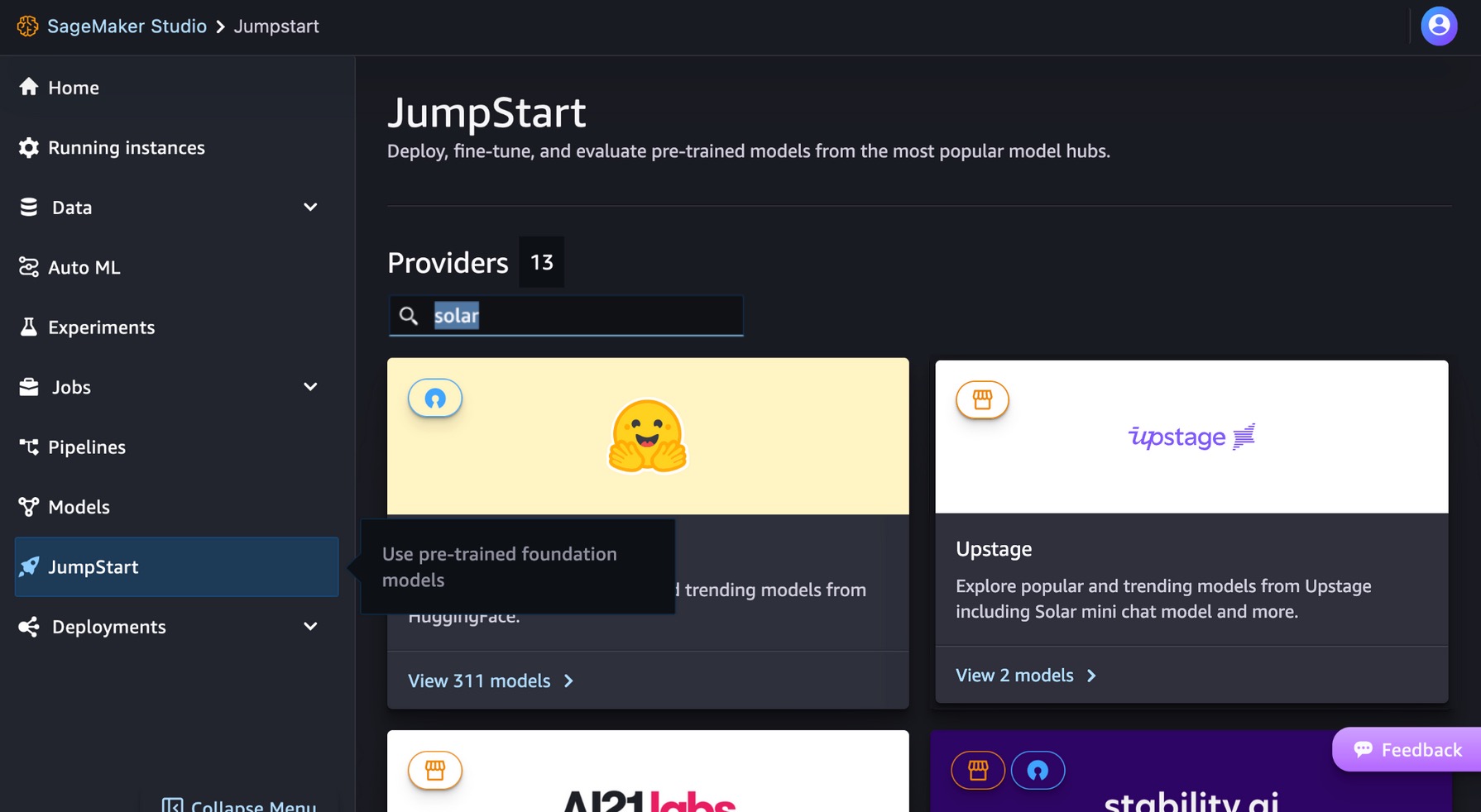

Vælg på SageMaker Studio-konsollen Forspring i navigationsruden. Du kan indtaste "solar" i søgefeltet for at finde Upstages solceller.

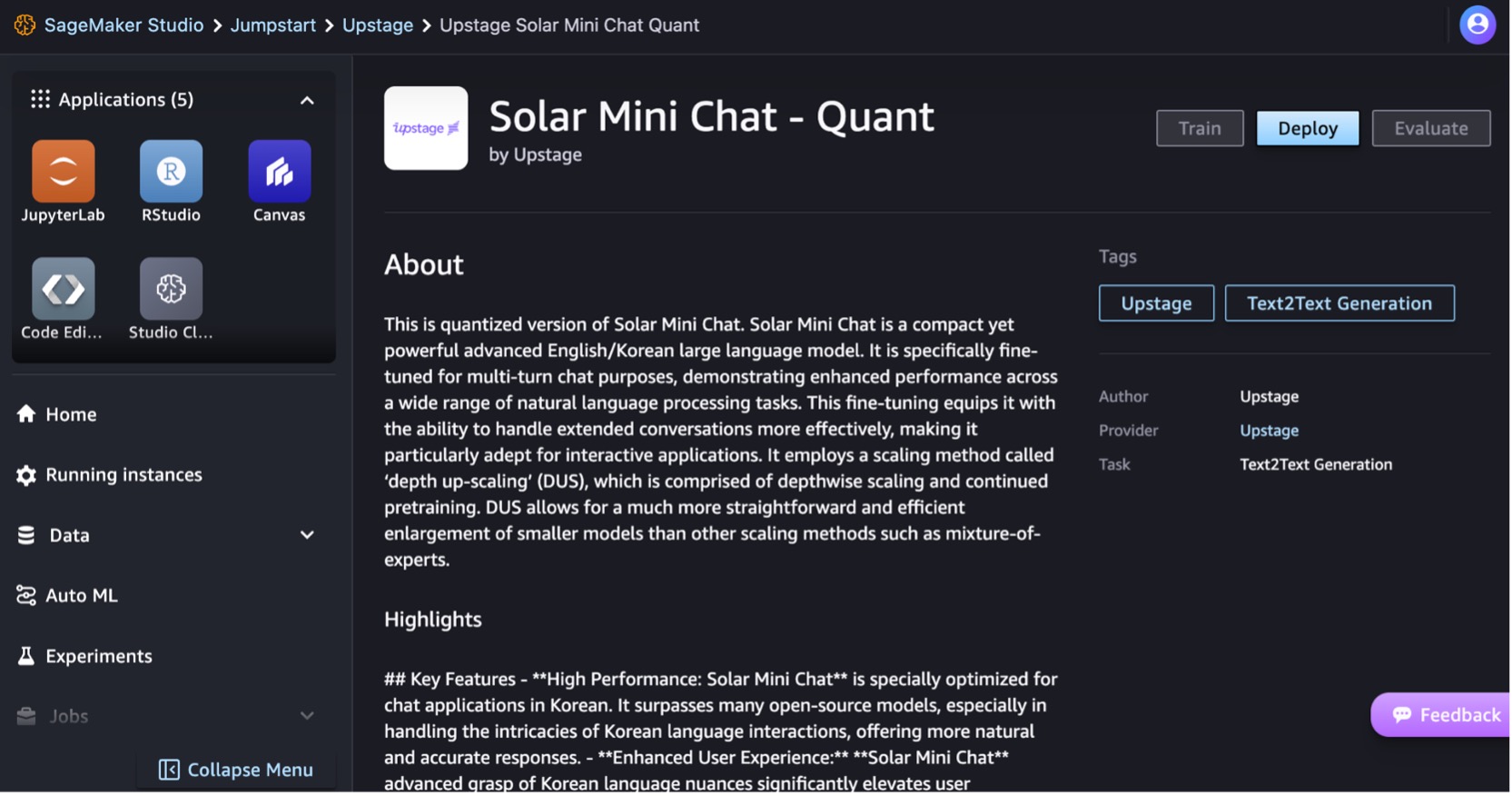

Lad os implementere Solar Mini Chat – Quant-modellen. Vælg modelkortet for at se detaljer om modellen, såsom licensen, data brugt til at træne, og hvordan du bruger modellen. Du finder også en Implementer mulighed, som fører dig til en landingsside, hvor du kan teste slutninger med et eksempel på nyttelast.

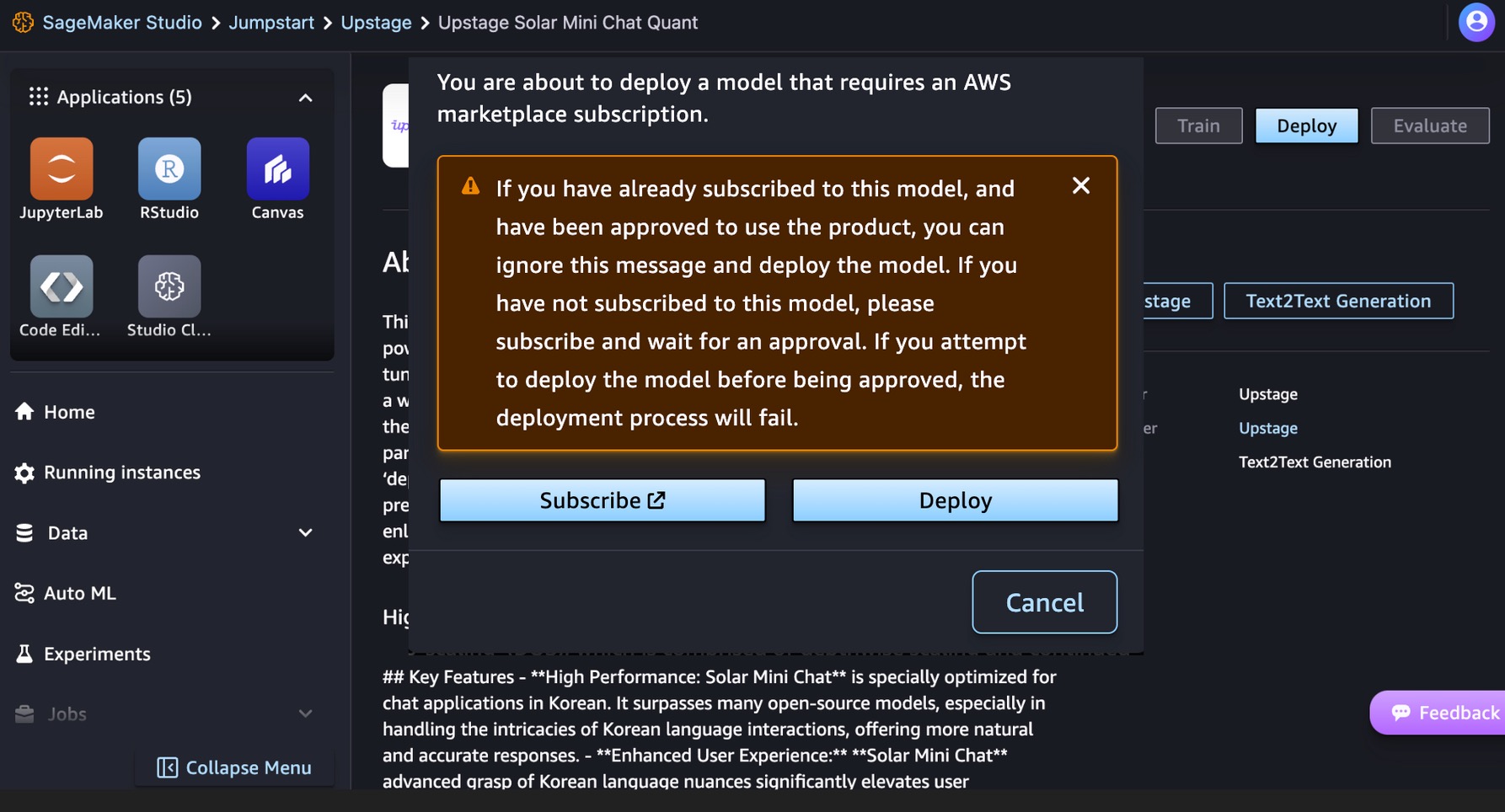

Denne model kræver en AWS Marketplace abonnement. Hvis du allerede har abonneret på denne model og er blevet godkendt til at bruge produktet, kan du implementere modellen direkte.

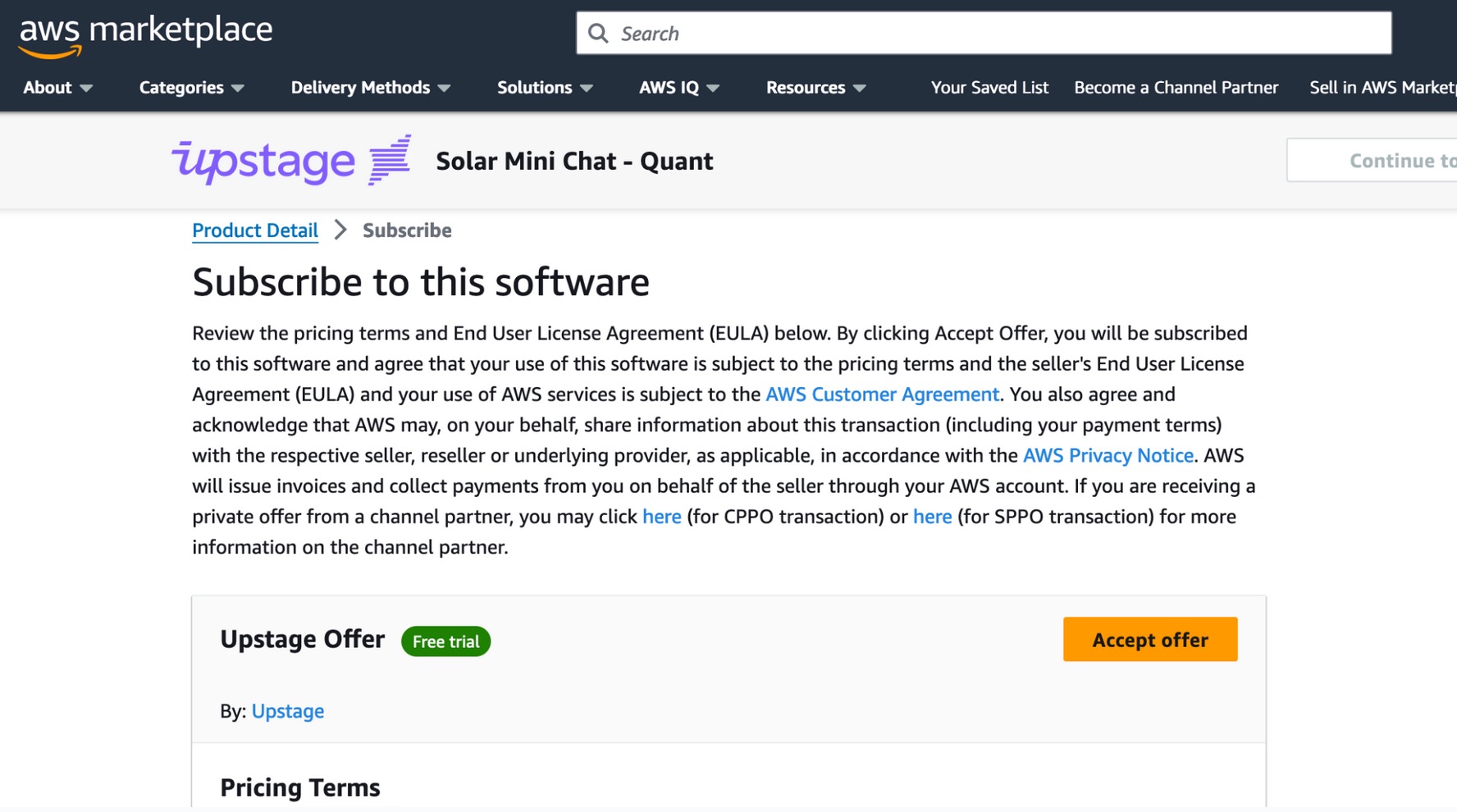

Hvis du ikke har abonneret på denne model, skal du vælge Tilmeld, gå til AWS Marketplace, gennemgå prisbetingelserne og slutbrugerlicensaftale (EULA), og vælg Accepter tilbud.

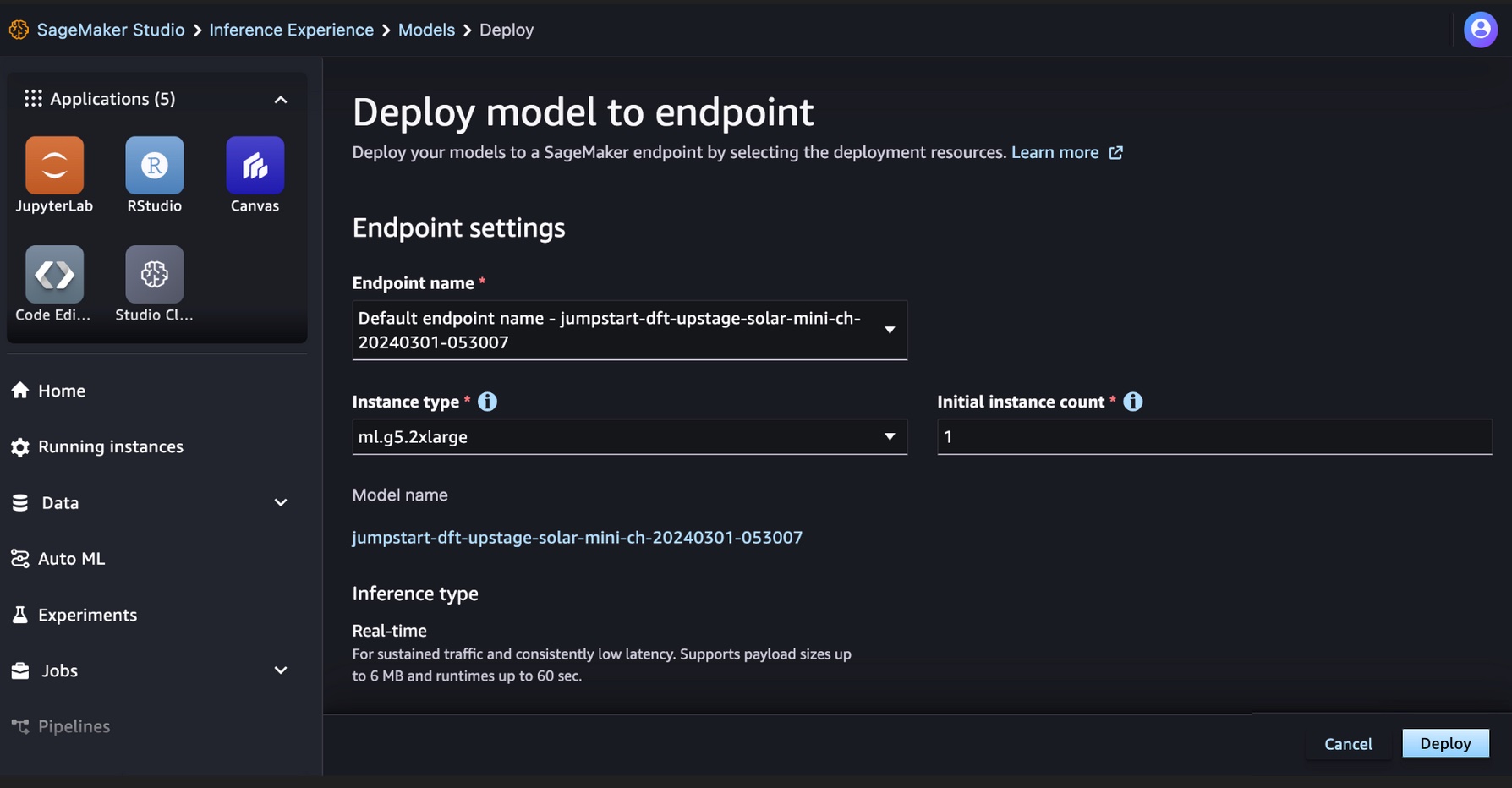

Når du har abonneret på modellen, kan du implementere din model til et SageMaker-slutpunkt ved at vælge implementeringsressourcerne, såsom instanstype og indledende instansantal. Vælge Implementer og vent, at der oprettes et slutpunkt for modelslutningen. Du kan vælge en ml.g5.2xlarge eksempel som en billigere mulighed for slutning med Solar-modellen.

Når dit SageMaker-slutpunkt er oprettet, kan du teste det gennem de forskellige SageMaker-applikationsmiljøer.

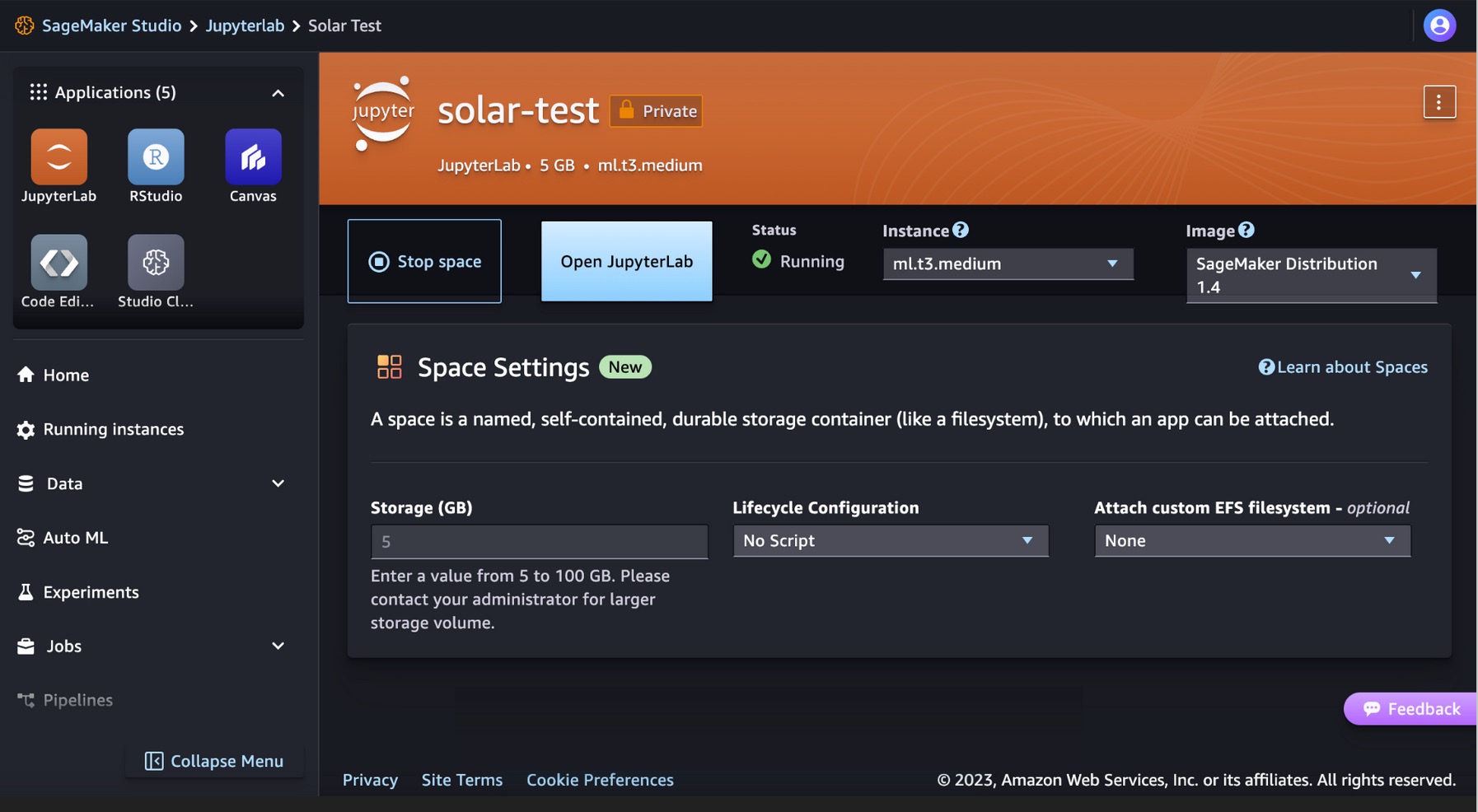

Kør din kode til Solar-modeller i SageMaker Studio JupyterLab

SageMaker Studio understøtter forskellige applikationsudviklingsmiljøer, herunder JupyterLab, et sæt funktioner, der udvider det fuldt administrerede notebook-udbud. Det inkluderer kerner, der starter på få sekunder, en forudkonfigureret runtime med populær datavidenskab, ML-frameworks og højtydende privat bloklagring. For mere information, se SageMaker JupyterLab.

Opret et JupyterLab-rum i SageMaker Studio, der administrerer de lager- og computerressourcer, der er nødvendige for at køre JupyterLab-applikationen.

Du kan finde koden, der viser implementeringen af Solar-modeller på SageMaker JumpStart og et eksempel på, hvordan du bruger den installerede model i GitHub repo. Du kan nu implementere modellen ved hjælp af SageMaker JumpStart. Følgende kode bruger standardforekomsten ml.g5.2xlarge til Solar Mini Chat – Quant model inference endpoint.

Solar-modeller understøtter en anmodning/svar-nyttelast, der er kompatibel med OpenAI's Chat-afslutningsslutpunkt. Du kan teste single-turn eller multi-turn chat eksempler med Python.

# Get a SageMaker endpoint

sagemaker_runtime = boto3.client("sagemaker-runtime")

endpoint_name = sagemaker.utils.name_from_base(model_name)

# Multi-turn chat prompt example

input = {

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Can you provide a Python script to merge two sorted lists?"

},

{

"role": "assistant",

"content": """Sure, here is a Python script to merge two sorted lists:

```python

def merge_lists(list1, list2):

return sorted(list1 + list2)

```

"""

},

{

"role": "user",

"content": "Can you provide an example of how to use this function?"

}

]

}

# Get response from the model

response = sagemaker_runtime.invoke_endpoint(EndpointName=endpoint_name, ContentType='application/json', Body=json.dumps (input))

result = json.loads(response['Body'].read().decode())

print resultDu har med succes udført en realtidsslutning med Solar Mini Chat-modellen.

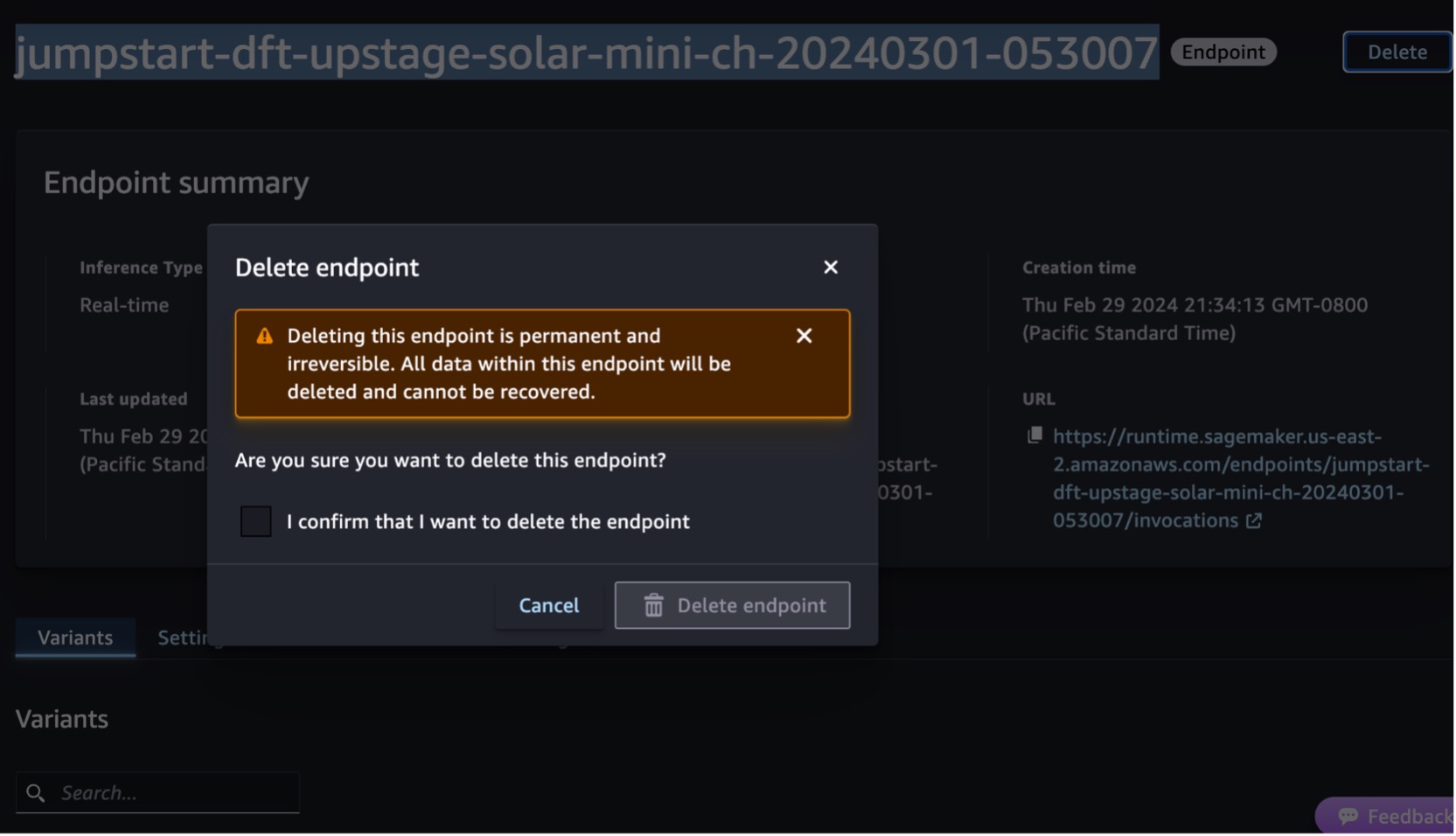

Ryd op

Når du har testet slutpunktet, skal du slette SageMaker-slutningsendepunktet og slette modellen for at undgå at pådrage dig gebyrer.

Du kan også køre følgende kode for at slette slutpunktet og tilstanden i SageMaker Studio JupyterLabs notesbog:

# Delete the endpoint

model.sagemaker_session.delete_endpoint(endpoint_name)

model.sagemaker_session.delete_endpoint_config(endpoint_name)

# Delete the model

model.delete_model()For mere information, se Slet slutpunkter og ressourcer. Derudover kan du lukke SageMaker Studio-ressourcerne som ikke længere er nødvendige.

Konklusion

I dette indlæg viste vi dig, hvordan du kommer i gang med Upstages Solar-modeller i SageMaker Studio og implementerer modellen til inferens. Vi viste dig også, hvordan du kan køre din Python-eksempelkode på SageMaker Studio JupyterLab.

Fordi Solar-modeller allerede er foruddannede, kan de hjælpe med at sænke uddannelses- og infrastrukturomkostninger og muliggøre tilpasning til dine generative AI-applikationer.

Prøv det på SageMaker JumpStart konsol or SageMaker Studio konsol! Du kan også se følgende video, Prøv 'Solar' med Amazon SageMaker.

Denne vejledning er kun til informationsformål. Du bør stadig udføre din egen uafhængige vurdering og træffe foranstaltninger for at sikre, at du overholder dine egne specifikke kvalitetskontrolpraksisser og standarder og de lokale regler, love, regler, licenser og brugsbetingelser, der gælder for dig, dit indhold, og den tredjepartsmodel, der henvises til i denne vejledning. AWS har ingen kontrol eller autoritet over den tredjepartsmodel, der henvises til i denne vejledning, og giver ingen erklæringer eller garantier for, at tredjepartsmodellen er sikker, virusfri, operationel eller kompatibel med dit produktionsmiljø og dine standarder. AWS giver ingen erklæringer, garantier eller garantier for, at nogen information i denne vejledning vil resultere i et bestemt resultat eller resultat.

Om forfatterne

Channy Yun er Principal Developer Advocate hos AWS og brænder for at hjælpe udviklere med at bygge moderne applikationer på de nyeste AWS-tjenester. Han er en pragmatisk udvikler og blogger i hjertet, og han elsker fællesskabsdrevet læring og deling af teknologi.

Channy Yun er Principal Developer Advocate hos AWS og brænder for at hjælpe udviklere med at bygge moderne applikationer på de nyeste AWS-tjenester. Han er en pragmatisk udvikler og blogger i hjertet, og han elsker fællesskabsdrevet læring og deling af teknologi.

Hwalsuk Lee er Chief Technology Officer (CTO) hos Upstage. Han har arbejdet for Samsung Techwin, NCSOFT og Naver som AI-forsker. Han forfølger sin ph.d. i computer- og elektroteknik ved Korea Advanced Institute of Science and Technology (KAIST).

Hwalsuk Lee er Chief Technology Officer (CTO) hos Upstage. Han har arbejdet for Samsung Techwin, NCSOFT og Naver som AI-forsker. Han forfølger sin ph.d. i computer- og elektroteknik ved Korea Advanced Institute of Science and Technology (KAIST).

Brandon Lee er Senior Solutions Architect hos AWS, og hjælper primært store uddannelsesteknologiske kunder i den Offentlige Sektor. Han har over 20 års erfaring med at lede applikationsudvikling hos globale virksomheder og store virksomheder.

Brandon Lee er Senior Solutions Architect hos AWS, og hjælper primært store uddannelsesteknologiske kunder i den Offentlige Sektor. Han har over 20 års erfaring med at lede applikationsudvikling hos globale virksomheder og store virksomheder.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/solar-models-from-upstage-are-now-available-in-amazon-sagemaker-jumpstart/

- :har

- :er

- :ikke

- :hvor

- 10

- 120

- 152

- 20

- 20 år

- 2023

- 7

- 990

- a

- evne

- Om

- Acceptere

- adgang

- tværs

- Desuden

- Derudover

- dygtig

- fremskreden

- fortaler

- Aftale

- AI

- algoritmer

- Alle

- tillader

- sammen

- allerede

- også

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- ,

- og infrastruktur

- Annoncere

- enhver

- Anvendelse

- Application Development

- applikationer

- Indløs

- godkendt

- arkitektur

- ER

- AS

- vurdering

- Assistant

- At

- forøge

- myndighed

- til rådighed

- undgå

- AWS

- AWS Marketplace

- Bar

- baseret

- BE

- været

- Bloker

- Blog

- krop

- Brandon

- bygge

- Bygning

- indbygget

- men

- by

- kaldet

- CAN

- kapaciteter

- kort

- vis

- afgifter

- chatte

- billigere

- chef

- Chief Technology Officer

- Vælg

- klarere

- kode

- Kommunikation

- Fællesskabsdrevet

- kompakt

- Virksomheder

- sammenlignelig

- kompatibel

- færdiggørelse

- overholde

- Indeholder

- Compute

- computer

- Konsol

- indhold

- fortsatte

- kontrol

- samtaler

- Selskaber

- Omkostninger

- tælle

- skabe

- oprettet

- CTO

- Kunder

- tilpasning

- data

- datalogi

- december

- Standard

- leverer

- demonstrerer

- indsætte

- indsat

- implementering

- implementering

- detaljer

- udviklet

- Udvikler

- udviklere

- Udvikling

- direkte

- opdage

- gør

- Domæner

- ned

- uddannelsesmæssige

- effektivt

- effektiv

- løfter

- beskæftiger

- muliggøre

- ende

- Endpoint

- Engineering

- Engelsk

- forbedret

- sikre

- sikring

- Indtast

- Miljø

- miljøer

- eksempel

- eksempler

- ophidset

- erfaring

- udvidet

- Ansigtet

- hurtigere

- færre

- Figur

- Finde

- efter

- Til

- Foundation

- rammer

- fra

- fuldt ud

- funktion

- generative

- Generativ AI

- få

- Global

- Go

- forståelse

- garantier

- vejledning

- håndtere

- Have

- he

- Hjerte

- hjælpe

- hjælpsom

- hjælpe

- hjælper

- link.

- Høj ydeevne

- hans

- hostede

- Hvordan

- How To

- HTML

- HTTPS

- Hub

- if

- illustrerer

- in

- omfatter

- Herunder

- uafhængig

- oplysninger

- Informational

- Infrastruktur

- initial

- indgang

- indgange

- instans

- Institut

- integreret

- interaktioner

- interaktiv

- ind

- IT

- ITS

- jpg

- json

- korea

- koreansk

- landing

- Sprog

- Sprog

- stor

- seneste

- Love

- leaderboard

- førende

- læring

- Lee

- Licens

- licenser

- Lister

- Llama

- LLM

- lokale

- længere

- elsker

- lavere

- maskine

- machine learning

- lavet

- lave

- Making

- lykkedes

- administrerer

- markedsplads

- foranstaltninger

- Flet

- beskeder

- Meta

- metode

- metoder

- Metrics

- ML

- tilstand

- model

- modeller

- Moderne

- mere

- mere effektiv

- meget

- Natural

- Natural Language Processing

- Naver

- Navigation

- behov

- ingen

- især

- notesbog

- nu

- nuancer

- of

- tilbyde

- tilbyde

- Officer

- on

- kun

- åbent

- operationelle

- optimeret

- Option

- or

- Andet

- ud

- Resultat

- udkonkurrerer

- i løbet af

- egen

- side

- brød

- parametre

- særlig

- især

- lidenskabelige

- Udfør

- ydeevne

- udføres

- phd

- foto

- tinde

- plato

- Platon Data Intelligence

- PlatoData

- Populær

- Indlæg

- vigtigste

- praksis

- pragmatisk

- brug

- forberede

- prissætning

- primært

- Main

- private

- Problem

- forarbejdning

- Produkt

- produktion

- give

- giver

- offentlige

- formål

- Python

- kvalitet

- Quant

- hurtigt

- rækkevidde

- nå

- ægte

- realtid

- optegnelser

- refereres

- regler

- påkrævet

- Kræver

- forsker

- Løsning

- Ressourcer

- svar

- reaktioner

- resultere

- afkast

- gennemgå

- roller

- regler

- Kør

- runtime

- sagemaker

- SageMaker Inference

- prøve

- Samsung

- skalering

- Videnskab

- Videnskab og Teknologi

- script

- Søg

- sekunder

- sektor

- sikker

- se

- Vælg

- udvælgelse

- senior

- tjeneste

- Tjenester

- sæt

- deling

- bør

- viste

- viser

- betydeligt

- Størrelse

- mindre

- sol

- Løsninger

- nogle

- Space

- specialisere

- specifikke

- specifikt

- standarder

- starte

- påbegyndt

- Steps

- Stadig

- opbevaring

- ligetil

- struktur

- Studio

- Hold mig opdateret

- abonnement

- Succesfuld

- sådan

- support

- Understøtter

- sikker

- systemet

- Tag

- tager

- opgaver

- Teknologier

- vilkår

- prøve

- afprøvet

- end

- at

- Disse

- de

- tredjepart

- denne

- Gennem

- tid

- gange

- til

- værktøjer

- spor

- Tog

- Kurser

- to

- typen

- brug

- anvendte

- Bruger

- bruger

- ved brug af

- forskellige

- alsidige

- udgave

- via

- video

- Specifikation

- vente

- gå

- garantier

- Ur

- bølger

- we

- web

- webservices

- web-baseret

- som

- bred

- Bred rækkevidde

- vilje

- med

- inden for

- arbejdede

- år

- Du

- Din

- youtube

- zephyrnet