Opsummering er teknikken til at kondensere betydelig information til en kompakt og meningsfuld form og står som en hjørnesten i effektiv kommunikation i vores informationsrige tidsalder. I en verden fuld af data sparer det tid og hjælper med at træffe informerede beslutninger ved at opsummere lange tekster i korte opsummeringer. Sammenfatning fortætter indhold, sparer tid og forbedrer klarhed ved at præsentere information kortfattet og sammenhængende. Opsummering er uvurderlig for beslutningstagning og håndtering af store mængder indhold.

Opsummeringsmetoder har en bred vifte af applikationer, der tjener forskellige formål, såsom:

- Nyhedssammenlægning - Nyhedssammenlægning går ud på at sammenfatte nyhedsartikler til et nyhedsbrev til mediebranchen

- Sammenfatning af juridisk dokument - Sammenfatning af juridisk dokument hjælper advokater med at udtrække vigtige juridiske oplysninger fra lange dokumenter som vilkår, betingelser og kontrakter

- Akademisk forskning – Opsummering annoterer, indekserer, kondenserer og forenkler vigtig information fra akademiske artikler

- Indholdskuration til blogs og hjemmesider – Du kan oprette engagerende og originale indholdsresuméer til læsere, især inden for markedsføring

- Finansielle rapporter og markedsanalyser – Du kan udtrække økonomisk indsigt fra rapporter og lave executive summary til investorpræsentationer i finansbranchen

Med fremskridtene inden for naturlig sprogbehandling (NLP), sprogmodeller og generativ AI, er opsummerende tekster af varierende længde blevet mere tilgængelige. Værktøjer som Langkæde, kombineret med en stor sprogmodel (LLM) drevet af Amazonas grundfjeld or Amazon SageMaker JumpStart, forenkle implementeringsprocessen.

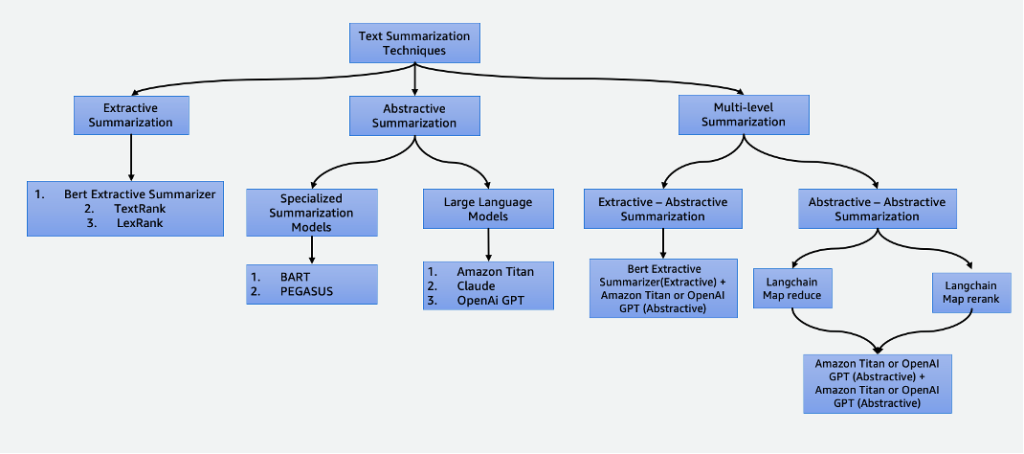

Dette indlæg dykker ned i følgende opsummeringsteknikker:

- Ekstraktiv opsummering ved hjælp af BERT ekstraktiv opsummering

- Abstrakt opsummering ved hjælp af specialiserede opsummeringsmodeller og LLM'er

- To opsummeringsteknikker på flere niveauer:

- Ekstraktiv-abstraktiv opsummering ved hjælp af den ekstraktiv-abstraktive indholdsopsummeringsstrategi (EACSS)

- Abstrakt-abstraktiv opsummering ved hjælp af Map Reduce og Map ReRank

Det komplette kodeeksempel findes i GitHub repo. Du lancere denne løsning in Amazon SageMaker Studio.

Klik her for at åbne AWS-konsollen og følg med.

Typer af opsummeringer

Der er flere teknikker til at opsummere tekst, som i store træk er kategoriseret i to hovedtilgange: udvindende , abstrakte opsummering. Desuden inkorporerer multi-level summary methodologier en række trin, der kombinerer både ekstraktive og abstraktive teknikker. Disse multi-level tilgange er fordelagtige, når man beskæftiger sig med tekst med tokens længere end grænsen for en LLM, hvilket muliggør en forståelse af komplekse fortællinger.

Ekstraktiv opsummering

Ekstraktiv opsummering er en teknik, der bruges i NLP og tekstanalyse til at skabe et resumé ved at udtrække nøglesætninger. I stedet for at generere nye sætninger eller indhold som i abstrakt opsummering, bygger ekstraktiv opsummering på at identificere og trække de mest relevante og informative dele af den originale tekst ud for at skabe en komprimeret version.

Ekstraktiv opsummering, selvom det er fordelagtigt til at bevare det originale indhold og sikre høj læsbarhed ved direkte at trække vigtige sætninger fra kildeteksten, har begrænsninger. Den mangler kreativitet, er ude af stand til at generere nye sætninger og kan overse nuancerede detaljer og muligvis gå glip af vigtig information. Desuden kan det producere lange resuméer, nogle gange overvældende læsere med overdreven og uønsket information. Der er mange ekstraktive opsummeringsteknikker, som f.eks TextRank , LexRank. I dette indlæg fokuserer vi på BERT-ekstraktive summarizer.

BERT ekstraktiv opsummerer

BERT ekstraktiv opsummerer er en type ekstraktiv opsummeringsmodel, der bruger BERT-sprogmodellen til at udtrække de vigtigste sætninger fra en tekst. BERTI er en fortrænet sprogmodel, der kan finjusteres til en række forskellige opgaver, herunder tekstresumé. Det fungerer ved først at indlejre sætningerne i teksten ved hjælp af BERT. Dette producerer en vektorrepræsentation for hver sætning, der fanger dens betydning og kontekst. Modellen bruger derefter en klyngealgoritme til at gruppere sætningerne i klynger. De sætninger, der er tættest på midten af hver klynge, er udvalgt til at danne resuméet.

Sammenlignet med LLM'er er fordelen ved BERT ekstraktiv summarizer, at den er relativt ligetil at træne og implementere modellen, og den er mere forklarlig. Ulempen er, at sammenfatningen ikke er kreativ og genererer ikke sætninger. Den vælger kun sætninger fra den originale tekst. Dette begrænser dens evne til at opsummere komplekse eller nuancerede tekster.

Abstrakt opsummering

Abstrakt opsummering er en teknik, der bruges i NLP og tekstanalyse til at skabe et resumé, der går ud over blot udtræk af sætninger eller sætninger fra kildeteksten. I stedet for at udvælge og omorganisere eksisterende indhold, genererer abstrakt opsummering nye sætninger eller sætninger, der fanger den oprindelige teksts kernebetydning og hovedideer i en mere fortættet og sammenhængende form. Denne tilgang kræver, at modellen forstår tekstens indhold og udtrykker det på en måde, der ikke nødvendigvis er til stede i kildematerialet.

Specialiserede opsummeringsmodeller

Disse fortrænede naturlige sprogmodeller, som f.eks BART , PEGASUS, er specielt skræddersyet til tekstopsummeringsopgaver. De anvender encoder-decoder-arkitekturer og er mindre i parametre sammenlignet med deres modparter. Denne reducerede størrelse giver mulighed for nem finjustering og implementering på mindre forekomster. Det er dog vigtigt at bemærke, at disse opsummeringsmodeller også kommer med mindre input- og outputtokenstørrelser. I modsætning til deres mere generelle modparter er disse modeller udelukkende designet til opsummeringsopgaver. Som følge heraf er det input, der kræves til disse modeller, udelukkende den tekst, der skal opsummeres.

Store sprogmodeller

A stor sprogmodel henviser til enhver model, der gennemgår træning på omfattende og forskelligartede datasæt, typisk gennem selvovervåget læring i stor skala, og som er i stand til at blive finjusteret til at passe til en bred vifte af specifikke downstream-opgaver. Disse modeller er større i parameterstørrelse og klarer sig bedre i opgaver. Især har de væsentligt større input token-størrelser, nogle af dem op til 100,000, såsom Anthropic's Claude. For at bruge en af disse modeller tilbyder AWS den fuldt administrerede tjeneste Amazon Bedrock. Hvis du har brug for mere kontrol over modeludviklingens livscyklus, kan du implementere LLM'er gennem SageMaker.

På grund af deres alsidige karakter kræver disse modeller specifikke opgaveinstruktioner, der leveres gennem inputtekst, en praksis, der omtales som hurtig ingeniørarbejde. Denne kreative proces giver forskellige resultater baseret på modeltypen og inputteksten. Effektiviteten af både modellens ydeevne og promptens kvalitet har væsentlig indflydelse på den endelige kvalitet af modellens output. Følgende er nogle tips, når tekniske beder om opsummering:

- Medtag teksten for at opsummere – Indtast den tekst, der skal opsummeres. Dette tjener som kildemateriale til resuméet.

- Definer opgaven – Sig tydeligt, at målet er tekstresumé. For eksempel, "Opsummer følgende tekst: [input tekst]."

- Giv kontekst – Tilbyd en kort introduktion eller kontekst for den givne tekst, der skal opsummeres. Dette hjælper modellen med at forstå indholdet og konteksten. For eksempel, "Du får følgende artikel om kunstig intelligens og dens rolle i sundhedsvæsenet: [inputtekst]."

- Bed om resuméet – Bed modellen om at generere et resumé af den medfølgende tekst. Vær klar over den ønskede længde eller format af resuméet. For eksempel: "Generer venligst et kortfattet resumé af den givne artikel om kunstig intelligens og dens rolle i sundhedsvæsenet: [inputtekst]."

- Indstil begrænsninger eller længderetningslinjer – Styr eventuelt længden af resuméet ved at angive et ønsket ordantal, sætningsantal eller tegnbegrænsning. For eksempel, "Generer venligst en oversigt, der ikke er længere end 50 ord: [input tekst]."

Effektiv prompt engineering er afgørende for at sikre, at de genererede resuméer er nøjagtige, relevante og afstemt med den tilsigtede opsummeringsopgave. Forfin prompten for optimalt opsummeringsresultat med eksperimenter og iterationer. Når du har fastslået effektiviteten af prompterne, kan du genbruge dem med brug af prompte skabeloner.

Opsummering på flere niveauer

Ekstraktive og abstrakte opsummeringer er nyttige til kortere tekster. Men når inputteksten overskrider modellens maksimale token-grænse, bliver det nødvendigt at opsummere på flere niveauer. Opsummering på flere niveauer involverer en kombination af forskellige opsummeringsteknikker, såsom ekstraktive og abstrakte metoder, for effektivt at kondensere længere tekster ved at anvende flere lag af opsummeringsprocesser. I dette afsnit diskuterer vi to opsummeringsteknikker på flere niveauer: ekstraktiv-abstraktiv opsummering og abstrakt-abstraktiv opsummering.

Ekstraktiv-abstraktiv opsummering

Ekstraktiv-abstraktiv opsummering fungerer ved først at generere en ekstraktiv sammenfatning af teksten. Derefter bruger den et abstrakt opsummeringssystem til at forfine det ekstraktive resumé, hvilket gør det mere kortfattet og informativt. Dette øger nøjagtigheden ved at give mere informative resuméer sammenlignet med udvindingsmetoder alene.

Strategi for ekstraktiv-abstraktiv indholdsopsummering

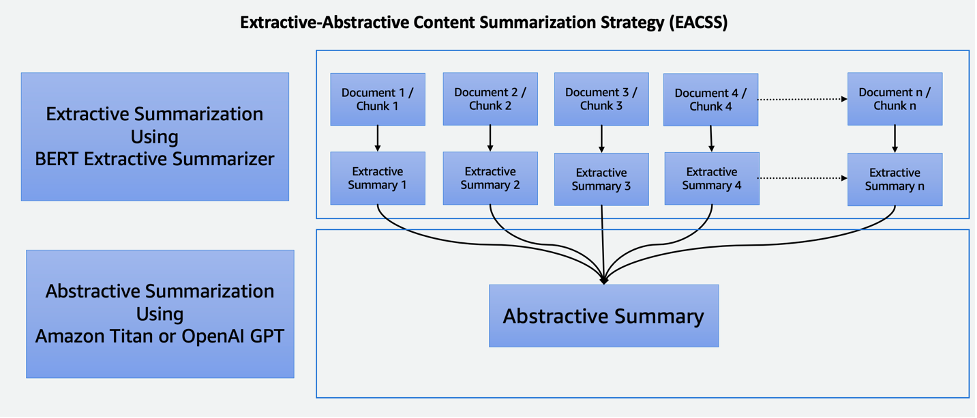

EACSS-teknikken kombinerer styrkerne ved to kraftfulde teknikker: BERT-ekstraktive summarizer for den ekstraktive fase og LLM'er for den abstrakte fase, som illustreret i følgende diagram.

EACSS tilbyder flere fordele, herunder bevarelse af afgørende information, forbedret læsbarhed og tilpasningsevne. Implementering af EACSS er dog beregningsmæssigt dyrt og komplekst. Der er en risiko for potentielt informationstab, og kvaliteten af opsummeringen afhænger i høj grad af de underliggende modellers ydeevne, hvilket gør omhyggelig modelvalg og justering afgørende for at opnå optimale resultater. Implementeringen omfatter følgende trin:

- Det første skridt er at opdele det store dokument, såsom en bog, i mindre sektioner, eller bidder. Disse bidder er defineret som sætninger, afsnit eller endda kapitler, afhængigt af den ønskede granularitet for resuméet.

- Til udvindingsfasen anvender vi BERT ekstraktiv summarizer. Denne komponent fungerer ved at indlejre sætningerne i hver del og derefter anvende en klyngealgoritme til at identificere sætninger, der er tættest på klyngens tyngdepunkter. Dette udvindingstrin hjælper med at bevare det vigtigste og mest relevante indhold fra hver del.

- Efter at have genereret ekstraktive resuméer for hver del, går vi videre til den abstrakte opsummeringsfase. Her bruger vi LLM'er kendt for deres evne til at generere sammenhængende og kontekstuelt relevante resuméer. Disse modeller tager de udtrukne resuméer som input og producerer abstrakte resuméer, der fanger essensen af det originale dokument, samtidig med at de sikrer læsbarhed og sammenhæng.

Ved at kombinere ekstraktive og abstrakte opsummeringsteknikker tilbyder denne tilgang en effektiv og omfattende måde at opsummere lange dokumenter såsom bøger. Det sikrer, at vigtig information udtrækkes, samtidig med at det tillader generering af kortfattede og menneskeligt læsbare resuméer, hvilket gør det til et værdifuldt værktøj til forskellige applikationer inden for dokumentresumé.

Abstraktiv-abstraktiv opsummering

Abstraktiv-abstraktiv opsummering er en tilgang, hvor der anvendes abstrakte metoder til både at udtrække og generere resuméer. Det giver bemærkelsesværdige fordele, herunder forbedret læsbarhed, sammenhæng og fleksibiliteten til at justere resuméets længde og detaljer. Det udmærker sig i sproggenerering, hvilket giver mulighed for parafrasering og undgåelse af redundans. Der er dog ulemper. For eksempel er det beregningsmæssigt dyrt og ressourcekrævende, og dets kvalitet afhænger i høj grad af effektiviteten af de underliggende modeller, som, hvis de ikke er veltrænede eller alsidige, kan påvirke kvaliteten af de genererede oversigter. Valg af modeller er afgørende for at afbøde disse udfordringer og sikre abstrakte resuméer af høj kvalitet. Til abstrakt-abstraktiv opsummering diskuterer vi to strategier: Kortreducer og Kort ReRank.

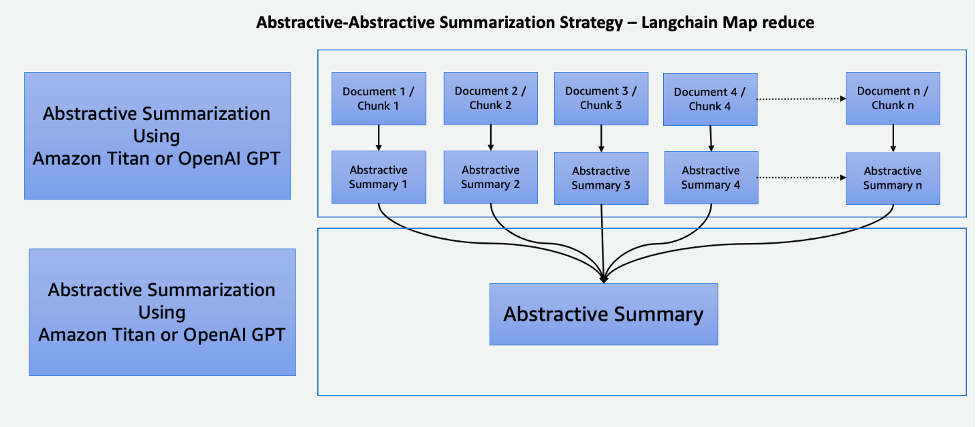

Kort Reducer ved hjælp af LangChain

Denne to-trins proces omfatter en Kort-trin og et Reducer-trin, som illustreret i følgende diagram. Denne teknik giver dig mulighed for at opsummere et input, der er længere end modellens inputtoken-grænse.

Processen består af tre hovedtrin:

- Korpuserne er opdelt i mindre bidder, der passer ind i LLM's token-grænse.

- Vi bruger et korttrin til individuelt at anvende en LLM-kæde, der udtrækker al vigtig information fra hver passage, og dens output bruges som en ny passage. Afhængig af korpusernes størrelse og struktur kan dette være i form af overordnede temaer eller korte resuméer.

- Reduceringstrinnet kombinerer outputpassagerne fra korttrinnet eller et reduktionstrin, så det passer til token-grænsen og fører det ind i LLM. Denne proces gentages, indtil det endelige output er en enkelt passage.

Fordelen ved at bruge denne teknik er, at den er meget skalerbar og paralleliserbar. Al behandling i hvert trin er uafhængig af hinanden, hvilket drager fordel af distribuerede systemer eller serverløse tjenester og lavere beregningstid.

Kort ReRank ved hjælp af LangChain

Denne kæde kører en indledende prompt på hvert dokument, der ikke kun forsøger at fuldføre en opgave, men også giver en score for, hvor sikker den er i sit svar. Det højeste scorende svar returneres.

Denne teknik minder meget om Map Reduce, men med fordelen ved at kræve færre overordnede opkald, hvilket strømliner opsummeringsprocessen. Dens begrænsning ligger imidlertid i dens manglende evne til at flette information på tværs af flere dokumenter. Denne begrænsning gør den mest effektiv i scenarier, hvor et enkelt, ligetil svar forventes fra et enkelt dokument, hvilket gør det mindre egnet til mere komplekse eller mangefacetterede informationssøgningsopgaver, der involverer flere kilder. Omhyggelig overvejelse af konteksten og arten af dataene er afgørende for at bestemme, om denne metode er egnet til specifikke opsummeringsbehov.

Cohere ReRank bruger et semantisk-baseret omrangeringssystem, der kontekstualiserer betydningen af en brugers forespørgsel ud over søgeordsrelevans. Det bruges sammen med vektorbutikssystemer såvel som søgeordsbaserede søgemaskiner, hvilket giver det fleksibilitet.

Sammenligning af opsummeringsteknikker

Hver opsummeringsteknik har sine egne unikke fordele og ulemper:

- Ekstraktiv opsummering bevarer det originale indhold og sikrer høj læsbarhed, men mangler kreativitet og kan give lange opsummeringer.

- Abstrakt opsummering, mens den tilbyder kreativitet og genererer kortfattede, flydende opsummeringer, indebærer risikoen for utilsigtet indholdsændring, udfordringer med sprognøjagtighed og ressourcekrævende udvikling.

- Ekstraktiv-abstraktiv opsummering på flere niveauer opsummerer effektivt store dokumenter og giver bedre fleksibilitet til at finjustere den ekstraktive del af modellerne. Det er dog dyrt, tidskrævende og mangler parallelisering, hvilket gør parameterjustering udfordrende.

- Abstraktiv-abstraktiv opsummering på flere niveauer opsummerer også effektivt store dokumenter og udmærker sig i forbedret læsbarhed og sammenhæng. Det er dog beregningsmæssigt dyrt og ressourcekrævende, og det er stærkt afhængigt af effektiviteten af de underliggende modeller.

Omhyggelig modelvalg er afgørende for at afbøde udfordringer og sikre abstrakte resuméer af høj kvalitet i denne tilgang. Følgende tabel opsummerer mulighederne for hver type opsummering.

| Aspect | Ekstraktiv opsummering | Abstrakt opsummering | Opsummering på flere niveauer |

| Generer kreative og engagerende resuméer | Ingen | Ja | Ja |

| Bevar originalt indhold | Ja | Ingen | Ingen |

| Afbalancere informationsbevaring og kreativitet | Ingen | Ja | Ja |

| Velegnet til kort, objektiv tekst (input tekstlængde mindre end modellens maksimale tokens) | Ja | Ja | Ingen |

| Effektiv til længere, komplekse dokumenter såsom bøger (input tekstlængde større end modellens maksimale tokens) | Ingen | Ingen | Ja |

| Kombinerer udvinding og indholdsgenerering | Ingen | Ingen | Ja |

Opsummeringsteknikker på flere niveauer er velegnede til lange og komplekse dokumenter, hvor inputtekstlængden overstiger modellens token-grænse. Følgende tabel sammenligner disse teknikker.

| Teknik | Fordele | Ulemper |

| EACSS (ekstraktiv-abstraktiv) | Bevarer afgørende information, giver mulighed for at finjustere den ekstraktive del af modellerne. | Beregningsmæssigt dyrt, potentielt informationstab og mangler parallelisering. |

| Kort Reducer (abstraktiv-abstraktiv) | Skalerbar og paralleliserbar med mindre beregningstid. Den bedste teknik til at generere kreative og kortfattede resuméer. | Hukommelseskrævende proces. |

| Map ReRank (abstraktiv-abstraktiv) | Strømlinet opsummering med semantisk-baseret rangering. | Begrænset informationssammenlægning. |

Tips til at opsummere tekst

Overvej følgende bedste praksis, når du opsummerer tekst:

- Vær opmærksom på den samlede tokenstørrelse – Vær forberedt på at opdele teksten, hvis den overskrider modellens token-grænser, eller brug flere opsummeringsniveauer, når du bruger LLM'er.

- Vær opmærksom på typen og antallet af datakilder – Kombination af information fra flere kilder kan kræve transformationer, klar organisation og integrationsstrategier. Langkæde ting har integration på en lang række datakilder og dokumenttyper. Det forenkler processen med at kombinere tekst fra forskellige dokumenter og datakilder ved brug af denne teknik.

- Vær opmærksom på modelspecialisering – Nogle modeller kan udmærke sig ved visse typer indhold, men kæmper med andre. Der kan være finjusterede modeller, der passer bedre til dit tekstdomæne.

- Brug opsummering på flere niveauer til store tekster – For tekster, der overskrider token-grænserne, skal du overveje en opsummeringstilgang på flere niveauer. Start med et resumé på højt niveau for at fange hovedideerne og opsummer derefter gradvist underafsnit eller kapitler for at få mere detaljeret indsigt.

- Opsummer tekst efter emner – Denne tilgang hjælper med at opretholde et logisk flow og reducere informationstab, og den prioriterer opbevaring af afgørende information. Hvis du bruger LLM'er, skal du lave klare og specifikke prompter, der guider modellen til at opsummere et bestemt emne i stedet for hele teksten.

Konklusion

Opsummering står som et vigtigt værktøj i vores informationsrige æra, der muliggør effektiv destillation af omfattende information til kortfattede og meningsfulde former. Det spiller en central rolle i forskellige domæner og tilbyder adskillige fordele. Opsummering sparer tid ved hurtigt at formidle væsentligt indhold fra lange dokumenter, hjælper beslutningstagningen ved at udtrække kritisk information og forbedrer forståelsen af uddannelse og indholdskuration.

Dette indlæg gav et omfattende overblik over forskellige opsummeringsteknikker, herunder ekstraktive, abstrakte og multi-level tilgange. Med værktøjer som LangChain og sprogmodeller kan du udnytte kraften ved opsummering til at strømline kommunikation, forbedre beslutningstagning og frigøre det fulde potentiale i enorme informationslagre. Sammenligningstabellen i dette indlæg kan hjælpe dig med at identificere de bedst egnede opsummeringsteknikker til dine projekter. Derudover tjener de tips, der er delt i indlægget, som værdifulde retningslinjer for at undgå gentagne fejl, når du eksperimenterer med LLM'er til tekstresumé. Denne praktiske rådgivning giver dig mulighed for at anvende den opnåede viden, hvilket sikrer en vellykket og effektiv opsummering i projekterne.

Referencer

Om forfatterne

Nick Biso er Machine Learning Engineer hos AWS Professional Services. Han løser komplekse organisatoriske og tekniske udfordringer ved hjælp af data science og engineering. Derudover bygger og implementerer han AI/ML-modeller på AWS Cloud. Hans passion strækker sig til hans tilbøjelighed til at rejse og forskellige kulturelle oplevelser.

Nick Biso er Machine Learning Engineer hos AWS Professional Services. Han løser komplekse organisatoriske og tekniske udfordringer ved hjælp af data science og engineering. Derudover bygger og implementerer han AI/ML-modeller på AWS Cloud. Hans passion strækker sig til hans tilbøjelighed til at rejse og forskellige kulturelle oplevelser.

Suhas chowdary Jonnalagadda er dataforsker hos AWS Global Services. Han brænder for at hjælpe virksomhedskunder med at løse deres mest komplekse problemer med kraften i AI/ML. Han har hjulpet kunder med at transformere deres forretningsløsninger på tværs af forskellige brancher, herunder finans, sundhedspleje, bank, e-handel, medier, reklame og marketing.

Suhas chowdary Jonnalagadda er dataforsker hos AWS Global Services. Han brænder for at hjælpe virksomhedskunder med at løse deres mest komplekse problemer med kraften i AI/ML. Han har hjulpet kunder med at transformere deres forretningsløsninger på tværs af forskellige brancher, herunder finans, sundhedspleje, bank, e-handel, medier, reklame og marketing.

Tabby Ward er en Principal Cloud Architect/Strategic Technical Advisor med omfattende erfaring med at migrere kunder og modernisere deres applikationsarbejdsmængde og tjenester til AWS. Med over 25 års erfaring med udvikling og arkitektur af software er hun anerkendt for sin dybe dykkeevne såvel som for at tjene kunders og partneres tillid til at designe arkitekturer og løsninger på tværs af flere teknologiske stakke og cloud-udbydere.

Tabby Ward er en Principal Cloud Architect/Strategic Technical Advisor med omfattende erfaring med at migrere kunder og modernisere deres applikationsarbejdsmængde og tjenester til AWS. Med over 25 års erfaring med udvikling og arkitektur af software er hun anerkendt for sin dybe dykkeevne såvel som for at tjene kunders og partneres tillid til at designe arkitekturer og løsninger på tværs af flere teknologiske stakke og cloud-udbydere.

Shyam Desai er en Cloud Engineer for big data og maskinlæringstjenester hos AWS. Han understøtter big data-applikationer og kunder på virksomhedsniveau ved hjælp af en kombination af softwareingeniørekspertise med datavidenskab. Han har omfattende viden inden for computersyn og billedbehandlingsapplikationer til kunstig intelligens, såvel som biomedicinske og bioinformatiske applikationer.

Shyam Desai er en Cloud Engineer for big data og maskinlæringstjenester hos AWS. Han understøtter big data-applikationer og kunder på virksomhedsniveau ved hjælp af en kombination af softwareingeniørekspertise med datavidenskab. Han har omfattende viden inden for computersyn og billedbehandlingsapplikationer til kunstig intelligens, såvel som biomedicinske og bioinformatiske applikationer.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://aws.amazon.com/blogs/machine-learning/techniques-for-automatic-summarization-of-documents-using-language-models/

- :har

- :er

- :ikke

- :hvor

- 1

- 100

- 11

- 20

- 25

- 50

- 7

- 8

- 9

- a

- evne

- Om

- akademisk

- tilgængelig

- nøjagtighed

- præcis

- opnå

- tværs

- Desuden

- Derudover

- fremskridt

- Fordel

- fordelagtige

- fordele

- Reklame

- rådgivning

- rådgiver

- Efter

- alder

- aggregering

- AI

- AI / ML

- hjælpemidler

- algoritme

- justeret

- Alle

- tillade

- tillader

- alene

- sammen

- også

- Skønt

- Amazon

- Amazon Web Services

- an

- analyse

- ,

- besvare

- Antropisk

- enhver

- Anvendelse

- applikationer

- Indløs

- Anvendelse

- tilgang

- tilgange

- ER

- Array

- artikel

- artikler

- kunstig

- kunstig intelligens

- AS

- At

- Automatisk Ur

- undgå

- undgå

- opmærksom på

- AWS

- AWS Professional Services

- Bank

- baseret

- BE

- bliver

- bliver

- være

- BEDSTE

- bedste praksis

- Bedre

- Beyond

- Big

- Big data

- biomedicinsk

- blogs

- organer

- krop

- bog

- Bøger

- både

- Pause

- bred

- bredt

- bygger

- virksomhed

- men

- .

- by

- Opkald

- CAN

- kapaciteter

- stand

- fange

- fanger

- forsigtig

- center

- vis

- kæde

- udfordringer

- udfordrende

- kapitler

- karakter

- klarhed

- klar

- tydeligt

- klik

- Cloud

- Cluster

- klyngedannelse

- kode

- SAMMENHÆNGENDE

- kombination

- kombineret

- kombinerer

- kombinerer

- Kom

- kommer

- Kommunikation

- kompakt

- sammenlignet

- sammenligning

- fuldføre

- komplekse

- komponent

- omfattende

- omfatter

- Compute

- computer

- Computer Vision

- kortfattet

- betingelser

- Overvej

- overvejelse

- består

- Konsol

- begrænsninger

- forbrugende

- indhold

- Indholdskuration

- sammenhæng

- kontrol

- Core

- hjørnesten

- kunne

- modparter

- håndværk

- skabe

- Kreativ

- kreativitet

- kritisk

- afgørende

- kulturelle

- datasikring

- Kunder

- data

- datalogi

- dataforsker

- datasæt

- beskæftiger

- Beslutningstagning

- afgørelser

- definerede

- Afhængigt

- afhænger

- indsætte

- implementering

- udruller

- Design

- konstrueret

- ønskes

- detail

- detaljeret

- detaljer

- Bestem

- udvikling

- Udvikling

- forskellige

- direkte

- Ulempe

- diskutere

- distribueret

- distribuerede systemer

- forskelligartede

- dokumentet

- dokumenter

- Er ikke

- domæne

- Domæner

- ned

- ulemper

- hver

- Optjening

- lette

- ecommerce

- Uddannelse

- Effektiv

- effektivt

- effektivitet

- effektiv

- indlejring

- anvendelse

- bemyndiger

- muliggør

- muliggør

- engagerende

- ingeniør

- Engineering

- Motorer

- forbedret

- Forbedrer

- sikre

- sikrer

- sikring

- Enterprise

- enterprise-niveau

- Era

- fejl

- især

- Essensen

- væsentlig

- etableret

- Endog

- eksempel

- overstige

- overstiger

- Excel

- overdreven

- udelukkende

- udøvende

- eksisterende

- forventet

- dyrt

- erfaring

- Oplevelser

- eksperimenter

- ekspertise

- Express

- udvider

- omfattende

- Omfattende oplevelse

- ekstrakt

- udvinding

- Uddrag

- Feature

- færre

- endelige

- finansiere

- Fornavn

- passer

- Fleksibilitet

- flow

- Fokus

- følger

- efter

- Til

- formular

- format

- formularer

- fundet

- fra

- fuld

- fuldt ud

- Endvidere

- vundet

- generelle formål

- generere

- genereret

- genererer

- generere

- generation

- generative

- Generativ AI

- given

- giver

- Give

- Global

- Goes

- gå

- større

- gruppe

- vejlede

- retningslinjer

- seletøj

- Have

- he

- sundhedspleje

- stærkt

- hjælpe

- hjulpet

- hjælpe

- hjælper

- hende

- link.

- Høj

- højt niveau

- høj kvalitet

- højeste

- stærkt

- hans

- Hvordan

- Men

- HTML

- HTTPS

- læsbar

- ideer

- identificere

- identificere

- if

- Imaging

- KIMOs Succeshistorier

- implementering

- gennemføre

- vigtigt

- Forbedre

- forbedring

- in

- manglende evne

- omfatter

- Herunder

- indarbejde

- uafhængig

- indekser

- Individuelt

- industrier

- indflydelse

- oplysninger

- informative

- informeret

- initial

- indgang

- indsigt

- i stedet

- anvisninger

- integration

- Intelligens

- beregnet

- ind

- Introduktion

- uvurderlig

- investor

- involvere

- IT

- iterationer

- ITS

- jpg

- Nøgle

- viden

- kendt

- Sprog

- stor

- større

- lag

- læring

- Politikker

- Længde

- mindre

- niveauer

- ligger

- livscyklus

- ligesom

- GRÆNSE

- begrænsning

- begrænsninger

- grænser

- LLM

- logisk

- Lang

- længere

- off

- lavere

- maskine

- machine learning

- Main

- vedligeholde

- lave

- maerker

- Making

- lykkedes

- styring

- mange

- kort

- Marked

- Marketing

- materiale

- maksimal

- Kan..

- betyder

- meningsfuld

- Medier

- blotte

- Flet

- sammenlægning

- metode

- metoder

- metoder

- migrere

- mangler

- afbøde

- model

- modeller

- modernisering

- mere

- Desuden

- mest

- bevæge sig

- mangefacetteret

- flere

- fortællinger

- Natural

- Natural Language Processing

- Natur

- nødvendigvis

- nødvendig

- Behov

- behov

- Ny

- nyheder

- Nyhedsbrev

- NLP

- ingen

- bemærkelsesværdig

- især

- Bemærk

- roman

- nummer

- talrige

- objektiv

- of

- tilbyde

- tilbyde

- Tilbud

- on

- ONE

- kun

- åbent

- optimal

- or

- organisation

- organisatorisk

- original

- Andet

- Andre

- vores

- ud

- udfald

- output

- udgange

- i løbet af

- samlet

- overordnet

- oversigt

- overvældende

- egen

- parameter

- parametre

- del

- særlig

- partnere

- passage

- lidenskab

- lidenskabelige

- Udfør

- ydeevne

- fase

- sætninger

- afgørende

- plato

- Platon Data Intelligence

- PlatoData

- spiller

- Indlæg

- potentiale

- potentielt

- magt

- strøm

- vigtigste

- Praktisk

- praksis

- praksis

- forberedt

- præsentere

- Præsentationer

- bevarelse

- bevare

- Main

- prioriterer

- problemer

- behandle

- Processer

- forarbejdning

- producere

- producerer

- professionel

- professionelle partnere

- gradvist

- projekter

- prompter

- forudsat

- udbydere

- giver

- leverer

- trækker

- formål

- kvalitet

- rækkevidde

- Ranking

- læsere

- anerkendt

- reducere

- Reduceret

- benævnt

- refererer

- raffinere

- relativt

- relevans

- relevant

- stole

- reorganisering

- gentaget

- repetitiv

- Rapporter

- repræsentation

- kræver

- påkrævet

- Kræver

- ressource

- ressourceintensive

- svar

- begrænsning

- resultere

- Resultater

- tilbageholdelse

- genbruge

- Risiko

- roller

- løber

- sagemaker

- besparelse

- skalerbar

- Scale

- scenarier

- Videnskab

- Videnskabsmand

- score

- scoring

- Søg

- Søgemaskiner

- Sektion

- sektioner

- valgt

- udvælgelse

- valg

- dømme

- Series

- tjener

- Serverless

- tjener

- tjeneste

- Tjenester

- servering

- flere

- delt

- hun

- Kort

- betydeligt

- lignende

- forenkler

- forenkle

- enkelt

- ental

- betydelige

- Størrelse

- størrelser

- mindre

- Software

- software Engineering

- Alene

- Løsninger

- SOLVE

- Løser

- nogle

- sommetider

- Kilde

- Kilder

- specialiserede

- specifikke

- specifikt

- delt

- Stakke

- står

- starte

- Tilstand

- Trin

- Steps

- butik

- ligetil

- strategier

- Strategi

- strømline

- strømlining

- styrker

- struktur

- Kamp

- væsentligt

- vellykket

- sådan

- Dragt

- egnede

- opsummere

- RESUMÉ

- Understøtter

- hurtigt

- systemet

- Systemer

- bord

- skræddersyet

- Tag

- tager

- Opgaver

- opgaver

- tech

- Teknisk

- teknik

- teknikker

- vilkår

- tekst

- end

- at

- Projekterne

- The Source

- deres

- Them

- temaer

- derefter

- Der.

- Disse

- de

- denne

- tre

- Gennem

- tid

- tips

- til

- token

- Tokens

- værktøj

- værktøjer

- emne

- Emner

- I alt

- Tog

- Kurser

- transformationer

- omdanne

- rejse

- Stol

- tuning

- to

- typen

- typer

- typisk

- ude af stand

- gennemgår

- underliggende

- forstå

- forståelse

- enestående

- I modsætning til

- låse

- indtil

- uønsket

- brug

- anvendte

- bruger

- ved brug af

- udnytte

- Værdifuld

- række

- forskellige

- Varierende

- Vast

- alsidige

- udgave

- meget

- vision

- afgørende

- mængder

- Vej..

- we

- web

- webservices

- GODT

- hvornår

- som

- mens

- Hele

- bred

- Wikipedia

- med

- inden for

- ord

- ord

- virker

- world

- år

- udbytter

- Du

- Din

- zephyrnet