En video postet af en Vision Pro-udvikler ser ud til at vise de nuværende niveauer af håndsporing og okklusionsydelse, som Apples nye headset er i stand til.

Apple Vision Pro, forventes lanceret i løbet af de næste par måneder, vil bruge håndsporing som sin primære inputmetode. Mens interaktioner på systemniveau kombinerer håndsporing med øjensporing for en "se og tryk"-modalitet, kan udviklere også bygge applikationer, der giver brugerne mulighed for at interagere direkte med applikationer ved hjælp af deres hænder.

Håndsporing på Vision Pro kan opdeles i to forskellige funktioner: 'håndsporing' og 'håndokklusion'.

Håndsporing er den estimerede 3D-model af hånden, dens led og fingerspidsernes position. Denne model bruges til at bestemme, hvornår objekter bliver rørt, grebet og interageret med.

Håndokklusion handler om, hvordan systemet overlejrer din rigtige hånd på virtuelt indhold. I stedet for at tegne en 3D-model af en virtuel hånd ind i scenen, skærer Vision Pro billedet af dine rigtige hænder ud for i stedet at vise dem i scenen. Hvis du gør det, tilføjer du endnu et lag af realisme til det virtuelle indhold, fordi du kan se dine egne, unikke hænder.

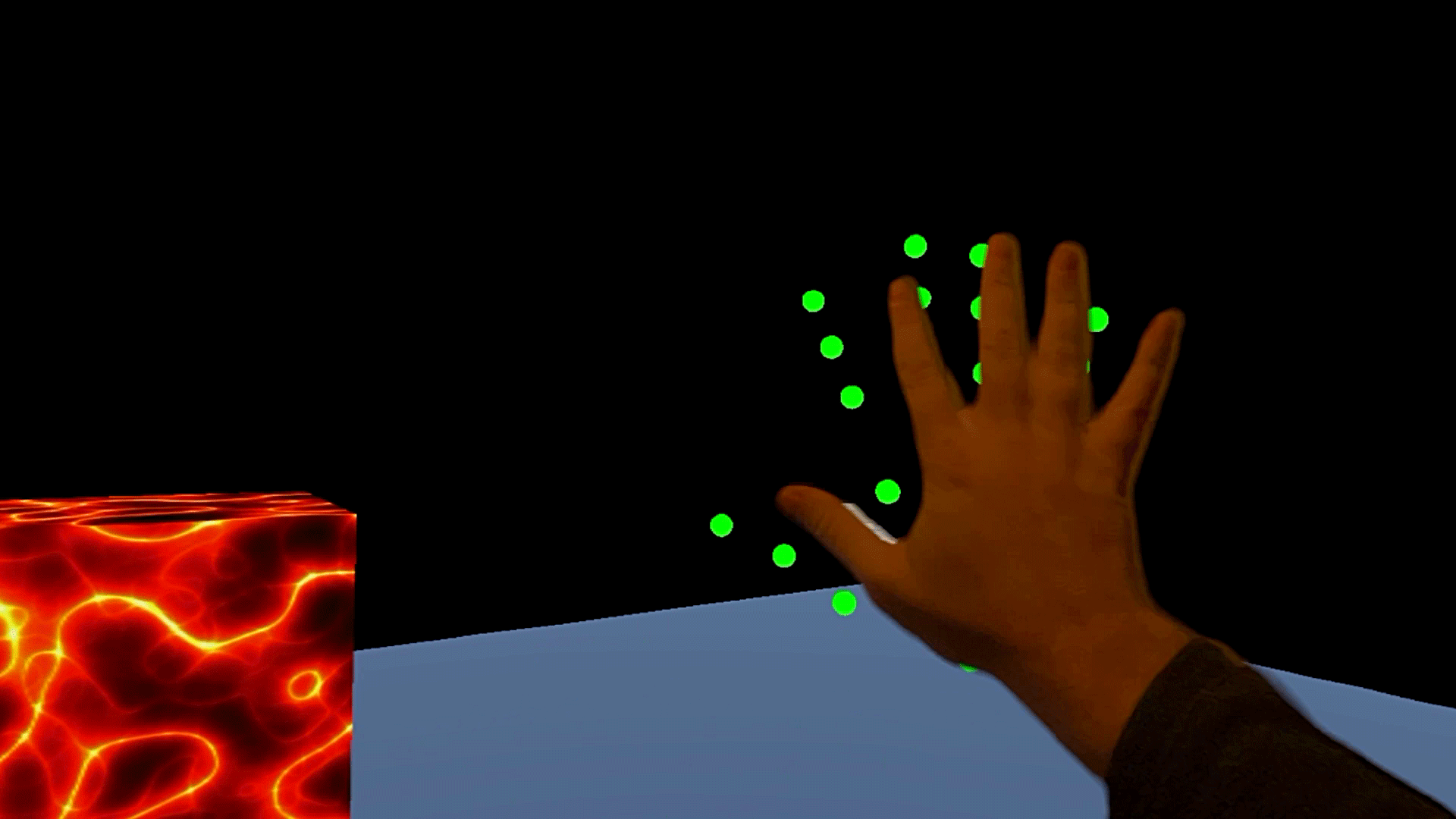

En udviklerbygning til Vision Pro ved hjælp af Unity postede en video, som giver et klart blik på både håndsporing og okklusion.

I videoen ovenfor viser de rigtige hænder okklusionssystemet i aktion, mens de grønne prikker viser håndens estimerede 3D-position.

Vi kan se, at håndokklusion er meget god, men ikke perfekt; når du er helt omgivet af virtuelt indhold og bevæger dig hurtigt, kan du se nogle klip omkring håndens kanter.

I mellemtiden halter den faktiske håndsporingsposition længere efter håndokklusionen, et sted omkring 100-200 ms bagud. Vi kan dog ikke helt bestemme den sande latens af Vision Pro's håndsporing, fordi vi kun har et overblik over de okklusionssporende hænder at sammenligne det med (som selv vil have en vis latenstid med hensyn til de rigtige hænder).

I denne sammenhæng kommer videoen fra en Unity-udviklersamtale, der siger, at deres tidlige eksperimenter med Vision Pro viste meget høj håndsporingsforsinkelse, tilsyneladende i sammenligning med de seneste Quest-håndsporingsfunktioner. Andre Unity-udviklere var enige om, at de så lignende latency på deres egne Vision Pro-enheder.

Den pågældende video er dog en håndsporingsintegration inde i en Unity-app, hvilket betyder, at håndsporingsydelsen og latensen kan have yderligere faktorer relateret til Unity, som ikke er til stede, når du bruger Apples førsteparts Vision Pro-udviklingsværktøjer. Og i betragtning af at headsettet ikke er lanceret endnu, og disse værktøjer stadig er under udvikling, kan vi se yderligere forbedringer, når headsettet rent faktisk når butikkerne.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk dig selv. Adgang her.

- PlatoAiStream. Web3 intelligens. Viden forstærket. Adgang her.

- PlatoESG. Kulstof, CleanTech, Energi, Miljø, Solenergi, Affaldshåndtering. Adgang her.

- PlatoHealth. Bioteknologiske og kliniske forsøgs intelligens. Adgang her.

- Kilde: https://www.roadtovr.com/apple-vision-pro-unity-hand-tracking-occlusion/

- :er

- :ikke

- 3d

- a

- over

- Handling

- faktiske

- faktisk

- Yderligere

- Tilføjer

- aftalt

- tillade

- også

- ,

- En anden

- app

- kommer til syne

- Apple

- applikationer

- ER

- omkring

- AS

- At

- BE

- fordi

- bag

- både

- Broken

- bygge

- Bygning

- men

- by

- CAN

- kapaciteter

- stand

- klar

- kombinerer

- kommer

- sammenligne

- sammenligning

- Overvejer

- indhold

- sammenhæng

- Samtale

- Nuværende

- nedskæringer

- Tilbud

- Bestem

- Udvikler

- udviklere

- Udvikling

- udviklingsværktøjer

- Enheder

- direkte

- distinkt

- gør

- tegning

- Tidligt

- helt

- anslået

- eksperimenter

- faktorer

- få

- fingerspidser

- Til

- fra

- yderligere

- giver

- glimt

- godt

- Grøn

- hånd

- hænder

- Have

- Headset

- Høj

- Hvordan

- Men

- HTTPS

- billede

- forbedringer

- in

- indgang

- indvendig

- i stedet

- integration

- interagere

- interaktioner

- ind

- IT

- ITS

- Latency

- seneste

- lancere

- lanceret

- lag

- niveauer

- Se

- Kan..

- midler

- metode

- model

- flytning

- Ny

- nyt headset

- næste

- objekter

- of

- Tilbud

- on

- kun

- på

- Andet

- ud

- egen

- perfekt

- ydeevne

- plato

- Platon Data Intelligence

- PlatoData

- position

- indsendt

- præsentere

- primære

- om

- Quest

- quest håndsporing

- spørgsmål

- hurtigt

- helt

- hellere

- når

- ægte

- realisme

- betragte

- siger

- scene

- se

- se

- Vis

- viste

- lignende

- So

- nogle

- et eller andet sted

- Stadig

- forhandler

- omgivet

- systemet

- end

- at

- deres

- Them

- selv

- Disse

- de

- denne

- tid

- til

- værktøjer

- rørt

- sand

- to

- enestående

- enhed

- brug

- anvendte

- brugere

- ved brug af

- meget

- video

- Specifikation

- Virtual

- vision

- we

- var

- hvornår

- som

- mens

- vilje

- med

- endnu

- Du

- Din

- zephyrnet