Wir freuen uns, heute bekannt geben zu können, dass das vom Technology Innovation Institute (TII) entwickelte und auf Amazon SageMaker geschulte Falcon 180B-Grundmodell für Kunden verfügbar ist Amazon SageMaker-JumpStart Bereitstellung mit einem Klick zum Ausführen von Inferenzen. Mit einer Parametergröße von 180 Milliarden und trainiert auf einem riesigen Datensatz mit 3.5 Billionen Token ist Falcon 180B das größte und eines der leistungsstärksten Modelle mit offen zugänglichen Gewichten. Sie können dieses Modell mit SageMaker JumpStart ausprobieren, einem Hub für maschinelles Lernen (ML), der Zugriff auf Algorithmen, Modelle und ML-Lösungen bietet, damit Sie schnell mit ML beginnen können. In diesem Beitrag erfahren Sie, wie Sie das Falcon 180B-Modell über SageMaker JumpStart entdecken und bereitstellen.

Was ist Falcon 180B?

Falcon 180B ist ein Modell von ICH S das folgt auf frühere Veröffentlichungen der Falcon-Familie. Es handelt sich um eine vergrößerte Version von Falcon 40B und nutzt die Aufmerksamkeit mehrerer Abfragen für eine bessere Skalierbarkeit. Es handelt sich um ein autoregressives Sprachmodell, das eine optimierte Transformatorarchitektur verwendet. Es wurde auf 3.5 Billionen Datentokens trainiert, die hauptsächlich aus Webdaten von bestehen RefinedWeb (ca. 85 %). Das Modell verfügt über zwei Versionen: 180B und 180B-Chat. 180B ist ein rohes, vorab trainiertes Modell, das für die meisten Anwendungsfälle weiter verfeinert werden sollte. 180B-Chat eignet sich besser für allgemeine Anweisungen. Das Chat-Modell wurde anhand von Chat- und Befehlsdatensätzen sowie mehreren umfangreichen Konversationsdatensätzen verfeinert.

Das Modell wird unter der zur Verfügung gestellt Falcon-180B TII-Lizenz und Acceptable Use Policy.

Falcon 180B wurde von TII trainiert Amazon Sage Maker, auf einem Cluster von etwa 4K A100 GPUs. Es verwendete eine benutzerdefinierte verteilte Trainingscodebasis namens Gigatron, die 3D-Parallelität mit ZeRO nutzt, und benutzerdefinierte, leistungsstarke Triton-Kernel. Die verwendete verteilte Trainingsarchitektur Amazon Simple Storage-Service (Amazon S3) als einziger einheitlicher Dienst zum Laden von Daten sowie zum Schreiben und Lesen von Prüfpunkten, was insbesondere zur Zuverlässigkeit der Arbeitslast und zur Einfachheit des Betriebs beitrug.

Was ist SageMaker JumpStart?

Mit SageMaker JumpStart können ML-Praktiker aus einer wachsenden Liste leistungsstärkster Grundlagenmodelle wählen. ML-Praktiker können Basismodelle auf dedizierten SageMaker-Instanzen in einer netzwerkisolierten Umgebung bereitstellen und Modelle mithilfe von Amazon SageMaker für die Modellschulung und -bereitstellung anpassen.

Sie können Falcon 180B jetzt mit wenigen Klicks entdecken und einsetzen Amazon SageMaker-Studio oder programmgesteuert über das SageMaker Python SDK, sodass Sie Modellleistung und MLOps-Steuerelemente mit SageMaker-Funktionen wie ableiten können Amazon SageMaker-Pipelines, Amazon SageMaker-Debuggeroder Containerprotokolle. Das Modell wird in einer sicheren AWS-Umgebung und unter Ihrer VPC-Kontrolle bereitgestellt, um die Datensicherheit zu gewährleisten. Falcon 180B ist erkennbar und kann in Regionen bereitgestellt werden, in denen die erforderlichen Instanzen verfügbar sind. Derzeit sind ml.p4de-Instanzen in den Regionen USA Ost (Nord-Virginia) und USA West (Oregon) verfügbar.

Entdecken Sie Modelle

Sie können über SageMaker JumpStart in der SageMaker Studio-Benutzeroberfläche und dem SageMaker Python SDK auf die Grundmodelle zugreifen. In diesem Abschnitt erfahren Sie, wie Sie die Modelle in SageMaker Studio entdecken.

SageMaker Studio ist eine integrierte Entwicklungsumgebung (IDE), die eine einzige webbasierte visuelle Schnittstelle bietet, über die Sie auf speziell entwickelte Tools zugreifen können, um alle ML-Entwicklungsschritte durchzuführen, von der Datenvorbereitung bis hin zum Erstellen, Trainieren und Bereitstellen Ihrer ML-Modelle. Weitere Informationen zu den ersten Schritten und zur Einrichtung von SageMaker Studio finden Sie unter Amazon SageMaker-Studio.

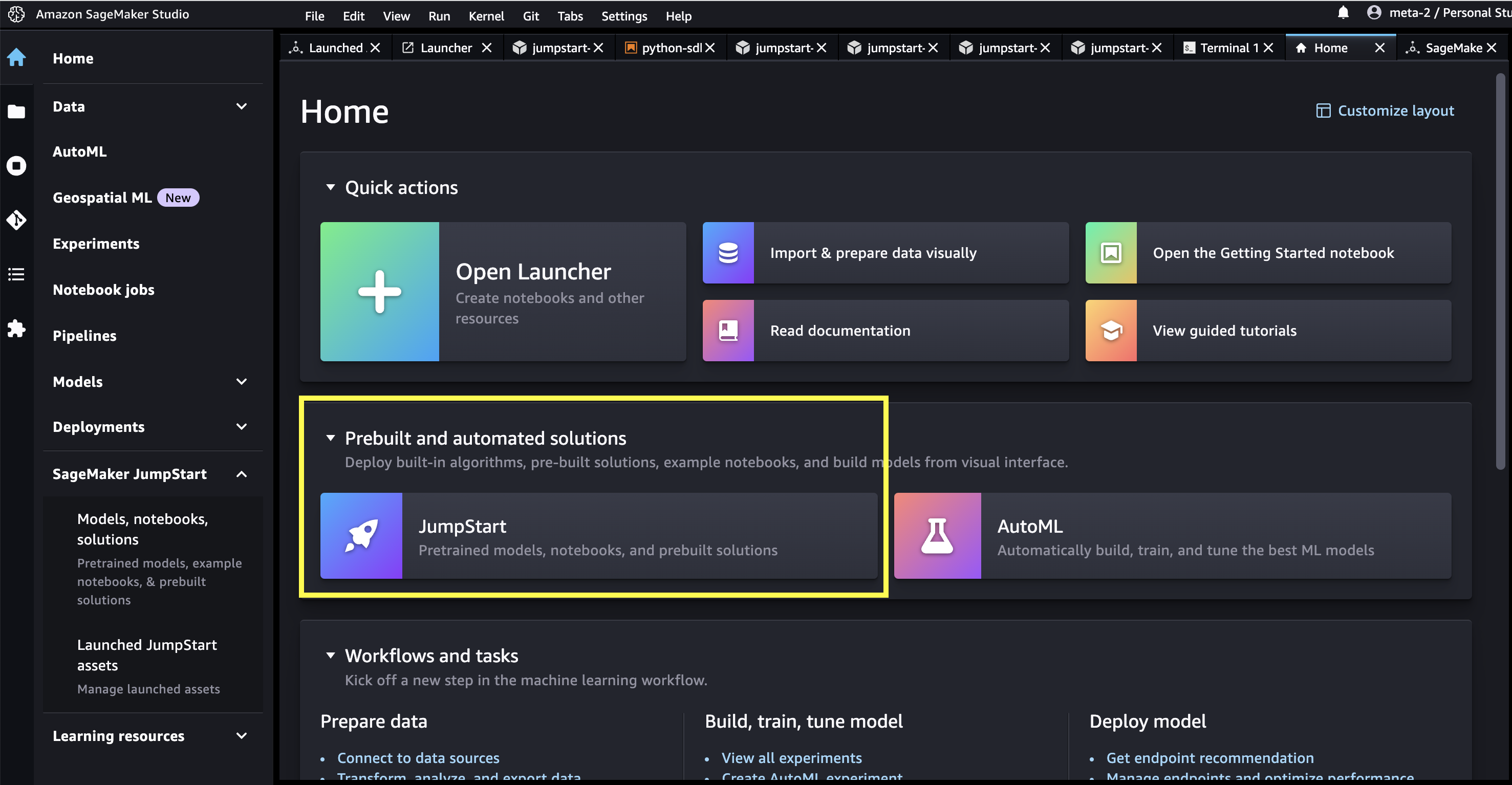

In SageMaker Studio können Sie unter auf SageMaker JumpStart zugreifen, das vorab trainierte Modelle, Notebooks und vorgefertigte Lösungen enthält Vorgefertigte und automatisierte Lösungen.

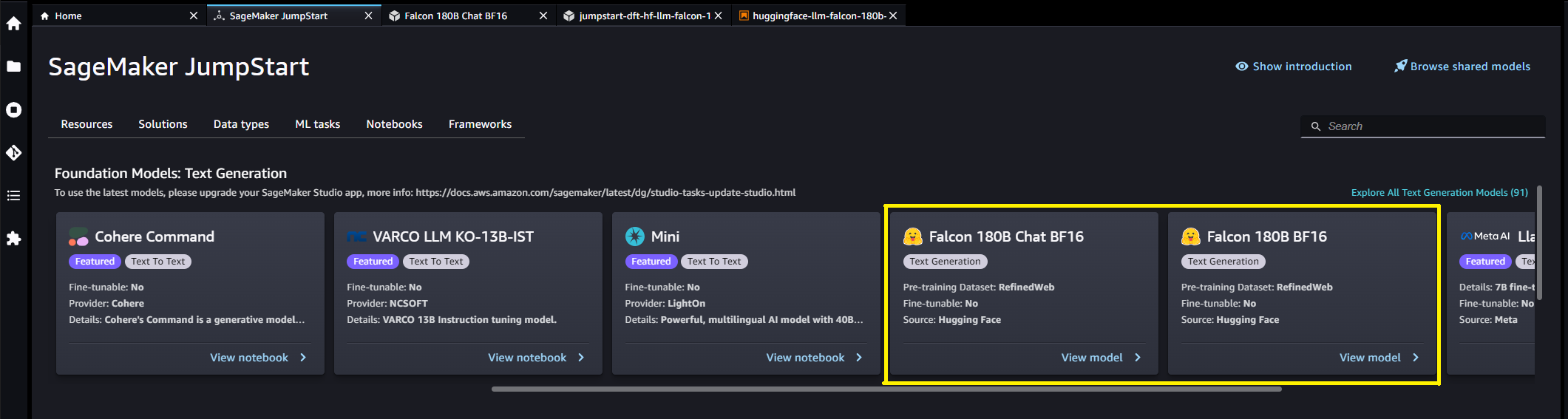

Auf der SageMaker JumpStart-Landingpage können Sie nach Lösungen, Modellen, Notizbüchern und anderen Ressourcen suchen. Sie finden Falcon 180B im Grundlagenmodelle: Textgenerierung Karussell.

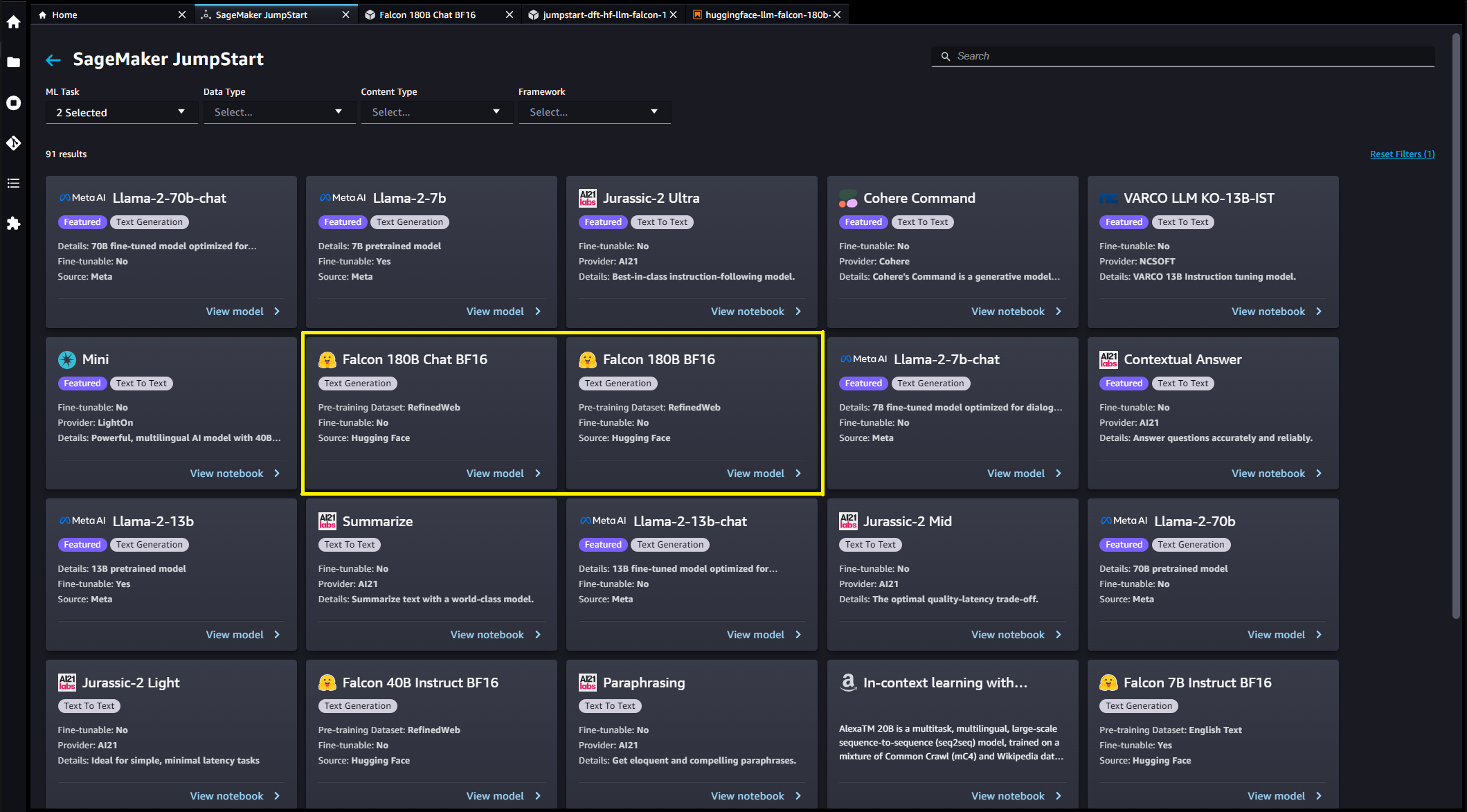

Weitere Modellvarianten finden Sie auch unter der Auswahl Entdecken Sie alle Modelle zur Textgenerierung oder suchen nach Falcon.

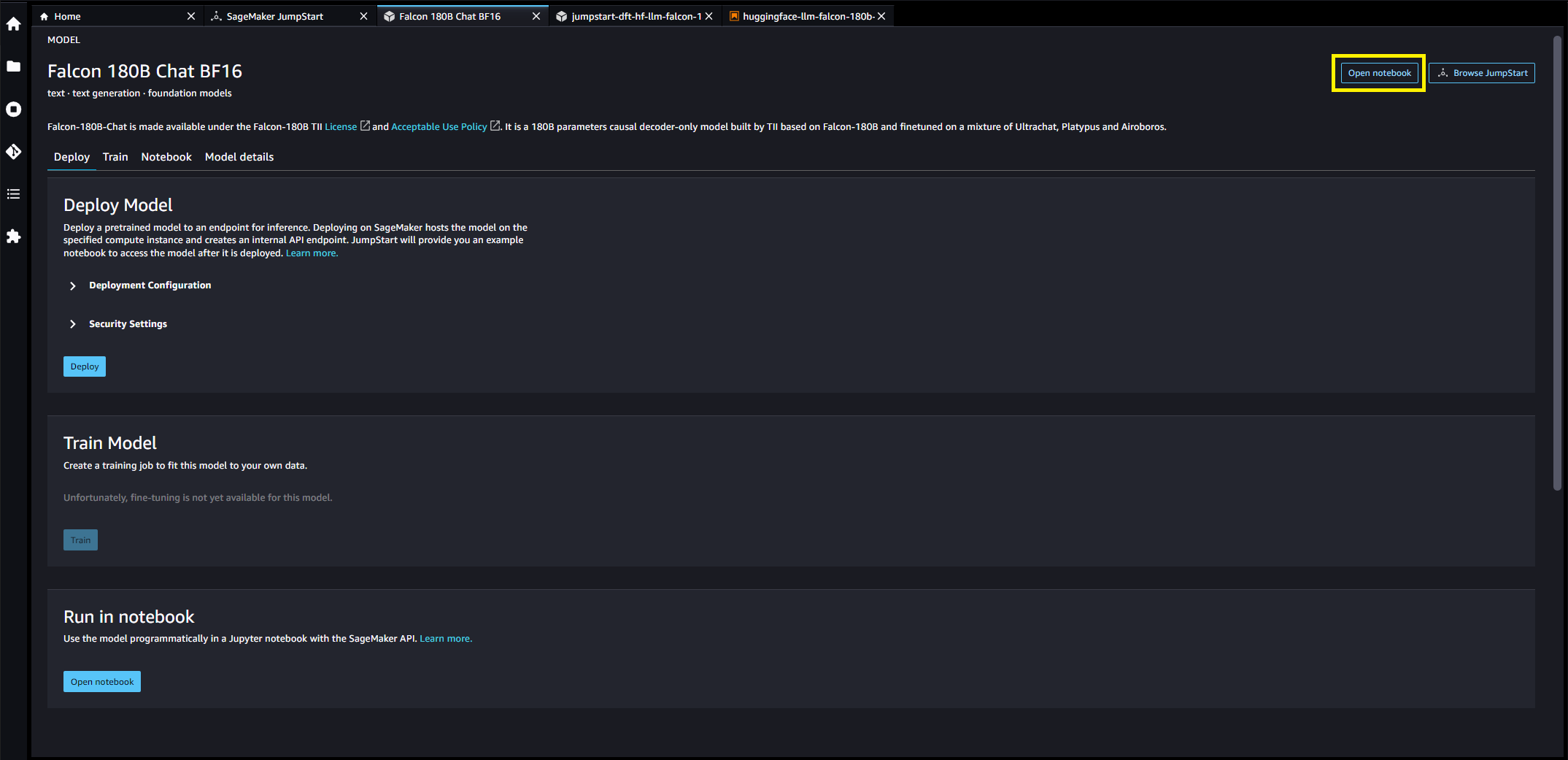

Sie können die Modellkarte auswählen, um Details zum Modell anzuzeigen, z. B. Lizenz, für das Training verwendete Daten und Verwendungsweise. Sie finden auch zwei Schaltflächen, Deploy und Notizbuch öffnen, das Ihnen bei der Verwendung des Modells hilft (der folgende Screenshot zeigt die Deploy Möglichkeit).

Modelle bereitstellen

Wenn Sie wählen Deploy, die Modellbereitstellung beginnt. Alternativ können Sie die Bereitstellung über das Beispielnotizbuch durchführen, das angezeigt wird, indem Sie auf klicken Notizbuch öffnen. Das Beispielnotizbuch bietet umfassende Anleitungen zur Bereitstellung des Modells für Rückschlüsse und zur Bereinigung von Ressourcen.

Um die Bereitstellung mithilfe eines Notebooks durchzuführen, wählen wir zunächst ein geeignetes Modell aus, das durch angegeben wird model_id. Sie können jedes der ausgewählten Modelle mit dem folgenden Code auf SageMaker bereitstellen:

Dadurch wird das Modell auf SageMaker mit Standardkonfigurationen bereitgestellt, einschließlich des Standardinstanztyps und der Standard-VPC-Konfigurationen. Sie können diese Konfigurationen ändern, indem Sie in nicht standardmäßige Werte angeben JumpStartModel. Weitere Informationen finden Sie unter API-Dokumentation. Nach der Bereitstellung können Sie über einen SageMaker-Prädiktor Rückschlüsse auf den bereitgestellten Endpunkt ziehen. Siehe den folgenden Code:

Inferenzparameter steuern den Textgenerierungsprozess am Endpunkt. Die maximale Anzahl neuer Token bezieht sich auf die Größe der vom Modell generierten Ausgabe. Beachten Sie, dass dies nicht mit der Anzahl der Wörter identisch ist, da das Vokabular des Modells nicht mit dem Vokabular der englischen Sprache übereinstimmt und nicht jedes Token ein Wort der englischen Sprache ist. Die Temperatur steuert die Zufälligkeit der Ausgabe. Höhere Temperaturen führen zu kreativeren und halluzinierteren Ergebnissen. Alle Inferenzparameter sind optional.

Dieses 180-B-Parametermodell ist 335 GB groß und erfordert noch mehr GPU-Speicher, um eine ausreichende Inferenz mit 16-Bit-Präzision durchzuführen. Derzeit unterstützt JumpStart dieses Modell nur auf ml.p4de.24xlarge-Instanzen. Es ist möglich, ein quantisiertes 8-Bit-Modell auf einer ml.p4d.24xlarge-Instanz bereitzustellen, indem Sie Folgendes bereitstellen env={"HF_MODEL_QUANTIZE": "bitsandbytes"} Schlüsselwortargument zum JumpStartModel Konstruktor und Spezifizierung instance_type="ml.p4d.24xlarge" zur Bereitstellungsmethode. Bitte beachten Sie jedoch, dass die Latenz pro Token bei dieser quantisierten Konfiguration etwa fünfmal langsamer ist.

Die folgende Tabelle listet alle in SageMaker JumpStart verfügbaren Falcon-Modelle zusammen mit den Modell-IDs, Standardinstanztypen, der maximalen Anzahl unterstützter Gesamttokens (Summe aus der Anzahl der Eingabetokens und der Anzahl der generierten Tokens) und der typischen Antwortlatenz pro Token auf für jedes dieser Modelle.

| Modell | Modell-ID | Standardinstanztyp | Maximale Gesamtanzahl an Token | Latenz pro Token* |

| Falcon 7B | huggingface-llm-falcon-7b-bf16 |

ml.g5.2xgroß | 2048 | 34 ms |

| Falcon 7B Instruktion | huggingface-llm-falcon-7b-instruct-bf16 |

ml.g5.2xgroß | 2048 | 34 ms |

| Falcon 40B | huggingface-llm-falcon-40b-bf16 |

ml.g5.12xgroß | 2048 | 57 ms |

| Falcon 40B Instruktion | huggingface-llm-falcon-40b-instruct-bf16 |

ml.g5.12xgroß | 2048 | 57 ms |

| Falcon 180B | huggingface-llm-falcon-180b-bf16 |

ml.p4de.24xlarge | 2048 | 45 ms |

| Falcon 180B Chat | huggingface-llm-falcon-180b-chat-bf16 |

ml.p4de.24xlarge | 2048 | 45 ms |

*Die Latenz pro Token wird für die mittlere Antwortzeit der in diesem Blog bereitgestellten Beispielaufforderungen angegeben. Dieser Wert variiert je nach Länge der Eingabe- und Ausgabesequenzen.

Schlussfolgerungen und Beispielaufforderungen für Falcon 180B

Falcon-Modelle können zur Textvervollständigung für jeden beliebigen Textabschnitt verwendet werden. Durch die Textgenerierung können Sie eine Vielzahl von Aufgaben ausführen, z. B. die Beantwortung von Fragen, Sprachübersetzungen, Stimmungsanalysen und vieles mehr. Der Endpunkt akzeptiert das folgende Eingabenutzlastschema:

Sie können die Definition dieser erkunden Client-Parameter und ihre Standardwerte im Textgenerierungs-Inferenz-Repository.

Im Folgenden finden Sie einige Beispielaufforderungen und den vom Modell generierten Text. Alle Ausgaben hier werden mit Inferenzparametern generiert {"max_new_tokens": 768, "stop": ["<|endoftext|>", "###"]}.

Der Aufbau einer Website kann in 10 einfachen Schritten erfolgen:

Möglicherweise stellen Sie fest, dass dieses vorab trainierte Modell lange Textsequenzen generiert, die nicht unbedingt ideal für Dialoganwendungsfälle sind. Bevor wir zeigen, wie das fein abgestimmte Chat-Modell für einen größeren Satz dialogbasierter Eingabeaufforderungen funktioniert, veranschaulichen die nächsten beiden Beispiele, wie Falcon-Modelle mit wenigen Schüssen im Kontextlernen verwendet werden, wobei wir dem Modell Trainingsbeispiele zur Verfügung stellen. Beachten Sie, dass „Few-Shot-Learning“ die Modellgewichte nicht anpasst – wir führen während dieses Prozesses nur Rückschlüsse auf das bereitgestellte Modell durch und stellen gleichzeitig einige Beispiele im Eingabekontext bereit, um die Ausgabe des Gildenmodells zu unterstützen.

Schlussfolgerungen und Beispielaufforderungen für Falcon 180B-Chat

Bei Falcon 180B-Chat-Modellen, die für Dialog-Anwendungsfälle optimiert sind, kann die Eingabe in die Endpunkte des Chat-Modells den Vorverlauf zwischen dem Chat-Assistenten und dem Benutzer enthalten. Sie können Fragen stellen, die sich auf das bisher stattgefundene Gespräch beziehen. Sie können auch die Systemkonfiguration bereitstellen, z. B. Personas, die das Verhalten des Chat-Assistenten definieren. Die Eingabenutzlast zum Endpunkt ist mit Ausnahme des Falcon 180B-Modells dieselbe inputs Der Zeichenfolgenwert sollte das folgende Format verwenden:

Im Folgenden finden Sie einige Beispielaufforderungen und den vom Modell generierten Text. Alle Ausgaben werden mit Inferenzparametern generiert {"max_new_tokens":256, "stop": ["nUser:", "<|endoftext|>", " User:", "###"]}.

Im folgenden Beispiel hat der Benutzer mit dem Assistenten ein Gespräch über Sehenswürdigkeiten in Paris geführt. Als nächstes erkundigt sich der Nutzer nach der ersten vom Chat-Assistenten empfohlenen Option.

Aufräumen

Nachdem Sie mit der Ausführung des Notebooks fertig sind, löschen Sie unbedingt alle Ressourcen, die Sie dabei erstellt haben, damit Ihre Abrechnung gestoppt wird. Verwenden Sie den folgenden Code:

Zusammenfassung

In diesem Beitrag haben wir Ihnen gezeigt, wie Sie mit Falcon 180B in SageMaker Studio beginnen und das Modell für die Inferenz bereitstellen. Da die Basismodelle vorab trainiert sind, können sie dazu beitragen, die Schulungs- und Infrastrukturkosten zu senken und eine Anpassung an Ihren Anwendungsfall zu ermöglichen. Besuchen Sie jetzt SageMaker JumpStart in SageMaker Studio, um loszulegen.

Downloads

Über die Autoren

Kyle Ulrich ist angewandter Wissenschaftler im Amazon SageMaker JumpStart-Team. Seine Forschungsinteressen umfassen skalierbare Algorithmen für maschinelles Lernen, Computer Vision, Zeitreihen, Bayes'sche Nichtparametrik und Gaußsche Prozesse. Er promovierte an der Duke University und hat Artikel in NeurIPS, Cell und Neuron veröffentlicht.

Kyle Ulrich ist angewandter Wissenschaftler im Amazon SageMaker JumpStart-Team. Seine Forschungsinteressen umfassen skalierbare Algorithmen für maschinelles Lernen, Computer Vision, Zeitreihen, Bayes'sche Nichtparametrik und Gaußsche Prozesse. Er promovierte an der Duke University und hat Artikel in NeurIPS, Cell und Neuron veröffentlicht.

Dr. Ashish Khetan ist Senior Applied Scientist bei Amazon SageMaker JumpStart und hilft bei der Entwicklung von Algorithmen für maschinelles Lernen. Er promovierte an der University of Illinois Urbana-Champaign. Er ist ein aktiver Forscher im Bereich maschinelles Lernen und statistische Inferenz und hat zahlreiche Artikel auf NeurIPS-, ICML-, ICLR-, JMLR-, ACL- und EMNLP-Konferenzen veröffentlicht.

Dr. Ashish Khetan ist Senior Applied Scientist bei Amazon SageMaker JumpStart und hilft bei der Entwicklung von Algorithmen für maschinelles Lernen. Er promovierte an der University of Illinois Urbana-Champaign. Er ist ein aktiver Forscher im Bereich maschinelles Lernen und statistische Inferenz und hat zahlreiche Artikel auf NeurIPS-, ICML-, ICLR-, JMLR-, ACL- und EMNLP-Konferenzen veröffentlicht.

Olivier Cruchant ist Principal Machine Learning Specialist Solutions Architect bei AWS mit Sitz in Frankreich. Olivier unterstützt AWS-Kunden – von kleinen Start-ups bis hin zu großen Unternehmen – bei der Entwicklung und Bereitstellung produktionstauglicher Anwendungen für maschinelles Lernen. In seiner Freizeit liest er gerne Forschungsarbeiten und erkundet mit Freunden und der Familie die Wildnis.

Olivier Cruchant ist Principal Machine Learning Specialist Solutions Architect bei AWS mit Sitz in Frankreich. Olivier unterstützt AWS-Kunden – von kleinen Start-ups bis hin zu großen Unternehmen – bei der Entwicklung und Bereitstellung produktionstauglicher Anwendungen für maschinelles Lernen. In seiner Freizeit liest er gerne Forschungsarbeiten und erkundet mit Freunden und der Familie die Wildnis.

Karl Albersen leitet den Foundation Model Hub, die Algorithmen und die Partnerschaftsteams von Amazon SageMaker.

Karl Albersen leitet den Foundation Model Hub, die Algorithmen und die Partnerschaftsteams von Amazon SageMaker.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- ChartPrime. Verbessern Sie Ihr Handelsspiel mit ChartPrime. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/falcon-180b-foundation-model-from-tii-is-now-available-via-amazon-sagemaker-jumpstart/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 150

- 20

- 25

- 26%

- 3d

- 4k

- 7

- 8

- 9

- a

- LiveBuzz

- Akzeptiert

- Zugang

- zugänglich

- Erreichen

- aktiv

- hinzufügen

- zusätzlich

- Adresse

- Nach der

- gegen

- Algorithmen

- Alle

- erlaubt

- entlang

- ebenfalls

- immer

- am

- Amazon

- Amazon Sage Maker

- Amazon SageMaker-JumpStart

- Amazon Web Services

- an

- Analyse

- und

- und Infrastruktur

- Bekannt geben

- Ein anderer

- beantworten

- jedem

- jemand

- ansprechend

- Anwendungen

- angewandt

- angemessen

- ca.

- Architektur

- SIND

- Argument

- Kunst

- Artikel

- AS

- fragen

- Assistentin

- At

- Aufmerksamkeit

- anziehen

- Attraktion

- Automatisiert

- verfügbar

- Alleen

- AWS

- basierend

- austauschbare Akkus

- Bayesianisch

- BE

- schön

- weil

- war

- Bevor

- Verhalten

- Besser

- zwischen

- Rechnungs-

- Blog

- rühmt sich

- Browser

- Baumeister

- Bauherren

- Building

- Geschäft

- aber

- by

- Cafés

- CAN

- capability

- Karte

- Karussell

- Häuser

- Fälle

- Übernehmen

- aus der Ferne überprüfen

- Auswählen

- Auswahl

- gewählt

- Stadt

- klassifizieren

- Cluster

- cms

- Code

- Codebasis

- Sammlung

- Spalten

- COM

- kombiniert

- gemeinsam

- Unternehmen

- abschließen

- Abschluss

- Computer

- Computer Vision

- Kongressbegleitung

- Konfiguration

- Bestehend

- Kontakt

- enthalten

- Container

- enthält

- Inhalt

- Kontext

- kontextuelle

- ständig

- beigetragen

- Smartgeräte App

- Steuerung

- Gespräch

- Konversations

- Kosten

- erstellen

- erstellt

- Erstellen

- Kreativ (Creative)

- Tasse

- Strom

- Zur Zeit

- Original

- Kunde

- Kundensupport

- Kunden

- Anpassung

- anpassen

- technische Daten

- Datensicherheit

- Datensätze

- Tag

- Entscheidung

- gewidmet

- Standard

- definieren

- Definition

- zeigen

- Abhängig

- einsetzen

- Einsatz

- Bereitstellen

- Einsatz

- setzt ein

- Design

- Reiseziel

- Details

- Bestimmen

- entwickeln

- entwickelt

- Entwicklung

- Dialog

- Dialog

- anders

- entdeckt,

- verteilt

- verteiltes Training

- do

- die

- Domain

- Domain Name

- DOMAIN NAMEN

- erledigt

- Träume

- Herzog

- Duke University

- im

- jeder

- erleichtern

- leicht

- Osten

- Einfache

- ermöglichen

- ermöglichen

- End-to-End

- Endpunkt

- Energie

- Entwicklung

- Englisch

- gewährleisten

- Unternehmen

- Arbeitsumfeld

- insbesondere

- Sogar

- Beispiel

- Beispiele

- Außer

- aufgeregt

- Expertise

- ERKUNDEN

- Möglichkeiten sondieren

- zum Ausdruck gebracht

- Erweiterung

- Erweiterungen

- umfangreiche

- Familie

- berühmt

- weit

- faszinierend

- Eigenschaften

- wenige

- Finden Sie

- Vorname

- Schwimmer

- Folgende

- folgt

- Aussichten für

- Format

- Früher

- Foundation

- vier

- FRAME

- Frankreich

- Französisch

- Freunde

- für

- funktioniert

- weiter

- Gärten

- Juwel

- erzeugen

- erzeugt

- erzeugt

- Generation

- bekommen

- Glas

- Go

- Kundenziele

- Ziele

- gehen

- gut

- habe

- GPU

- GPUs

- groß

- persönlichem Wachstum

- die Vermittlung von Kompetenzen,

- Gilde

- hätten

- passiert

- hassen

- Haben

- mit

- he

- Herz

- Hilfe

- hilfreich

- Unternehmen

- hilft

- hier

- versteckt

- verstecktes Juwel

- Hohe Leistungsfähigkeit

- höher

- seine

- Geschichte

- Startseite

- Gastgeber

- Hosting

- Ultraschall

- Hilfe

- aber

- HTML

- HTTPS

- Nabe

- i

- ikonischen

- ID

- ideal

- ids

- if

- Illinois

- Image

- Bilder

- importieren

- beeindruckend

- in

- das

- Einschließlich

- unglaublich

- Information

- Infrastruktur

- Innovation

- Varianten des Eingangssignals:

- Eingänge

- Instanz

- Institut

- Anleitung

- integriert

- interessiert

- Interessen

- Schnittstelle

- in

- isoliert

- IT

- SEINE

- jpg

- bekannt

- kyle

- Landung

- Sprache

- grosse

- Große Unternehmen

- großflächig

- größer

- höchste

- Latency

- neueste

- starten

- Gesetze

- Layout

- umwandeln

- LERNEN

- lernen

- Länge

- Lizenz

- !

- gefüttert

- LINK

- Links

- Liste

- Listen

- Laden

- Lang

- senken

- Luxemburg

- Maschine

- Maschinelles Lernen

- gemacht

- um

- Making

- Management

- Managed

- viele

- Wunder

- Masse

- massiv

- max

- maximal

- Kann..

- Bedeutung

- Mittel

- Medien

- mittelalterlich

- Memory

- Nachricht

- Methode

- könnte

- Vermischung

- Mischung

- ML

- MLOps

- Modell

- für

- mehr

- vor allem warme

- Bewegung

- Museum

- Musik

- my

- Name

- Namens

- Namen

- Navigieren

- Menü

- Notwendig

- Need

- Negativ

- Netto-

- Netzwerk

- Neutral

- Neu

- weiter

- Nacht-

- nicht

- Notizbuch

- Notiz..

- jetzt an

- Anzahl

- Beobachter

- of

- Angebote

- ÖL

- Olive

- on

- einmal

- EINEM

- einzige

- offen

- Betriebs-

- optimiert

- Option

- Optionen

- or

- Oregon

- Andere

- skizzierte

- Möglichkeiten für das Ausgangssignal:

- übrig

- Seite

- Seiten

- Palast

- Papiere

- Parameter

- Parameter

- Paris

- Park

- besonders

- Partnerschaften

- Zahlung

- Zahlungsmethode

- Personen

- für

- perfekt

- Ausführen

- Leistung

- führt

- phd

- Telefon

- Physik

- Stück

- Plan

- Plato

- Datenintelligenz von Plato

- PlatoData

- Bitte

- positiv

- möglich

- Post

- BLOG-POSTS

- Präzision

- Predictor

- Vorbereitung

- Gegenwart

- früher

- in erster Linie

- Principal

- Probleme

- Prozessdefinierung

- anpassen

- Produkt

- fördern

- richtig

- die

- vorausgesetzt

- Versorger

- bietet

- Bereitstellung

- veröffentlicht

- Zweck

- setzen

- Python

- Fragen

- schnell

- Zufälligkeit

- Roh

- Lesebrillen

- Rezept

- empfohlen

- siehe

- bezieht sich

- Ungeachtet

- Regionen

- Registrieren

- Registrieren

- registrieren

- Registrierung:

- relativ

- Relativität

- freigegeben

- Mitteilungen

- relevant

- Zuverlässigkeit

- zuverlässig

- merken

- Quelle

- representiert

- erfordert

- Requisit

- Forschungsprojekte

- Forscher

- Downloads

- Antwort

- Die Ergebnisse

- Reiches

- Biken

- Königtum

- Führen Sie

- Laufen

- s

- sagemaker

- Salz

- gleich

- Skalierbarkeit

- skalierbaren

- Skalieren

- Wissenschaftler

- Sdk

- WASSER

- Suche

- Suche

- Jahreszeit

- Zweite

- Abschnitt

- Verbindung

- Sicherheitdienst

- sehen

- Samen

- ausgewählt

- Auswahl

- Senior

- Gefühl

- Modellreihe

- Lösungen

- kompensieren

- Einstellungen

- mehrere

- Teilen

- Geschäfte

- Short

- sollte

- erklären

- zeigte

- Konzerte

- Schild

- Einfacher

- Einfachheit

- einfach

- Single

- Seiten

- Größe

- Langsam

- klein

- So

- bis jetzt

- Social Media

- Social Media

- Social Media Beiträge

- Lösungen

- einige

- etwas

- Quelle

- Raumfahrt

- Spezialist

- angegeben

- Geschwindigkeit

- Anfang

- begonnen

- Startups

- Staaten

- Station

- statistisch

- Shritte

- Stoppen

- gestoppt

- Lagerung

- speichern

- Straße

- Schnur

- Studio Adressen

- Atemberaubende

- so

- Support

- Unterstützte

- Unterstützt

- sicher

- Symbol

- System

- Tabelle

- Nehmen

- Einnahme

- und Aufgaben

- Geschmack

- Team

- Teams

- Technologie

- Technologie Innovation

- Vorlage

- Test

- Text

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- die Welt

- ihr

- Sie

- Thema

- dann

- Theorie

- Dort.

- Diese

- vom Nutzer definierten

- Dritte

- fehlen uns die Worte.

- Durch

- Zeit

- Zeitfolgen

- zu

- gemeinsam

- Zeichen

- Tokens

- Werkzeug

- Werkzeuge

- Gesamt

- Tower

- Training

- trainiert

- Ausbildung

- Transformator

- Übersetzen

- Übersetzungen

- Billion

- Ausflug

- Triton

- versuchen

- Tweet

- XNUMX

- tippe

- Typen

- typisch

- ui

- für

- einheitlich

- einzigartiges

- Universität

- bis

- Uploading

- us

- -

- Anwendungsfall

- benutzt

- Mitglied

- Nutzer

- verwendet

- Verwendung von

- Vakuum

- Wert

- Werte

- Vielfalt

- verschiedene

- Version

- Versionen

- Vibe

- Video

- Videos

- Anzeigen

- Ansichten

- Virginia

- Seh-

- Besuchen Sie

- Besucher

- visuell

- Spaziergang

- wollen

- wurde

- Wasserzeichen

- we

- Netz

- Web-Services

- Webbasiert

- Webseite

- Woche

- Wochen

- GUT

- West

- Was

- Was ist

- wann

- welche

- während

- werden wir

- Fenster

- mit

- .

- ohne

- Word

- Worte

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- Schreiben

- ja

- Du

- Ihr

- Zephyrnet

- Null