Vizepräsident von IBM Quantum Jay Gambetta spricht mit Philip Ball über die vielen Quantenfortschritte des Unternehmens in den letzten 20 Jahren sowie seinen kürzlich angekündigten Fünf-Jahres-Plan zum „Quantenvorteil“

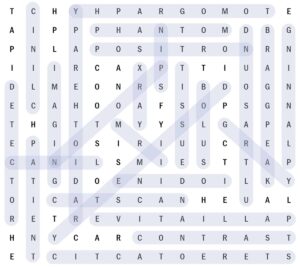

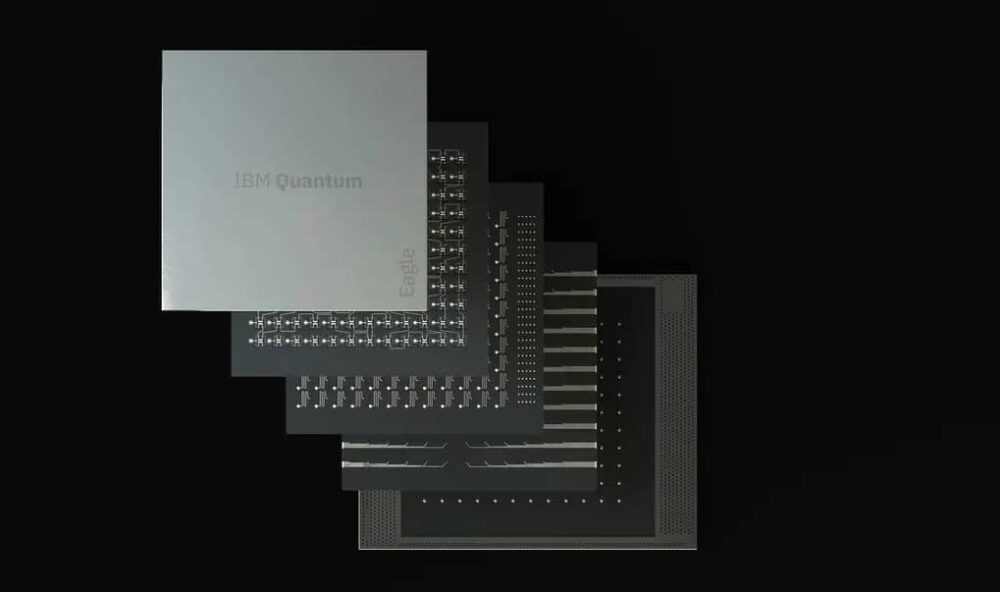

Unternehmen und Forschungslabore auf der ganzen Welt arbeiten daran, ihre aufkommenden Quantentechnologien aus dem Labor in die reale Welt zu bringen, wobei der US-amerikanische Technologieriese IBM ein wichtiger Akteur ist. Im Mai dieses Jahres IBM Quantum hat seine neueste Roadmap vorgestellt für die Zukunft des Quantencomputings im kommenden Jahrzehnt, und das Unternehmen hat sich einige ehrgeizige Ziele gesetzt. Nachdem ich es angekündigt habe Eagle-Prozessor mit 127 Quantenbits (Qubits) letztes Jahr, das Unternehmen ist entwickelt derzeit den 433-Qubit-Osprey-Prozessor für ein Debüt später in diesem Jahr, dem 2023 der 1121-Qubit-Condor folgen soll.

Aber darüber hinaus, so das Unternehmen, werde man sich darauf konzentrieren, solche Prozessoren zu modularen Schaltkreisen zusammenzubauen, in denen die Chips über spärlichere Quanten- oder klassische Verbindungen miteinander verbunden seien. Diese Bemühungen werden im Jahr 4158 in ihrem sogenannten 2025-Qubit-Kookaburra-Gerät gipfeln. Darüber hinaus prognostiziert IBM eine modulare Entwicklung Prozessoren mit 100,000 oder mehr Qubits, die in der Lage sind, ohne die Fehler zu rechnen, die derzeit beim Quantencomputing eine Frage der Suche nach Problemumgehungen für das Rauschen der Qubits sind. Das Quantencomputing-Team des Unternehmens ist zuversichtlich, mit diesem Ansatz einen allgemeinen „Quantenvorteil“ erzielen zu können, bei dem Quantencomputer klassische Computer durchweg übertreffen und komplexe Berechnungen durchführen, die über die Möglichkeiten klassischer Geräte hinausgehen.

Während er in London auf dem Weg war 28th Solvay-Konferenz in Brüssel, das sich mit Quanteninformation befasste, Physik-Welt Habe den Physiker getroffen Jay Gambetta, Vizepräsident von IBM Quantum. Gambetta, der in den letzten zwei Jahrzehnten viele Fortschritte des Unternehmens vorangetrieben hat, erläuterte, wie diese Ziele erreicht werden könnten und welche Auswirkungen sie auf die Zukunft des Quantencomputings haben werden.

Wie ist der aktuelle Stand der Technik bei IBM Quantum? Auf welche Schlüsselparameter konzentrieren Sie sich?

Bei der IBM-Roadmap geht es um die Skalierung – nicht nur um die Anzahl der Qubits, sondern auch um deren Geschwindigkeit, Qualität und Schaltungsarchitektur. Wir haben jetzt Kohärenzzeiten [die Dauer, für die die Qubits kohärent bleiben und eine Quantenberechnung durchführen können] von 300 Mikrosekunden im Eagle-Prozessor [im Vergleich zu etwa 1 μs im Jahr 2010], und die nächste Generation von Geräten wird 300 Millisekunden erreichen. Und unsere Qubits [aus supraleitenden Metallen] haben jetzt eine Wiedergabetreue von fast 99.9 % [sie weisen nur einen Fehler alle 1000 Vorgänge auf – eine Fehlerrate von 10].-3]. Ich denke, dass 99.99 % bis Ende nächsten Jahres nicht unmöglich sein werden.

Der ultimative Lackmustest für die Reife von Quantencomputern ist also, ob die Quantenlaufzeit mit der klassischen Laufzeit konkurrieren kann

Aber intelligentes Handeln wird wichtiger werden, als nur die reinen Kennzahlen voranzutreiben. Die Prozessorarchitektur wird immer wichtiger. Ich glaube nicht, dass wir weit über 1000 Qubits pro Chip hinauskommen werden [wie beim Condor], also schauen wir uns jetzt die Modularität an. Auf diese Weise können wir bis zum Ende dieses Jahrzehnts Prozessoren mit 10,000 Qubits erreichen. Wir werden sowohl die klassische Kommunikation (zur Steuerung der Elektronik) zwischen Chips als auch Quantenkanäle nutzen, die eine gewisse Verschränkung erzeugen (zur Durchführung von Berechnungen). Diese Kanäle zwischen den Chips werden langsam sein – vielleicht 100-mal langsamer als die Schaltkreise selbst. Und es wird schwierig sein, die Wiedergabetreue der Kanäle auf über 95 % zu bringen.

Was beim Hochleistungsrechnen wirklich zählt, ist die Minimierung der Laufzeit – also die Minimierung der Zeit, die benötigt wird, um eine Lösung für ein interessierendes Problem zu generieren. Der ultimative Lackmustest für die Reife von Quantencomputern besteht darin, ob die Quantenlaufzeit mit der klassischen Laufzeit konkurrenzfähig sein kann. Wir haben damit begonnen, theoretisch zu zeigen, dass, wenn Sie eine große Strecke betreiben möchten und diese in kleinere Strecken aufteilen, Sie sich jedes Mal, wenn Sie einen Schnitt vornehmen, vorstellen können, dass dadurch klassische Kosten entstehen, die die Laufzeit erhöhen exponentiell. Das Ziel besteht also darin, diesen exponentiellen Anstieg so nahe wie möglich bei 1 zu halten.

Für eine gegebene Schaltung hängt die Laufzeit exponentiell von a ab Parameter nennen wir γ̄ zur Macht erhoben nd, Wobei n ist die Anzahl der Qubits und d ist die Tiefe [ein Maß für den längsten Weg zwischen Eingang und Ausgang der Schaltung oder gleichwertig die Anzahl der Zeitschritte, die für den Betrieb der Schaltung erforderlich sind]. Wenn wir also b γ̄ so nah wie möglich an 1 bringen können, erreichen wir einen Punkt, an dem es einen echten Quantenvorteil gibt: kein exponentielles Wachstum zur Laufzeit. Wir können γ̄ durch Verbesserungen der Kohärenz und Gate-Treue [intrinsische Fehlerrate] reduzieren. Irgendwann werden wir einen Wendepunkt erreichen, an dem wir trotz des exponentiellen Aufwands zur Fehlerminderung Laufzeitvorteile gegenüber klassischen Computern erzielen können. Wenn Sie γ̄ auf 1.001 reduzieren können, ist die Laufzeit schneller, als wenn Sie diese Schaltkreise klassisch simulieren würden. Ich bin zuversichtlich, dass wir das schaffen können – mit Verbesserungen in der Gate-Treue und unterdrücktem Übersprechen zwischen Qubits haben wir bereits ein γ̄ von 1.008 auf dem Falcon r10 [27-Qubit]-Chip gemessen.

Wie können Sie diese Verbesserungen zur Fehlerminderung vornehmen?

Um die Wiedergabetreue zu verbessern, haben wir einen Ansatz namens probabilistische Fehlerunterdrückung gewählt [arXiv:2201.09866]. Die Idee ist, dass Sie mir Arbeitslasten schicken und ich Ihnen verarbeitete Ergebnisse mit rauschfreien Schätzungen davon schicke. Sie sagen, ich möchte, dass Sie diesen Rundgang leiten; Ich charakterisiere das gesamte Rauschen, das ich in meinem System habe, mache viele Durchläufe und verarbeite dann alle Ergebnisse zusammen, um Ihnen eine rauschfreie Schätzung des Schaltungsausgangs zu geben. Auf diese Weise beginnen wir zu zeigen, dass es wahrscheinlich ein Kontinuum von der heutigen Fehlerunterdrückung und Fehlerminderung bis hin zur vollständigen Fehlerkorrektur geben wird.

Sie können also dorthin gelangen, ohne vollständig fehlerkorrigierende logische Qubits zu bauen?

Was ist eigentlich ein logisches Qubit? Was meinen die Leute eigentlich damit? Was wirklich zählt, ist: Können Sie logische Schaltkreise ausführen und wie führen Sie sie so aus, dass die Laufzeit immer schneller wird? Anstatt über den Aufbau logischer Qubits nachzudenken, denken wir darüber nach, wie wir Schaltkreise betreiben und den Benutzern Schätzungen der Antwort geben und diese dann anhand der Laufzeit quantifizieren.

Wenn Sie eine normale Fehlerkorrektur durchführen, korrigieren Sie die Antwort, von der Sie bis zu diesem Zeitpunkt dachten, dass sie lautete. Sie aktualisieren einen Referenzrahmen. Aber wir werden eine Fehlerkorrektur durch Fehlerminderung erreichen. Wenn γ̄ gleich 1 ist, habe ich effektiv eine Fehlerkorrektur, da es keinen Mehraufwand gibt, die Schätzungen so weit zu verbessern, wie Sie möchten.

Auf diese Weise erhalten wir praktisch logische Qubits, die jedoch kontinuierlich eingefügt werden. Wir fangen also an, auf einer höheren Ebene darüber nachzudenken. Unser Ziel ist es, aus Benutzersicht ein Kontinuum zu schaffen, das immer schneller wird. Der ultimative Lackmustest für die Reife von Quantencomputern ist also, ob die Quantenlaufzeit mit der klassischen Laufzeit konkurrieren kann.

Das unterscheidet sich stark von dem, was andere Quantenfirmen tun, aber ich wäre sehr überrascht, wenn dies nicht zur allgemeinen Ansicht wird – ich wette, Sie werden Leute sehen, die Laufzeiten und nicht Fehlerkorrekturraten vergleichen.

Was wir tun, ist einfach Computer im Allgemeinen, und wir geben ihm durch einen Quantenprozessor einen Schub

Wenn Sie modulare Geräte mit klassischen Verbindungen herstellen, bedeutet das, dass die Zukunft nicht wirklich Quanten versus Klassik, sondern Quanten ist? und klassisch?

Ja. Wenn Sie Klassik und Quantentheorie zusammenbringen, können Sie mehr erreichen. Das nenne ich Quantenüberschuss: klassisches Rechnen auf intelligente Weise mit Quantenressourcen betreiben.

Wenn ich einen Zauberstab schwenken könnte, würde ich es nicht Quantencomputing nennen. Ich würde zurückgehen und sagen, dass wir eigentlich nur Computer im Allgemeinen machen und dem durch einen Quantenprozessor einen Schub verleihen. Ich habe das Schlagwort „Quantenzentriertes Supercomputing“ verwendet. Es geht wirklich darum, die Datenverarbeitung zu verbessern, indem Quanten hinzugefügt werden. Ich denke wirklich, dass dies die Architektur sein wird.

Welche technischen Hürden gibt es? Ist es wichtig, dass diese Geräte beispielsweise kryogene Kühlung benötigen?

Das ist eigentlich keine große Sache. Eine größere Sache ist, dass ich mir Sorgen um den Preis der Elektronik und alles, was damit zusammenhängt, mache, wenn wir an unserer Roadmap festhalten. Um diese Kosten zu senken, müssen wir ein Ökosystem entwickeln; und wir als Gemeinschaft tun immer noch nicht genug, um dieses Umfeld zu schaffen. Ich sehe nicht, dass sich viele Leute nur auf die Elektronik konzentrieren, aber ich denke, dass es passieren wird.

Ist die ganze Wissenschaft nun fertig, so dass es sich nun mehr um eine Frage der Technik handelt?

Es wird immer wissenschaftliche Arbeit geben, insbesondere wenn Sie den Weg von der Fehlerminderung zur Fehlerkorrektur einschlagen. Welche Art von Konnektivität möchten Sie in den Chip einbauen? Welche Zusammenhänge gibt es? Dies alles sind grundlegende wissenschaftliche Erkenntnisse. Ich denke, wir können die Fehlerquote immer noch auf 10 steigern-5. Ich persönlich mag es nicht, Dinge als „Wissenschaft“ oder „Technologie“ zu bezeichnen; Wir bauen eine Innovation. Ich denke, es gibt definitiv einen Übergang dahingehend, dass diese Geräte zu Werkzeugen werden, und es stellt sich die Frage, wie wir diese Dinge für die Wissenschaft nutzen, und nicht um die Wissenschaft der Herstellung des Werkzeugs.

Befürchten Sie, dass es eine Quantenblase geben könnte?

Nein. Ich denke, der Quantenvorteil kann in zwei Dinge unterteilt werden. Erstens: Wie lassen sich Schaltkreise auf Quantenhardware tatsächlich schneller betreiben? Ich bin zuversichtlich, dass ich diesbezüglich Vorhersagen treffen kann. Und zweitens: Wie nutzen Sie diese Schaltkreise tatsächlich und beziehen sie auf Anwendungen? Warum funktioniert eine quantenbasierte Methode besser als nur eine klassische Methode allein? Das sind sehr schwierige wissenschaftliche Fragen. Und es sind Fragen, die Hochenergiephysiker, Materialwissenschaftler und Quantenchemiker interessieren. Ich denke, dass es definitiv eine Nachfrage geben wird – wir sehen sie bereits. Wir sehen, dass auch einige Unternehmen Interesse zeigen, aber es wird eine Weile dauern, bis echte Lösungen gefunden werden und Quanten nicht nur ein Werkzeug für die Wissenschaft sind.

Ich sehe darin einen reibungslosen Übergang. Ein großes potenzielles Anwendungsgebiet sind Probleme, bei denen es um Daten mit einer bestimmten Struktur geht, insbesondere um Daten, für die es auf klassischem Weg sehr schwierig ist, Korrelationen zu finden. Sowohl die Finanzwelt als auch die Medizin sind mit solchen Problemen konfrontiert, und Quantenmethoden wie Quantenmaschinelles Lernen sind sehr gut darin, Korrelationen zu finden. Es wird ein langer Weg sein, aber die Investition lohnt sich für sie.

Wie wäre es damit, die Berechnung beispielsweise vor Angriffen wie Shors Faktorisierungsalgorithmus zu schützen, der Quantenmethoden nutzt, um aktuelle kryptografische Methoden mit öffentlichen Schlüsseln auf der Grundlage der Faktorisierung zu knacken?

Jeder möchte vor Shors Algorithmus sicher sein – er wird jetzt als „quantensicher“ bezeichnet. Wir haben viel Grundlagenforschung zu den Algorithmen betrieben, aber wie man sie einbaut, wird eine wichtige Frage sein. Wir überlegen, dies von Anfang an in unsere Produkte zu integrieren und nicht als Add-on. Und wir müssen uns fragen, wie wir sicherstellen können, dass wir über die klassische Infrastruktur verfügen, die für Quantensicherheit sicher ist. Wie sich diese Zukunft entwickelt, wird in den nächsten Jahren sehr wichtig sein – wie man von Grund auf quantensichere Hardware baut.

Meine Definition von Erfolg ist, wenn die meisten Benutzer nicht einmal wissen, dass sie einen Quantencomputer verwenden

Waren Sie überrascht, wie schnell sich Quantencomputing durchgesetzt hat?

Für jemanden, der seit dem Jahr 2000 so tief darin steckt wie ich, ist es dem vorhergesagten Weg bemerkenswert nahe gekommen. Ich erinnere mich, dass ich auf eine interne IBM-Roadmap aus dem Jahr 2011 zurückgegriffen habe, und sie war ziemlich genau richtig. Ich dachte, ich hätte mir damals etwas ausgedacht! Generell habe ich das Gefühl, dass die Leute überschätzen, wie lange es dauern wird. Da wir immer fortschrittlicher werden und Menschen Quanteninformationsideen in diese Geräte einbringen, werden wir in den nächsten Jahren in der Lage sein, größere Schaltkreise zu betreiben. Dann geht es darum, welche Arten von Architektur Sie aufbauen müssen, wie groß die Cluster sind, welche Arten von Kommunikationskanälen Sie nutzen und so weiter. Diese Fragen hängen von der Art der Rennstrecken ab, die Sie betreiben: Wie beginnen wir mit dem Bau von Maschinen für bestimmte Arten von Rennstrecken? Es wird eine Spezialisierung auf Schaltkreise geben.

Wie wird das Quantencomputing im Jahr 2030 aussehen?

Meine Definition von Erfolg ist, dass die meisten Benutzer nicht einmal merken, dass sie einen Quantencomputer verwenden, weil er in eine Architektur integriert ist, die nahtlos mit klassischem Computing zusammenarbeitet. Der Maßstab für den Erfolg wäre dann, dass es für die meisten Menschen, die es nutzen, unsichtbar ist, ihr Leben aber in irgendeiner Weise bereichert. Möglicherweise verwendet Ihr Mobiltelefon eine App, die die Schätzung mithilfe eines Quantencomputers durchführt. Im Jahr 2030 werden wir dieses Niveau nicht erreichen, aber ich denke, dass wir bis dahin sehr große Maschinen haben werden, die weit über das hinausgehen, was wir auf klassische Weise leisten können.