Unternehmen möchten das Potenzial des maschinellen Lernens (ML) nutzen, um komplexe Probleme zu lösen und Ergebnisse zu verbessern. Bis vor Kurzem waren für die Erstellung und Bereitstellung von ML-Modellen umfassende technische Kenntnisse und Programmierkenntnisse erforderlich, einschließlich der Optimierung von ML-Modellen und der Aufrechterhaltung operativer Pipelines. Seit seiner Einführung im Jahr 2021 Amazon SageMaker-Leinwand hat es Geschäftsanalysten ermöglicht, eine Vielzahl von ML-Modellen – einschließlich tabellarischer, Computer-Vision- und natürlicher Sprachverarbeitung – zu erstellen, bereitzustellen und zu verwenden, ohne eine Codezeile schreiben zu müssen. Dies hat die Fähigkeit von Unternehmen beschleunigt, ML auf Anwendungsfälle wie Zeitreihenprognosen, Vorhersage der Kundenabwanderung, Stimmungsanalyse, Erkennung von Industriefehlern und viele andere anzuwenden.

Wie angekündigt am 5. Oktober 2023, SageMaker Canvas erweiterte seine Modellunterstützung auf Foundation Models (FMs) – große Sprachmodelle, die zum Generieren und Zusammenfassen von Inhalten verwendet werden. Mit dem Veröffentlichung am 12. Oktober 2023Mit SageMaker Canvas können Benutzer Fragen stellen und Antworten erhalten, die auf ihren Unternehmensdaten basieren. Dies stellt sicher, dass die Ergebnisse kontextspezifisch sind, und eröffnet zusätzliche Anwendungsfälle, in denen ML ohne Code zur Lösung von Geschäftsproblemen eingesetzt werden kann. Beispielsweise können Geschäftsteams jetzt Antworten formulieren, die dem spezifischen Vokabular und den Grundsätzen einer Organisation entsprechen, und umfangreichere Dokumente schneller abfragen, um Antworten zu erhalten, die spezifisch und auf den Inhalt dieser Dokumente abgestimmt sind. Alle diese Inhalte werden auf private und sichere Weise bereitgestellt, um sicherzustellen, dass auf alle sensiblen Daten mit angemessener Governance und Sicherheitsmaßnahmen zugegriffen wird.

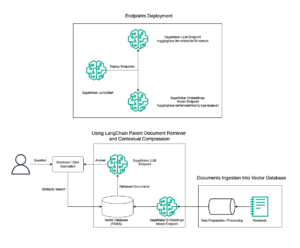

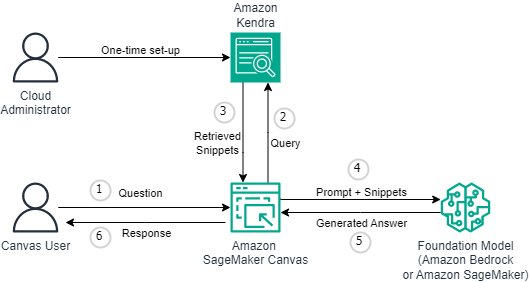

Zu Beginn konfiguriert und füllt ein Cloud-Administrator die Cloud Amazon Kendra Indizes mit Unternehmensdaten als Datenquellen für SageMaker Canvas. Canvas-Benutzer wählen den Index aus, in dem sich ihre Dokumente befinden, und können Ideen entwickeln, recherchieren und erforschen, in der Gewissheit, dass die Ausgabe immer durch ihre Quellen der Wahrheit gestützt wird. SageMaker Canvas verwendet modernste FMs von Amazonas Grundgestein und Amazon SageMaker-JumpStart. Gespräche können mit mehreren FMs nebeneinander begonnen werden, wodurch die Ergebnisse verglichen werden und generative KI wirklich für jedermann zugänglich wird.

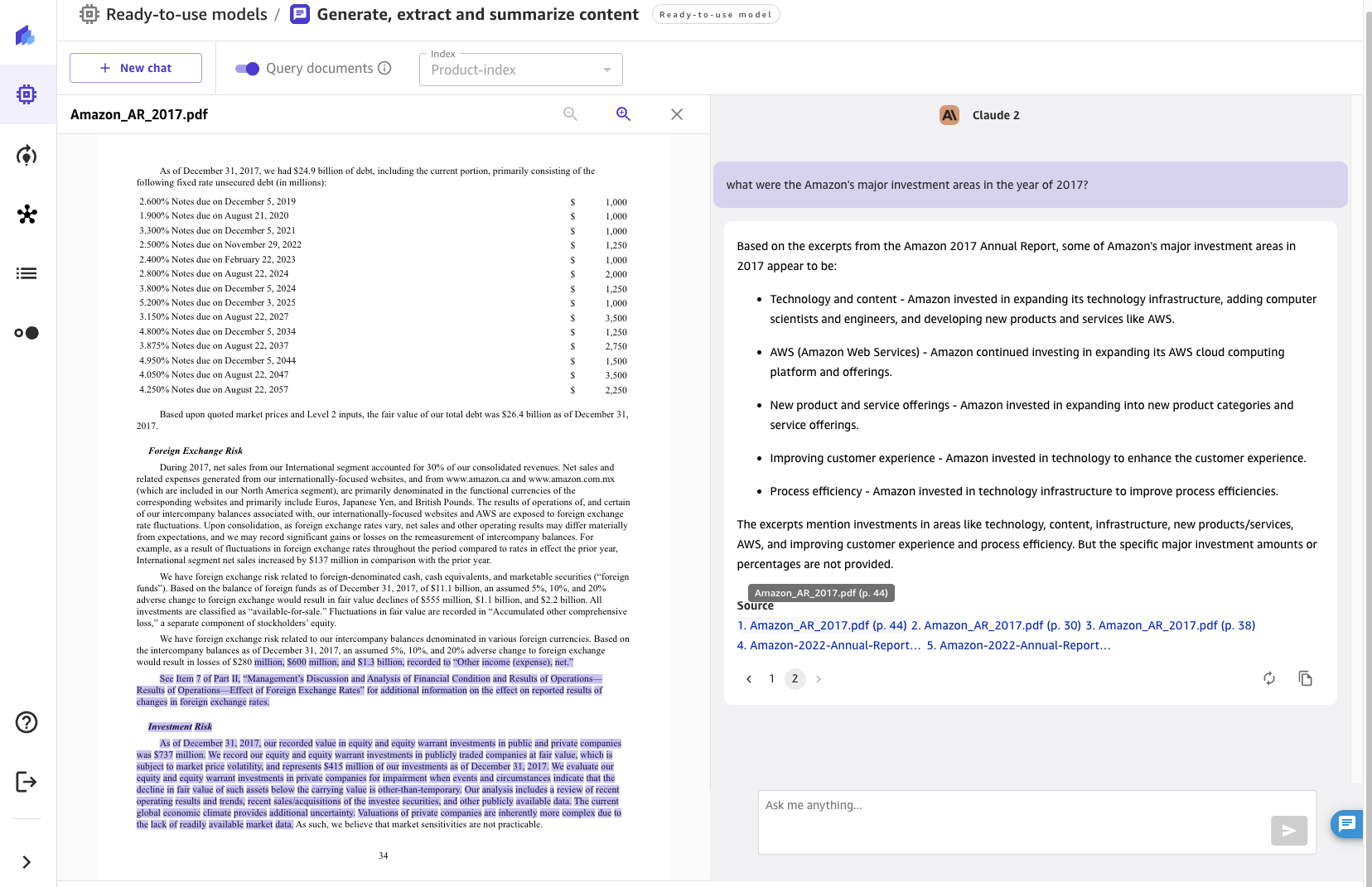

In diesem Beitrag werden wir die kürzlich veröffentlichte Funktion überprüfen, die Architektur diskutieren und eine Schritt-für-Schritt-Anleitung präsentieren, um SageMaker Canvas in die Lage zu versetzen, Dokumente aus Ihrer Wissensdatenbank abzufragen, wie im folgenden Screenshot gezeigt.

Lösungsüberblick

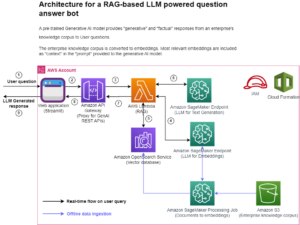

Foundation-Modelle können Halluzinationen hervorrufen – Reaktionen, die allgemein, vage, nicht zusammenhängend oder sachlich falsch sind. Retrieval Augmented Generation (RAG) ist ein häufig eingesetzter Ansatz zur Reduzierung von Halluzinationen. RAG-Architekturen werden verwendet, um Daten von außerhalb eines FM abzurufen, die dann zum Durchführen von kontextbezogenem Lernen zur Beantwortung der Benutzeranfrage verwendet werden. Dadurch wird sichergestellt, dass der FM Daten aus einer vertrauenswürdigen Wissensdatenbank verwenden und dieses Wissen nutzen kann, um die Fragen der Benutzer zu beantworten, wodurch das Risiko einer Halluzination verringert wird.

Mit RAG können die Daten außerhalb des FM, die zur Erweiterung von Benutzereingaben verwendet werden, aus mehreren unterschiedlichen Datenquellen stammen, wie z. B. Dokumentrepositorys, Datenbanken oder APIs. Der erste Schritt besteht darin, Ihre Dokumente und alle Benutzeranfragen in ein kompatibles Format zu konvertieren, um eine semantische Relevanzsuche durchzuführen. Um die Formate kompatibel zu machen, werden eine Dokumentensammlung oder Wissensbibliothek und vom Benutzer übermittelte Abfragen mithilfe von Einbettungsmodellen in numerische Darstellungen umgewandelt.

Mit dieser Version wird die RAG-Funktionalität ohne Code und nahtlos bereitgestellt. Unternehmen können das Chat-Erlebnis in Canvas mit Amazon Kendra als zugrundeliegendem Wissensmanagementsystem bereichern. Das folgende Diagramm veranschaulicht die Lösungsarchitektur.

Die Verbindung von SageMaker Canvas mit Amazon Kendra erfordert eine einmalige Einrichtung. Wir beschreiben den Einrichtungsprozess im Detail unter Einrichten von Canvas zum Abfragen von Dokumenten. Wenn Sie Ihre SageMaker-Domäne noch nicht eingerichtet haben, lesen Sie hier Integrieren in die Amazon SageMaker-Domäne.

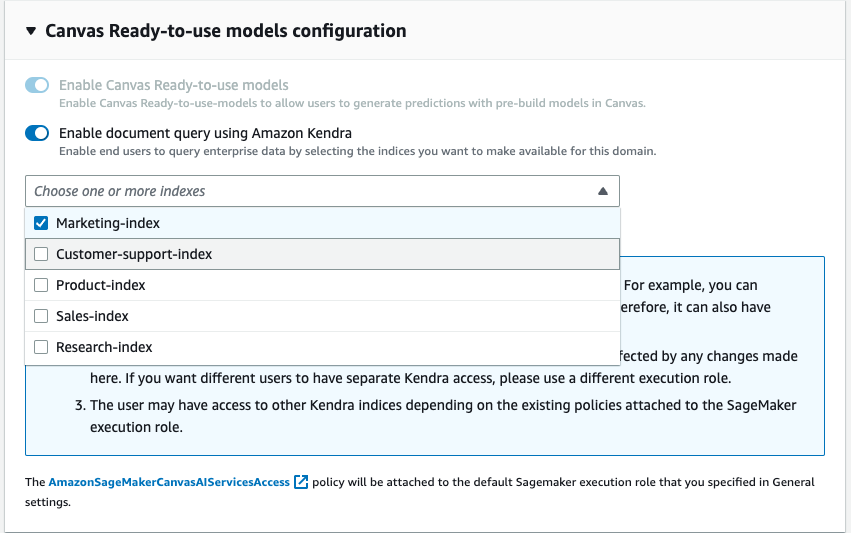

Als Teil der Domänenkonfiguration kann ein Cloud-Administrator einen oder mehrere Kendra-Indizes auswählen, die der Geschäftsanalyst bei der Interaktion mit dem FM über SageMaker Canvas abfragen kann.

Nachdem die Kendra-Indizes hydratisiert und konfiguriert wurden, verwenden Geschäftsanalysten sie mit SageMaker Canvas, indem sie einen neuen Chat starten und den Schalter „Dokumente abfragen“ auswählen. SageMaker Canvas verwaltet dann die zugrunde liegende Kommunikation zwischen Amazon Kendra und dem FM Ihrer Wahl, um die folgenden Vorgänge durchzuführen:

- Fragen Sie die Kendra-Indizes mit der vom Benutzer gestellten Frage ab.

- Rufen Sie die Ausschnitte (und die Quellen) von Kendra-Indizes ab.

- Konstruieren Sie die Eingabeaufforderung mit den Snippets mit der ursprünglichen Abfrage, damit das Grundlagenmodell aus den abgerufenen Dokumenten eine Antwort generieren kann.

- Stellen Sie dem Benutzer die generierte Antwort zusammen mit Verweisen auf die Seiten/Dokumente zur Verfügung, die zur Formulierung der Antwort verwendet wurden.

Einrichten von Canvas zum Abfragen von Dokumenten

In diesem Abschnitt führen wir Sie durch die Schritte zum Einrichten von Canvas für die Abfrage von Dokumenten, die über Kendra-Indizes bereitgestellt werden. Folgende Voraussetzungen sollten Sie mitbringen:

- Einrichtung der SageMaker-Domäne – Integrieren in die Amazon SageMaker-Domäne

- Erstellen Sie Kendra-Index (oder mehr als eine)

- Richten Sie den Kendra Amazon S3-Connector ein – befolgen Sie die Anweisungen Amazon S3-Anschluss – und laden Sie PDF-Dateien und andere Dokumente in den Amazon S3-Bucket hoch, der mit dem Kendra-Index verknüpft ist

- Richten Sie IAM so ein, dass Canvas über die entsprechenden Berechtigungen verfügt, einschließlich der Berechtigungen, die zum Aufrufen von Amazon Bedrock- und/oder SageMaker-Endpunkten erforderlich sind. Befolgen Sie die Anweisungen Richten Sie den Canvas-Chat ein Dokumentation

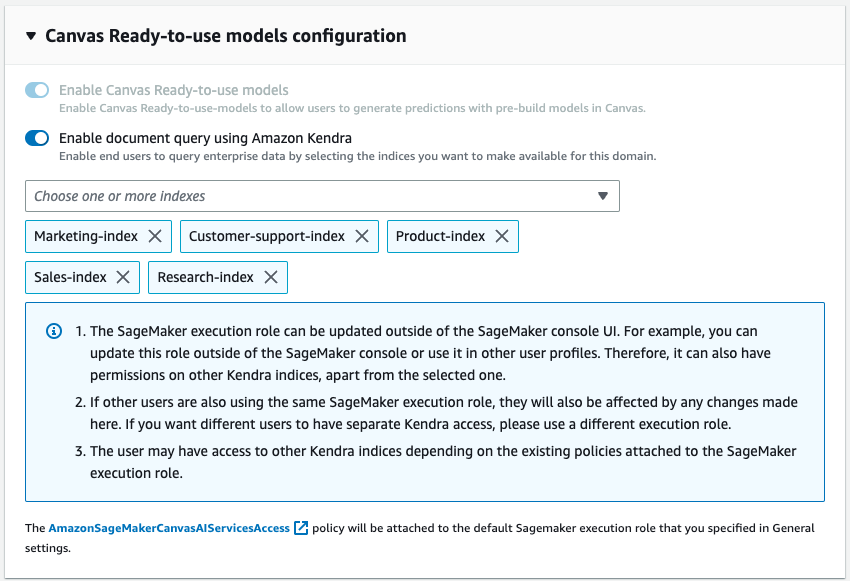

Jetzt können Sie die Domain aktualisieren, damit sie auf die gewünschten Indizes zugreifen kann. Wählen Sie in der SageMaker-Konsole für die angegebene Domäne auf der Registerkarte „Domäneneinstellungen“ die Option „Bearbeiten“ aus. Aktivieren Sie den Schalter „Abfragedokumente mit Amazon Kendra aktivieren“, der sich im Schritt „Canvas-Einstellungen“ befindet. Wählen Sie nach der Aktivierung einen oder mehrere Kendra-Indizes aus, die Sie mit Canvas verwenden möchten.

Das ist alles, was Sie zum Konfigurieren der Funktion „Canvas-Abfragedokumente“ benötigen. Benutzer können jetzt in Canvas in einen Chat einsteigen und mit der Nutzung der Wissensdatenbanken beginnen, die über die Kendra-Indizes an die Domain angehängt wurden. Die Betreuer der Wissensdatenbank können die Quelle der Wahrheit weiterhin aktualisieren und mit der Synchronisierungsfunktion in Kendra können die Chat-Benutzer automatisch die aktuellen Informationen nahtlos nutzen.

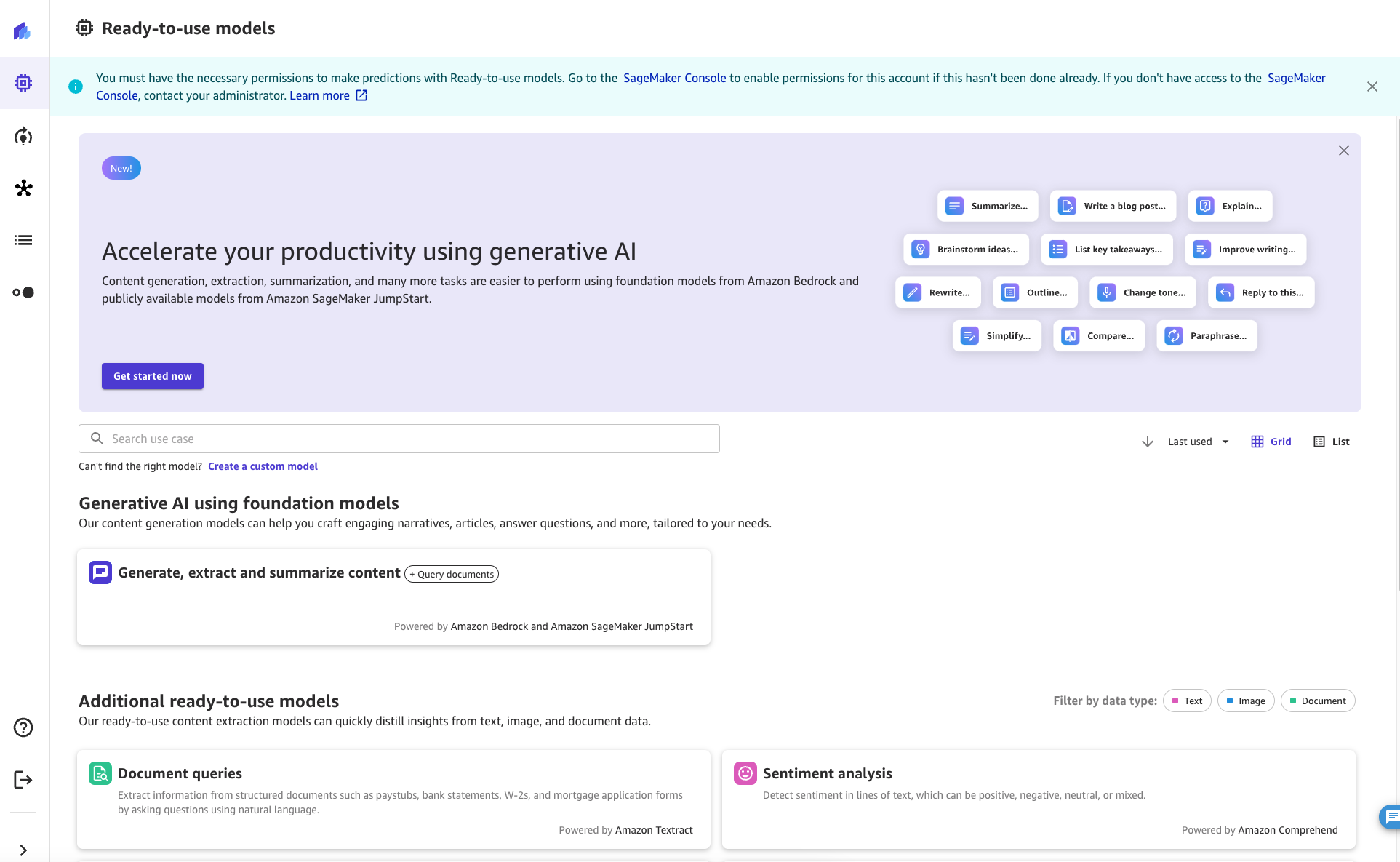

Verwenden der Funktion „Dokumente abfragen“ für den Chat

Als SageMaker Canvas-Benutzer kann aus einem Chat heraus auf die Funktion „Dokumente abfragen“ zugegriffen werden. Um die Chat-Sitzung zu starten, klicken Sie auf der Registerkarte „Gebrauchsfertige Modelle“ in SageMaker Canvas auf die Schaltfläche „Inhalt generieren, extrahieren und zusammenfassen“ oder suchen Sie danach.

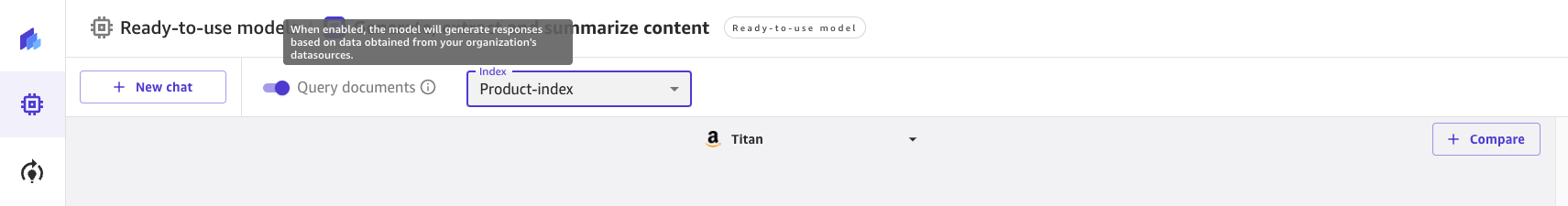

Dort können Sie Abfragedokumente mit dem Schalter oben auf dem Bildschirm aktivieren und deaktivieren. Sehen Sie sich die Informationsaufforderung an, um mehr über die Funktion zu erfahren.

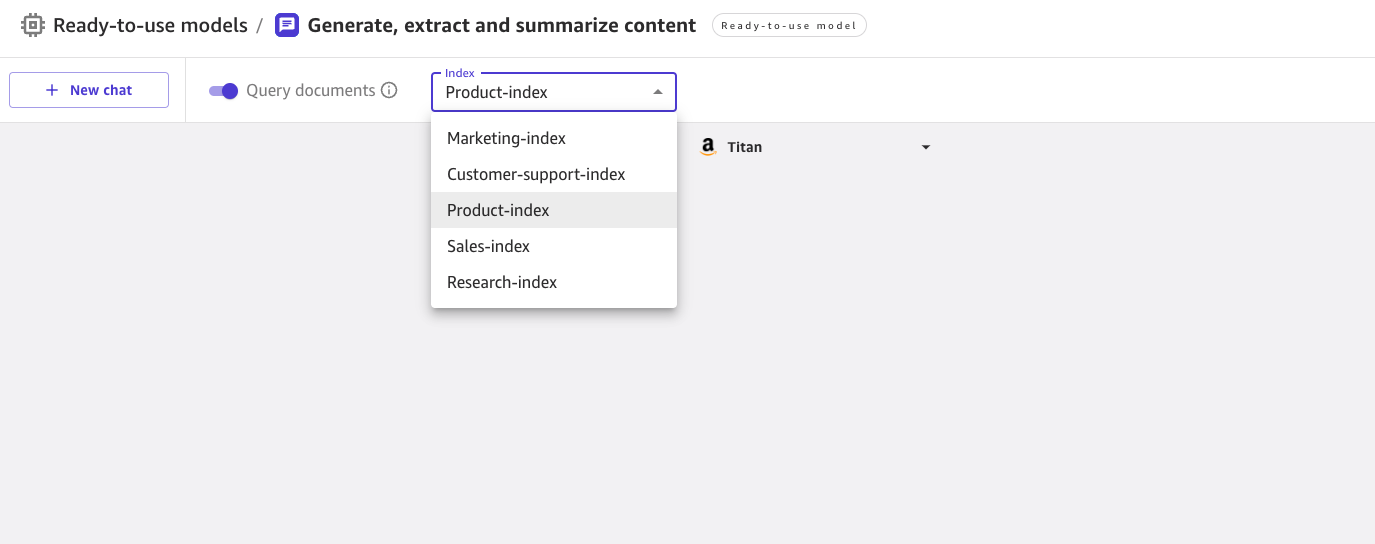

Wenn „Abfragedokumente“ aktiviert ist, können Sie aus einer Liste von Kendra-Indizes auswählen, die vom Cloud-Administrator aktiviert wurden.

Sie können einen Index auswählen, wenn Sie einen neuen Chat starten. Anschließend können Sie in der UX eine Frage stellen, wobei das Wissen automatisch aus dem ausgewählten Index bezogen wird. Beachten Sie, dass es nicht möglich ist, zu einem anderen Index zu wechseln, nachdem eine Konversation für einen bestimmten Index begonnen hat.

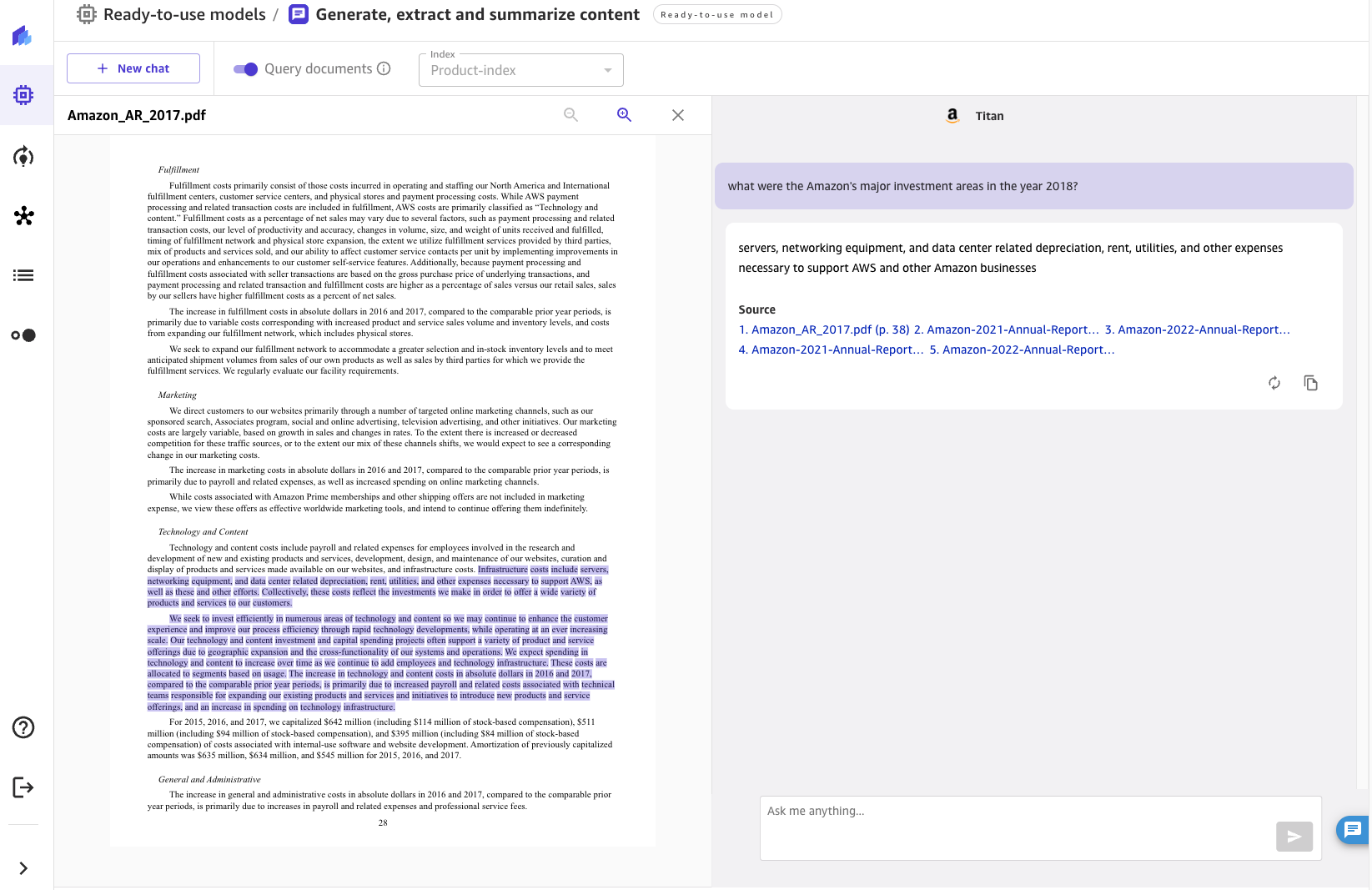

Für die gestellten Fragen zeigt der Chat die vom FM generierte Antwort zusammen mit den Quelldokumenten an, die zur Generierung der Antwort beigetragen haben. Wenn Sie auf eines der Quelldokumente klicken, öffnet Canvas eine Vorschau des Dokuments und hebt den vom FM verwendeten Auszug hervor.

Zusammenfassung

Konversations-KI hat ein enormes Potenzial, das Kunden- und Mitarbeitererlebnis zu verändern, indem sie einem menschenähnlichen Assistenten natürliche und intuitive Interaktionen bietet, wie zum Beispiel:

- Recherche zu einem Thema durchführen oder die Wissensdatenbank der Organisation durchsuchen und durchsuchen

- Fassen Sie große Mengen an Inhalten zusammen, um schnell Erkenntnisse zu gewinnen

- Suche nach Entitäten, Gefühlen, PII und anderen nützlichen Daten und Steigerung des Geschäftswerts unstrukturierter Inhalte

- Erstellen von Entwürfen für Dokumente und Geschäftskorrespondenz

- Erstellen von Wissensartikeln aus unterschiedlichen internen Quellen (Vorfälle, Chat-Protokolle, Wikis)

Die innovative Integration von Chat-Schnittstellen, Wissensabruf und FMs ermöglicht es Unternehmen, präzise und relevante Antworten auf Benutzerfragen zu geben, indem sie ihr Fachwissen und ihre Quellen der Wahrheit nutzen.

Durch die Verbindung von SageMaker Canvas mit Wissensdatenbanken in Amazon Kendra können Unternehmen ihre proprietären Daten in ihrer eigenen Umgebung behalten und gleichzeitig von den hochmodernen natürlichen Sprachfunktionen von FMs profitieren. Mit der Einführung der Funktion „Dokumente abfragen“ von SageMaker Canvas machen wir es jedem Unternehmen leicht, LLMs und ihr Unternehmenswissen als Quelle der Wahrheit zu nutzen, um ein sicheres Chat-Erlebnis zu ermöglichen. Alle diese Funktionen sind in einem No-Code-Format verfügbar, sodass Unternehmen die Bearbeitung sich wiederholender und nicht spezialisierter Aufgaben vermeiden können.

Um mehr über SageMaker Canvas zu erfahren und wie es jedem den Einstieg in maschinelles Lernen erleichtert, schauen Sie sich das an SageMaker Canvas-Ankündigung. Erfahren Sie mehr darüber, wie SageMaker Canvas die Zusammenarbeit zwischen Datenwissenschaftlern und Geschäftsanalysten fördert, indem Sie lesen Beitrag erstellen, teilen und bereitstellen. Abschließend erfahren Sie, wie Sie Ihren eigenen Retrieval Augmented Generation-Workflow erstellen SageMaker JumpStart RAG.

Bibliographie

Lewis, P., Perez, E., Piktus, A., Petroni, F., Karpukhin, V., Goyal, N., Küttler, H., Lewis, M., Yih, W., Rocktäschel, T., Riedel, S., Kiela, D. (2020). Retrieval-Augmented Generation für wissensintensive NLP-Aufgaben. Fortschritte in neuronalen Informationsverarbeitungssystemen, 33, 9459-9474.

Über die Autoren

David Gallitelli ist Senior Specialist Solutions Architect für KI/ML. Er hat seinen Sitz in Brüssel und arbeitet eng mit Kunden auf der ganzen Welt zusammen, die Low-Code/No-Code-Technologien für maschinelles Lernen und generative KI einführen möchten. Er ist seit seiner Kindheit als Entwickler tätig und begann im Alter von 7 Jahren mit dem Programmieren. An der Universität begann er, KI/ML zu lernen und hat sich seitdem darin verliebt.

David Gallitelli ist Senior Specialist Solutions Architect für KI/ML. Er hat seinen Sitz in Brüssel und arbeitet eng mit Kunden auf der ganzen Welt zusammen, die Low-Code/No-Code-Technologien für maschinelles Lernen und generative KI einführen möchten. Er ist seit seiner Kindheit als Entwickler tätig und begann im Alter von 7 Jahren mit dem Programmieren. An der Universität begann er, KI/ML zu lernen und hat sich seitdem darin verliebt.

Bilal Alam ist Enterprise Solutions Architect bei AWS mit Schwerpunkt auf der Finanzdienstleistungsbranche. An den meisten Tagen hilft Bilal Kunden beim Aufbau, der Modernisierung und der Sicherung ihrer AWS-Umgebung, um ihre kritischsten Workloads bereitzustellen. Er verfügt über umfassende Erfahrung in den Bereichen Telekommunikation, Netzwerke und Softwareentwicklung. In jüngerer Zeit beschäftigt er sich mit der Nutzung von KI/ML zur Lösung von Geschäftsproblemen.

Bilal Alam ist Enterprise Solutions Architect bei AWS mit Schwerpunkt auf der Finanzdienstleistungsbranche. An den meisten Tagen hilft Bilal Kunden beim Aufbau, der Modernisierung und der Sicherung ihrer AWS-Umgebung, um ihre kritischsten Workloads bereitzustellen. Er verfügt über umfassende Erfahrung in den Bereichen Telekommunikation, Netzwerke und Softwareentwicklung. In jüngerer Zeit beschäftigt er sich mit der Nutzung von KI/ML zur Lösung von Geschäftsproblemen.

Pashmeen Mistry ist Senior Product Manager bei AWS. Außerhalb der Arbeit genießt Pashmeen abenteuerliche Wanderungen, Fotografieren und verbringt Zeit mit seiner Familie.

Pashmeen Mistry ist Senior Product Manager bei AWS. Außerhalb der Arbeit genießt Pashmeen abenteuerliche Wanderungen, Fotografieren und verbringt Zeit mit seiner Familie.

Dan Sinnreich ist Senior Product Manager bei AWS und hilft bei der Demokratisierung von Low-Code/No-Code-Maschinenlernen. Vor seiner Zeit bei AWS hat Dan Unternehmens-SaaS-Plattformen und Zeitreihenmodelle entwickelt und kommerzialisiert, die von institutionellen Anlegern zum Risikomanagement und zum Aufbau optimaler Portfolios verwendet werden. Außerhalb der Arbeit spielt er Hockey, taucht und liest Science-Fiction.

Dan Sinnreich ist Senior Product Manager bei AWS und hilft bei der Demokratisierung von Low-Code/No-Code-Maschinenlernen. Vor seiner Zeit bei AWS hat Dan Unternehmens-SaaS-Plattformen und Zeitreihenmodelle entwickelt und kommerzialisiert, die von institutionellen Anlegern zum Risikomanagement und zum Aufbau optimaler Portfolios verwendet werden. Außerhalb der Arbeit spielt er Hockey, taucht und liest Science-Fiction.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/empower-your-business-users-to-extract-insights-from-company-documents-using-amazon-sagemaker-canvas-generative-ai/

- :hast

- :Ist

- :nicht

- :Wo

- ][P

- $UP

- 100

- 12

- 2020

- 2021

- 2023

- 225

- 7

- a

- Fähigkeit

- Fähig

- LiveBuzz

- beschleunigt

- Zugang

- Zugriff

- zugänglich

- genau

- Zusätzliche

- adoptieren

- Nach der

- gegen

- Alter

- AI

- AI / ML

- Alle

- Zulassen

- entlang

- bereits

- immer

- Amazon

- Amazon Kendra

- Amazon Sage Maker

- Amazon SageMaker-Leinwand

- Amazon Web Services

- unter

- an

- Analyse

- Analytiker

- Business Analysten

- und

- angekündigt

- Ein anderer

- beantworten

- jedem

- APIs

- angewandt

- Bewerben

- Ansatz

- angemessen

- Architektur

- SIND

- um

- Artikel

- AS

- fragen

- Assistentin

- damit verbundenen

- At

- vermehren

- Augmented

- Im Prinzip so, wie Sie es von Google Maps kennen.

- verfügbar

- vermeiden

- AWS

- unterstützt

- Base

- basierend

- BE

- war

- Sein

- profitieren

- zwischen

- Brüssel

- bauen

- Building

- erbaut

- Geschäft

- Unternehmen

- Taste im nun erscheinenden Bestätigungsfenster nun wieder los.

- by

- Aufruf

- CAN

- Leinwand

- Fähigkeiten

- capability

- Erfassung

- Fälle

- aus der Ferne überprüfen

- Wahl

- Auswählen

- klicken Sie auf

- eng

- Cloud

- Code

- Programmierung

- Zusammenarbeit

- Sammlung

- wie die

- Kommen

- Kommunikation

- Unternehmen

- Vergleich

- kompatibel

- Komplex

- Computer

- Computer Vision

- Konfiguration

- konfiguriert

- Sich zusammenschliessen

- konsistent

- Konsul (Console)

- konstruieren

- Inhalt

- Inhalt

- fortsetzen

- beigetragen

- Gespräch

- Gespräche

- verkaufen

- umgewandelt

- erstellen

- kritischem

- Kunde

- Kunden

- technische Daten

- Datenbanken

- Tage

- tief

- demokratisieren

- einsetzen

- Bereitstellen

- beschreiben

- erwünscht

- Detail

- Entdeckung

- Entwickler:in / Unternehmen

- Entwicklung

- diskutieren

- disparat

- Tauchen

- Dokument

- Unterlagen

- Domain

- e

- einfacher

- Einfache

- Einbettung

- Mitarbeiter

- ermächtigen

- ermöglichen

- freigegeben

- ermöglicht

- bereichern

- sorgt

- Gewährleistung

- Unternehmen

- Unternehmen

- Entitäten

- Arbeitsumfeld

- jedermann

- Beispiel

- ergänzt

- ERFAHRUNGEN

- ERKUNDEN

- umfangreiche

- Langjährige Erfahrung

- extern

- Extrakt

- Gefallen

- Familie

- Merkmal

- Fiktion

- Mappen

- Endlich

- Revolution

- Finanzdienstleistungen

- Vorname

- Setzen Sie mit Achtsamkeit

- folgen

- Folgende

- Aussichten für

- Format

- Fördern

- gefunden

- Foundation

- häufig

- für

- Funktionalität

- sammeln

- erzeugen

- erzeugt

- Erzeugung

- Generation

- generativ

- Generative KI

- bekommen

- gegeben

- Globus

- Governance

- Guide

- Handling

- Geschirr

- Haben

- he

- Unternehmen

- hilft

- Hervorheben

- Wanderungen

- seine

- Ultraschall

- Hilfe

- HTML

- http

- HTTPS

- if

- zeigt

- immens

- zu unterstützen,

- in

- Einschließlich

- zunehmend

- Index

- Indizes

- Indizes

- industriell

- Energiegewinnung

- Information

- innovativ

- Einblicke

- Institutionell

- institutionelle Anleger

- Integration

- Interaktion

- Interaktionen

- Schnittstellen

- intern

- in

- Einleitung

- intuitiv

- Investoren

- IT

- SEINE

- jpg

- springen

- Behalten

- Wissend

- Wissen

- Knowledge Management

- Sprache

- grosse

- starten

- LERNEN

- lernen

- Lasst uns

- Cholesterinspiegel

- Lewis

- Bibliothek

- Line

- Liste

- suchen

- ich liebe

- Maschine

- Maschinelles Lernen

- Aufrechterhaltung

- um

- Making

- verwalten

- Management

- Manager

- Weise

- viele

- ML

- Modell

- für

- mehr

- vor allem warme

- mehrere

- Natürliche

- Verarbeitung natürlicher Sprache

- erforderlich

- Vernetzung

- Nerven-

- Neu

- Nlp

- jetzt an

- of

- WOW!

- on

- einmal

- EINEM

- Eröffnung

- öffnet

- Betriebs-

- Einkauf & Prozesse

- optimal

- or

- Organisationen

- Original

- Andere

- Anders

- Ergebnisse

- Möglichkeiten für das Ausgangssignal:

- Ausgänge

- aussen

- besitzen

- Teil

- Ausführen

- durchgeführt

- Berechtigungen

- Fotografie

- ein Bild

- Plattformen

- Plato

- Datenintelligenz von Plato

- PlatoData

- spielend

- Portfolios

- möglich

- Post

- Potenzial

- Werkzeuge

- Prognose

- Voraussetzungen

- Gegenwart

- Vorspann

- früher

- privat

- Probleme

- Prozessdefinierung

- Verarbeitung

- produziert

- Produkt

- Produkt-Manager

- ordnungsgemäße

- Eigentums-

- die

- vorausgesetzt

- Bereitstellung

- Abfragen

- Frage

- Fragen

- schnell

- schnell

- Lesebrillen

- kürzlich

- Veteran

- Reduzierung

- siehe

- Referenzen

- Release

- freigegeben

- relevant

- repetitiv

- falls angefordert

- erfordert

- Forschungsprojekte

- Antwort

- Antworten

- Die Ergebnisse

- Überprüfen

- Risiko

- s

- SaaS

- Schutzmaßnahmen

- sagemaker

- Wissenschaft

- Science-Fiction

- Wissenschaftler

- Bildschirm

- nahtlos

- Suche

- Abschnitt

- Verbindung

- Sicherung

- Suchen

- ausgewählt

- Auswahl

- Senior

- empfindlich

- Gefühl

- Gefühle

- Lösungen

- Sitzung

- kompensieren

- Einstellung

- Einstellungen

- Setup

- Teilen

- sollte

- erklären

- gezeigt

- da

- Fähigkeiten

- So

- Software

- Software-Entwicklung

- Lösung

- Lösungen

- LÖSEN

- Quelle

- bezogen

- Quellen

- Spezialist

- spezifisch

- Ausgabe

- Anfang

- begonnen

- Beginnen Sie

- State-of-the-art

- Schritt

- Shritte

- Immer noch

- so

- zusammenfassen

- Support

- Schalter

- System

- und Aufgaben

- Teams

- Technische

- Technologies

- Telco

- Grundsätze

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- die Informationen

- Die Quelle

- ihr

- Sie

- dann

- Dort.

- fehlen uns die Worte.

- diejenigen

- Durch

- Zeit

- zu

- Top

- Thema

- Transformieren

- wirklich

- vertraut

- WENDE

- für

- zugrunde liegen,

- Universität

- bis

- auf dem neusten Stand

- Aktualisierung

- -

- benutzt

- Mitglied

- Nutzer

- verwendet

- Verwendung von

- ux

- Wert

- Vielfalt

- sehr

- Seh-

- Volumen

- W

- Spaziergang

- wollen

- wurde

- we

- Netz

- Web-Services

- waren

- wann

- welche

- während

- werden wir

- mit

- .

- ohne

- Arbeiten

- Arbeitsablauf.

- Werk

- Schreiben

- Du

- jung

- Ihr

- Zephyrnet