Open-Source-Modelle für große Sprachen (LLMs) erfreuen sich zunehmender Beliebtheit und ermöglichen Forschern, Entwicklern und Organisationen den Zugriff auf diese Modelle, um Innovationen und Experimente zu fördern. Dies fördert die Zusammenarbeit der Open-Source-Community, um zur Entwicklung und Verbesserung von LLMs beizutragen. Open-Source-LLMs bieten Transparenz für die Modellarchitektur, den Trainingsprozess und die Trainingsdaten, sodass Forscher die Funktionsweise des Modells verstehen, potenzielle Vorurteile erkennen und ethische Bedenken ansprechen können. Diese Open-Source-LLMs demokratisieren die generative KI, indem sie fortschrittliche Technologie zur Verarbeitung natürlicher Sprache (NLP) einem breiten Spektrum von Benutzern zur Verfügung stellen, um geschäftskritische Geschäftsanwendungen zu erstellen. GPT-NeoX, LLaMA, Alpaca, GPT4All, Vicuna, Dolly und OpenAssistant sind einige der beliebtesten Open-Source-LLMs.

OpenChatKit ist ein Open-Source-LLM zum Erstellen allgemeiner und spezialisierter Chatbot-Anwendungen, das im März 2023 von Together Computer unter der Apache-2.0-Lizenz veröffentlicht wurde. Dieses Modell ermöglicht es Entwicklern, mehr Kontrolle über das Verhalten des Chatbots zu haben und es an ihre spezifischen Anwendungen anzupassen. OpenChatKit bietet eine Reihe von Tools, Basis-Bots und Bausteinen zum Erstellen vollständig angepasster, leistungsstarker Chatbots. Die Schlüsselkomponenten sind wie folgt:

- Ein auf Anweisungen abgestimmtes LLM, abgestimmt auf den Chat von EleutherAIs GPT-NeoX-20B mit über 43 Millionen Anweisungen auf 100 % COXNUMX-negativem Computing. Der

GPT-NeoXT-Chat-Base-20BDas Modell basiert auf dem GPT-NeoX-Modell von EleutherAI und ist mit Daten abgestimmt, die sich auf Interaktionen im Dialogstil konzentrieren. - Anpassungsrezepte zur Feinabstimmung des Modells, um eine hohe Genauigkeit bei Ihren Aufgaben zu erreichen.

- Ein erweiterbares Abrufsystem, mit dem Sie Bot-Antworten mit Informationen aus einem Dokumenten-Repository, einer API oder einer anderen live aktualisierten Informationsquelle zum Zeitpunkt der Inferenz ergänzen können.

- Ein Moderationsmodell, das anhand von GPT-JT-6B verfeinert wurde und dazu dient, zu filtern, auf welche Fragen der Bot antwortet.

Der zunehmende Umfang und die zunehmende Größe von Deep-Learning-Modellen stellen Hindernisse für den erfolgreichen Einsatz dieser Modelle in generativen KI-Anwendungen dar. Um den Anforderungen an geringe Latenz und hohen Durchsatz gerecht zu werden, ist der Einsatz anspruchsvoller Methoden wie Modellparallelität und Quantisierung unerlässlich. Mangels Kenntnissen in der Anwendung dieser Methoden haben zahlreiche Benutzer Schwierigkeiten, das Hosting umfangreicher Modelle für generative KI-Anwendungsfälle zu initiieren.

In diesem Beitrag zeigen wir, wie man OpenChatKit-Modelle bereitstellt (GPT-NeoXT-Chat-Base-20B and GPT-JT-Moderation-6B) Modelle auf Amazon Sage Maker unter Verwendung von DJL Serving und parallelen Open-Source-Modellbibliotheken wie DeepSpeed und Hugging Face Accelerate. Wir verwenden DJL Serving, eine leistungsstarke, universelle Model-Serving-Lösung, die auf der Deep Java Library (DJL) basiert und unabhängig von der Programmiersprache ist. Wir zeigen, wie die Hugging Face Accelerate-Bibliothek die Bereitstellung großer Modelle auf mehreren GPUs vereinfacht und so den Aufwand für die verteilte Ausführung von LLMs verringert. Lass uns anfangen!

Erweiterbares Abrufsystem

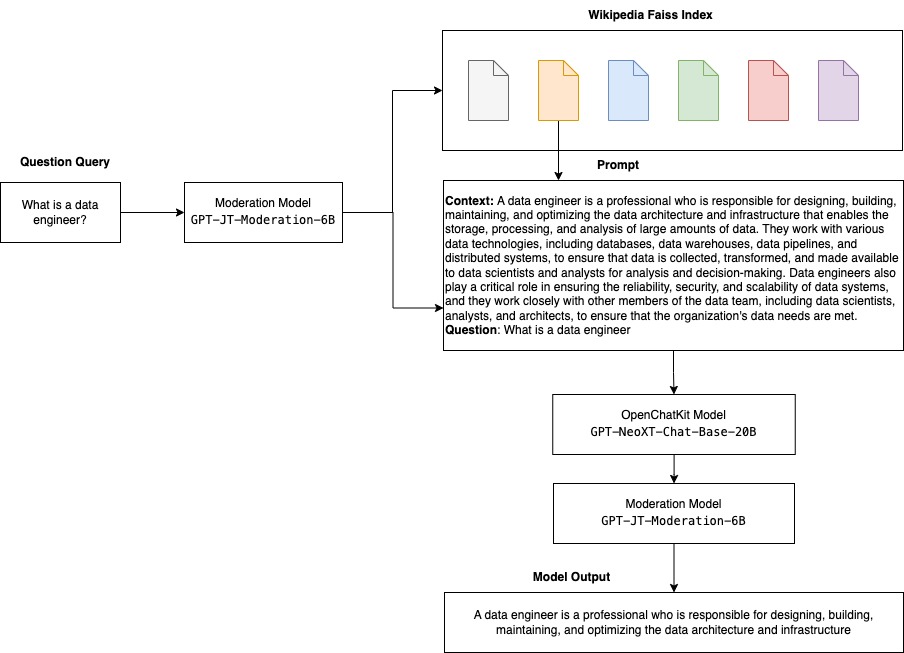

Ein erweiterbares Abrufsystem ist eine der Schlüsselkomponenten von OpenChatKit. Es ermöglicht Ihnen, die Bot-Reaktion basierend auf einer geschlossenen Domänen-Wissensdatenbank anzupassen. Obwohl LLMs in der Lage sind, Faktenwissen in ihren Modellparametern beizubehalten und bei Feinabstimmung eine bemerkenswerte Leistung bei nachgelagerten NLP-Aufgaben zu erzielen, bleibt ihre Fähigkeit, auf geschlossenes Domänenwissen zuzugreifen und es genau vorherzusagen, begrenzt. Wenn ihnen daher wissensintensive Aufgaben gestellt werden, leidet ihre Leistung unter der von aufgabenspezifischen Architekturen. Sie können das OpenChatKit-Abrufsystem verwenden, um das Wissen in ihren Antworten aus externen Wissensquellen wie Wikipedia, Dokumentrepositorys, APIs und anderen Informationsquellen zu erweitern.

Das Retrieval-System ermöglicht es dem Chatbot, auf aktuelle Informationen zuzugreifen, indem es relevante Details als Antwort auf eine bestimmte Anfrage erhält, und stellt so den notwendigen Kontext bereit, damit das Modell Antworten generieren kann. Um die Funktionalität dieses Abrufsystems zu veranschaulichen, bieten wir Unterstützung für einen Index von Wikipedia-Artikeln und bieten Beispielcode an, der zeigt, wie eine Websuch-API für den Informationsabruf aufgerufen wird. Indem Sie die bereitgestellte Dokumentation befolgen, können Sie das Abrufsystem während des Inferenzprozesses in jeden Datensatz oder jede API integrieren, sodass der Chatbot dynamisch aktualisierte Daten in seine Antworten integrieren kann.

Moderationsmodell

Moderationsmodelle sind in Chatbot-Anwendungen wichtig, um Inhaltsfilterung, Qualitätskontrolle, Benutzersicherheit sowie rechtliche und Compliance-Gründe durchzusetzen. Moderation ist eine schwierige und subjektive Aufgabe und hängt stark von der Domäne der Chatbot-Anwendung ab. OpenChatKit bietet Tools zum Moderieren der Chatbot-Anwendung und zum Überwachen von Eingabeaufforderungen auf unangemessene Inhalte. Das Moderationsmodell bietet eine gute Basis, die an verschiedene Bedürfnisse angepasst und angepasst werden kann.

OpenChatKit verfügt über ein Moderationsmodell mit 6 Milliarden Parametern. GPT-JT-Moderation-6B, der den Chatbot moderieren kann, um die Eingaben auf die moderierten Themen zu beschränken. Obwohl das Modell selbst über eine gewisse Moderation verfügt, hat TogetherComputer a trainiert GPT-JT-Moderation-6B Modell mit Ontocord.ai's OIG-Moderationsdatensatz. Dieses Modell läuft neben dem Haupt-Chatbot, um zu überprüfen, dass sowohl die Benutzereingabe als auch die Antwort des Bots keine unangemessenen Ergebnisse enthalten. Sie können dies auch verwenden, um Fragen an den Chatbot zu erkennen, die außerhalb der Domäne liegen, und diese zu überschreiben, wenn die Frage nicht Teil der Domäne des Chatbots ist.

Das folgende Diagramm veranschaulicht den OpenChatKit-Workflow.

Anwendungsfälle für erweiterbare Abrufsysteme

Obwohl wir diese Technik in verschiedenen Branchen anwenden können, um generative KI-Anwendungen zu erstellen, diskutieren wir in diesem Beitrag Anwendungsfälle in der Finanzbranche. Retrieval Augmented Generation kann in der Finanzforschung eingesetzt werden, um automatisch Forschungsberichte zu bestimmten Unternehmen, Branchen oder Finanzprodukten zu erstellen. Durch den Abruf relevanter Informationen aus internen Wissensdatenbanken, Finanzarchiven, Nachrichtenartikeln und Forschungspapieren können Sie umfassende Berichte erstellen, die wichtige Erkenntnisse, Finanzkennzahlen, Markttrends und Anlageempfehlungen zusammenfassen. Mit dieser Lösung können Sie Finanznachrichten, Marktstimmung und Trends überwachen und analysieren.

Lösungsüberblick

Die folgenden Schritte sind erforderlich, um einen Chatbot mithilfe von OpenChatKit-Modellen zu erstellen und auf SageMaker bereitzustellen:

- Laden Sie die Chat-Basis herunter

GPT-NeoXT-Chat-Base-20BModellieren und verpacken Sie die Modellartefakte, in die hochgeladen werden soll Amazon Simple Storage-Service (Amazon S3). - Verwenden Sie einen LMI-Container (Large Model Inference) von SageMaker, konfigurieren Sie die Eigenschaften und richten Sie benutzerdefinierten Inferenzcode ein, um dieses Modell bereitzustellen.

- Konfigurieren Sie modellparallele Techniken und verwenden Sie Inferenzoptimierungsbibliotheken in DJL-Bereitstellungseigenschaften. Wir werden Hugging Face Accelerate als Engine für die DJL-Bereitstellung verwenden. Darüber hinaus definieren wir tensorparallele Konfigurationen, um das Modell zu partitionieren.

- Erstellen Sie ein SageMaker-Modell und eine Endpunktkonfiguration und stellen Sie den SageMaker-Endpunkt bereit.

Sie können mitmachen, indem Sie das Notizbuch im ausführen GitHub Repo.

Laden Sie das OpenChatKit-Modell herunter

Zuerst laden wir das OpenChatKit-Basismodell herunter. Wir gebrauchen huggingface_hub Und verwenden snapshot_download um das Modell herunterzuladen, wodurch ein gesamtes Repository mit einer bestimmten Revision heruntergeladen wird. Um den Vorgang zu beschleunigen, werden gleichzeitig Downloads durchgeführt. Siehe den folgenden Code:

DJL bedient Immobilien

Sie können SageMaker LMI-Container verwenden, um große generative KI-Modelle mit benutzerdefiniertem Inferenzcode zu hosten, ohne Ihren eigenen Inferenzcode bereitzustellen. Dies ist äußerst nützlich, wenn keine benutzerdefinierte Vorverarbeitung der Eingabedaten oder Nachverarbeitung der Modellvorhersagen erfolgt. Sie können ein Modell auch mithilfe von benutzerdefiniertem Inferenzcode bereitstellen. In diesem Beitrag zeigen wir, wie man OpenChatKit-Modelle mit benutzerdefiniertem Inferenzcode bereitstellt.

SageMaker erwartet die Modellartefakte im TAR-Format. Wir erstellen jedes OpenChatKit-Modell mit den folgenden Dateien: serving.properties und model.py.

Das serving.properties Die Konfigurationsdatei gibt DJL Serving an, welche Modellparallelisierungs- und Inferenzoptimierungsbibliotheken Sie verwenden möchten. Im Folgenden finden Sie eine Liste der Einstellungen, die wir in dieser Konfigurationsdatei verwenden:

Dieser enthält folgende Parameter:

- Sie – Die Engine, die DJL verwenden kann.

- option.entryPoint – Die Einstiegspunkt-Python-Datei oder das Python-Modul. Dies sollte mit dem verwendeten Motor übereinstimmen.

- option.s3url – Legen Sie dies auf den URI des S3-Buckets fest, der das Modell enthält.

- option.modelid – Wenn Sie das Modell von Huggingface.co herunterladen möchten, können Sie es festlegen

option.modelidzur Modell-ID eines vorab trainierten Modells, das in einem Modell-Repository auf Huggingface.co gehostet wird (https://huggingface.co/models). Der Container verwendet diese Modell-ID, um das entsprechende Modell-Repository auf Huggingface.co herunterzuladen. - option.tensor_parallel_degree – Legen Sie hier die Anzahl der GPU-Geräte fest, über die DeepSpeed das Modell partitionieren muss. Dieser Parameter steuert auch die Anzahl der Worker pro Modell, die gestartet werden, wenn DJL Serving ausgeführt wird. Wenn wir beispielsweise über eine Maschine mit 8 GPUs verfügen und acht Partitionen erstellen, haben wir einen Worker pro Modell, der die Anforderungen bearbeitet. Es ist notwendig, den Grad der Parallelität zu optimieren und den optimalen Wert für eine bestimmte Modellarchitektur und Hardwareplattform zu ermitteln. Wir nennen das Fähigkeit inferenzadaptierter Parallelismus.

Beziehen auf Konfigurationen und Einstellungen für eine vollständige Liste der Optionen.

OpenChatKit-Modelle

Die OpenChatKit-Basismodellimplementierung verfügt über die folgenden vier Dateien:

- model.py – Diese Datei implementiert die Verarbeitungslogik für das Hauptmodell von OpenChatKit GPT-NeoX. Es empfängt die Inferenzeingabeanforderung, lädt das Modell, lädt den Wikipedia-Index und stellt die Antwort bereit. Beziehen auf

model.py(erstellter Teil des Notizbuchs) für weitere Details.model.pyverwendet die folgenden Schlüsselklassen:- OpenChatKitService – Dies übernimmt die Weitergabe der Daten zwischen dem GPT-NeoX-Modell, der Faiss-Suche und dem Konversationsobjekt.

WikipediaIndexundConversationObjekte werden initialisiert und Eingabe-Chat-Konversationen werden an den Index gesendet, um nach relevanten Inhalten aus Wikipedia zu suchen. Dadurch wird auch eine eindeutige ID für jeden Aufruf generiert, sofern diese nicht zum Zweck der Speicherung der Eingabeaufforderungen angegeben wird Amazon DynamoDB. - ChatModel – Diese Klasse lädt das Modell und den Tokenizer und generiert die Antwort. Es übernimmt die Partitionierung des Modells auf mehrere GPUs

tensor_parallel_degree, und konfiguriert diedtypesunddevice_map. Die Eingabeaufforderungen werden an das Modell übergeben, um Antworten zu generieren. Ein StoppkriteriumStopWordsCriteriaist so konfiguriert, dass die Generierung nur die Bot-Antwort bei Inferenz erzeugt. - Moderationsmodell – Wir nutzen zwei Moderationsmodelle im

ModerationModelKlasse: das Eingabemodell, um dem Chat-Modell anzuzeigen, dass die Eingabe ungeeignet ist, um das Inferenzergebnis zu überschreiben, und das Ausgabemodell, um das Inferenzergebnis zu überschreiben. Wir klassifizieren die Eingabeaufforderung und Ausgabeantwort mit den folgenden möglichen Bezeichnungen:- lässig

- braucht Vorsicht

- erfordert Intervention (dies wird vom Modell als moderiert gekennzeichnet)

- Möglicherweise ist Vorsicht geboten

- wahrscheinlich ist Vorsicht geboten

- OpenChatKitService – Dies übernimmt die Weitergabe der Daten zwischen dem GPT-NeoX-Modell, der Faiss-Suche und dem Konversationsobjekt.

- wikipedia_prepare.py – Diese Datei übernimmt das Herunterladen und Vorbereiten des Wikipedia-Index. In diesem Beitrag verwenden wir einen Wikipedia-Index zu Hugging Face-Datensätzen. Um die Wikipedia-Dokumente nach relevantem Text zu durchsuchen, muss der Index von Hugging Face heruntergeladen werden, da er nicht anderswo verpackt ist. Der

wikipedia_prepare.pyDie Datei ist für die Handhabung des Downloads beim Import verantwortlich. Nur ein einzelner Prozess in den mehreren Prozessen, die zur Inferenz ausgeführt werden, kann das Repository klonen. Der Rest wartet, bis die Dateien im lokalen Dateisystem vorhanden sind. - wikipedia.py – Diese Datei wird für die Suche im Wikipedia-Index nach kontextrelevanten Dokumenten verwendet. Die Eingabeabfrage wird tokenisiert und Einbettungen werden mit erstellt

mean_pooling. Wir berechnen Cosinus-Ähnlichkeitsdistanzmetriken zwischen der Abfrageeinbettung und dem Wikipedia-Index, um kontextrelevante Wikipedia-Sätze abzurufen. Beziehen aufwikipedia.pyfür Ausführungsdetails.

- Konversation.py – Diese Datei wird zum Speichern und Abrufen des Konversationsthreads in DynamoDB zur Weitergabe an das Modell und den Benutzer verwendet.

conversation.pyist aus dem Open-Source-Repository OpenChatKit übernommen. Diese Datei ist für die Definition des Objekts verantwortlich, das die Gesprächsrunden zwischen dem Menschen und dem Modell speichert. Dadurch ist das Modell in der Lage, eine Sitzung für die Konversation beizubehalten, sodass ein Benutzer auf frühere Nachrichten zurückgreifen kann. Da SageMaker-Endpunktaufrufe zustandslos sind, muss diese Konversation an einem Ort außerhalb der Endpunktinstanzen gespeichert werden. Beim Start erstellt die Instanz eine DynamoDB-Tabelle, falls diese nicht vorhanden ist. Alle Aktualisierungen der Konversation werden dann basierend auf dem in DynamoDB gespeichertsession_idSchlüssel, der vom Endpunkt generiert wird. Jeder Aufruf mit einer Sitzungs-ID ruft die zugehörige Konversationszeichenfolge ab und aktualisiert sie nach Bedarf.

Erstellen Sie einen LMI-Inferenzcontainer mit benutzerdefinierten Abhängigkeiten

Die Indexsuche nutzt Facebooks Faiß Bibliothek zur Durchführung der Ähnlichkeitssuche. Da dies nicht im Basis-LMI-Image enthalten ist, muss der Container angepasst werden, um diese Bibliothek zu installieren. Der folgende Code definiert eine Docker-Datei, die Faiss von der Quelle zusammen mit anderen vom Bot-Endpunkt benötigten Bibliotheken installiert. Wir benutzen das sm-docker Dienstprogramm zum Erstellen und Übertragen des Images Amazon Elastic Container-Registrierung (Amazon ECR) von Amazon SageMaker-Studio. Beziehen auf Verwenden der Amazon SageMaker Studio Image CLI zum Erstellen von Container-Images aus Ihren Studio-Notebooks für weitere Informationen an.

Im DJL-Container ist Conda nicht installiert, daher muss Faiss geklont und aus der Quelle kompiliert werden. Um Faiss zu installieren, müssen die Abhängigkeiten für die Verwendung der BLAS-APIs und der Python-Unterstützung installiert werden. Nach der Installation dieser Pakete wird Faiss für die Verwendung von AVX2 und CUDA konfiguriert, bevor es mit den installierten Python-Erweiterungen kompiliert wird.

pandas, fastparquet, boto3 und git-lfs werden nachträglich installiert, da diese zum Herunterladen und Lesen der Indexdateien benötigt werden.

Modell erstellen

Da wir nun das Docker-Image in Amazon ECR haben, können wir mit der Erstellung des SageMaker-Modellobjekts für die OpenChatKit-Modelle fortfahren. Wir stellen bereit GPT-NeoXT-Chat-Base-20B Input- und Output-Moderationsmodelle unter Verwendung GPT-JT-Moderation-6B. Beziehen auf create_model für weitere Informationen an.

Konfigurieren Sie den Endpunkt

Als Nächstes definieren wir die Endpunktkonfigurationen für die OpenChatKit-Modelle. Wir stellen die Modelle mithilfe des Instanztyps ml.g5.12xlarge bereit. Beziehen auf create_endpoint_config für weitere Informationen an.

Stellen Sie den Endpunkt bereit

Schließlich erstellen wir einen Endpunkt mithilfe des Modells und der Endpunktkonfiguration, die wir in den vorherigen Schritten definiert haben:

Führen Sie Rückschlüsse aus OpenChatKit-Modellen aus

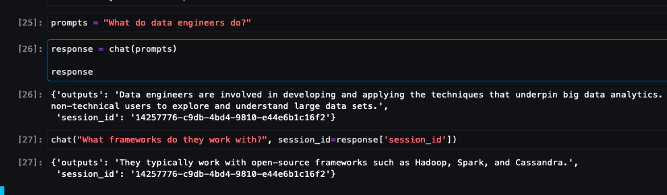

Jetzt ist es an der Zeit, Inferenzanfragen an das Modell zu senden und die Antworten zu erhalten. Wir übergeben den Eingabeaufforderungstext und Modellparameter wie z temperature, top_k und max_new_tokens. Die Qualität der Chatbot-Antworten basiert auf den angegebenen Parametern. Daher wird empfohlen, die Modellleistung anhand dieser Parameter zu vergleichen, um die optimale Einstellung für Ihren Anwendungsfall zu finden. Die Eingabeaufforderung wird zunächst an das Eingabemoderationsmodell gesendet, und die Ausgabe wird an gesendet ChatModel um die Antworten zu generieren. Während dieses Schritts verwendet das Modell den Wikipedia-Index, um kontextrelevante Abschnitte des Modells abzurufen, als Aufforderung, domänenspezifische Antworten vom Modell zu erhalten. Schließlich wird die Modellantwort an das Ausgabemoderationsmodell gesendet, um die Klassifizierung zu überprüfen, und dann werden die Antworten zurückgegeben. Siehe den folgenden Code:

Nachfolgend finden Sie Beispiele für Chat-Interaktionen.

Aufräumen

Befolgen Sie die Anweisungen im Bereinigungsabschnitt des, um die im Rahmen dieses Beitrags bereitgestellten Ressourcen zu löschen und unnötige Kosten zu vermeiden. Beziehen auf Amazon SageMaker Preise Einzelheiten zu den Kosten der Inferenzinstanzen finden Sie hier.

Zusammenfassung

In diesem Beitrag haben wir die Bedeutung von Open-Source-LLMs und die Bereitstellung eines OpenChatKit-Modells auf SageMaker diskutiert, um Chatbot-Anwendungen der nächsten Generation zu erstellen. Wir diskutierten verschiedene Komponenten von OpenChatKit-Modellen, Moderationsmodellen und die Verwendung einer externen Wissensquelle wie Wikipedia für Retrieval Augmented Generation (RAG)-Workflows. Eine Schritt-für-Schritt-Anleitung finden Sie im GitHub-Notizbuch. Informieren Sie uns über die fantastischen Chatbot-Anwendungen, die Sie erstellen. Beifall!

Über die Autoren

Dhawal Patel ist Principal Machine Learning Architect bei AWS. Er hat mit Organisationen von großen Unternehmen bis hin zu mittelständischen Startups an Problemen im Zusammenhang mit verteiltem Computing und künstlicher Intelligenz gearbeitet. Er konzentriert sich auf Deep Learning, einschließlich NLP- und Computer Vision-Domänen. Er hilft Kunden, hochleistungsfähige Modellinferenz auf SageMaker zu erreichen.

Dhawal Patel ist Principal Machine Learning Architect bei AWS. Er hat mit Organisationen von großen Unternehmen bis hin zu mittelständischen Startups an Problemen im Zusammenhang mit verteiltem Computing und künstlicher Intelligenz gearbeitet. Er konzentriert sich auf Deep Learning, einschließlich NLP- und Computer Vision-Domänen. Er hilft Kunden, hochleistungsfähige Modellinferenz auf SageMaker zu erreichen.

Vikram Elango ist Senior AIML Specialist Solutions Architect bei AWS mit Sitz in Virginia, USA. Derzeit konzentriert er sich auf generative KI, LLMs, Prompt Engineering, Optimierung großer Modellinferenzen und unternehmensweite Skalierung von ML. Vikram unterstützt Kunden aus der Finanz- und Versicherungsbranche mit Design und Vordenkerrolle bei der Entwicklung und Bereitstellung von Anwendungen für maschinelles Lernen in großem Maßstab. In seiner Freizeit reist er gerne, wandert, kocht und campt mit seiner Familie.

Vikram Elango ist Senior AIML Specialist Solutions Architect bei AWS mit Sitz in Virginia, USA. Derzeit konzentriert er sich auf generative KI, LLMs, Prompt Engineering, Optimierung großer Modellinferenzen und unternehmensweite Skalierung von ML. Vikram unterstützt Kunden aus der Finanz- und Versicherungsbranche mit Design und Vordenkerrolle bei der Entwicklung und Bereitstellung von Anwendungen für maschinelles Lernen in großem Maßstab. In seiner Freizeit reist er gerne, wandert, kocht und campt mit seiner Familie.

Andrew Smith ist ein Cloud-Support-Ingenieur im SageMaker, Vision & Other-Team bei AWS mit Sitz in Sydney, Australien. Er unterstützt Kunden, die viele KI/ML-Dienste auf AWS nutzen, mit Fachwissen in der Arbeit mit Amazon SageMaker. Außerhalb der Arbeit verbringt er gerne Zeit mit Freunden und Familie und lernt verschiedene Technologien kennen.

Andrew Smith ist ein Cloud-Support-Ingenieur im SageMaker, Vision & Other-Team bei AWS mit Sitz in Sydney, Australien. Er unterstützt Kunden, die viele KI/ML-Dienste auf AWS nutzen, mit Fachwissen in der Arbeit mit Amazon SageMaker. Außerhalb der Arbeit verbringt er gerne Zeit mit Freunden und Familie und lernt verschiedene Technologien kennen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- EVM-Finanzen. Einheitliche Schnittstelle für dezentrale Finanzen. Hier zugreifen.

- Quantum Media Group. IR/PR verstärkt. Hier zugreifen.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/build-custom-chatbot-applications-using-openchatkit-models-on-amazon-sagemaker/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 10

- 100

- 11

- 14

- 15%

- 17

- 195

- 20

- 2023

- 30

- 40

- 7

- 8

- a

- Fähigkeit

- Fähig

- Über Uns

- beschleunigen

- Zugang

- Genauigkeit

- genau

- Erreichen

- über

- Zusätzliche

- zusätzlich

- Adresse

- advanced

- Nach der

- danach

- gegen

- AI

- KI-Anwendungsfälle

- AI / ML

- AIML

- ausrichten

- Alle

- Zulassen

- erlaubt

- entlang

- neben

- ebenfalls

- Obwohl

- erstaunlich

- Amazon

- Amazon Sage Maker

- Amazon SageMaker-Studio

- Amazon Web Services

- an

- analysieren

- und

- beantworten

- Antworten

- jedem

- Bienen

- APIs

- Anwendung

- Anwendungen

- Bewerben

- APT

- Architektur

- Archiv

- SIND

- Artikel

- künstlich

- künstliche Intelligenz

- AS

- damit verbundenen

- At

- Augmented

- Australien

- Im Prinzip so, wie Sie es von Google Maps kennen.

- verfügbar

- vermeiden

- AWS

- Base

- basierend

- Baseline

- BE

- weil

- werden

- wird

- Bevor

- Sein

- unten

- Benchmark

- zwischen

- Vorurteile

- BIN

- Blockiert

- Körper

- Wander- und Outdoorschuhen

- beide

- bauen

- Building

- erbaut

- Last

- Geschäft

- Geschäftsanwendungen

- by

- rufen Sie uns an!

- CAN

- Kapazität

- Kohlenstoff

- Häuser

- Fälle

- CD

- Gebühren

- Chatbot

- Chatbots

- aus der Ferne überprüfen

- Klasse

- Unterricht

- Einstufung

- klassifizieren

- geschlossen

- Cloud

- CO

- Code

- Zusammenarbeit

- community

- Unternehmen

- Compliance

- Komponenten

- umfassend

- Berechnen

- Computer

- Computer Vision

- Computing

- Bedenken

- Konfiguration

- konfiguriert

- enthalten

- Container

- Behälter

- enthält

- Inhalt

- Kontext

- beitragen

- Smartgeräte App

- Steuerung

- Gespräch

- Gespräche

- Dazugehörigen

- Kosten

- erstellen

- erstellt

- schafft

- Erstellen

- Kriterien

- Strom

- Zur Zeit

- Original

- Kunden

- anpassen

- maßgeschneiderte

- technische Daten

- Datensätze

- tief

- tiefe Lernen

- definiert

- Definiert

- Definition

- Grad

- Anforderungen

- Demokratisierung

- zeigen

- demonstrieren

- hängt

- einsetzen

- Einsatz

- Design

- entworfen

- Details

- Entwickler

- Entwicklungen

- Geräte

- anders

- schwer

- Schwierigkeiten

- diskutieren

- diskutiert

- Abstand

- verteilt

- Verteiltes rechnen

- do

- Docker

- Dokument

- Dokumentation

- Unterlagen

- die

- Tut nicht

- Domain

- Domains

- Nicht

- herunterladen

- Downloads

- im

- dynamisch

- jeder

- sonst

- anderswo

- Einbettung

- beschäftigt

- ermöglicht

- ermöglichen

- ermutigt

- Endpunkt

- erzwingen

- Motor

- Ingenieur

- Entwicklung

- Unternehmen

- Ganz

- Eintrag

- essential

- ethisch

- ÜBERHAUPT

- Beispiel

- existieren

- erwartet

- Expertise

- Erweiterungen

- extern

- äußerst

- Gesicht

- Familie

- Fashion

- Reichen Sie das

- Mappen

- Filter

- Filterung

- Endlich

- Revolution

- Finanznachrichten

- Finanzprodukte

- Finden Sie

- Vorname

- markiert

- konzentriert

- konzentriert

- Fokussierung

- folgen

- Folgende

- folgt

- Aussichten für

- Format

- Fördern

- vier

- Freunde

- für

- voll

- Funktionalität

- allgemeiner Zweck

- erzeugen

- erzeugt

- erzeugt

- Generation

- generativ

- Generative KI

- bekommen

- Git

- gegeben

- gut

- GPU

- GPUs

- Griffe

- Handling

- Hardware

- Haben

- he

- hilft

- GUTE

- Hohe Leistungsfähigkeit

- seine

- Gastgeber

- gehostet

- Hosting

- Ultraschall

- Hilfe

- HTML

- http

- HTTPS

- Umarmendes Gesicht

- human

- ID

- identifizieren

- if

- zeigt

- Image

- Bilder

- Implementierung

- implementiert

- importieren

- Bedeutung

- wichtig

- Verbesserung

- in

- inklusive

- Einschließlich

- integrieren

- zunehmend

- Index

- zeigen

- zeigt

- Branchen

- Energiegewinnung

- Information

- Innovation

- Varianten des Eingangssignals:

- Eingänge

- innerhalb

- Einblicke

- installieren

- installiert

- Instanz

- Anleitung

- Versicherung

- integrieren

- Intelligenz

- Interaktionen

- intern

- Intervention

- in

- Investition

- Anlageempfehlungen

- beteiligt

- IT

- SEINE

- selbst

- Javac

- jpg

- JSON

- Wesentliche

- Wissen

- Wissen

- Etiketten

- Sprache

- grosse

- Große Unternehmen

- Latency

- Leadership

- lernen

- am wenigsten

- Rechtlich

- lassen

- Hebelwirkung

- Bibliotheken

- Bibliothek

- Lizenz

- Gefällt mir

- LIMIT

- Liste

- Lama

- LLM

- Belastungen

- aus einer regionalen

- Standorte

- Logik

- Los

- Sneaker

- Maschine

- Maschinelles Lernen

- gemacht

- Main

- um

- Making

- viele

- März

- Markt

- Grundstimmung des Marktes

- Markt-Trends

- Maske"

- Abstimmung

- Triff

- Nachrichten

- Methoden

- Metrik

- Million

- ML

- Modell

- für

- Mäßigung

- Modul

- Überwachen

- mehr

- mehrere

- Name

- Natürliche

- Verarbeitung natürlicher Sprache

- notwendig,

- Need

- erforderlich

- Bedürfnisse

- Negativ

- News

- nächste Generation

- Nlp

- nicht

- Notizbuch

- Anzahl

- und viele

- Objekt

- Objekte

- Hindernisse

- beschaffen

- of

- bieten

- on

- EINEM

- einzige

- Open-Source-

- optimal

- Optimierung

- Option

- Optionen

- or

- Organisation

- Organisationen

- OS

- Andere

- Möglichkeiten für das Ausgangssignal:

- aussen

- übrig

- Override

- besitzen

- Paket

- verpackt

- Pakete

- Pandas

- Papiere

- Parallel

- Parameter

- Parameter

- Teil

- passieren

- Bestanden

- Bestehen

- Weg

- Schnittmuster

- Leistung

- Durchführung

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Beliebt

- möglich

- Post

- Potenzial

- angetriebene

- größte treibende

- vorhersagen

- Prognosen

- Vorbereitung

- Gegenwart

- vorgeführt

- früher

- Principal

- Probleme

- Prozessdefinierung

- Verarbeitung

- produziert

- Produkte

- Programmierung

- immobilien

- die

- vorausgesetzt

- bietet

- Bereitstellung

- Zweck

- Push

- Python

- Pytorch

- Qualität

- Frage

- Fragen

- Angebot

- Bereich

- Lesebrillen

- Gründe

- erhält

- Empfehlungen

- empfohlen

- Reduzierung

- bezogene

- freigegeben

- relevant

- bleibt bestehen

- bemerkenswert

- Meldungen

- Quelle

- Anforderung

- Zugriffe

- falls angefordert

- Forschungsprojekte

- Forscher

- Downloads

- Antwort

- Antworten

- für ihren Verlust verantwortlich.

- REST

- eingeschränkt

- Folge

- Die Ergebnisse

- behalten

- Rückkehr

- Führen Sie

- Laufen

- Sicherheit

- sagemaker

- Skalieren

- Skalierung

- Suche

- Suche

- Abschnitt

- Abschnitte

- sehen

- senden

- geschickt

- Satz

- Gefühl

- brauchen

- dient

- Lösungen

- Dienst

- Sitzung

- kompensieren

- Einstellung

- Einstellungen

- sollte

- erklären

- Einfacher

- da

- Single

- beträchtlich

- Größe

- Schnappschuss

- So

- Lösung

- Lösungen

- einige

- anspruchsvoll

- Quelle

- Quellen

- Spezialist

- spezialisiert

- spezifisch

- angegeben

- Geschwindigkeit

- Ausgabe

- begonnen

- Anfang

- Startups

- Schritt

- Shritte

- Einstellung

- Lagerung

- gelagert

- Läden

- Speicherung

- Schnur

- Studio Adressen

- Erfolgreich

- so

- Leidet

- zusammenfassen

- geliefert

- Zuführung

- Support

- Unterstützt

- Sydney

- System

- Tabelle

- Aufgabe

- und Aufgaben

- Team

- Techniken

- Technologies

- Technologie

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Quelle

- ihr

- Sie

- dann

- Dort.

- damit

- deswegen

- Diese

- fehlen uns die Worte.

- dachte

- Gedankenführung

- Durchsatz

- Zeit

- zu

- gemeinsam

- Tokenisiert

- Werkzeuge

- trainiert

- Ausbildung

- Transparenz

- Reise

- Trends

- was immer dies auch sein sollte.

- Drehungen

- XNUMX

- tippe

- für

- verstehen

- einzigartiges

- Universal-

- bis

- Aktualisierung

- aktualisiert

- Updates

- hochgeladen

- us

- -

- Anwendungsfall

- benutzt

- Mitglied

- Nutzer

- verwendet

- Verwendung von

- Nutzen

- Wert

- verschiedene

- VIKUNA

- Virginia

- Seh-

- warten

- wollen

- we

- Netz

- Web-Services

- GUT

- Was

- wann

- welche

- breit

- Große Auswahl

- Wikipedia

- werden wir

- mit

- ohne

- Arbeiten

- gearbeitet

- Arbeiter

- Arbeiter

- Arbeitsablauf.

- Workflows

- arbeiten,

- Werk

- würde

- X

- Du

- Ihr

- Zephyrnet