In diesem Beitrag sprechen wir darüber, wie generative KI die Konversations-KI-Branche verändert, indem sie neue Kunden- und Bot-Builder-Erlebnisse bietet, sowie über die neuen Funktionen in Amazon Lex die diese Fortschritte nutzen.

Da die Nachfrage nach Konversations-KI weiter wächst, suchen Entwickler nach Möglichkeiten, ihre Chatbots mit menschenähnlichen Interaktionen und erweiterten Funktionen wie der FAQ-Verarbeitung zu verbessern. Jüngste Durchbrüche in der generativen KI führen zu erheblichen Verbesserungen beim Verständnis natürlicher Sprache, die Konversationssysteme intelligenter machen. Durch das Training großer neuronaler Netzwerkmodelle anhand von Datensätzen mit Billionen von Token haben KI-Forscher Techniken entwickelt, die es Bots ermöglichen, komplexere Fragen zu verstehen, differenzierte und natürlichere, menschlich klingende Antworten zu geben und ein breites Themenspektrum zu bearbeiten. Mit diesen neuen generativen KI-Innovationen können Sie virtuelle Assistenten erstellen, die sich bei text- oder sprachbasierten Self-Service-Interaktionen natürlicher, intuitiver und hilfreicher anfühlen. Der rasante Fortschritt in der generativen KI bringt automatisierte Chatbots und virtuelle Assistenten dem Ziel, wirklich intelligente, fließende Gespräche zu führen, deutlich näher. Mit weiteren Fortschritten im Bereich Deep Learning und neuronalen Netzwerktechniken sind Konversationssysteme auf dem besten Weg, noch flexibler, nachvollziehbarer und menschenähnlicher zu werden. Diese neue Generation von KI-gestützten Assistenten kann nahtlose Self-Service-Erlebnisse in einer Vielzahl von Anwendungsfällen bieten.

Wie Amazon Bedrock die Landschaft der Konversations-KI verändert

Amazonas Grundgestein ist eine benutzerfreundliche Möglichkeit, generative KI-Anwendungen mit Basismodellen (FMs) zu erstellen und zu skalieren. Amazon Bedrock bietet eine Reihe von FMs führender Anbieter, sodass AWS-Kunden die Flexibilität und Auswahl haben, die besten Modelle für ihren spezifischen Anwendungsfall zu verwenden.

In der heutigen schnelllebigen Welt erwarten wir von jedem Unternehmen einen schnellen und effizienten Kundenservice. Allerdings kann die Bereitstellung eines exzellenten Kundenservices eine große Herausforderung darstellen, wenn die Anzahl der Anfragen die für die Beantwortung dieser Anfragen eingesetzten Personalressourcen übersteigt. Unternehmen können diese Herausforderung effizient bewältigen und gleichzeitig einen personalisierten Kundenservice bieten, indem sie die Fortschritte in der generativen KI nutzen, die auf großen Sprachmodellen (LLMs) basiert.

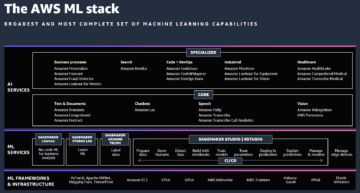

Im Laufe der Jahre hat AWS in die Demokratisierung des Zugangs zu KI, maschinellem Lernen (ML) und generativer KI investiert und das Verständnis dafür erweitert. LLMs können in Contact Centern äußerst nützlich sein, indem sie automatisierte Antworten auf häufig gestellte Fragen bereitstellen, die Stimmung und Absichten der Kunden analysieren, Anrufe entsprechend weiterzuleiten, Zusammenfassungen von Gesprächen zur Unterstützung von Agenten erstellen und sogar automatisch E-Mails oder Chat-Antworten auf häufige Kundenanfragen generieren. Durch die Bewältigung sich wiederholender Aufgaben und die Gewinnung von Erkenntnissen aus Gesprächen ermöglichen LLMs den Contact-Center-Agenten, sich auf die Erbringung eines höheren Mehrwerts durch personalisierten Service und die Lösung komplexer Probleme zu konzentrieren.

Verbessern Sie das Kundenerlebnis mit konversationsorientierten FAQs

Generative KI hat ein enormes Potenzial, im Dialog schnelle und zuverlässige Antworten auf häufig gestellte Kundenfragen zu geben. Durch den Zugriff auf autorisierte Wissensquellen und LLMs kann Ihr vorhandener Amazon Lex-Bot hilfreiche, natürliche und genaue Antworten auf häufig gestellte Fragen bereitstellen, die über den aufgabenorientierten Dialog hinausgehen. Unser Retrieval Augmented Generation (RAG)-Ansatz ermöglicht es Amazon Lex, sowohl die Breite des in Repositorys verfügbaren Wissens als auch die Fluenz von LLMs zu nutzen. Sie können Ihre Frage einfach in freier, verständlicher Sprache stellen und erhalten innerhalb von Sekunden eine natürliche, maßgeschneiderte Antwort. Die neue Konversations-FAQ-Funktion in Amazon Lex ermöglicht es Bot-Entwicklern und Konversationsdesignern, sich auf die Definition der Geschäftslogik zu konzentrieren, anstatt umfassende FAQ-basierte Konversationsabläufe innerhalb eines Bots zu entwerfen.

Wir führen ein integriertes QnAIntent ein, das mithilfe eines LLM eine autorisierte Wissensquelle abfragt und eine aussagekräftige und kontextbezogene Antwort liefert. Darüber hinaus können Entwickler QnAIntent so konfigurieren, dass es auf bestimmte Wissensdatenbankabschnitte verweist und so sicherstellt, dass zur Laufzeit nur bestimmte Teile des Wissensinhalts abgefragt werden, um Benutzeranforderungen zu erfüllen. Diese Funktion erfüllt den Bedarf stark regulierter Branchen wie Finanzdienstleistungen und Gesundheitswesen, Antworten nur in konformer Sprache bereitzustellen. Die Konversations-FAQ-Funktion in Amazon Lex ermöglicht es Unternehmen, die Eindämmungsraten zu verbessern und gleichzeitig die hohen Kosten für verpasste Anfragen und die Versetzung menschlicher Vertreter zu vermeiden.

Erstellen eines Amazon Lex-Bots mit dem beschreibenden Bot-Builder

Das Erstellen von Konversations-Bots von Grund auf ist ein zeitaufwändiger Prozess, der umfassende Kenntnisse darüber erfordert, wie Benutzer mit Bots interagieren, um potenzielle Anfragen vorherzusehen und entsprechende Antworten zu programmieren. Heutzutage verbringen Konversationsdesigner und Entwickler viele Tage damit, Code zu schreiben, um alle möglichen Benutzeraktionen auszuführen (Absichten), die verschiedenen Arten, wie Benutzer ihre Anfragen formulieren (Äußerungen) und die Informationen, die der Benutzer zum Ausführen dieser Aktionen benötigt (Slots).

Die neue Funktion zur beschreibenden Bot-Erstellung in Amazon Lex nutzt generative KI, um den Bot-Erstellungsprozess zu beschleunigen. Anstatt Code zu schreiben, können Konversationsdesigner und Bot-Entwickler jetzt in einfachem Englisch beschreiben, was der Bot erreichen soll (z. B. „Reservierungen für mein Hotel mit Namen und Kontaktinformationen, Reisedaten, Zimmertyp und Zahlungsinformationen entgegennehmen“). . Mit nur dieser einfachen Eingabeaufforderung generiert Amazon Lex automatisch Absichten, Trainingsäußerungen, Slots, Eingabeaufforderungen und einen Gesprächsfluss, um den beschriebenen Bot zum Leben zu erwecken. Durch die Bereitstellung eines Basis-Bot-Designs reduziert diese Funktion den Zeitaufwand und die Komplexität der Erstellung von Konversations-Chatbots enorm und ermöglicht es dem Entwickler, den Aufwand für die Feinabstimmung des Konversationserlebnisses neu zu priorisieren.

Durch die Nutzung der Leistungsfähigkeit generativer KI mit LLMs ermöglicht Amazon Lex Entwicklern und technisch nicht versierten Benutzern, Bots zu erstellen, indem sie einfach ihr Ziel beschreiben. Anstatt Absichten, Äußerungen, Slots usw. akribisch zu codieren, können Entwickler eine Eingabeaufforderung in natürlicher Sprache bereitstellen und Amazon Lex generiert automatisch einen grundlegenden Bot-Flow, der zur weiteren Verfeinerung bereit ist. Diese Funktion ist zunächst nur auf Englisch verfügbar, Entwickler können den KI-generierten Bot jedoch vor der Bereitstellung nach Bedarf weiter anpassen, wodurch viele Stunden manueller Entwicklungsarbeit eingespart werden.

Verbesserung des Benutzererlebnisses durch unterstützte Slot-Auflösung

Da Verbraucher mit Chatbots und interaktiven Sprachantwortsystemen (IVR) immer vertrauter werden, erwarten sie ein höheres Maß an Intelligenz, die in Self-Service-Erlebnisse integriert ist. Für den Erfolg ist es unerlässlich, eindeutigere Antworten zu geben, die eher auf den Dialog ausgerichtet sind, da Benutzer natürlichere, menschenähnlichere Erlebnisse erwarten. Da das Vertrauen der Verbraucher in die Fähigkeiten von Chatbots steigt, wird auch eine höhere Leistung des Natural Language Understanding (NLU) erwartet. In dem wahrscheinlichen Szenario, dass eine semantisch einfache oder komplexe Äußerung nicht richtig in einen Slot aufgelöst wird, kann das Vertrauen der Benutzer schwinden. In solchen Fällen kann ein LLM das vorhandene Amazon Lex NLU-Modell dynamisch unterstützen und eine genaue Slot-Auflösung gewährleisten, selbst wenn die Benutzeräußerung außerhalb der Grenzen des Slot-Modells liegt. In Amazon Lex bietet die unterstützte Slot-Auflösungsfunktion dem Bot-Entwickler ein weiteres Tool zur Verbesserung der Eindämmung.

Wenn NLU zur Laufzeit einen Slot während einer Konversationsrunde nicht auflösen kann, ruft Amazon Lex den vom Bot-Entwickler ausgewählten LLM auf, um bei der Auflösung des Slots zu helfen. Wenn das LLM bei einem Slot-Wiederholungsversuch einen Wert bereitstellen kann, kann der Benutzer die Konversation wie gewohnt fortsetzen. Wenn ein Bot beispielsweise bei einem erneuten Slot-Versuch fragt: „In welcher Stadt wohnt der Versicherungsnehmer?“ und der Benutzer antwortet „Ich lebe in Springfield“, kann das LLM den Wert in „Springfield“ auflösen. Zu den unterstützten Slot-Typen für diese Funktion gehören AMAZON.City, AMAZON.Country, AMAZON.Number, AMAZON.Date, AMAZON.AlphaNumeric (ohne Regex) und AMAZON.PhoneNumber sowie AMAZON.Confirmation. Diese Funktion ist zum Zeitpunkt des Schreibens nur auf Englisch verfügbar.

Verbesserung der Builder-Erfahrung durch Schulung der Äußerungsgenerierung

Einer der Schwachpunkte, mit denen Bot-Entwickler und Conversational-Designer häufig konfrontiert werden, besteht darin, die Vielfalt und Vielfalt der Reaktionen zu antizipieren, wenn sie eine Absicht aufrufen oder Slot-Informationen anfordern. Wenn ein Bot-Entwickler eine neue Absicht erstellt, müssen Beispieläußerungen bereitgestellt werden, um das ML-Modell auf die Arten von Antworten zu trainieren, die es akzeptieren kann und sollte. Es kann oft schwierig sein, die von Kunden verwendeten Permutationen in Bezug auf Wortschatz und Syntax vorherzusagen. Bei der Äußerungsgenerierung verwendet Amazon Lex grundlegende Modelle wie Amazonas-Titan Trainingsäußerungen mit nur einem Klick zu generieren, ohne dass eine sofortige technische Planung erforderlich ist.

Die Äußerungsgenerierung verwendet den Absichtsnamen, vorhandene Äußerungen und optional die Absichtsbeschreibung, um neue Äußerungen mit einem LLM zu generieren. Bot-Entwickler und Konversationsdesigner können die generierten Äußerungen bearbeiten oder löschen, bevor sie sie akzeptieren. Diese Funktion funktioniert sowohl mit neuen als auch mit vorhandenen Absichten.

Zusammenfassung

Die jüngsten Fortschritte in der generativen KI haben zweifellos zu einem besseren automatisierten Verbrauchererlebnis geführt. Mit Amazon Lex setzen wir uns dafür ein, generative KI in jeden Aspekt des Builder- und Benutzererlebnisses zu integrieren. Die in diesem Beitrag erwähnten Funktionen sind nur der Anfang – und wir können es kaum erwarten, Ihnen zu zeigen, was noch kommt.

Weitere Informationen finden Sie unter Amazon Lex-Dokumentation, und probieren Sie diese Funktionen auf der Amazon Lex-Konsole aus.

Über die Autoren

Anuradha Durfee ist Senior Product Manager im Amazon Lex-Team und verfügt über mehr als 7 Jahre Erfahrung im Bereich Konversations-KI. Sie ist fasziniert von Sprachbenutzeroberflächen und der Verbesserung des Zugangs zu Technologie durch intuitives Design.

Anuradha Durfee ist Senior Product Manager im Amazon Lex-Team und verfügt über mehr als 7 Jahre Erfahrung im Bereich Konversations-KI. Sie ist fasziniert von Sprachbenutzeroberflächen und der Verbesserung des Zugangs zu Technologie durch intuitives Design.

Sandeep Srinivasan ist Senior Product Manager im Amazon Lex-Team. Als aufmerksamer Beobachter des menschlichen Verhaltens liegt ihm das Kundenerlebnis am Herzen. Er verbringt seine wachen Stunden an der Schnittstelle von Menschen, Technologie und Zukunft.

Sandeep Srinivasan ist Senior Product Manager im Amazon Lex-Team. Als aufmerksamer Beobachter des menschlichen Verhaltens liegt ihm das Kundenerlebnis am Herzen. Er verbringt seine wachen Stunden an der Schnittstelle von Menschen, Technologie und Zukunft.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/elevate-your-self-service-assistants-with-new-generative-ai-features-in-amazon-lex/

- :hast

- :Ist

- :nicht

- 100

- 7

- a

- Fähig

- LiveBuzz

- beschleunigen

- Akzeptieren

- akzeptieren

- Zugang

- zugänglich

- erreichen

- genau

- über

- Aktionen

- Zusatz

- Adresse

- advanced

- Fortschritte

- Vorschüsse

- Vorteil

- Agenten

- AI

- AI-powered

- Alle

- erlauben

- Zulassen

- erlaubt

- ebenfalls

- Amazon

- Amazon Lex

- Amazon Web Services

- verstärkend

- an

- Analyse

- und

- Ein anderer

- Antworten

- erwarten

- vorwegnehmen

- jedem

- Anwendungen

- Ansatz

- angemessen

- passend

- SIND

- Feld

- AS

- fragen

- Aussehen

- helfen

- Assistenten

- unterstützt

- At

- Augmented

- zugelassen

- Automatisiert

- Im Prinzip so, wie Sie es von Google Maps kennen.

- verfügbar

- Vermeidung von

- AWS

- Base

- Baseline

- basic

- BE

- werden

- Bevor

- Verhalten

- BESTE

- Besser

- Beyond

- Wander- und Outdoorschuhen

- beide

- Bots

- Beschränkt

- Breite

- Durchbrüche

- bringen

- Bringing

- bauen

- Baumeister

- Bauherren

- Building

- eingebaut

- Geschäft

- Unternehmen

- aber

- by

- rufen Sie uns an!

- Aufrufe

- CAN

- Fähigkeiten

- capability

- Häuser

- Fälle

- Center

- Centers

- challenges

- herausfordernd

- Ändern

- Chatbot

- Chatbots

- Wahl

- Stadt

- klicken Sie auf

- näher

- Code

- Programmierung

- wie die

- begangen

- gemeinsam

- häufig

- abschließen

- Komplex

- Komplexität

- konform

- Vertrauen

- Bestätigung

- Konsul (Console)

- Verbraucher

- KUNDEN

- Kontakt

- Contact Center

- Eindämmung

- Inhalt

- kontextuelle

- fortsetzen

- weiter

- Gespräch

- Konversations

- Konversations-KI

- Gespräche

- Kosten

- Land

- erstellen

- schafft

- Kunde

- Customer Experience

- Kundenservice

- Kunden

- anpassen

- Datensätze

- Datum

- Datum

- Tage

- tief

- tiefe Lernen

- Definition

- liefern

- Demand

- Demokratisierung

- Einsatz

- beschreiben

- beschrieben

- Beschreibung

- Beschreibung

- Design

- Designer

- Entwerfen

- entwickelt

- Entwickler:in / Unternehmen

- Entwickler

- Entwicklung

- Dialog

- schwer

- Diversität

- die

- im

- dynamisch

- effizient

- effizient

- Anstrengung

- ELEVATE

- erhöhten

- E-Mails

- beschäftigt

- ermöglicht

- Entwicklung

- Englisch

- zu steigern,

- gewährleisten

- Gewährleistung

- Sogar

- Jedes

- Beispiel

- Ausgezeichnet

- vorhandenen

- erwarten

- Erwartung

- ERFAHRUNGEN

- Erfahrungen

- scheitert

- vertraut

- FAQ

- schnelllebig

- Merkmal

- Eigenschaften

- fühlen

- Revolution

- Finanzdienstleistungen

- Flexibilität

- flexibel

- Fluss

- Fließt

- Setzen Sie mit Achtsamkeit

- Aussichten für

- Gründen

- häufig

- für

- Erfüllen

- weiter

- Zukunft

- gewinnen

- erzeugen

- erzeugt

- Erzeugung

- Generation

- generativ

- Generative KI

- Kundenziele

- gehen

- Wachsen Sie über sich hinaus

- Griff

- Handling

- Geschirr

- Haben

- mit

- he

- Gesundheitswesen

- Hilfe

- hilfreich

- GUTE

- höher

- hoch

- seine

- Halter

- Hotels

- STUNDEN

- Ultraschall

- aber

- HTTPS

- human

- Human Resources

- if

- immens

- Imperativ

- zu unterstützen,

- Verbesserungen

- in

- das

- Erhöhung

- Branchen

- Energiegewinnung

- Info

- Information

- anfänglich

- Innovationen

- Anfragen

- Einblicke

- beantragen müssen

- Intelligenz

- Intelligent

- Absicht

- interagieren

- Interaktionen

- interaktive

- Schnittstellen

- Überschneidung

- in

- Einführung

- intuitiv

- investiert

- Probleme

- IT

- jpg

- nur

- nur einer

- Scharf

- Wissen

- Landschaft

- Sprache

- grosse

- führenden

- LERNEN

- lernen

- Cholesterinspiegel

- Lebensdauer

- wahrscheinlich

- leben

- LLM

- Logik

- Maschine

- Maschinelles Lernen

- gemacht

- um

- Making

- Manager

- Weise

- manuell

- viele

- sinnvoll

- erwähnt

- sorgfältig

- vermisst

- ML

- Modell

- für

- mehr

- Vielzahl

- sollen

- my

- Name

- Natürliche

- Need

- erforderlich

- Netzwerk

- Nerven-

- neuronale Netzwerk

- Neu

- Neue Funktionen

- nlu

- Nicht-technisch

- normal

- jetzt an

- Anzahl

- of

- Angebote

- vorgenommen,

- on

- EINEM

- einzige

- or

- Auftrag

- Organisationen

- UNSERE

- Überwinden

- Schmerzen

- leidenschaftlich

- Zahlung

- Personen

- Leistung

- Personalisiert

- Ebene

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Punkte

- balanciert

- Datenschutzrichtlinien

- möglich

- Post

- Potenzial

- Werkzeuge

- angetriebene

- Prozessdefinierung

- Produkt

- Produkt-Manager

- Fortschritt

- Eingabeaufforderungen

- richtig

- die

- vorausgesetzt

- Anbieter

- bietet

- Bereitstellung

- Abfragen

- Frage

- Fragen

- Direkt

- Angebot

- schnell

- Honorar

- lieber

- bereit

- erhalten

- kürzlich

- reduziert

- siehe

- Regex

- geregelt

- regulierte Branchen

- zuverlässig

- repetitiv

- Vertreter

- Zugriffe

- erfordert

- Forscher

- Auflösung

- lösen

- entschlossen

- Lösung

- Downloads

- Antwort

- Antworten

- Anstieg

- Zimmer

- Straße

- Führen Sie

- Laufzeit

- Einsparung

- Skalieren

- Szenario

- kratzen

- nahtlos

- Sekunden

- Abschnitte

- auf der Suche nach

- ausgewählt

- Selbstbedienung

- Senior

- Gefühl

- Lösungen

- sie

- sollte

- erklären

- signifikant

- bedeutend

- Einfacher

- einfach

- Schloß

- Slots

- So

- Quelle

- Quellen

- spezifisch

- verbringen

- Erfolg

- so

- Unterstützte

- Syntax

- Systeme und Techniken

- zugeschnitten

- Nehmen

- Einnahme

- Reden

- Klopfen

- und Aufgaben

- Team

- Techniken

- Technologie

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Zukunft

- die Informationen

- Die Landschaft

- ihr

- Sie

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- Durch

- Zeit

- Zeitaufwendig

- zu

- heute

- heutigen

- Tokens

- Werkzeug

- Themen

- Training

- Ausbildung

- Transfers

- reisen

- enorm

- Billionen

- wirklich

- versuchen

- WENDE

- tippe

- Typen

- verstehen

- Verständnis

- zweifellos

- auf

- -

- Anwendungsfall

- benutzt

- Mitglied

- Benutzererfahrung

- benutzerfreundlich

- Nutzer

- verwendet

- Verwendung von

- Wert

- verschiedene

- Assistent

- Stimme

- Volumen

- warten

- wollen

- Weg..

- Wege

- we

- Netz

- Web-Services

- GUT

- Was

- Was ist

- wann

- welche

- während

- breit

- Große Auswahl

- werden wir

- mit

- .

- ohne

- Arbeiten

- Werk

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- Schreiben

- Jahr

- noch

- Du

- Ihr

- Zephyrnet