Der generative KI-Boom ist rechengebunden. Es hat die einzigartige Eigenschaft, dass das Hinzufügen von mehr Rechenleistung direkt zu einem besseren Produkt führt. Normalerweise sind F&E-Investitionen direkter an den Wert eines Produkts gebunden, und diese Beziehung ist deutlich sublinear. Bei der künstlichen Intelligenz ist dies derzeit jedoch nicht der Fall, und daher sind die Kosten für Schulung und Inferenz heute ein vorherrschender Faktor, der die Branche antreibt.

Obwohl wir die wahren Zahlen nicht kennen, haben wir aus seriösen Quellen gehört, dass das Angebot an Rechenleistung so begrenzt ist, dass die Nachfrage es um den Faktor 10 (!) Übertrifft. Daher halten wir es für fair zu sagen, dass im Moment Der Zugang zu Rechenressourcen – zu den niedrigsten Gesamtkosten – ist zu einem entscheidenden Faktor für den Erfolg von KI-Unternehmen geworden.

Tatsächlich haben wir gesehen, dass viele Unternehmen mehr als 80 % ihres gesamten aufgebrachten Kapitals für Rechenressourcen ausgeben!

In diesem Beitrag versuchen wir, die Kostenfaktoren für ein KI-Unternehmen herunterzubrechen. Die absoluten Zahlen werden sich natürlich im Laufe der Zeit ändern, aber wir sehen keine sofortige Erleichterung durch KI-Unternehmen, die an ihren Zugang zu Rechenressourcen gebunden sind. Hoffentlich ist dies ein hilfreicher Rahmen, um die Landschaft zu durchdenken.

Warum sind KI-Modelle so rechenintensiv?

Es gibt eine Vielzahl generativer KI-Modelle, und die Inferenz- und Schulungskosten hängen von der Größe und Art des Modells ab. Glücklicherweise sind die beliebtesten Modelle heute hauptsächlich transformatorbasierte Architekturen, zu denen beliebte Large Language Models (LLMs) wie GPT-3, GPT-J oder BERT gehören. Während die genaue Anzahl der Operationen für die Inferenz und das Lernen von Transformatoren modellspezifisch ist (vgl Dieses Papier), gibt es eine ziemlich genaue Faustregel, die nur von der Anzahl der Parameter (dh den Gewichtungen der neuronalen Netze) des Modells und der Anzahl der Eingabe- und Ausgabetoken abhängt.

Token sind im Wesentlichen kurze Folgen von wenigen Zeichen. Sie entsprechen Wörtern oder Wortteilen. Der beste Weg, um eine Intuition für Token zu bekommen, ist das Ausprobieren der Tokenisierung mit öffentlich verfügbaren Online-Tokenizern (z. OpenAI). Für GPT-3 die durchschnittliche Länge eines Tokens ist 4 Zeichen.

Die Faustregel für Transformatoren ist, dass ein Vorwärtspass (dh Inferenz) für ein Modell mit p Parameter für eine Eingabe- und eine Ausgabefolge der Länge n Token jeder, dauert ungefähr 2*n*p Gleitkommaoperationen (FLOPS)¹. Die Schulung für dasselbe Modell dauert ungefähr 6*S FLOPS pro Token (d. h. der zusätzliche Rückwärtsdurchlauf erfordert vier weitere Operationen²). Sie können die gesamten Schulungskosten annähern, indem Sie diese mit der Anzahl der Token in den Schulungsdaten multiplizieren.

Die Speicheranforderungen für Transformatoren hängen auch von der Modellgröße ab. Für die Inferenz benötigen wir die p Modellparameter in den Speicher passen. Für das Lernen (dh Back-Propagation) müssen wir zusätzliche Zwischenwerte pro Parameter zwischen dem Vorwärts- und dem Rückwärtsdurchlauf speichern. Angenommen, wir verwenden 32-Bit-Gleitkommazahlen, sind dies zusätzliche 8 Bytes pro Parameter. Um ein Modell mit 175 Milliarden Parametern zu trainieren, müssten wir über ein Terabyte an Daten im Speicher halten – das übersteigt jede heute existierende GPU und erfordert, dass wir das Modell auf mehrere Karten aufteilen. Speicheranforderungen für Inferenz und Training können optimiert werden, indem Gleitkommawerte kürzerer Länge verwendet werden, wobei 16-Bit üblich wird und 8-Bit in naher Zukunft erwartet wird.

Die obige Tabelle enthält Größen und Rechenkosten für mehrere beliebte Modelle. GPT-3 hat etwa 175 Milliarden Parameter, was bei einer Ein- und Ausgabe von 1,024 Token zu einem Rechenaufwand von etwa 350 Billionen Gleitkommaoperationen (dh Teraflops oder TFLOPS) führt. Das Training eines Modells wie GPT-3 erfordert etwa 3.14 * 10 ^ 23 Gleitkommaoperationen. Andere Modelle wie Metas LLaMA haben noch höher Rechenanforderungen. Das Trainieren eines solchen Modells ist eine der rechenintensiveren Aufgaben, die sich die Menschheit bisher gestellt hat.

Zusammenfassend: KI-Infrastruktur ist teuer, weil die zugrunde liegenden algorithmischen Probleme extrem rechenintensiv sind. Der algorithmische Aufwand, eine Datenbanktabelle mit einer Million Einträgen zu sortieren, ist unbedeutend im Vergleich zu dem Aufwand, ein einzelnes Wort mit GPT-3 zu generieren. Das bedeutet, dass Sie das kleinste Modell auswählen sollten, das Ihren Anwendungsfall löst.

Die gute Nachricht ist, dass wir für Transformatoren leicht abschätzen können, wie viel Rechenleistung und Arbeitsspeicher ein Modell einer bestimmten Größe verbraucht. Und so wird die Auswahl der richtigen Hardware zur nächsten Überlegung.

Das Zeit- und Kostenargument für GPUs

Wie lässt sich Rechenkomplexität in Zeit übersetzen? Ein Prozessorkern kann typischerweise 1-2 Befehle pro Zyklus ausführen, und die Prozessortaktraten liegen seit Ende 3 Jahren stabil bei etwa 15 GHz Dennard Skalierung. Die Ausführung einer einzelnen GPT-3-Inferenzoperation ohne Nutzung einer parallelen Architektur würde in der Größenordnung von 350 TFLOPS/(3 GHz*1 FLOP) oder 116,000 Sekunden oder 32 Stunden dauern. Das ist absolut unpraktisch; Stattdessen benötigen wir spezialisierte Chips, die diese Aufgabe beschleunigen.

In der Praxis laufen heute alle KI-Modelle auf Karten, die sehr viele spezialisierte Kerne verwenden. Beispielsweise verfügt eine NVIDIA A100-GPU über 512 „Tensorkerne“, die eine 4×4-Matrixmultiplikation (was 64 Multiplikationen und Additionen oder 128 FLOPS entspricht) in einem einzigen Zyklus ausführen kann. KI-Beschleunigerkarten werden oft als GPUs (Graphics Processing Units) bezeichnet, da die Architektur ursprünglich für Desktop-Spiele entwickelt wurde. In Zukunft erwarten wir, dass KI immer mehr zu einer eigenständigen Produktfamilie wird.

Der A100 hat eine Nennleistung von 312 TFLOPS was theoretisch die Inferenz für GPT-3 auf etwa 1 Sekunde reduzieren würde. Dies ist jedoch aus mehreren Gründen eine zu stark vereinfachte Berechnung. Erstens ist für die meisten Anwendungsfälle der Engpass nicht die Rechenleistung der GPU, sondern die Fähigkeit, Daten aus dem spezialisierten Grafikspeicher an die Tensorkerne zu übertragen. Zweitens würden die 175 Milliarden Gewichte 700 GB beanspruchen und passen nicht in den Grafikspeicher irgendeiner GPU. Techniken wie Partitionierung und Gewichtsstreaming müssen verwendet werden. Und drittens gibt es eine Reihe von Optimierungen (z. B. die Verwendung kürzerer Fließkommadarstellungen, wie z. B. FP16, FP8 oder Sparse-Matrizen), die verwendet werden, um die Berechnung zu beschleunigen. Aber insgesamt gibt uns die obige Mathematik eine Vorstellung von den gesamten Berechnungskosten der heutigen LLMs.

Das Trainieren eines Transformer-Modells dauert etwa dreimal so lange pro Token wie das Inferieren. Da der Trainingsdatensatz jedoch etwa 300 Millionen Mal größer ist als ein Inferenz-Prompt, dauert das Training um den Faktor 1 Milliarde länger. Auf einer einzelnen GPU würde das Training Jahrzehnte dauern; In der Praxis geschieht dies auf großen Compute-Clustern in dedizierten Rechenzentren oder, was wahrscheinlicher ist, in der Cloud. Training ist auch schwieriger zu parallelisieren als Inferenz, da aktualisierte Gewichtungen zwischen Knoten ausgetauscht werden müssen. Speicher und Bandbreite zwischen GPUs werden oft zu einem weitaus wichtigeren Faktor, wobei Hochgeschwindigkeitsverbindungen und dedizierte Fabrics üblich sind. Für das Training sehr großer Modelle kann die Erstellung eines geeigneten Netzwerkaufbaus die größte Herausforderung sein. Mit Blick auf die Zukunft werden KI-Beschleuniger über Netzwerkfähigkeiten auf der Karte oder sogar auf dem Chip verfügen.

Wie wirkt sich diese Rechenkomplexität auf die Kosten aus? Eine GPT-3-Inferenz, die, wie wir oben gesehen haben, auf einem A1 etwa 100 Sekunde dauert, würde für 0.0002 Token reine Rechenkosten zwischen 0.0014 und 1,000 US-Dollar haben (im Vergleich zu OpenAIs Preis von 0.002 US-Dollar/1000 Token). Ein Benutzer, der 100 Inferenzanfragen pro Tag generiert, würde in der Größenordnung von Dollar pro Jahr kosten. Dies ist ein sehr niedriger Preispunkt und macht die meisten Anwendungsfälle von textbasierter KI durch Menschen finanziell rentabel.

Ausbildung GPT-3 hingegen ist deutlich teurer. Wenn wir erneut nur die Rechenkosten für 3.14 * 10 ^ 23 FLOPS bei den obigen Raten berechnen, erhalten wir eine Schätzung von 560,000 USD für A100-Karten für a einzigen Trainingslauf. In der Praxis werden wir für das Training nicht annähernd 100 % Effizienz in der GPU erreichen; Wir können jedoch auch Optimierungen verwenden, um die Trainingszeit zu reduzieren. Andere Schätzungen der GPT-3-Schulungskosten reichen von $500,000 zu $ 4.6 Mio. abhängig von Hardwareannahmen. Beachten Sie, dass dies die Kosten für einen einzelnen Lauf und nicht die Gesamtkosten sind. Wahrscheinlich sind mehrere Durchläufe erforderlich, und Cloud-Anbieter möchten langfristige Verpflichtungen (mehr dazu weiter unten). Die Ausbildung von Spitzenmodellen bleibt teuer, aber für ein gut finanziertes Start-up erreichbar.

Zusammenfassend erfordert generative KI heute massive Investitionen in die KI-Infrastruktur. Es gibt keinen Grund zu der Annahme, dass sich dies in naher Zukunft ändern wird. Das Trainieren eines Modells wie GPT-3 ist eine der rechenintensivsten Aufgaben, die die Menschheit je unternommen hat. Und während GPUs schneller werden und wir Wege finden, das Training zu optimieren, negiert die schnelle Ausbreitung der KI diese beiden Effekte.

Überlegungen zur KI-Infrastruktur

Bis zu diesem Punkt haben wir versucht, Ihnen eine Vorstellung davon zu geben, welche Größenordnung für das Training und die Inferenz von KI-Modellen erforderlich ist und welche zugrunde liegenden Parameter sie antreiben. Vor diesem Hintergrund möchten wir nun einige praktische Hinweise geben, wie man entscheidet, welche KI-Infrastruktur verwendet werden soll.

Externe vs. interne Infrastruktur

Seien wir ehrlich: GPUs sind cool. Viele Ingenieure und technisch interessierte Gründer neigen dazu, ihre eigene KI-Hardware bereitzustellen, nicht nur, weil sie eine feinkörnige Kontrolle über das Modelltraining bietet, sondern weil es einfach Spaß macht, große Mengen an Rechenleistung zu nutzen (Ausstellung A).

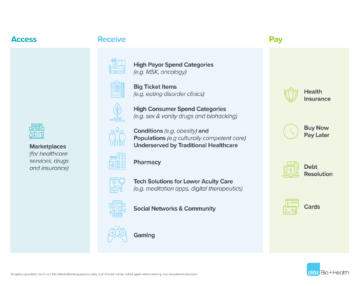

Die Realität ist jedoch so Viele Startups – insbesondere App-Unternehmen – müssen keine eigene KI-Infrastruktur aufbauen am Tag 1. Stattdessen ermöglichen gehostete Modelldienste wie OpenAI oder Hugging Face (für die Sprache) und Replicate (für die Bildgenerierung) Gründern, schnell nach Produktmarktanpassungen zu suchen, ohne die zugrunde liegende Infrastruktur oder Modelle verwalten zu müssen.

Diese Dienstleistungen sind so gut geworden, dass viele Unternehmen sie nie abschließen. Entwickler können eine sinnvolle Kontrolle über die Modellleistung durch Prompt Engineering und Feinabstimmungsabstraktionen höherer Ordnung (dh Feinabstimmung durch API-Aufrufe) erreichen. Die Preise für diese Dienste richten sich nach dem Verbrauch und sind daher oft günstiger als der Betrieb einer separaten Infrastruktur. Wir haben gesehen, dass App-Unternehmen mehr als 50 Millionen US-Dollar an ARR generiert haben und einen Wert von über 1 Milliarde US-Dollar haben, die gehostete Modelldienste unter der Haube betreiben.

Auf der anderen Seite einige Startups – besonders diejenigen, die neue Grundlagenmodelle trainieren oder vertikal integrierte KI-Anwendungen entwickeln – kommen nicht darum herum, ihre eigenen Modelle direkt zu betreiben auf GPUs. Entweder, weil das Modell effektiv das Produkt ist und das Team nach „Model-Market-Fit“ sucht, oder weil eine feinkörnige Kontrolle über Training und/oder Inferenz erforderlich ist, um bestimmte Fähigkeiten zu erreichen oder die Grenzkosten in großem Maßstab zu reduzieren. In jedem Fall kann die Verwaltung der Infrastruktur zu einem Wettbewerbsvorteil werden.

Der Cloud vs. Rechenzentrumsaufbau

In den meisten Fällen ist die Cloud der richtige Ort für Ihre KI-Infrastruktur. Geringere Anschaffungskosten, die Möglichkeit zur Auf- und Abwärtsskalierung, regionale Verfügbarkeit und weniger Ablenkung durch den Bau eines eigenen Rechenzentrums sind für die meisten Startups und größeren Unternehmen überzeugend.

Aber es gibt ein paar Ausnahmen von dieser Regel:

- Wenn Sie in sehr großem Umfang operieren, kann es kostengünstiger sein, ein eigenes Rechenzentrum zu betreiben. Der genaue Preispunkt variiert je nach geografischem Standort und Einrichtung, erfordert jedoch in der Regel Infrastrukturausgaben von mehr als 50 Millionen US-Dollar pro Jahr.

- Sie benötigen sehr spezifische Hardware, die Sie nicht von einem Cloud-Anbieter erhalten können. Zum Beispiel GPU-Typen, die nicht weit verbreitet sind, sowie ungewöhnliche Speicher-, Speicher- oder Netzwerkanforderungen.

- Sie können keine Wolke finden, die aus geopolitischen Erwägungen akzeptabel ist.

Wenn Sie Ihr eigenes Rechenzentrum bauen möchten, gibt es umfassende Preis-/Leistungsanalysen von GPUs für Ihr eigenes Setup (z. Die Analyse von Tim Dettmer). Neben den Kosten und der Leistung der Karte selbst hängt die Hardwareauswahl auch von der Leistung, dem Platz und der Kühlung ab. Beispielsweise haben zwei RTX 3080 Ti-Karten zusammen eine ähnliche rohe Rechenkapazität wie eine A100, aber der jeweilige Stromverbrauch beträgt 700 W gegenüber 300 W. Die Leistungsdifferenz von 3,500 kWh zu Marktpreisen von 0.10 $/kWh über einen dreijährigen Lebenszyklus erhöht die Kosten des RTX3080 Ti um fast das Zweifache (ca. 2 $).

All dies gesagt, erwarten wir, dass die überwiegende Mehrheit der Startups Cloud Computing nutzt.

Vergleich der Cloud-Dienstleister

Amazon Web Services (AWS), Microsoft Azure und Google Cloud Platform (GCP) bieten alle GPU-Instanzen an, aber neue Anbieter scheinen sich auch speziell auf KI-Workloads zu konzentrieren. Hier ist ein Framework, das viele Gründer bei der Auswahl eines Cloud-Anbieters verwenden:

Preis: Die folgende Tabelle zeigt die Preise für eine Reihe größerer und kleinerer Specialty Clouds mit Stand vom 7. April 2023. Diese Daten sind nur Richtwerte, da die Instanzen in Bezug auf Netzwerkbandbreite, Datenausgangskosten, zusätzliche Kosten von CPU und verfügbarem Netzwerk erheblich variieren Rabatte und andere Faktoren.

Rechenkapazität auf bestimmter Hardware ist eine Ware. Naiverweise würden wir ziemlich einheitliche Preise erwarten, aber das ist nicht der Fall. Und obwohl es erhebliche Funktionsunterschiede zwischen den Clouds gibt, reichen sie nicht aus, um zu erklären, dass die Preise für einen On-Demand-NVIDIA A100 zwischen den Anbietern um einen Faktor von fast dem Vierfachen variieren.

Am oberen Ende der Preisskala verlangen die großen Public Clouds einen Aufpreis, der auf dem Ruf der Marke, der nachgewiesenen Zuverlässigkeit und der Notwendigkeit basiert, eine breite Palette von Workloads zu verwalten. Kleinere spezialisierte KI-Anbieter bieten niedrigere Preise, indem sie entweder speziell gebaute Rechenzentren betreiben (z. B. Coreweave) oder andere Clouds (z. B. Lambda Labs) vermitteln.

In der Praxis verhandeln die meisten größeren Käufer die Preise direkt mit den Cloud-Anbietern und verpflichten sich häufig zu Mindestausgaben sowie Mindestzeitverpflichtungen (wir haben 1-3 Jahre gesehen). Die Preisunterschiede zwischen Clouds schrumpfen nach Verhandlungen etwas, aber wir haben gesehen, dass das Ranking in der obigen Tabelle relativ stabil bleibt. Es ist auch wichtig zu beachten, dass kleinere Unternehmen ohne große Ausgabenverpflichtungen aggressive Preise von Specialty Clouds erhalten können.

Verfügbarkeit: Die leistungsstärksten GPUs (z. B. Nvidia A100s) waren in den letzten 12-plus-Monaten durchgängig Mangelware.

Angesichts ihrer großen Kaufkraft und ihres Ressourcenpools wäre es logisch zu glauben, dass die drei führenden Cloud-Anbieter die beste Verfügbarkeit haben. Aber, etwas überraschend, viele Startups haben das nicht als wahr empfunden. Die großen Clouds haben viel Hardware, müssen aber auch große Kundenanforderungen erfüllen – z. B. ist Azure der primäre Host für ChatGPT – und fügen ständig Kapazität hinzu/mieten, um die Nachfrage zu befriedigen. In der Zwischenzeit hat sich Nvidia verpflichtet, Hardware branchenweit verfügbar zu machen, einschließlich Zuteilungen für neue Spezialanbieter. (Sie tun dies, um fair zu sein und ihre Abhängigkeit von einigen wenigen Großkunden zu verringern, die auch mit ihnen konkurrieren.)

Infolgedessen finden viele Startups bei kleineren Cloud-Anbietern mehr verfügbare Chips, einschließlich der hochmodernen Nvidia H100s. Wenn Sie bereit sind, mit einem neueren Infrastrukturunternehmen zusammenzuarbeiten, können Sie möglicherweise die Wartezeiten für Hardware verkürzen und dabei möglicherweise Geld sparen.

Compute-Bereitstellungsmodell: Die großen Clouds bieten heute nur Instanzen mit dedizierten GPUs an, da die GPU-Virtualisierung immer noch ein ungelöstes Problem ist. Spezialisierte KI-Clouds bieten andere Modelle wie Container oder Batch-Jobs, die einzelne Aufgaben erledigen können, ohne dass die Start- und Abschaltkosten einer Instanz anfallen. Wenn Sie mit diesem Modell vertraut sind, können Sie die Kosten erheblich senken.

Netzwerkverbindungen: Insbesondere für das Training ist die Netzwerkbandbreite ein wichtiger Faktor bei der Auswahl des Anbieters. Cluster mit dedizierten Fabrics zwischen Knoten, wie z. B. NVLink, werden benötigt, um bestimmte große Modelle zu trainieren. Bei der Bildgenerierung können die Gebühren für ausgehenden Datenverkehr ebenfalls ein wichtiger Kostentreiber sein.

Kunden-Support Große Cloud-Anbieter bedienen einen riesigen Kundenpool mit Tausenden von Produkt-SKUs. Es kann schwierig sein, die Aufmerksamkeit des Kundensupports zu erregen oder ein Problem zu beheben, es sei denn, Sie sind ein Großkunde. Viele spezialisierte KI-Clouds hingegen bieten auch kleinen Kunden einen schnellen und reaktionsschnellen Support. Dies liegt zum Teil daran, dass sie in kleinerem Umfang arbeiten, aber auch daran, dass ihre Workloads homogener sind – so dass sie mehr Anreize haben, sich auf KI-spezifische Funktionen und Fehler zu konzentrieren.

Vergleich von GPUs

Wenn alles andere gleich ist, werden die Top-End-GPUs bei fast allen Workloads die beste Leistung erbringen. Wie Sie der folgenden Tabelle entnehmen können, ist die beste Hardware jedoch auch wesentlich teurer. Die Auswahl des richtigen GPU-Typs für Ihre spezifische Anwendung kann die Kosten erheblich senken und den Unterschied zwischen einem rentablen und einem nicht rentablen Geschäftsmodell ausmachen.

Die Entscheidung, wie weit Sie in der Liste nach unten gehen – das heißt, die kostengünstigste GPU-Auswahl für Ihre Anwendung – ist größtenteils eine technische Entscheidung, die den Rahmen dieses Artikels sprengen würde. Aber wir werden unten einige der Auswahlkriterien teilen, die wir gesehen haben, sind die wichtigsten:

Training vs. Inferenz: Wie wir im ersten Abschnitt oben gesehen haben, müssen wir zum Trainieren eines Transformer-Modells zusätzlich zu den Modellgewichten 8 Byte Daten für das Training speichern. Das bedeutet, dass eine typische High-End-Consumer-GPU mit 12 GB Speicher kaum zum Trainieren eines 4-Milliarden-Parameter-Modells verwendet werden könnte. In der Praxis erfolgt das Trainieren großer Modelle auf Computer-Clustern mit vorzugsweise vielen GPUs pro Server, viel VRAM und Verbindungen mit hoher Bandbreite zwischen den Servern (dh Cluster, die unter Verwendung von Rechenzentrums-GPUs der Spitzenklasse erstellt wurden).

Insbesondere viele Modelle werden auf dem NVIDIA H100 am kostengünstigsten sein, aber derzeit ist es schwer zu finden und erfordert normalerweise eine langfristige Verpflichtung von mehr als einem Jahr. Der NVIDIA A100 führt heute das meiste Modelltraining durch; es ist einfacher zu finden, aber für große Cluster kann auch ein langfristiges Engagement erforderlich sein.

Speicheranforderungen: Große LLMs haben Parameterzahlen, die zu hoch sind, um in irgendeine Karte zu passen. Sie müssen auf mehrere Karten aufgeteilt werden und erfordern ein ähnliches Setup wie das Training. Mit anderen Worten, Sie benötigen wahrscheinlich H100s oder A100s sogar für LLM-Inferenz. Aber kleinere Modelle (z. B. Stable Diffusion) benötigen viel weniger VRAM. Während der A100 immer noch beliebt ist, haben wir gesehen, wie Startups die A10-, A40-, A4000-, A5000- und A6000- oder sogar RTX-Karten verwenden.

Hardware-Unterstützung: Während die überwiegende Mehrheit der Workloads in Unternehmen, mit denen wir gesprochen haben, auf NVIDIA ausgeführt werden, haben einige wenige begonnen, mit anderen Anbietern zu experimentieren. Am gebräuchlichsten ist die Google TPU, aber Intels Gaudi 2 scheint auch etwas Zugkraft zu bekommen. Die Herausforderung bei diesen Anbietern besteht darin, dass die Leistung Ihres Modells oft stark von der Verfügbarkeit von Softwareoptimierungen für diese Chips abhängt. Sie müssen wahrscheinlich einen PoC durchführen, um die Leistung zu verstehen.

Latenzanforderungen: Im Allgemeinen können weniger latenzempfindliche Arbeitslasten (z. B. Batch-Datenverarbeitung oder Anwendungen, die keine interaktiven UI-Antworten erfordern) weniger leistungsstarke GPUs verwenden. Dies kann die Rechenkosten um das Drei- bis Vierfache reduzieren (z. B. Vergleich von A3s mit A4s auf AWS). Benutzerorientierte Apps hingegen benötigen oft Karten der Spitzenklasse, um ein ansprechendes Benutzererlebnis in Echtzeit zu bieten. Um die Kosten in einen überschaubaren Rahmen zu bringen, ist oft eine Modelloptimierung notwendig.

Spitzigkeit: Generative KI-Unternehmen erleben oft dramatische Nachfragespitzen, da die Technologie so neu und aufregend ist. Es ist nicht ungewöhnlich, dass sich das Anfragevolumen basierend auf einer neuen Produktversion an einem Tag um das 10-fache erhöht oder beständig pro Woche um 50 % wächst. Der Umgang mit diesen Spitzen ist bei Low-End-GPUs oft einfacher, da bei Bedarf wahrscheinlich mehr Rechenknoten verfügbar sind. Es ist oft auch sinnvoll, diese Art von Datenverkehr mit kostengünstigeren Ressourcen – auf Kosten der Leistung – zu bedienen, wenn er von weniger engagierten oder weniger zurückhaltenden Benutzern stammt.

Optimierungs- und Planungsmodelle

Softwareoptimierungen können die Laufzeit von Modellen enorm beeinflussen – und 10-fache Gewinne sind keine Seltenheit. Sie müssen jedoch bestimmen, welche Methoden mit Ihrem speziellen Modell und System am effektivsten sind.

Einige Techniken funktionieren mit einer ziemlich breiten Palette von Modellen. Durch die Verwendung kürzerer Fließkommadarstellungen (dh FP16 oder FP8 gegenüber dem ursprünglichen FP32) oder Quantisierung (INT8, INT4, INT2) wird eine Beschleunigung erzielt, die häufig linear mit der Reduzierung von Bits ist. Dies erfordert manchmal eine Modifikation des Modells, aber es stehen zunehmend Technologien zur Verfügung, die das Arbeiten mit gemischter oder kürzerer Präzision automatisieren. Durch das Pruning neuronaler Netze wird die Anzahl der Gewichtungen reduziert, indem Gewichtungen mit niedrigen Werten ignoriert werden. Zusammen mit einer effizienten Sparse-Matrix-Multiplikation kann dies eine erhebliche Beschleunigung auf modernen GPUs erreichen. Ein weiterer Satz von Optimierungstechniken adressiert den Speicherbandbreitenengpass (z. B. durch Streamen von Modellgewichten).

Andere Optimierungen sind stark modellspezifisch. Beispielsweise hat Stable Diffusion große Fortschritte bei der für die Inferenz erforderlichen VRAM-Menge erzielt. Noch eine weitere Klasse von Optimierungen ist hardwarespezifisch. NVIDIAs TensorML enthält eine Reihe von Optimierungen, funktioniert aber nur auf NVIDIA-Hardware. Nicht zuletzt kann die Planung von KI-Aufgaben zu enormen Leistungsengpässen oder -verbesserungen führen. Gängige Techniken sind das Zuweisen von Modellen zu GPUs, um das Austauschen von Gewichten zu minimieren, das Auswählen der besten GPU für eine Aufgabe, wenn mehrere verfügbar sind, und das Minimieren von Ausfallzeiten durch Batching von Workloads im Voraus.

Letztendlich ist die Modelloptimierung immer noch ein bisschen schwarze Kunst, und die Mehrheit der Startups, mit denen wir sprechen, arbeiten mit Drittanbietern zusammen, um bei einigen dieser Softwareaspekte zu helfen. Dabei handelt es sich häufig nicht um traditionelle MLops-Anbieter, sondern um Unternehmen, die sich auf Optimierungen für bestimmte generative Modelle (z. B. OctoML oder SegMind) spezialisiert haben.

Wie werden sich die Kosten der KI-Infrastruktur entwickeln?

In den letzten Jahren haben wir bei beiden ein exponentielles Wachstum erlebt Modellparameter und GPU-Rechenleistung. Ob sich dieser Trend fortsetzt, ist unklar.

Heute ist allgemein anerkannt, dass es einen Zusammenhang zwischen der optimalen Anzahl von Parametern und der Größe des Trainingsdatensatzes gibt (siehe Deepmind's Chinchilla Arbeit für mehr dazu). Die besten LLMs werden heute auf der ausgebildet Allgemeines Crawlen (eine Sammlung von 4.5 Milliarden Webseiten oder etwa 10 % aller existierenden Webseiten). Das Schulungskorpus umfasst auch Wikipedia und eine Büchersammlung, obwohl beide viel kleiner sind (die Gesamtzahl der existierenden Bücher wird auf ca nur rund 100 Mio). Andere Ideen, wie das Transkribieren von Video- oder Audioinhalten, wurden vorgeschlagen, aber keine davon kommt an Umfang heran. Es ist nicht klar, ob wir einen nicht-synthetischen Trainingsdatensatz erhalten könnten, der zehnmal größer ist als der bereits verwendete.

Die GPU-Leistung wird weiter steigen, aber auch langsamer. Das Mooresche Gesetz ist immer noch intakt und erlaubt mehr Transistoren und mehr Kerne, aber Leistung und I/O werden zu limitierenden Faktoren. Darüber hinaus wurden viele der niedrig hängenden Früchte für Optimierungen gepflückt.

All dies bedeutet jedoch nicht, dass wir nicht mit einem Anstieg der Nachfrage nach Rechenkapazität rechnen. Selbst wenn sich das Wachstum von Modellen und Trainingssets verlangsamt, werden das Wachstum der KI-Branche und die steigende Zahl von KI-Entwicklern die Nachfrage nach mehr und schnelleren GPUs anheizen. Ein großer Teil der GPU-Kapazität wird von Entwicklern während der Entwicklungsphase eines Modells zum Testen verwendet, und dieser Bedarf skaliert linear mit der Mitarbeiterzahl. Es gibt keine Anzeichen dafür, dass der GPU-Mangel, den wir heute haben, in naher Zukunft nachlassen wird.

Werden diese anhaltend hohen Kosten für die KI-Infrastruktur einen Graben schaffen, der es neuen Marktteilnehmern unmöglich macht, zu kapitalkräftigen etablierten Unternehmen aufzuschließen? Wir kennen die Antwort auf diese Frage noch nicht. Die Schulungskosten eines LLM mögen heute wie ein Wassergraben aussehen, aber Open-Source-Modelle wie Alpaca oder Stable Diffusion haben gezeigt, dass diese Märkte noch früh sind und sich schnell ändern können. Im Laufe der Zeit wird die Kostenstruktur des aufkommenden KI-Software-Stacks (siehe unseren vorherigen Beitrag) könnte anfangen, eher wie die traditionelle Softwareindustrie auszusehen.

Letztlich wäre das auch gut so: Die Geschichte hat gezeigt, dass dies zu lebendigen Ökosystemen mit schneller Innovation und vielen Chancen für unternehmerische Gründer führt.

Danke an Moin Nadeem und Shangda Xu für ihren Input und ihre Anleitung während des Schreibprozesses.

¹ Die Intuition hier ist, dass für jeden Parameter (dh Gewicht) in einem neuronalen Netzwerk eine Inferenzoperation (dh Vorwärtspass) zwei Gleitkommaoperationen pro Parameter ausführen muss. Zunächst multipliziert es den Wert des Eingangsknotens des neuronalen Netzes mit dem Parameter. Zweitens fügt es das Ergebnis der Summierung dem Ausgangsknoten des neuronalen Netzwerks hinzu. Die Parameter im Encoder werden einmal pro Eingabe-Token verwendet und die Parameter im Decoder werden einmal pro Ausgabe-Token verwendet. Wenn wir davon ausgehen, dass ein Modell hat p Parameter und Ein- und Ausgabe haben beide eine Länge n Token, insgesamt Gleitkommaoperationen sind n * p. Es gibt viele andere Operationen (z. B. Normalisierung, Codierung/Decodierung der Einbettung), die in einem Modell ausgeführt werden, aber die Zeit, die benötigt wird, um sie auszuführen, ist im Vergleich dazu gering.

² Das Lernen erfordert zuerst einen Vorwärtsdurchlauf durch den Transformator, wie oben beschrieben, gefolgt von einem Rückwärtsdurchlauf, der vier zusätzliche Operationen pro Parameter erfordert, um den Gradienten zu berechnen und das Gewicht einzustellen. Beachten Sie, dass die Berechnung des Gradienten die Beibehaltung der berechneten Knotenwerte aus dem Vorwärtsdurchgang erfordert. Für GPT-3, Sprachmodelle sind wenige Lerner bespricht Schulungskosten.

* * *

Die hier geäußerten Ansichten sind die der einzelnen zitierten Mitarbeiter von AH Capital Management, LLC („a16z“) und nicht die Ansichten von a16z oder seinen verbundenen Unternehmen. Bestimmte hierin enthaltene Informationen stammen aus Drittquellen, einschließlich von Portfoliounternehmen von Fonds, die von a16z verwaltet werden. Obwohl sie aus als zuverlässig erachteten Quellen stammen, hat a16z solche Informationen nicht unabhängig überprüft und gibt keine Zusicherungen über die dauerhafte Genauigkeit der Informationen oder ihre Angemessenheit für eine bestimmte Situation. Darüber hinaus kann dieser Inhalt Werbung von Drittanbietern enthalten; a16z hat solche Anzeigen nicht überprüft und unterstützt keine darin enthaltenen Werbeinhalte.

Dieser Inhalt wird nur zu Informationszwecken bereitgestellt und sollte nicht als Rechts-, Geschäfts-, Anlage- oder Steuerberatung angesehen werden. Sie sollten diesbezüglich Ihre eigenen Berater konsultieren. Verweise auf Wertpapiere oder digitale Vermögenswerte dienen nur der Veranschaulichung und stellen keine Anlageempfehlung oder ein Angebot zur Erbringung von Anlageberatungsdiensten dar. Darüber hinaus richtet sich dieser Inhalt nicht an Anleger oder potenzielle Anleger und ist nicht für die Verwendung durch diese bestimmt, und es darf unter keinen Umständen darauf vertraut werden, wenn eine Entscheidung getroffen wird, in einen von a16z verwalteten Fonds zu investieren. (Ein Angebot zur Investition in einen a16z-Fonds wird nur durch das Privatplatzierungsmemorandum, den Zeichnungsvertrag und andere relevante Unterlagen eines solchen Fonds abgegeben und sollte vollständig gelesen werden.) Alle erwähnten, erwähnten oder erwähnten Investitionen oder Portfoliounternehmen oder Portfoliounternehmen Die beschriebenen Investitionen sind nicht repräsentativ für alle Investitionen in von a16z verwaltete Vehikel, und es kann nicht garantiert werden, dass die Investitionen rentabel sind oder dass andere Investitionen in der Zukunft ähnliche Merkmale oder Ergebnisse aufweisen werden. Eine Liste der Investitionen von Fonds, die von Andreessen Horowitz verwaltet werden (mit Ausnahme von Investitionen, für die der Emittent a16z keine Genehmigung zur öffentlichen Offenlegung erteilt hat, sowie unangekündigte Investitionen in öffentlich gehandelte digitale Vermögenswerte) ist unter https://a16z.com/investments verfügbar /.

Die darin bereitgestellten Diagramme und Grafiken dienen ausschließlich zu Informationszwecken und sollten bei Anlageentscheidungen nicht als verlässlich angesehen werden. Die Wertentwicklung in der Vergangenheit ist kein Hinweis auf zukünftige Ergebnisse. Der Inhalt spricht nur zum angegebenen Datum. Alle Prognosen, Schätzungen, Prognosen, Ziele, Aussichten und/oder Meinungen, die in diesen Materialien geäußert werden, können ohne Vorankündigung geändert werden und können von den Meinungen anderer abweichen oder ihnen widersprechen. Weitere wichtige Informationen finden Sie unter https://a16z.com/disclosures.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Quelle: https://a16z.com/2023/04/27/navigating-the-high-cost-of-ai-compute/

- :hast

- :Ist

- :nicht

- 1 Milliarden Dollar

- $UP

- 000

- 1

- 100

- 116

- 15 Jahre

- 2023

- 500

- 7

- 8

- a

- a16z

- Fähigkeit

- Fähig

- Über uns

- oben

- Absolute

- beschleunigen

- Beschleuniger

- Beschleuniger

- akzeptabel

- akzeptiert

- Zugang

- Genauigkeit

- genau

- Erreichen

- über

- Hinzufügen

- Zusatz

- Zusätzliche

- zusätzlich

- Zugänge

- Adressen

- Fügt

- vorantreiben

- Vorschüsse

- Vorteil

- Marketings

- Beratung

- beratend

- Beratungsdienste

- beeinflussen

- Mitgliedsorganisationen

- Nach der

- aufs Neue

- aggressiv

- Zustimmung

- AI

- algorithmisch

- Alle

- Zuweisungen

- Zulassen

- bereits

- ebenfalls

- Obwohl

- unter

- Betrag

- Beträge

- an

- Analyse

- und

- Andreessen

- Andreessen Horowitz

- Ein anderer

- beantworten

- Vorweggenommen

- jedem

- Bienen

- App

- erscheinen

- erscheint

- Anwendung

- Anwendungen

- ca.

- Apps

- April

- Architektur

- SIND

- Argument

- um

- Kunst

- Artikel

- künstlich

- künstliche Intelligenz

- AS

- Aspekte

- Details

- Versicherung

- At

- Aufmerksamkeit

- Audio-

- automatisieren

- Verfügbarkeit

- verfügbar

- durchschnittlich

- vermeiden

- AWS

- Azure

- Bandbreite

- basierend

- BE

- weil

- werden

- wird

- Werden

- war

- Sein

- Glauben

- angenommen

- unten

- BESTE

- Besser

- zwischen

- Beyond

- vorspannen

- Big

- Milliarde

- Bit

- Schwarz

- Bücher

- Boom

- beide

- Bound

- Marke

- Break

- bringen

- breit

- allgemein

- Bugs

- bauen

- Building

- erbaut

- Geschäft

- Geschäftsmodell

- aber

- Käufer

- by

- Berechnen

- berechnet

- Berechnung

- Aufrufe

- CAN

- Kann bekommen

- kann keine

- Fähigkeiten

- Kapazität

- Hauptstadt

- Karte

- Karten

- Häuser

- Fälle

- Ringen

- Center

- Centers

- sicher

- challenges

- Übernehmen

- Charakteristik

- Zeichen

- berechnen

- ChatGPT

- billiger

- Chip

- Pommes frites

- Entscheidungen

- Auswählen

- Umstände

- Klasse

- klar

- Uhr

- Menu

- Cloud

- Cloud Computing

- Cloud-Plattform

- Sammlung

- wie die

- kommt

- komfortabel

- Engagement

- begangen

- begehen

- Ware

- gemeinsam

- Unternehmen

- Unternehmen

- verglichen

- Vergleich

- Vergleich

- zwingend

- konkurrieren

- wettbewerbsfähig

- Komplexität

- umfassend

- Berechnung

- Berechnen

- Computing

- Rechenleistung

- Verbindungen

- Berücksichtigung

- Überlegungen

- ständig

- bilden

- verbrauchen

- Verbraucher

- Verbrauch

- Behälter

- Inhalt

- Kontext

- fortsetzen

- weiter

- Gegenteil

- Smartgeräte App

- cool

- Kernbereich

- Kosten

- kostengünstiger

- Kosten

- könnte

- Kurs

- erstellen

- Erstellen

- Kriterien

- Zur Zeit

- Kunde

- Kundensupport

- Kunden

- innovativ, auf dem neuesten Stand

- Zyklus

- technische Daten

- Data Center

- Rechenzentren

- Datenverarbeitung

- Datensatz

- Datenbase

- Datum

- Tag

- Jahrzehnte

- entscheidet

- Entscheidung

- gewidmet

- DeepMind

- Übergeben

- Lieferanten

- Demand

- Abhängigkeit

- abhängig

- Abhängig

- hängt

- beschrieben

- Desktop

- Bestimmen

- Festlegung

- entwickelt

- Entwickler

- Entwicklung

- abweichen

- Unterschied

- Unterschiede

- Rundfunk

- digital

- Digitale Assets

- Direkt

- Enthüllen

- exklusive Rabatte

- deutlich

- do

- Dokumentation

- die

- Dabei

- Dollar

- erledigt

- Nicht

- nach unten

- Ausfallzeit

- dramatisch

- Antrieb

- Fahrer

- Fahren

- zwei

- im

- e

- Früh

- einfacher

- leicht

- Ecosystems

- Effektiv

- effektiv

- Effekten

- Effizienz

- effizient

- entweder

- Einbettung

- aufstrebenden

- Ende

- befürworten

- dauerhaft

- beschäftigt

- Eingriff

- Entwicklung

- Ingenieure

- Gesamtheit

- eingehend

- unternehmerisch

- Äquivalent

- insbesondere

- im Wesentlichen

- schätzen

- geschätzt

- Schätzungen

- Sogar

- ÜBERHAUPT

- entwickelt sich

- Beispiel

- übersteigt

- unterhaltsame Programmpunkte

- ohne

- ausführen

- Ausführung

- existieren

- Expansion

- erwarten

- teuer

- ERFAHRUNGEN

- Erklären

- exponentiell

- Exponentielles Wachstum

- zum Ausdruck gebracht

- äußerst

- Stoffe

- Gesicht

- Faktoren

- Messe

- ziemlich

- Familie

- FAST

- beschleunigt

- Merkmal

- Eigenschaften

- Honorare

- wenige

- finanziell

- Finden Sie

- Ende

- Vorname

- passen

- fixiert

- Flip

- schweben

- Setzen Sie mit Achtsamkeit

- gefolgt

- Aussichten für

- Prognosen

- Zum Glück

- vorwärts

- gefunden

- Foundation

- Gründer

- vier

- Fraktion

- Unser Ansatz

- für

- Treibstoff

- Spaß

- Fonds

- Mittel

- Außerdem

- Zukunft

- Gewinne

- Gaming

- Allgemeines

- Erzeugung

- Generation

- generativ

- Generative KI

- geographisch

- geopolitischen

- bekommen

- bekommen

- ABSICHT

- gegeben

- gibt

- Go

- gut

- Cumolocity

- Google Cloud Platform

- GPU

- GPUs

- Abschluss

- Grafik

- Graphen

- Wachsen Sie über sich hinaus

- Wachstum

- die Vermittlung von Kompetenzen,

- Pflege

- Griff

- Handling

- passieren

- hart

- Hardware

- Nutzen

- Haben

- Mitarbeiterzahl

- gehört

- Hilfe

- hilfreich

- hier

- GUTE

- High-End

- hoch

- Geschichte

- Haube

- Hoffentlich

- Horowitz

- Gastgeber

- gehostet

- STUNDEN

- Ultraschall

- Hilfe

- aber

- HTML

- HTTPS

- riesig

- Riesig

- Humans

- i

- Ideen

- if

- Image

- unmittelbar

- wichtig

- unmöglich

- Verbesserungen

- in

- In anderen

- incentiviert

- das

- Dazu gehören

- Einschließlich

- Erhöhung

- Steigert

- zunehmend

- unabhängig

- angegeben

- Krankengymnastik

- Energiegewinnung

- Information

- Informational

- Infrastruktur

- Innovation

- Varianten des Eingangssignals:

- Instanz

- beantragen müssen

- Anleitung

- integriert

- Intelligenz

- interaktive

- in

- Investieren

- Investition

- Anlageberatung

- Investments

- Investoren

- Aussteller

- IT

- SEINE

- selbst

- Jobs

- nur

- Behalten

- Art

- Wissen

- Labs

- Landschaft

- Sprache

- grosse

- weitgehend

- größer

- Nachname

- Latency

- Recht

- umwandeln

- lernen

- Rechtlich

- Länge

- Lebensdauer

- Gefällt mir

- wahrscheinlich

- Liste

- Lama

- LLM

- Standorte

- logisch

- Lang

- langfristig

- länger

- aussehen

- aussehen wie

- suchen

- Los

- Sneaker

- senken

- niedrigste

- Maschinen

- gemacht

- Dur

- Mehrheit

- um

- MACHT

- Making

- verwalten

- verwaltet

- Management

- flächendeckende Gesundheitsprogramme

- Menschheit

- viele

- Markt

- Märkte

- massiv

- Materialien

- Mathe

- Matrix

- Angelegenheiten

- max-width

- Kann..

- sinnvoll

- Mittel

- Mittlerweile

- Triff

- Memorandum

- Memory

- erwähnt

- Methoden

- Microsoft

- Microsoft Azure

- Million

- minimieren

- Minimum

- gemischt

- MLOps

- Modell

- für

- modern

- Geld

- Monat

- mehr

- vor allem warme

- Am beliebtesten

- viel

- mehrere

- Multiplizieren

- navigieren

- In der Nähe von

- fast

- notwendig,

- Need

- erforderlich

- Bedürfnisse

- Netzwerk

- Vernetzung

- Netzwerke

- neuronale Netzwerk

- Neuronale Netze

- Neu

- neue Produkt

- News

- weiter

- nicht

- Knoten

- Fiber Node

- Notiz..

- jetzt an

- Anzahl

- Zahlen

- Nvidia

- erhalten

- erhalten

- of

- bieten

- bieten

- vorgenommen,

- on

- On-Demand

- einmal

- EINEM

- Online

- einzige

- XNUMXh geöffnet

- Open-Source-

- OpenAI

- die

- Betrieb

- Einkauf & Prozesse

- Meinungen

- Entwicklungsmöglichkeiten

- optimal

- Optimierung

- Optimieren

- optimiert

- Optimierung

- or

- Auftrag

- Original

- ursprünglich

- Andere

- Anders

- UNSERE

- Möglichkeiten für das Ausgangssignal:

- übertrifft

- übrig

- Gesamt-

- besitzen

- Parallel

- Parameter

- Parameter

- besondere

- Parteien

- Teile

- passieren

- passt

- Ausführen

- Leistung

- Erlaubnis

- Personal

- Phase

- wählen

- abgeholt

- Ort

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Bitte

- PoC

- Points

- Pool

- Beliebt

- Mappe

- gegebenenfalls

- Post

- Werkzeuge

- größte treibende

- Praktisch

- Praxis

- Präzision

- Prämie

- früher

- Preis

- Preise

- gebühr

- primär

- privat

- wahrscheinlich

- Aufgabenstellung:

- Probleme

- Prozessdefinierung

- Verarbeitung

- Prozessor

- Produkt

- profitabel

- Projektionen

- Resorts

- prospektiv

- Chancen

- zuverlässig

- die

- vorausgesetzt

- Versorger

- Anbieter

- Öffentlichkeit

- öffentlich

- Kauf

- Zwecke

- Frage

- schnell

- F&E

- geschafft

- Angebot

- Rangliste

- schnell

- schnell

- Bewerten

- Honorar

- Roh

- erreichen

- Lesen Sie mehr

- Echtzeit

- Realität

- Grund

- Gründe

- Software Empfehlungen

- Veteran

- reduziert

- Referenzen

- bezeichnet

- regional

- Beziehung

- verhältnismäßig

- Release

- relevant

- Zuverlässigkeit

- zuverlässig

- Erleichterung

- bleiben

- bleibt bestehen

- Vertreter

- seriöse

- Ruf

- Anforderung

- Zugriffe

- erfordern

- falls angefordert

- Anforderung

- Voraussetzungen:

- erfordert

- Downloads

- diejenigen

- ansprechbar

- Folge

- Die Ergebnisse

- bewertet

- rtx

- RTX 3080

- RTX 3080 Ti

- Regel

- Führen Sie

- Laufen

- Said

- gleich

- Speichern

- Skalieren

- Waage

- Planung

- Umfang

- Suche

- Suche

- Zweite

- Sekunden

- Abschnitt

- Securities

- sehen

- gesehen

- Auswahl

- Sinn

- empfindlich

- getrennte

- Reihenfolge

- brauchen

- Fertige Server

- Dienstleistungen

- kompensieren

- Setup

- mehrere

- Teilen

- Short

- Mangel

- sollte

- gezeigt

- Konzerte

- Seite

- Schild

- ähnlich

- einfach

- da

- Single

- Situation

- Größe

- Größen

- verlangsamt

- klein

- kleinere

- So

- bis jetzt

- Software

- Löst

- einige

- etwas

- etwas

- Quelle

- Quellen

- Raumfahrt

- Sprechen

- spricht

- spezialisieren

- spezialisiert

- Spezialprodukte

- spezifisch

- speziell

- verbringen

- Ausgabe

- Spikes

- gespalten

- stabil

- Stapel

- Anfang

- anfang

- begonnen

- Startups

- Immer noch

- Lagerung

- speichern

- Streaming

- Struktur

- Fach

- Abonnement

- wesentlich

- Erfolg

- so

- geeignet

- zusammenfassen

- liefern

- Support

- System

- Tabelle

- Nehmen

- nimmt

- Reden

- Ziele

- Aufgabe

- und Aufgaben

- Steuer

- Team

- Technische

- Techniken

- Technologies

- Technologie

- AGB

- Testen

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Zukunft

- die Informationen

- Die Landschaft

- ihr

- Sie

- Dort.

- darin

- Diese

- vom Nutzer definierten

- Ding

- think

- Denken

- Dritte

- dritte seite

- basierte Online-to-Offline-Werbezuordnungen von anderen gab.

- fehlen uns die Worte.

- diejenigen

- Tausende

- nach drei

- Durch

- Gebunden

- Zeit

- mal

- zu

- heute

- heutigen

- gemeinsam

- Zeichen

- Tokenisierung

- Tokens

- auch

- Top

- Gesamt

- gegenüber

- Zugkraft

- gehandelt

- traditionell

- der Verkehr

- Training

- trainiert

- Ausbildung

- Transformer

- Übersetzen

- Trend

- versucht

- Billion

- was immer dies auch sein sollte.

- XNUMX

- tippe

- Typen

- typisch

- typisch

- ui

- Ungewöhnlich

- für

- zugrunde liegen,

- verstehen

- einzigartiges

- Bereiche

- aktualisiert

- auf

- us

- -

- Anwendungsfall

- benutzt

- Mitglied

- Benutzererfahrung

- Nutzer

- Verwendung von

- gewöhnlich

- wertvoll

- Wert

- geschätzt

- Werte

- Vielfalt

- riesig

- Fahrzeuge

- Anbieter

- verified

- vertikal

- sehr

- lebensfähig

- lebendig

- Video

- Ansichten

- Volumen

- vs

- warten

- wollen

- wurde

- Weg..

- Wege

- we

- Netz

- Web-Services

- Woche

- Gewicht

- GUT

- Was

- wann

- welche

- während

- WHO

- breit

- Große Auswahl

- weit

- Wikipedia

- werden wir

- bereit

- mit

- .

- ohne

- Word

- Worte

- Arbeiten

- arbeiten,

- würde

- Schreiben

- Jahr

- Jahr

- noch

- Du

- Ihr

- Zephyrnet